使用 SEO 爬蟲尋找 CRO 機會

已發表: 2022-08-12

人類仍然需要,但是,男孩,爬蟲可以幫忙嗎

我做 CRO 的時間越長,我就越意識到不同類型研究的重要性。 多年來,我沉迷於定量數據(在某種程度上仍然如此)。 將乾淨可靠的數據收集到近乎完美的 Google Analytics 設置中。 這將導致最好的 CRO 計劃,對嗎? 它確實讓你在一個很好的地方開始,但這只是一個開始。

在這篇文章中,我將分享我多年來在分析和 SEO 期間開發的內部搜索結果工作流程,這將有助於加快您對 CRO 計劃應該關注的領域的研究。

認識尖叫的青蛙。

搜索結果(內部站點搜索)深入研究

我很容易向您展示意圖映射(對於搜索者意圖和 SERP 意圖)以顯示何時缺少相關性(對於關鍵字和頁麵類型)。 也許那會在以後發生,但我認為這已經做了很多。

相反,我想談談更接近轉化的東西,即您的內部網站搜索結果。

站點搜索是您的用戶真正想要某物的更大信號之一。

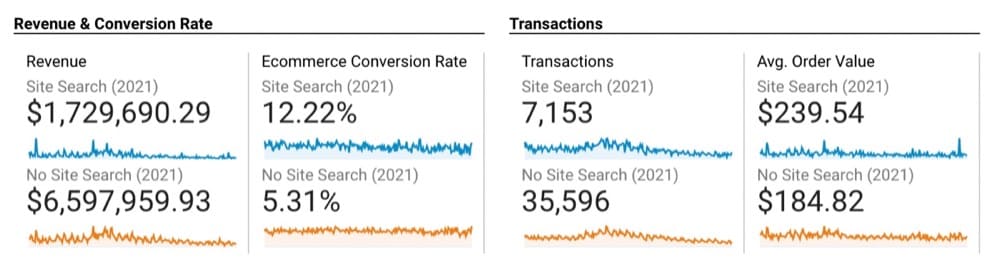

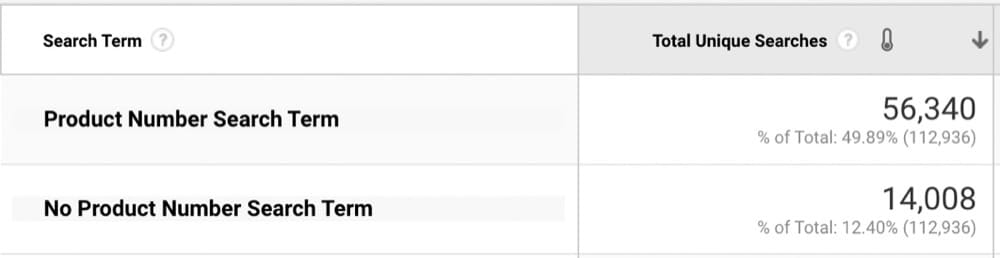

我們可以從這個泳池用品網站上看到搜索用戶與不搜索用戶的區別:

當用戶搜索時,轉化次數增加 130% 並不過分令人驚訝,但它確實顯示了提供最佳搜索體驗的能力。

現在讓我們深入研究搜索詞以確保優化體驗。

我的第一個建議是下載所有搜索詞(過去 12 個月通常是最有意義的,除非你的季節性很強)。

接下來,通過集群工具運行它們,以了解人們如何在更高級別進行搜索(這將為您提供比梳理數千個 KW 更好的方向)。

(在聚類之前,請確保您標準化和清理您的 KW 以防止拼寫錯誤和/或不同的案例處理。)

使用 =trim(clean(lower(cell-number))) 為您的公式清理 Google 表格中的內容。

現在,將它們從 MarketBold 複製並粘貼到 Keyword Grouper Pro(這是免費的)。

要組成一個小組,您將估計有多少基於我使用 1,000 個關鍵字開始,所以猜測每組 10 個將給我正確數量的組。 你永遠不知道你想要多少個組,但你應該有足夠的數據來代表你的用戶根據你上傳的數量進行搜索(你會在這方面做得更好)。

通過 GIPHY

在看到聚類的關鍵字時,我會根據人們的搜索方式將它們分為幾個不同的類別:

- 零件號(漏斗底部沒有比這更多的東西了)

- 品牌名稱

- 廣泛的類別類型

現在,我可以更有針對性地使用 GA 搜索詞來了解要查找的內容。

在這種情況下,由於搜索產品編號的用戶具有很高的購買意願,我想從那裡開始(而不僅僅是查看頂部的“x”搜索結果)。 使用一些簡單的正則表達式來僅隔離產品編號(搜索詞中的多個數字),我們發現 80% 的搜索包含產品編號

現在我們要從 Google Analytics 中導出我們的搜索結果。 如果您有很多搜索詞,您可能需要使用 API,或者像 Google Analytics(分析)Google 表格插件(它是免費的)這樣的工具。

檢查搜索結果(我們在尋找什麼?)

誠然,這是我第一次開始確保我不會掉進兔子洞的地方。 但是現在已經這樣做了太多次了,我知道我在尋找什麼

此處的“問題區域”將根據您使用的平台和搜索提供商而有所不同。 對於這種情況,我主要感興趣的是:

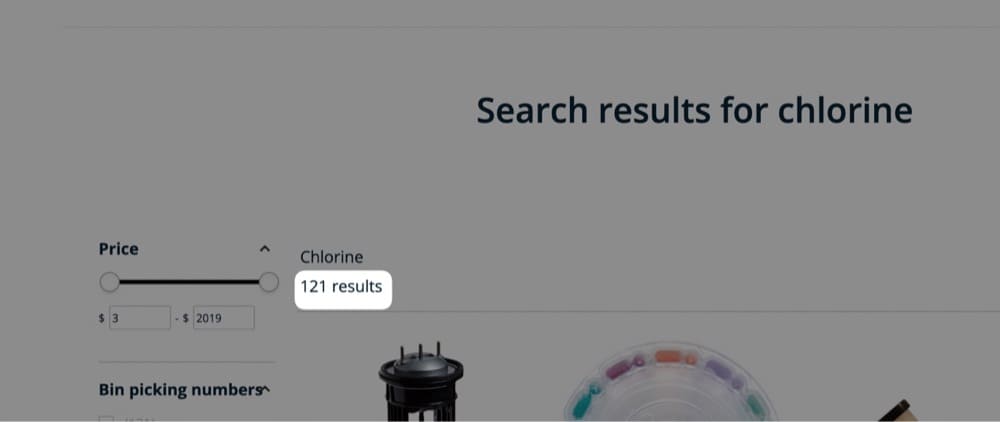

- 顯示的結果數

此處顯示:

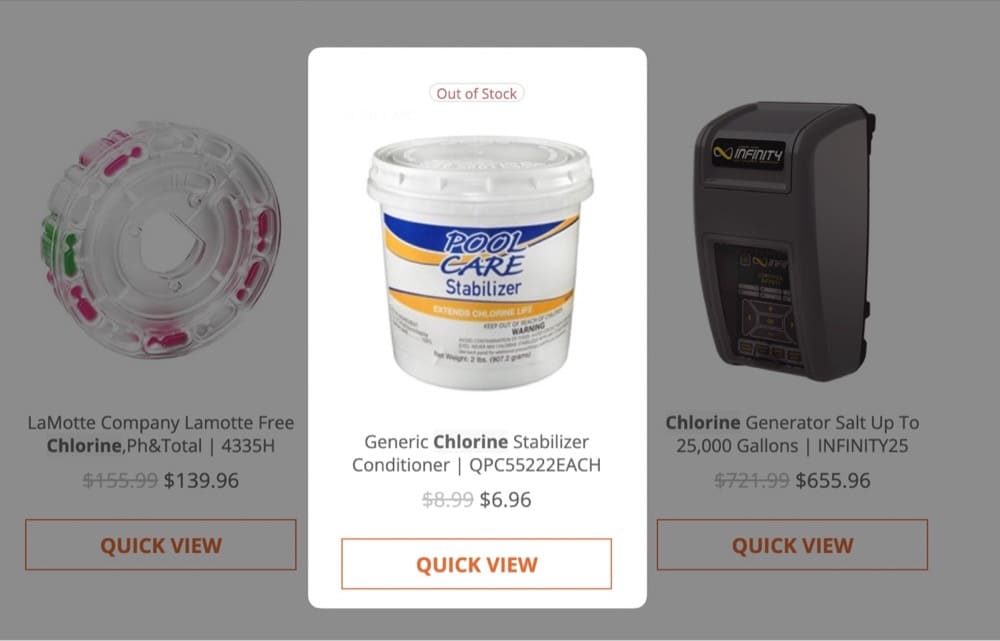

- 顯示缺貨的商品

此處顯示:

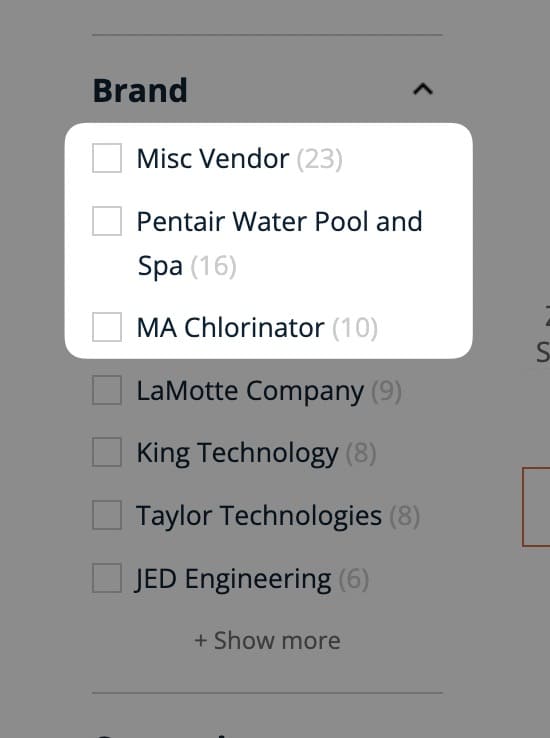

- 搜索結果所屬的前 3 個類別(這可以稍後通過 VLOOKUP 來實現,但我更願意在這裡/一次全部完成)

此處顯示:

以下問題有助於我理解數據:

- 我們是否為這些產品編號搜索顯示了適量的搜索結果?

對於幾乎所有其他類型的搜索,只有一個結果不是最佳的,但基於這些搜索,只顯示 1 個結果是有意義的。 但是,非常重要的是,我們看到了這一結果!

- 哪些搜索結果返回的卡住產品最多?

對於返回大量結果的搜索也更相關。

- 哪些類別獲得最多……

- 產品搜索?

- 有最缺貨的結果?

- 返回的結果數量最少(這很可能會導致更高的退出)?

使用 Screaming Frog 模擬搜索結果

現在到了有趣的部分——使用 Screaming Frog!

我不會介紹如何使用 Screaming Frog 的任何方面。 這是一個非常複雜的工具,儘管我已經使用它近十年了,但我可能還可以用它做更多的事情。

他們的網站上有很棒的指南(您也可以在此下載)。:https://www.screamingfrog.co.uk/seo-spider/user-guide/(費用為每年 151.77 美元,而且價格非常低它可以做什麼。)

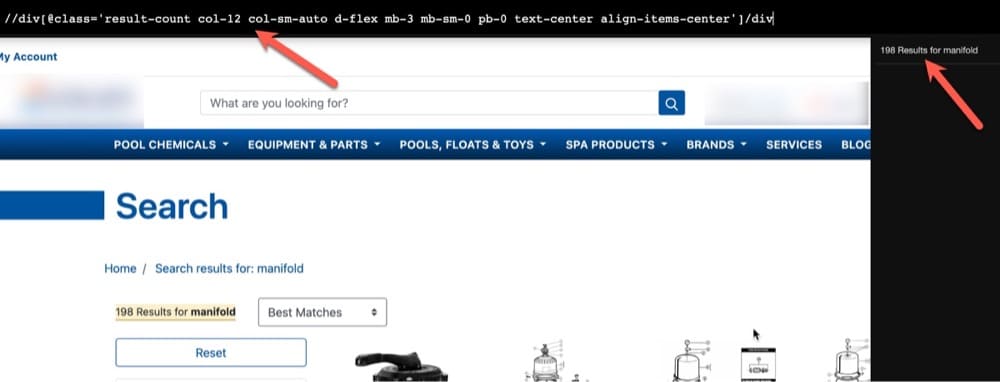

最後一個“注意細節”部分是在搜索後查看您網站的 URL 以查看模式:

了解這一點很重要,因為我們會將來自 Google Analytics 的搜索詞附加到站點 URL 以匹配此模式。 我們將模擬用戶使用爬蟲搜索此內容並提取我們已經涵蓋的感興趣區域(搜索結果、缺貨和類別)。

- 抓取 URL 中搜索詞之前的所有內容:

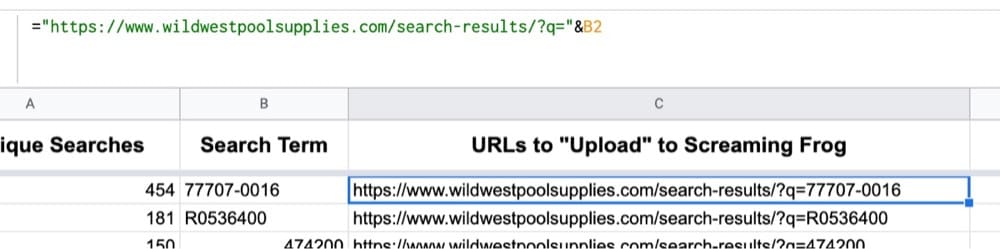

- 將該 URL 字符串與搜索詞組合:

注意:如果您的搜索詞中有空格,則必須使用高級正則表達式或 JS 在 URL 中添加 %20。 我個人使用 TextSoap 進行這些操作。

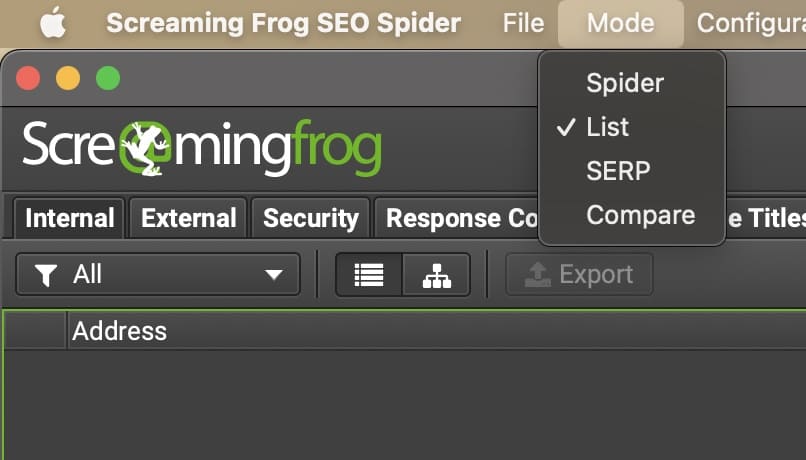

- 打開 Screaming Frog 並切換到 List 模式:

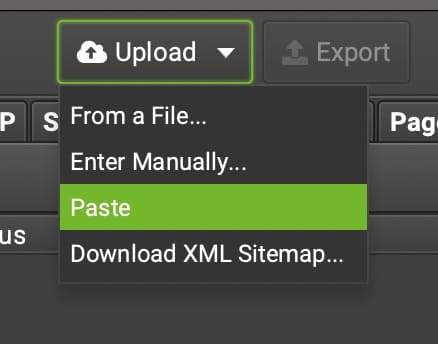

- 選擇您希望如何上傳您的 URL 列表(如果您的 URL 超過 10k,請不要粘貼它們,這將永遠加載):

- 在運行爬蟲之前,您需要想辦法從站點中提取所需的元素。

我將在 SF 中顯示搜索結果,其餘的您可以選擇要如何提取。

1.您需要提取搜索結果的數量,以了解搜索此關鍵字時返回的結果數量。 為此,我們將使用 XPATH(我通常在 SF 中選擇的語言)。

2.我通常喜歡先嘗試最簡單的方法,然後只在需要時才檢查元素。 #WorkSmarter 與 XPather chrome 擴展。

吉菲

3.這為我提供了我需要的 XPATH,以及我在 Screaming Frog 中很可能看到的“輸出”的預覽。

4.注意:我不會擔心只提取結果的數量。 這是 Google 表格中的 5 秒清理時間。

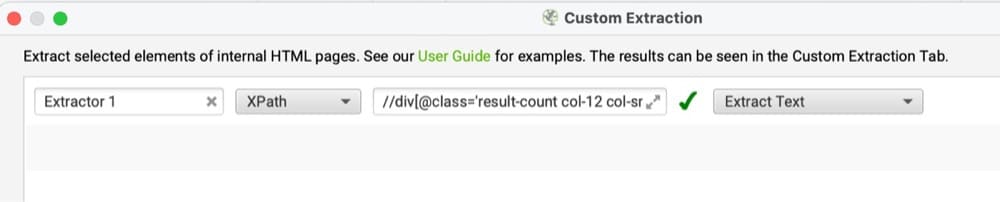

5.現在我可以在配置 → 自定義 → 提取部分下將其輸入 SF,如下所示:

6.我會將輸出更改為 Extract Text 以進一步清理它並刪除不必要的 HTML。

7.單擊確定後,您將能夠抓取您之前(或可能尚未)上傳的指定 URL。 (同樣,我們上傳 URL 的原因是為了避免抓取整個網站,只抓取我們關心的搜索詞。)

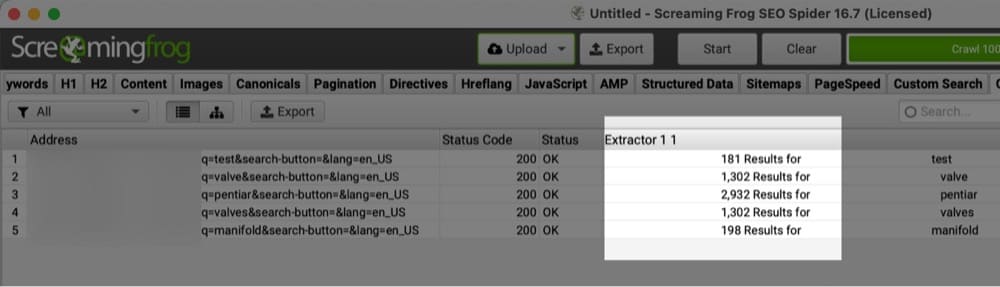

8.以下是一些 URL 的輸出示例以及這些搜索詞返回的搜索結果的數量:

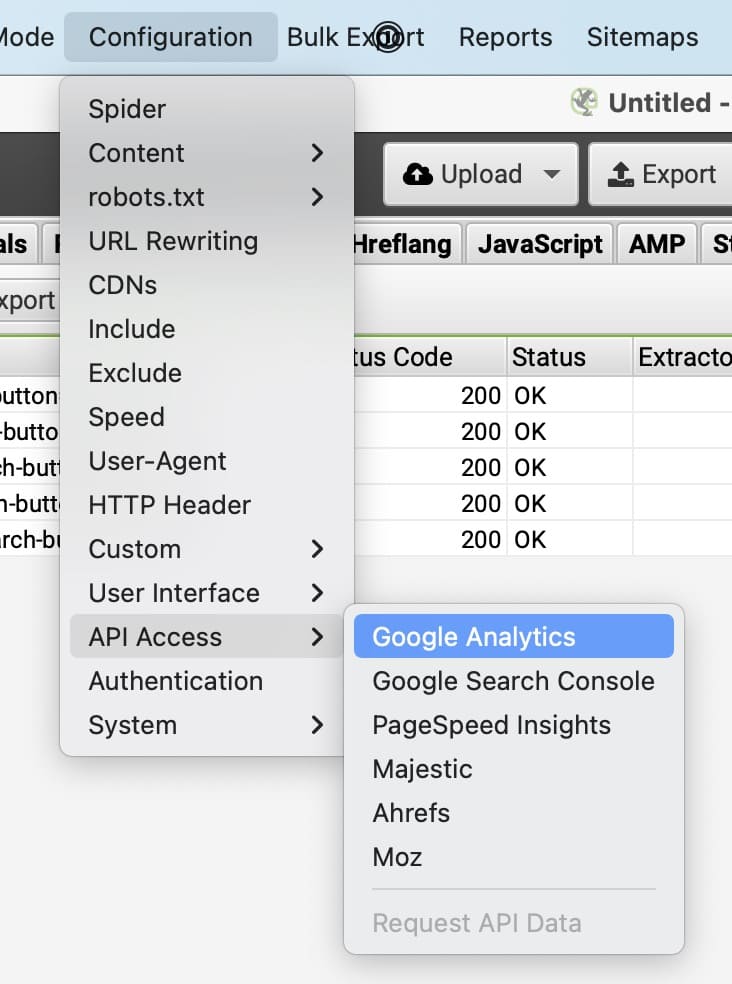

9.接下來,您可能想知道這些搜索發生的頻率。 您可以在此處連接 Google Analytics 以查看相應 URL 的綜合瀏覽量。

10.我個人覺得在這裡創建一個高搜索頁面與低返回結果的“比率”很有幫助。

此外,這些頁面上的低結果數和高退出率之間是否存在相關性? (我看到當結果少於 10 個時會發生這種情況,這意味著搜索結果看起來並不“完整”,因為大多數網站每行的寬度不超過 5 個。)

11.您可能在此處使用的其他有用數據點(基於您的搜索結果和分面導航的顯示方式):

哪些搜索結果返回的缺貨結果最多? (如果您無法採取任何措施,例如在該產品有貨時收到通知,您可能需要考慮將其從搜索結果中刪除。)

將搜索詞映射回類別(以及相關的子類別)。 幫助了解用戶隨時間推移的需求,並激發許多不同的見解——從新測試到對結果排序如何工作的模棱兩可的關鍵字進行個性化。

Product # 搜索,就像我們之前展示的那樣。 如果他們的產品# 沒有返回任何內容,大多數人不會執行多次搜索。 這可能不是一個容易立即解決的問題,但您可以顯示退出意圖彈出窗口,以便在該產品重新入庫時獲得通知。

使用 URL 作為變量來傳遞您用於彈出式提供程序的任何形式,以便您知道他們所追求的產品#。

我可以繼續講下去,但希望這些示例有助於更好地了解如何抓取自己的搜索結果,以便更好地了解他們為用戶提供的體驗類型。

注意:您可能已經註意到我切換了從這裡提取的站點。 當我開始寫這篇博文時,第一個站點使用了不同的搜索提供程序,然後它發生了變化,我想展示一個基於 XPATH 與深入研究其他方法的更好示例(這通常是最可靠的方法,以及 CSS選擇器)。

第二個注意事項:在 Google Analytics 中過濾掉您的爬蟲的 IP 地址,這樣您就不會將自己計入您的網頁瀏覽量中。 如果您在窗口加載後 2-3 秒觸發您的綜合瀏覽量標籤,則無需擔心像這樣的爬蟲或機器人流量(感謝您,這是一個更有用的數據真相)。

擴展+自動化此過程的領域

你們中的一些人可能會說,“這不是自動化的,我不想手動執行此操作。”

這是一個完全正確的觀點。 我個人不介意,因為我的大多數客戶都沒有返回數百萬個搜索結果來保證每週(或更多)執行此操作。 這通常是我與 Google Analytics 一起執行的每月或每季度的任務,以查看趨勢和模式是否正在發生變化。

如果你更懂技術,你可以堅持使用 Screaming Frog 並設置一個 VPS 解決方案來在雲中運行自動抓取,並在完成後將結果推送到 Google BigQuery。 SF對此有很好的指導。

還有其他一些更“交鑰匙”的解決方案,而且肯定更少動手,比如 ContentKing(我過去曾使用過它們),它還允許在達到某些閾值時發出“警報”。 (想想沒有返回結果的產品編號搜索 = 電子郵件或 Slack 通知)。

使用 SEO 爬蟲尋找的其他領域

希望這讓您更加了解使用 SEO 爬蟲獲取優化見解的可能性。 (尖叫的青蛙只是其中之一,但我推薦的)。

內部搜索結果只是我使用爬蟲的一小部分。 爬蟲可以為您找到更多內容。 在與客戶合作時,我以許多不同的方式使用它們。

如果您對此或其他任何與 CRO 相關的具體問題或意見,請隨時通過 LinkedIn、Twitter 或電子郵件與我聯繫:[email protected]。