什麼是 Robots.txt:定義、重要性和示例

已發表: 2022-07-14您可能聽說過 Google 會抓取我們的網站和 Internet 上的頁面,然後將它們顯示在他們的搜索結果頁面上。

好吧,robots.txt 告訴 Google 哪些網站遵循他們的算法,哪些沒有。 在本指南中,我們分享了您需要了解的有關 robots.txt、示例及其工作原理的所有信息。

什麼是 Robots.txt?

Robots.txt 是網站管理員的文本文件,用於指導網絡機器人(通常是搜索引擎機器人)抓取其域中的頁面。 換句話說,robots.txt 文件是一組機器人指令。

Robots.txt 包含在大多數網站的源代碼中。

robots.txt 文件是機器人排除協議 (REP) 的一部分。 它定義了機器人如何抓取網頁、查找和索引內容,並將該信息提供給需要它的人。

Robots.txt 幫助搜索引擎機器人了解他們應該在您的網站上抓取哪些 URL。

為什麼 Robots.txt 很重要?

如何.txt 可以幫助您主要有三個原因:

- 最大化抓取預算:抓取預算是谷歌機器人在一個時間範圍內索引的頁面數量。 Robots.txt 可以幫助阻止不重要或重複的內容頁面,並且只關注對您很重要的頁面,從而最大限度地提高抓取預算並提高可見性。

- 避免資源索引: Robots.txt 可以索引或取消索引資源,例如 PDF 或圖像。 因此,可以使用 noindex 或受密碼保護的頁面來阻止頁面或資源。 您可以使用 Google 搜索控制台檢查已編入索引的頁面,並查看機器人是否會抓取您要編入索引的頁面。

- 阻止不重要的頁面:您網站上的某些頁面不希望在 Google 搜索結果中顯示。 這些可能是登錄頁面或您網站的暫存/測試版本。 使用 robots.txt,您可以屏蔽這些頁面並只關注重要的頁面。

Robots.txt 示例

robots.txt 的一些示例是:

用戶代理:Googlebot

禁止:/nogooglebot/

用戶代理: *

允許: /

站點地圖:http://www.example.com/sitemap.xml

同樣,對於 Bing 搜索引擎,它是:

用戶代理:Bingbot

禁止:/example-subfolder/blocked-page.html

語法幫助爬蟲避免對某個頁面的爬取。

值得注意的是,每個子域都需要自己的 robots.txt 文件。

例如,雖然 www.cloudflare.com 有自己的文件,但所有 Cloudflare 子域(blog.cloudflare.com、community.cloudflare.com 等)也需要自己的文件。

Robots.txt 文件如何工作?

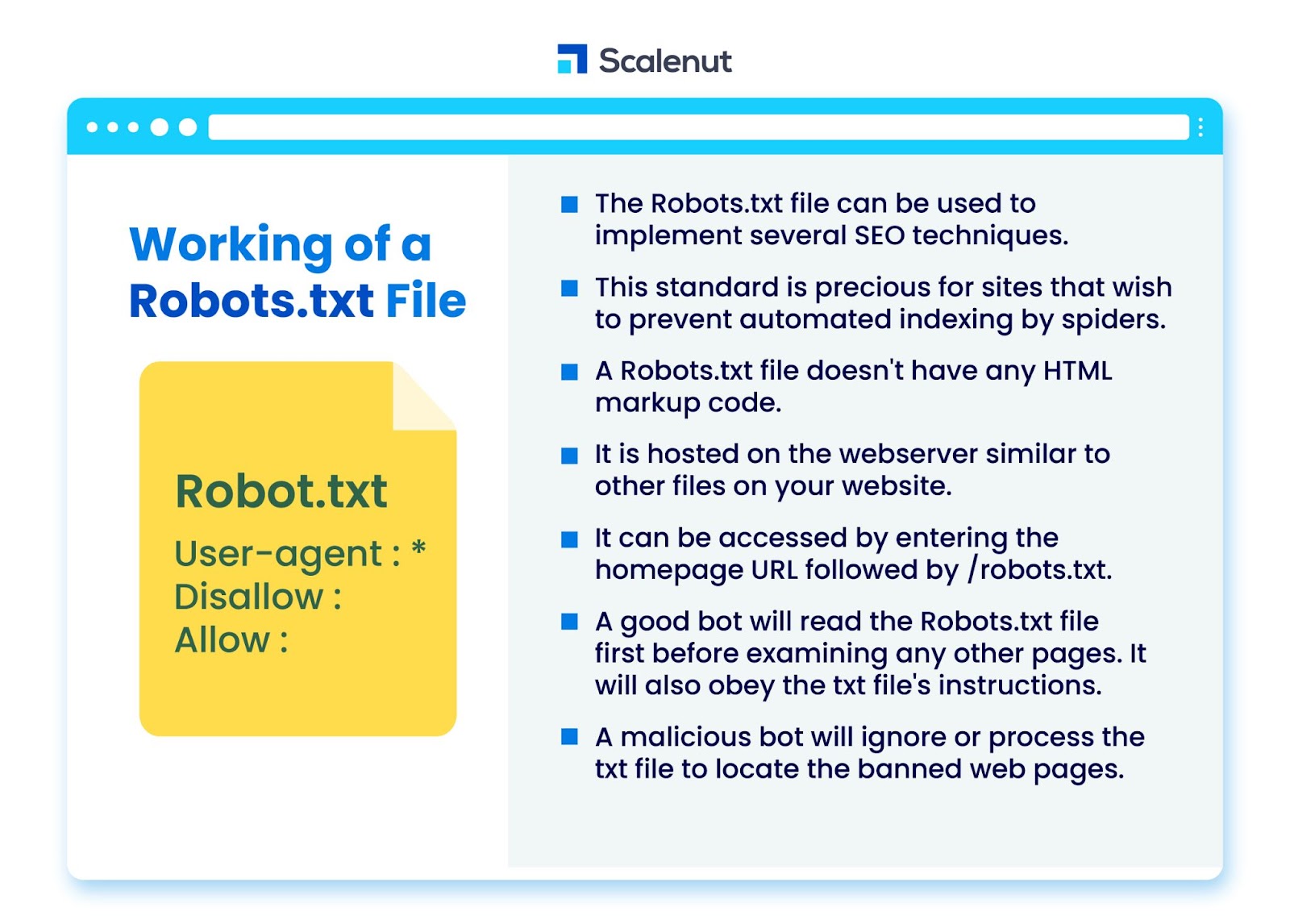

robots.txt 文件可用於實現多種搜索引擎優化 (SEO) 技術,例如未編入索引的頁面或 robots txt 不允許機器人程序訪問網站的所有或特定部分。

該標準對於希望防止蜘蛛通過自動過程(例如使用自動網絡爬蟲的搜索和頁面排名軟件)索引其內容的網站特別有價值。

robots.txt 是沒有 HTML 標記代碼的文件。 它託管在網絡服務器上,就像您網站上的其他文件一樣。

可以通過輸入主頁 URL 後跟 /robots.txt 來訪問它。 一個一般的例子是 https://www.xyz.com/robots.txt。

由於該文件未鏈接到站點上的其他任何位置,因此訪問者不太可能遇到它,但大多數網絡爬蟲機器人會在索引站點的其餘部分之前查找它。

一個好的機器人,例如穀歌爬蟲或新聞提要機器人,會先閱讀 robots.txt 文件,然後再檢查網站上的任何其他頁面並遵守說明。

惡意機器人將忽略或處理 robots.txt 文件以查找被禁止的網頁。

Robots.txt 阻止

Robots.txt 包含指令,用於通知機器人在由 Googlebot 索引的其他可搜索網站上的任何阻止規則,這些規則旨在阻止爬蟲訪問包含某些內容的頁面。

它不會影響只瀏覽網站而不抓取它們的普通用戶或機器人。

隨著時間的推移,網站已經使用這種方法阻止了移動應用程序、JavaScript 和他們網站的其他部分,同時仍然允許一些元素,如圖像。

Robots.txt 文件中使用了哪些協議?

協議是一種在網絡中傳輸指令或命令的格式。 Robots.txt 文件採用多種協議。 主要協議稱為機器人排除協議。

它指示機器人避開哪些網站和資源。

站點地圖協議是用於 robots.txt 文件的另一種協議。 這可以被認為是機器人包含的協議。

站點地圖通知網絡爬蟲他們可以訪問哪些頁面。 這有助於確保爬蟲機器人不會忽略任何關鍵頁面。

什麼是站點地圖?

站點地圖是一個 XML 文件,描述了網絡爬蟲用來顯示您網站頁面的信息。 站點地圖列出了您網站上的所有 URL,包括它們的標題和描述,以及其他相關信息。

本文檔幫助搜索引擎正確索引這些項目,以便訪問者可以使用搜索引擎或其他導航系統快速找到它們。

什麼是用戶代理?

用戶代理 user-agent: *disallow: /nogooglebot/ user-agent user-agent: Googlebot

禁止所有 robots.txt 規則,無論用戶代理如何。 這將阻止任何網絡爬蟲訪問您的網站。 這最常用於對隱私問題敏感的網站(因此不希望其用戶的數據暴露)。

常見的搜索引擎機器人用戶代理名稱包括:

谷歌:

- 谷歌機器人

- Googlebot-Image(用於圖像)

- Googlebot-新聞(新聞)

- Googlebot-Video(用於視頻)

必應:

- 兵機器人

- MSNBot-Media(用於圖像和視頻)

百度:

- 百度蜘蛛

什麼是 .txt 文件?

TXT 是許多文本編輯器支持的文本文件擴展名。

文本文件沒有這樣的靜態定義,但有幾種流行的格式,包括 ASCII(一種跨平台格式)和 ANSI(用於 DOS 和 Windows 平台)。 TXT 是 TeXT 的縮寫。 Text/plain 是 MIME 類型。

在文本文件 robots.txt 中,每個規則都指定了一種 URL 模式,所有爬蟲或指定爬蟲都可以訪問這些 URL。

每行應以一個冒號 (:) 開頭並包含 1-3 行,忽略空白行。 每一行都被解釋為一個文件名,它可以是絕對的或相對於它所在的目錄。

Web Robots 是否與 Robots.txt 相同?

一些搜索引擎可能不支持 txt 指令。

robots.txt 文件中的說明無法強制爬蟲訪問您的網站; 由爬蟲跟隨它們。 相比之下,Googlebot 和其他知名網絡爬蟲遵循 robots.txt 文件中的規則。

如何實現 Robots.txt?

robots.txt 文件幾乎可以在任何文本編輯器中實現。 例如,記事本、TextEdit、vi 和 emacs 都可能生成合法的 robots.txt 文件。

以下是遵循 robots.txt 的規則:

- 文件名應為 robots.txt。

- robots.txt 文件可用於限制對子域(例如 https://website.example.com/robots.txt)或非標準端口的訪問。

- robots.txt 文件必須採用 UTF-8 格式(包括 ASCII)。 Google 可能會拒絕不在 UTF-8 範圍內的字符,這可能會使 robots.txt 法規失效。

- robots.txt 文件通常位於應用它的網站主機的根目錄中。 要對所有 URL(例如 https://www.example.com/)啟用抓取,robots.txt 文件必須位於 https://www.example.com/robots.txt。 它不能放在子目錄中(例如,https://example.com/pages/robots.txt)。

Robots.txt 文件的限制

以下是 robots.txt 文件的限制:

- 所有搜索引擎均不支持 Robots.txt:Robots.txt 文件無法強制爬蟲訪問您的網站; 由爬蟲跟隨它們。 雖然 Googlebot 和其他值得信賴的網絡抓取工具會遵循 robots.txt 文件中的說明,但其他抓取工具可能不會。

- 不同的爬蟲對語法的解釋不同:雖然信譽良好的網絡蜘蛛遵循 robots.txt 文件中的指令,但每個爬蟲對指令的解釋可能不同。

- 如果不允許的頁面鏈接到其他頁面,則可以將其編入索引:雖然 Google 不會抓取或索引 robots.txt 文件限制的內容,但如果它是從 Internet 上的其他位置鏈接的,它可能會找到並索引一個不允許的 URL。

因此,URL 地址和其他公開可用的信息(例如頁面鏈接中的錨文本)可能仍會出現在 Google 搜索結果中。

常問問題

Q1。 robots.txt 在網站上的什麼位置?

答:robots.txt 文件通常放置在您網站的根目錄中,但它可以位於您網站上您想要限制訪問的任何位置。

Q2。 是否需要 robots.txt 文件?

答:簡短的回答是否定的。 網站不需要 robots.txt 文件。 如果機器人訪問您的網站並且它沒有 robots.txt 文件,它將像往常一樣抓取和索引頁面。 僅當您想要更好地控制抓取的內容時,才需要 .txt 文件。

Q3。 robots.txt 安全嗎?

回答:robots.txt 文件本身並沒有安全風險,正確使用它可以代表非安全原因的良好做法。 您不應期望所有網絡機器人都會遵循文件中的說明。

Q4。 訪問 robots.txt 是否違法?

答:robots.txt 文件是網站所有者默示的許可。 如果您知道 robots.txt 文件,那麼在未經許可的情況下繼續抓取他們的網站可能會被視為未經授權的訪問或黑客攻擊。

Q5。 robots txt 中的抓取延遲是什麼?

Ans: crawl-delay 指令是一種告訴爬蟲放慢速度的方法,這樣網絡服務器就不會超載。

結論

Robots.txt 是一個功能強大的簡單文件。 如果你知道如何使用它,它可以幫助 SEO。 創建正確類型的 robots.txt 意味著您也在改善您的 SEO 和用戶體驗。

如果您允許機器人抓取正確的內容,機器人將能夠以您希望的方式在 SERP 中呈現您的內容。

如果您願意了解更多關於 SEO 和重要因素的信息,請查看許多其他 Scalenut 博客。