整體網站健康的快速和骯髒的 11 步技術 SEO 審計

已發表: 2020-02-27技術 SEO 很重要,因為它是任何項目的起點。 從 SEO 專家的角度來看,每個網站都是一個新項目。 一個網站應該有堅實的基礎才能獲得良好的結果並達到SEO中最重要的KPI,如排名。

每次我開始一個新項目時,我做的第一件事就是技術 SEO 審核。 大多數情況下,一旦重新抓取網站,修復技術問題就會得到驚人的結果。

當人們談論內容和更多內容時,我覺得很有趣,但他們對技術 SEO 隻字不提。 有一件事是肯定的,網站健康和技術 SEO 是 2020 年至關重要的兩件事。我並不是說內容不重要。 是的,但如果不解決網站上的技術問題,我認為內容不能帶來結果。

我見過重要頁面被 robots.txt 文件中的指令屏蔽的情況,或者最重要的類別或服務頁面被 noindex、nofollow 等元機器人破壞或屏蔽。 如果不優先解決這些問題,怎麼可能取得成功?

看到不知道如何識別技術問題以報告給網絡開發專家進行修復的 SEO 的數量可能會令人驚訝。 我記得有一次在公司領域工作時,我創建了一份技術 SEO 審核清單供我的團隊使用。 那時,我意識到手頭有一張這樣的快速修復表可以極大地幫助團隊並為客戶帶來快速的提升。 這就是為什麼我認為投資可以幫助您進行技術 SEO 診斷和建議的工具/軟件至關重要。

讓我們開始動手實踐如何進行快速技術 SEO 審核,這將產生重大影響。 這是一個快速練習,即使您不是專業人士,也需要大約一個小時才能完成。 對我來說,使用像 OnCrawl 這樣的技術 SEO 工具可以在五分鐘內快速完成所有事情,而無需做所有的手動工作,這讓我的生活變得輕鬆。

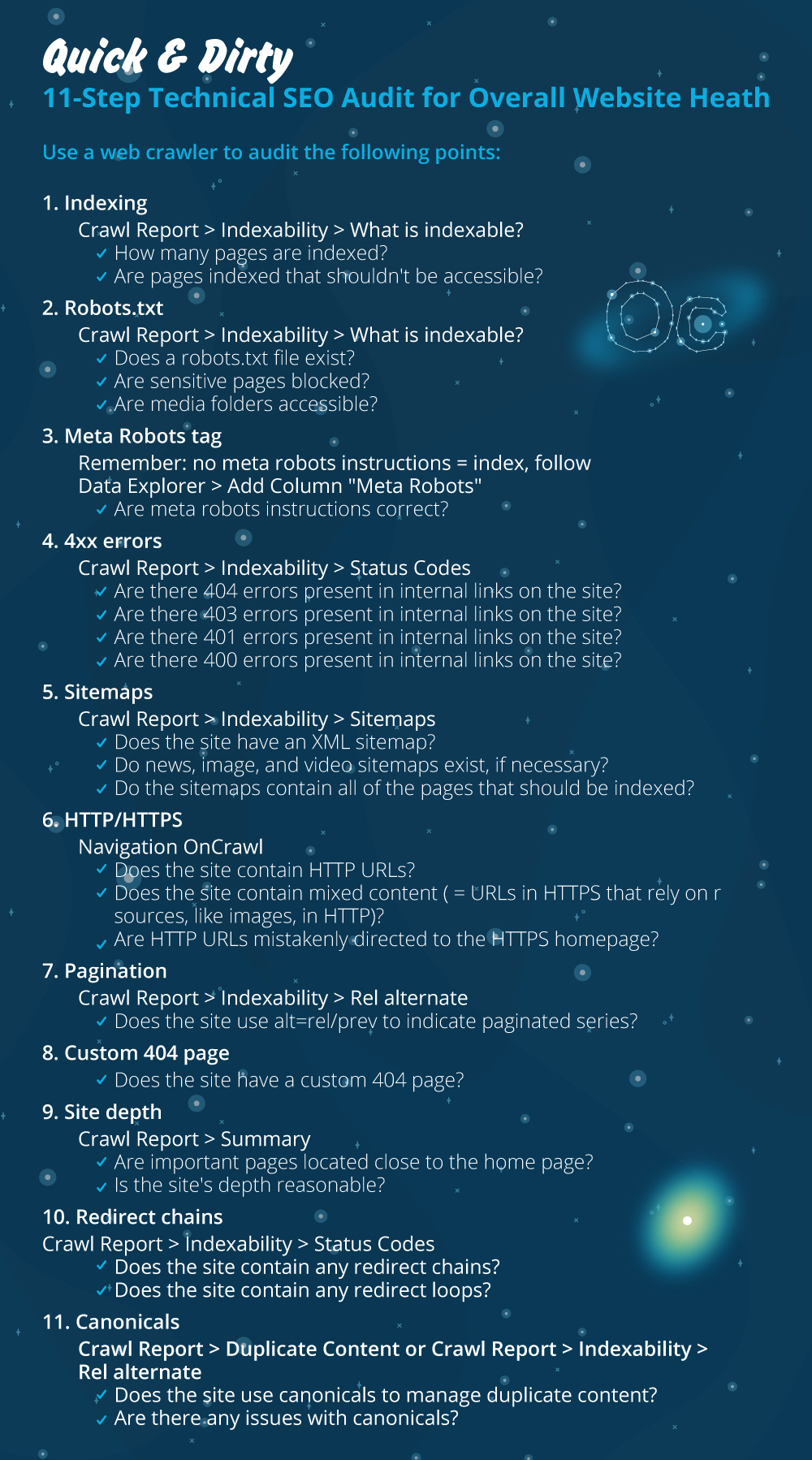

在進行技術 SEO 審核時,我將回顧最重要的檢查事項。 還有更多我們可以檢查頁面問題的事情,但我只想關注那些會造成索引問題和爬行浪費預算的事情。 優先考慮這是確保最重要的頁面將被 Googlebot 抓取的方法。

- 索引

- 機器人.txt 文件

- 元機器人標籤

- 4xx 錯誤

- 站點地圖

- HTTP/HTTPS(網站安全、混合內容和重複內容問題)

- 分頁

- 404頁

- 場地深度和結構

- 長重定向鏈

- 規範標籤實現

1) 索引

這是首先要檢查的。 很多時候索引可能會受到插件配置或任何小錯誤的影響,但對可查找性的影響可能是巨大的,因為今天有超過 61.6 億個網頁被索引。 您需要了解任何搜索引擎都在努力,甚至 Google 也需要優先考慮與用戶體驗最相關的頁面。 如果您不考慮讓 Googlebot 更輕鬆,您的競爭對手會這樣做並獲得更多信任,而這正是健康網站所帶來的。

當存在索引問題時,您的網站健康問題將反映在自然流量的損失上。 索引過程意味著搜索引擎抓取網頁並組織稍後在 SERP 中提供的信息。 結果取決於用戶意圖的相關性。 如果一個網頁不能或有爬行問題,這將有利於同一利基中的其他頁面具有優勢。

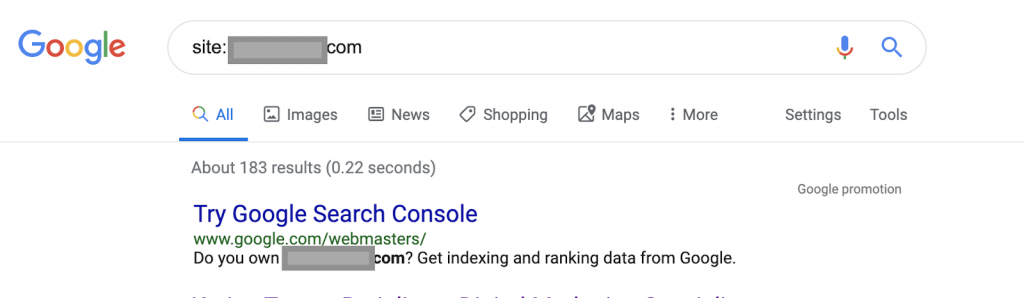

例如使用搜索運算符:

網站:www.abc.com

該查詢將返回由 Google 索引的 183 個頁面。 這是對 Google 已編入索引的頁面數量的粗略估計。 您可以查看 Google Search Console 的確切數字。

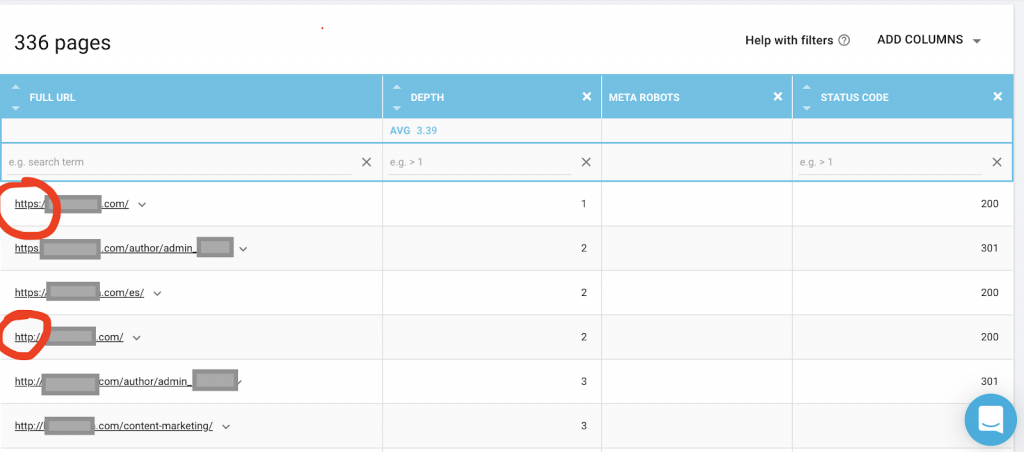

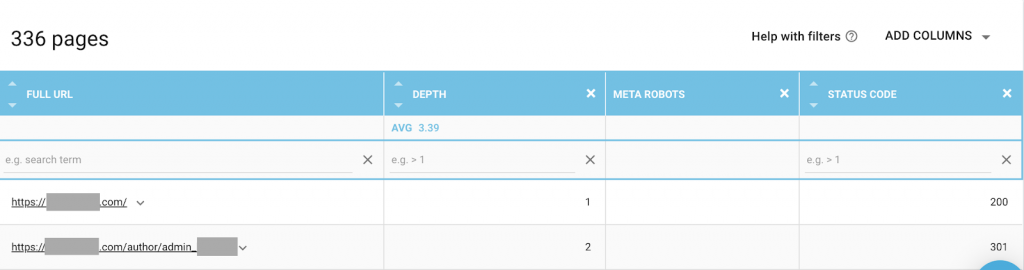

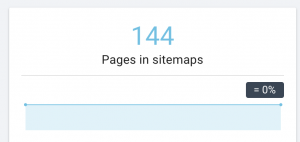

您還應該使用像 OnCrawl 這樣的網絡爬蟲來列出 Google 可以訪問的所有頁面。 這顯示了一個不同的數字,如下所示:

該網站的可抓取頁面數量幾乎是已編入索引的頁面數量的兩倍。

這可能會揭示重複的內容問題,甚至是 HTTP 和 HTTPS 問題之間的網站安全版本問題。 我將在本文後面討論這個問題。

在這種情況下,網站從 HTTP 遷移到 HTTPS。 我們可以在 OnCrawl 中看到 HTTP 頁面已被重定向。 Googlebot 仍然可以訪問 HTTP 和 HTTPS 版本,它可能會抓取所有重複的頁面,而不是優先考慮所有者想要排名的最重要的頁面,從而造成抓取預算的浪費。

被忽視的網站或電子商務網站等大型網站的另一個常見問題是混合內容問題。 長話短說,當您的安全頁面具有從不安全版本加載的媒體文件(最常見的是:圖像)等資源時,問題就會出現。

如何修復它:

您可以要求 Web 開發人員將所有 HTTP 頁面強制為 HTTPS 版本,並使用 301 狀態代碼將 HTTP 地址重定向到 HTTPS。

對於混合內容問題,您可以手動檢查頁面來源並蒐索加載為“src=http://example.com/media/images”的資源,這對於大型網站來說幾乎是瘋狂的。 這就是為什麼我們需要使用技術 SEO 工具。

2) Robots.txt 文件:

robots.txt 文件告訴抓取代理他們不應該抓取哪些頁面。 Robots.txt 規範指南指出文件格式必須是純文本,最大大小為 500KB。

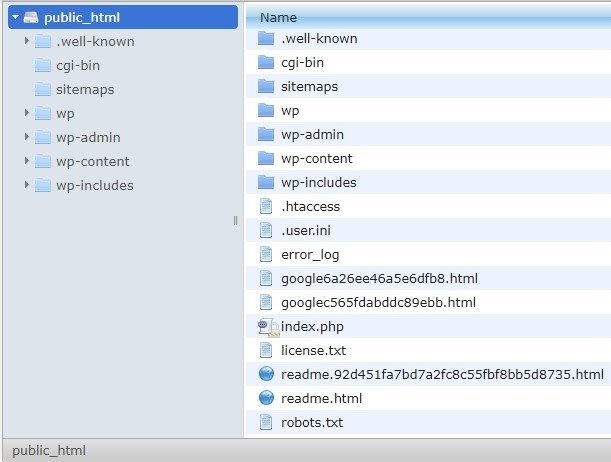

我建議將站點地圖添加到 robots.txt.file。 不是每個人都這樣做,但我相信這是一個很好的做法。 robots.txt 文件必須放在 public_html 中的託管服務器中,並位於根域之後。

我們可以在 robots.txt 文件中使用指令來防止搜索引擎抓取不必要的頁面或包含敏感信息的頁面,例如管理頁面、模板或購物車(/cart、/checkout、/login、博客中使用的 /tag 等文件夾) ,通過在 robots.txt 文件中添加這些頁面。

建議:確保您不會阻止媒體文件夾,因為這會將您的圖像、視頻或其他自託管媒體排除在索引之外。 媒體對於頁面相關性以及圖像或視頻的自然排名和流量非常重要。

3) 元機器人標籤

這是一段 HTML 代碼,用於指示搜索引擎是否對頁面以及該頁面內的所有鏈接進行爬網和索引。 HTML 標記位於網頁的頭部。 機器人有 4 個常見的 HTML 標籤:

- 沒有關注

- 跟隨

- 指數

- 無索引

當沒有元機器人標籤存在時,搜索引擎將默認跟踪並索引內容。

您可以使用最適合您需求的任何組合。 例如,通過使用 OnCrawl,我發現該網站的“作者頁面”沒有元機器人。 這意味著默認情況下方向是(“follow, index”)

這應該是(“noindex,nofollow”)。

為什麼?

每個案例都不一樣,但是這個網站是一個小型的個人博客。 博客上只有一個作者發表,域名是作者的名字。 在這種情況下,“作者”頁面沒有提供任何附加信息,即使它是由博客平台生成的。

另一種情況可能是博客上的類別很重要的網站。 當所有者想要在他或她的博客上對類別進行排名時,元機器人應該是(“關注,索引”)或默認在類別頁面上。

在另一種情況下,對於一個大型知名網站,主要 SEO 專家撰寫文章並被社區關注,Google 中的作者姓名充當品牌。 在這種情況下,您可能希望索引一些作者姓名。

如您所見,元機器人可以以多種不同的方式使用。

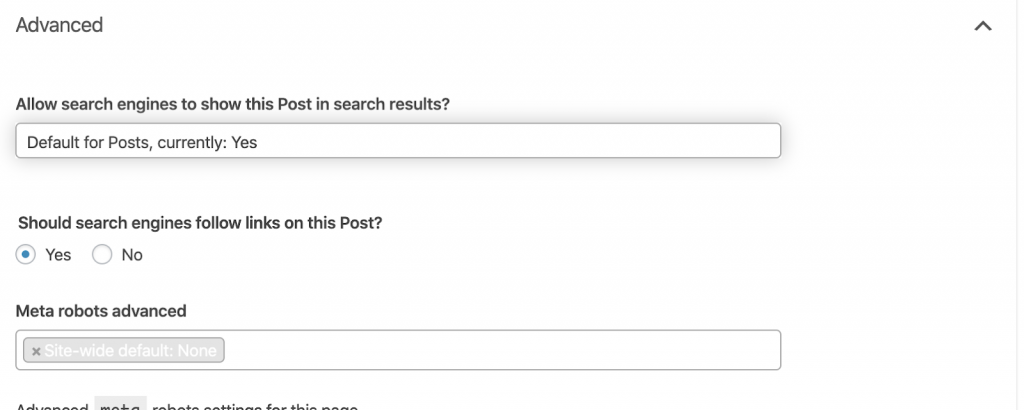

如何修復它:

要求 Web 開發人員根據需要更改元機器人標記。 在上述小型網站的情況下,我可以自己訪問每個頁面並手動更改它。 如果您使用的是 WordPress,則可以從 RankMath 或 Yoast 設置中進行更改。

4) 4xx 錯誤:

這些是客戶端的錯誤,它們可以是 401、403 和 404。

- 404頁面不存在:

當索引的 URL 地址處的頁面不可用時,會發生此錯誤。 它可能已被移動或刪除,並且沒有使用 Web 服務器功能 301 正確重定向舊地址。404 錯誤對用戶來說是一種糟糕的體驗,並且代表了應該解決的技術 SEO 問題。 經常檢查 404 並修復它們是一件好事,而不是讓它們被一遍又一遍地嘗試爬行代理浪費他們的預算。

如何修復它:

如果內容仍然存在,我們需要找到返回 404 的地址並使用 301 重定向修復它們。 或者,如果它們是圖像,則可以將它們替換為保持相同文件名的新圖像。

- 401未經授權

這是一個權限問題。 401 錯誤通常發生在需要身份驗證(例如用戶名和密碼)時。

如何修復它:

這裡有兩個選項:第一個是使用 robots.txt 阻止搜索引擎訪問該頁面。第二個選項是刪除身份驗證要求。

- 403 禁止

此錯誤類似於 401 錯誤。 發生 403 錯誤是因為該頁麵包含公眾無法訪問的鏈接。

如何修復它:

更改服務器中的要求以允許訪問頁面(僅當這是一個錯誤時)。 如果您需要此頁面無法訪問,請從頁面中刪除所有內部和外部鏈接。

- 400 錯誤請求

當瀏覽器無法與網絡服務器通信時會發生這種情況。 錯誤的 URL 語法通常會發生此錯誤。

如何修復它:

查找這些 URL 的鏈接並修正語法。 如果這無法修復,您將需要聯繫 Web 開發人員進行修復。

注意:我們可以使用工具或在 Google 控制台中找到 400 錯誤

5) 站點地圖

站點地圖是網站包含的所有 URL 的列表。 擁有站點地圖可以提高可查找性,因為它可以幫助爬蟲找到並理解您的內容。

我們有不同類型的站點地圖,我們需要確保它們都處於良好狀態。

我們應該擁有的站點地圖是:

- HTML 站點地圖:這將在您的網站上,幫助用戶瀏覽和查找您網站上的頁面

- XML 站點地圖:這是一個幫助搜索引擎抓取您的網站的文件(作為最佳實踐,它應該包含在您的 robots.txt 文件中)。

- 視頻 XML 站點地圖:同上。

- 圖片 XML 站點地圖:也同上。 建議為圖像、視頻和內容創建單獨的站點地圖。

對於大型網站,建議使用多個站點地圖以獲得更好的可抓取性,因為站點地圖包含的 URL 不應超過 50.000 個。

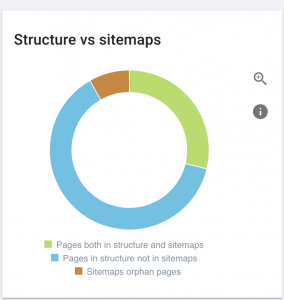

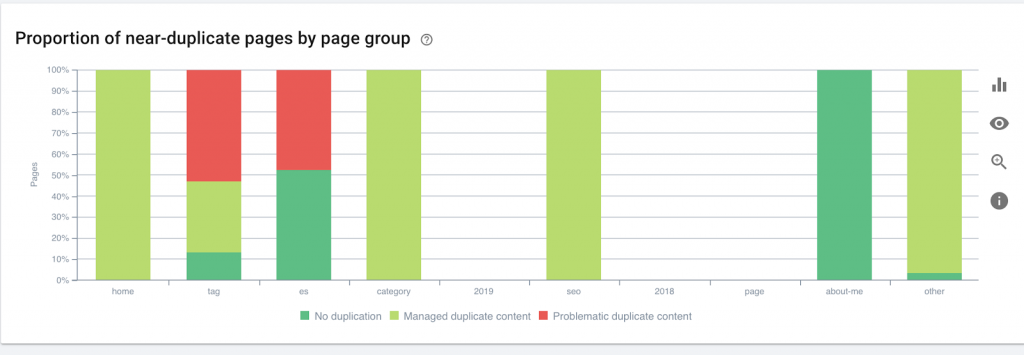

該網站存在站點地圖問題。

我們如何解決它:

我們通過為以下內容生成不同的站點地圖來解決此問題:內容、圖像和視頻。 然後,我們通過 Google Search Console 提交它們,並為該網站創建一個 HTML 站點地圖。 為此,我們不需要網絡開發人員。 我們可以使用任何免費的在線工具來生成站點地圖。

6)HTTP/HTTPS(重複內容)

由於從 HTTP 遷移到 HTTPS,許多網站都存在這些問題。 如果是這種情況,該網站將在搜索引擎中顯示 HTTP 和 HTTPS 版本。 由於這個常見的技術問題,排名被稀釋了。 這些問題還會產生重複的內容問題。

![]()

如何修復它:

要求 Web 開發人員通過強制所有 HTTP 到 HTTPS 來解決此問題。

注意:切勿將所有 HTTP 重定向到 HTTPS 主頁,因為它會生成軟 404 錯誤。 (您應該對 Web 開發人員這麼說;記住他們不是 SEO。)

7) 分頁

這是使用 HTML 標籤(“rel = prev”和“rel = next”)建立頁面之間的關係,它向搜索引擎顯示不同頁面中呈現的內容應該被識別或與單個頁面相關。 分頁用於限制 UX 的內容和技術部分的頁面重量,將它們保持在 3MB 以下。 我們可以使用免費工具來檢查分頁。

分頁應該有自我規範的引用,並指出“rel = prev”和“rel = next”。 唯一重複的信息是元標題和元描述,但開發人員可以更改它以創建一個小算法,這樣每個頁面都會生成一個元標題和元描述。

如何修復它:

要求 Web 開發人員使用自規範標籤實現分頁 HTML 標籤。

Oncrawl 搜索引擎優化爬蟲

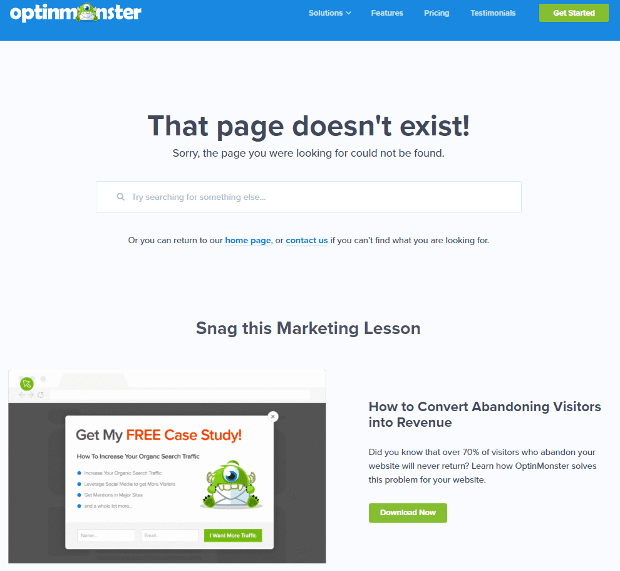

8) 自定義 404 未找到頁面

正如我們之前討論的那樣,404 響應是“未找到”錯誤,它會將用戶帶到斷開的鏈接或不存在的頁面。 這是一個將用戶重定向到正確位置的機會。 自定義 404 頁面有很多很好的例子。 這是必須的。

這是一個很棒的 404 自定義頁面的示例:

如何修復它:

創建一個自定義的 404 頁面:考慮添加一些令人驚奇的東西。 讓這個錯誤成為您業務的機會。

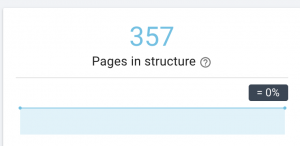

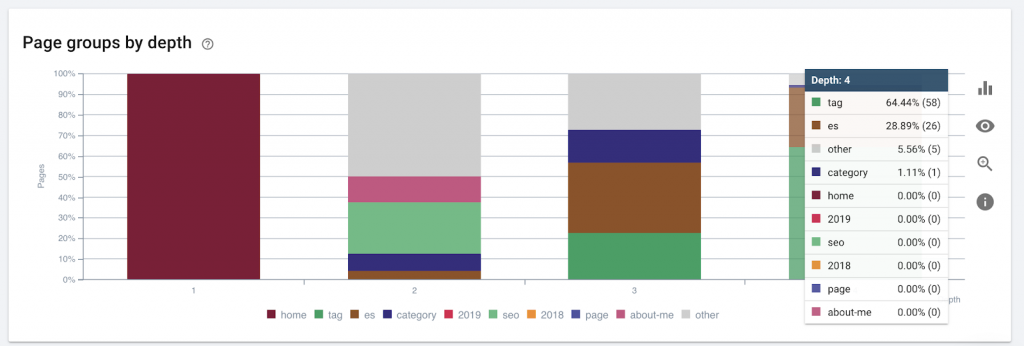

9)場地深度/結構

頁面深度是您的頁面位於根域的點擊次數。 谷歌的 John Mueller 說“離主頁越近的頁面權重越大”。 例如,假設這裡的頁面需要以下導航才能到達:

“地毯”頁面距離主頁僅 4 次點擊。 建議不要讓頁面距離家超過 4 次點擊,因為搜索引擎很難抓取更深的頁面。

此圖按深度顯示頁面組。 它可以幫助我們了解網站的結構是否需要重新設計。

如何修復它:

最重要的頁面應該最靠近用戶體驗的主頁,以便用戶輕鬆訪問並獲得更好的網站結構。 在創建網站結構或重組網站時考慮到這一點非常重要。

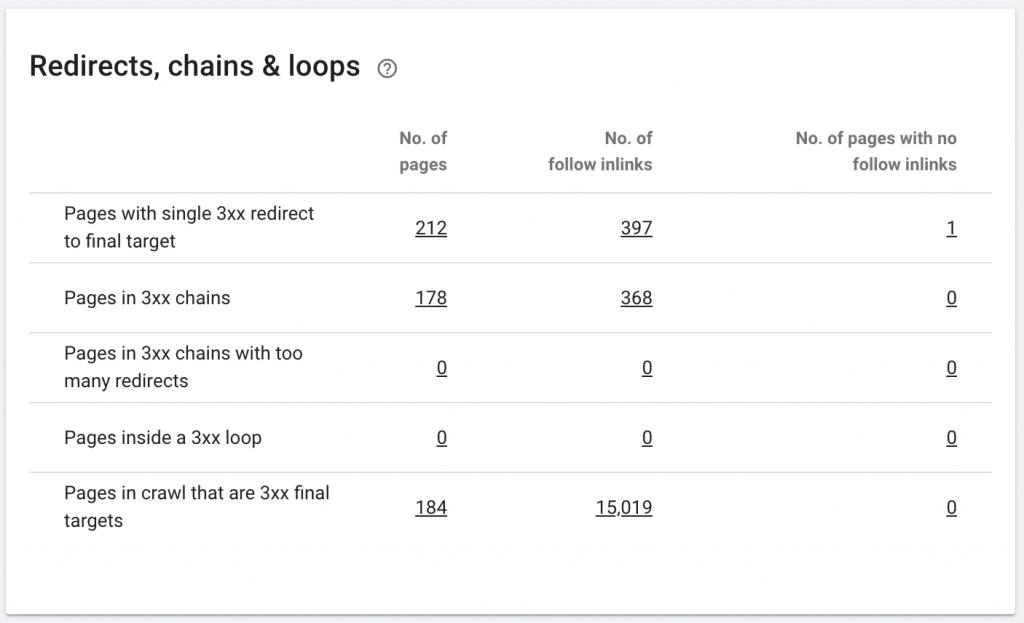

10. 重定向鏈

重定向鍊是指在 URL 之間發生一系列重定向。 這些重定向鏈也可能產生循環。 它還會給 Googlebot 帶來問題並浪費抓取預算。

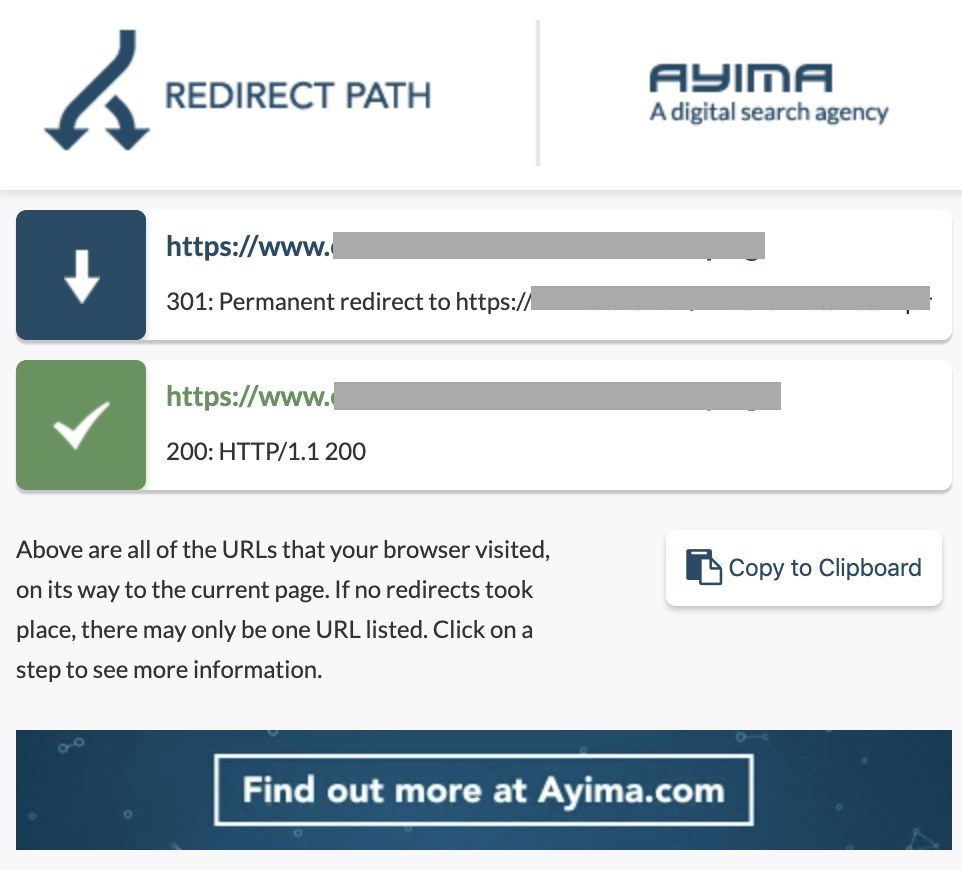

我們可以使用 Chrome 擴展重定向路徑或在 OnCrawl 中識別重定向鏈。

如何修復它:

如果您使用的是 WordPress 網站,解決此問題非常容易。 只需轉到重定向並查找鏈 - 如果這些更改發生在 2-3 個月前,則刪除鏈中涉及的所有鏈接,並將最後一個重定向保留到當前 URL。 如果需要,Web 開發人員還可以通過在 .htacces 文件中進行所需的所有更改來幫助解決此問題。 您可以檢查和更改 SEO 插件中的長重定向鏈。

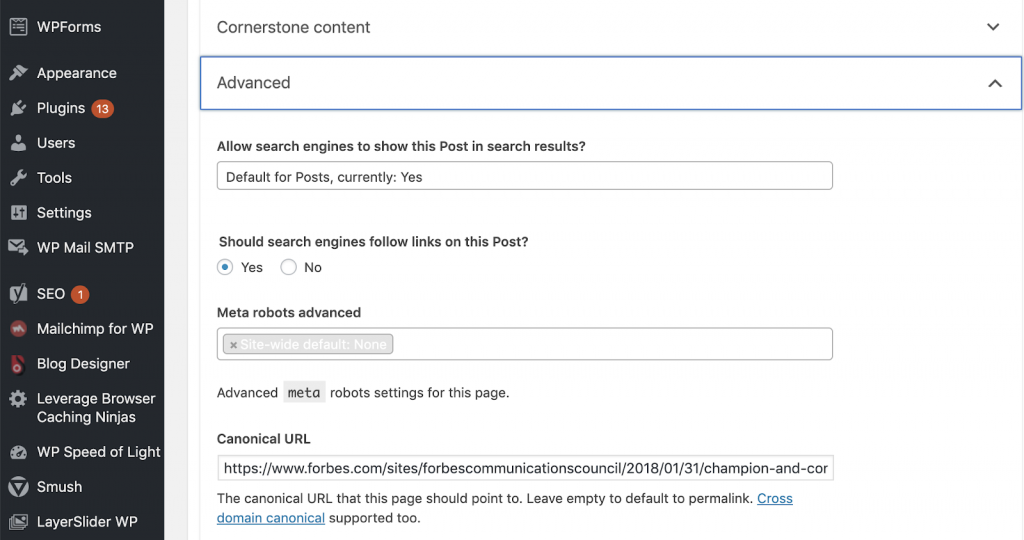

11) 規範

規範標籤告訴搜索引擎該 URL 是另一個頁面的副本。 這是許多網站上都存在的一個大問題。 沒有以正確的方式實施規範,或者根本沒有實施它們,將產生重複的內容問題。

規範通常用於電子商務網站,其中可以在不同類別中多次找到產品,例如:尺寸、顏色等。

您可以使用 OnCrawl 來判斷您的頁面是否具有規範標籤,以及它們是否被正確實施。 然後,您可以探索和糾正任何問題。

我們如何解決它:

如果我們在 WordPress 中工作,我們可以使用 Yoast SEO 來解決規範問題。 我們轉到 WordPress 儀表板,然後轉到 Yoast -setting - 高級。

運行您自己的審核

想要開始研究技術 SEO 的 SEO 需要遵循快速步驟指南來改善 SEO 健康。 在 2019 年 10 月的紐約全球營銷日上,與康泰納仕 (Conde Nast) 受眾增長副總裁兼 NewzDash 創始人 John Shehata 談論技術 SEO。

這是他對我說的:

“SEO行業的很多人都不是技術人員。 現在,並不是每個 SEO 都了解如何編碼,而且很難要求人們這樣做。 一些公司,他們所做的是僱傭開發人員並培訓他們成為 SEO 以填補技術 SEO 的差距。”

在我看來,不具備完整代碼知識的 SEO 仍然可以通過知道如何運行審計、識別關鍵元素、報告、要求 Web 開發人員實施以及最終測試更改來在技術 SEO 方面做得很好。

準備好開始了嗎? 下載這些主要問題的清單。