從 A/B 測試結果中學習和改進的 7 個關鍵步驟

已發表: 2021-04-13

您的 A/B 測試剛剛完成,但您沒有看到預期的結果。

其他人都在分享案例研究,他們看到只需更改按鈕顏色或進行微小調整即可獲得巨大提升,但您的測試在轉換方面沒有任何改善,或者更糟糕的是,它似乎反而虧本了,現在您需要把這個介紹給你的老闆。

好吧,如果您的測試實際上不是失敗者怎麼辦?

如果它是偽裝的勝利者怎麼辦?

如果它是一個失敗者,如果失敗的測試實際上是一件好事呢?

在本指南中,我們將幫助您更深入地了解 A/B 測試結果,以便您可以分析和分解它們以找到黃金。

我們將介紹為什麼從您的 A/B 測試中學習如此重要,以及為什麼失敗者可以為您帶來銷售。 我們分享了一個您可以遵循的流程,這樣您就可以逐步全面分析您的測試,並對您所看到的、勝利或失敗充滿信心。

更好的是,我們將幫助您擺脫對數據的焦慮和不想檢查您的分析,轉變為有信心與您的同行分享您的結果。

所以讓我們潛入...

為什麼需要從 A/B 測試中學習?

首先,其中涉及明顯的成本。 每個測試都需要花錢來設置。 如果您丟失了變體,那麼您也會看到該變體的銷售額下降。

事情是這樣的:

A/B 測試(以及一般的 CRO)不僅僅是為了賺更多的錢。 這是關於購買數據。 您的受眾數據可以幫助您更好地了解他們並提供更好的產品和服務。 然後,這會帶來更多的銷售和改善的客戶體驗,甚至是對新產品報價的洞察。

你越了解你所服務的人,你就會做得越好。 這就是為什麼經常測試和測試如此重要的原因——即使大多數測試都失敗了。

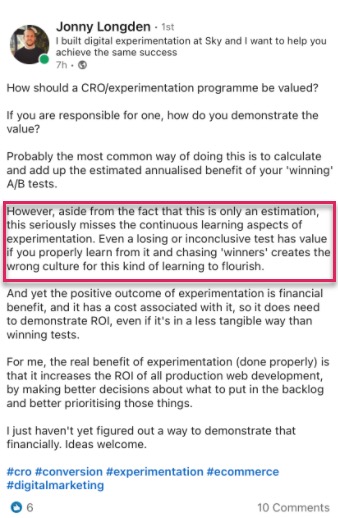

我們也不是唯一有這種想法的人。

事實上,當我們使用我們的工具查看 28,304 次測試的內部數據以及與專家測試機構的對話時,我們發現大多數公司每 10 次測試中只能找到 1 名獲勝者,而代理機構通常會在每 10 次測試中找到 1 名獲勝者。 4.

我知道你在想什麼,

當然,這意味著我每次測試 90% 的時間都在賠錢嗎?

是的,但僅限於一半的測試觀眾。 另一半仍在查看您的網站並照常進行轉換。

此外,您獲得的數據可以幫助您找出什麼不起作用,這樣您就可以了解什麼是有效的。 您測試、學習、再次測試並繼續前進,直到找到有效的方法。

那些 10% 的測試確實獲勝?

它們可以提供持續的增量提升,可以一次又一次地改進,然後在每個類似頁面上擴展到您的站點以產生更大的影響。

這就是在數字平台上看到轉化率提升的美妙之處。 僅提升 1% 的絕對規模就可能對您的業務產生巨大影響,無論是現在還是未來的所有流量。 事實上,傑夫·貝佐斯 (Jeff Bezos) 也有同樣的想法,在其年度股東報告中稱亞馬遜及其測試和改進目標是“世界上最容易失敗的地方”:

假設有 10% 的機會獲得 100 倍的回報,您應該每次都下注。 但是十有八九你還是會錯。

傑夫貝索斯,亞馬遜

更多的銷售和更好的洞察力並不是 A/B 測試的唯一好處。

運行測試可以讓你擺脫障礙主題和群體理論。 與其花幾個月的時間討論可能的網頁設計更改而無所事事,不如採取行動並對其進行測試,讓您的團隊騰出時間專注於其他事情。 (一定要在直播之前測試它的效果!)

不僅如此,您還可以了解只有 A/B 測試才能告訴您的有關您的受眾的新知識。

理論制定和客戶調查很棒,但最重要的是您的受眾在您的網站上實際所做的事情,而不僅僅是他們所說的內容。 了解您的測試有助於您證明或反駁這些想法和反饋。

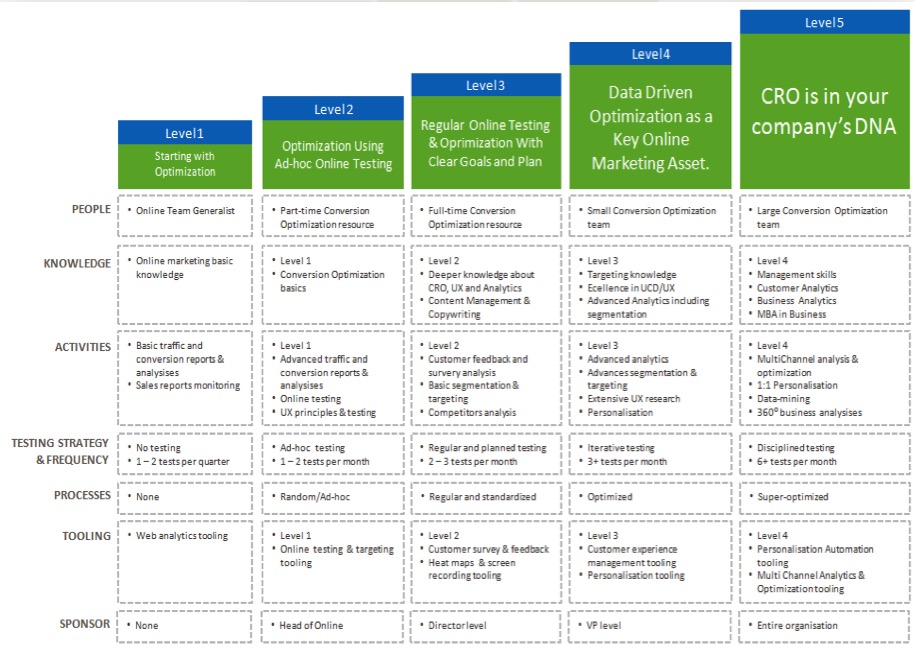

您對結果了解得越多,您對測試就越有信心,從而使您的 CRO 工作“成熟”並更頻繁地運行測試,甚至可能開始在內部建立測試團隊。

現在您看到了從每個 A/B 測試中學習的好處,讓我們通過一個簡單的過程來分析您運行的每個新測試……

從 A/B 測試中學習的 7 步流程(以及可用於改進未來測試的系統)

我們將其分解為 7 個要遵循的關鍵步驟。

您可能沒有我們在這裡推薦的所有方法或工具,但是,通過查看它們的適用性,您可以評估它們的價值並決定是否要將它們集成到您未來的測試中。

第 1 步:檢查您的數據是否準確、有效 + 重要

這是整個過程中最重要的部分。 確保您在測試中獲得的信息既準確又有效,這樣您就可以對結果充滿信心。

那麼,您如何確保您的測試結果提供您可以信任的數據呢?

好吧,你可以做一些事情......

驗證您的工具精度

現在,大多數人都錯過了這一點。 如果您的網站每月訪問量不超過 10,000,請隨意跳過它。 從技術上講,它不需要開始使用 CRO,並且最適合流量大的網站,但我不會在此處包含它,因為大型網站可以真正看到差異。

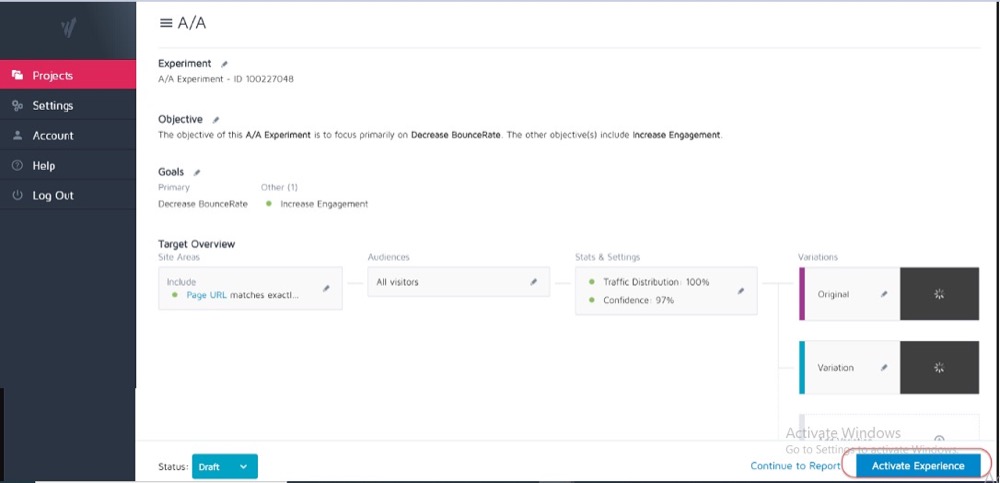

理想情況下,您已經在當前測試工具上運行了 A/A 測試,以查看它的準確性以及是否存在任何問題。

如何?

您使用 2 個相同的網頁副本運行一個簡單的拆分測試,然後跨這 2 個相同的頁面跟踪結果。

因為它們之間沒有區別,所以每個頁面的結果應該是相同的。 但是,該工具以及它如何測量或跟踪您的數據可能會導致一些差異。

提前了解這一點可以幫助您獲得對測試結果準確性的容忍度,並將其用作所有未來測試的指南。

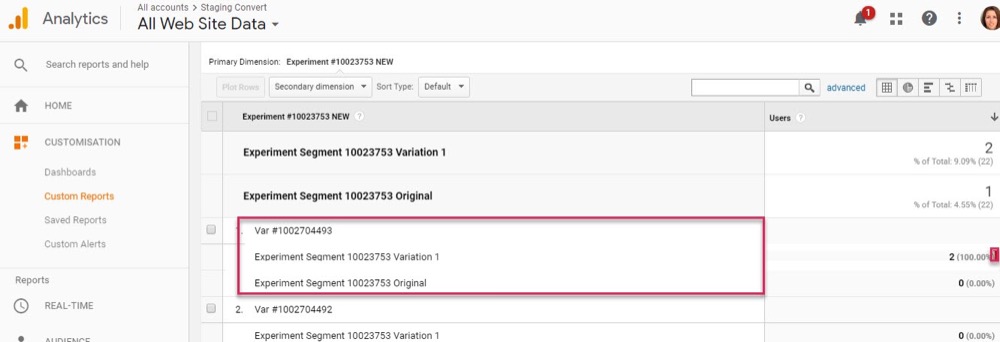

例子

如果您注意到您的 A/A 測試顯示兩個相同頁面之間的轉化率差異為 0.5%,那麼您可能會警惕任何顯示獲勝者的測試結果,而對照和變體之間只有 0.5% 的差異。

您可以設置內部指南,規定測試必須顯示 1% 或更高的提升,然後您才會相信結果。 同樣,當您嘗試新工具或者您認為當前工具可能存在報告問題或設置不正確時,您只需要運行一次 A/A 測試。

A/A 測試最適合大流量站點,因為準確檢查所需的樣本數據可能非常大,但 1% 的誤差差異可能很大。

運行足夠長的測試以有效了解客戶如何與您的網站互動

因此,既然您信任您的工具,您希望運行 2-4 週的測試,即使您獲得足夠的轉化以統計數據能夠在之前關閉它。

為什麼?

因為您的受眾通常會根據一周中的某一天或一個月的某些階段與您的網站進行不同的互動。

例子

如果您的聽眾中的人在星期四獲得報酬,那麼如果您的測試只從星期一到星期三進行,您可能會錯過一個上升,對嗎?

同樣,其他用戶可能會每兩週或每月獲得報酬,如果您的測試運行時間不夠長以將其包含在其中,則會再次扭曲您的結果。 您只需假設您錯過的時間銷售額或流量較低。

你怎麼知道什麼時候結束測試? 閱讀更多關於 A/B 測試統計意義:如何以及何時結束測試

注意可能影響結果的任何內部或外部因素

這些是可能會扭曲您的數據的獨特或預定事件。

例如,如果您的 CEO 或公司出現在新聞中,或者您正在進行任何當前的營銷活動或促銷活動,以及任何外部因素,例如國定假日,甚至是隨機流量高峰。

所有這些都會影響您的網站流量,然後改變您在此期間結果的準確性。

真實的故事:

大約 6 年前,我曾經擁有一家衝浪服裝公司。

有一天,我們的流量突然飆升了大約 800%,跳出率猛增。 我們沒有進行任何新的營銷活動,因此我做了一些調查以找出流量的來源。

事實證明,我們的一件 T 恤的產品名稱與韓國流行樂隊的新歌名稱相同,我們在兩天內對其進行排名並吸引了他們的訪客。

當然,這些新觀眾對我們的產品一點也不感興趣,很快就離開了。

瘋了吧?

還有一次,我的營銷博客開始為一家電視公司的品牌排名,同樣的事情也發生了。 我們從錯誤的受眾那裡獲得了流量高峰。

儘管這是隨機的,但這類事情可能會發生,因此請注意此類外部或內部事件。 您可以隨時檢查分析以查看流量來自何處,然後在一切恢復正常時重新啟動測試。

確保獲得足夠的數據

您希望確保您的測試有足夠的轉化次數來有效地了解它的表現。

擁有一個只有 50 次總轉化並且它們之間只有很小差異的控件和變體不足以深入了解您的受眾——即使測試結果在某種程度上具有統計顯著性。 大多數專家都同意,每個變體大約 300 次以上的轉化通常是一個很好的經驗法則(如果您想稍後進行細分,甚至更多)。

數據集越大,就越容易在測試後分析中找到見解。

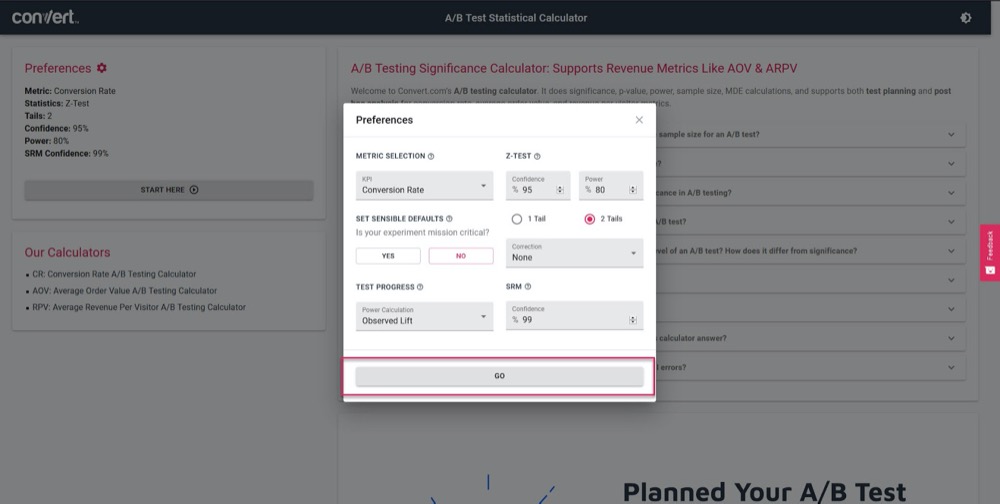

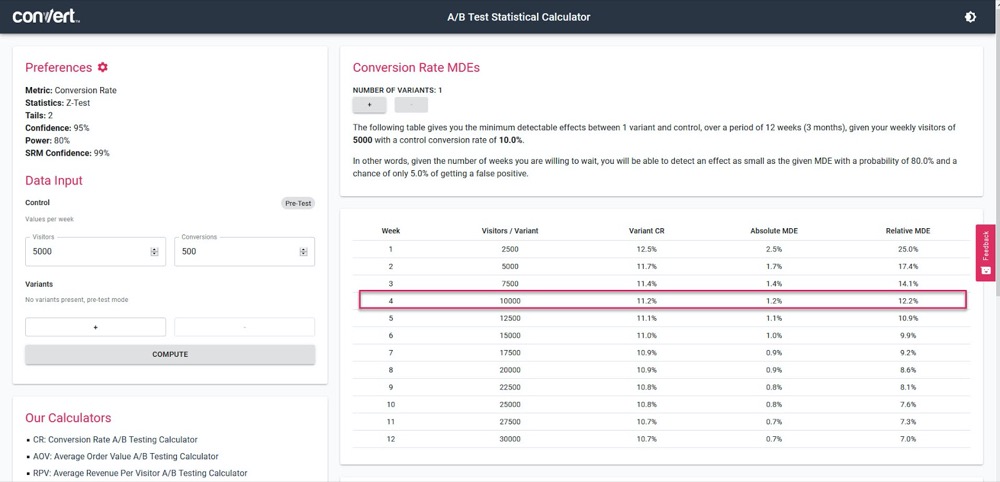

使用我們的 A/B 測試重要性計算器,根據 4 週的銷售週期和您當前的“控制”頁面信息,了解您的測試的準確度。

只需設置您的測試參數:

然後,輸入您的測試每週應該獲得多少流量,以及您當前頁面的轉化次數,然後找出您的測試能夠計算的準確度和提升百分比。

在上面的例子中,我們可以在 4 週後測量低至 1.2% 的提升。 (如果我們想獲得更高的準確率,只需運行更長時間的測試或增加測試中的流量即可。)

獲得具有統計意義的結果

這就是為什麼統計顯著性很重要,但在測試時不是最重要的因素。

是的,您希望確保您的測試運行足夠長的時間以在結果中看到 95-99% 的置信度,但您還希望確保我們上面涵蓋的所有其他因素都得到了滿足。

為什麼?

如果運行時間不夠長,即使是 A/A 測試也可以顯示 95% 的信心認為某個版本優於其相同副本。

(它可能會在某一天隨機看到一個版本的所有轉換,而另一天則沒有。)

太多的新測試人員一旦點擊“stat sig”就會停止活動,從而導致他們獲得虛假數據。 這就是為什麼我們建議您獲得 95% 或更高的統計顯著性,但也要在 2-4 個銷售週期、300 多次轉化和足夠大的樣本量下運行測試。

如果你做了所有這些,那麼你可以非常確定你可以相信你的測試會給你有效和準確的結果。

讓測試運行以使您滿足這些標準有多重要,我怎麼強調都不為過。

過早調用測試會給您提供錯誤信息,從而導致:

- 由於您沒有足夠的信息,找不到潛在的贏家,

- 運行效果較差的廣告系列,因為您認為它們是贏家,但實際上轉化率較低,

- 或者更糟糕的是,您可能會對這些結果產生錯誤的信心,然後使用您學到的知識將其擴展到您網站的其他部分,從而加劇這些負面影響。

您知道您的 A/B 測試工具如何得出關於獲勝變體的結論嗎? 單擊此處使用我們的 A/B 測試重要性計算器。

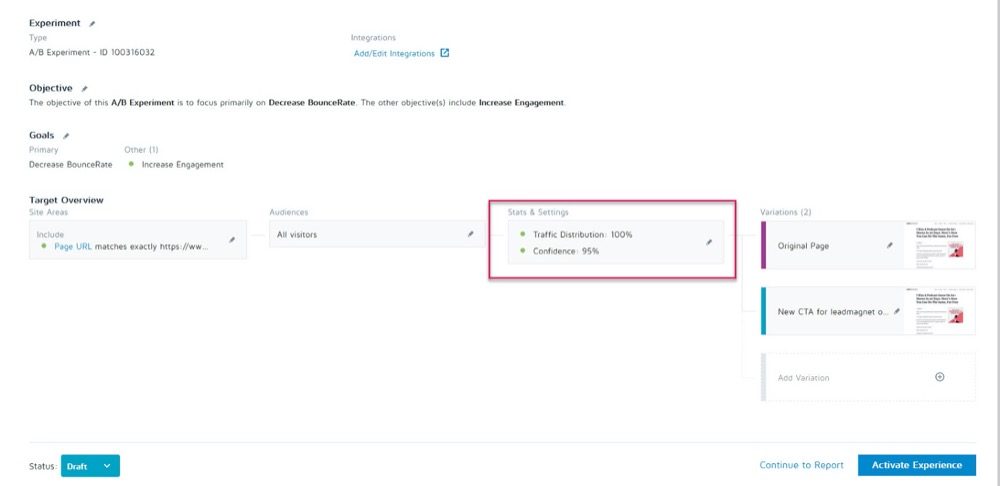

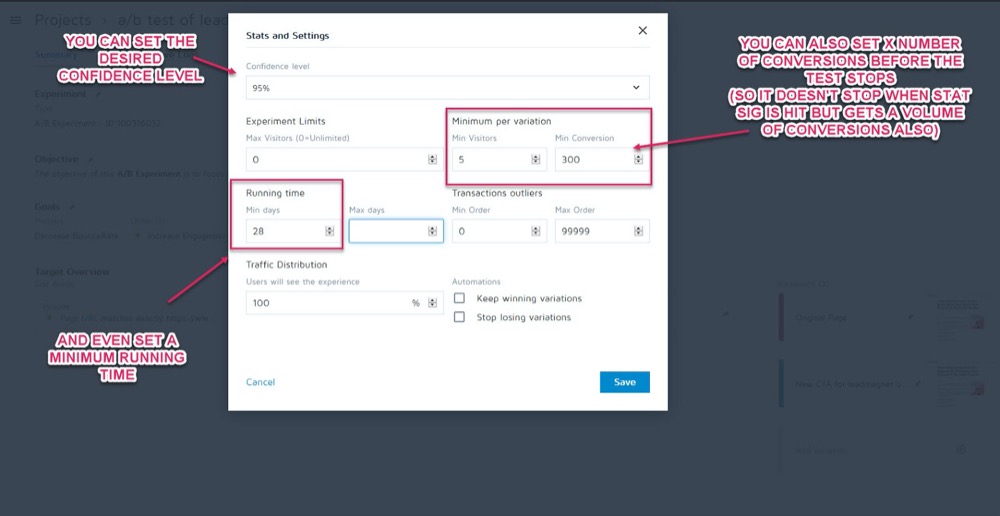

邊注:

您可以在測試運行之前在轉換體驗應用程序中實驗的統計和設置部分將這些設置為參數。

然後,您可以設置所需的置信水平、最短運行時間和在調用測試之前要實現的轉換次數。

一旦你確定你的數據是準確的,就該分析它了……

第 2 步:檢查您的微觀、宏觀和護欄指標

大多數人會看一個測試,並根據工具告訴他們的任何東西來判斷贏家或輸家。

當然,問題在於該工具只能根據您為其設置的標準告訴您測試的執行情況。 作為 CRO 測試人員,我們總是想了解導致這些結果發生的“方式”和“原因”,以便我們從中學習。

現在我們要做一些檢查,但是,首先我將介紹三個最重要的檢查。 這就是微觀和宏觀結果跟踪的用武之地。

讓我解釋:

- 微跟踪是指跟踪您優化測試的目標,可能是更多的點擊、註冊等。

- 宏觀跟踪正在查看對您的業務(通常是銷售額)的北極星指標的影響。

為什麼這很重要?

有時,測試頁面上微事件的提升不會像您想像的那樣影響宏。

例子

假設您在潛在客戶捕獲頁面上測試 CTA,而失敗者獲得的潛在客戶比控制者少。

似乎很明顯哪個測試贏了,對吧?

但是在您的分析中進一步檢查時,您會注意到通過“失敗”測試的潛在客戶實際上在後端轉換得更高,並創造了更大的投資回報率。

為什麼會發生這種情況?

可能是您當前的頁面吸引了更廣泛的受眾並轉化了更多潛在客戶,但您的新“失敗”變體實際上吸引了現在準備購買的人。

在示例中,失敗的廣告系列實際上是您想要運行的頁面,因為它使用您的 Northstar 指標轉換得更好。

記住你的最終目標,把精力集中在影響最大的事情上。

微觀和宏觀結果並不是您需要尋找的全部。

如果您還沒有,請考慮將“護欄指標”添加到您的廣告系列中。

這些是您在進行任何其他更改時要關注的核心指標,以便如果它們開始下降,您可以回滾或停止某些測試方法,因為它們的性能太重要了。

在 Uber,我們在任何給定時間進行 100 次實驗。 這些實驗的目標是不斷改進我們的產品和用戶體驗。 但是,有時實驗者可能會考慮一些關鍵指標,並且可能沒有意識到對團隊和公司整體重要的其他幾個指標的影響,並且隨著實驗的運行,這些不受監控的指標可能會倒退。

為了檢測和緩解此類情況,我們構建了我們的實驗監控平台。 目標是識別和監控一些我們不想在實驗運行期間降級的護欄指標。 我們應用順序 A/B 方法的變體來持續監控這些護欄指標,並檢測實驗的治療組和對照組之間的任何回歸。 如果檢測到回歸,我們會向實驗所有者發送警報。

Suman Bhattacharya,Uber 高級數據科學家

例子

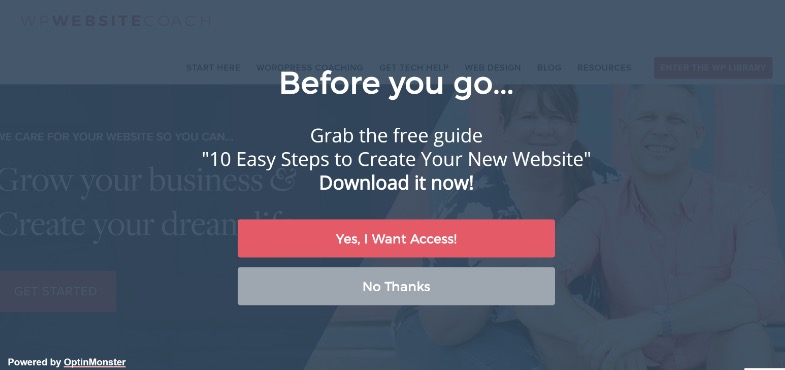

假設您想使用全屏彈出窗口收集更多潛在客戶。

對於某些網站,這些效果很好,但並非總是如此。 (這就是我們測試的原因!)

也許您安裝了一個全屏彈出窗口並開始在該頁面上獲得更多潛在客戶,但是您發送給這些新訂閱者的歡迎電子郵件正在彈跳並且沒有發送。

事實證明,人們選擇使用虛假電子郵件只是為了讓彈出窗口停止顯示。

您不希望電子郵件列表中出現虛假線索,因為它們可能會將您的電子郵件傳遞結果降低給實際訂閱者。 您也不應該過多地降低用戶體驗,以至於您的聽眾覺得他們需要偽造他們的電子郵件。

由於電子郵件營銷是您的銷售流程的核心部分,因此您決定設置一個警報,讓您知道在您的潛在客戶捕獲頁面上運行 A/B 測試時電子郵件跳出率是否超過設定點。

這將是您的護欄指標。 在此示例中,您可以看到它已損壞,您決定使用侵入性較小的潛在客戶捕獲方法。

那有意義嗎?

不過,Guardrail 指標不僅僅是潛在客戶捕獲率和跳出率。 它們是您不希望看到影響用戶體驗的關鍵指標。

為了防止用戶體驗下降,同時確保您也在改進重要的指標,請定義一些護欄指標,如果它們下降到某個閾值,它將阻止您繼續推出所謂的“獲勝”的變體。 這也有助於結束轉換優化與用戶體驗或品牌指南之間的爭論。

Alex Birkett,全知數字

由您決定這些指標對您的業務有什麼影響。 使用它們來查看您是否有真正的贏家,或者您是否只是用一個結果的提升來換取更重要的領域的損失。

如果您需要一些靈感,請查看 Ben Labay 的實驗和測試中常見護欄指標列表:

然後,相應地進行這些更改。

只要您使用分析和高級細分設置了轉換體驗應用程序,您就應該能夠通過快速瀏覽找到這些信息。 檢查每個變體對您的 Northstar 指標的影響,以及您的“護欄”,這樣您就不會只選擇測試工具的贏家。

現在您已經涵蓋了核心指標,讓我們更深入地了解您的結果......

第 3 步:更深入地細分您的結果

請記住,在測試方面,平均值是一個謊言。

平均結果只能基於多個數據點的組合為您提供廣泛的信息。 您需要了解為什麼會出現這種結果,然後再深入研究,因為它並不總是看起來那樣。

我們已經看到宏觀結果受到微觀測試變化的影響,但您的分析細分可以提供更深入的見解。

例子

假設您正在測試更多潛在客戶。 乍一看,控件和變體具有相同的訪問者到訂閱者的轉化率。

然而,在更深入的檢查中,您會注意到在桌面上,新的變體幾乎是控件轉化率的兩倍,但在移動設備上它為零,導致頁面的平均值看起來與控件相同。

顯然,有些地方出了問題,但為什麼會發生這種情況呢?

可能是新變體無法在移動設備上正確加載,或者表單無法在特定設備上運行,因此實際上沒有想要訂閱的移動用戶可以訂閱。 如果您解決了這個問題,則可能是您的“相等結果”變體實際上能夠遠遠勝過控件。

只有當您努力獲取結果背後的更多信息時,您才能找到這些東西。

通過每次測試,您將嘗試獲得洞察力,這將為更智能的細分提供信息,從而產生新的洞察力,最終將引導您制定更有意義的策略。

香奈兒穆林斯,Shopify

細分不僅是發現錯誤,還包括發現其他用戶見解。

也許頁面和控件都工作正常,但是當您深入觀察時,您會注意到某些流量渠道在這個新測試中的轉化率遠高於其他渠道?

通常,您會發現一些細分市場表現不佳,而另一些則表現出色。 然後,這可以為新的個性化活動或付費或自然流量策略提供信息。

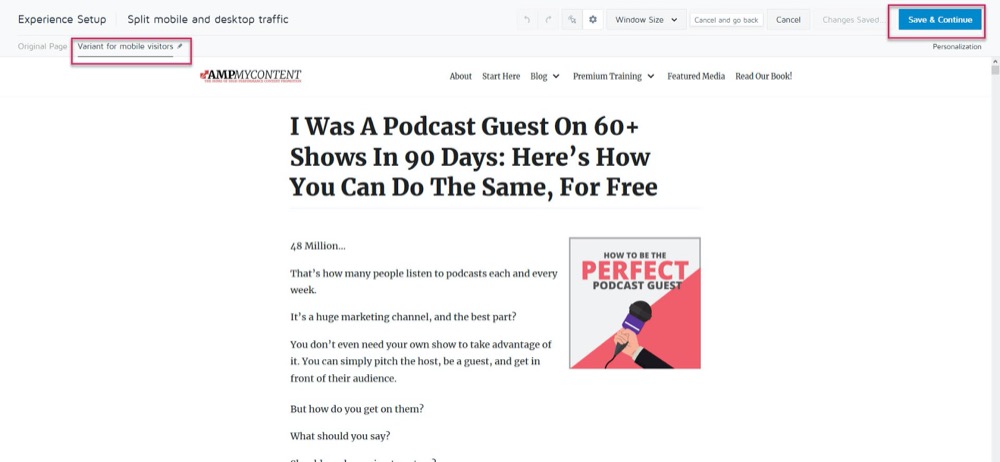

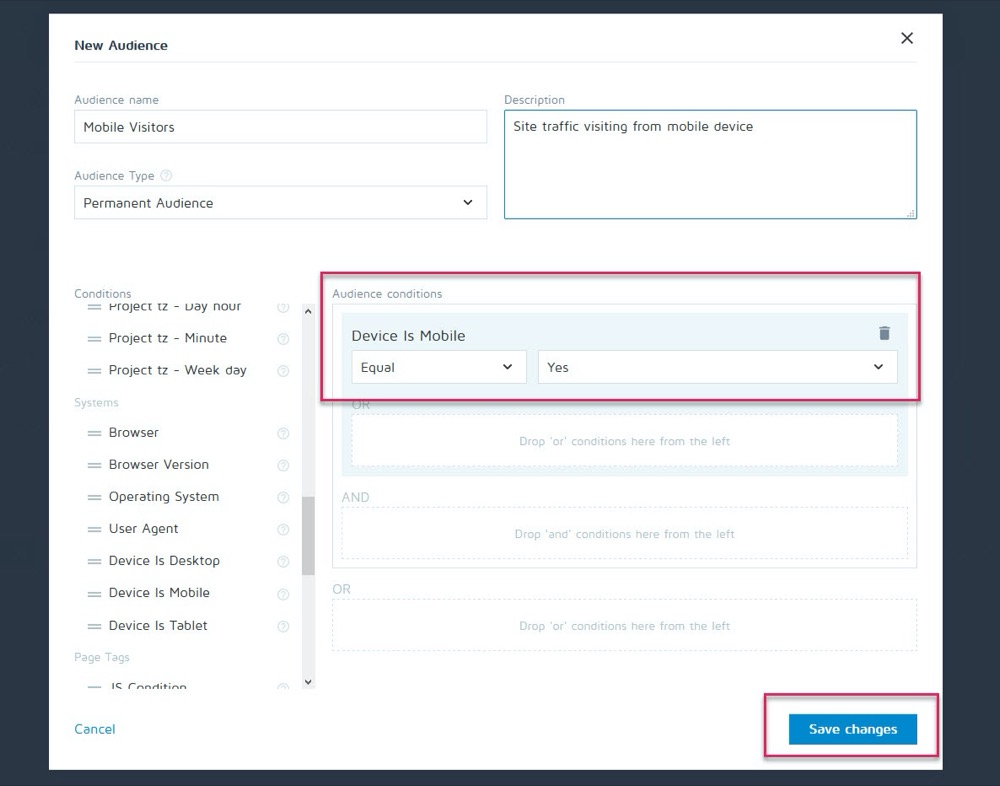

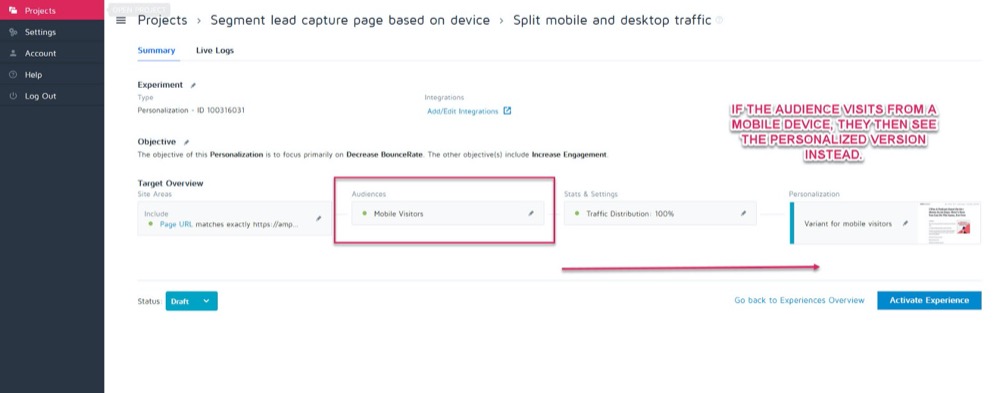

也許控件在台式機上的轉換效果最好,但新變體在移動設備上的轉換率更高。 例如,您想根據查看者對您網站的看法來選擇顯示哪個版本。

使用 Convert 的個性化功能,您可以將該移動獲勝變體設置為僅針對該受眾的個性化。

然後,您可以在訪問者來自任何移動設備時顯示新版本。

但是,如果他們從桌面遇到,他們會看到桌面版本。

您可以使用一大堆不同的個性化方法,但只有在您從廣告系列中獲得一些見解時才能使用。

分析細分的關鍵是始終查看您的結果以了解為什麼會發生某些事情。

看著:

- 新觀眾與回訪觀眾。 一種變體是否讓人們更頻繁地回來? 是否正在轉換更多的冷/新觀眾?

- 流量來源。 一個渠道比其他渠道做得更好嗎? 你能在這裡更專注嗎?

- 頁面瀏覽量。 特別是如果您的測試頁面試圖將流量吸引到您的銷售頁面。 一個版本沒有點擊可能意味著您的按鈕損壞或 CTA 問題。

- 跳出率。 這可能表明鏈接斷開/加載緩慢/用戶體驗不佳,甚至針對錯誤的受眾。

- 操作系統,

- 移動與桌面。

- 使用的設備。

輕微的免責聲明:

要在這樣的分段時準確反映每個通道,您需要大量數據。 一個好的經驗法則是進行大約 10 倍於您通常運行的轉換量的測試(或者每個渠道 300 次轉換,而不僅僅是每個變體頁面)。

您可能會想, “我們無法獲得足夠的流量來運行這樣的測試”。 或者如果你這樣做了,它可能需要幾個月的時間才能發生。

即使是這種情況,也不要跳過查看您的細分分析。

為什麼?

即使您在每個細分市場中可能沒有足夠的轉化率來得出有數據支持的結論,但如果您開始看到諸如零點擊的頁面瀏覽量或立即跳出率等問題,它可以為您提供一些明顯的見解。

這些都是可能表明測試失敗並幫助您找到可能錯過的獲勝者的所有事情。 繼續尋找任何重大的下降和問題。 在每個平台和設備上一切正常嗎?

理想情況下,您在測試前檢查了所有內容,但測試中途可能會出現問題,因此請再次檢查。

我個人讓 WordPress 在廣告活動中自動更新,然後導致潛在客戶捕獲表單在測試中突然停止工作。 始終檢查,如果您確實看到破壞結果準確性的東西,請停止測試,修復問題,然後再次運行。

如果一切正常?

讓我們來看看為什麼人們沒有採取你的行動……

第 4 步:檢查用戶行為以獲取更多信息

理想情況下,您應該在測試工具之上進行定性跟踪。

為什麼?

因為這通常可以讓您深入了解您在常規測試中會錯過的變體。

記住:

Convert 等定量測試工具會告訴您發生了什麼。 我們可以為您提供點擊或未點擊的人數之間的原始數字數據,並幫助您設置每個 A/B 測試。

但是添加定性工具可以幫助您了解為什麼會發生某項操作。 它們允許您查看用戶在做什麼,並更深入地了解他們的行為。

(測試通常會由於執行不力或觀眾理解不佳而失敗,只有通過查看問題所在才能解決問題。)

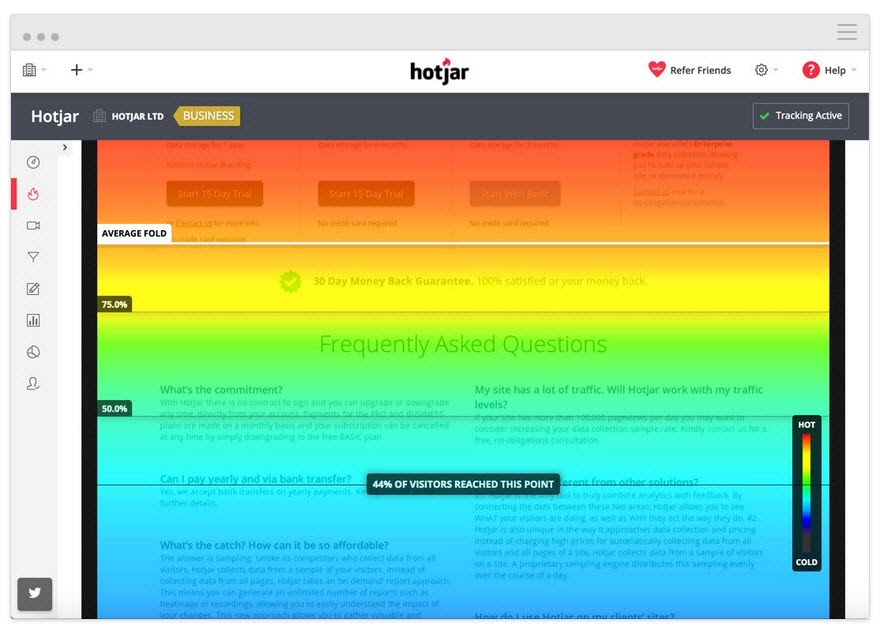

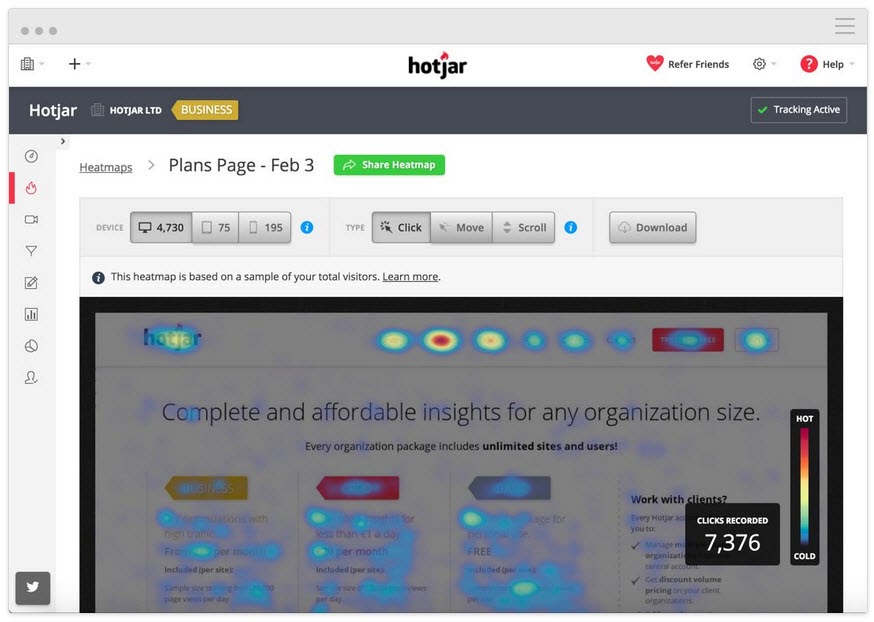

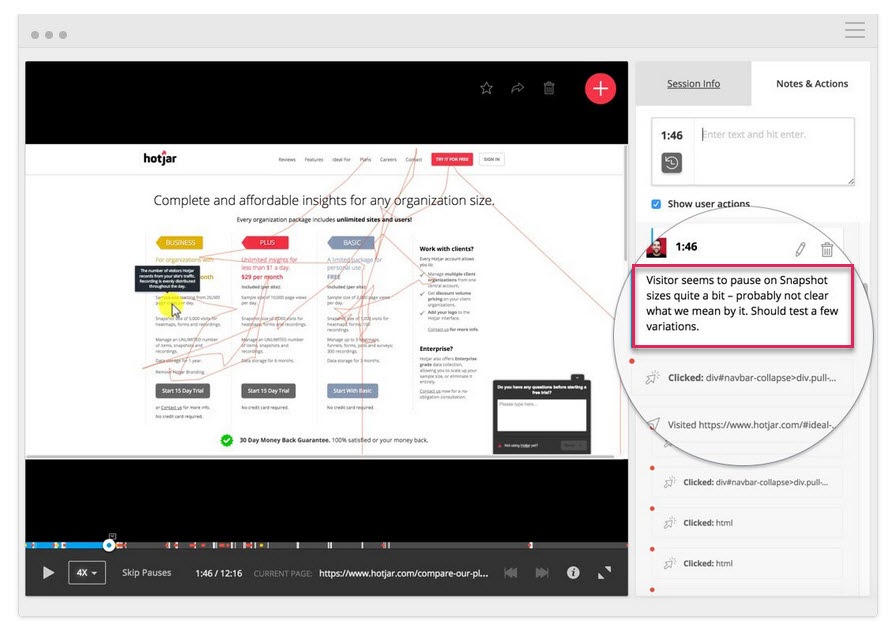

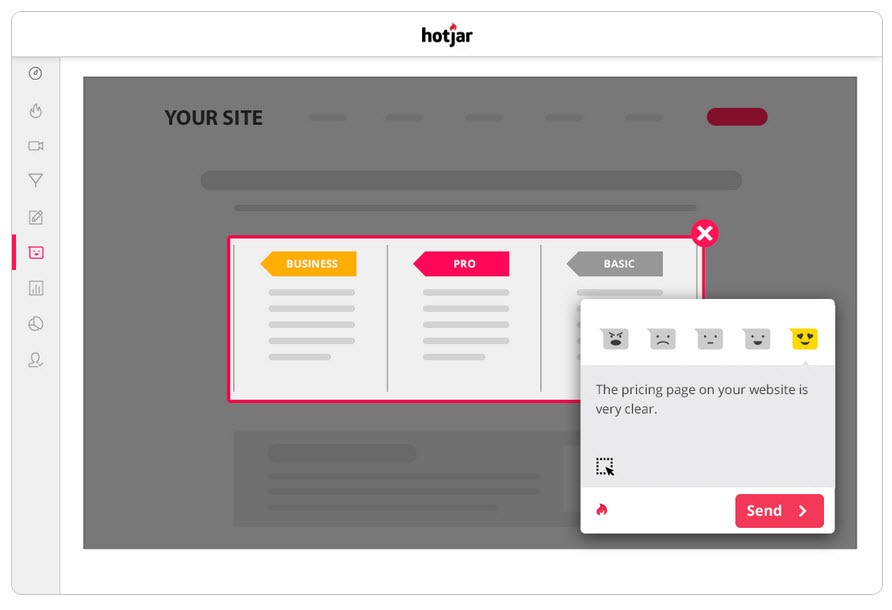

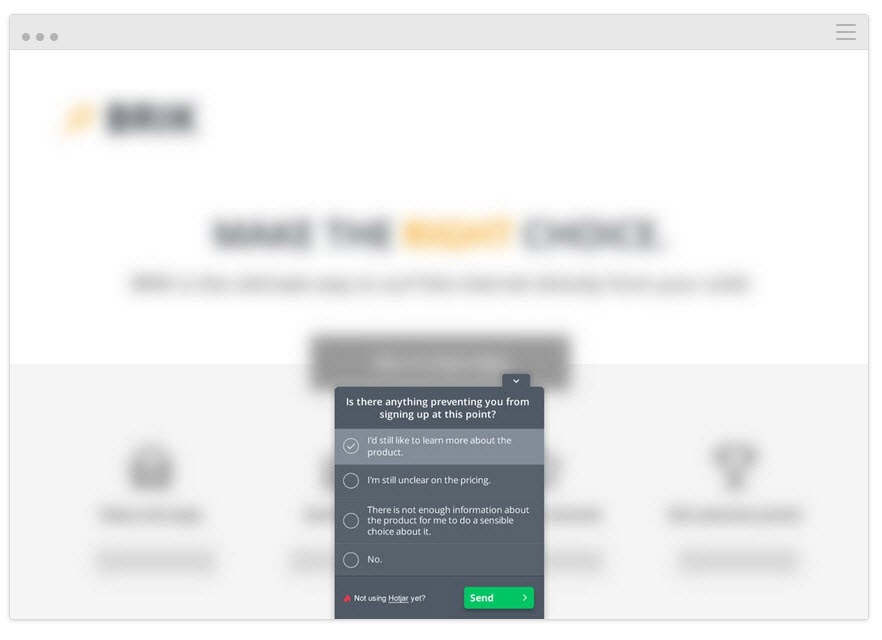

使用像 Hotjar 這樣的工具,您可以運行許多定性測試,甚至可以通過我們的內置集成將數據直接拉入您的 Convert 儀表板。

要獲得更深入的見解,請設置 Hotjar – Convert 集成並嘗試以下策略。

跟踪用戶閱讀的深度

將熱圖工具添加到您的頁面,以查看您的受眾是否與您的 CTA 一樣遠。 如果沒有,您可以再次運行測試並將 CTA 移到頁面上方。

跟踪用戶點擊的內容,但不應該

他們是點擊戰略 CTA 還是他們認為可能是鏈接的隨機文本?

觀看屏幕錄像以查看他們不點擊但應該點擊的內容

他們是否沒有點擊您的 CTA 按鈕,即使他們滾動的距離足以看到它? 他們在點擊但它沒有打開嗎? 他們是否看到它但沒有意識到這是一個可以點擊的按鈕?

您可以觀看所有這些內容,甚至可以在這些內容彈出時添加註釋。

不僅僅是熱圖和點擊跟踪工具可以提供幫助。

對您的受眾進行調查

調查不僅可以幫助您獲得有關導致您的受眾採取行動(或阻止他們)的原因的反饋,還可以為您提供它用來描述這一點的語言。

在文案寫作中,我們稱之為“鏡像語言”,它在與用戶建立聯繫方面非常有效。 感覺就像您不僅認識到他們的問題,而且比其他任何人都更了解它,因為您用他們使用的相同詞語來描述它。

將調查與 A/B 測試工具一起使用的兩種好方法是:

- 退出意圖民意調查。 找出那些不接受新版本的人,這樣你就可以找出是什麼阻止了他們。

您今天沒有選擇/購買是否有原因?

- 購買後/轉換調查。 找到那些接受變體的人,看看是否有任何癥結和激勵因素。

是什麼讓你決定今天採取行動?” 有什麼事情讓你幾乎無法做出決定嗎?

如果您想了解更多信息,您甚至可以在控件上運行類似的調查。 所有這些都將幫助您了解測試的執行方式,以便您可以迭代和改進。

說到這個……

第 5 步:從失敗的測試中學習

當涉及到失敗的測試時,最重要的是從結果中學到一些東西。 只要您可以從中獲得洞察力以更好地改善或了解您的受眾,就沒有糟糕的測試這回事。

A/B 測試是一個交互式過程。 我們在獲得理解的同時失敗了。 你通常可以從失敗的測試中學到更多,而不是直接獲得勝利。

到目前為止,我們一直在做 3 件事:

- 確保測試數據準確,

- 查看任何問題的原始結果,以及

- 試圖了解我們的用戶及其行為。

此步驟更像是一種啟發式方法,可幫助您了解可能導致失敗的常見問題(假設測試數據準確且 CTA 按鈕均有效)並分析您的方法和假設。

你的假設是錯誤的還是你的測試錯位了?

這是一個常見問題,尤其是在新測試人員中。

您是否根據一些與實際 KPI 不一致的“嗚嗚”指標或想法進行了測試?

例子

假設您希望從頁面獲得更多銷售額,但出於某種原因,您決定改為測試對社交分享按鈕的調整。 (即使您有零數據表明更多的社交分享會影響您的銷售。)

這聽起來很瘋狂,但你會驚訝於這樣的事情發生的頻率。

問你自己:

我的測試目標是否與核心 KPI 保持一致並以某種方式影響它?

如果沒有,那沒關係,但要確保下一個測試更好地對齊。

我們失敗,我們學習,我們再試一次。

在您的下一個測試中,請務必關注您的核心 KPI 指標以及如何影響它們,並為測試提供明確的贏/失敗場景。

我們希望此頁面獲得更多潛在客戶,因此我們正在測試讓他們選擇加入的方法,這意味著我們希望創建更好的 CTA。

或者

我們希望此頁面獲得更多潛在客戶,並且我們發現用戶不會滾動到我們的 CTA,因此我們正在測試將其提升到頁面上。

讓您的測試與您的目標保持一致將使您走上正確的道路,但即便如此,它仍然可能看不到更多的轉化......

假設正確,測試對齊,但結果仍然沒有變化

這可能在 90% 的時間發生,這也是大多數測試失敗的原因。

示例 #1

您的用戶數據顯示用戶對您的網站不夠信任。 您添加了社交證明、用戶推薦、SSL 證書等信任因素,但轉化率仍未增加。

這是否意味著您應該停下來嘗試新的測試或角度?

一點也不…

您最初的假設可能是正確的,但您的測試只需要改進或執行得更好,然後才能看到任何效果。

你可以嘗試添加更多的信任因素,甚至改變你所擁有的因素,讓它們更加突出。 也許重新措辭他們使用的語言,以幫助他們更好地與您的受眾建立聯繫。

所有這些事情仍然與最初的假設一致,您只需要測試更多版本即可找到贏家。

示例 #2

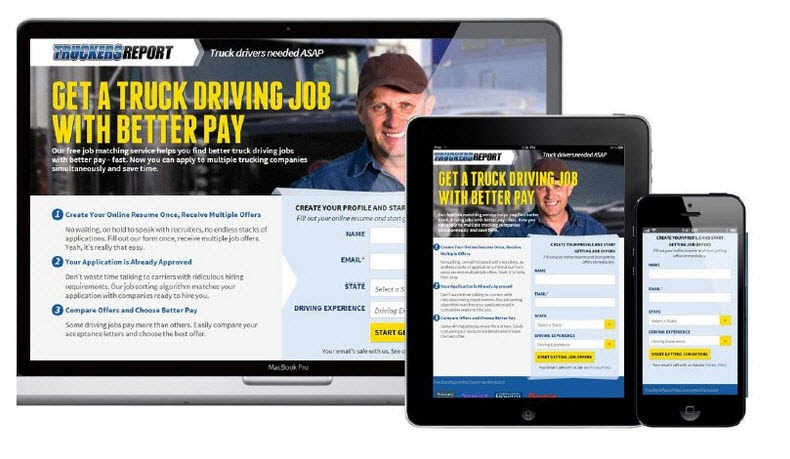

CXL 在此著陸頁上進行了 6 次不同的測試活動,以獲得更多卡車司機認證的潛在客戶。

他們將選擇加入率從 12.1% 提高到 79.3%,這一切都是為了繼續改進頁面。

(幾乎所有這些測試活動在看到提升之前都使用相同的假設進行了多次嘗試。直到那時,他們才繼續前進並測試以改進頁面上的其他元素。)

A/B 測試是一個迭代過程。 你必須不斷測試和調整才能找到改進,即使是業內最好的也可能只有 10% 的時間能找到贏家。

如果假設您是一個組織,並且您進行的每一次測試都是成功的,那麼在我看來這實際上是一個危險信號。

這聽起來違反直覺,但它向我表明,您只是在測試明顯的東西,並沒有冒足夠的風險來真正推動針頭。

Deborah O'Malley,猜猜測試

向最優秀的人學習總是很棒,我們很高興能分享我們對 Deborah 的採訪。 我們談到了為什麼測試永遠不會失敗,以及在測試中擁有正確心態的重要性。 為了幫助您從正確的角度開始,請在此處收聽我們的採訪。

這意味著您可能需要 9 次測試才能看到積極的提升,所以堅持下去。

您的測試應該遵循影響最大到最低的優先系統。 通過運行更多測試和更改來改進您當前的廣告系列,您將看到比跳到較低重要性測試更大的影響,因為您沒有看到當前測試的立竿見影的結果。

如果它仍然沒有看到較小變化的提升,請考慮在運行不同設計的情況下運行創新測試。

它可以是圍欄的搖擺,但有時它可能是您需要做出的改變。

如果在所有這些測試和調整之後,變體仍然是失敗者怎麼辦?

所以數據是正確的,你已經嘗試了每一個調整,甚至對整個頁面進行了大的創新更改,但它仍然不會比控件更好。

看起來可能不是,但這實際上是一件好事。

為什麼?

因為您發現了哪些內容不適合您的觀眾!

如此多的網站在沒有測試任何東西的情況下進行了巨大的徹底更改,並且無論如何都將其推出。

問問自己這個:

如果該頁面變體的轉換率僅比您當前的控制差 1%,那麼通過首先測試而不是推出它,您節省了多少錢?

早在 2014 年,Marks and Spencer 決定更新他們的整個網站,而不是先用樣本受眾進行測試。

結果?

Their online sales dropped by 8.1% in 3 months, causing a loss of $55 million.

This is why testing and finding losers is a really good thing because even losing tests can save you money.

What if the Test and the Variant Have Identical Results?

You checked everything, it all works, you've segmented down and gone into the nitty-gritty, but there's just no discernible difference between your current page and your new variant.

You've even tried complete page overhauls but through some fluke of math, your new page still converts at the same rate as the old one.

In this case, it's simply the dealer's choice.

Does the new variation more actively represent your brand and style?

If so, choose whichever you wish to use. The results are still the same but you are happier with the design.

Note: This should be the only time that you do this. Branding should not sacrifice results; it should aid them, as seen in the previous example.

Step #6: Double Down on Winners and Continue to Improve Them

So far we've been covering losing campaigns, but what if you got a winner right out of the gate?

First off, congratulations!

Second, let's make sure you actually have a winner. Oftentimes, things can happen to affect your results and give you a false positive (ie we think it's a winner but we implement it and nothing happens.)

Go ahead and run the test again with just your control and the winning variant and prove the lift in results first before you make any changes to your site.

Then if it really is a winner? Don't stop there, continue to improve it!

Iterative improvements of a new winning campaign are the easiest new test to run. With each new improvement, you'll see more ongoing ROI. You can even take what you learned with your winning test and then roll it out across similar pages on your site for further tests and see if it also adds lift there too.

Step #7: Create a Learning Repository for Future Tests

This step is relevant to both winning and losing tests.

Not only will it help you with future tests, but it will also help your QA team diagnose any broken campaigns faster, as they can see where issues have appeared in the past.

Better still?

It will help you document your results for clients or your boss, while also standardizing your reporting processes and ramping up your test velocity.

以下是它的工作原理:

You're going to create a master archive or learning repository of all past tests. A place to document your previous wins and losses that you can use to both reference for new campaigns and share with stakeholders or customers.

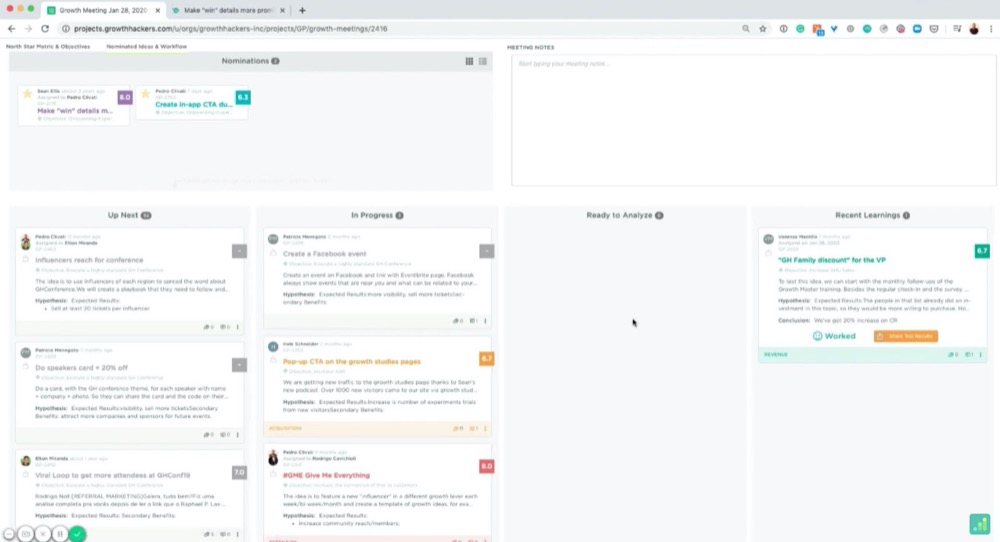

You can use a folder on your computer for this, but, if you really want to get organized, there's a great tool called GrowthHackers experiments.

Its main goal is to help marketing growth teams communicate and organize campaigns, but you can easily use it to manage your CRO testing and learnings. It will even pull in results from your test tool and allows you to archive each test. (You can simply tag and then add them to the repository.)

Whatever you decide to use, here are some best practices:

Organizing Your Tests

You probably have your own naming conventions but if you're just starting, I recommend naming each test like so:

“Goal – Campaign – Test Date”

例如:

“CTR lift test – XYZ client – March 1st-14th 2021”

This way, you can organize tests by goals to get inspiration for future tests, search through and find them for client campaigns, or look back on your experiments month by month.

Then, if you wanted to run a CTR test later on, you can swipe through them and see what ideas worked or failed in the past.

How Do We Create Documents for the Learning Repository?

Feel free to add screenshots of your testing tools graphs, confidence, and power level or any data that you think is relevant.

However, I highly recommend creating a slide with the following information:

- The hypothesis and how you came up with the idea (any survey data or information).

- A headline with the test goal.

- A screenshot of the control, the winning variant, and any other failed versions/tests that got some lift but not as much. (Highlight the key elements so you can spot what changed without having to look too hard.)

- Add the micro goal and its percentage lift. (Perhaps 3.2% CTR)

- Then add the macro goal and its percentage lift. (AVG order value up 2.2%, etc.)

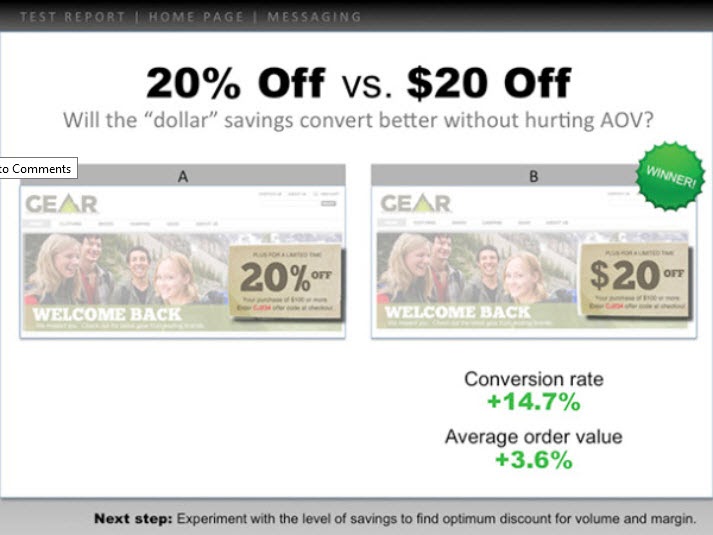

這是一個例子:

You can use these slides to present the test information to anyone else who needs them, while also having a simple file to understand the test at a moment's notice.

Pretty handy, right?

Now that you've analyzed your test and recorded the results, let's walk you through how to present this to your boss in a way that even if the test failed, they're still happy to see your findings…

How To Present This Information To Your Boss (Even When Your Campaigns Failed)

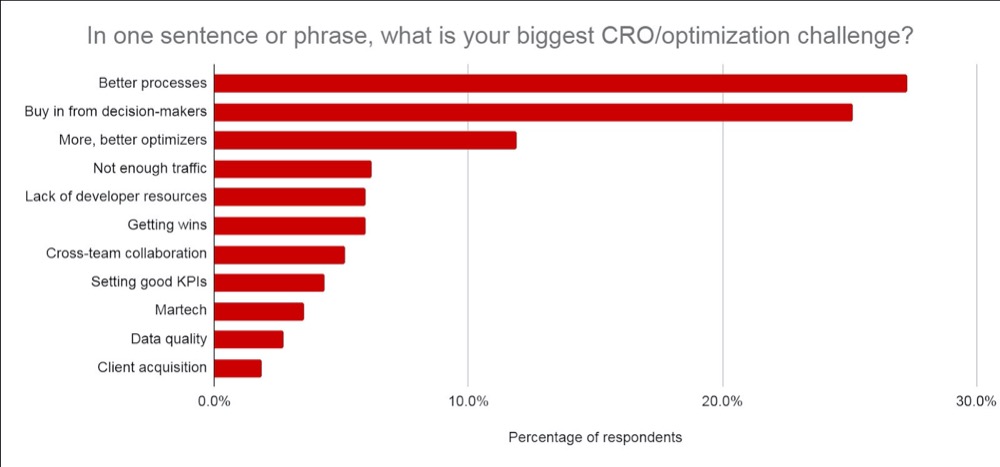

Don't worry if you feel anxious about this, you're not alone. In fact, according to CXL's state of the industry report, presenting test information or getting buy-in from your stakeholders is consistently one of the biggest struggles CROs face.

We've covered the best ways to communicate this information before, but I want to give you a few extra tips on how to get your test results across (even if your test failed).

Tip #1: Get Everyone On Board With CRO and Its Realities as Soon as Possible

Ideally, you covered this when you first broached the topic of running A/B tests but it never hurts to recap.

Make sure they understand that A/B testing is a continual learning process that's more about understanding your audience and improving their experience. The lift in ROI is simply a byproduct of taking action on each test and implementing what you learn, regardless of if it wins or fails.

Winners give lift and losers give insight into where to improve.

No test is ever wasted but the majority of them do fail. You're looking at roughly 1/10 winners for most people's tests and agencies are around 1/4.

Be clear on how many tests fail and the need to run more tests to find winners.

Tip #2: Present the Information as Simply as You Can

Not everyone can read graphs easily. Even if they can, it still means that it takes effort to understand the context of what they are seeing.

The more effort it takes to understand something, the more frustrating it can be and can cause you to lose the other person's attention.

(Top tip for landing pages btw ^^)

Break it down nice and simple by using the slides from your learning repository.

It should already include:

- 你事先學到了什麼以及你是如何產生測試想法的。

- 你測試了什麼。 顯示控制、變化和獲勝者。

- 它是如何在微觀和宏觀層面上發揮作用的。 包括結果。

Finally, add any insights you drew from tests to decide on your next important action to take. (Improve execution, test new variations, new hypothesis, etc.)

Providing insight into what happened is HUGE.

你的老闆更關心你學到了什麼而不是結果,因為這是可以採取行動的。 分享這一點並給出下一步做什麼的想法將幫助他們看到你可以控制情況,並幫助他們對進一步的測試充滿信心。

提示#3:讓它們看起來不錯

更進一步,添加他們關心的數據:

- 如果測試失敗,請深入了解您認為它失敗的原因。 添加通過不推出失敗的測試而節省的投資回報率以及它將如何影響 MRR 和 ARR。

- 如果它贏了,那麼請深入了解所取得的投資回報率以及這如何影響年收入/MRR 和 ARR ,以及進一步擴大投資回報率並獲得更大投資回報率的任何機會。 (即,您可能已經測試了潛在客戶捕獲頁面並在調整佈局時看到了提升。您可能有 30 個其他類似的頁面,您可以將此測試應用到可能會看到潛在提升。)

- 如果測試是平的,那麼就您認為發生的事情以及下一步要做什麼分享見解。 (更好的執行、新的變體、徹底的改變或更好的測試等)

當然,ARR + MRR 或 YOY 影響是一個粗略的估計,但它顯示了您的測試的潛在影響和價值。 這就是你的老闆關心的事情,也是他們看到你的結果時可能在想的事情。

相信我,當你像這樣展示你的信息時,你會發現它更容易傳達。 您不再將測試視為“金錢損失”或浪費時間,而是關注潛在的儲蓄、實際收益和潛在的進一步增長。

不僅如此,您還能夠證明運行更多測試、使您的 CRO 努力成熟以及提高測試速度的價值。

結論

你有它。

到目前為止,您應該對如何分析和學習 A/B 測試結果更有信心,並且能夠將這些信息呈現給您的老闆或其他任何人,無論您的測試如何執行。

只需按照本指南簡化您運行的每個新 A/B 測試的測試後分析!