所有關於 A/A 測試:為什麼以及何時應該運行 A/A 測試?

已發表: 2022-07-07

A/A 測試允許您測試兩個相同的頁面,並且在設置新的 A/B 測試工具時非常有用。

A/A 測試可用於

- 評估 A/B 測試平台的準確性,

- 確定您的 A/B 測試平台是否與您的內部分析完全集成,

- 識別您的 A/B 測試工具可能存在的技術問題,

- 為頁面或渠道提供基準轉化率,

- 確定用於 A/B 測試的適當樣本量,以及

- 對您的網頁和渠道的性能進行基準測試。

Convert 提供 A/A 和 A/B 測試功能,以確保您擁有成功設計和開發高轉化率網站所需的一切。

繼續閱讀以了解更多關於 A/A 測試的重要性以及如何設置您的第一次體驗的信息!

- 什麼是 A/A 測試?

- 為什麼要運行 A/A 測試?

- 檢查 A/B 測試平台的準確性

- 確定與您的內部分析的集成程度

- 識別可能的技術問題

- 為任何頁面或渠道提供基準轉化率

- 找到必要的樣本量

- 對頁面和渠道的性能進行基準測試

- 設置 A/A 體驗

- 如何解釋 A/A 測試結果?

- 我們預計 A/A 體驗的結果不確定

- 如果您得到不同的變化,這意味著什麼?

- A/A 測試的挑戰是什麼?

- 隨機性

- 大樣本量

- 轉換體驗和 A/A 測試

- 如何在轉換體驗中設置 A/A 測試?

- 純粹的 A/A 體驗

- 校準的 A/A/B 或 A/A/B/B 體驗

- 運行許多 A/A 體驗

- 我可以在 A/B 體驗的同時運行 A/A 體驗嗎?

- 測試前 QA 流程:A/A 測試的有趣替代方案

- SRM 可以存在於 A/A 測試中嗎?

- 如何在轉換體驗中設置 A/A 測試?

- A/A 測試的優點是否大於缺點?

也許你以前也遇到過這樣的事情……

- 您運行 A/B 測試以查看您的新 CTA 按鈕和標題是否會增加轉化次數。

- 在接下來的一個月中,您向控制和變體目標網頁發送相同數量的流量。

- 您的軟件聲明您的變體是贏家(有 99% 的置信度),所以您停止了。

- 然後你啟動了你的“成功”設計,但是在幾個商業周期之後,你發現你的轉化率提高了 50% 對你的淨收入幾乎沒有影響。

最可能的解釋是假陽性測試結果。 幸運的是,有多種方法可以處理不正確的測試。

您可能聽說過的一種是 A/A 測試。

什麼是 A/A 測試?

在我們深入了解 A/A 測試之前,讓我們先談談 A/B 測試,這樣我們就可以指出它們之間的區別。

在典型的 A/B 體驗中,流量在兩個或多個備選變體之間分配。

一種變體通常被指定為“對照”或“原始”。 將體驗的所有其他變體與對照進行比較,以確定在給定指標中哪個變體產生最大的提升。

另一方面,A/A 測試要求將流量分配給兩個相同的變體,通常使用 50/50 拆分。

在正常的 A/B 測試中,目標是找到更高的轉化率,而在 A/A 測試中,目的通常是檢查變化是否具有相同的提升。

在 A/A 測試中,流量被隨機拆分,兩個組顯示相同的頁面。

然後,記錄每組報告的轉化率、點擊率和相關統計數據,以期從中學到一些東西。

A/A 測試 = 2 個相同的頁面相互測試

現在,讓我們看一些可以使用 A/A 體驗的示例,以確定它們是否對您有用。

為什麼要運行 A/A 測試?

在網頁設計和開發過程的各個階段運行 A/A 測試可能特別有效,例如:

- 當您安裝完新的 A/B 測試工具後,

- 當您當前的 A/B 測試工具的設置已升級或更改時,

- 當您創建新網站或應用程序時,

- 當您發現 A/B 測試的數據報告與您使用的其他分析工具之間存在差異時。

讓我們更深入地研究每個用例。

檢查 A/B 測試平台的準確性

A/A 體驗可以由希望獲得 A/B 測試平台的公司或希望嘗試新測試軟件(以確認其設置正確)的公司推出。

在 A/A 體驗中,我們比較同一頁面的兩個完全相同的版本,目標是獲得相似的轉化價值。

如果控制和變異之間沒有差異,則預期結果是不確定的。

即便如此,有時會在兩個相同的副本上宣布“獲勝者”。

發生這種情況時,評估 A/B 測試平台至關重要,因為該工具可能配置錯誤或可能無效。

作為下一步,您應該:

- 檢查您是否正確安裝了 A/B 跟踪代碼

- 檢查您的站點區域

- 檢查您的受眾

- 檢查你的目標

- 聯繫 A/B 測試支持團隊,以確定在放棄您的平台之前是否可以解決問題。

希望問題是上述問題之一。 如果你無法找出問題所在,這可能意味著 A/A 測試是結論性的,而你的 A/B 測試平台不准確。

確定與您的內部分析的集成程度

在檢查 A/B 測試平台的準確性時,您可以使用 A/A 測試來評估該平台是否與您的分析工具完全集成。

無論您使用的是 Google Analytics、Heap Analytics、Adobe Analytics、Plausible、Matomo 還是其他任何工具,您都可以將 A/A 測試結果與您的內部分析工具進行比較,以確定集成是否按預期工作。

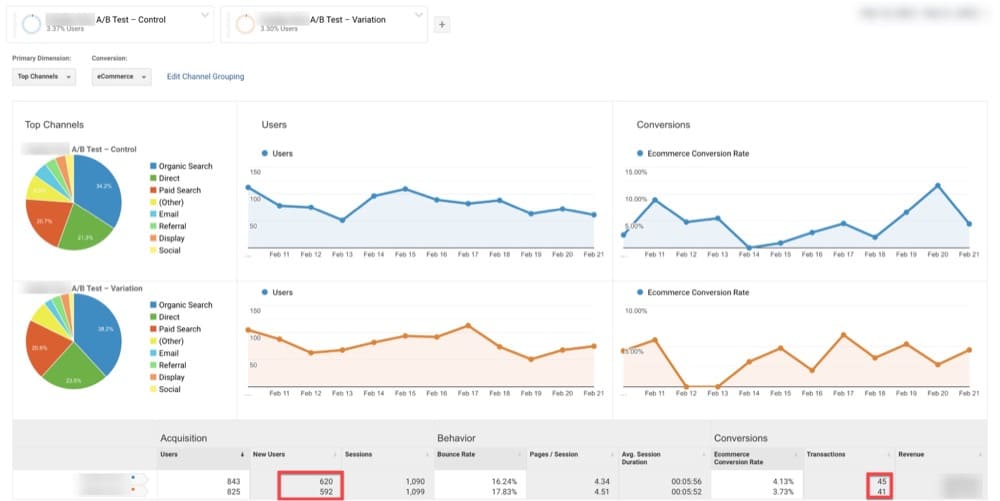

例如下面的例子,GA 已經在 Original 上識別了 620 位訪問者,在 Variation 上識別了 592 位訪問者(與 Original 頁面相同)。

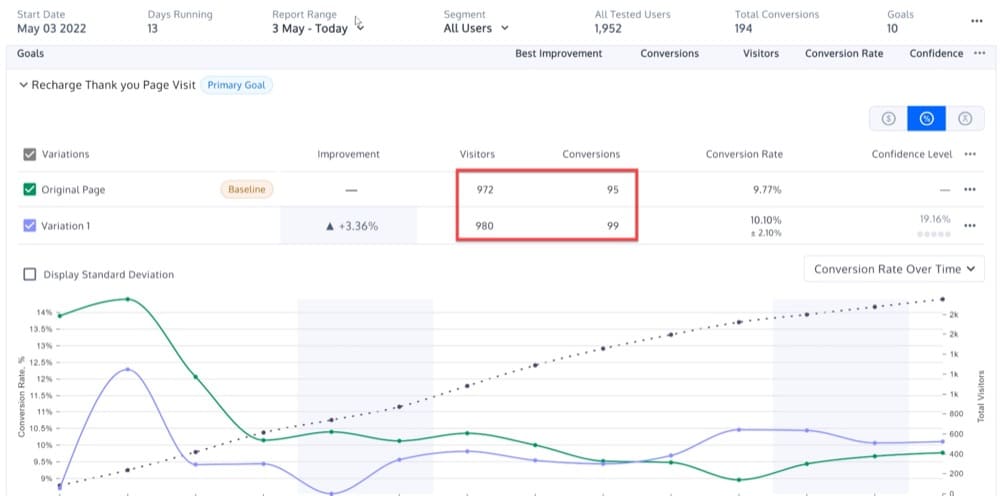

在同一日期範圍內,Convert 顯示原始訪問者為 972 人,變體訪問者為 980(與原始頁面相同)。

這可能表明兩個平台之間的集成沒有按預期工作。

識別可能的技術問題

您還可以使用 A/A 測試來識別可能的技術問題。

大多數 A/B 測試軟件使用的方法有些不同,並且可能導致顯著變化,具體取決於程序的推進程度。

這可能看起來是一種異常情況,但也可能表明存在以下情況之一的更嚴重的潛在問題:

- 數學和統計公式

- 隨機化算法

- 瀏覽器 cookie

您可以使用 A/A 經驗來揭示上述問題。

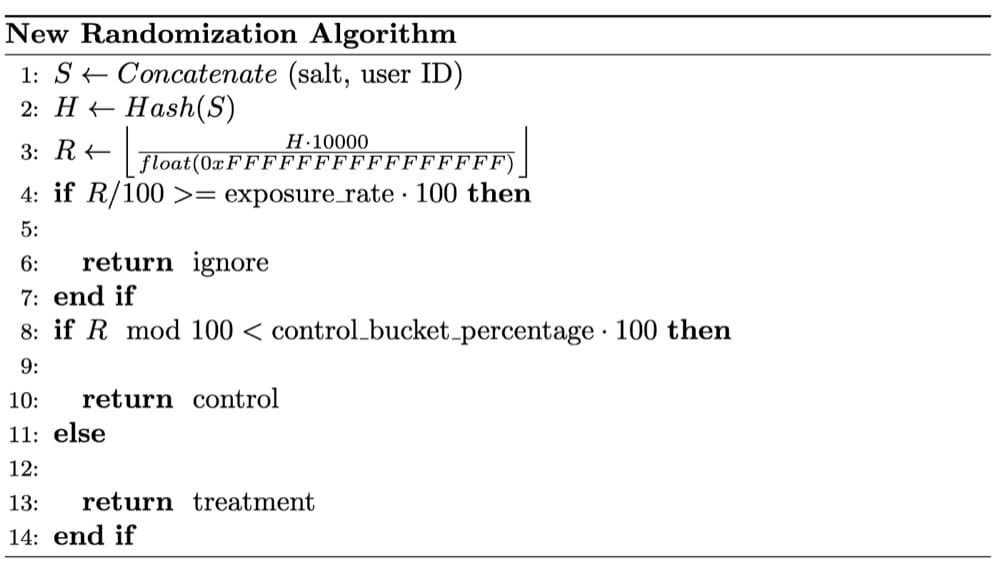

在下面的案例中,Wish 數據科學家注意到 SRM 對 A/A 測試的擔憂。 經過徹底檢查,確定 SRM 是由於它們的隨機化不是完全隨機的。

隨機化技術對於可靠的實驗結果至關重要。

隨機樣本的使用是 A/B 測試中使用的統計測試的基本假設。

隨機化平衡了實驗桶之間觀察到的和未觀察到的用戶因素。 它在被測試的產品特性和試驗結果的任何變化之間建立了因果關係。

為任何頁面或渠道提供基準轉化率

如果你想提高任何一個數字,你必須首先掌握它的基線是什麼樣的。 這可能是您的速度、體重或跑步時間。

同樣,在執行任何 A/B 測試之前,您必須首先確定要比較結果的轉化率。 這是您的基準轉化率。

您可能聽說過單次體驗會增加收入,但這可能會產生誤導。 單一的體驗不會告訴您您的網站轉換是否有所改善。

了解您的基準轉化率很重要,因為如果您無法量化每次體驗的提升,則需要經常比較總體預期轉化率和已完成轉化率。

運氣好的話,每一次被視為“勝利”的體驗都將幫助您的轉化超出預期。

如果您經常這樣做,您的轉化率只會繼續提高!

A/A 測試將幫助您實現這一目標。

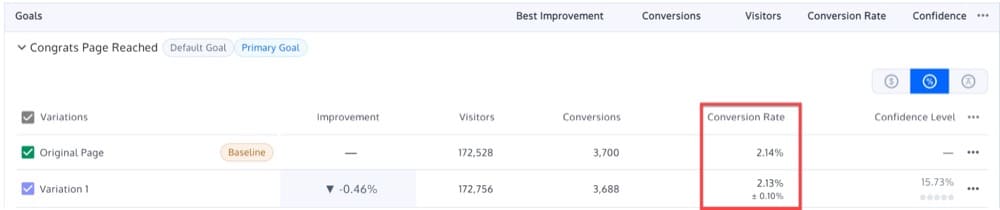

假設您在一個著陸頁上運行 A/A 測試,原始 A 和變體 B 提供幾乎相同的結果:2.14% 和 2.13%。

因此,基線轉化率可以設置為 2.13-2.14%。

考慮到這一點,您可以進行未來的 A/B 測試,目標是超過這個基準。

如果您在新版本的著陸頁上運行 A/B 測試並獲得 2.15% 的轉化率,則結果在統計上不顯著。

找到必要的樣本量

在進行 A/B 體驗之前,請仔細檢查您的樣本量,就像在進行公路旅行之前一樣。

如果沒有足夠的樣本(用戶),您將無法觀察到體驗效果。 另一方面,如果你有太多的樣本,你可能會因為不斷地讓人們接觸到糟糕的體驗而減慢團隊的進度。

理想情況下,您永遠不應該在沒有首先確定您將收集多少樣本的情況下開始體驗。

要了解原因,請考慮以下幾點:

假設你有一枚硬幣,你的假設是它有 50/50 的機會正面或反面。 為了證明這一點,你折騰了一百次。

但是,假設您在前十次拋擲中有十次反面,並決定在那裡停止實驗。

拒絕原假設(硬幣是公平的)可能看起來具有統計意義,但您提前終止了實驗。 您不知道該實驗需要多長時間才能開始。

如果您不估計樣本量,您也可能無法確定您將進行多長時間的體驗。

那麼我們該如何處理呢?

A/A 測試可以幫助您確定您需要從網站訪問者那裡獲得多大的樣本量。

也許,您週一早上的訪客在統計上與週六晚上的訪客完全不同。 也許,您的假日購物者與在非假日季節購物的人在統計上有所不同。

您的桌面客戶可能與您的移動客戶在統計上有所不同。 而且,通過贊助廣告而來的客戶與來自口碑推薦的客戶不同。

在設備和瀏覽器等類別中查看結果時,您會驚訝於通過正確的樣本量發現的趨勢。

當然,如果您的樣本量太小,結果可能不可靠。 您可能會錯過一些部分,這可能會影響您的體驗結果。

較大的樣本量會增加包括影響測試的所有部分的可能性。

通過運行 A/A 測試,您將能夠確定哪種樣本量可以實現相同變體之間的理想相等。

簡而言之,A/A 測試可幫助您確定可用於未來 A/B 測試的適當樣本量。

對頁面和渠道的性能進行基準測試

有多少訪問者訪問您的主頁、購物車頁面、產品頁面和其他頁面?

當你這樣做時,你不關心你是否會找到贏家。 相反,您正在為某個頁面搜索更大的模式。

這些經驗可以幫助您回答以下問題:

- 首頁的宏觀轉化率是多少?

- 按訪問者細分的轉化率是多少?

- 按設備細分的轉化率是多少?

A/A 體驗為您提供了一個基準,您可以根據該基準比較網站任何部分的新鮮 A/B 體驗。

有人可能會爭辯說,您可以通過網站的分析獲得相同的信息。

但是,這既是真實的,也是不真實的。

A/B 測試工具主要用於宣布獲勝者(同時將測試數據發送到 Google Analytics 或執行其他計算),因此您仍然需要在運行時觀察網站指標。

設置 A/A 體驗

A/A 體驗是轉化率優化的一個非常重要的工具。

但是,A/A 體驗的挑戰在於決定在進行體驗時使用哪個頁面。

確保您為 A/A 體驗頁面選擇的頁面具有以下兩個品質:

- 高流量。 訪問頁面的人越多,您就會越早注意到變體之間的一致性。

- 訪客有能力購買或註冊。 您需要微調您的 A/B 測試解決方案,直至完成。

這些要求是我們經常在網站首頁進行A/A測試的原因。

在下一節中,我將更詳細地解釋如何創建 A/A 測試活動,但簡而言之,以下是如何在網站主頁上設置 A/A 測試:

- 製作同一頁面的兩個相同版本:控件和變體。 完成創建變體後,選擇具有相同樣本大小的受眾。

- 確定您的 KPI。 KPI 是衡量一段時間內績效的指標。 例如,您的 KPI 可以是點擊號召性用語的訪問者數量。

- 使用您的測試工具將您的觀眾均勻隨機分配,將一組發送到控制組,另一組發送到變體組。 運行體驗,直到控制和變化都達到一定的訪問次數。

- 跟踪兩個組的 KPI。 因為兩組都接觸到相同的內容,所以他們應該採取類似的行動。

- 將您的 A/B 測試工具連接到您的分析軟件。 這將允許您仔細檢查您的數據是否在您的分析程序中準確收集。

如何解釋 A/A 測試結果?

我們預計 A/A 體驗的結果不確定

雖然季節性不太可能改變 A/A 測試的結果,但其目的之一是檢測意外結果。 出於這個原因,我們建議在查看結果之前至少運行一周的測試。

在一周結束時,當您檢查 A/A 測試的結果時,您應該注意到以下行為:

- 隨著時間的推移,您的統計顯著性將圍繞給定值穩定下來。 10% 的時間,統計顯著性將穩定在 90% 以上。

- 隨著收集到更多數據,您的實驗的置信區間將縮小,排除非零值。

- 在測試結果期間,原始版本和變體版本在不同點的表現可能不同,但兩者都不應被正式標記為具有統計學意義的贏家。

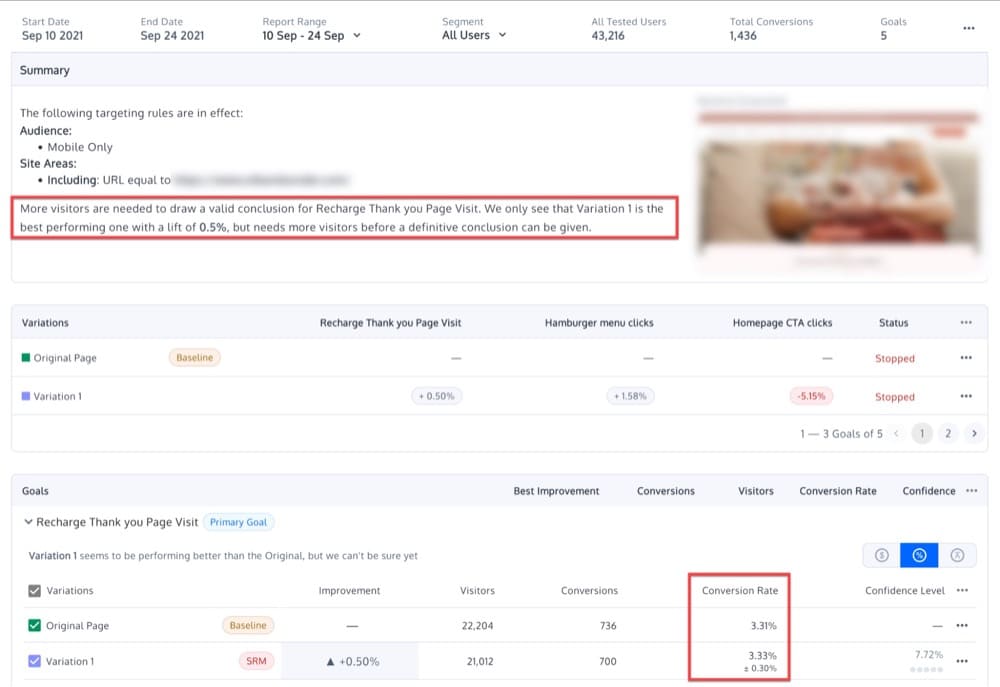

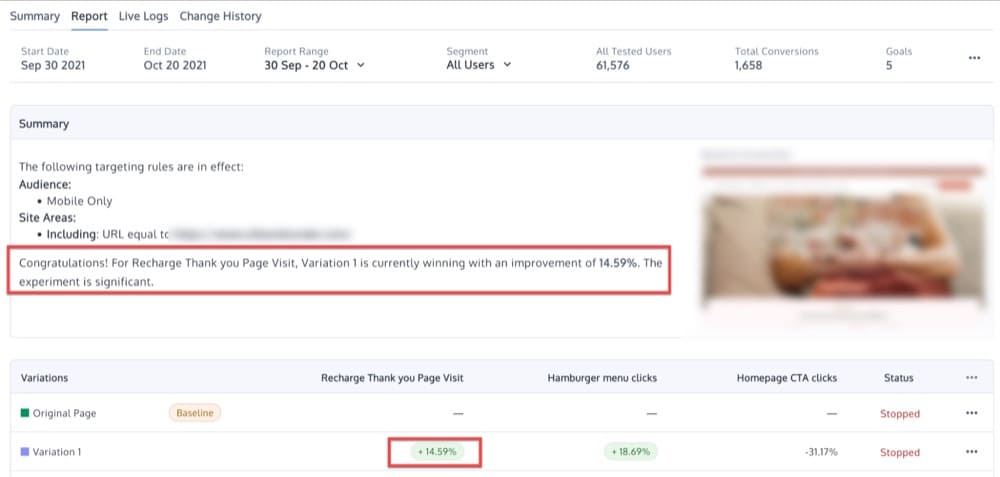

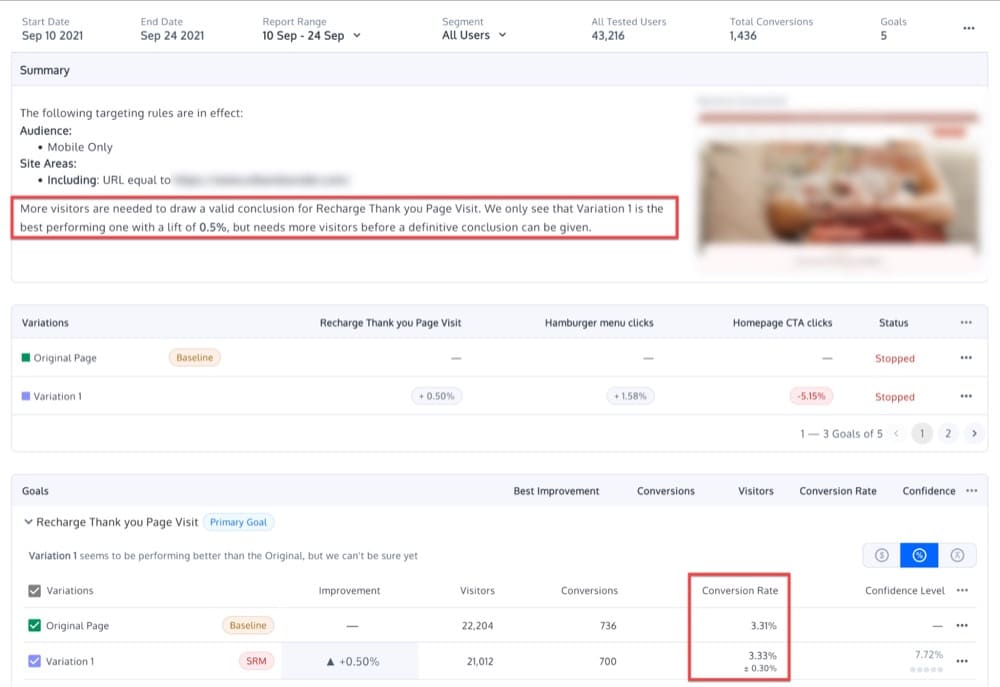

因為變化之間應該沒有差異,所以您應該只看到適度的差異並且沒有統計上顯著的結果。 也許,您會看到以下內容:

如果您得到不同的變化,這意味著什麼?

如果 A/A 體驗中的兩個相同變體之間存在相當大的差異,則可能意味著您的A/B 測試軟件未正確實施或測試工具效率低下。

但是,也有可能是體驗沒有正確進行,或者結果是由於隨機方差造成的。 這種抽樣誤差是在測量樣本時自然發生的,而不是測量所有訪問者。

例如,95% 的置信水平表明每 20 次出現中獎結果將出現一次,這是由於抽樣錯誤而不是兩種變體之間的有意義的性能差異。

正確執行的 A/A 體驗可能無法驗證變體身份的另一個原因是目標受眾的異質性。

例如,假設我們對一組女性進行 A/A 體驗,針對不同年齡的女性提供不同的轉化率。

即使我們正確地運行測試,使用準確的 A/B 測試工具,它仍然可能揭示兩個相同變體之間的顯著差異。 為什麼? 在這個例子中,50% 的訪問者可能年齡在 20 到 90 歲之間,而另外 50% 的訪問者可能介於 20 到 50 歲之間。不一致的結果不是平台的錯誤,而是表明這兩個受眾是非常不一樣。

最後,在運行任何類型的測試(包括 A/A 測試)時,另一個常見錯誤是不斷檢查結果並在檢測到統計顯著性時過早結束測試。

這種過早宣布獲勝變化的做法稱為“數據偷看”,它可能導致無效結果。

在 A/A 測試中窺視數據可以讓分析師看到一個變體的提升,而這兩個變體實際上是相同的。

為避免這種情況,您應該提前決定要使用的樣本量。 做出此決定的依據是:

- 最小效應大小:低於該效應對您的組織沒有意義的最小提升

- 力量

- 您認為可接受的顯著性水平

A/A 測試的目的是避免在達到樣本量後看到統計上顯著的結果。

A/A 測試的挑戰是什麼?

除了 A/A 測試可以為您的實驗策略帶來許多好處之外,以下是 A/A 測試的兩個主要缺點:

- A/A 實驗設置包含不可預測的元素。

- 需要高樣本量。

讓我們分別看看這些挑戰中的每一個。

隨機性

如前所述,執行 A/A 測試的主要原因之一是評估測試工具的準確性。

但是,假設您發現控制轉換和變體轉換之間存在差異。

A/A 測試的問題在於總是涉及到一些隨機因素。

在其他情況下,統計顯著性完全是偶然獲得的。 這意味著兩種變體之間的轉化率差異是概率性的,而不是絕對的。

大樣本量

在比較相似的變體時,需要大樣本量來確定一個變體是否比相同的變體更受青睞。

這需要大量的時間。

運行 A/A 測試會佔用“真正的”測試時間。

大規模優化計劃的訣竅是通過完全消除流程中的浪費、愚蠢和低效率來降低資源成本與機會比,以確保測試吞吐量和所學知識的速度。

在您的網站上進行實驗有點像在主要國際機場運營一家繁忙的航空公司——您的起飛時間有限,您需要確保有效地使用它們。

CXL 的克雷格·沙利文

轉換體驗和 A/A 測試

A/A 測試經常出現在更“高級”的支持請求中。

Convert 支持代理的以下建議基於數十個已解決的案例:

- 要測試您的 A/B 測試平台,請先進行 A/A 體驗。 如果兩者之間的差異在所選級別具有統計顯著性,則您的平台可能會損壞。

- 執行 A/A/B 或 A/A/B/B 測試(下面將詳細介紹),如果兩個 A 變體或兩個 B 變體在所選水平上產生統計上的顯著差異,則丟棄結果。

- 設置許多 A/A 測試。 如果比預期更多的測試顯示統計上的顯著差異,則您的平台已損壞。

如何在轉換體驗中設置 A/A 測試?

現在讓我們看看如何使用 Convert Experiences 設置幾種不同類型的 A/A 測試(是的,複數)。

純粹的 A/A 體驗

最典型的 A/A 設置是兩個相同頁面之間的 50/50 分割。

目標是通過確保每個變體具有大致相同的性能來驗證體驗配置。

您正在檢查同一件事,以發現數據是否包含噪音而不是有用的信息。

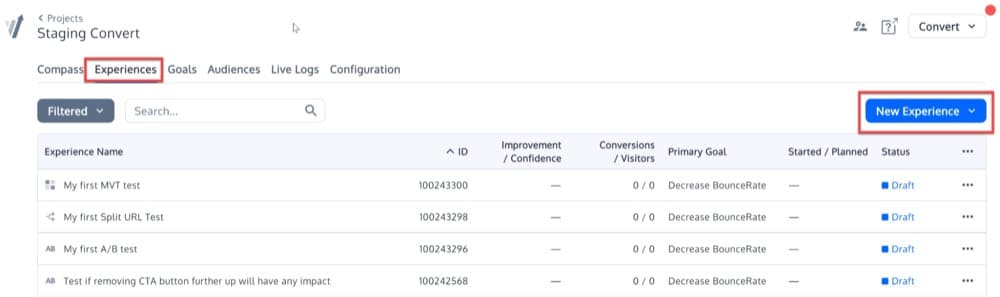

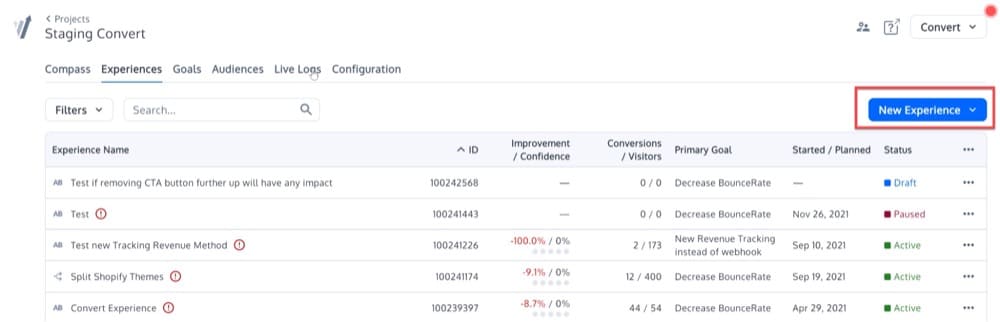

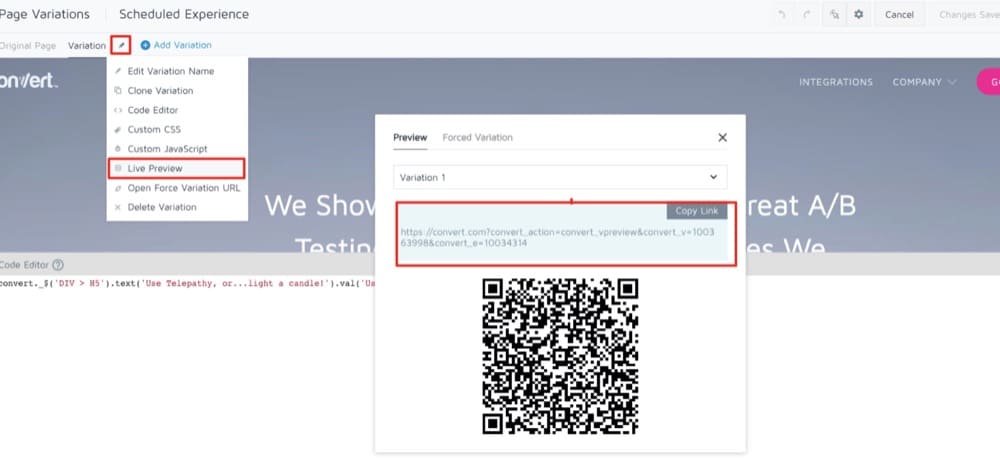

要設置這個簡單的 A/A 體驗,請單擊“體驗”菜單。 然後,點擊右上角的“新體驗”按鈕。

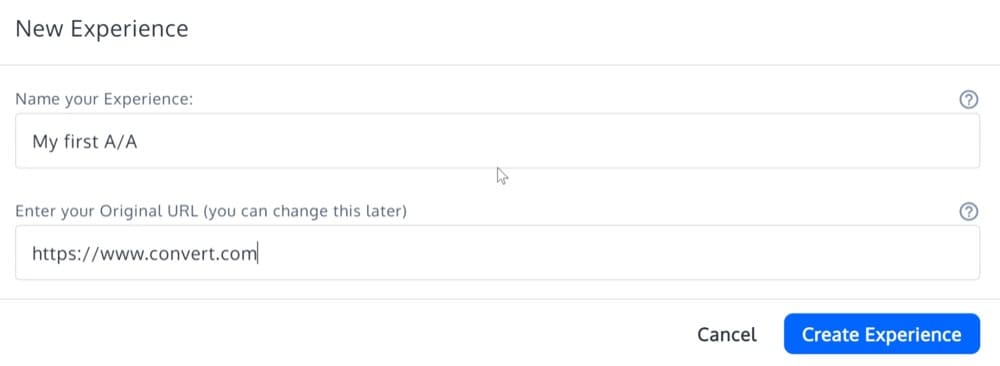

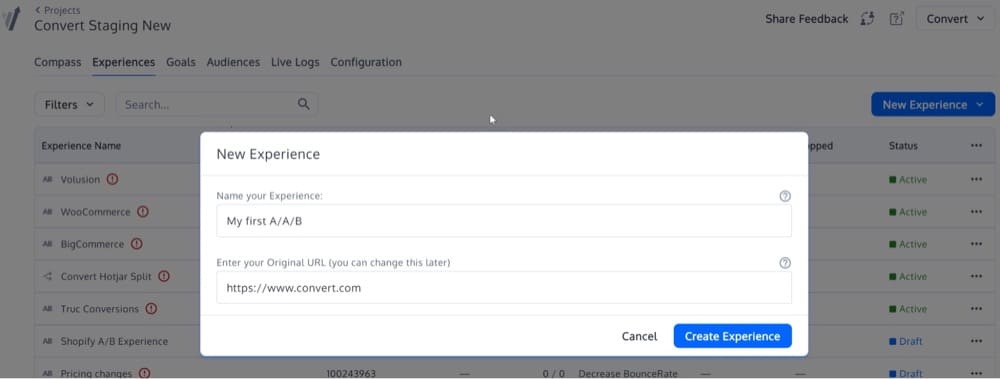

填寫“體驗創建嚮導”的詳細信息,選擇“A/A體驗”體驗類型。

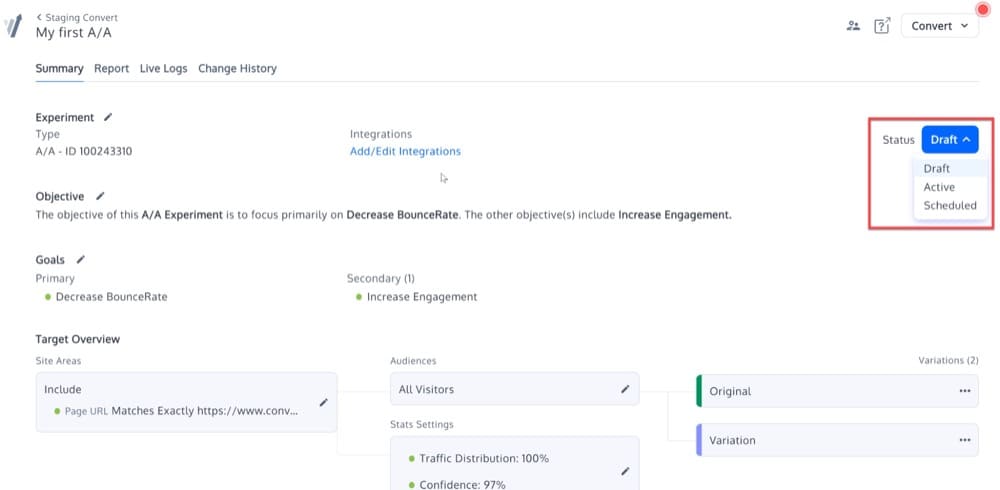

現在,應該創建您的 A/A 體驗。 除了沒有“編輯變體”選項外,它將與平台中的其他類型的實驗相同。

通過更改其狀態來激活體驗:

校準的 A/A/B 或 A/A/B/B 體驗

這種經過校準的 A/A/B 或 A/A/B/B 測試背後的想法是,複製的 A 或 B 變體提供了 A/B 測試準確性的衡量標準。

如果 A 和 A 或 B 和 B 之間的差異在統計上顯著,則認為測試無效並丟棄結果。

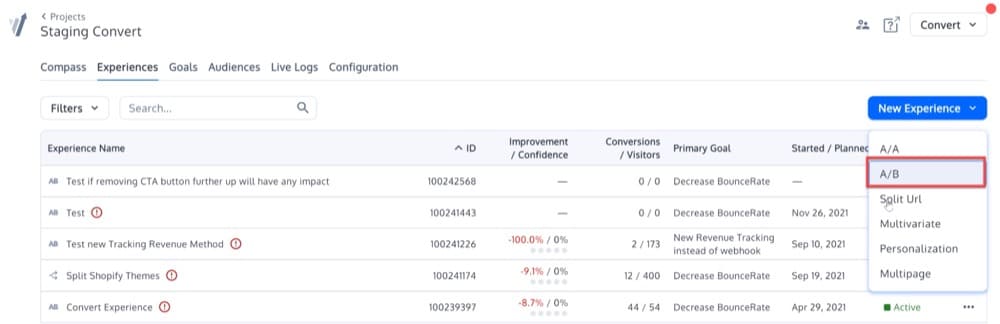

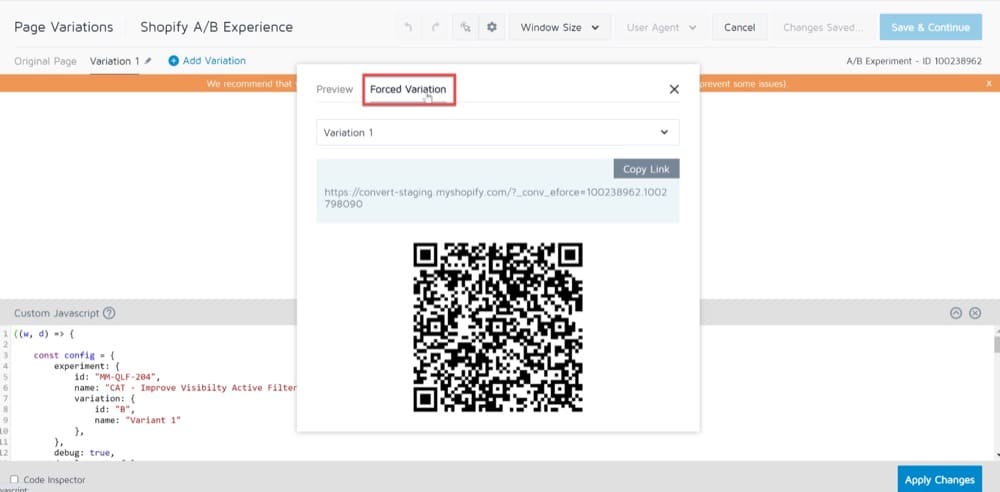

為了設置這樣的測試,您需要開始 A/B 體驗,而不是 A/A。

單擊屏幕右側的“新體驗”按鈕,開始創建新體驗。

單擊該按鈕後,您將看到此彈出菜單。 選擇選項 A/B:

然後,在第二個框中輸入您的 URL。

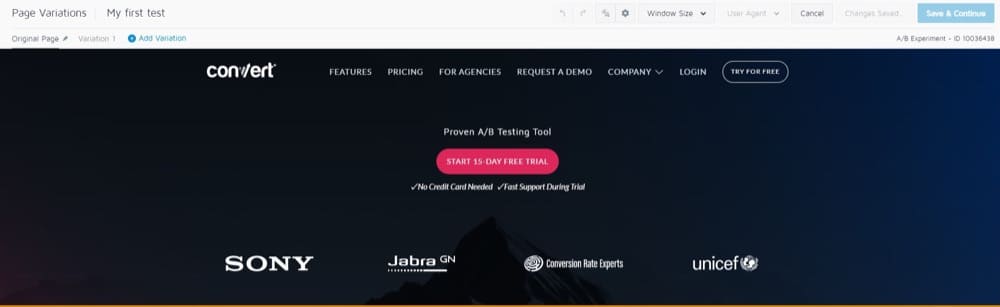

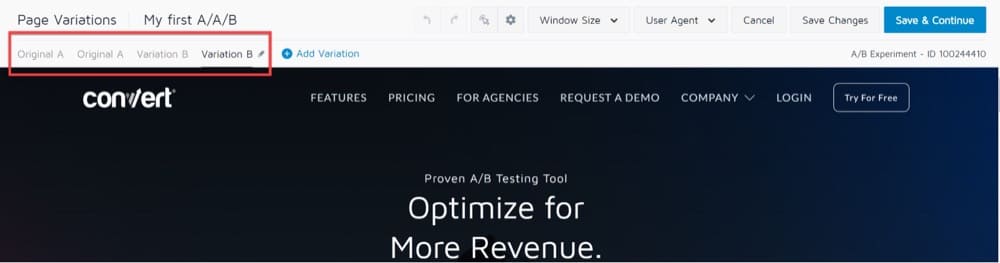

您將被帶到顯示您選擇的 URL 和頂部工具欄的可視化編輯器:

在左上角的 Page Variations 部分中,您會注意到默認選擇了“Variation 1”。

這意味著我們對這個版本的 URL 所做的任何更改都不會影響原始 URL。

這將產生一個經典的 A/B 測試,其中“A”版本是原始頁面,“B”版本是 Variation 1。

對於 A/A/B 或 A/A/B/B,您需要添加另一個變體 A 和另一個變體 B,它們分別與變體 A 和變體 B 相同。

它應該如下所示:

單擊“保存並繼續”按鈕,您就完成了!

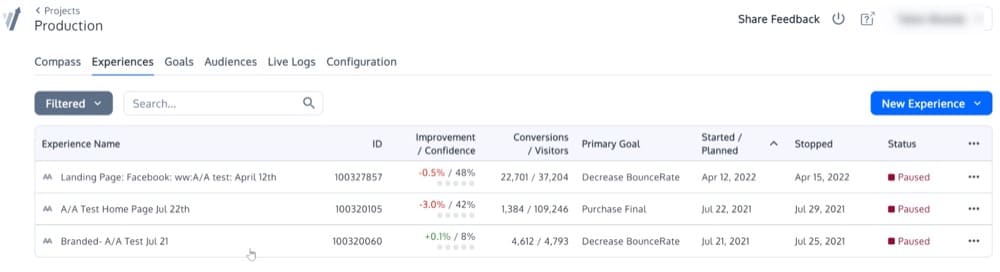

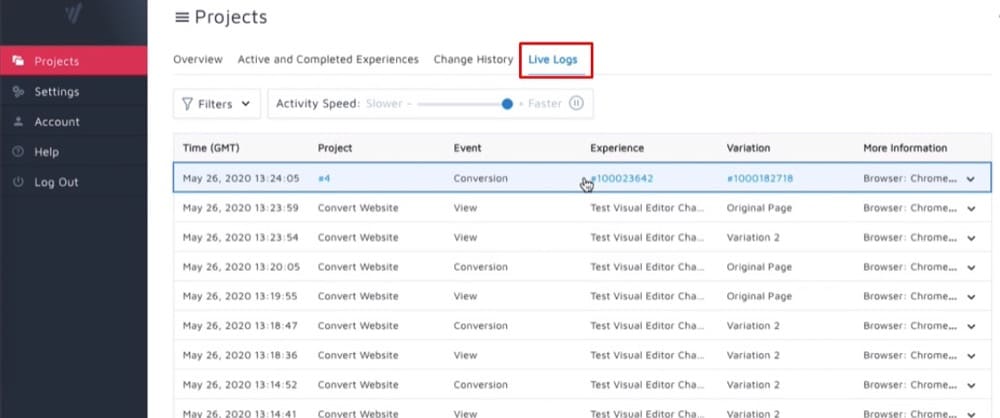

運行許多 A/A 體驗

我們已經對此進行了介紹,但是如果您對大量受眾進行 1000 次連續的 A/A 測試,遵循所有要求並比預期更頻繁地獲得具有統計意義的結果,那麼您的 A/B 測試框架可能會被破壞。

可能是樣本沒有正確隨機化。 或者,這兩種變體並不相互排斥。

這可能是這樣的:

我可以在 A/B 體驗的同時運行 A/A 體驗嗎?

您可能需要在同一網站上同時運行 A/A 測試和 A/B 測試。

在這種情況下,這裡有幾種可能性:

- 如果您同時運行它們,您將不必擔心測試會相互衝突。

- 你可以同時進行實驗,但有不同的受眾。

- 您可以按正確的順序執行測試(在繼續測試 2(A/B 測試)之前完成測試 1(A/A 測試))。

選項 3 是最安全的,但它極大地限制了您的體驗能力。

完全有可能同時在同一頁面或一組頁面上運行多個體驗。

但是,請記住,一個實驗中的分桶可能會對另一個同時發生的實驗的數據產生影響。

以下是運行並行測試時要使用的兩種最重要的轉換技術:

- 將 50% 的流量分配給 A/A 測試,同時允許其他 50% 的流量進入其他正在運行的 A/B 體驗。

- 從其他 A/B 測試中排除 A/A 訪問者。

測試前 QA 流程:A/A 測試的有趣替代方案

在決定是否進行 A/A 測試時,答案會因您詢問的對象而異。 毫無疑問,A/A 測試是一個有爭議的問題。

反對 A/A 測試的最常見論點之一是它花費的時間太長。

A/A 測試消耗大量時間,並且通常需要比 A/B 測試大得多的樣本量。

在比較網站的兩個相同版本時,需要較大的樣本量才能證明存在顯著偏差。

因此,測試將需要更長的時間才能完成,可能會減少花在其他重要測試上的時間。

在您沒有太多時間或高流量的情況下,最好考慮進行預測試 QA 流程。

在這篇博客文章中,我們將引導您完成執行完整 QA 流程所需遵循的所有步驟。 您使用的方法取決於您自己,取決於您有多少時間。

SRM 可以存在於 A/A 測試中嗎?

問問自己:如果將用戶分成兩半,在 A/A 測試期間觀察到的實際用戶數量是否接近 50/50 比率(或 90/10 比率,或任何其他比率)?

如果不是,您將面臨以下兩個問題之一:您從代碼中調用測試基礎設施的方式存在問題(使其在一側“洩漏”)或測試基礎設施的問題分配機制。

採樣率不匹配錯誤(SRM 錯誤)是 A/A 測試可以檢測到的缺陷。

如果您的比率達到 65/35,您應該在使用相同的定位策略運行另一個 A/B 測試之前調查問題。

A/A 測試的優點是否大於缺點?

雖然 A/A 測試不應該每月進行一次,但在設置新的 A/B 工具時測試您的數據是值得的。

如果您現在捕獲錯誤數據,那麼您在以後的 A/B 測試結果中就會更有信心。

雖然最終決定權在您手中,但如果您開始使用新工具,強烈建議您進行 A/A 測試。 如果沒有,我們建議您設置嚴格的測試前 QA 程序,因為 A/B 測試將為您節省時間、金錢和流量。

我們希望上面的屏幕截圖回答了您的問題,但如果沒有,請註冊一個演示,親眼看看使用 Convert Experiences 設置 A/A 測試是多麼容易。