如何處理 SEO 網站遷移

已發表: 2017-10-13在網站的生命週期中,SEO 網站遷移階段是重要的時刻,在此期間您必須注意許多細節,以免對 SEO 產生負面影響。

每個站點遷移都是不同的。 遷移並不意味著立竿見影,但它是改善您的 SEO 的最佳時機。 必須理解的是,當一個站點發展時,搜索引擎並不總是處於相同的時間,並且它或多或少會有一個重要的適應時間。 然而,這是網站提高技術質量、使用 HTML5 和 json-ld 豐富代碼、由於內部鏈接架構、編輯豐富性和向搜索引擎返回強大的 SEO 信號而形成孤島的最佳時機。

根據發生的變化,有幾種類型的站點遷移,通常涉及以下一個或多個元素:

- 主機 / IP 地址

- 域名

- 網址結構

- 網站架構

- 內容

- 設計理念

遷移最困難的站點涉及上述大部分(或全部)的變化。

如果 SEO 重新設計管理得當,遷移前和遷移後都會有一個。 花時間了解網站的痛點並努力糾正它們。 提高性能,使可抓取性更容易。 從長遠來看,您將成為贏家。

在本文中,我們將為您提供安全 SEO 網站遷移的最佳實踐。

SEO網站遷移的關鍵步驟、操作和文件

受控遷移是精心準備的遷移。 因此,如果您遵循一系列結構化步驟,您將是有效的。 這些步驟還允許您積累一組文檔和數據,您可以在整個遷移週期中依賴這些文檔和數據,然後確定遷移的好(或壞)影響。

下表列出了根據目標的操作和遷移文檔:

| 目標 | 行動 | 文件 |

| 網站圖片 | – 初步 CrawlAggregate 服務器日誌數據 | 抓取報告 技術文件(robots.txt、站點地圖、舊重定向文件) 已爬網/未爬網 url、孤立頁面和每個天的爬網頻率表 |

| 從外部工具編譯、聚合和存儲數據 | – 閱讀數據Google Analytics、Omniture、AT Internet、Search Consoles (Bing/Google)、SemRush、MyPoseo、Majestic、SEObserver、... | 按表達/利基導出位置、點擊率和印象 分析數據導出 反向鏈接導出、TF/CF、利基、 從利基市場導出關鍵詞 關鍵詞搜索 數據交叉 |

| 確定需要改進的領域 | – 審計和數據分析 | 任務列表 |

| 主題優先級 | – 收益/努力的評估 | 投資回報矩陣 |

| 規格 | – 收益/努力的評估 | 對 SEO 友好的代碼的要求表達式和附件 |

| 生產 | - 發展 – 知識實施 | 圍繞關鍵點進行團隊討論 質量代碼 |

| 修改檢查 | – 技術配方 – 代碼驗證代碼保證 | 比較抓取報告 每日更正 報告 驗證 D 日要進行的測試 |

| 居住 | – 部署新代碼和文件(站點地圖、robots.txt、重定向) – 新站點的完整性測試 - 新站點地圖的聲明 - 使用 Search Console 強制引擎抓取 | 在生產中傳遞新代碼 確保最新的 XML 站點地圖文件 驗證機器人。 txt優化 重定向文件(如果適用) 在生產中具有預期和穩定的代碼 |

| 實時監控 | - 爬行爬行 - 重定向網址的抓取 | 返回數據比較 關鍵績效指標發展報告 |

遷移前的數據編譯和分析

初步抓取

了解站點的問題對於準備規範和遷移監控 KPI 至關重要。 為了更好地了解該站點並發現需要改進的地方,我們邀請您在遷移前拍攝該站點的完整照片。

為此,請按照與 Google 所遵循的原則相同的原則啟動抓取:考慮機器人。 txt,後跟帶有查詢字符串的鏈接。 如果您的遷移包括多個子域,OnCrawl 允許您發現和爬取子域。

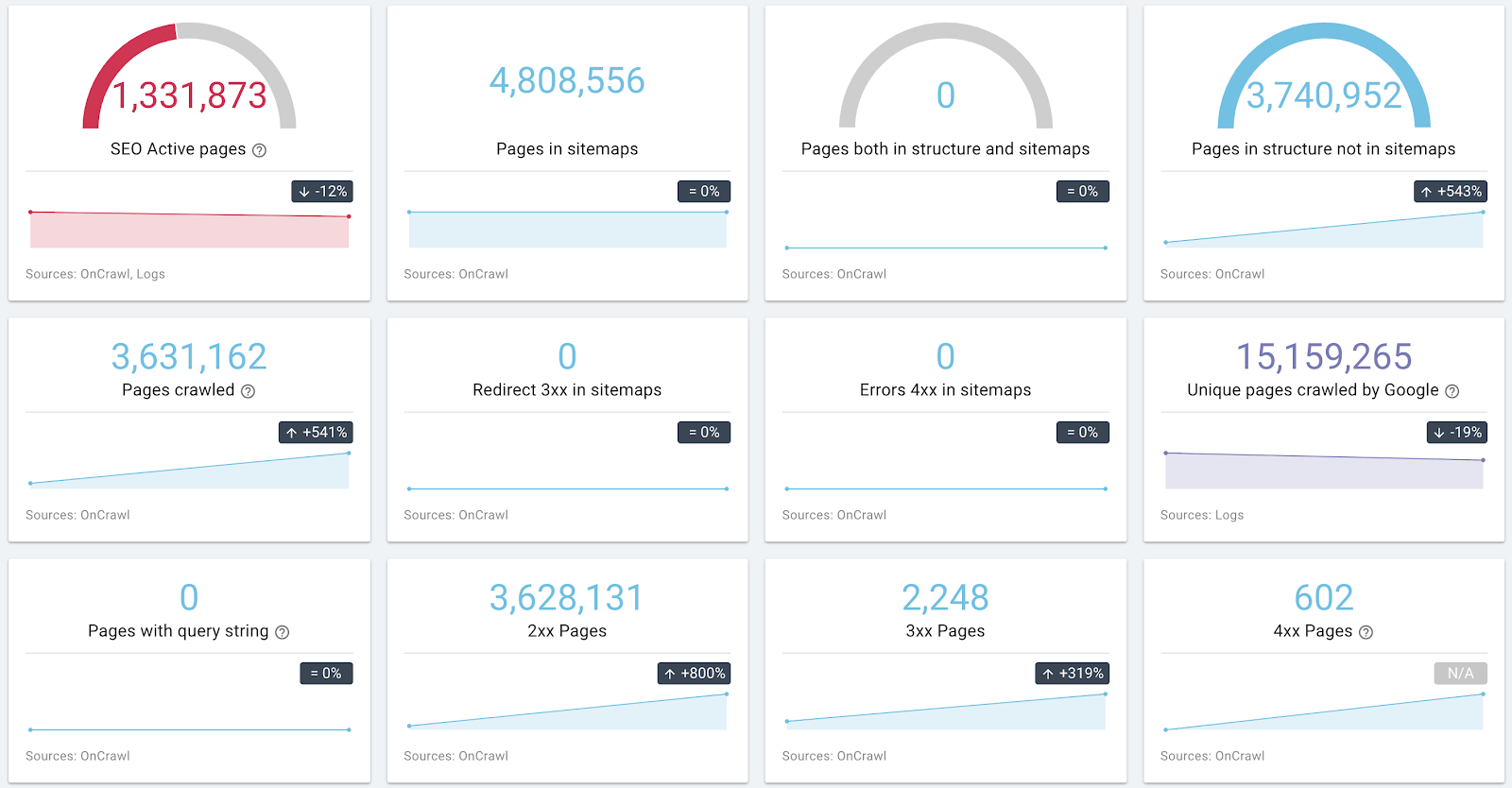

有關站點架構和健康狀況的信息示例

如果您有可能收集日誌數據,請不要猶豫,為每個 URL 這樣做。 Crawl/Logs 交叉引用的數據可用於確定一組頁面的成功因素。

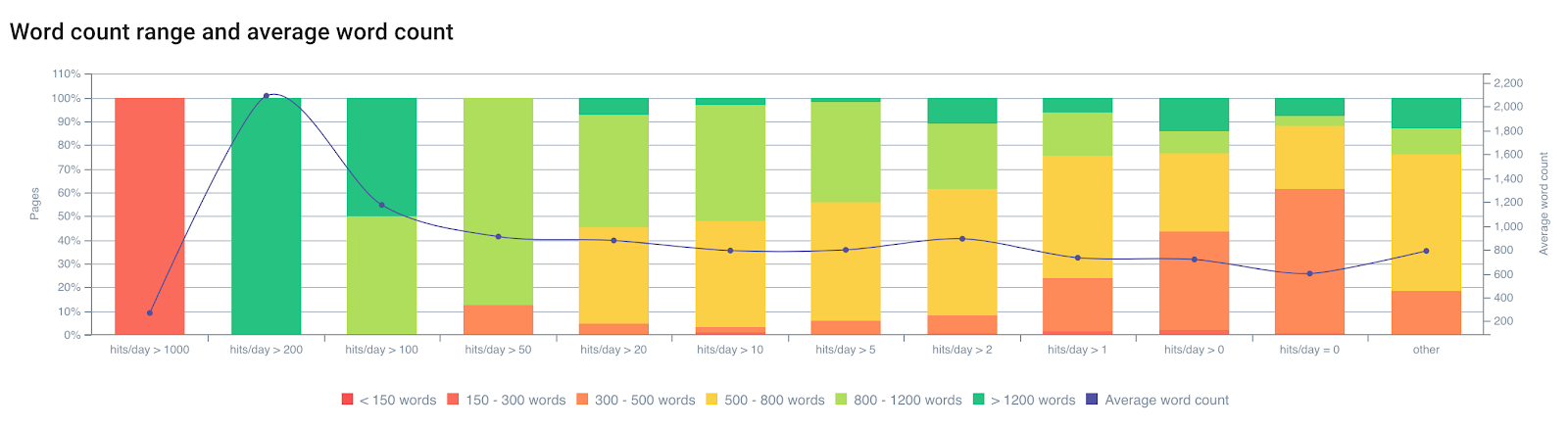

根據字數查看bot hits/day

根據經驗,我們知道 Google 的抓取會受到多個頁面因素的影響。 Google 不會以相同的頻率瀏覽所有頁面。 它的索引不會為這些頁面刷新,因此它會傾向於降級它們。 索引中過時的頁面不再一定是用戶請求的“最佳答案”。 爬取頻率、索引更新和排名之間有很強的關係。

如果出現以下情況,頁面將被較少抓取:

- 建築太深了;

- 它不包含足夠的單個文本;

- 它沒有足夠的內部鏈接(也包括外部鏈接);

- 加載速度不夠快或太重;

- … ETC。

想了解更多關於頁面內因素對谷歌抓取的影響,可以閱讀《谷歌重要性頁面》一文,讓你詳細了解谷歌與“抓取調度”相關的專利。

初步爬網可讓您了解您的網站。 它還允許您對將成為優化驗證頁面的頁面進行分類。 您的初步分析必須將這些數據考慮在內,以糾正影響抓取的因素。

從外部工具讀取數據

谷歌搜索控制台/必應搜索控制台/必應搜索控制台

在 Google 和 Bing 的 Search Console 上,您會找到定性和定量數據。 收集這些數據以監控改進是非常好的做法。

我們邀請您再次交叉檢查這些數據,以了解定位自己的頁面的共同特徵、缺少關鍵字或與移動/AMP 或 SEO 錯誤相關的問題。

要存儲的重要數據:錯誤的數量和類型、抓取預算(每天的點擊次數)和加載時間、HTML 改進、索引頁面的數量、按表達式和 url 的位置/點擊率/印象。

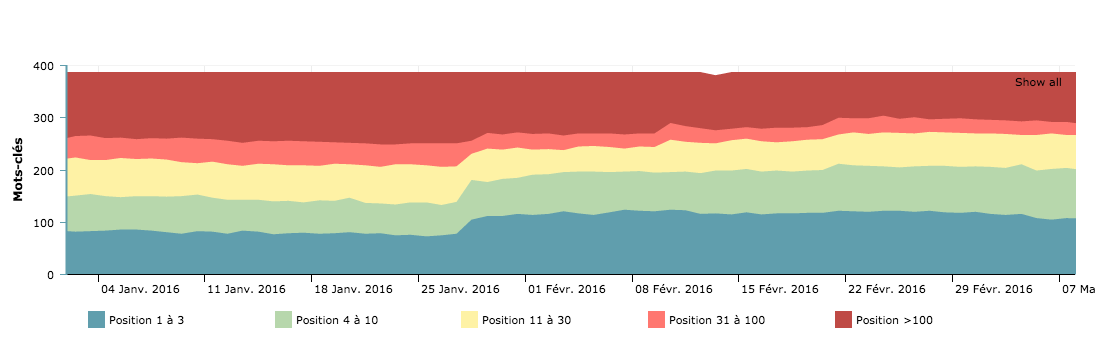

每天瀏覽的頁面 - 用於比較遷移前後的抓取預算曲線

來自搜索引擎的這些視圖讓您了解他們如何解釋您的網站。 它也是 KPI 遷移後監控的基礎。 重要的是要考慮引擎報告的 SEO 錯誤以首先糾正它們。

排名和知名度

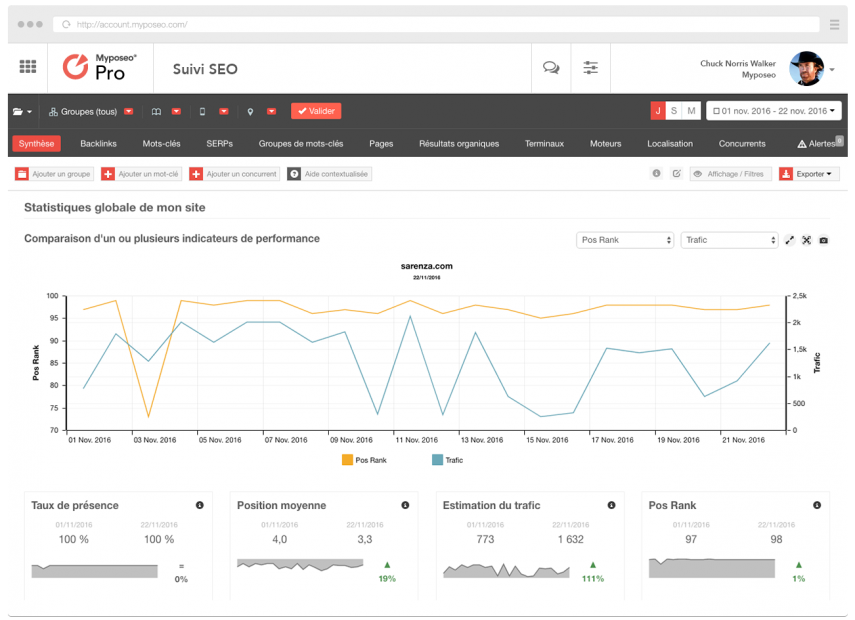

MyPoseo 等定位跟踪工具簡化了對網站可見性和關鍵字的研究。

除了 Google Search Console 數據之外,您還需要了解您在利基市場的可見度。 這些數據對於您的遷移後分析至關重要。

分析

跟踪和分析解決方案可用於收集用戶的使用數據。 它們也是有關您的網頁在自然訪問、跳出率、轉換隧道、路線和網站吸引力方面的表現的信息來源。 您需要導出數據,以便檢測需要改進的區域並存儲它們以供您進行實時分析。

通過 Google Analytics 導出過去 12 個月內至少獲得一次訪問的所有 URL 是檢索大量有價值的索引頁面的一種方法。

對登錄頁面進行分類以優先考慮您的操作,不要錯過未審核的頁面,並再次嘗試檢測性能因素以激發您的建議。

分割

在初步爬網和外部數據記錄之後,您將擁有遷移邊界的完整視圖。 根據您的分析,您可以創建可根據不同指標進行分組的頁面集,以限定您的遷移。

使用 OnCrawl,可以創建 10 組或一組 15 組頁面。 為什麼不使用此功能來創建遷移集?

對每個需要改進的領域進行分類。 OnCrawl 允許您根據 350 多個指標創建組——例如差、重、重複、機器人未訪問、用戶訪問少、傳入鏈接太少或太深。 他們將允許您對重新設計進行後驗驗證。

專業提示:您可以將所有響應時間超過 1 秒的頁面、抓取率較差的頁面以及排名數據和人類行為的交叉(GSC 上的 CTR 或分析上的跳出率)分組。 您將能夠做出正確的決定。

交叉檢查爬網、日誌和分析數據是為您的遷移執行完整和現實分析的最佳方式。

要編輯、創建、刪除的頁面

由於收集到的數據,您將能夠識別訪問次數最多的頁面、重複內容率最高的頁面、架構中的缺失頁面等。

您應該記住,重組除了糾正最不利的 SEO 問題和 SEO 合規性外,還應該讓您的網站圍繞引擎用戶的關鍵語句進行豐富和重新調整。 他們用自己的話搜索您頁面中存在的數據。 探索和語義調整的工作是一項經常被忽視的任務,但它可以在排名方面獲得最佳性能。

需要添加新的中心和登錄頁面以最適合用戶的需求。 它們必須與網站最不適合的查詢對齊。

[案例研究] 避免重新設計對您的 SEO 造成不利影響

內部鏈接管理

內部鏈接現在比以往任何時候都成為成功進行 SEO 重組的關鍵因素之一。 錨的變化、內部流行度擴散的優化和錨的語義對齊是強大的盟友。

使用 OnCrawl 表示優化的內部鏈接

花點時間了解您的網頁的受歡迎程度是如何通過各種鏈接塊傳播的。 盡量減少頁面上不相關的鏈接。 最好的例子是超級菜單。

避免從所有頁面鏈接到所有頁面; 這是適得其反的。 從 HTML 代碼中刪除不屬於同一筒倉的鏈接,同時保留指向類別標題的鏈接。

導航也是一個機器人陷阱。 嘗試使用一種算法在頁面之間創建快捷方式,該算法允許您跳轉到最近的單位、十、百。

嘗試盡可能多地改變指向頁面的錨點。 這使您可以向引擎顯示您正在使用廣泛的語義領域,並有利於頁面重要性得分,從而有助於頁面的抓取。

還要考慮減少或分割頁腳鍊接,以避免創建沒有吸引力和非常受歡迎的頁面。 CGU 或時事通訊訂閱鏈接以及來自您域的傳出鏈接與內部頁面排名洩漏一樣多。 還要注意社交網絡的鏈接,這些網站通常比您的網站大,而且它們會佔用您網站的頁面排名。

重定向

這項活動需要很多關注,因為事情可能會出錯。 檢索當前的重定向規則很重要,這樣您就可以將它們與新的樹結構(如果有)匹配。 舊的重定向規則需要更新以避免重定向字符串。

還需要檢查所有舊網址是否以 301 重定向到新網址。

可以通過導出所有舊 url 的列表並將它們添加到最大深度為 1 的起始 url 來進行測試爬網。

對於 HTTPS 遷移的特殊情況(無論是否更改 url 結構),請確保所有內部鏈接都已更新(沒有從 HTTPS 頁面到 HTTP 頁面的內部鏈接)。 有海關字段 OnCrawl 來執行此操作。

專業提示:創建要排名的頁面的快捷方式頁面(產品頁面歸功於中心頁面),改善加載時間,增加頁面內容量,創建站點地圖並更正孤立頁面,規範頁面,減少重複內容......

重要的是要強調高流量頁面需要特別注意,但在 SEO 中每個 URL 都很重要。

重要的是要強調高流量頁面需要特別注意,但在 SEO 中每個 URL 都很重要。

配方階段

遷移的這個重要階段是您需要注意源代碼中的任何錯誤或理解需求表達的時期。

保護搜索引擎開發平台

htpasswd 是推薦的解決方案,可避免搜索引擎看到您抓取的暫存網址。 此方法還確保您不會運行阻止 robots.txt 文件或元機器人“禁止”。 它比看起來更頻繁地發生。

專業提示:您正在開發的站點必須是 ISO 以保證未來站點的代碼。

檢查每個代碼交付的質量

在此階段,您必須通過在食譜平台上定期啟動爬網來檢查站點是否朝著正確的方向移動。 我們建議您創建 Crawl Over Crawl 來比較兩個版本。

不要猶豫,檢查一下:

- 鏈接果汁傳輸和內部鏈接;

- 頁面深度的演變;

- 錯誤 40x 和這些頁面的鏈接;

- 錯誤 50x 和這些頁面的鏈接;

- 標題、元描述和機器人標籤的質量;

- 源代碼和重複內容元素的質量。

確保代碼符合 W3C。 我們經常忘記它,但它是谷歌的第一個建議,語義數據不包含錯誤,源代碼處於野心級別,優化規則應用於整個邊界。

專業提示:需要更新舊的重定向規則以防止重定向指向新的重定向。

有必要檢查所有舊網址是否以 301 重定向到新網址。 可以通過導出所有舊 url 的列表並將它們添加到 start url 中進行測試爬網,最大深度為 1。

站點地圖。 xml 文件

當代碼穩定並且所有的url都被測試爬蟲發現後,就可以導出站點的所有url了。 這允許您構建您的 sitemap.xml 文件(或 sitemap_index.xml)。

在您的 robots.txt 中添加地址並將它們放在站點的根目錄中(如此處提供的站點地圖規範所建議的那樣)

專業提示:通過網站的大部分創建站點地圖,您可以在 Google Search Console 中獨立跟踪網站每個部分的索引。

創建一個包含所有舊重定向 url 的站點地圖文件,以強制引擎傳遞每一個。

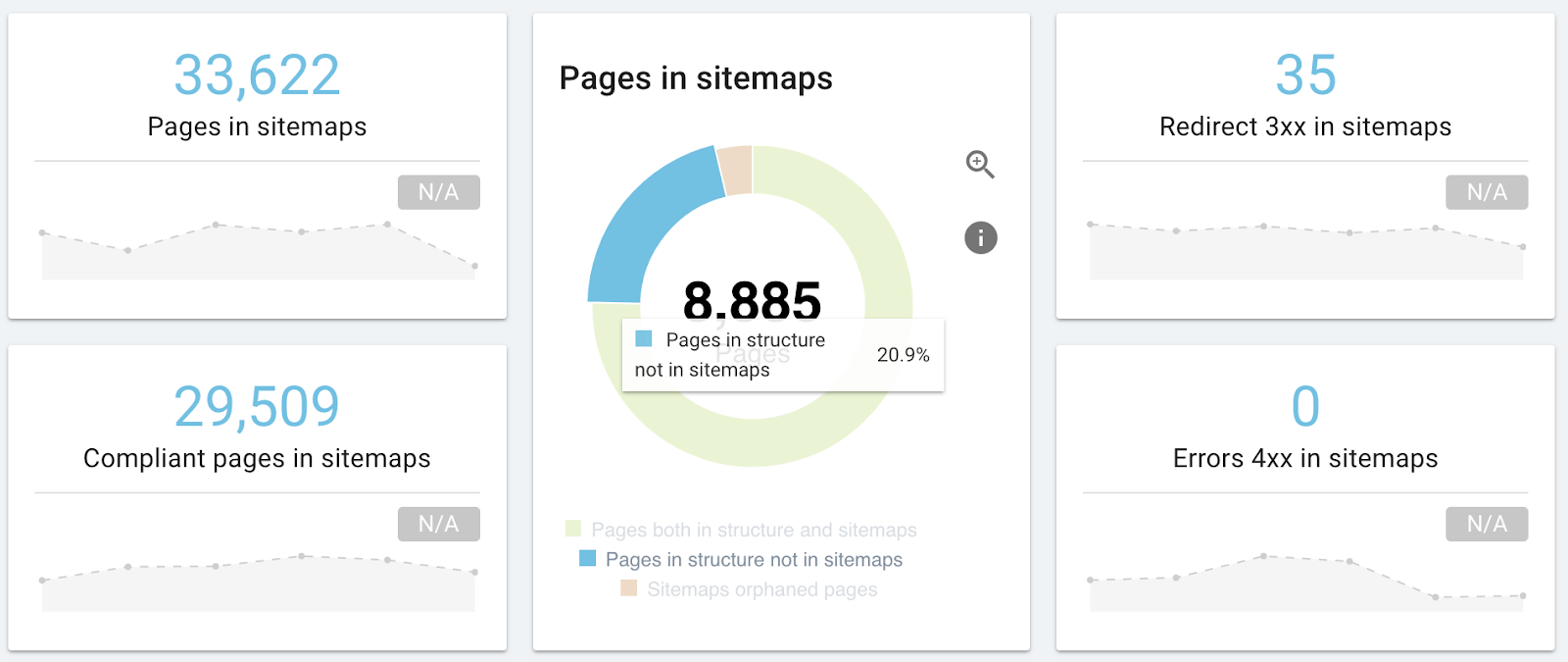

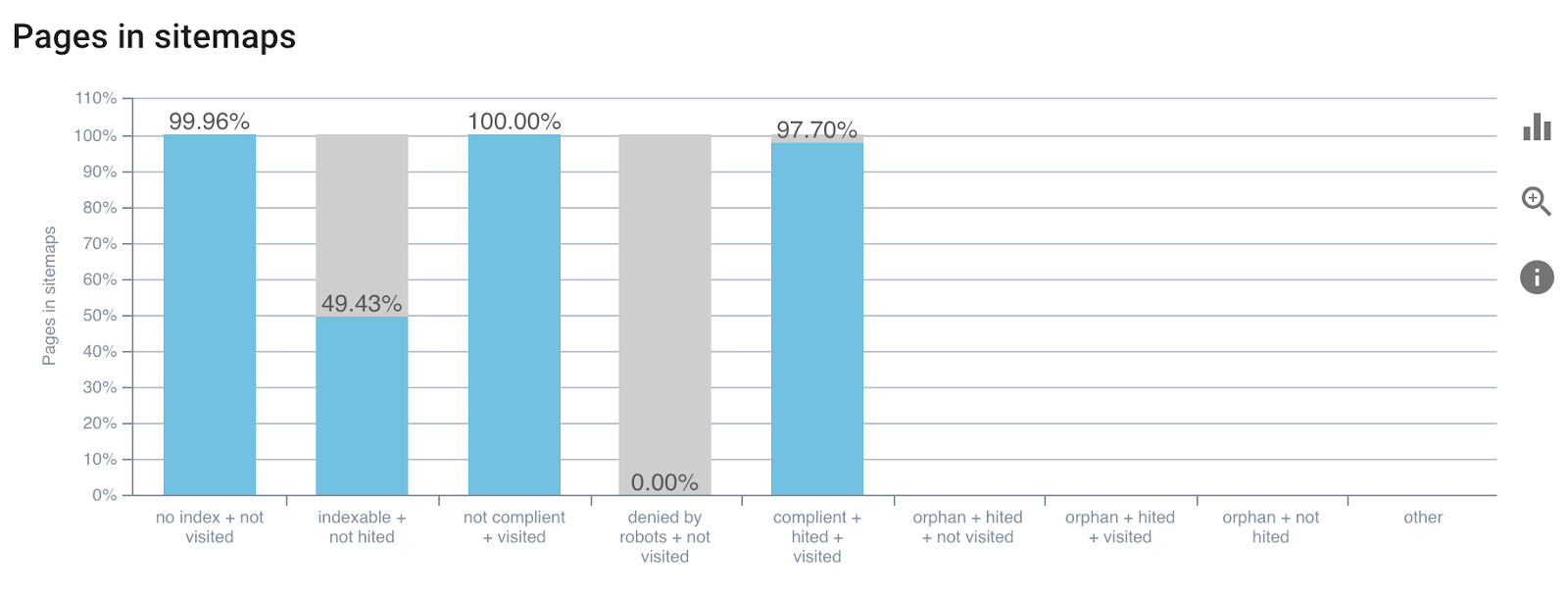

最新版本的 OnCrawl 將包含一份與 sitemap.xml 研究相關的報告。 它將允許您驗證您沒有錯過 url,您的站點地圖沒有指向規範與 url 不同的頁面,或者它們指向 404。

站點地圖分析報告示例

了解有關站點地圖的更多信息。 xml。

過渡到現場版的日子

配方完成,代碼由所有玩家驗證。 所以你有所有的綠色信號來傳遞新的代碼。 SEO 不會受到影響,因為重要的頁面值得特別關注。 但是,您也是 Google 方面將要執行的所有操作的保證人。

以下是您作為 SEO 的任務列表:

- 檢查 robots.txt 文件;

- 在線查看代碼;

- 檢查在線站點地圖;

- 檢查重定向;

如果一切正常:

- 強制馬達爬行

- 實時檢查日誌和狀態代碼

您可以為每個步驟啟動專門的爬網,目標是限定頁面,以便在更窄的範圍內使用爬網來獲得反應性。

專業提示:定義最大深度為 1 的爬網以測試更改的參考頁面,而不測試整個站點。

實時跟進

在線發布後,您必須能夠比較之前/之後的 SEO,並確保遷移產生了積極影響或負面影響最小。

新站點啟動並運行後,需要監控任何更改的影響。 作為第一步,每週監控排名和索引。 估計要等短短一個月才能得出結論,所以一定要耐心等待。

遷移後檢查網站管理員工具中的網站性能是否存在異常情況。

在檢查排名之前,請遵循搜索引擎對頁面的索引率和緩存。

正如我們在介紹中所說,引擎將需要一些時間來適應您的新版本,並且在此期間職位可能會非常不穩定。

在遷移前後啟動 Crawl Over Crawl(Crawl Over Crawl 比較)來比較您的數據是提高效率的最佳方式。

結論

遷移對於 SEO 來說是一個重要且通常有益的時期。 OnCrawl 將陪伴您完成這些階段。 從最初的爬取到驗證指標的跟進以及通過日誌分析搜索引擎反應,您的操作工作將得到簡化。