更新前後的抓取預算跟踪

已發表: 2019-12-10噓……有個秘密想告訴你。

您的網站有 Google 設置的“抓取預算”。

這是谷歌用來衡量兩件事的秘密指標:

- 您的網站構建得如何

- 您的網站有多受歡迎

本文將重點介紹第一點。

提高網站的構建質量將增加您的抓取預算。

您的抓取預算越大,Google 就會越頻繁地停下來閱讀您的網頁。

讓我們首先分享對抓取預算是什麼的理解。

什麼是抓取預算

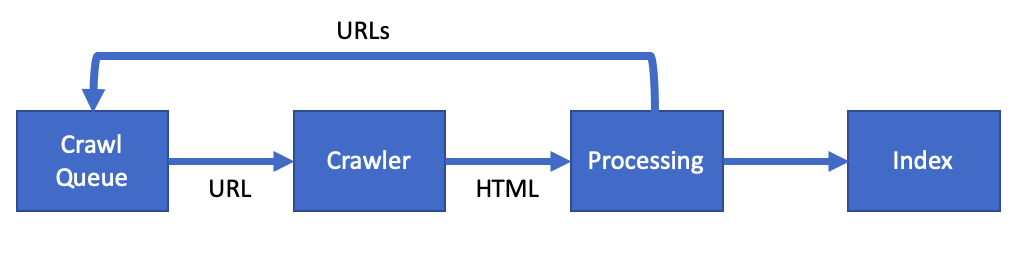

Google 使用一種稱為網絡爬蟲(或蜘蛛)的特殊軟件程序來讀取您網站上的頁面。

他們將這種網絡爬蟲稱為 Googlebot。

抓取預算是描述 Googlebot 抓取您網頁的頻率的術語。

通過優化您的網站,您可以增加抓取預算。

谷歌表示您的抓取預算是以下各項的組合:

- 抓取速度 – Googlebot 在不破壞服務器的情況下抓取您的網站的速度

- 抓取需求——你的網頁對谷歌用戶的重要性

隨著這些指標的改進,您會看到 Googlebot 更頻繁地訪問。 每次訪問時閱讀更多頁面。

一旦谷歌抓取了一個頁面,它就會將內容添加到谷歌索引中。 然後更新谷歌搜索結果中顯示的信息。

通過優化抓取預算,您可以提高從您的網站更新到 Google 搜索的速度。

為什麼你應該提高你的抓取預算

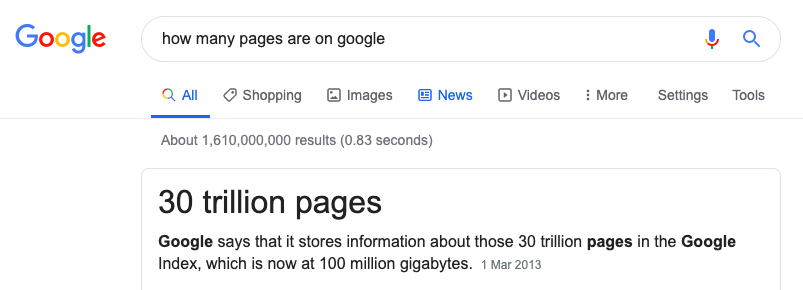

谷歌有一項艱鉅的任務。 他們需要對互聯網上的每一頁進行抓取和索引。

他們需要這樣做的力量是巨大的,他們不能索引每一頁。

優化您的抓取預算將使您的網站有最好的機會出現在搜索中。

[案例研究] 管理 Google 的機器人抓取

如何提高您的抓取預算

改進網站是為了讓 Googlebot 在網站上的時間盡可能高效。

我們不希望:

- Googlebot 正在閱讀我們不希望在 Google 搜索中出現的頁面。

- Googlebot 發現服務器錯誤

- Googlebot 跟踪損壞/死鏈接

- Googlebot 正在等待頁面加載

- Googlebot 讀取重複內容

以上都是在浪費谷歌寶貴的資源,可能會看到你的抓取率下降。

抓取預算和技術搜索引擎優化

作為技術 SEO 的一部分,您需要做的很多事情與優化抓取預算相同。

我們需要:

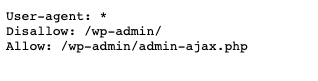

- 優化 robots.txt 並檢查錯誤

- 修復任何 hreflang 和規範鏈接標籤

- 解決非 200 頁

- 修復重定向和任何重定向循環

- 確保任何站點地圖都沒有錯誤

接下來讓我們看看如何為 Googlebot 創建完美的頁面。

如何創建完美的頁面

好的,所以也許不是完美的頁面,但我們應該盡可能地嘗試和改進頁面。

讓我們看一些您可以改進的常見頁面問題。

頁面問題

- 重複內容 - 使用規範鏈接標籤標記您網站上的任何重複內容。

- 非 SSL 頁面 – 查找任何 HTTP 鏈接並將其轉換為 HTTPS。 如果您沒有 SSL 證書,請從 Let's Encrypt 獲得免費證書。

- 只抓取有用的頁面 - 使用您的 robots.txt 文件來減少 Googlebot 可以去的地方。 例如,如果您有用於管理員的頁面,則在您的 robots.txt 文件中禁止此操作。

- 內容稀少 - 考慮阻止對內容稀少或非常少的頁面的抓取。 如果您的頁面對用戶沒有什麼價值,那麼不要在這些頁面上浪費 Googlebot 的時間。

- 服務器錯誤——服務器錯誤是網絡服務器不健康的標誌。 如果您的網站返回 5xx 錯誤,則修復這些錯誤可以提高抓取速度。

緩慢加載頁面

提高爬網預算的一種方法是使頁面快速。

快速頁面使 Googlebot 更快,這向 Google 表明網絡服務器“健康”。

谷歌已經說過頁面速度會提高抓取速度:

使網站更快可以改善用戶體驗,同時還可以提高抓取速度。

- 頁面權重- 該指標是頁面的整體大小。 這包括頁面上的所有 Javascript CSS 和圖像。 總共應該小於 1mb。

- 優化圖像– 圖像應盡可能小,以 KB 為單位,而不會損失質量。 使用像 Squoosh 這樣的工具可以幫助解決這個問題。

- 縮小的 CSS 和 JS – 縮小你的 JS 和 CSS 文件。 這是從文件中刪除所有不必要字符的過程。 使用 CSSNano 和 UglifyJS 來縮小文件。

- 壓縮和緩存- 確保服務器上的 GZip 或 BR 壓縮。 這將加快獲取文件所需的時間。 添加緩存,以便文件只下載一次。

有關頁面速度改進的列表,請查看此深入的網站性能審查。 它有 30 個步驟來提高網站性能。

衡量你的改變的方法

作為一個聰明的 SEO,你知道在開始任何優化之前你需要跟踪變化。

您需要選擇具有兩個屬性的數據點:

- 您必須能夠隨時間跟踪數據點。

- 您必須能夠通過您的行動影響該數據。

那麼我們應該為抓取預算跟踪的數據點是什麼?

我們之前說過,Google 在決定抓取預算時會考慮兩個因素:

- 抓取速度– Googlebot 在不破壞服務器的情況下抓取您的網站的速度

- 抓取需求——你的網頁對谷歌用戶的重要性

由於我們是技術 SEO,我們的工作是提高抓取速度。

所以這是我們應該跟踪的數據點。

跟踪抓取率

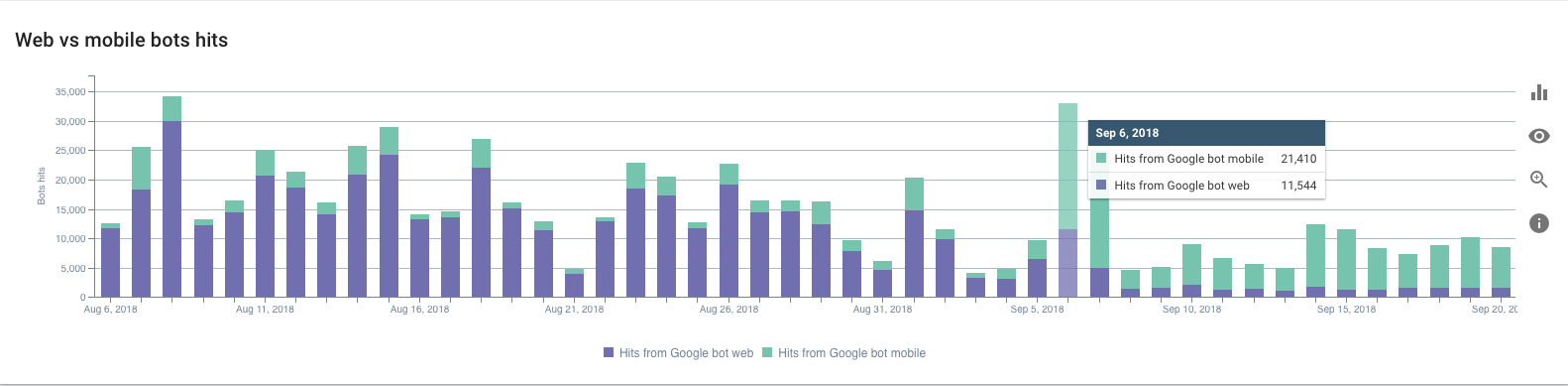

那麼我們如何跟踪 Googlebot 的抓取率呢?

我們需要使用您的網絡服務器訪問日誌。

日誌存儲向您的網絡服務器發出的每個請求。 每次用戶或 Googlebot 訪問您的網站時,都會將日誌條目添加到訪問日誌文件中。

以下是 Googlebot 條目的外觀:

127.0.0.1 - - [11/Nov/2019:08:29:01 +0100]“GET /example HTTP/1.1”200 2326“-”“Mozilla/5.0(兼容;Googlebot/2.1;+http://www .google.com/bot.html)"

每個日誌中有三個重要的數據點。 日期:

[2019 年 11 月 11 日:08:29:01 +0100]

網址:

“GET /example HTTP/1.1”

用戶代理告訴我們是 Googlebot 發出請求:

“Mozilla/5.0(兼容;Googlebot/2.1;+http://www.google.com/bot.html)”

以上日誌來自 Nginx 網絡服務器。 但是,所有 Web 服務器(例如 Apache 或 IIS)都將具有類似的訪問日誌條目。

根據您的設置,您可能擁有內容交付網絡 (CDN)。 Cloudflare 或 Fastly 等 CDN 也會創建訪問日誌。

儘管有可能,但手動分析訪問日誌並不是最有趣的。

您可以下載 access.log 並使用 Excel 對其進行分析。 但是,我建議您使用日誌分析器,例如 OnCrawl 的日誌分析器。

這將允許您在圖表上實時查看 Googlebot 的抓取速度。 一旦你有了這個監控設置來跟踪抓取率,你就可以開始改進它。

做出改變

現在我們知道我們正在跟踪什麼,我們可以考慮進行一些改進。 但是,不要同時進行很多更改。 有條不紊,一一做出改變。

建造、測量、學習。

使用這種技術,您可以在學習時調整您所做的更改。 專注於提高爬取率的任務。

如果你急於一次改變太多,可能很難理解結果。

很難分辨什麼有效,什麼無效。

隨著頁面的改進,隨著時間的推移,您會看到隨著抓取速度的提高,抓取預算也會增加。

總結,更新前後的預算跟踪

我們已經準確地涵蓋了抓取預算是什麼。

作為技術 SEO,您有能力提高網站的抓取速度。

提高技術健康度可以讓 Googlebot 在您的網站上的時間更高效。

使用您的日誌跟踪抓取速度以獲得準確的結果。

使用構建、測量、學習作為一種技術,一次做出一個改變,並隨著你的進步而改進。

隨著時間的推移,您的抓取速度會提高。 您的網頁會更快地出現在 Google 搜索結果中。 用戶將在您的網站上獲得出色的體驗。