25 個用於從網站高效提取數據的最佳網絡爬蟲工具

已發表: 2023-06-15網絡爬蟲工具簡介

網絡爬蟲工具,也稱為蜘蛛或網絡爬蟲,對於希望從網站中提取有價值的數據以進行分析和數據挖掘的企業來說是必不可少的。 這些工具具有廣泛的應用,從市場研究到搜索引擎優化 (SEO)。 他們從各種公共來源收集數據,並以結構化和可用的格式呈現。 通過使用網絡爬蟲工具,公司可以跟踪新聞、社交媒體、圖像、文章、競爭對手等等。

25 種最佳網絡爬蟲工具,可快速從網站中提取數據

廢料

Scrapy 是一種流行的基於 Python 的開源網絡爬蟲框架,允許開發人員創建可擴展的網絡爬蟲。 它提供了一套全面的功能,可以更輕鬆地實施網絡爬蟲和從網站提取數據。 Scrapy 是異步的,這意味著它不會一次一個地發出請求,而是並行地發出請求,從而實現高效的爬行。 Scrapy 作為成熟的網絡爬蟲工具,適用於大型網絡爬蟲項目。

主要特徵

- 它以 JSON、CSV 和 XML 等格式生成提要導出。

- 它內置支持通過 XPath 或 CSS 表達式從源中選擇和提取數據。

- 它允許使用蜘蛛自動從網頁中提取數據。

- 它快速而強大,具有可擴展和容錯的架構。

- 它易於擴展,具有插件系統和豐富的 API。

- 它是可移植的,可以在 Linux、Windows、Mac 和 BSD 上運行。

價錢

- 它是一個免費工具。

解析中心

ParseHub 是一個網絡爬蟲工具,可以從使用 AJAX 技術、JavaScript、cookie 等的網站收集數據。 它的機器學習技術可以讀取、分析網絡文檔,然後將其轉換為相關數據。 ParseHub 的桌面應用程序支持 Windows、Mac OS X 和 Linux 操作系統。 通過提供用戶友好的界面,ParseHub 專為想要從網站提取數據的非程序員而設計。

主要特徵

- 它可以抓取使用 AJAX、JavaScript、無限滾動、分頁、下拉、登錄和其他元素的動態網站。

- 它易於使用,不需要編碼技能。

- 它是基於雲的,可以在其服務器上存儲數據。

- 它支持IP 輪換、定時收集、正則表達式、 API 和 web-hooks。

- 它可以導出JSON 和 Excel格式的數據。

價錢

- ParseHub 有免費和付費計劃。 付費計劃的價格從每月 149 美元起,提供升級的項目速度、更高的每次運行抓取的頁面數量限制以及創建更多項目的能力。

章魚解析

Octoparse 是一個基於客戶端的網絡爬蟲工具,它允許用戶在不需要編碼的情況下將網絡數據提取到電子表格中。 通過點擊式界面,Octoparse 專為非編碼人員打造。 用戶可以創建自己的網絡爬蟲來從任何網站收集數據,而 Octoparse 為亞馬遜、eBay 和 Twitter 等熱門網站提供預構建的爬蟲。 該工具還提供高級功能,如計劃的雲提取、數據清理和繞過 IP 代理服務器的阻塞。

主要特徵

- 點擊界面:您可以通過點擊輕鬆選擇要抓取的網絡元素,Octoparse 會自動識別數據模式並為您提取數據。

- 高級模式:您可以自定義您的抓取任務,使用各種操作,例如輸入文本、單擊按鈕、滾動頁面、循環列表等。您還可以使用 XPath 或 RegEx 來精確定位數據。

- 雲服務:您可以在 Octoparse 的雲服務器上 24/7 全天候運行您的抓取任務,並將您的數據存儲在雲平台中。 您還可以安排任務並使用自動 IP 輪換來避免被網站阻止。

- API :您可以通過 API 訪問您的數據並將其與其他應用程序或平台集成。 您還可以使用 Octoparse 將任何數據轉換為自定義 API。

價錢

- 它有免費和付費計劃。 付費計劃起價為每月 89 美元。

Web哈維

WebHarvy 是一款專為非程序員設計的點擊式網絡抓取軟件。 它可以自動從網站上抓取文本、圖像、URL 和電子郵件,並將它們保存為各種格式,例如 XML、CSV、JSON 或 TSV。 WebHarvy還支持匿名爬取和處理動態網站,利用代理服務器或VPN服務訪問目標網站。

主要特徵

- 無需編碼或腳本即可選擇數據的點擊式界面

- 自動抓取和抓取的多頁挖掘

- 用於從相似頁面或列表中抓取數據的類別抓取

- 電商網站商品詳情頁圖片下載

- 無需額外配置即可自動檢測抓取列表或表格的模式

- 通過將輸入關鍵字提交到搜索表單來進行基於關鍵字的提取

- 正則表達式更靈活和控制抓取

- 用於執行諸如單擊鏈接、選擇選項、滾動等任務的自動化瀏覽器交互

價錢

- WebHarvy 是一種網絡抓取軟件,需要支付一次性許可費。

- 他們的許可證起價為一年 139 美元。

美湯

Beautiful Soup 是一個用於解析 HTML 和 XML 文檔的開源 Python 庫。 它創建了一個解析樹,可以更輕鬆地從 Web 中提取數據。 雖然不如 Scrapy 快,但 Beautiful Soup 主要因其易用性和出現問題時的社區支持而受到稱讚。

主要特徵

- 解析:您可以將 Beautiful Soup 與各種解析器一起使用,例如 html.parser、lxml、html5lib 等,以解析不同類型的 Web 文檔。

- 導航:您可以使用 Pythonic 方法和屬性導航解析樹,例如 find()、find_all()、select()、.children、.parent、.next_sibling 等。

- 搜索:你可以使用過濾器搜索解析樹,比如標籤名稱、屬性、文本、CSS選擇器、正則表達式等,以找到你想要的元素。

- 修改:您可以通過添加、刪除、替換或編輯元素及其屬性來修改解析樹。

價錢

Beautiful Soup 是一個免費的開源庫,您可以使用 pip 安裝它。

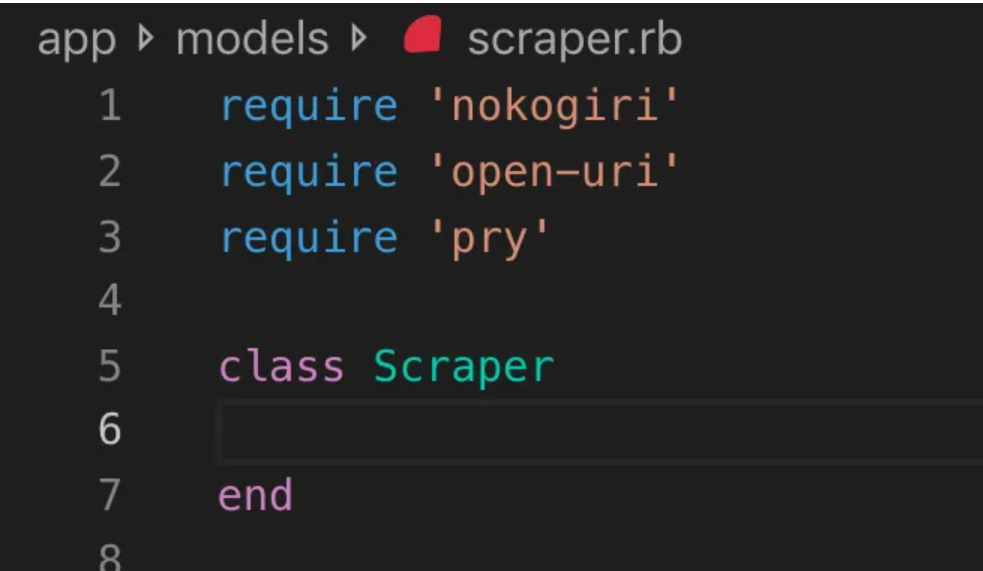

野切

Nokogiri 是一種網絡爬蟲工具,可以使用 Ruby 輕鬆解析 HTML 和 XML 文檔,Ruby 是一種對網絡開發初學者友好的編程語言。 Nokogiri 依賴於 C 的 libxml2 和 Java 的 xerces 等原生解析器,使其成為從網站提取數據的強大工具。 它非常適合想要使用基於 Ruby 的網絡爬蟲庫的網絡開發人員。

主要特徵

- 用於 XML、HTML4 和 HTML5 的 DOM 解析器

- 用於 XML 和 HTML4 的 SAX 解析器

- 用於 XML 和 HTML4 的推送解析器

- 通過 XPath 1.0 進行文檔搜索

- 通過 CSS3 選擇器進行文檔搜索,帶有一些類似 jquery 的擴展

- XSD 架構驗證

- XSLT 轉換

- 用於 XML 和 HTML 文檔的“Builder”DSL

價錢

- Nokogiri 是一個可以免費使用的開源項目。

Zyte(以前稱為 Scrapinghub)

Zyte(前身為 Scrapinghub)是一種基於雲的數據提取工具,可幫助成千上萬的開發人員從網站獲取有價值的數據。 它的開源可視化抓取工具允許用戶在沒有任何編程知識的情況下抓取網站。 Zyte 使用 Crawlera,這是一種智能代理輪轉器,支持繞過機器人反制措施以輕鬆抓取大型或受機器人保護的網站,它允許用戶通過簡單的 HTTP API 從多個 IP 和位置抓取而無需代理管理的痛苦。

主要特徵

- 按需提供數據:向 Zyte 提供網站和數據要求,他們會按您的時間表提供請求的數據。

- Zyte AP I:使用最高效的代理和提取配置自動從網站獲取 HTML,讓您專注於數據而無需擔心技術問題。

- Scrapy Cloud :Scrapy 蜘蛛的可擴展託管,具有用戶友好的 Web 界面,用於管理、監視和控制您的爬蟲,並配有監視、日誌記錄和數據 QA 工具。

- 自動數據提取API :通過 Zyte 的人工智能提取 API 即時訪問網絡數據,快速提供高質量的結構化數據。 有了這項專利技術,加入新資源變得更加簡單。

價錢

Zyte 有一個靈活的定價模型,該模型取決於您需要的數據的複雜性和數量。 您可以從三個計劃中進行選擇:

- 開發人員:25 萬個請求 49 美元/月

- 商業:200 萬個請求每月 299 美元

- 企業:超過 1000 萬個請求的自定義定價

- 您還可以每月 10K 次請求免費試用 Zyte。

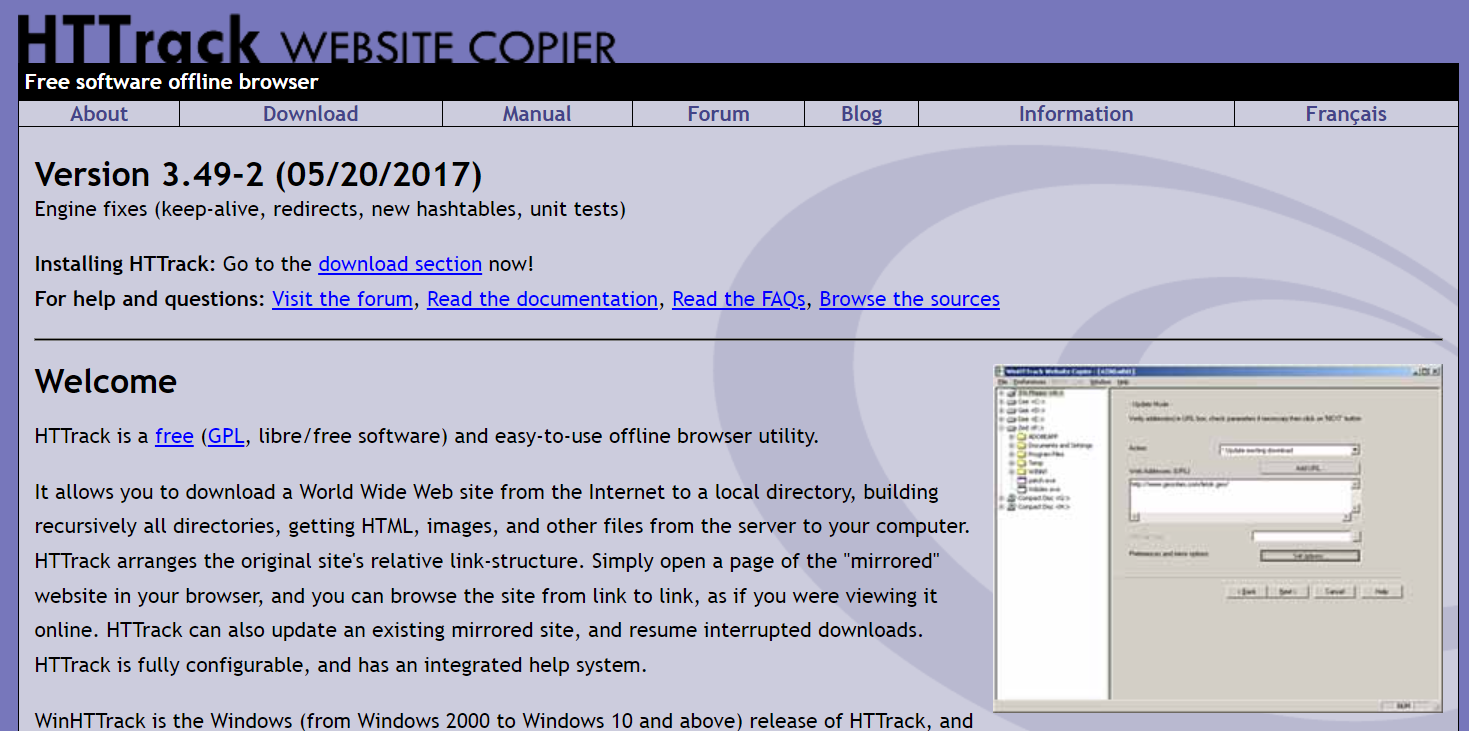

HT軌道

HTTrack 是一個免費的開源網絡爬蟲工具,允許用戶將整個網站或特定網頁下載到他們的本地設備以供離線瀏覽。 它提供了一個命令行界面,可以在 Windows、Linux 和 Unix 系統上使用。

主要特徵

- 它保留了原始站點的相關鏈接結構。

- 它可以更新現有的鏡像站點並恢復中斷的下載。

- 它是完全可配置的,並具有集成的幫助系統。

- 支持Windows、Linux、OSX、Android等多種平台。

- 它有命令行版本和圖形用戶界面版本。

價錢

- HTTrack 是根據 GNU GPL 許可的免費軟件。

阿帕奇納奇

Apache Nutch 是一種可擴展的開源網絡爬蟲,常用於數據分析等領域。 它可以通過 HTTPS、HTTP 或 FTP 等協議獲取內容,並從 HTML、PDF、RSS 和 ATOM 等文檔格式中提取文本信息。

主要特徵

- 它基於 Apache Hadoop 數據結構,非常適合批量處理大量數據。

- 它具有高度模塊化的架構,允許開發人員創建用於媒體類型解析、數據檢索、查詢和集群的插件。

- 支持Windows、Linux、OSX、Android等多種平台。

- 它有命令行版本和圖形用戶界面版本。

- 它集成了用於解析的 Apache Tika,用於索引的 Apache Solr 和 Elasticsearch,以及用於存儲的 Apache HBase。

價錢

- Apache Nutch 是根據 Apache License 2.0 許可的免費軟件。

氦氣刮板

Helium Scraper 是一款可視化的網絡數據爬取工具,用戶無需編碼即可自定義控制。 它提供代理輪換、快速提取等高級功能,並支持多種數據格式,如 Excel、CSV、MS Access、MySQL、MSSQL、XML 或 JSON。

主要特徵

- 快速提取:自動將提取任務委託給單獨的瀏覽器

- 大數據:SQLite 數據庫最多可容納 140 TB

- 數據庫生成:根據提取的數據生成表關係

- SQL 生成:快速連接和過濾表以導出或輸入數據

- API調用:將網絡抓取和API調用集成到一個項目中

- 文本操作:生成函數來匹配、拆分或替換提取的文本

- JavaScript 支持:在任何網站上註入和運行自定義 JavaScript 代碼

- 代理輪換:輸入代理列表並以任何給定的時間間隔輪換它們

- 相似元素檢測:從一個或兩個樣本中檢測相似元素

- 列表檢測:自動檢測網站上的列表和表格行

- 數據導出:將數據導出到 CSV、Excel、XML、JSON 或 SQLite

- 調度:可從命令行或 Windows 任務計劃程序啟動

價錢

- 基本許可證的費用為每位用戶 99 美元。

內容採集器(Sequentum)

Content Grabber是一款面向企業的網絡爬蟲軟件,允許用戶創建獨立的網絡爬蟲代理。 它提供高級功能,如與第三方數據分析或報告應用程序的集成、強大的腳本編輯和調試界面,以及支持將數據導出到 Excel 報告、XML、CSV 和大多數數據庫。

主要特徵

- 易於使用的點擊界面:自動檢測基於 HTML 元素的操作

- 強大的 API :支持與現有數據管道的輕鬆拖放集成

- 自定義:使用 Python、C#、JavaScript、正則表達式等常見編碼語言自定義您的抓取代理

- 集成:集成第三方 AI、ML、NLP 庫或 API 以豐富數據

- 可靠性和規模:降低基礎設施成本,同時享受端到端操作的實時監控

- 法律合規性:減少您的責任並降低與代價高昂的訴訟和監管罰款相關的風險

- 數據導出:將數據導出為任何格式並傳送到任何端點

- 調度:從命令行或 Windows 任務調度程序啟動你的抓取代理

價錢

- 基本許可證每年花費 27,500 美元,並允許您在一台計算機上使用該軟件。

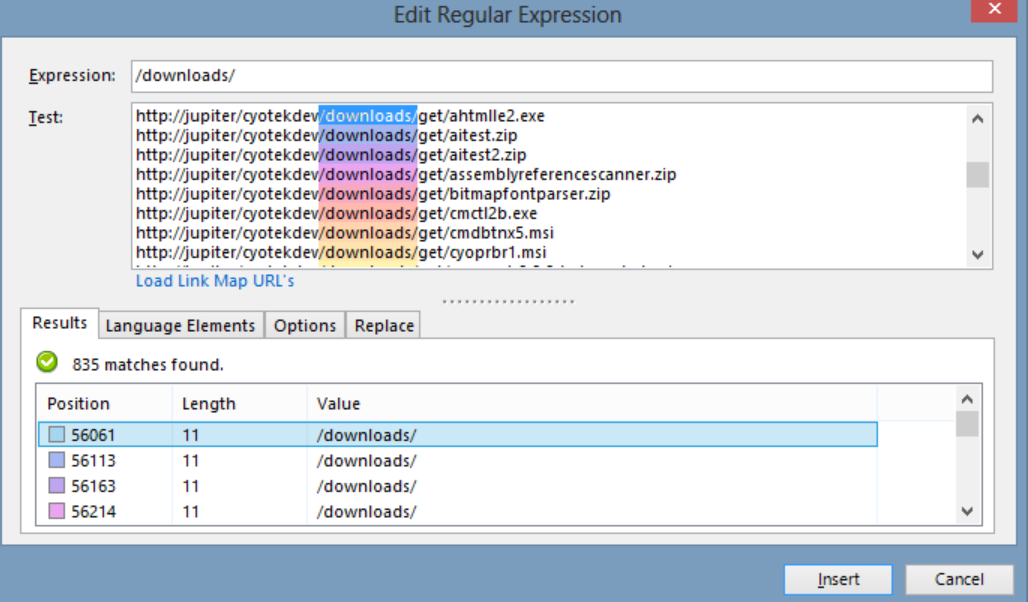

Cyotek 網絡複製

Cyotek WebCopy 是一個免費的網站爬蟲,它允許用戶將部分或全部網站本地複製到他們的硬盤中以供離線參考。 它可以檢測和跟踪網站內的鏈接,並自動重新映射鏈接以匹配本地路徑。 但是,WebCopy 不包括虛擬 DOM 或任何形式的 JavaScript 解析,因此由於大量使用 JavaScript,它可能無法正確處理動態網站佈局。

主要特徵

- 易於使用的點擊式界面,帶有基於 HTML 元素的自動動作檢測

- 強大的 API,可通過簡單的拖放功能與現有數據管道無縫集成

- 使用流行的編碼語言(如 Python、C#、JavaScript 和正則表達式)的自定義選項,以根據特定需求定制抓取代理

- 與第三方 AI、ML、NLP 庫或 API 的集成功能,以豐富抓取的數據

- 可靠且可擴展的基礎架構,具有實時監控功能,可實現經濟高效的運營

- 法律合規性功能可減少責任並降低訴訟和監管罰款的風險

- 數據導出為任何所需格式並傳送到各種端點

- 調度選項允許從命令行或 Windows 任務調度程序啟動抓取代理

價錢

- 基本許可證每年花費 27,500 美元,並允許您在一台計算機上使用該軟件。

80條腿

80legs是一款功能強大的網絡爬蟲工具,可以根據用戶需求進行配置。 它支持獲取大量數據以及立即下載提取的數據的選項。 該工具為用戶提供了一個 API 來創建爬蟲、管理數據等。 它的一些主要功能包括自定義抓取工具、用於 Web 抓取請求的 IP 服務器,以及用於配置具有自定義行為的 Web 抓取的基於 JS 的應用程序框架。

主要特徵

- 可擴展且快速:您每天可以抓取多達 20 億個頁面,並發請求超過 50,000 個。

- 靈活可定制:您可以使用自己的代碼來控制爬取邏輯和數據提取,也可以使用內置的工具和模板。

價錢

- 您可以根據需要選擇不同的定價計劃,從 100,000 個 URL/抓取的 29 美元/月到 1000 萬個 URL/抓取的 299 美元/月不等。

Webhose.io

Webhose.io 使用戶能夠通過抓取來自世界各地的在線資源並以各種干淨的格式呈現來獲取實時數據。 這個網絡爬蟲工具可以使用覆蓋廣泛來源的多個過濾器來爬取數據並進一步提取不同語言的關鍵字。 用戶可以將抓取的數據保存為 XML、JSON 和 RSS 格式,並從其存檔中訪問歷史數據。 Webhose.io 的爬取數據結果支持多達80 種語言,使用戶能夠輕鬆地索引和搜索該工具爬取的結構化數據。

主要特徵

- 多種格式:您可以獲取 XML、JSON、RSS 或 Excel 格式的數據。

- 結構化結果:您可以獲得根據您的需要進行規範化、豐富化和分類的數據。

- 歷史數據:您可以訪問過去 12 個月或更長時間的存檔數據。

- 覆蓋範圍廣:您可以從 80 種語言和 240 個國家/地區的超過一百萬個來源獲取數據。

- 多種來源:您可以從新聞網站、博客、論壇、留言板、評論、評論等獲取數據。

- 快速集成:您可以使用簡單的 REST API 在幾分鐘內將 Webhose.io 與您的系統集成。

價錢

- 它有一個免費計劃,允許您每月免費提出 1000 個請求。 它還具有自定義計劃,您可以聯繫他們獲取報價。

莫贊達

Mozenda 是一種基於雲的網絡抓取軟件,允許用戶在不編寫任何代碼的情況下提取網絡數據。 它使數據提取過程自動化,並提供諸如預定數據提取、數據清理和繞過 IP 代理服務器阻塞等功能。 Mozenda 專為企業設計,具有用戶友好的界面和強大的抓取功能。

主要特徵

- 文本分析:您可以使用自然語言處理技術從任何網站提取和分析文本數據。

- 圖像提取:您可以從網頁中下載並保存圖像,或者提取圖像元數據,如大小、格式、分辨率等。

- 不同的數據收集:您可以從多種來源和格式收集數據,例如 HTML、XML、JSON、RSS 等。

- 文檔提取:您可以使用光學字符識別 (OCR) 或文本提取方法從 PDF、Word、Excel 和其他類型的文檔中提取數據。

- 電子郵件地址提取:您可以使用正則表達式或模式匹配從網頁或文檔中查找和提取電子郵件地址。

價錢

- 付費計劃起價為每月 99 美元。

路徑

UiPath 是一款用於免費網頁抓取的機器人過程自動化 (RPA) 軟件。 它可以自動從大多數第三方應用程序中抓取 Web 和桌面數據。 UiPath 與 Windows 兼容,可以跨多個網頁提取表格和基於模式的數據。 該軟件還提供內置工具,用於進一步抓取和處理複雜的用戶界面。

主要特徵

- 文本分析:使用自然語言處理、正則表達式和模式匹配來提取和分析文本數據,以完成電子郵件地址提取等任務。

- 圖像提取:從網頁下載並保存圖像,提取圖像元數據,包括大小、格式和分辨率。

- 不同的數據收集:從各種來源和格式(如 HTML、XML、JSON、RSS)收集數據,並具有連接到其他在線服務和 API 的集成功能。

- 文檔提取:使用 OCR 或文本提取方法從 PDF、Word、Excel 和其他文檔類型中提取數據。 使用文檔理解功能處理和提取跨不同文檔類型和結構的信息。

- Web 自動化:自動化基於 Web 的活動,例如登錄、瀏覽頁面、填寫表格、單擊按鈕。 利用記錄器功能捕獲操作並生成自動化腳本。

價錢

- 付費的 計劃起價為每月 420 美元。

智取中心

OutWit Hub 是一個 Firefox 附加組件,具有數十種數據提取功能,可簡化用戶的網絡搜索。 該網絡爬蟲工具可以瀏覽頁面並以適當的格式存儲提取的信息。 OutWit Hub 提供了一個單一界面,用於根據需要抓取少量或大量數據,並且可以創建自動代理以在幾分鐘內從各種網站提取數據。

主要特徵

- 查看和導出網頁內容:您可以查看網頁中包含的鏈接、文檔、圖像、聯繫人、數據表、RSS 源、電子郵件地址和其他元素。 您還可以將它們導出為 HTML、SQL、CSV、XML、JSON 或其他格式。

- 組織表格和列表中的數據:您可以對錶格和列表中收集的數據進行排序、篩選、分組和編輯。 您還可以使用多個條件來選擇要提取的數據。

- 設置自動化功能:您可以使用抓取工具功能創建自定義抓取工具,使用簡單或高級命令可以從任何網站提取數據。 您還可以使用宏功能來自動執行網頁瀏覽和抓取任務。

- 生成查詢和 URL:您可以使用查詢功能根據關鍵字或模式生成查詢。 您還可以使用 URL 功能根據模式或參數生成 URL。

價錢

- Light 許可證是免費的且完全可操作,但它不包括自動化功能並將提取限制為一行或幾百行,具體取決於提取器。

- Pro 許可證每年收費 110 美元,包括 Light 許可證的所有功能以及自動化功能和無限提取。

視覺刮板

Visual Scraper 除了作為 SaaS 平台外,還提供網絡抓取服務,例如數據傳輸服務和為客戶創建軟件提取器。 這個網絡爬蟲工具涵蓋了爬蟲的整個生命週期,從下載、URL 管理到內容提取。 它允許用戶安排項目在特定時間運行或每分鐘、每天、每週、每月或每年重複序列。 Visual Scraper 非常適合想要經常提取新聞、更新和論壇的用戶。 不過官網現在好像不更新了,這個信息可能不是最新的。

主要特徵

- 易於使用的界面

- 支持多種數據格式(CSV、JSON、XML等)

- 支持分頁、AJAX 和動態網站

- 支持代理服務器和IP輪換

- 支持調度和自動化

價錢

- 它有免費計劃和付費計劃,每月 39.99 美元起。

導入.io

Import.io 是一個網絡抓取工具,允許用戶從特定網頁導入數據並將其導出為 CSV,而無需編寫任何代碼。 它可以輕鬆地在幾分鐘內抓取數千個網頁,並根據用戶的需求構建 1000+ 個 API。 Import.io 只需單擊幾下即可將網絡數據集成到用戶的應用程序或網站中,從而使網絡抓取更加容易。

主要特徵

- 點擊選擇和培訓

- 經過身份驗證的交互式提取

- 圖片下載和截圖

- 高級代理和特定國家/地區的提取器

- CSV、Excel、JSON 輸出和 API 訪問

- 數據質量 SLA 和報告

- 電子郵件、工單、聊天和電話支持

價錢

- 初學者:5,000 次查詢每月 199 美元

Dexi.io

Dexi.io 是一個基於瀏覽器的網絡爬蟲,它允許用戶根據他們的瀏覽器從任何網站抓取數據,並提供三種類型的機器人來創建抓取任務——Extractor、Crawler 和 Pipes。 該免費軟件提供匿名網絡代理服務器,提取的數據將在數據歸檔前在 Dexi.io 的服務器上託管兩週,或者用戶可以直接將提取的數據導出為 JSON 或 CSV 文件。 它為需要實時數據提取的用戶提供付費服務。

主要特徵

- 點擊選擇和培訓

- 經過身份驗證的交互式提取

- 圖片下載和截圖

- 高級代理和特定國家/地區的提取器

- CSV、Excel、JSON 輸出和 API 訪問

- 數據質量 SLA 和報告

- 電子郵件、工單、聊天和電話支持

價錢

- 標準:1 名工人每月 119 美元或每年 1,950 美元

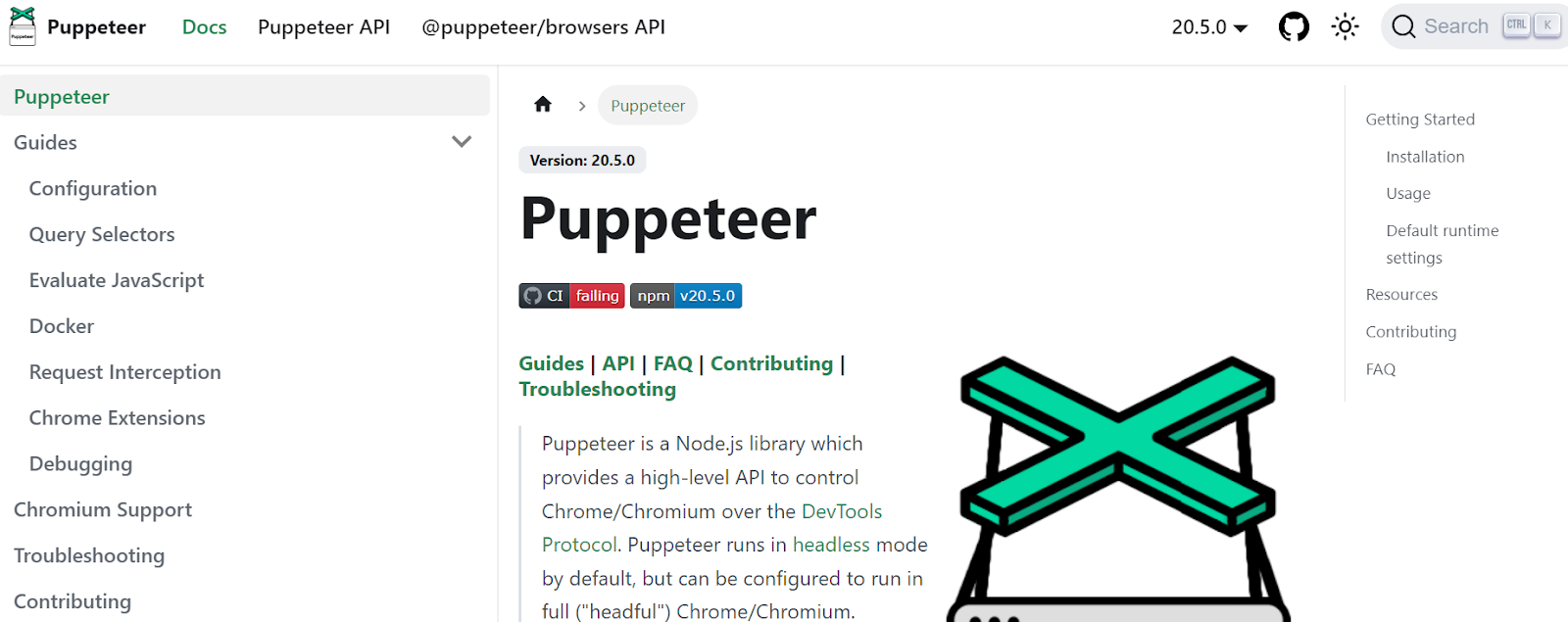

木偶師

Puppeteer 是 Google 開發的一個 Node 庫,為程序員提供了一個 API 來通過 DevTools 協議控制 Chrome 或 Chromium。 它使用戶能夠使用 Puppeteer 和 Node.js 構建網絡抓取工具。 Puppeteer 可用於多種目的,例如截屏或生成網頁的 PDF、自動化表單提交/數據輸入以及創建用於自動化測試的工具。

主要特徵

- 生成網頁的屏幕截圖和 PDF

- 從網站抓取和抓取數據

- 自動化表單提交、UI 測試、鍵盤輸入等。

- 捕獲性能指標和跟踪

- 測試 Chrome 擴展

- 以無頭或有頭模式運行

價錢

- Puppeteer 是免費和開源的。

Crawler4j

Crawler4j 是一個開源的 Java 網絡爬蟲,具有簡單的網絡爬蟲界面。 它允許用戶構建多線程爬蟲,同時提高內存使用效率。 Crawler4j 非常適合需要簡單且可自定義的基於 Java 的網絡爬蟲解決方案的開發人員。

主要特徵

- 它允許您使用正則表達式指定應抓取哪些 URL 以及應忽略哪些 URL。

- 它允許您處理下載的頁面並從中提取數據。

- 它遵循 robots.txt 協議並避免抓取不允許的頁面。

- 它可以抓取 HTML、圖像和其他文件類型。

- 它可以收集統計數據並同時運行多個爬蟲。

價錢

- Crawler4j 是一個開源 Java 項目,它允許您輕鬆地設置和運行您自己的網絡爬蟲。

普通抓取

Common Crawl 是一個網絡爬蟲工具,它提供了一個開放的網絡數據語料庫,用於研究、分析和教育目的。

主要特徵

- 它為用戶提供對 Web 爬網數據的訪問,例如原始網頁數據、提取的元數據和文本,以及 Common Crawl Index。

價錢

- 這種免費且可公開訪問的網絡抓取數據可供開發人員、研究人員和企業用於各種數據分析任務。

機械湯

MechanicalSoup 是一個用於解析網站的 Python 庫,基於 Beautiful Soup 庫,靈感來自 Mechanize 庫。 它非常適合存儲 cookie、跟踪重定向、超鏈接和處理網站上的表單。

主要特徵

- MechanicalSoup 提供了一種簡單的方法來瀏覽網站和從網站提取數據,而無需處理複雜的編程任務。

價錢

- 它是一個免費工具。

節點爬蟲

Node Crawler 是一個流行且功能強大的軟件包,用於使用 Node.js 平台抓取網站。 它基於 Cheerio 運行,並帶有許多選項來自定義用戶抓取或抓取網絡的方式,包括限制請求的數量和它們之間花費的時間。 Node Crawler 非常適合喜歡使用 Node.js 進行網絡爬蟲項目的開發人員。

主要特徵

- 便於使用

- 事件驅動的API

- 可配置的重試和超時

- 自動編碼檢測

- 自動 cookie 處理

- 自動重定向處理

- 自動 gzip/deflate 處理

價錢

- 它是一個免費工具。

選擇網絡爬蟲工具時要考慮的因素

價錢

考慮所選工具的定價結構,並確保它是透明的,沒有隱藏成本。 選擇一家提供清晰定價模型並提供有關可用功能的詳細信息的公司。

使用方便

選擇一個用戶友好且不需要廣泛技術知識的網絡爬蟲工具。 許多工具都提供點擊式界面,使非程序員更容易從網站提取數據。

可擴展性

考慮網絡爬蟲工具是否可以處理您需要提取的數據量,以及它是否可以隨著您的業務增長。 有些工具更適合小型項目,而另一些則專為大規模數據提取而設計。

數據質量和準確性

確保網絡爬蟲工具能夠以可用的格式清理和組織提取的數據。 數據質量對於準確分析至關重要,因此請選擇能夠提供高效數據清理和組織功能的工具。

客戶支持

選擇具有響應迅速且有用的客戶支持的網絡爬蟲工具,以便在出現問題時為您提供幫助。 通過聯繫他們並註意他們在做出明智的決定之前需要多長時間來響應來測試客戶支持。

結論

網絡爬蟲工具對於想要從網站中提取有價值的數據用於各種目的(例如市場研究、搜索引擎優化和競爭分析)的企業來說是必不可少的。 通過考慮定價、易用性、可擴展性、數據質量和準確性以及客戶支持等因素,您可以選擇適合您需求的正確網絡爬蟲工具。 上面提到的排名前 25 位的網絡爬蟲工具迎合了從非程序員到開發人員的一系列用戶,確保每個人都有合適的工具。 您還可以註冊 Scalenut 的 7 天免費試用,以優化您的網站內容並提高您的排名。