了解 Search Console 覆盖率报告

已发表: 2019-08-15覆盖率报告介绍以及如何解释数据

Search Console 覆盖率报告提供有关您网站上哪些页面已被编入索引的信息,并列出在 Googlebot 尝试抓取和编入索引时出现问题的 URL。

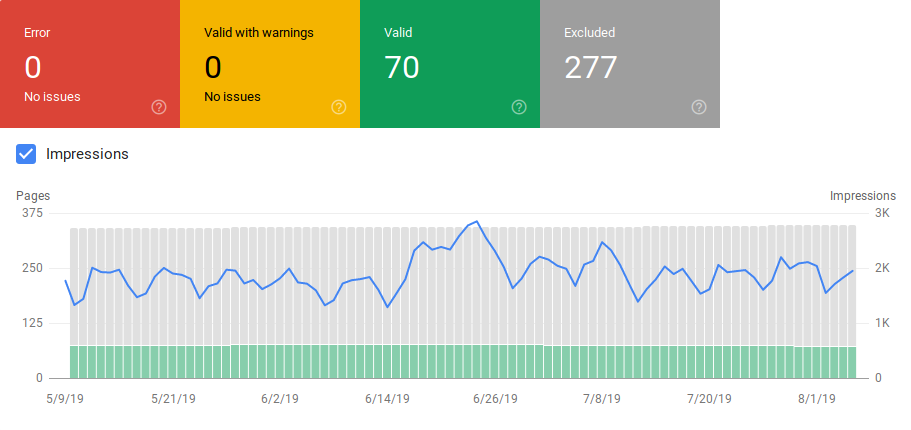

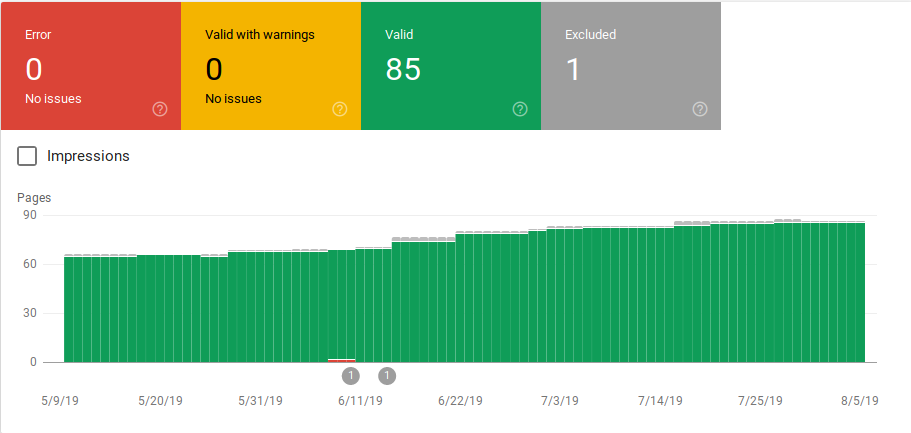

覆盖率报告中的主页显示您网站中按状态分组的 URL:

- 错误:该页面未编入索引。 这有几个原因,页面响应 404,软 404 页面等等。

- 警告有效:页面已编入索引但有问题。

- 有效:页面已编入索引。

- 排除:该页面未编入索引,Google 遵循网站上的规则,例如 robots.txt 中的 noindex 标记或元标记、规范标记等,以防止页面被编入索引。

这份覆盖率报告提供了比旧的谷歌搜索控制台更多的信息。 谷歌确实改进了它共享的数据,但仍有一些地方需要改进。

正如您在下面看到的,Google 显示了一个图表,其中包含每个类别中的 URL 数量。 如果错误突然增加,您可以看到条形图,甚至可以将其与展示次数相关联,以确定带有错误或警告的 URL 的增加是否会降低展示次数。

在站点启动或创建新部分后,您希望看到有效索引页面的数量不断增加。 谷歌索引新页面需要几天时间,但您可以使用 URL 检查工具请求索引并减少谷歌查找新页面的时间。

但是,如果您看到有效 URL 的数量下降或突然出现高峰,请务必在错误部分识别 URL 并修复报告中列出的问题。 当错误或警告增加时,Google 提供了一个很好的操作项摘要。

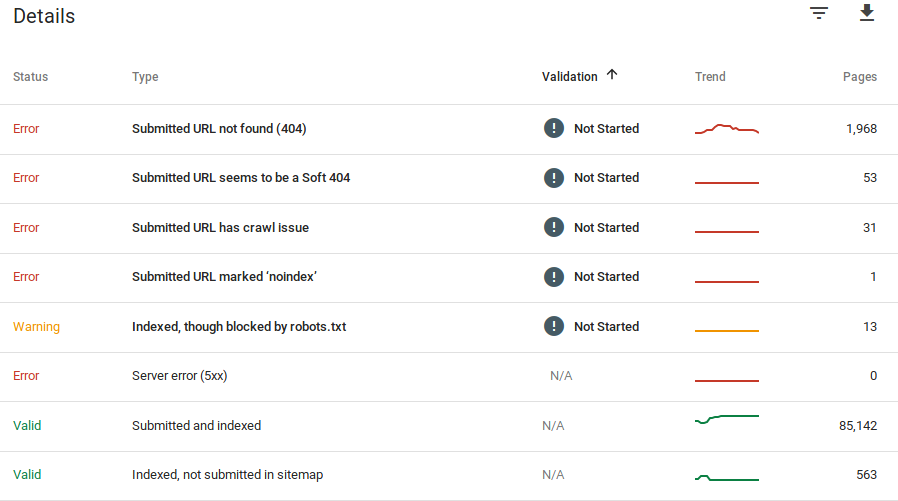

Google 提供了有关错误是什么以及有多少 URL 存在该问题的信息:

请记住,Google Search Console 不会显示 100% 准确的信息。 事实上,已经有几起关于错误和数据异常的报告。 此外,谷歌搜索控制台更新需要时间,众所周知,数据滞后 16 天到 20 天。 此外,如上图所示,该报告有时会列出超过 1000 个错误或警告类别的页面,但它只允许您查看和下载 1000 个 URL 的样本供您审核和检查。

尽管如此,这是在您的网站上查找索引问题的好工具:

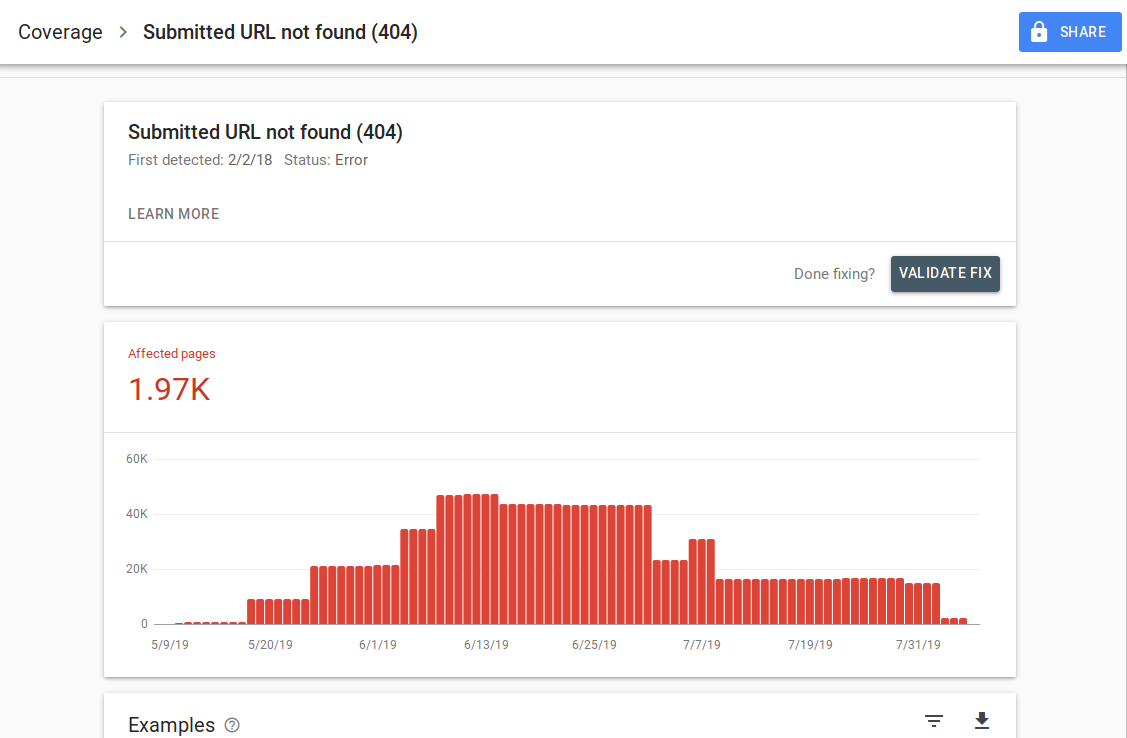

当您单击特定错误时,您将能够看到列出 URL 示例的详细信息页面:

正如您在上图中看到的,这是所有响应 404 的 URL 的详细信息页面。每个报告都有一个“了解更多”链接,可将您带到提供有关该特定错误的详细信息的 Google 文档页面。 Google 还提供了一个图表,显示一段时间内受影响的页面数。

您可以单击每个 URL 以检查与旧 Google Search Console 中的旧“fetch as Googlebot”功能类似的 URL。 您还可以测试该页面是否被您的 robots.txt 阻止

修复 URL 后,您可以请求 Google 对其进行验证,以便错误从您的报告中消失。 您应该优先解决处于验证状态“失败”或“未启动”的问题。

值得一提的是,您不应期望网站上的所有 URL 都被编入索引。 谷歌表示,网站管理员的目标应该是让所有规范的 URL 都被编入索引。 重复或替代页面将被归类为排除,因为它们与规范页面具有相似的内容。

网站在排除类别中包含多个页面是正常的。 大多数网站会有几个页面没有索引元标记或被 robots.txt 阻止。 当 Google 识别出重复页面或替代页面时,您应确保这些页面具有指向正确 URL 的规范标签,并尝试在有效类别中找到规范等效项。

Google 在报告的左上角包含了一个下拉过滤器,因此您可以过滤所有已知页面、所有提交的页面或特定站点地图中的 URL 的报告。 默认报告包括所有已知页面,其中包括 Google 发现的所有 URL。 所有提交的页面都包含您通过站点地图报告的所有 URL。 如果您提交了多个站点地图,则可以按每个站点地图中的 URL 进行过滤。

[案例研究] 增加战略页面的抓取预算

错误、警告、有效和排除的 URL

错误

- 服务器错误 (5xx):当 Googlebot 尝试抓取网页时,服务器返回 500 错误。

- 重定向错误:当 Googlebot 抓取 URL 时出现重定向错误,可能是因为链太长,存在重定向循环,URL 超出最大 URL 长度,或者重定向链中有错误或空的 URL。

- 提交的 URL 被 robots.txt 阻止:此列表中的 URL 被您的 robts.txt 文件阻止。

- 提交的 URL 标记为“noindex”:此列表中的 URL 具有元机器人“noindex”标签或 http 标头。

- 提交的 URL 似乎是软 404:当不存在的页面(已被删除或重定向)向用户显示“找不到页面”消息但未能返回 HTTP 404 状态代码时,会发生软 404 错误。 当页面被重定向到非相关页面时也会发生软 404,例如页面重定向到主页而不是返回 404 状态代码或重定向到相关页面。

- 提交的 URL 返回未经授权的请求 (401):提交索引的页面正在返回 401 未经授权的 HTTP 响应。

- 未找到提交的 URL (404):当 Googlebot 尝试抓取该页面时,该页面以 404 Not Found 错误响应。

- 提交的网址存在抓取问题: Googlebot 在抓取这些不属于任何其他类别的网页时遇到抓取错误。 您必须检查每个 URL 并确定问题可能是什么。

警告

- 已编入索引,但已被 robots.txt 阻止:该页面已编入索引,因为 Googlebot 通过指向该页面的外部链接访问该页面,但该页面已被您的 robots.txt 阻止。 Google 将这些 URL 标记为警告,因为他们不确定是否应该阻止该页面显示在搜索结果中。 如果要阻止页面,则应使用“noindex”元标记,或使用 noindex HTTP 响应标头。

如果 Google 是正确的并且该 URL 被错误地阻止,您应该更新您的 robots.txt 文件以允许 Google 抓取该网页。

有效的

- 已提交并编入索引:您通过 sitemap.xml 提交给 Google 以供编入索引并已编入索引的 URL。

- 已编入索引,未在站点地图中提交:该 URL 已被 Google 发现并编入索引,但未包含在您的站点地图中。 建议更新您的站点地图并包含您希望 Google 抓取和索引的每个页面。

排除在外

- 被“noindex”标签排除:当 Google 尝试将页面编入索引时,它发现了“noindex”元机器人标签或 HTTP 标头。

- 被页面删除工具阻止:有人使用 Google Search Console 中的 URL 删除请求向 Google 提交了不索引此页面的请求。 如果您希望将此页面编入索引,请登录 Google 的 Search Console 并将其从已删除页面列表中删除。

- 被 robots.txt 阻止: robots.txt 文件中有一行将 URL 排除在抓取之外。 您可以使用 robots.txt 测试器检查哪一行正在执行此操作。

- 由于未经授权的请求而被阻止(401):与错误类别相同,此处的页面返回 401 HTTP 标头。

- 抓取异常:这是一个包罗万象的类别,此处的 URL 以 4xx 或 5xx 级别的响应代码进行响应; 这些响应代码阻止了页面的索引。

- 已抓取 - 当前未编入索引: Google 未提供 URL 未编入索引的原因。 他们建议重新提交 URL 以进行索引。 但是,重要的是要检查页面是否包含稀薄或重复的内容、是否规范化到不同的页面、是否有 noindex 指令、指标显示糟糕的用户体验、页面加载时间长等。谷歌可能有几个原因不想索引页面。

- 已发现 - 当前未编入索引:已找到该页面,但 Google 尚未将其包含在其索引中。 您可以提交 URL 以进行索引以加快我们上面提到的过程。 谷歌表示,发生这种情况的典型原因是网站超载,谷歌重新安排了抓取时间。

- 具有正确规范标记的备用页面: Google 没有将此页面编入索引,因为它具有指向不同 URL 的规范标记。 Google 已遵循规范规则并已正确索引规范 URL。 如果您打算不将此页面编入索引,那么这里没有什么可修复的。

- 没有用户选择的规范的重复: Google 已发现此类别中列出的页面的重复项,并且没有使用规范标签。 Google 选择了不同的版本作为规范标签。 您需要查看这些页面并添加指向正确 URL 的规范标签。

- 重复,谷歌选择了与用户不同的规范:谷歌在没有明确的抓取请求的情况下发现了这些类别的网址。 谷歌通过外部链接找到了这些,并确定还有另一个页面可以制作更好的规范。 由于这个原因,谷歌没有将这些页面编入索引。 Google 建议将这些 URL 标记为规范的重复。

- 未找到 (404):当 Googlebot 尝试访问这些页面时,它们会返回 404 错误。 Google 声明这些 URL 尚未提交,这些 URL 是通过指向这些 URL 的外部链接找到的。 将这些 URL 重定向到类似页面以利用链接资产并确保用户登陆相关页面是一个好主意。

- 因法律投诉而被删除的页面:有人因法律问题(例如侵犯版权)而投诉这些页面。 您可以在此处对提交的法律投诉提出上诉。

- 带有重定向的页面:这些 URL 正在重定向,因此它们被排除在外。

- 软 404:如上所述,这些 URL 被排除在外,因为它们应该以 404 响应。检查页面并确保是否有“未找到”消息,以便它们以 404 HTTP 标头响应。

- 重复的,提交的 URL 未选择为规范:类似于“Google 选择了与用户不同的规范”,但此类别中的 URL 是由您提交的。 检查您的站点地图并确保不包含重复页面是个好主意。

如何使用数据和行动项目来改进网站

在一家机构工作,我可以访问许多不同的站点及其覆盖报告。 我花时间分析 Google 在不同类别中报告的错误。

发现规范化和重复内容的问题很有帮助,但是有时您会遇到@jroakes 报告的差异:

看起来 Google Search Console > URL Inspection > Live Test 错误地将所有 JS 和 CSS 文件报告为允许抓取:否:被 robots.txt 阻止。 在 3 个域中测试大约 20 个文件。 pic.twitter.com/fM3WAcvK8q

— JR%20奥克斯 ???? (@jroakes)2019 年 7 月 16 日

AJ Koh 在新的 Google Search Console 面世后不久写了一篇很棒的文章,他解释说数据的真正价值在于使用它为您网站上的每种内容描绘健康状况:

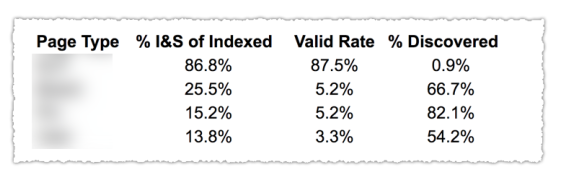

如上图所示,覆盖报告中不同类别的 URL 已按页面模板(例如博客、服务页面等)进行分类。为不同类型的 URL 使用多个站点地图可以帮助完成此任务,因为 Google 允许您可以按站点地图过滤覆盖率信息。 然后,他包含了三个列,其中包含以下信息:索引和提交页面的百分比、有效率和发现的百分比。

该表确实为您提供了网站健康状况的一个很好的概述。 现在,如果您想深入研究不同的部分,我建议您查看报告并仔细检查谷歌提出的错误。

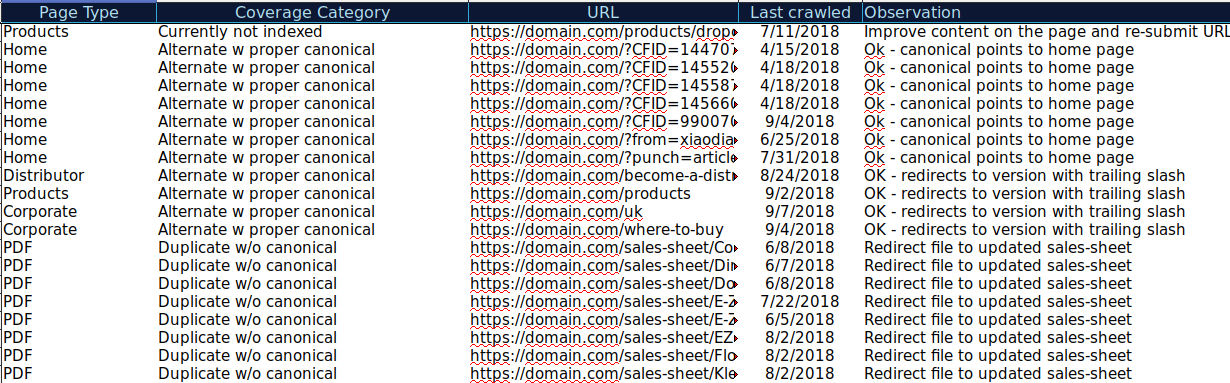

您可以下载不同类别中显示的所有 URL,并使用 OnCrawl 检查其 HTTP 状态、规范标签等,并创建如下电子表格:

像这样组织数据有助于跟踪问题,并为需要改进或修复的 URL 添加操作项。 此外,您可以检查正确的 URL,如果这些 URL 的参数具有正确的规范标签实现,则不需要任何操作项。

开始您的 14 天免费试用

您甚至可以从其他来源(例如 ahrefs、Majestic 和具有 OnCrawl 集成的 Google Analytics)向此电子表格添加更多信息。 这将允许您为 Google Search Console 中的每个 URL 提取链接数据以及流量和转换数据。 所有这些数据都可以帮助您更好地决定如何处理每个页面,例如,如果您有一个包含 404 的页面列表,您可以将其与反向链接联系起来,以确定您是否从链接到的域中丢失任何链接资产您网站上的损坏页面。 或者您可以检查索引页面以及它们获得了多少自然流量。 您可以识别没有获得自然流量的索引页面并努力优化它们(改善内容和可用性)以帮助为该页面带来更多流量。

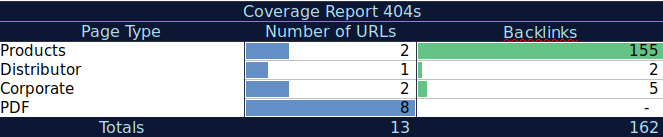

使用这些额外数据,您可以在另一个电子表格上创建汇总表。 您可以使用公式 =COUNTIF(range, criteria) 来计算每种页面类型中的 URL(此表可以补充 AJ Kohn 上面建议的表)。 您还可以使用另一个公式来添加您为每个 URL 提取的反向链接、访问或转化,并使用以下公式 =SUMIF (range, criteria, [sum_range]) 在汇总表中显示它们。 你会得到这样的东西:

我真的很喜欢使用汇总表,它可以为我提供数据的汇总视图,并可以帮助我确定我需要首先关注修复的部分。

最后的想法

在解决问题并查看此报告中的数据时,您需要考虑的是:我的网站是否针对抓取进行了优化? 我的索引页面和有效页面是增加还是减少? 有错误的页面是增加还是减少? 我是否允许 Google 将时间花在可以为我的用户带来更多价值的 URL 上,还是它会发现很多毫无价值的页面? 有了这些问题的答案,您就可以开始改进您的网站,以便 Googlebot 可以将其抓取预算用于可以为您的用户提供价值的网页,而不是毫无价值的网页。 您可以使用 robots.txt 来帮助提高抓取效率,尽可能删除无价值的 URL,或者使用规范或 noindex 标签来防止重复内容。

谷歌不断为谷歌搜索控制台中的不同报告添加功能并更新数据准确性,因此希望我们将继续在覆盖报告中的每个类别以及谷歌搜索控制台中的其他报告中看到更多数据。