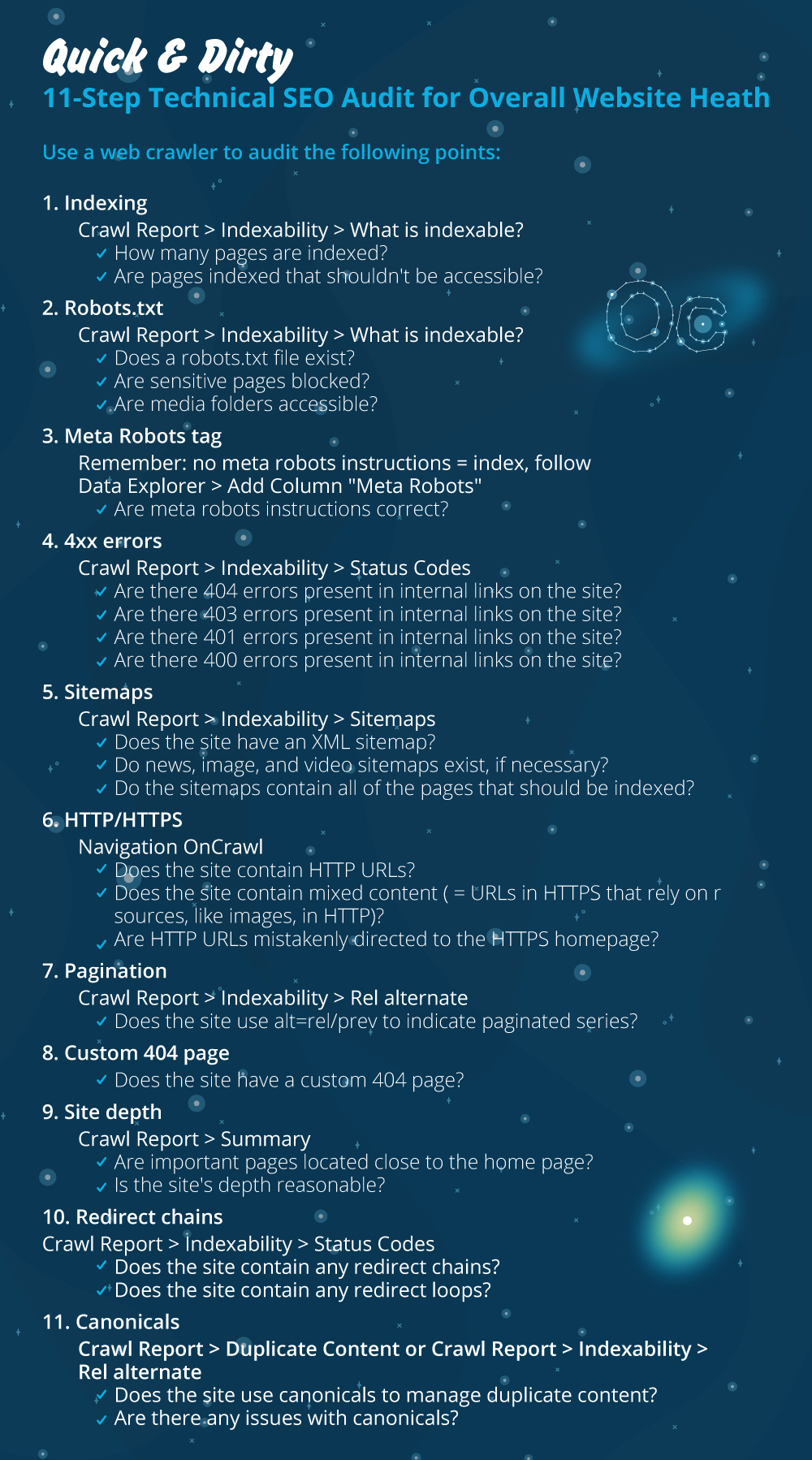

整体网站健康的快速和肮脏的 11 步技术 SEO 审计

已发表: 2020-02-27技术 SEO 很重要,因为它是任何项目的起点。 从 SEO 专家的角度来看,每个网站都是一个新项目。 一个网站应该有坚实的基础才能获得良好的结果并达到SEO中最重要的KPI,如排名。

每次我开始一个新项目时,我做的第一件事就是技术 SEO 审核。 大多数情况下,一旦重新抓取网站,修复技术问题就会得到惊人的结果。

当人们谈论内容和更多内容时,我觉得很有趣,但他们对技术 SEO 只字不提。 有一件事是肯定的,网站健康和技术 SEO 是 2020 年至关重要的两件事。我并不是说内容不重要。 是的,但如果不解决网站上的技术问题,我认为内容不能带来结果。

我见过重要页面被 robots.txt 文件中的指令阻止,或者最重要的类别或服务页面被 noindex、nofollow 等元机器人破坏或阻止的情况。 如果不优先解决这些问题,怎么可能取得成功?

看到不知道如何识别技术问题以报告给网络开发专家进行修复的 SEO 的数量可能会令人惊讶。 我记得有一次在公司领域工作时,我创建了一份技术 SEO 审核清单供我的团队使用。 那时,我意识到手头有一张这样的快速修复表可以极大地帮助团队并为客户带来快速的提升。 这就是为什么我认为投资可以帮助您进行技术 SEO 诊断和建议的工具/软件至关重要。

让我们开始动手实践如何进行快速技术 SEO 审核,这将产生重大影响。 这是一个快速练习,即使您不是专业人士,也需要大约一个小时才能完成。 对我来说,使用像 OnCrawl 这样的技术 SEO 工具可以在五分钟内快速完成所有事情,而无需做所有的手动工作,这让我的生活变得轻松。

在进行技术 SEO 审核时,我将回顾最重要的检查事项。 还有更多我们可以检查页面问题的事情,但我只想关注那些会造成索引问题和爬行浪费预算的事情。 优先考虑这是确保最重要的页面将被 Googlebot 抓取的方法。

- 索引

- 机器人.txt 文件

- 元机器人标签

- 4xx 错误

- 站点地图

- HTTP/HTTPS(网站安全、混合内容和重复内容问题)

- 分页

- 404页

- 场地深度和结构

- 长重定向链

- 规范标签实现

1) 索引

这是首先要检查的。 很多时候索引可能会受到插件配置或任何小错误的影响,但对可查找性的影响可能是巨大的,因为今天有超过 61.6 亿个网页被索引。 您需要了解任何搜索引擎都在努力,甚至 Google 也需要优先考虑与用户体验最相关的页面。 如果您不考虑让 Googlebot 更轻松,您的竞争对手会这样做并获得更多信任,而这正是健康网站所带来的。

当存在索引问题时,您的网站健康问题将反映在自然流量的损失上。 索引过程意味着搜索引擎抓取网页并组织稍后在 SERP 中提供的信息。 结果取决于用户意图的相关性。 如果一个网页不能或有爬行问题,这将有利于同一利基中的其他页面具有优势。

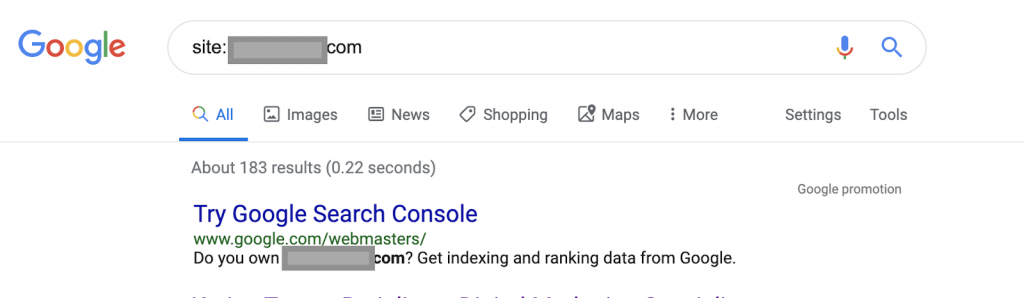

例如使用搜索运算符:

网站:www.abc.com

该查询将返回由 Google 索引的 183 个页面。 这是对 Google 已编入索引的页面数量的粗略估计。 您可以查看 Google Search Console 的确切数字。

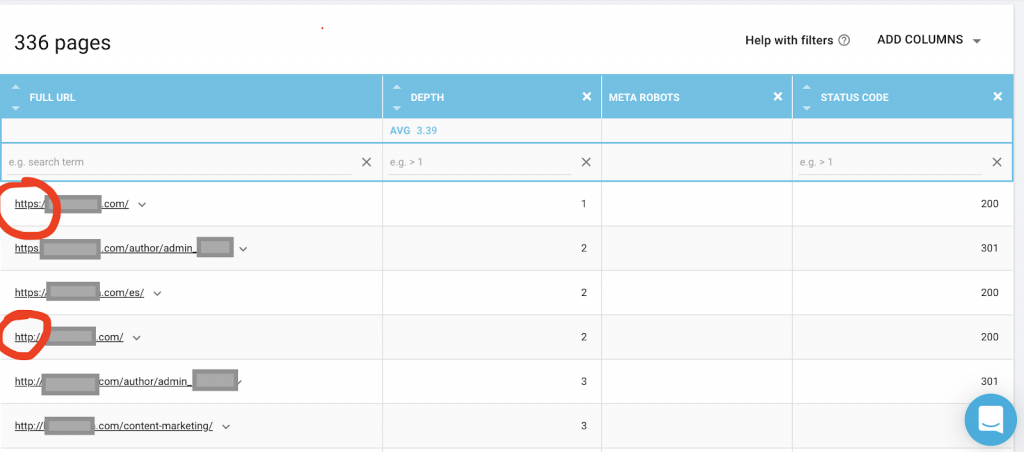

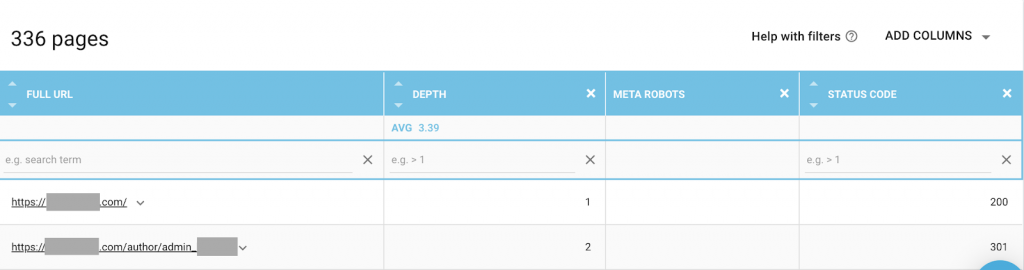

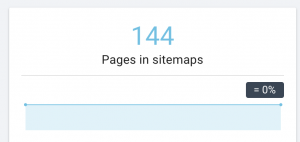

您还应该使用像 OnCrawl 这样的网络爬虫来列出 Google 可以访问的所有页面。 这显示了一个不同的数字,如下所示:

该网站的可抓取页面数量几乎是已编入索引的页面数量的两倍。

这可能会揭示重复的内容问题,甚至是 HTTP 和 HTTPS 问题之间的网站安全版本问题。 我将在本文后面讨论这个问题。

在这种情况下,网站从 HTTP 迁移到 HTTPS。 我们可以在 OnCrawl 中看到 HTTP 页面已被重定向。 Googlebot 仍然可以访问 HTTP 和 HTTPS 版本,它可能会抓取所有重复的页面,而不是优先考虑所有者想要排名的最重要的页面,从而造成抓取预算的浪费。

被忽视的网站或电子商务网站等大型网站的另一个常见问题是混合内容问题。 长话短说,当您的安全页面具有从不安全版本加载的媒体文件(最常见的是:图像)等资源时,问题就会出现。

如何修复它:

您可以要求 Web 开发人员将所有 HTTP 页面强制为 HTTPS 版本,并使用 301 状态代码将 HTTP 地址重定向到 HTTPS。

对于混合内容问题,您可以手动检查页面来源并搜索加载为“src=http://example.com/media/images”的资源,这对于大型网站来说几乎是疯狂的。 这就是为什么我们需要使用技术 SEO 工具。

2) Robots.txt 文件:

robots.txt 文件告诉抓取代理他们不应该抓取哪些页面。 Robots.txt 规范指南指出文件格式必须是纯文本,最大大小为 500KB。

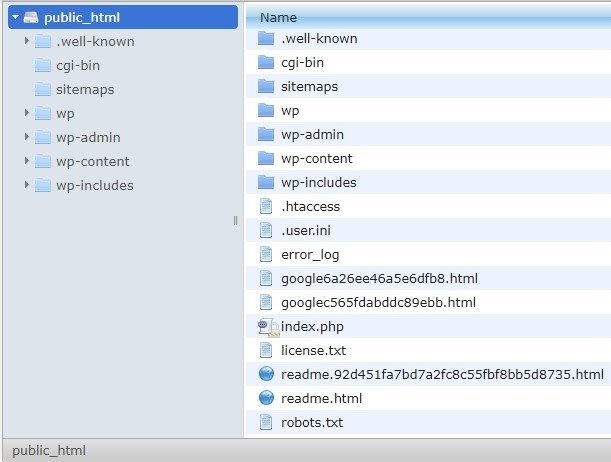

我建议将站点地图添加到 robots.txt.file。 不是每个人都这样做,但我相信这是一个很好的做法。 robots.txt 文件必须放在 public_html 中的托管服务器中,并位于根域之后。

我们可以在 robots.txt 文件中使用指令来防止搜索引擎抓取不必要的页面或包含敏感信息的页面,例如管理页面、模板或购物车(/cart、/checkout、/login、博客中使用的 /tag 等文件夹) ,通过在 robots.txt 文件中添加这些页面。

建议:确保您不会阻止媒体文件夹,因为这会将您的图像、视频或其他自托管媒体排除在索引之外。 媒体对于页面相关性以及图像或视频的自然排名和流量非常重要。

3) 元机器人标签

这是一段 HTML 代码,用于指示搜索引擎是否对页面以及该页面内的所有链接进行爬网和索引。 HTML 标记位于网页的头部。 机器人有 4 个常见的 HTML 标签:

- 没有关注

- 跟随

- 指数

- 无索引

当没有元机器人标签存在时,搜索引擎将默认跟踪并索引内容。

您可以使用最适合您需求的任何组合。 例如,通过使用 OnCrawl,我发现该网站的“作者页面”没有元机器人。 这意味着默认情况下方向是(“follow, index”)

这应该是(“noindex,nofollow”)。

为什么?

每个案例都不一样,但是这个网站是一个小型的个人博客。 博客上只有一个作者发表,域名是作者的名字。 在这种情况下,“作者”页面没有提供任何附加信息,即使它是由博客平台生成的。

另一种情况可能是博客上的类别很重要的网站。 当所有者想要在他或她的博客上对类别进行排名时,元机器人应该是(“关注,索引”)或默认在类别页面上。

在另一种情况下,对于一个大型知名网站,主要 SEO 专家撰写文章并被社区关注,Google 中的作者姓名充当品牌。 在这种情况下,您可能希望索引一些作者姓名。

如您所见,元机器人可以以多种不同的方式使用。

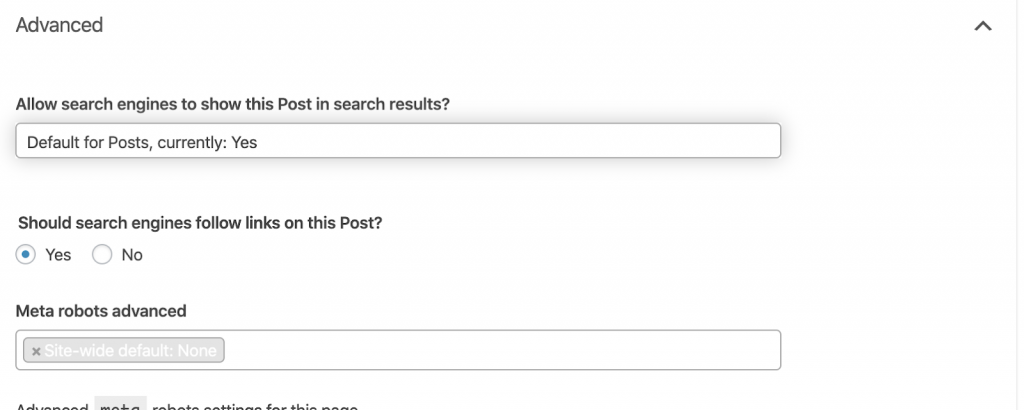

如何修复它:

要求 Web 开发人员根据需要更改元机器人标记。 在上述小型网站的情况下,我可以自己访问每个页面并手动更改它。 如果您使用的是 WordPress,则可以从 RankMath 或 Yoast 设置中进行更改。

4) 4xx 错误:

这些是客户端的错误,它们可以是 401、403 和 404。

- 404页面不存在:

当索引的 URL 地址处的页面不可用时,会发生此错误。 它可能已被移动或删除,并且没有使用 Web 服务器功能 301 正确重定向旧地址。404 错误对用户来说是一种糟糕的体验,并且代表了应该解决的技术 SEO 问题。 经常检查 404 并修复它们是一件好事,而不是让它们被一遍又一遍地尝试爬行代理浪费他们的预算。

如何修复它:

如果内容仍然存在,我们需要找到返回 404 的地址并使用 301 重定向修复它们。 或者,如果它们是图像,则可以将它们替换为保持相同文件名的新图像。

- 401未经授权

这是一个权限问题。 401 错误通常发生在需要身份验证(例如用户名和密码)时。

如何修复它:

这里有两个选项:第一个是使用 robots.txt 阻止搜索引擎访问该页面。第二个选项是删除身份验证要求。

- 403 禁止

此错误类似于 401 错误。 发生 403 错误是因为该页面包含公众无法访问的链接。

如何修复它:

更改服务器中的要求以允许访问页面(仅当这是一个错误时)。 如果您需要此页面无法访问,请从页面中删除所有内部和外部链接。

- 400 错误请求

当浏览器无法与网络服务器通信时会发生这种情况。 错误的 URL 语法通常会发生此错误。

如何修复它:

查找这些 URL 的链接并修正语法。 如果这无法修复,您将需要联系 Web 开发人员进行修复。

注意:我们可以使用工具或在 Google 控制台中找到 400 错误

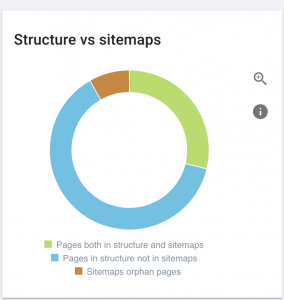

5) 站点地图

站点地图是网站包含的所有 URL 的列表。 拥有站点地图可以提高可查找性,因为它可以帮助爬虫找到并理解您的内容。

我们有不同类型的站点地图,我们需要确保它们都处于良好状态。

我们应该拥有的站点地图是:

- HTML 站点地图:这将在您的网站上,帮助用户浏览和查找您网站上的页面

- XML 站点地图:这是一个帮助搜索引擎抓取您的网站的文件(作为最佳实践,它应该包含在您的 robots.txt 文件中)。

- 视频 XML 站点地图:同上。

- 图片 XML 站点地图:也同上。 建议为图像、视频和内容创建单独的站点地图。

对于大型网站,建议使用多个站点地图以获得更好的可抓取性,因为站点地图包含的 URL 不应超过 50.000 个。

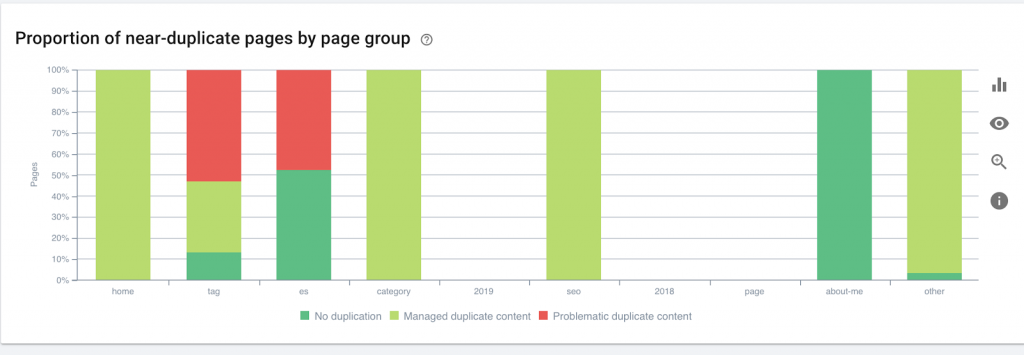

该网站存在站点地图问题。

我们如何解决它:

我们通过为以下内容生成不同的站点地图来解决此问题:内容、图像和视频。 然后,我们通过 Google Search Console 提交它们,并为该网站创建一个 HTML 站点地图。 为此,我们不需要网络开发人员。 我们可以使用任何免费的在线工具来生成站点地图。

6)HTTP/HTTPS(重复内容)

由于从 HTTP 迁移到 HTTPS,许多网站都存在这些问题。 如果是这种情况,该网站将在搜索引擎中显示 HTTP 和 HTTPS 版本。 由于这个常见的技术问题,排名被稀释了。 这些问题还会产生重复的内容问题。

![]()

如何修复它:

要求 Web 开发人员通过强制所有 HTTP 到 HTTPS 来解决此问题。

注意:切勿将所有 HTTP 重定向到 HTTPS 主页,因为它会生成软 404 错误。 (您应该对 Web 开发人员这么说;记住他们不是 SEO。)

7) 分页

这是使用 HTML 标签(“rel = prev”和“rel = next”)建立页面之间的关系,它向搜索引擎显示不同页面中呈现的内容应该被识别或与单个页面相关。 分页用于限制 UX 的内容和技术部分的页面重量,将它们保持在 3MB 以下。 我们可以使用免费工具来检查分页。

分页应该有自我规范的引用,并指出“rel = prev”和“rel = next”。 唯一重复的信息是元标题和元描述,但开发人员可以更改它以创建一个小算法,这样每个页面都会生成一个元标题和元描述。

如何修复它:

要求 Web 开发人员使用自规范标签实现分页 HTML 标签。

Oncrawl 搜索引擎优化爬虫

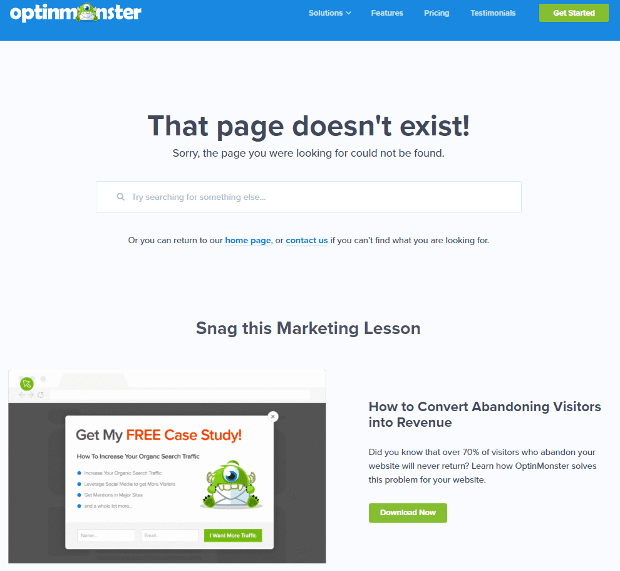

8) 自定义 404 未找到页面

正如我们之前讨论的那样,404 响应是“未找到”错误,它会将用户带到断开的链接或不存在的页面。 这是一个将用户重定向到正确位置的机会。 自定义 404 页面有很多很好的例子。 这是必须的。

这是一个很棒的 404 自定义页面的示例:

如何修复它:

创建一个自定义的 404 页面:考虑添加一些令人惊奇的东西。 让这个错误成为您业务的机会。

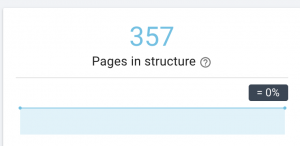

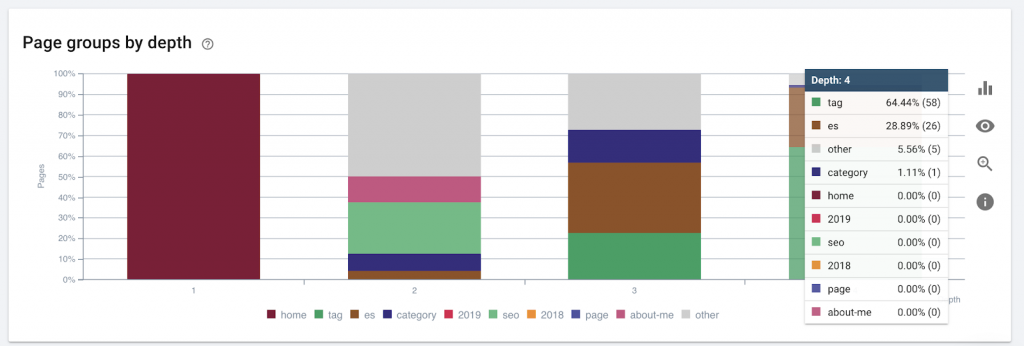

9)场地深度/结构

页面深度是您的页面位于根域的点击次数。 谷歌的 John Mueller 说“离主页越近的页面权重越大”。 例如,假设这里的页面需要以下导航才能到达:

“地毯”页面距离主页仅 4 次点击。 建议不要让页面距离家超过 4 次点击,因为搜索引擎很难抓取更深的页面。

此图按深度显示页面组。 它可以帮助我们了解网站的结构是否需要重新设计。

如何修复它:

最重要的页面应该最靠近用户体验的主页,以便用户轻松访问并获得更好的网站结构。 在创建网站结构或重组网站时考虑到这一点非常重要。

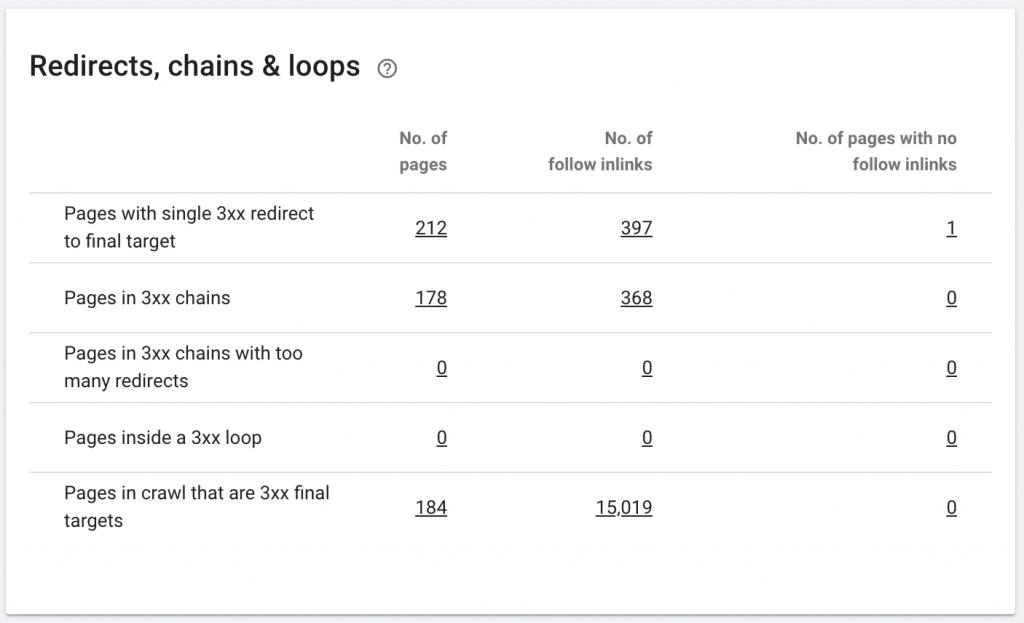

10. 重定向链

重定向链是指在 URL 之间发生一系列重定向。 这些重定向链也可能产生循环。 它还会给 Googlebot 带来问题并浪费抓取预算。

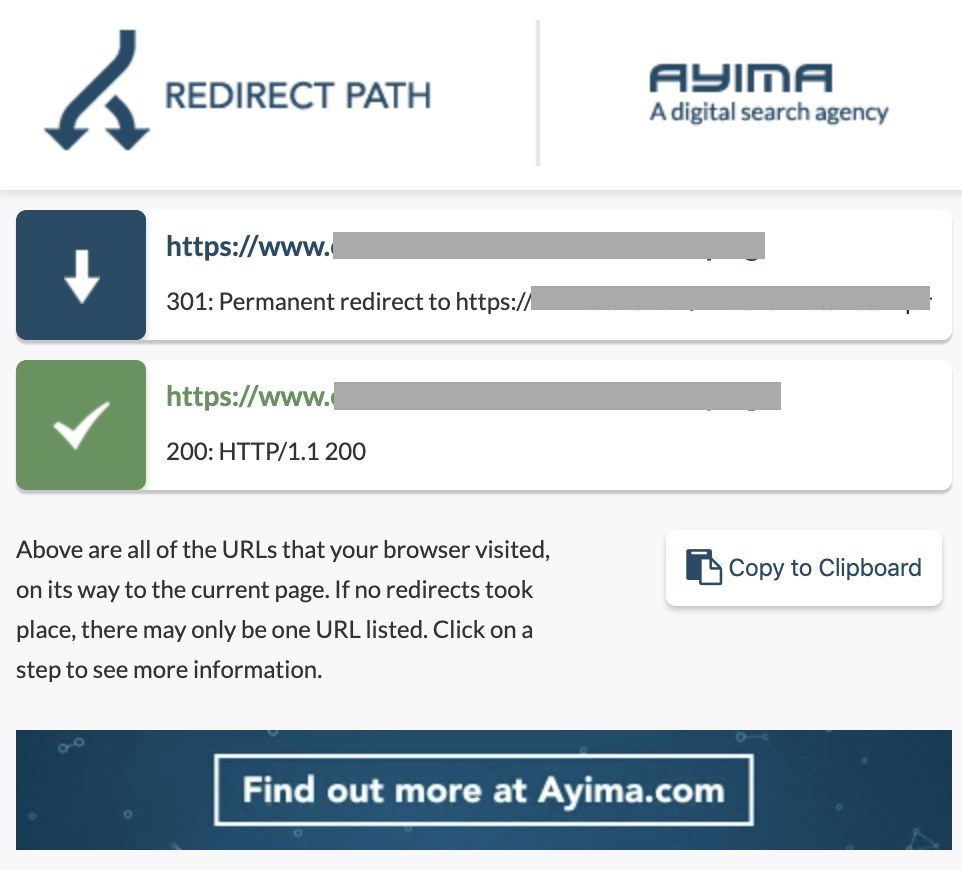

我们可以使用 Chrome 扩展重定向路径或在 OnCrawl 中识别重定向链。

如何修复它:

如果您使用的是 WordPress 网站,解决此问题非常容易。 只需转到重定向并查找链 - 如果这些更改发生在 2-3 个月前,则删除链中涉及的所有链接,并将最后一个重定向保留到当前 URL。 如果需要,Web 开发人员还可以通过在 .htacces 文件中进行所需的所有更改来帮助解决此问题。 您可以检查和更改 SEO 插件中的长重定向链。

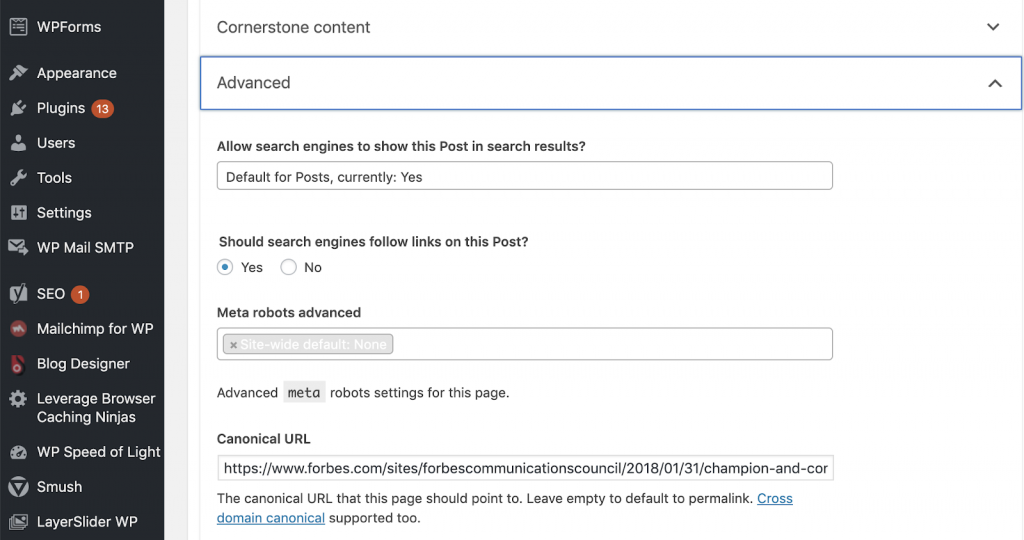

11) 规范

规范标签告诉搜索引擎该 URL 是另一个页面的副本。 这是许多网站上都存在的一个大问题。 没有以正确的方式实施规范,或者根本没有实施它们,将产生重复的内容问题。

规范通常用于电子商务网站,其中可以在不同类别中多次找到产品,例如:尺寸、颜色等。

您可以使用 OnCrawl 来判断您的页面是否具有规范标签,以及它们是否被正确实施。 然后,您可以探索和纠正任何问题。

我们如何解决它:

如果我们在 WordPress 中工作,我们可以使用 Yoast SEO 来解决规范问题。 我们转到 WordPress 仪表板,然后转到 Yoast -setting - 高级。

运行您自己的审核

想要开始研究技术 SEO 的 SEO 需要遵循快速步骤指南来改善 SEO 健康。 在 2019 年 10 月的纽约全球营销日上,与康泰纳仕 (Conde Nast) 受众增长副总裁兼 NewzDash 创始人 John Shehata 谈论技术 SEO。

这是他对我说的:

“SEO行业的很多人都不是技术人员。 现在,并不是每个 SEO 都了解如何编码,而且很难要求人们这样做。 一些公司,他们所做的是雇佣开发人员并培训他们成为 SEO 以填补技术 SEO 的差距。”

在我看来,不具备完整代码知识的 SEO 仍然可以通过知道如何运行审计、识别关键元素、报告、要求 Web 开发人员实施以及最终测试更改来在技术 SEO 方面做得很好。

准备好开始了吗? 下载这些主要问题的清单。