从 A/B 测试结果中学习和改进的 7 个关键步骤

已发表: 2021-04-13

您的 A/B 测试刚刚完成,但您没有看到预期的结果。

其他人都在分享案例研究,他们看到只需更改按钮颜色或进行微小调整即可获得巨大提升,但您的测试在转换方面没有任何改善,或者更糟糕的是,它似乎反而亏本了,现在您需要把这个介绍给你的老板。

好吧,如果您的测试实际上不是失败者怎么办?

如果它是伪装的胜利者怎么办?

如果它是一个失败者,如果失败的测试实际上是一件好事呢?

在本指南中,我们将帮助您更深入地了解 A/B 测试结果,以便您可以分析和分解它们以找到黄金。

我们将介绍为什么从您的 A/B 测试中学习如此重要,以及为什么失败者可以为您带来销售。 我们分享了一个您可以遵循的流程,这样您就可以逐步全面分析您的测试,并对您所看到的、胜利或失败充满信心。

更好的是,我们将帮助您摆脱对数据的焦虑和不想检查您的分析,转变为有信心与您的同行分享您的结果。

所以让我们潜入...

为什么需要从 A/B 测试中学习?

首先,其中涉及明显的成本。 每个测试都需要花钱来设置。 如果您丢失了变体,那么您也会看到该变体的销售额下降。

事情是这样的:

A/B 测试(以及一般的 CRO)不仅仅是为了赚更多的钱。 这是关于购买数据。 您的受众数据可以帮助您更好地了解他们并提供更好的产品和服务。 然后,这会带来更多的销售和改善的客户体验,甚至是对新产品报价的洞察。

你越了解你所服务的人,你就会做得越好。 这就是为什么经常测试和测试如此重要的原因——即使大多数测试都失败了。

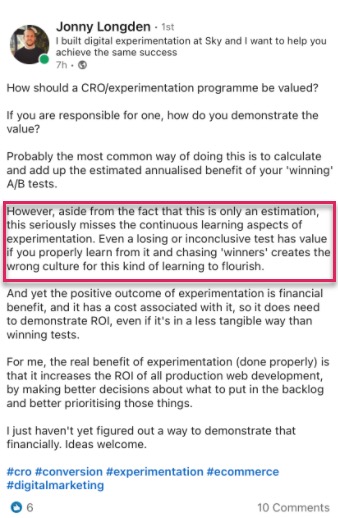

我们也不是唯一有这种想法的人。

事实上,当我们使用我们的工具查看 28,304 次测试的内部数据以及与专家测试机构的对话时,我们发现大多数公司每 10 次测试中只能找到 1 名获胜者,而代理机构通常会在每 10 次测试中找到 1 名获胜者。 4.

我知道你在想什么,

当然,这意味着我每次测试 90% 的时间都在赔钱吗?

是的,但仅限于一半的测试观众。 另一半仍在查看您的网站并照常进行转换。

此外,您获得的数据可以帮助您找出什么不起作用,这样您就可以了解什么是有效的。 您测试、学习、再次测试并继续前进,直到找到有效的方法。

那些 10% 的测试确实获胜?

它们可以提供持续的增量提升,可以一次又一次地改进,然后在每个类似页面上扩展到您的站点以产生更大的影响。

这就是在数字平台上看到转化率提升的美妙之处。 仅提升 1% 的绝对规模就可能对您的业务产生巨大影响,无论是现在还是未来的所有流量。 事实上,杰夫·贝佐斯 (Jeff Bezos) 也有同样的想法,在其年度股东报告中称亚马逊及其测试和改进目标是“世界上最容易失败的地方”:

假设有 10% 的机会获得 100 倍的回报,您应该每次都下注。 但是十有八九你还是会错。

杰夫贝索斯,亚马逊

更多的销售和更好的洞察力并不是 A/B 测试的唯一好处。

运行测试可以让你摆脱障碍主题和群体理论。 与其花几个月的时间讨论可能的网页设计更改而无所事事,不如采取行动并对其进行测试,让您的团队腾出时间专注于其他事情。 (一定要在直播之前测试它的效果!)

不仅如此,您还可以了解只有 A/B 测试才能告诉您的有关您的受众的新知识。

理论制定和客户调查很棒,但最重要的是您的受众在您的网站上实际所做的事情,而不仅仅是他们所说的内容。 了解您的测试有助于您证明或反驳这些想法和反馈。

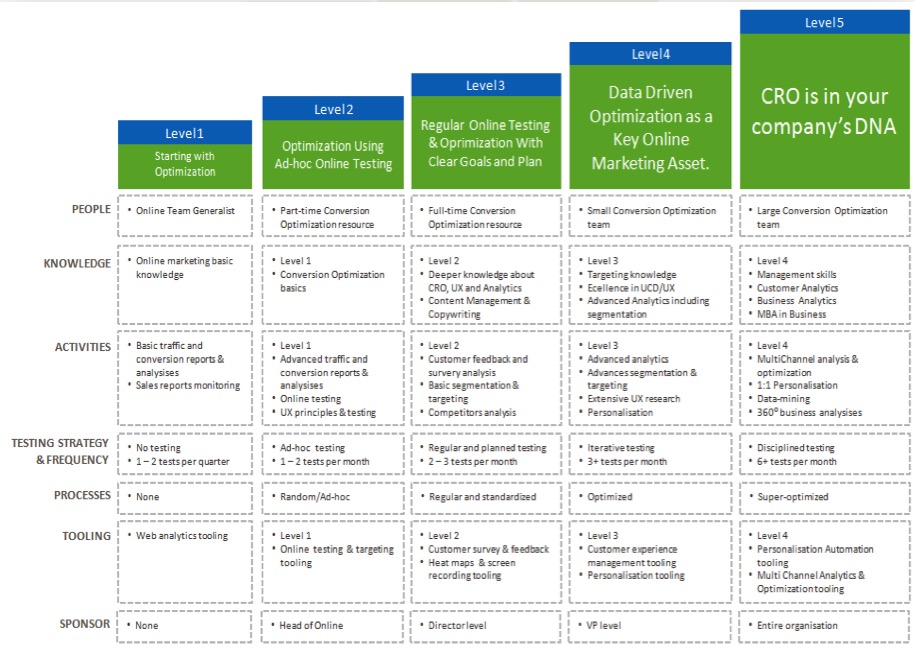

您对结果了解得越多,您对测试就越有信心,从而使您的 CRO 工作“成熟”并更频繁地运行测试,甚至可能开始在内部建立测试团队。

现在您看到了从每个 A/B 测试中学习的好处,让我们通过一个简单的过程来分析您运行的每个新测试……

从 A/B 测试中学习的 7 步流程(以及可用于改进未来测试的系统)

我们将其分解为 7 个要遵循的关键步骤。

您可能没有我们在这里推荐的所有方法或工具,但是,通过查看它们的适用性,您可以评估它们的价值并决定是否要将它们集成到您未来的测试中。

第 1 步:检查您的数据是否准确、有效 + 重要

这是整个过程中最重要的部分。 确保您在测试中获得的信息既准确又有效,这样您就可以对结果充满信心。

那么,您如何确保您的测试结果提供您可以信任的数据呢?

好吧,你可以做一些事情......

验证您的工具精度

现在,大多数人都错过了这一点。 如果您的网站每月访问量不超过 10,000,请随意跳过它。 从技术上讲,它不需要开始使用 CRO,并且最适合流量大的网站,但我不会在此处包含它,因为大型网站可以真正看到差异。

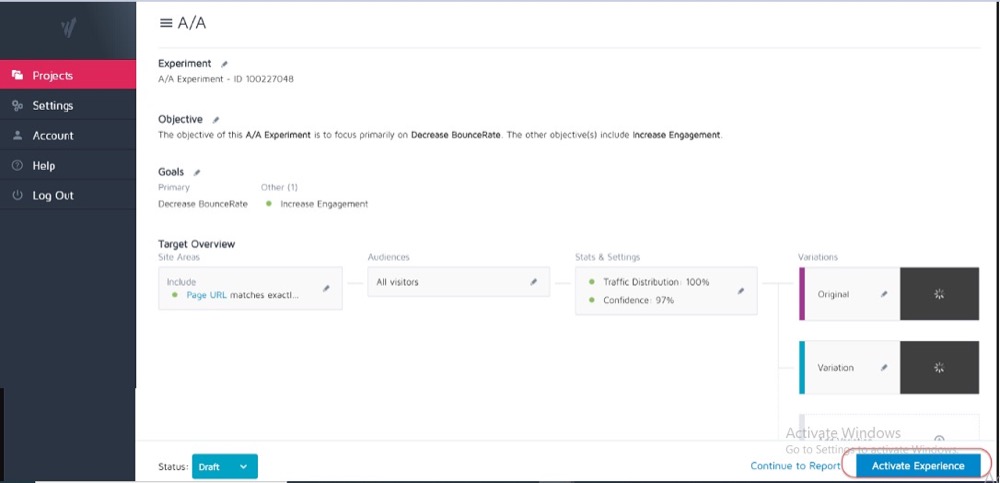

理想情况下,您已经在当前测试工具上运行了 A/A 测试,以查看它的准确性以及是否存在任何问题。

如何?

您使用 2 个相同的网页副本运行一个简单的拆分测试,然后跨这 2 个相同的页面跟踪结果。

因为它们之间没有区别,所以每个页面的结果应该是相同的。 但是,该工具以及它如何测量或跟踪您的数据可能会导致一些差异。

提前了解这一点可以帮助您获得对测试结果准确性的容忍度,并将其用作所有未来测试的指南。

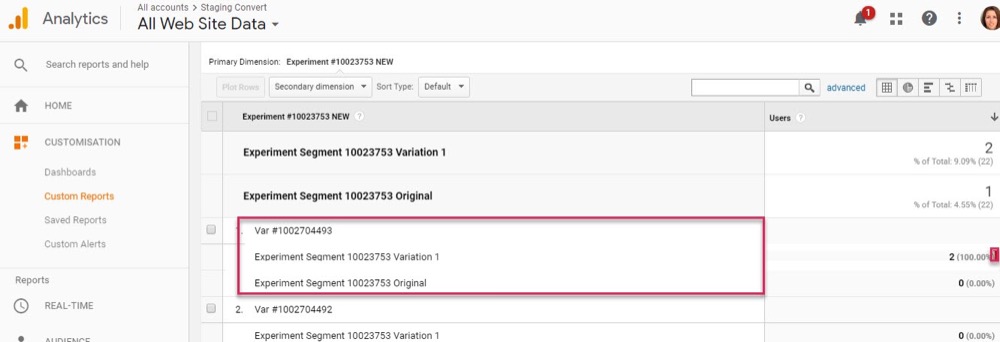

例子

如果您注意到您的 A/A 测试显示两个相同页面之间的转化率差异为 0.5%,那么您可能会警惕任何显示获胜者的测试结果,而对照和变体之间只有 0.5% 的差异。

您可以设置内部指南,规定测试必须显示 1% 或更高的提升,然后您才会相信结果。 同样,当您尝试新工具或者您认为当前工具可能存在报告问题或设置不正确时,您只需要运行一次 A/A 测试。

A/A 测试最适合大流量站点,因为准确检查所需的样本数据可能非常大,但 1% 的误差差异可能很大。

运行足够长的测试以有效了解客户如何与您的网站互动

因此,既然您信任您的工具,您希望运行 2-4 周的测试,即使您获得足够的转化以统计数据能够在之前关闭它。

为什么?

因为您的受众通常会根据一周中的某一天或一个月的某些阶段与您的网站进行不同的互动。

例子

如果您的听众中的人在星期四获得报酬,那么如果您的测试只从星期一到星期三进行,您可能会错过一个上升,对吗?

同样,其他用户可能会每两周或每月获得报酬,如果您的测试运行时间不够长以将其包含在其中,则会再次扭曲您的结果。 您只需假设您错过的时间销售额或流量较低。

你怎么知道什么时候结束测试? 阅读更多关于 A/B 测试统计意义:如何以及何时结束测试

注意可能影响结果的任何内部或外部因素

这些是可能会扭曲您的数据的独特或预定事件。

例如,如果您的 CEO 或公司出现在新闻中,或者您正在进行任何当前的营销活动或促销活动,以及任何外部因素,例如国定假日,甚至是随机流量高峰。

所有这些都会影响您的网站流量,然后改变您在此期间结果的准确性。

真实的故事:

大约 6 年前,我曾经拥有一家冲浪服装公司。

有一天,我们的流量突然飙升了大约 800%,跳出率猛增。 我们没有进行任何新的营销活动,因此我做了一些调查以找出流量的来源。

事实证明,我们的一件 T 恤的产品名称与韩国流行乐队的新歌名称相同,我们在两天内对其进行排名并吸引了他们的访客。

当然,这些新观众对我们的产品一点也不感兴趣,很快就离开了。

疯了吧?

还有一次,我的营销博客开始为一家电视公司的品牌排名,同样的事情也发生了。 我们从错误的受众那里获得了流量高峰。

尽管这是随机的,但这类事情可能会发生,因此请注意此类外部或内部事件。 您可以随时检查分析以查看流量来自何处,然后在一切恢复正常时重新启动测试。

确保获得足够的数据

您希望确保您的测试有足够的转化次数来有效地了解它的表现。

拥有一个只有 50 次总转化并且它们之间只有很小差异的控件和变体不足以深入了解您的受众——即使测试结果在某种程度上具有统计显着性。 大多数专家都同意,每个变体大约 300 次以上的转化通常是一个很好的经验法则(如果您想稍后进行细分,甚至更多)。

数据集越大,就越容易在测试后分析中找到见解。

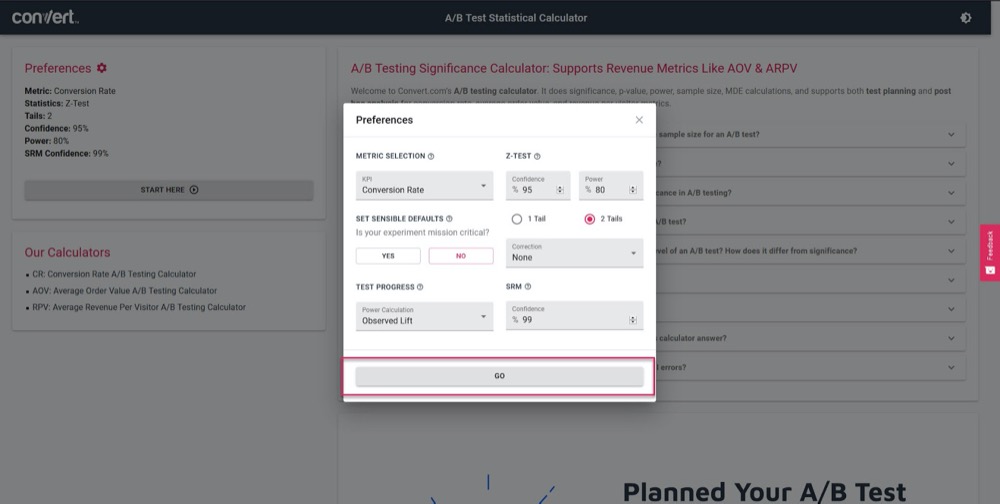

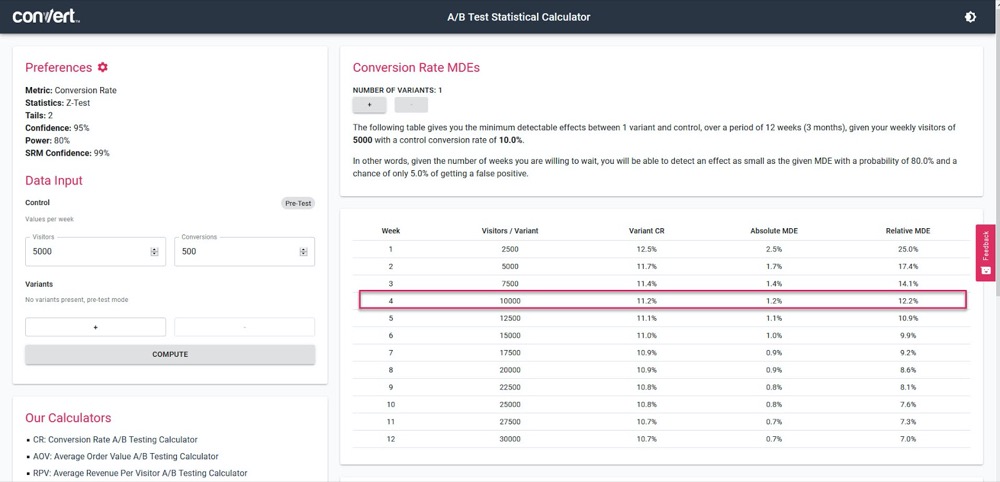

使用我们的 A/B 测试重要性计算器,根据 4 周的销售周期和您当前的“控制”页面信息,了解您的测试的准确度。

只需设置您的测试参数:

然后,输入您的测试每周应该获得多少流量,以及您当前页面的转化次数,然后找出您的测试能够计算的准确度和提升百分比。

在上面的例子中,我们可以在 4 周后测量低至 1.2% 的提升。 (如果我们想获得更高的准确率,只需运行更长时间的测试或增加测试中的流量即可。)

获得具有统计意义的结果

这就是为什么统计显着性很重要,但在测试时不是最重要的因素。

是的,您希望确保您的测试运行足够长的时间以在结果中看到 95-99% 的置信度,但您还希望确保我们上面涵盖的所有其他因素都得到了满足。

为什么?

如果运行时间不够长,即使是 A/A 测试也可以显示 95% 的信心认为某个版本优于其相同副本。

(它可能会在某一天随机看到一个版本的所有转换,而另一天则没有。)

太多的新测试人员一旦点击“stat sig”就会停止活动,从而导致他们获得虚假数据。 这就是为什么我们建议您获得 95% 或更高的统计显着性,但也要在 2-4 个销售周期、300 多次转化和足够大的样本量下运行测试。

如果你做了所有这些,那么你可以非常确定你可以相信你的测试会给你有效和准确的结果。

让测试运行以使您满足这些标准有多重要,我怎么强调都不为过。

过早调用测试会给您提供错误信息,从而导致:

- 由于您没有足够的信息,找不到潜在的赢家,

- 运行效果较差的广告系列,因为您认为它们是赢家,但实际上转化率较低,

- 或者更糟糕的是,您可能会对这些结果产生错误的信心,然后使用您学到的知识将其扩展到您网站的其他部分,从而加剧这些负面影响。

您知道您的 A/B 测试工具如何得出关于获胜变体的结论吗? 单击此处使用我们的 A/B 测试重要性计算器。

边注:

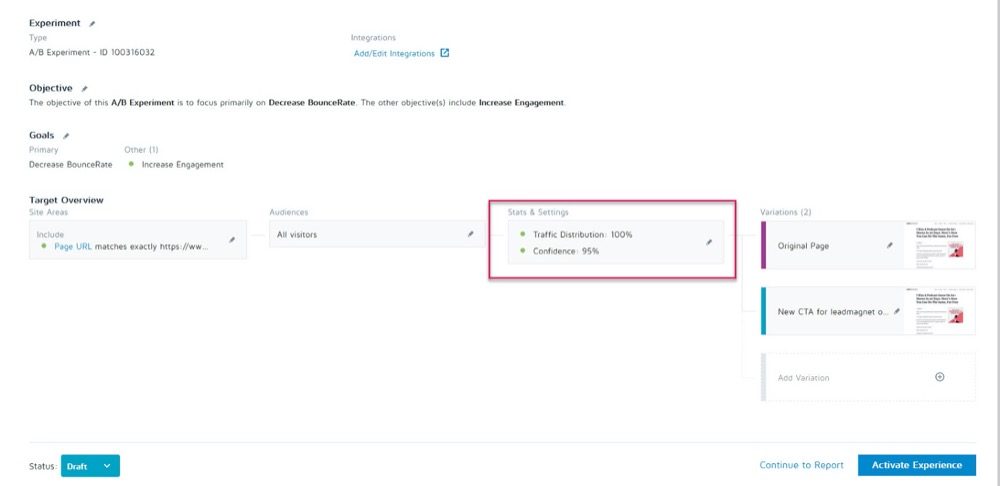

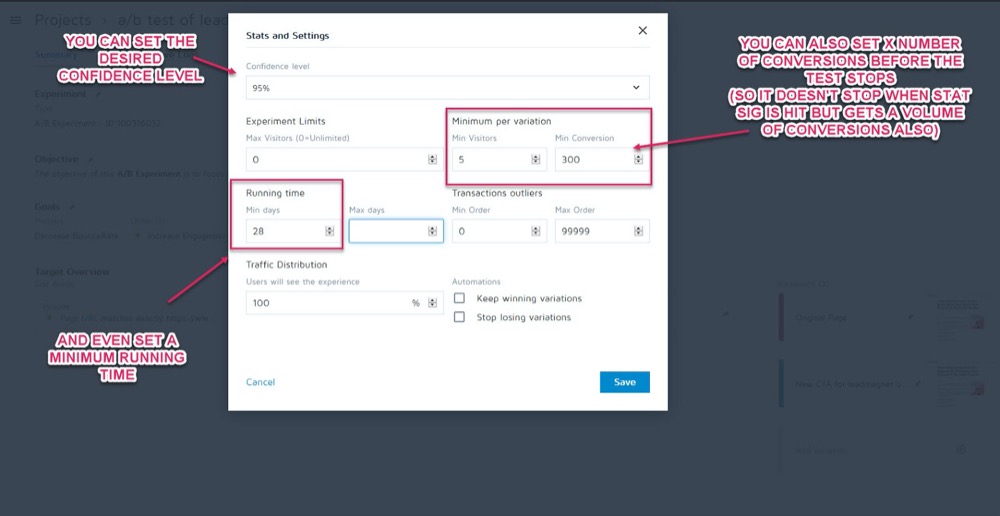

您可以在测试运行之前在转换体验应用程序中实验的统计和设置部分将这些设置为参数。

然后,您可以设置所需的置信水平、最短运行时间和在调用测试之前要实现的转换次数。

一旦你确定你的数据是准确的,就该分析它了……

第 2 步:检查您的微观、宏观和护栏指标

大多数人会看一个测试,并根据工具告诉他们的任何东西来判断赢家或输家。

当然,问题在于该工具只能根据您为其设置的标准告诉您测试的执行情况。 作为 CRO 测试人员,我们总是想了解导致这些结果发生的“方式”和“原因”,以便我们从中学习。

现在我们要做一些检查,但是,首先我将介绍三个最重要的检查。 这就是微观和宏观结果跟踪的用武之地。

让我解释:

- 微跟踪是指跟踪您优化测试的目标,可能是更多的点击、注册等。

- 宏观跟踪正在查看对您的业务(通常是销售额)的北极星指标的影响。

为什么这很重要?

有时,测试页面上微事件的提升不会像您想象的那样影响宏。

例子

假设您在潜在客户捕获页面上测试 CTA,而失败者获得的潜在客户比控制者少。

似乎很明显哪个测试赢了,对吧?

但是在您的分析中进一步检查时,您会注意到通过“失败”测试的潜在客户实际上在后端转换得更高,并创造了更大的投资回报率。

为什么会发生这种情况?

可能是您当前的页面吸引了更广泛的受众并转化了更多潜在客户,但您的新“失败”变体实际上吸引了现在准备购买的人。

在示例中,失败的广告系列实际上是您想要运行的页面,因为它使用您的 Northstar 指标转换得更好。

记住你的最终目标,把精力集中在影响最大的事情上。

微观和宏观结果并不是您需要寻找的全部。

如果您还没有,请考虑将“护栏指标”添加到您的广告系列中。

这些是您在进行任何其他更改时要关注的核心指标,以便如果它们开始下降,您可以回滚或停止某些测试方法,因为它们的性能太重要了。

在 Uber,我们在任何给定时间进行 100 次实验。 这些实验的目标是不断改进我们的产品和用户体验。 但是,有时实验者可能会考虑一些关键指标,并且可能没有意识到对团队和公司整体重要的其他几个指标的影响,并且随着实验的运行,这些不受监控的指标可能会倒退。

为了检测和缓解此类情况,我们构建了我们的实验监控平台。 目标是识别和监控一些我们不想在实验运行期间降级的护栏指标。 我们应用顺序 A/B 方法的变体来持续监控这些护栏指标,并检测实验的治疗组和对照组之间的任何回归。 如果检测到回归,我们会向实验所有者发送警报。

Suman Bhattacharya,Uber 高级数据科学家

例子

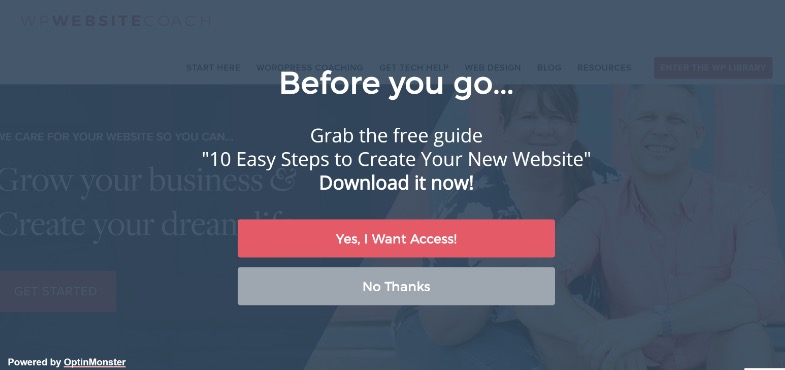

假设您想使用全屏弹出窗口收集更多潜在客户。

对于某些网站,这些效果很好,但并非总是如此。 (这就是我们测试的原因!)

也许您安装了一个全屏弹出窗口并开始在该页面上获得更多潜在客户,但是您发送给这些新订阅者的欢迎电子邮件正在弹跳并且没有发送。

事实证明,人们选择使用虚假电子邮件只是为了让弹出窗口停止显示。

您不希望电子邮件列表中出现虚假线索,因为它们可能会将您的电子邮件传递结果降低给实际订阅者。 您也不应该过多地降低用户体验,以至于您的听众觉得他们需要伪造他们的电子邮件。

由于电子邮件营销是您的销售流程的核心部分,因此您决定设置一个警报,让您知道在您的潜在客户捕获页面上运行 A/B 测试时电子邮件跳出率是否超过设定点。

这将是您的护栏指标。 在此示例中,您可以看到它已损坏,您决定使用侵入性较小的潜在客户捕获方法。

那有意义吗?

不过,Guardrail 指标不仅仅是潜在客户捕获率和跳出率。 它们是您不希望看到影响用户体验的关键指标。

为了防止用户体验下降,同时确保您也在改进重要的指标,请定义一些护栏指标,如果它们下降到某个阈值,它将阻止您继续推出所谓的“获胜”的变体。 这也有助于结束转换优化与用户体验或品牌指南之间的争论。

Alex Birkett,全知数字

由您决定这些指标对您的业务有什么影响。 使用它们来查看您是否有真正的赢家,或者您是否只是用一个结果的提升来换取更重要的领域的损失。

如果您需要一些灵感,请查看 Ben Labay 的实验和测试中常见护栏指标列表:

然后,相应地进行这些更改。

只要您使用分析和高级细分设置了转换体验应用程序,您就应该能够通过快速浏览找到这些信息。 检查每个变体对您的 Northstar 指标的影响,以及您的“护栏”,这样您就不会只选择测试工具的赢家。

现在您已经涵盖了核心指标,让我们更深入地了解您的结果......

第 3 步:更深入地细分您的结果

请记住,在测试方面,平均值是一个谎言。

平均结果只能基于多个数据点的组合为您提供广泛的信息。 您需要了解为什么会出现这种结果,然后再深入研究,因为它并不总是看起来那样。

我们已经看到宏观结果受到微观测试变化的影响,但您的分析细分可以提供更深入的见解。

例子

假设您正在测试更多潜在客户。 乍一看,控件和变体具有相同的访问者到订阅者的转化率。

然而,在更深入的检查中,您会注意到在桌面上,新的变体几乎是控件转化率的两倍,但在移动设备上它为零,导致页面的平均值看起来与控件相同。

显然,有些地方出了问题,但为什么会发生这种情况呢?

可能是新变体无法在移动设备上正确加载,或者表单无法在特定设备上运行,因此实际上没有想要订阅的移动用户可以订阅。 如果您解决了这个问题,则可能是您的“相等结果”变体实际上能够远远胜过控件。

只有当您努力获取结果背后的更多信息时,您才能找到这些东西。

通过每次测试,您将尝试获得洞察力,这将为更智能的细分提供信息,从而产生新的洞察力,最终将引导您制定更有意义的策略。

香奈儿穆林斯,Shopify

细分不仅是发现错误,还包括发现其他用户见解。

也许页面和控件都工作正常,但是当您深入观察时,您会注意到某些流量渠道在这个新测试中的转化率远高于其他渠道?

通常,您会发现一些细分市场表现不佳,而另一些则表现出色。 然后,这可以为新的个性化活动或付费或自然流量策略提供信息。

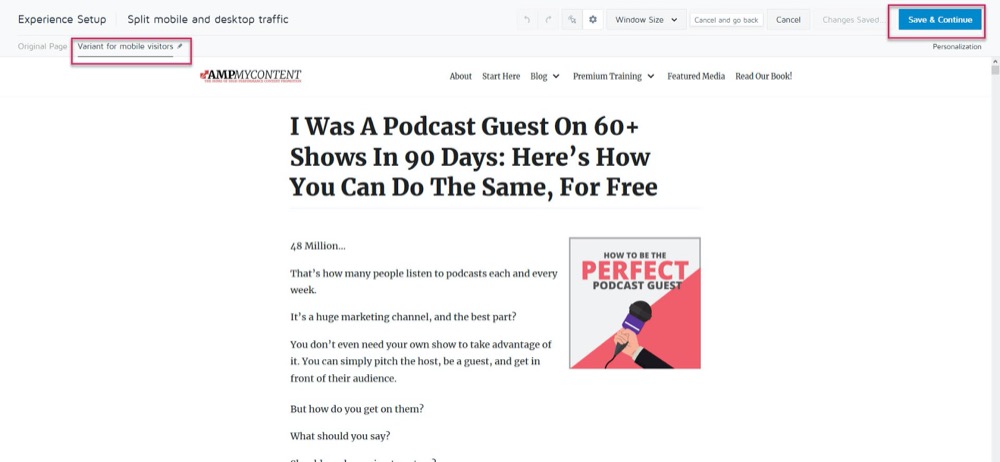

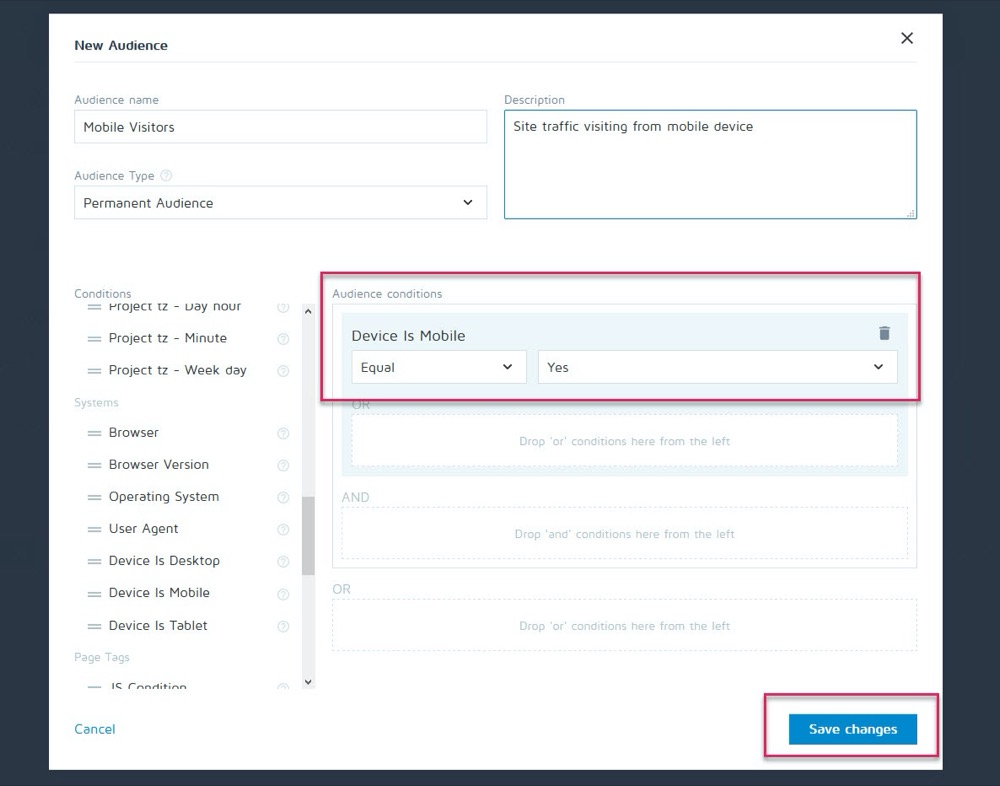

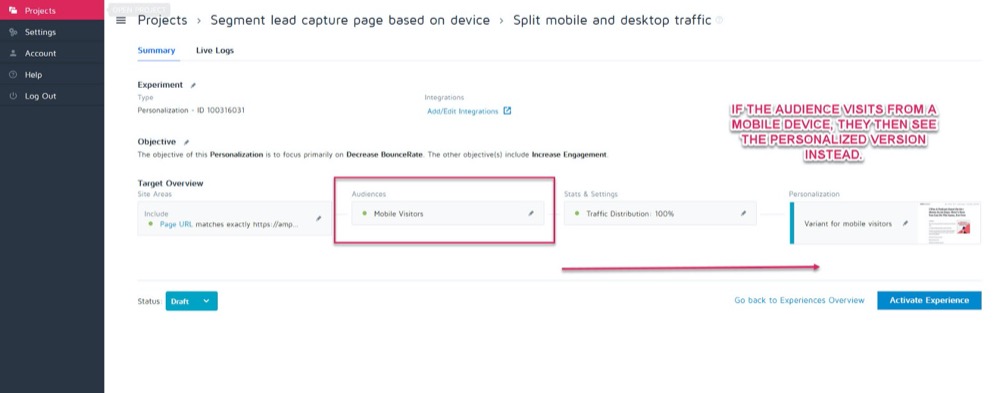

也许控件在台式机上的转换效果最好,但新变体在移动设备上的转换率更高。 例如,您想根据查看者对您网站的看法来选择显示哪个版本。

使用 Convert 的个性化功能,您可以将该移动获胜变体设置为仅针对该受众的个性化。

然后,您可以在访问者来自任何移动设备时显示新版本。

但是,如果他们从桌面遇到,他们会看到桌面版本。

您可以使用一大堆不同的个性化方法,但只有在您从广告系列中获得一些见解时才能使用。

分析细分的关键是始终查看您的结果以了解为什么会发生某些事情。

看着:

- 新观众与回访观众。 一种变体是否让人们更频繁地回来? 是否正在转换更多的冷/新观众?

- 流量来源。 一个渠道比其他渠道做得更好吗? 你能在这里更专注吗?

- 页面浏览量。 特别是如果您的测试页面试图将流量吸引到您的销售页面。 一个版本没有点击可能意味着您的按钮损坏或 CTA 问题。

- 跳出率。 这可能表明链接断开/加载缓慢/用户体验不佳,甚至针对错误的受众。

- 操作系统,

- 移动与桌面。

- 使用的设备。

轻微的免责声明:

要在这样的分段时准确反映每个通道,您需要大量数据。 一个好的经验法则是进行大约 10 倍于您通常运行的转换量的测试(或者每个渠道 300 次转换,而不仅仅是每个变体页面)。

您可能会想, “我们无法获得足够的流量来运行这样的测试”。 或者如果你这样做了,它可能需要几个月的时间才能发生。

即使是这种情况,也不要跳过查看您的细分分析。

为什么?

即使您在每个细分市场中可能没有足够的转化率来得出有数据支持的结论,但如果您开始看到诸如零点击的页面浏览量或立即跳出率等问题,它可以为您提供一些明显的见解。

这些都是可能表明测试失败并帮助您找到可能错过的获胜者的所有事情。 继续寻找任何重大的下降和问题。 在每个平台和设备上一切正常吗?

理想情况下,您在测试前检查了所有内容,但测试中途可能会出现问题,因此请再次检查。

我个人让 WordPress 在广告活动中自动更新,然后导致潜在客户捕获表单在测试中突然停止工作。 始终检查,如果您确实看到破坏结果准确性的东西,请停止测试,修复问题,然后再次运行。

如果一切正常?

让我们来看看为什么人们没有采取你的行动……

第 4 步:检查用户行为以获取更多信息

理想情况下,您应该在测试工具之上进行定性跟踪。

为什么?

因为这通常可以让您深入了解您在常规测试中会错过的变体。

记住:

Convert 等定量测试工具会告诉您发生了什么。 我们可以为您提供点击或未点击的人数之间的原始数字数据,并帮助您设置每个 A/B 测试。

但是添加定性工具可以帮助您了解为什么会发生某项操作。 它们允许您查看用户在做什么,并更深入地了解他们的行为。

(测试通常会由于执行不力或观众理解不佳而失败,只有通过查看问题所在才能解决问题。)

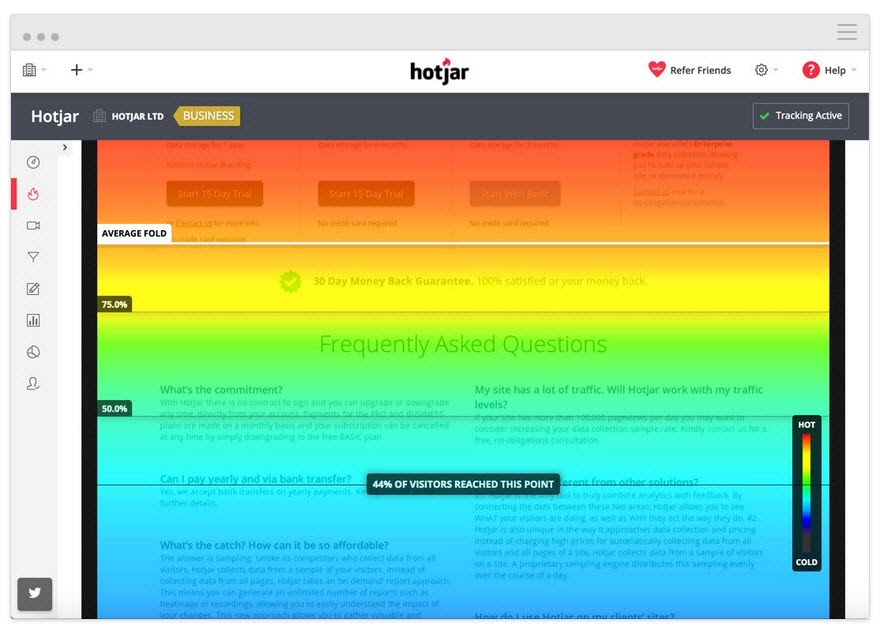

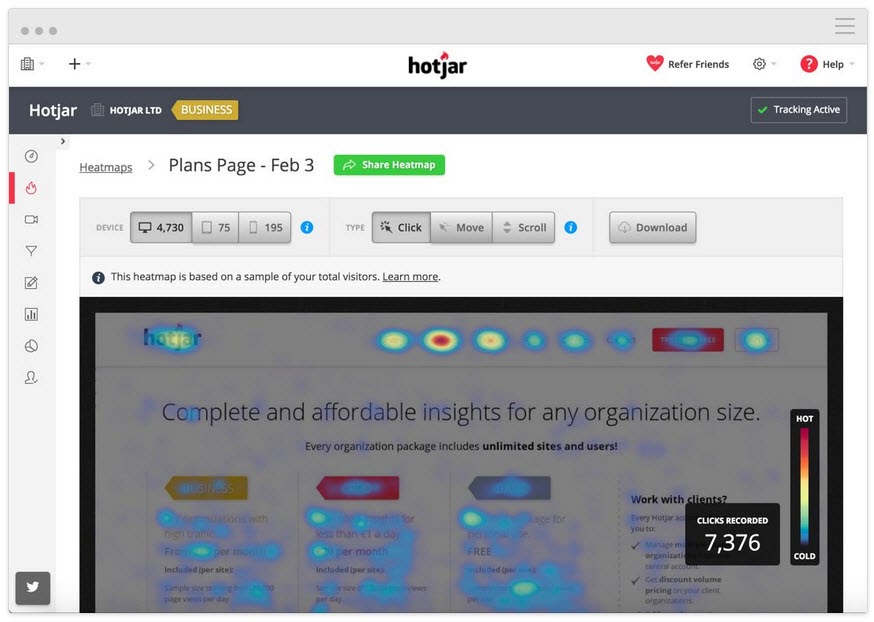

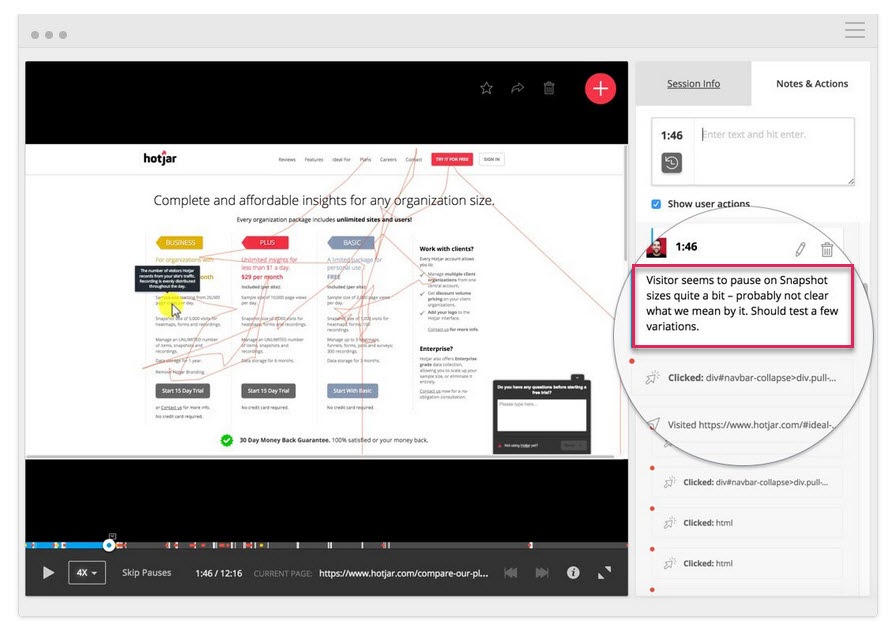

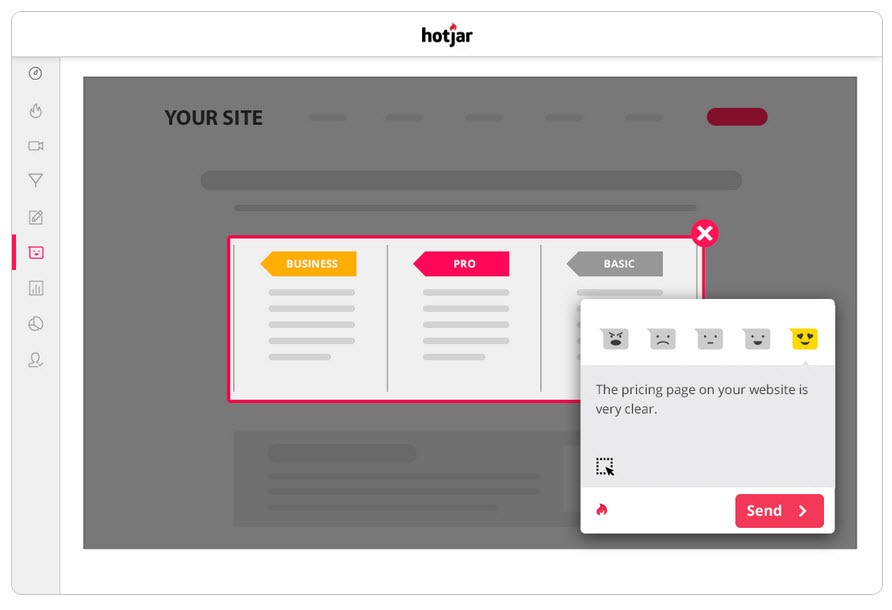

使用像 Hotjar 这样的工具,您可以运行许多定性测试,甚至可以通过我们的内置集成将数据直接拉入您的 Convert 仪表板。

要获得更深入的见解,请设置 Hotjar – Convert 集成并尝试以下策略。

跟踪用户阅读的深度

将热图工具添加到您的页面,以查看您的受众是否与您的 CTA 一样远。 如果没有,您可以再次运行测试并将 CTA 移到页面上方。

跟踪用户点击的内容,但不应该

他们是点击战略 CTA 还是他们认为可能是链接的随机文本?

观看屏幕录像以查看他们不点击但应该点击的内容

他们是否没有点击您的 CTA 按钮,即使他们滚动的距离足以看到它? 他们在点击但它没有打开吗? 他们是否看到它但没有意识到这是一个可以点击的按钮?

您可以观看所有这些内容,甚至可以在这些内容弹出时添加注释。

不仅仅是热图和点击跟踪工具可以提供帮助。

对您的受众进行调查

调查不仅可以帮助您获得有关导致您的受众采取行动(或阻止他们)的原因的反馈,还可以为您提供它用来描述这一点的语言。

在文案写作中,我们称之为“镜像语言”,它在与用户建立联系方面非常有效。 感觉就像您不仅认识到他们的问题,而且比其他任何人都更了解它,因为您用他们使用的相同词语来描述它。

将调查与 A/B 测试工具一起使用的两种好方法是:

- 退出意图民意调查。 找出那些不接受新版本的人,这样你就可以找出是什么阻止了他们。

您今天没有选择/购买是否有原因?

- 购买后/转换调查。 找到那些接受变体的人,看看是否有任何症结和激励因素。

是什么让你决定今天采取行动?” 有什么事情让你几乎无法做出决定吗?

如果您想了解更多信息,您甚至可以在控件上运行类似的调查。 所有这些都将帮助您了解测试的执行方式,以便您可以迭代和改进。

说到这个……

第 5 步:从失败的测试中学习

当涉及到失败的测试时,最重要的是从结果中学到一些东西。 只要您可以从中获得洞察力以更好地改善或了解您的受众,就没有糟糕的测试这回事。

A/B 测试是一个交互式过程。 我们在获得理解的同时失败了。 你通常可以从失败的测试中学到更多,而不是直接获得胜利。

到目前为止,我们一直在做 3 件事:

- 确保测试数据准确,

- 查看任何问题的原始结果,以及

- 试图了解我们的用户及其行为。

此步骤更像是一种启发式方法,可帮助您了解可能导致失败的常见问题(假设测试数据准确且 CTA 按钮均有效)并分析您的方法和假设。

你的假设是错误的还是你的测试错位了?

这是一个常见问题,尤其是在新测试人员中。

您是否根据一些与实际 KPI 不一致的“呜呜”指标或想法进行了测试?

例子

假设您希望从页面获得更多销售额,但出于某种原因,您决定改为测试对社交分享按钮的调整。 (即使您有零数据表明更多的社交分享会影响您的销售。)

这听起来很疯狂,但你会惊讶于这样的事情发生的频率。

问你自己:

我的测试目标是否与核心 KPI 保持一致并以某种方式影响它?

如果没有,那没关系,但要确保下一个测试更好地对齐。

我们失败,我们学习,我们再试一次。

在您的下一个测试中,请务必关注您的核心 KPI 指标以及如何影响它们,并为测试提供明确的赢/失败场景。

我们希望此页面获得更多潜在客户,因此我们正在测试让他们选择加入的方法,这意味着我们希望创建更好的 CTA。

或者

我们希望此页面获得更多潜在客户,并且我们发现用户不会滚动到我们的 CTA,因此我们正在测试将其提升到页面上。

让您的测试与您的目标保持一致将使您走上正确的道路,但即便如此,它仍然可能看不到更多的转化......

假设正确,测试对齐,但结果仍然没有变化

这可能在 90% 的时间发生,这也是大多数测试失败的原因。

示例 #1

您的用户数据显示用户对您的网站不够信任。 您添加了社交证明、用户推荐、SSL 证书等信任因素,但转化率仍未增加。

这是否意味着您应该停下来尝试新的测试或角度?

一点也不…

您最初的假设可能是正确的,但您的测试只需要改进或执行得更好,然后才能看到任何效果。

你可以尝试添加更多的信任因素,甚至改变你所拥有的因素,让它们更加突出。 也许重新措辞他们使用的语言,以帮助他们更好地与您的受众建立联系。

所有这些事情仍然与最初的假设一致,您只需要测试更多版本即可找到赢家。

示例 #2

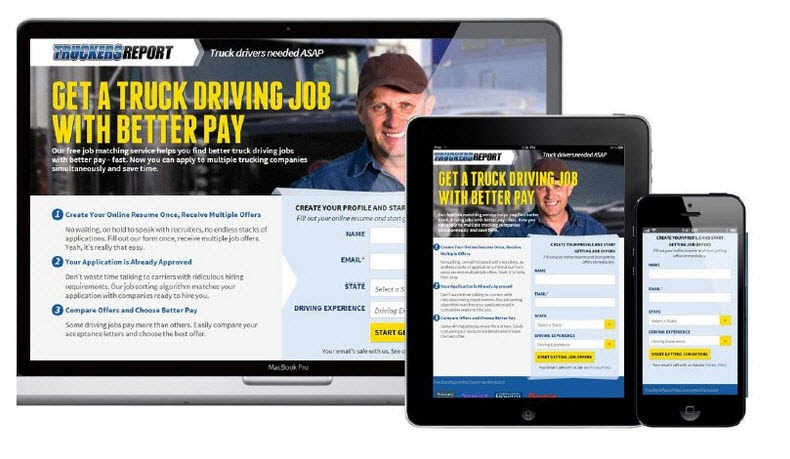

CXL 在此着陆页上进行了 6 次不同的测试活动,以获得更多卡车司机认证的潜在客户。

他们将选择加入率从 12.1% 提高到 79.3%,这一切都是为了继续改进页面。

(几乎所有这些测试活动在看到提升之前都使用相同的假设进行了多次尝试。直到那时,他们才继续前进并测试以改进页面上的其他元素。)

A/B 测试是一个迭代过程。 你必须不断测试和调整才能找到改进,即使是业内最好的也可能只有 10% 的时间能找到赢家。

如果假设您是一个组织,并且您进行的每一次测试都是成功的,那么在我看来这实际上是一个危险信号。

这听起来违反直觉,但它向我表明,您只是在测试明显的东西,并没有冒足够的风险来真正推动针头。

Deborah O'Malley,猜猜测试

向最优秀的人学习总是很棒,我们很高兴能分享我们对 Deborah 的采访。 我们谈到了为什么测试永远不会失败,以及在测试中拥有正确心态的重要性。 为了帮助您从正确的角度开始,请在此处收听我们的采访。

这意味着您可能需要 9 次测试才能看到积极的提升,所以坚持下去。

您的测试应该遵循影响最大到最低的优先系统。 通过运行更多测试和更改来改进您当前的广告系列,您将看到比跳到较低重要性测试更大的影响,因为您没有看到当前测试的立竿见影的结果。

如果它仍然没有看到较小变化的提升,请考虑在运行不同设计的情况下运行创新测试。

它可以是围栏的摇摆,但有时它可能是您需要做出的改变。

如果在所有这些测试和调整之后,变体仍然是失败者怎么办?

所以数据是正确的,你已经尝试了每一个调整,甚至对整个页面进行了大的创新更改,但它仍然不会比控件更好。

看起来可能不是,但这实际上是一件好事。

为什么?

因为您发现了哪些内容不适合您的观众!

如此多的网站在没有测试任何东西的情况下进行了巨大的彻底更改,并且无论如何都将其推出。

问问自己这个:

如果该页面变体的转换率仅比您当前的控制差 1%,那么通过首先测试而不是推出它,您节省了多少钱?

早在 2014 年,Marks and Spencer 决定更新他们的整个网站,而不是先用样本受众进行测试。

结果?

他们的在线销售额在 3 个月内下降了 8.1%,造成了 5500 万美元的损失。

This is why testing and finding losers is a really good thing because even losing tests can save you money.

What if the Test and the Variant Have Identical Results?

You checked everything, it all works, you've segmented down and gone into the nitty-gritty, but there's just no discernible difference between your current page and your new variant.

You've even tried complete page overhauls but through some fluke of math, your new page still converts at the same rate as the old one.

In this case, it's simply the dealer's choice.

Does the new variation more actively represent your brand and style?

If so, choose whichever you wish to use. The results are still the same but you are happier with the design.

Note: This should be the only time that you do this. Branding should not sacrifice results; it should aid them, as seen in the previous example.

Step #6: Double Down on Winners and Continue to Improve Them

So far we've been covering losing campaigns, but what if you got a winner right out of the gate?

First off, congratulations!

Second, let's make sure you actually have a winner. Oftentimes, things can happen to affect your results and give you a false positive (ie we think it's a winner but we implement it and nothing happens.)

Go ahead and run the test again with just your control and the winning variant and prove the lift in results first before you make any changes to your site.

Then if it really is a winner? Don't stop there, continue to improve it!

Iterative improvements of a new winning campaign are the easiest new test to run. With each new improvement, you'll see more ongoing ROI. You can even take what you learned with your winning test and then roll it out across similar pages on your site for further tests and see if it also adds lift there too.

Step #7: Create a Learning Repository for Future Tests

This step is relevant to both winning and losing tests.

Not only will it help you with future tests, but it will also help your QA team diagnose any broken campaigns faster, as they can see where issues have appeared in the past.

更好的是?

It will help you document your results for clients or your boss, while also standardizing your reporting processes and ramping up your test velocity.

以下是它的工作原理:

You're going to create a master archive or learning repository of all past tests. A place to document your previous wins and losses that you can use to both reference for new campaigns and share with stakeholders or customers.

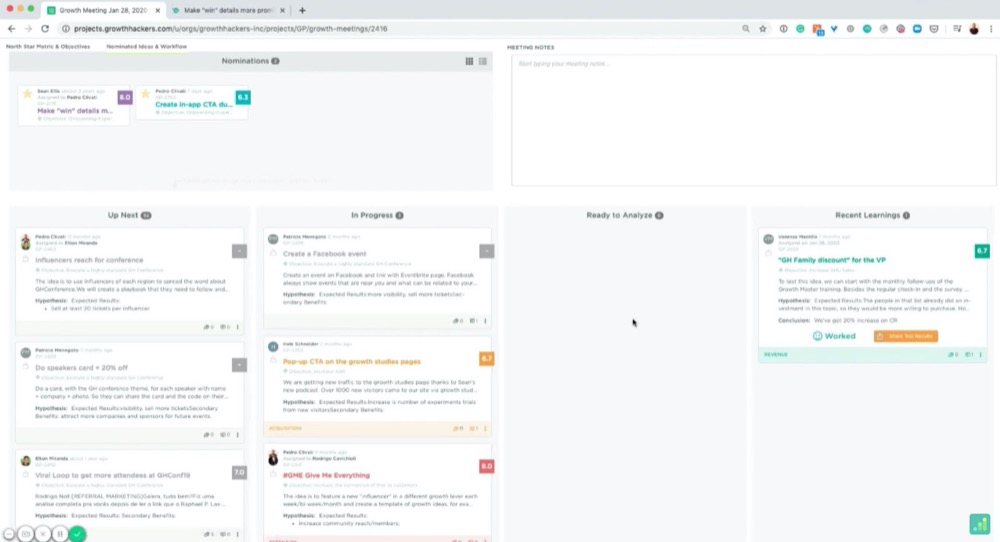

You can use a folder on your computer for this, but, if you really want to get organized, there's a great tool called GrowthHackers experiments.

Its main goal is to help marketing growth teams communicate and organize campaigns, but you can easily use it to manage your CRO testing and learnings. It will even pull in results from your test tool and allows you to archive each test. (You can simply tag and then add them to the repository.)

Whatever you decide to use, here are some best practices:

Organizing Your Tests

You probably have your own naming conventions but if you're just starting, I recommend naming each test like so:

“Goal – Campaign – Test Date”

例如:

“CTR lift test – XYZ client – March 1st-14th 2021”

This way, you can organize tests by goals to get inspiration for future tests, search through and find them for client campaigns, or look back on your experiments month by month.

Then, if you wanted to run a CTR test later on, you can swipe through them and see what ideas worked or failed in the past.

How Do We Create Documents for the Learning Repository?

Feel free to add screenshots of your testing tools graphs, confidence, and power level or any data that you think is relevant.

However, I highly recommend creating a slide with the following information:

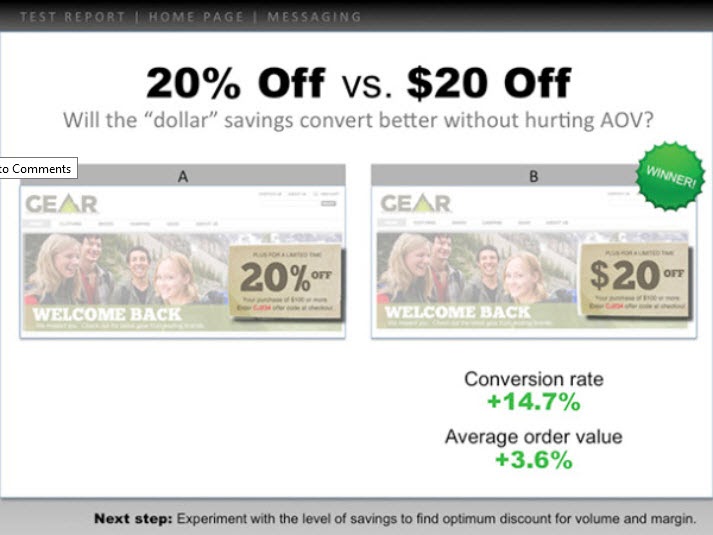

- The hypothesis and how you came up with the idea (any survey data or information).

- A headline with the test goal.

- A screenshot of the control, the winning variant, and any other failed versions/tests that got some lift but not as much. (Highlight the key elements so you can spot what changed without having to look too hard.)

- Add the micro goal and its percentage lift. (Perhaps 3.2% CTR)

- Then add the macro goal and its percentage lift. (AVG order value up 2.2%, etc.)

这是一个例子:

You can use these slides to present the test information to anyone else who needs them, while also having a simple file to understand the test at a moment's notice.

Pretty handy, right?

Now that you've analyzed your test and recorded the results, let's walk you through how to present this to your boss in a way that even if the test failed, they're still happy to see your findings…

How To Present This Information To Your Boss (Even When Your Campaigns Failed)

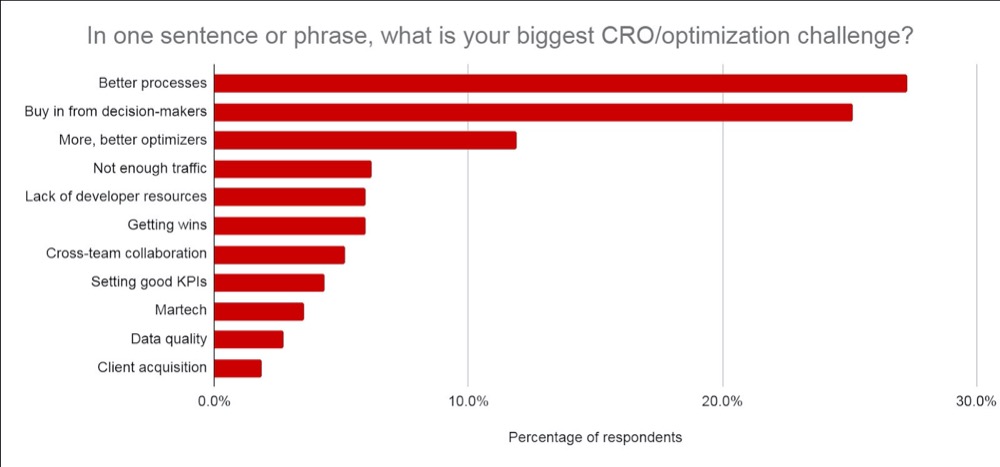

Don't worry if you feel anxious about this, you're not alone. In fact, according to CXL's state of the industry report, presenting test information or getting buy-in from your stakeholders is consistently one of the biggest struggles CROs face.

We've covered the best ways to communicate this information before, but I want to give you a few extra tips on how to get your test results across (even if your test failed).

Tip #1: Get Everyone On Board With CRO and Its Realities as Soon as Possible

Ideally, you covered this when you first broached the topic of running A/B tests but it never hurts to recap.

Make sure they understand that A/B testing is a continual learning process that's more about understanding your audience and improving their experience. The lift in ROI is simply a byproduct of taking action on each test and implementing what you learn, regardless of if it wins or fails.

Winners give lift and losers give insight into where to improve.

No test is ever wasted but the majority of them do fail. You're looking at roughly 1/10 winners for most people's tests and agencies are around 1/4.

Be clear on how many tests fail and the need to run more tests to find winners.

Tip #2: Present the Information as Simply as You Can

Not everyone can read graphs easily. Even if they can, it still means that it takes effort to understand the context of what they are seeing.

The more effort it takes to understand something, the more frustrating it can be and can cause you to lose the other person's attention.

(Top tip for landing pages btw ^^)

Break it down nice and simple by using the slides from your learning repository.

It should already include:

- 你事先学到了什么以及你是如何产生测试想法的。

- 你测试了什么。 显示控制、变化和获胜者。

- 它是如何在微观和宏观层面上发挥作用的。 包括结果。

Finally, add any insights you drew from tests to decide on your next important action to take. (Improve execution, test new variations, new hypothesis, etc.)

Providing insight into what happened is HUGE.

你的老板更关心你学到了什么而不是结果,因为这是可以采取行动的。 分享这一点并给出下一步做什么的想法将帮助他们看到你可以控制情况,并帮助他们对进一步的测试充满信心。

提示#3:让它们看起来不错

更进一步,添加他们关心的数据:

- 如果测试失败,请深入了解您认为它失败的原因。 添加通过不推出失败的测试而节省的投资回报率以及它将如何影响 MRR 和 ARR。

- 如果它赢了,那么请深入了解所取得的投资回报率以及这如何影响年收入/MRR 和 ARR ,以及进一步扩大投资回报率并获得更大投资回报率的任何机会。 (即,您可能已经测试了一个潜在客户捕获页面,并在调整布局时看到了提升。您可能有 30 个其他类似的页面,您可以将此测试应用到可能会看到潜在提升。)

- 如果测试是平的,那么就您认为发生的事情以及下一步要做什么分享见解。 (更好的执行、新的变体、彻底的改变或更好的测试等)

当然,ARR + MRR 或 YOY 影响是一个粗略的估计,但它显示了您的测试的潜在影响和价值。 这就是你的老板关心的事情,也是他们看到你的结果时可能在想的事情。

相信我,当你像这样展示你的信息时,你会发现它更容易传达。 您不再将测试视为“金钱损失”或浪费时间,而是关注潜在的储蓄、实际收益和潜在的进一步增长。

不仅如此,您还能够证明运行更多测试、使您的 CRO 努力成熟以及提高测试速度的价值。

结论

你有它。

到现在为止,您应该对如何分析和从 A/B 测试结果中学习更有信心,并且能够将这些信息呈现给您的老板或其他任何人,无论您的测试如何执行。

只需按照本指南简化您运行的每个新 A/B 测试的测试后分析!