如何定义抓取预算?

已发表: 2016-09-14我们都将其称为 SEO,但抓取预算实际上是如何工作的? 我们知道搜索引擎在访问我们客户的网站时抓取和索引的页面数量与他们在自然搜索中的成功相关,但是拥有更大的抓取预算总是更好吗?

就像谷歌的一切一样,我不认为你的网站抓取预算和排名/SERP 性能之间的关系是 100% 直接的,它取决于许多因素。

为什么抓取预算很重要? 因为 2010 年的咖啡因更新。 通过这次更新,谷歌通过增量索引重建了它索引内容的方式。 引入“过滤器”系统,他们消除了被索引页面的“瓶颈”。

Google 如何确定抓取预算?

这完全取决于您的 PageRank、引文流和信任流。

为什么我没有提到域权限? 老实说,在我看来,它是 SEO 和内容营销人员最容易被滥用和误解的指标之一,它有它的位置,但太多的机构和 SEO 对它过于重视,尤其是在建立链接时。

当然,PageRank 现在已经过时了,特别是因为他们已经放弃了工具栏,所以这一切都与网站的信任率有关(信任率 = 信任流量/引文流量)。 本质上,更强大的域具有更大的抓取预算,那么您如何识别您网站上的 Google bot 活动,更重要的是,识别任何 bot 抓取问题? 服务器日志文件。

现在我们都知道,为了向 Google 机器人指示我们索引(和排名)的页面,我们使用内部链接结构并将它们靠近根域,而不是 URL 上的 5 个子文件夹。 但是更多的技术问题呢? 就像抓取预算浪费、机器人陷阱或者如果谷歌试图在网站上填写表格(它发生了)。

识别爬虫活动

为此,您需要掌握一些服务器日志文件。 您可能需要向您的客户请求这些,或者您可以直接从托管公司下载它们。

这背后的想法是您想尝试查找 Google 机器人访问您网站的记录 - 但由于这不是预定事件,您可能需要获取几天的数据。 有多种软件可用于分析这些文件。

以下是 Apache 服务器的示例命中:

50.56.92.47 – – [31/May/2012:12:21:17 +0100] “GET” – “/wp-content/themes/wp-theme/help.php” – “404” “-” “Mozilla/ 5.0(兼容;Googlebot/2.1;+http://www.google.com/bot.html)” – www.hit-example.com

从这里您可以使用工具(例如 OnCrawl)来分析日志文件并识别问题,例如 Google 抓取 PPC 页面或对 JSON 脚本的无限 GET 请求——这两者都可以在 Robots.txt 文件中修复。

抓取预算何时成为问题?

抓取预算并不总是一个问题,如果您的网站有很多 URL 并且“抓取”的分配比例合理,那您就可以了。 但是,如果您的网站有 200,000 个 URL,而 Google 每天只在您的网站上抓取 2,000 个页面怎么办? 谷歌最多可能需要 100 天才能注意到新的或刷新的 URL——现在这是一个问题。

查看您的抓取预算是否存在问题的一项快速测试是使用 Google Search Console 和您网站上的网址数量来计算您的“抓取数量”。

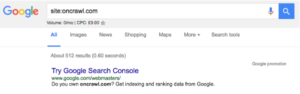

- 首先你需要确定你的站点有多少页面,你可以通过做一个站点来做到这一点:搜索,例如 oncrawl.com 在索引中大约有 512 个页面:

- 其次,您需要转到您的 Google Search Console 帐户并转到 Crawl,然后是 Crawl Stats。 如果您的 GSC 帐户未正确配置,您可能没有此数据。

- 第三步,将“每天抓取的页面”平均数(中间那个)和您网站上的 URL 总数除以:

网站总页数 / 每天抓取的平均页数 = X

如果 X 大于 10,则需要考虑优化抓取预算。 如果它小于5,那就太好了。 您无需继续阅读。

优化您的“抓取预算”容量

您可以在互联网上拥有最大的抓取预算,但如果您不知道如何使用它,那将一文不值。

是的,这是陈词滥调,但这是真的。 如果 Google 抓取您网站的所有页面并发现其中大部分是重复的、空白的或加载速度太慢,它们会导致超时错误,那么您的预算也可能会被浪费掉。

要充分利用爬网预算(即使无法访问服务器日志文件),您需要确保执行以下操作:

删除重复页面

通常在电子商务网站上,诸如 OpenCart 之类的工具可以为同一产品创建多个 URL,我已经在 4 个 URL 上看到相同产品的实例,这些 URL 在目标和根目录之间具有不同的子文件夹。

您不希望 Google 将每个页面的多个版本编入索引,因此请确保您有适当的规范标签将 Google 指向正确的版本。

解决断开的链接

使用 Google Search Console 或抓取软件,找到您网站上所有损坏的内部和外部链接并修复它们。 使用 301 非常棒,但如果它们是损坏的导航链接或页脚链接,只需更改它们指向的 URL,而不依赖 301。

不要写薄页

避免在您的网站上有大量对用户或搜索引擎几乎没有价值的页面。 如果没有上下文,Google 发现很难对页面进行分类,这意味着它们对网站的整体相关性没有任何贡献,它们只是占用抓取预算的乘客。

删除 301 重定向链

链式重定向是不必要的、混乱的和被误解的。 重定向链可能会以多种方式损害您的抓取预算。 当 Google 到达某个 URL 并看到 301 时,它并不总是立即跟随它,而是将新 URL 添加到列表中然后跟随它。

您还需要确保您的 XML 站点地图(和 HTML 站点地图)准确无误,并且如果您的网站是多语言的,请确保您拥有网站每种语言的站点地图。 您还需要实施智能站点架构、URL 架构并加速您的页面。 将您的网站置于 CloudFlare 之类的 CDN 之后也是有益的。

TL;博士:

像任何预算一样抓取预算是一个机会,理论上您是在使用您的预算来购买 Googlebot、Bingbot 和 Slurp 在您的网站上花费的时间,充分利用这段时间很重要。

抓取预算优化并不容易,而且肯定不是“速赢”。 如果您有一个小型站点或维护良好的中型站点,那么您可能没问题。 如果您有一个拥有数万个 URL 的网站庞然大物,并且服务器日志文件超出了您的想象,那么可能是时候请来专家了。