A/A Testi Nedir ve Pazarlamacılar Neden Önemsemelidir?

Yayınlanan: 2017-05-18Bu senaryoyu yaşadınız mı? Yeni düğme ve başlık kombinasyonunuzun daha fazla dönüşüm sağlayıp sağlamayacağını keşfetmek için bir A/B testi ayarladınız...

Hem tıklama sonrası açılış sayfalarınıza (kontrol ve varyasyon) eşit trafik çekersiniz ve bir ay sonra, yazılımınız varyasyonunuzu %99 güvenle kazanan ilan ettiğinde durursunuz...

Yeni "kazanan" tasarımı kullanıma sunuyorsunuz, ancak birkaç iş döngüsü sonra, dönüşüm oranındaki bu %50'lik artış, kârlılığınız üzerinde hiçbir etki göstermiyor. kafan karışık sinirlendin…

Ve muhtemelen yanlış bir pozitif test sonucunun kurbanısınız.

Yanlış pozitif test sonucu nedir?

Neden bu %50'lik dönüşüm oranı artışı daha fazla satışa dönüşmüyor? Copyhackers'tan Lance Jones bunun nedeninin muhtemelen var olmaması olduğunu söylüyor.

Testinizden elde ettiğiniz satış veya gelir artışını görmemeniz tamamen mümkündür (hatta büyük olasılıkla), çünkü bu hiçbir zaman orada olmamıştır. Testinizde bilmeden bir "yanlış pozitif" almış olabilirsiniz - I. Tip istatistiksel hata olarak bilinir, aksi takdirde gerçek bir boş hipotezin yanlış reddi olarak bilinir. Bu bir ağız dolusu, bu yüzden bunu yanlış bir pozitif olarak hatırlıyorum.

Ağız dolusu olsun ya da olmasın, bu Tip 1 istatistiksel hatalar sandığınızdan daha yaygındır. AB testi sonuçlarının yaklaşık %80'inin hayali olduğu tahmin edilmektedir.

Tweetlemek için tıklayın

Yanlış pozitiflere dayalı olarak önemli kararlar alıyorsanız, en iyi ihtimalle optimizasyonu şansa bırakıyorsunuz demektir. En kötüsü, aslında tıklama sonrası açılış sayfalarınızın dönüşüm oranını kötüleştiriyorsunuz.

Neyse ki, zehirli verilerle savaşmanın bazı yolları var. Bunlardan biri, muhtemelen zaten aşina olduğunuz bir test yöntemine benziyor…

A/A testi nedir?

A/B testi, hangisinin daha iyi performans gösterdiğini görmek için trafiği bir orijinal (sizin kontrolünüz) ve başka bir sürüme (sizin varyasyonunuz) olmak üzere iki farklı sayfaya yönlendirmeyi içerir.

Benzer şekilde, A/A testi, hangisinin daha iyi performans gösterdiğini görmek için trafiği iki sayfaya yönlendirmeyi içerir. Ancak, A/B testinden farklı olarak, A/A testi iki özdeş sayfayı karşı karşıya getirir ve bir artış keşfetmek yerine, amaçları sizin kontrolünüz ve varyasyonunuz arasında hiçbir fark bulmamaktır.

Neden A/A testi yapmalısınız?

"İki özdeş sayfayı birbirine karşı test etmek ne işe yarar?" diye merak edip kafanızı kaşıdığınız için sizi suçlamıyoruz.

Aptalca gelebilir, ancak bazı profesyonel test uzmanlarının A/B testlerini test etmeden önce test etmek için kullandıkları bir tekniktir. (Ha?)

Doğru test sonuçları, istatistiksel anlamlılıktan daha fazlasını gerektirir

Herkes A/B testi yapabilir, ancak çok azı geçerli bir A/B testi yapabilir (unutmayın: Test sonuçlarının yalnızca yaklaşık %20'si gerçekten meşrudur).

Doğru test verilerinin üretilmesi, büyük ve temsili bir örneklem büyüklüğü ile istatistiksel anlamlılığa ulaşmaktan daha fazlasını içerir. Sonuçlarınızdan emin olmak için, örneğin bir dizi geçerlilik tehdidiyle lekelenmediğinden emin olmalısınız.

Bu tehditlerden biri olan araç etkisi, A/A testlerinin mücadelede en çok yardımcı olduğu şeydir.

Enstrüman etkisi nedir?

Geçerlilik tehditlerine karşı koruma, A/B testine başlamadan önce başlar. CXL'den Peep Laja, enstrüman etkisinin çoğu test sonucunu zehirleyen şey olduğunu söylüyor:

Bu en yaygın sorundur. Test araçlarında (veya araçlarında) testte hatalı verilere neden olan bir şey olduğunda ortaya çıkar. Genellikle web sitesindeki yanlış kod uygulamasından kaynaklanır ve tüm sonuçları çarpıtır.

Bu nedenle, bir test ayarlarken araçlarınızın doğru yapılandırıldığından ve olması gerektiği gibi çalıştığından emin olmanız önemlidir. Değilse, bu yaygın sorunlar ortaya çıkabilir:

- Temel performans göstergelerinin yanlış raporlanması. Bir araçtaki tek bir hata, verilerinizi karıştırabilir, bu nedenle tüm test bilgilerinizi izlemek için asla tekil bir platforma güvenmemelisiniz. En azından, test yazılımınızda ve web sitesi izlemede gördüğünüz ölçümlerin doğru olduğunu tekrar kontrol etmek için Google Analytics ile entegre edin. Daha da iyi sonuçlar için başka bir araçla üçlü kontrol yapın. Nispeten yakından eşleşmeyen herhangi bir rapordan şüphelenin.

- tıklama sonrası açılış sayfası görüntüleme sorunları. Küçük kodlama hataları, A/B testiniz sırasında görüntüleme sorunları gibi büyük geçerlilik tehditlerine neden olabilir. Bu nedenle, tıklama sonrası açılış sayfalarınızın tüm cihazlarda ve tarayıcılarda olması gerektiği gibi göründüğünden ve ziyaretçilerinizin "titreşim efekti" denen bir şeyden etkilenmediğinden emin olmanız çok önemlidir. Diğerlerinin yanı sıra, yavaş bir web sitesi, kontrolünüz varyasyondan hemen önce ziyaretçinize anlık olarak gösterildiğinde ortaya çıkan bu soruna neden olabilir.

- Bir testi çok erken durdurmak. Bazı test yazılımları, bir örnek boyutu yeterince büyük olmadığında veya hedef müşterinizi temsil etmediğinde kazanan bir sayfayı erken ilan eder. Unutmayın: İstatistiksel anlamlılığa ulaşmak , testinizi durdurma zamanının geldiği anlamına gelmez. Ne kadar uzun süre çalıştırırsanız, sonuçlarınız o kadar doğru olacaktır.

Bu sorunlardan herhangi biri (ve daha fazlası), testinizin sonunda yanlış pozitife yol açabilir, bu nedenle Peep, test uzmanlarını dikkatli olmaları konusunda uyarır:

Bir test oluşturduğunuzda, onu bir şahin gibi izleyin. İzlediğiniz her bir hedefin ve ölçümün kaydedildiğini gözlemleyin. Bazı ölçütler veri göndermiyorsa (örneğin, sepete tıklama verileri ekleyin), testi durdurun, sorunu bulun ve düzeltin ve verileri sıfırlayarak baştan başlayın.

Ancak herkes, özellikle yeni bir yazılım kullanırken, A/B testine hemen iki ayağıyla atlamak konusunda rahat hissetmez. Bu nedenle, ek bir önlem olarak, bazı uygulayıcılar A/B testine başlamadan önce araçlarını değerlendirmek için A/A testi yaparlar.

Denemeniz doğru ayarlanmışsa, bir A/A testinin sonunda her iki sayfa da benzer bir dönüşüm oranıyla çıkmalıdır. Aşağıdaki test cihazlarının gösterdiği gibi, bu her zaman olmaz.

A/A testi örnekleri

Yanlış pozitifler gerçekten bu kadar yaygın mı? Bir sayfa gerçekten klonundan daha iyi performans gösterebilir mi? Bu adamlar, aşağıdaki blog gönderilerinde bulgularını öğrenmek ve ortaya çıkarmak için A/A testini kullandılar…

1. Ana Sayfa Bölünmüş Test, Popüler Test Araçlarının Büyük Eksikliğini Ortaya Koydu

11 Kasım 2012'de Copyhackers ekibi ana sayfalarında aşağıda resmi görülen bir A/A split testine başladı:

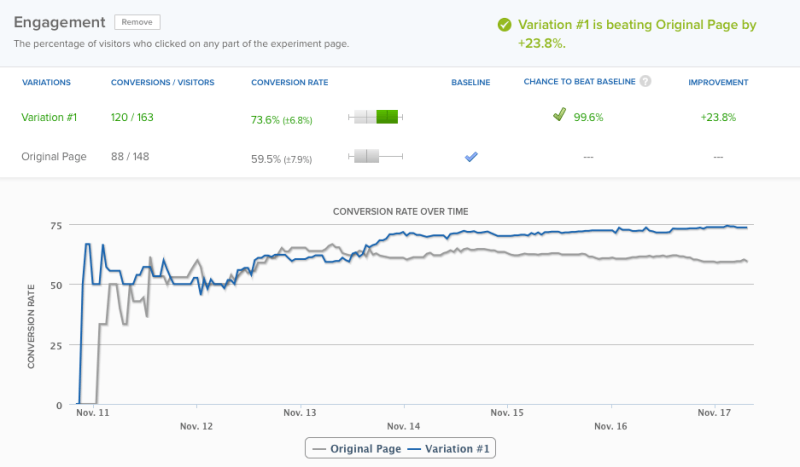

18'inde - 6 gün sonra - test araçları %95 güvenle kazananı ilan etti. Ancak doğruluk adına ekip, testin bir gün daha çalışmasına izin verdi - bu noktada yazılımları %99,6'lık bir güven düzeyinde kazananı ilan etti:

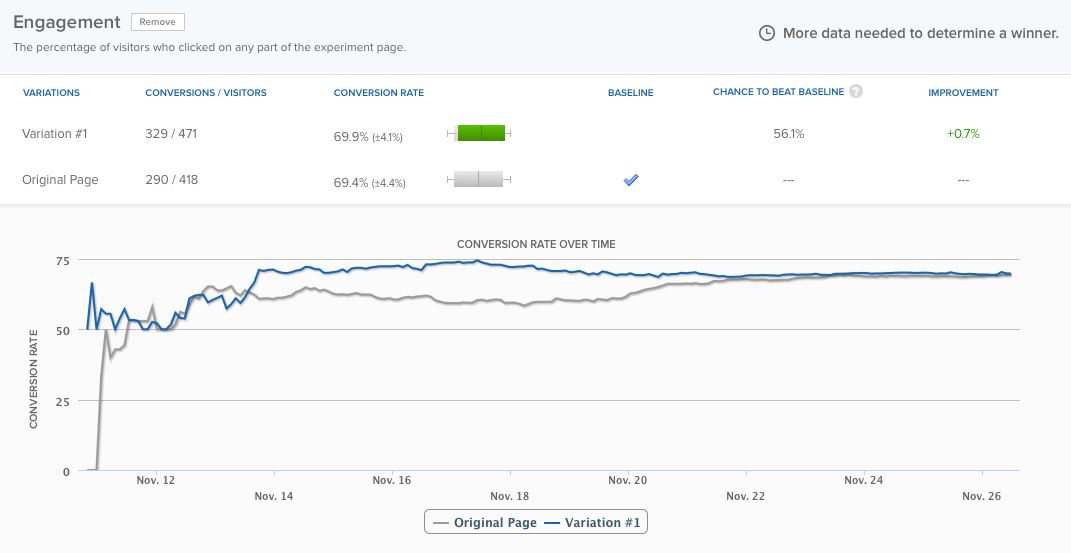

Yazılıma göre, ana sayfaları aynı sayfadan yaklaşık %24 daha iyi performans gösteriyordu ve sonucun yanlış pozitif olma olasılığı yalnızca %0,4'tü. Yine de ekip, testin yaklaşık üç gün daha çalışmasına izin verdi ve sonunda farklar eşitlendi:

Ama mesele bu değil. Önemli nokta şu: Test aracı çok erken bir kazanan ilan etti. Copyhackers ekibi onu çalışır durumda tutmasaydı, yanlış bir şekilde deneylerinde bir sorun olduğunu varsayacaklardı. Test hakkında daha fazlasını buradan okuyun.

2. A/A Testi: Kesinlikle Hiçbir Şey Yapmayarak Dönüşümleri Nasıl %300 Artırdım

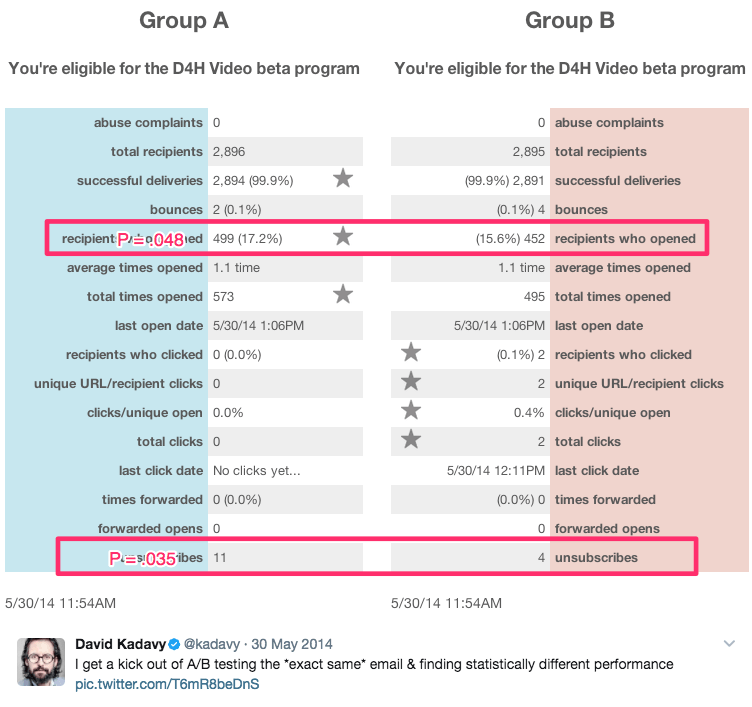

Bu alaycı başlık, 750.000 e-posta abonesi üzerinde 8 ay boyunca bir dizi A/A testi yürüten yazar ve kendi kendini "iyileşmek isteyen girişimci" ilan eden David Kadavy'den geliyor. Bu süre zarfında, aşağıdakiler gibi istatistiksel olarak anlamlı sonuçlar üretti:

Bu sonuçlar arasında şunlar vardı:

- E-posta açılışlarında %9 artış

- Tıklamalarda %300 artış

- %51 daha düşük abonelikten çıkma oranı

Diyor:

Birçok girişimci için (eski ben dahil), bu "vay canına, açılışları %10 artırdınız!" Hatta bunu Visual Web Sitesi Optimize Edici'nin önem hesaplayıcısına girip p=.048 olduğunu görebilirler. "İstatistiksel olarak önemli!" onlar (veya ben) haykırabiliriz.

Gerçek şu ki, bunların hepsi A/A testleriydi. Birbirine karşı test edilen içerik aynıydı. Elde ettiği sonuçların daha fazlasını burada görün.

A/A testleri yapmalı mıyım?

Bu sorunun cevabı, kime sorduğunuza bağlıdır.

Daha fazla gelir sağlamayan büyük dönüşüm artışları görmeye devam eden Neil Patel, "Yanlış yazılımlarla zaman kaybetmemenize yardımcı olacağından, önce bir A/A testi yapmanız gerçekten önemlidir" diyor.

Öte yandan, CXL'den Peep Laja, A/A testlerinin kendisinin zaman kaybı olduğunu söylüyor. Peki kim haklı?

A/A testiyle ilgili iki büyük sorun

Teorik bir bakış açısından, A/A testi çok mantıklı. Her şeyden önce, bir A/B testi çalıştırırken doğruluk çok önemlidir ve testinizi test etmek, bunu sağlamanın birçok yolundan yalnızca biridir.

Ancak gerçek dünya test ortamlarında, A/A testlerinin yarardan çok zarar verme potansiyeli vardır. Craig Sullivan açıklıyor:

Benim için sorun, test çalıştırma süresini bir A/A testi dönemiyle önceden yüklemek zorunda kalarak her zaman gerçek trafiği ve test süresini tüketmektir. Ayda 40 test yapmaya çalışırsam, bu, canlı yayın yapma yeteneğimi sakatlar. Sıralamayı kontrol etmek için 2-4 haftalık A/A testi yapmaktansa, denemede yarım günlük bir QA testi yapmayı tercih ederim.

Sorun bir. A/A testleri, A/B testleri ile web sitenizin ziyaretçileri hakkında daha fazla bilgi edinmek için kullanabileceğiniz gerçek zamanlı ve trafiğe mal olur.

İkinci sorun , Copyhackers'ın örnek olay incelemesinde örneklenmiştir. A/B testleri gibi, A/A testlerinin de yanlış pozitiflere karşı hassas oldukları için dikkatle tasarlanması ve izlenmesi gerekir.

Başka bir deyişle, A/A testiniz size bir sayfanın diğerinden daha iyi performans gösterdiğini söyleyebilir, öyle değilken (bu şans sandığınızdan çok daha yüksektir — yaklaşık %50)

Copyhackers'taki ekip, test araçlarını dinlemiş ve yalnızca altı gün içinde bir kazanan ilan etmiş olsaydı, ana sayfalarının neden tek yumurta ikizinden (gerçekte öyle olmadığı halde) daha iyi performans gösterdiğini anlamak için daha fazla zaman harcayacaklardı. .

A/A testinin en büyük yararı

Bu sorunlara rağmen A/A testi, gerçek testler sırasında daha da büyük sorunları yakalamanıza yardımcı olma potansiyeline sahiptir. Bu testlerin sonuçları, önemli iş kararlarını dayandırdığınız sonuçlar olduğunda, dikkate alınması gereken güçlü bir avantajdır.

A/A testi yapmaya karar verirseniz, bunu yapmanın A/A/B testi adı verilen potansiyel olarak daha az israflı bir yolu vardır.

A/A/B testi ve A/A testi

Geleneksel A/A testi yöntemi trafiği boşa harcar çünkü sonuç kısmında size ziyaretçileriniz hakkında hiçbir şey söylemez. Ancak, bu teste bir "B" varyasyonu eklerseniz, olabilir. İşte ikisi arasındaki fark:

- A/A testi = birbirine karşı test edilen 2 özdeş sayfa

- A/A/B testi = 2 aynı sayfa ve birbirine karşı test edilen bir varyasyon

A/A/B testi, trafiğinizi üç bölüme ayırır, bu da istatistiksel anlamlılığa ulaşmasının daha uzun süreceği anlamına gelir. Ancak iyi tarafı, bir kez yaptığınızda, hem test aracınız hem de ziyaretçileriniz hakkında verilere sahip olacaksınız.

Testinize güvenip güvenemeyeceğinizi belirlemek için A ile A sonuçlarını karşılaştırın. İstatistiksel olarak benzerlerse, A ile B'nin sonuçlarını karşılaştırın. Değillerse, tüm testin sonuçlarını atmanız gerekir (bu, çalıştırılması geleneksel bir A/A testinden daha uzun sürdü) çünkü trafiğiniz üç şekilde bölümlere ayrılmıştır).

A/A testinin faydaları eksilerinden ağır basıyor mu?

Bazı uzmanlar “evet” derken, diğerleri “hayır” diyor. Leadplum'dan Andrew First, cevabın aşağıdakiler arasında bir yerde olduğunu düşünüyor:

A/A testi muhtemelen aylık bir iş olmamalı, ancak yeni bir araç kurarken verilerinizi test etmek için zaman ayırmaya değer. Kötü verileri şimdi yakalarsanız, aylar sonra test sonuçlarınıza daha fazla güvenirsiniz.

Sonuç olarak, size kalmış. Yeni bir araç kullanıyorsanız, Andrew'un tavsiyesine uymanız akıllıca olabilir. Yine de değilseniz, muhtemelen en iyisi Craig Sullivan'ın liderliğini takip etmek ve bunun yerine titiz bir ön test KG süreci oluşturmaktır. A/B testi için zamandan, kaynaklardan ve trafikten tasarruf edin.

Test çalışmalarınızdan ve dijital reklam kampanyalarınızdan en iyi şekilde yararlanın, bugün bir Instapage Enterprise demosuna kaydolun.