Genel Web Sitesi Sağlığı için Hızlı ve Kirli 11 Adımlı Teknik SEO Denetimi

Yayınlanan: 2020-02-27Teknik SEO önemlidir çünkü herhangi bir projenin başlangıç noktasıdır. Bir SEO uzmanının bakış açısından, her web sitesi yeni bir projedir. Bir web sitesinin iyi sonuçlar alabilmesi ve SEO benzeri sıralamalarda en önemli KPI'ya ulaşabilmesi için sağlam bir temele sahip olması gerekir.

Ne zaman yeni bir projeye başlasam, yaptığım ilk şey teknik bir SEO denetimidir. Çoğu zaman teknik sorunları düzeltmek, web sitesi yeniden taranır taranmaz şaşırtıcı sonuçlar alabilir.

İnsanların içerik ve daha fazla içerik hakkında konuşmaları benim için komik ama teknik SEO hakkında tek kelime etmiyorlar. Kesin olan bir şey var ki, web sitesi sağlığı ve Teknik SEO 2020'de çok önemli olacak iki önemli şey. İçeriğin önemli olmadığını söylemek istemiyorum. Öyle, ancak bir web sitesindeki teknik sorunları çözmeden içeriğin sonuç getirebileceğini düşünmüyorum.

Robots.txt dosyasında önemli sayfaların direktifler tarafından engellendiği veya en önemli kategori veya hizmet sayfalarının noindex, nofollow gibi meta robotlar tarafından bozulduğu veya engellendiği durumlar gördüm. Bu sorunları düzelterek önceliklendirmeden başarılı olmak nasıl mümkün olabilir?

Düzeltilecek web geliştirme uzmanlarına rapor vermek için teknik sorunları nasıl tanımlayacağını bilmeyen SEO'ların sayısını görmek şaşırtıcı olabilir. Kurumsal alanda çalışırken bir kez hatırladım, ekibim tarafından kullanılmak üzere bir Tech SEO denetim kontrol listesi sayfası oluşturdum. O zaman, bunun gibi hızlı bir düzeltme sayfasına sahip olmanın bir ekibe son derece yardımcı olabileceğini ve bir müşteri için hızlı bir destek sağlayabileceğini fark ettim. Bu nedenle, teknik SEO teşhisi ve önerileri konusunda size yardımcı olabilecek bir araca/yazılıma yatırım yapmanın son derece önemli olduğunu düşünüyorum.

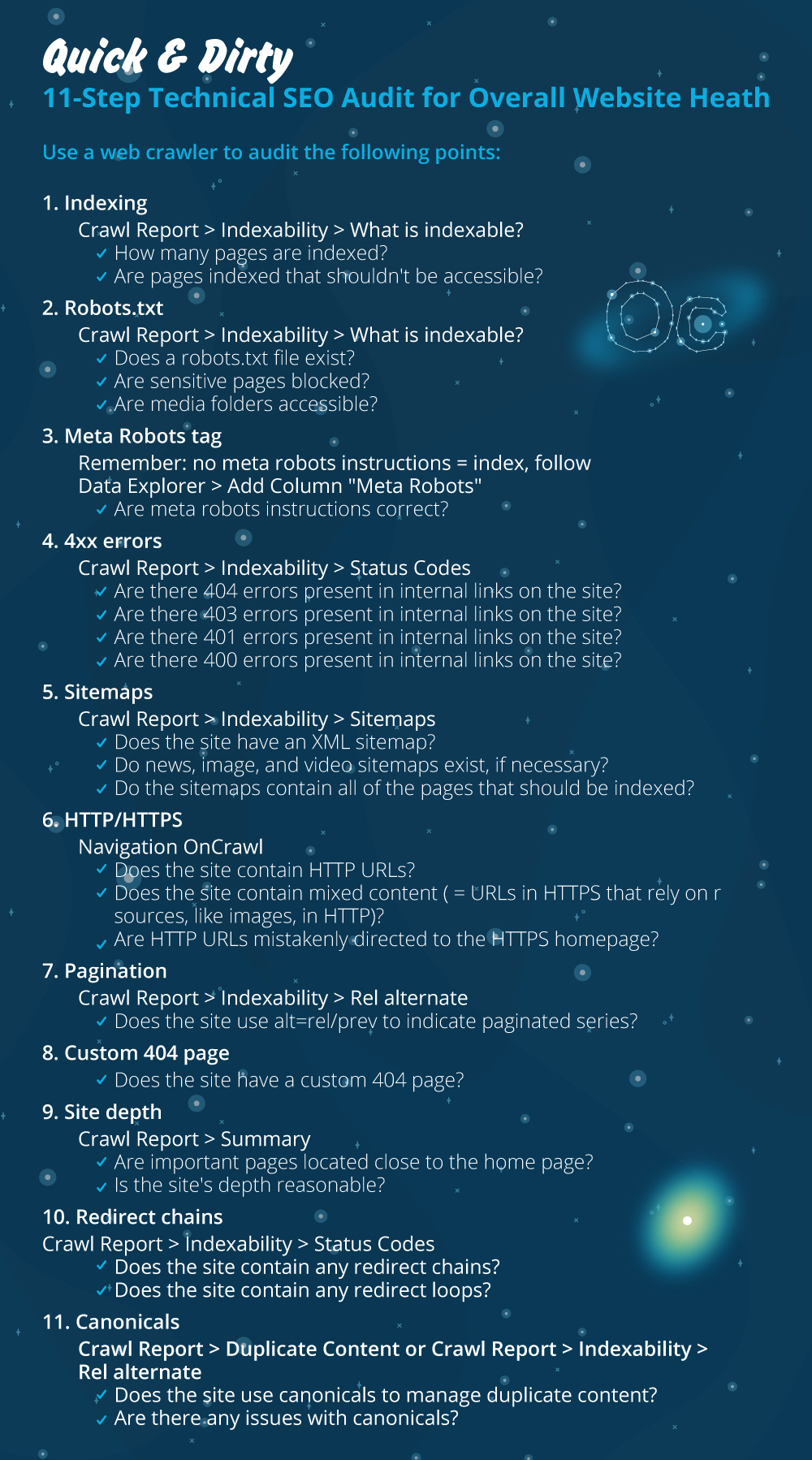

Büyük bir fark yaratacak hızlı bir teknik SEO denetiminin nasıl yapılacağına ilişkin uygulamalı süreci başlatalım. Bu, profesyonel olmasanız bile yapmanız yaklaşık bir saat sürecek hızlı bir egzersizdir. OnCrawl gibi bir Tech SEO aracı kullanmak benim için tüm manuel işleri yapmak zorunda kalmadan her şeyi beş dakika içinde hızlı ileri sarmak hayatımı kolaylaştırıyor.

Teknik SEO Denetimi yaparken kontrol edilecek en önemli şeyleri gözden geçireceğim. Sayfa sorunları için kontrol edebileceğimiz daha çok şey var, ancak ben yalnızca dizine ekleme sorunlarına ve taramayla bütçe israfına neden olacak şeylere odaklanmak istiyorum. Buna öncelik vermek, en önemli sayfaların Googlebot tarafından taranmasını sağlamanın yoludur.

- indeksleme

- Robots.txt dosyası

- Meta robot etiketi

- 4xx hataları

- Site Haritaları

- HTTP/HTTPS (web sitesi güvenliği, karma içerik ve yinelenen içerik sorunları)

- sayfalandırma

- 404 sayfa

- Site derinliği ve yapısı

- Uzun yönlendirme zincirleri

- Kanonik etiket uygulaması

1) indeksleme

Bu kontrol edilecek ilk şey. Dizin oluşturma çoğu zaman bir eklenti yapılandırmasından veya herhangi bir küçük hatadan etkilenebilir, ancak bugün dizine eklenmiş 6,16 milyardan fazla web sayfası olduğu için bulunabilirlik üzerindeki etkisi çok büyük olabilir. Herhangi bir arama motorunun çaba sarf ettiğini ve Google'ın bile kullanıcı deneyimi için en alakalı sayfaya öncelik vermesi gerektiğini anlamanız gerekir. Googlebot için işleri kolaylaştırmayı düşünmüyorsanız, rakipleriniz bunu yapacak ve sağlıklı bir web sitesiyle gelen güveni çok daha fazla kazanacaktır.

İndeksleme sorunları olduğunda, web sitenizin sağlık sorunları organik trafik kaybına yansıyacaktır. İndeksleme işlemi, bir arama motorunun bir web sayfasını taraması ve daha sonra SERP'de sunduğu bilgileri düzenlemesi anlamına gelir. Sonuçlar, kullanıcı amacı ile alaka düzeyine bağlıdır. Bir web sayfası tarama ile ilgili sorun yaşıyorsa veya sorun yaşıyorsa, bu aynı niş içindeki diğer sayfaların avantaj sağlamasına yardımcı olacaktır.

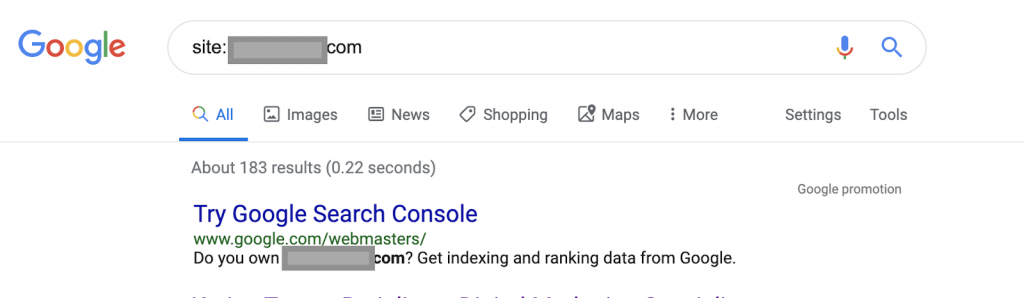

Örneğin arama operatörlerini kullanma:

Site: www.abc.com

Sorgu, Google tarafından dizine eklenen 183 sayfa döndürür. Bu, Google'ın dizine eklediği sayfa sayısının kaba bir tahminidir. Tam sayı için Google Arama Konsolu'nu kontrol edebilirsiniz.

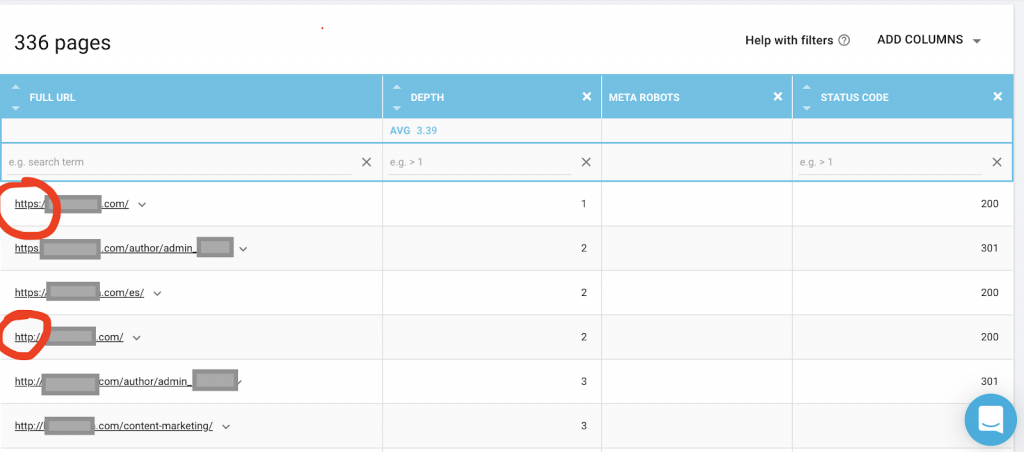

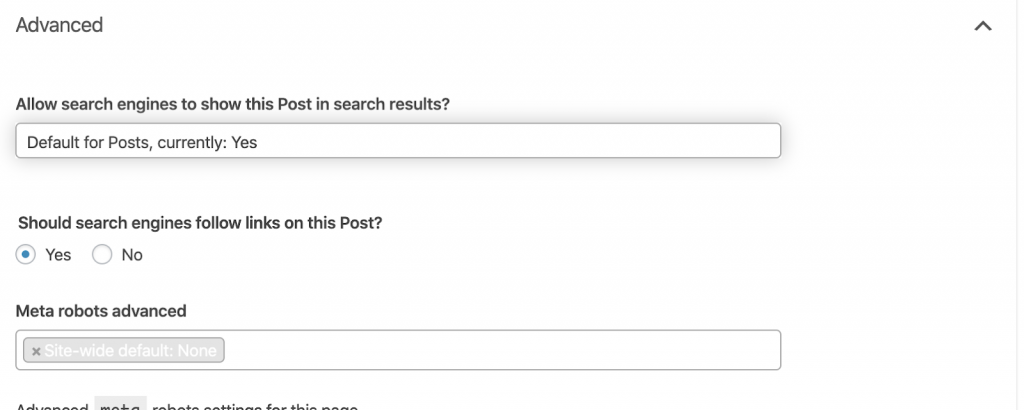

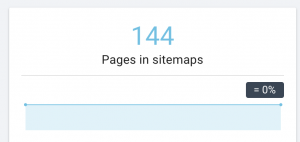

Ayrıca, Google'ın erişebildiği tüm sayfaları listelemek için OnCrawl gibi bir web tarayıcısı kullanmalısınız. Bu, aşağıda görebileceğiniz gibi farklı bir sayı gösterir:

Bu web sitesinde, dizine eklenen sayfalara göre neredeyse iki kat daha fazla taranabilir sayfa var.

Bu, HTTP ve HTTPS sorunu arasında yinelenen bir içerik sorununu veya hatta bir web sitesi güvenlik sürümü sorununu ortaya çıkarabilir. Bu makalenin ilerleyen kısımlarında bunun hakkında konuşacağım.

Bu durumda, web sitesi HTTP'den HTTPS'ye taşındı. OnCrawl'da HTTP sayfalarının yeniden yönlendirildiğini görebiliriz. Hem HTTP hem de HTTPS sürümlerine Googlebot hâlâ erişebilir ve sahibinin sıralamak istediği en önemli sayfalara öncelik vermek yerine tüm yinelenen sayfaları tarayarak tarama bütçesinin boşa harcanmasına neden olabilir.

İhmal edilen web siteleri veya e-ticaret siteleri gibi büyük web siteleri arasındaki bir diğer yaygın sorun, karışık içerik sorunlarıdır. Uzun lafın kısası, güvenli sayfanızda güvenli olmayan sürümden yüklenen medya dosyaları (en sık: resimler) gibi kaynaklar olduğunda sorunlar ortaya çıkar.

Nasıl düzeltilir:

Bir web geliştiricisinden tüm HTTP sayfalarını HTTPS sürümüne zorlamasını ve bir kez 301 durum kodu kullanarak HTTP adreslerini HTTPS'ye yönlendirmesini isteyebilirsiniz.

Karışık içerik sorunları için, sayfanın kaynağını manuel olarak kontrol edebilir ve özellikle büyük web siteleri için bunu yapmak neredeyse delice olan “src=http://example.com/media/images” olarak yüklenen kaynakları arayabilirsiniz. Bu yüzden teknik bir SEO aracı kullanmamız gerekiyor.

2) Robots.txt dosyası:

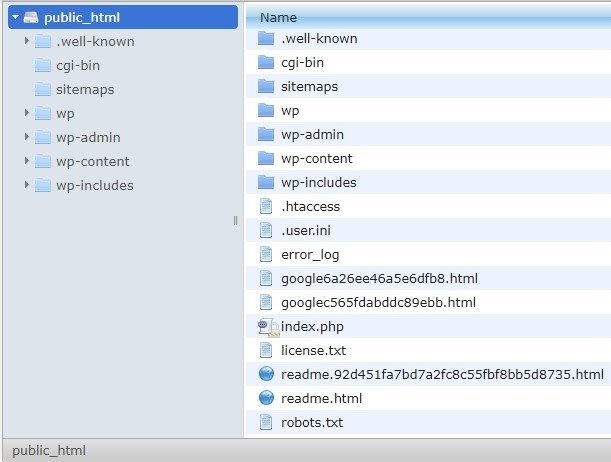

robots.txt dosyası, tarama aracılarına hangi sayfaları taramamaları gerektiğini söyler. Robots.txt belirtim kılavuzu, dosya biçiminin maksimum 500 KB boyutunda düz metin olması gerektiğini belirtir.

Site haritasını robots.txt.file dosyasına eklemenizi tavsiye ederim. Bunu herkes yapmaz, ancak bunun iyi bir uygulama olduğuna inanıyorum. Robots.txt dosyası, barındırılan sunucunuza public_html'de yerleştirilmelidir ve kök etki alanından sonra gelir.

Arama motorlarının gereksiz sayfaları veya yönetici sayfası, şablonlar veya alışveriş sepeti (/cart, /checkout, /login, bloglarda kullanılan /tag gibi klasörler) gibi hassas bilgiler içeren sayfaları taramasını önlemek için robots.txt dosyasındaki yönergeleri kullanabiliriz. , bu sayfaları robots.txt dosyasına ekleyerek.

Tavsiye : Medya dosyası klasörünü engellemediğinizden emin olun çünkü bu, resimlerinizi, videolarınızı veya diğer kendi kendine barındırılan medyalarınızı dizine eklenmesini engelleyecektir. Medya, sayfa alaka düzeyinin yanı sıra organik sıralama ve resimler veya videolar için trafik için çok önemli olabilir.

3) Meta Robotlar etiketi

Bu, arama motorlarına o sayfadaki tüm bağlantılarla birlikte bir sayfayı tarama ve dizine ekleme talimatı veren bir HTML kodu parçasıdır. HTML etiketi web sayfanızın başına gelir. Robotlar için 4 yaygın HTML etiketi vardır:

- Takip etme

- Takip etmek

- dizin

- dizin yok

Hiçbir meta robot etiketi olmadığında, arama motorları içeriği varsayılan olarak takip edecek ve dizine ekleyecektir.

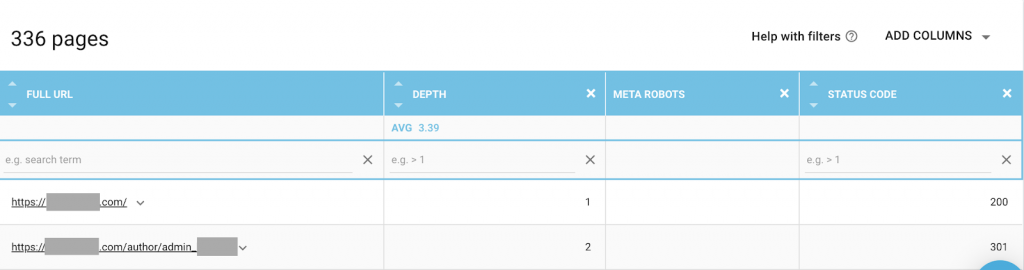

İhtiyaçlarınıza en uygun herhangi bir kombinasyonu kullanabilirsiniz. Örneğin, OnCrawl'ı kullanarak bu web sitesindeki bir "yazar sayfasının" meta robotları olmadığını buldum. Bu, varsayılan olarak yönün ("takip et, dizin") olduğu anlamına gelir.

Bu (“noindex, nofollow”) olmalıdır.

Niye ya?

Her vaka farklıdır, ancak bu web sitesi küçük bir kişisel blogdur. Blogda yayın yapan tek bir yazar vardır ve alan adı yazarın adıdır. Bu durumda, "yazar" sayfası, blog platformu tarafından oluşturulmuş olmasına rağmen ek bilgi sağlamaz.

Başka bir senaryo, blogdaki kategorilerin önemli olduğu bir web sitesi olabilir. Sahibi kendi blogunda kategoriler için sıralama yapmak istediğinde, meta robotlar kategori sayfalarında ("takip et, dizine ekle") veya varsayılan olmalıdır.

Farklı bir senaryoda, büyük SEO uzmanlarının topluluk tarafından takip edilen makaleler yazdığı büyük ve tanınmış bir web sitesi için Google'daki yazar adı bir marka gibi davranır. Bu durumda muhtemelen bazı yazar adlarını indekslemek isteyeceksiniz.

Gördüğünüz gibi meta robotlar birçok farklı şekilde kullanılabilir.

Nasıl düzeltilir:

Bir web geliştiricisinden meta robot etiketini ihtiyaç duyduğunuzda değiştirmesini isteyin. Küçük bir web sitesi için yukarıdaki durumda, her sayfaya gidip manuel olarak değiştirerek kendim yapabilirim. WordPress kullanıyorsanız bunu RankMath veya Yoast ayarlarından değiştirebilirsiniz.

4) 4xx hataları:

Bunlar istemci tarafındaki hatalardır ve 401, 403 ve 404 olabilir.

- 404 Sayfa Bulunamadı:

Bu hata, dizine eklenen URL adresinde bir sayfa bulunmadığında oluşur. Taşınmış veya silinmiş olabilir ve eski adres, web sunucusu işlevi 301 kullanılarak doğru şekilde yeniden yönlendirilmemiş olabilir. 404 hataları, kullanıcılar için kötü bir deneyimdir ve ele alınması gereken teknik bir SEO sorununu temsil eder. 404'leri sık sık kontrol etmek ve düzeltmek iyi bir şeydir ve bütçelerini boşa harcayan sürünen ajanlar için tekrar tekrar denenmesine izin vermemek.

Nasıl düzeltilir:

404'leri döndüren adresleri bulmamız ve içerik hala mevcutsa 301 yönlendirmelerini kullanarak düzeltmemiz gerekiyor. Veya resim iseler, aynı dosya adını taşıyan yenileriyle değiştirilebilirler.

- 401 Yetkisiz

Bu bir izin sorunudur. 401 hatası genellikle kullanıcı adı ve parola gibi kimlik doğrulama gerektiğinde ortaya çıkar.

Nasıl düzeltilir:

İşte iki seçenek: Birincisi, sayfayı robots.txt kullanarak arama motorlarından engellemek. İkinci seçenek, kimlik doğrulama gereksinimini kaldırmak.

- 403 yasak

Bu hata, 401 hatasına benzer. 403 hatası, sayfanın herkese açık olmayan bağlantılara sahip olması nedeniyle oluşur.

Nasıl düzeltilir:

Sayfaya erişime izin vermek için sunucudaki gereksinimi değiştirin (yalnızca bu bir hataysa). Bu sayfanın erişilemez olmasını istiyorsanız, sayfadan tüm dahili ve harici bağlantıları kaldırın.

- 400 Hatalı İstek

Bu, tarayıcı web sunucusuyla iletişim kuramadığında oluşur. Bu hata genellikle hatalı URL sözdizimi için ortaya çıkar.

Nasıl düzeltilir:

Bu URL'lerin bağlantılarını bulun ve sözdizimini düzeltin. Bu düzeltilemezse, bunları düzeltmek için web geliştiricisiyle iletişime geçmeniz gerekir.

Not: Araçlarla veya Google Konsolunda 400 hata bulabiliriz

5) Site Haritaları

Site haritası, web sitesinin içerdiği tüm URL'lerin bir listesidir. Site haritalarına sahip olmak, tarayıcıların içeriğinizi bulmasına ve anlamasına yardımcı olduğu için bulunabilirliği artırır.

Farklı türde site haritalarımız var ve hepsinin iyi durumda olduğundan emin olmamız gerekiyor.

Sahip olmamız gereken site haritaları:

- HTML site haritası: Bu, web sitenizde olacak ve kullanıcıların web sitenizdeki sayfaları gezinmesine ve bulmasına yardımcı olacaktır.

- XML site haritası: Bu, arama motorlarının web sitenizi taramasına yardımcı olacak bir dosyadır (en iyi uygulama olarak robots.txt dosyanıza dahil edilmelidir).

- Video XML site haritası: Yukarıdakiyle aynı.

- Resimler XML site haritası: Aynı zamanda yukarıdakiyle aynıdır. Resimler, videolar ve içerik için ayrı site haritaları oluşturmanız önerilir.

Büyük web siteleri için, site haritalarının 50.000'den fazla URL içermemesi gerektiğinden, daha iyi taranabilirlik için birkaç site haritasına sahip olmanız önerilir.

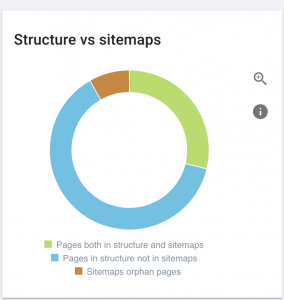

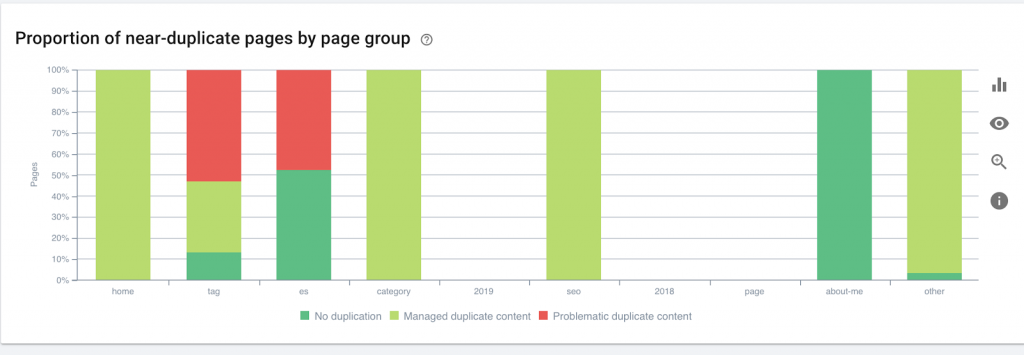

Bu web sitesinde site haritası sorunları var.

Nasıl düzeltiriz:

İçerik, resimler ve videolar için farklı site haritaları oluşturarak bunu düzeltiriz. Ardından bunları Google Arama Konsolu aracılığıyla göndeririz ve ayrıca web sitesi için bir HTML site haritası oluştururuz. Bunun için bir web geliştiricisine ihtiyacımız yok. Site haritaları oluşturmak için herhangi bir ücretsiz çevrimiçi aracı kullanabiliriz.

6) HTTP/HTTPS (yinelenen içerik)

Birçok web sitesinde, HTTP'den HTTPS'ye geçişin bir sonucu olarak bu sorunlar vardır. Bu durumda, web sitesi arama motorlarında HTTP ve HTTPS versiyonlarını gösterecektir. Bu yaygın teknik sorunun bir sonucu olarak, sıralamalar sulandırılmıştır. Bu sorunlar aynı zamanda yinelenen içerik sorunları da oluşturur.

![]()

Nasıl düzeltilir:

Tüm HTTP'yi HTTPS'ye zorlayarak bir web geliştiricisinden bu sorunu çözmesini isteyin.

Not : Soft 404 hataları üreteceğinden, HTTP'nin tamamını asla HTTPS ana sayfasına yönlendirmeyin. (Bunu web geliştiricisine söylemelisiniz; bunların SEO olmadığını unutmayın.)

7) Sayfalandırma

Bu, sayfalar arasında ilişkiler kuran bir HTML etiketinin ("rel = prev" ve "rel = next") kullanılmasıdır ve arama motorlarına farklı sayfalarda sunulan içeriğin tanımlanması veya tek bir sayfayla ilişkilendirilmesi gerektiğini gösterir. Sayfalandırma, UX içeriğini ve teknik kısım için bir sayfanın ağırlığını sınırlamak ve bunları 3 MB'ın altında tutmak için kullanılır. Sayfalandırmayı kontrol etmek için ücretsiz bir araç kullanabiliriz.

Sayfalandırmanın kendi kendine kurallı referansları olmalı ve bir "rel = önceki" ve "rel = sonraki" belirtilmelidir. Tek kopya bilgi meta başlık ve meta açıklama olacaktır, ancak bu, geliştiriciler tarafından küçük bir algoritma oluşturacak şekilde değiştirilebilir, böylece her sayfanın oluşturulmuş bir meta başlığı ve meta açıklaması olacaktır.

Nasıl düzeltilir:

Bir web geliştiricisinden kendi kendine kurallı etiketle sayfalandırma HTML etiketlerini uygulamasını isteyin.

Oncrawl SEO Tarayıcısı

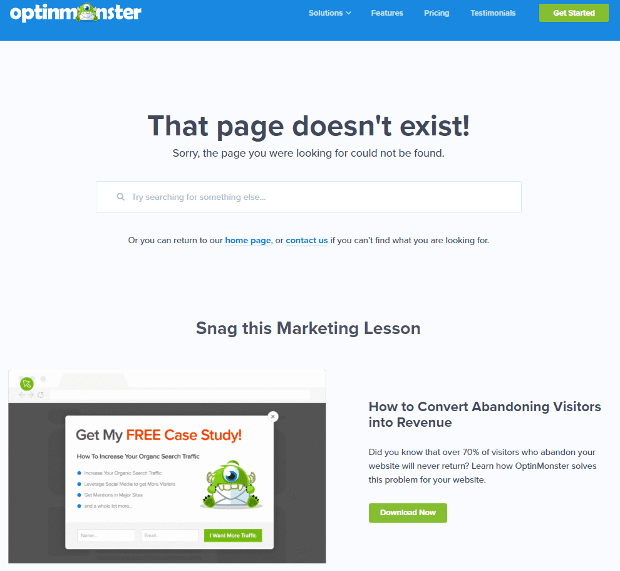

8) Özel 404 Bulunamadı Sayfası

404 yanıtı, daha önce tartıştığımız gibi, kullanıcıları bozuk bir bağlantıya veya var olmayan bir sayfaya getiren bir “ Bulunamadı ” hatasıdır. Bu, kullanıcıları doğru yere yönlendirmek için bir fırsattır. Özel 404 sayfalarının harika örnekleri var. Bu olmazsa olmazlardan.

İşte harika bir 404 özel sayfa örneği:

Nasıl düzeltilir:

Özel bir 404 sayfası oluşturun: Üzerine eklemek için harika bir şey düşünün. Bu hatayı işletmeniz için bir fırsata dönüştürün.

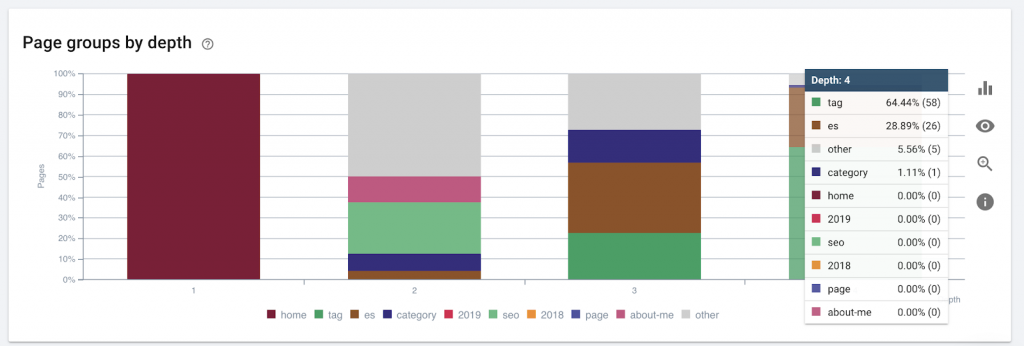

9) Saha derinliği/yapısı

Sayfa derinliği, sayfanızın kök etki alanından bulunduğu tıklamaların sayısıdır. Google'dan John Mueller, "ana sayfaya yakın sayfaların daha fazla ağırlığa sahip olduğunu" söyledi. Örneğin buradaki sayfaya ulaşılabilmesi için aşağıdaki navigasyonun gerekli olduğunu düşünelim:

“Kilimler” sayfası ana sayfadan 4 tık uzaklıktadır. Arama motorları daha derin sayfaları taramakta zorlandığından, sayfaların evden 4 tıklamadan fazla uzakta olmaması önerilir.

Bu grafik, sayfa grubunu derinliğe göre gösterir. Bir web sitesinin yapısının yeniden işlenmesi gerekip gerekmediğini anlamamıza yardımcı olur.

Nasıl düzeltilir:

Kullanıcıların kolay erişimi ve daha iyi web sitesi yapısı için en önemli sayfalar UX ana sayfasına en yakın olmalıdır. Bir web sitesi yapısı oluştururken veya bir web sitesini yeniden yapılandırırken bunu dikkate almak çok önemlidir.

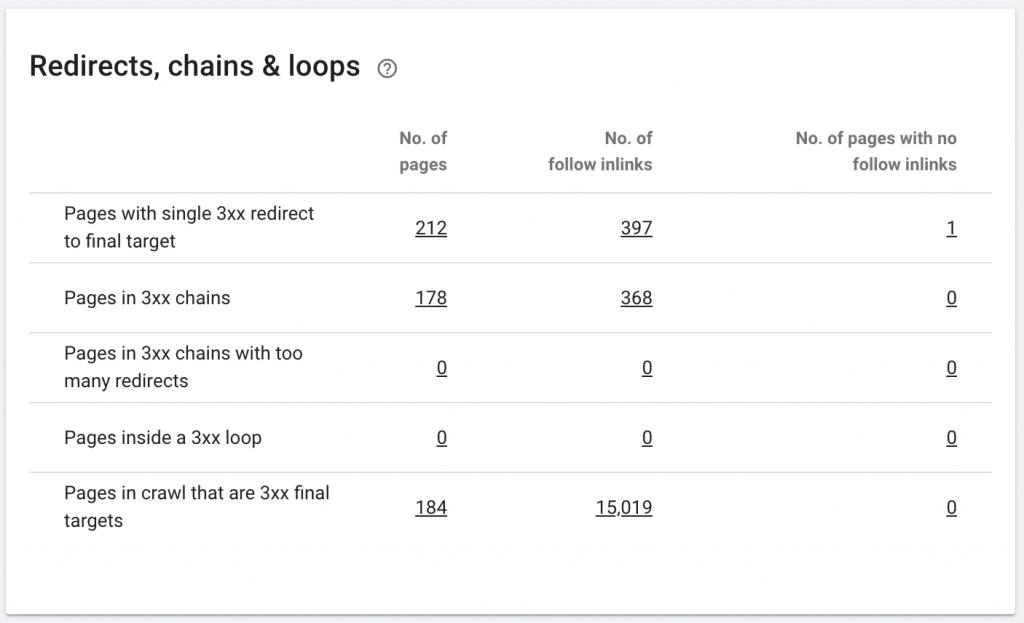

10. Yönlendirme Zincirleri

Yönlendirme zinciri, URL'ler arasında bir dizi yönlendirme gerçekleştiğinde ortaya çıkar. Bu yeniden yönlendirme zincirleri de döngüler oluşturabilir. Aynı zamanda Googlebot için sorunlar yaratır ve tarama bütçesini boşa harcar.

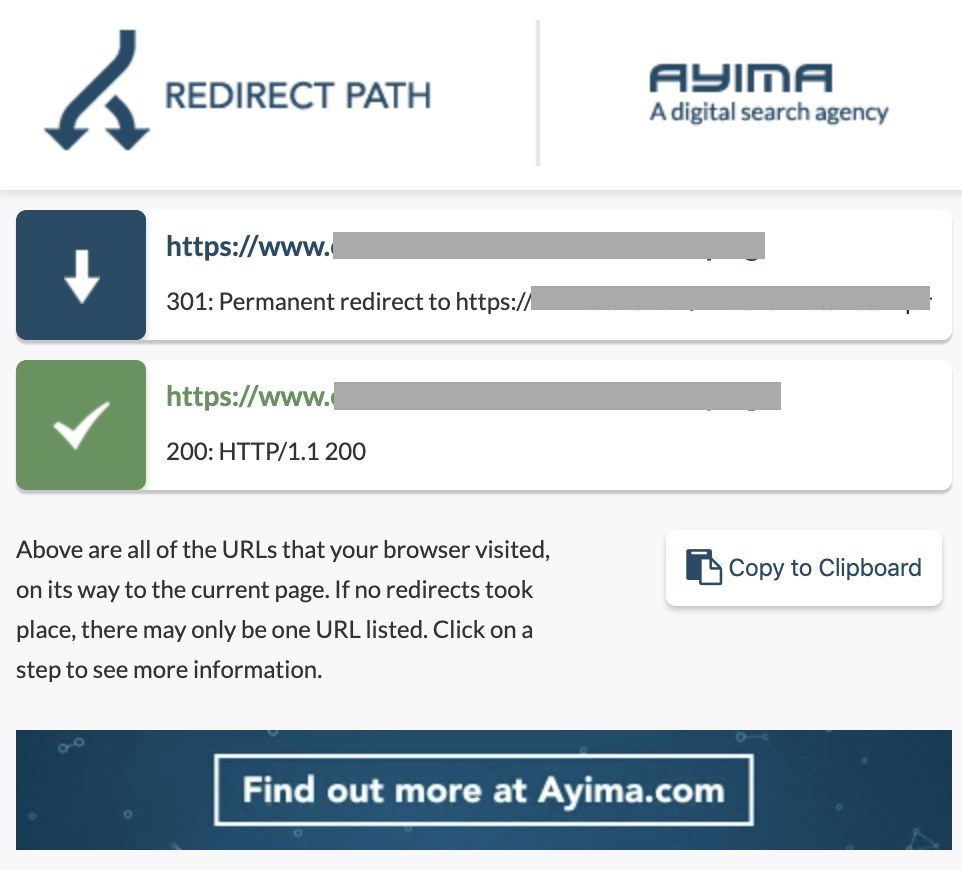

Chrome uzantısı Yeniden Yönlendirme yolunu kullanarak veya OnCrawl'da yönlendirme zincirlerini tanımlayabiliriz.

Nasıl düzeltilir:

Bir WordPress web sitesiyle çalışıyorsanız, bunu düzeltmek gerçekten kolaydır. Yönlendirmeye gidin ve zinciri arayın - bu değişiklikler 2-3 aydan daha önce gerçekleştiyse zincirle ilgili tüm bağlantıları silin ve son yönlendirmeyi geçerli URL'ye bırakın. Web geliştiricileri, gerekirse .httacces dosyasında gerekli tüm değişiklikleri yaparak da bu konuda yardımcı olabilir. SEO eklentilerinizdeki uzun yönlendirme zincirlerini kontrol edebilir ve değiştirebilirsiniz.

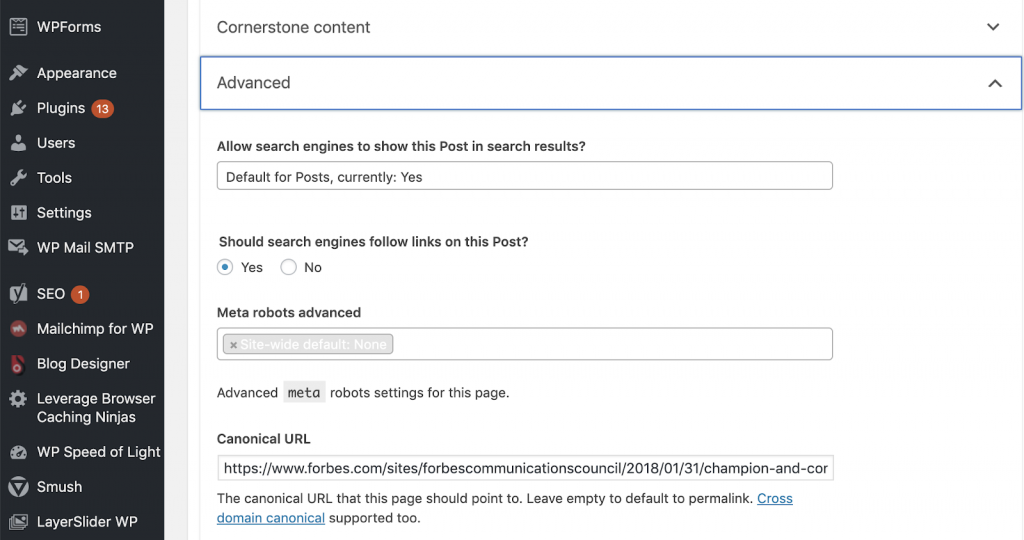

11) Kanonikler

Kurallı etiket, arama motorlarına URL'nin başka bir sayfanın kopyası olduğunu söyler. Bu, birçok web sitesinde bulunan büyük bir sorundur. Kuralları doğru şekilde uygulamamak veya hiç uygulamamak, yinelenen içerik sorunlarına yol açacaktır.

Kanonikler, bir ürünün boyut, renk vb. gibi farklı kategorilerde birden çok kez bulunabileceği e-ticaret web sitelerinde yaygın olarak kullanılır.

Sayfalarınızın kurallı etiketlere sahip olup olmadığını ve bunların doğru şekilde uygulanıp uygulanmadığını anlamak için OnCrawl'ı kullanabilirsiniz. Daha sonra tüm sorunları keşfedebilir ve düzeltebilirsiniz.

Nasıl düzeltiriz:

WordPress'te çalışıyorsak, Yoast SEO kullanarak kanonik sorunları çözebiliriz. WordPress kontrol paneline ve ardından Yoast -setting – gelişmiş seçeneğine gidiyoruz.

Kendi denetiminizi yürütmek

Teknik SEO'ya dalmaya başlamak isteyen SEO'ların, SEO sağlığını iyileştirmek için izlenecek hızlı adımlar kılavuzuna ihtiyacı vardır. Conde Nast'ta Audience Grow Başkan Yardımcısı ve NewzDash'in kurucusu John Shehata ile geçtiğimiz Ekim 2019'da NYC'de düzenlenen Küresel Pazarlama Günü'nde Teknik SEO hakkında konuşuyorlar.

İşte bana söylediği şey:

“SEO endüstrisindeki birçok insan teknik değildir. Şimdi, her SEO nasıl kod yazılacağını anlamıyor ve insanlardan bunu yapmasını istemek zor. Bazı şirketler, yaptıkları şey, geliştiricileri işe almak ve teknik SEO boşluğunu doldurmak için onları SEO uzmanı olmaları için eğitmektir.”

Benim düşünceme göre, tam kod bilgisine sahip olmayan SEO'lar, bir denetimin nasıl yürütüleceğini, temel unsurları belirleyerek, raporlama yaparak, web geliştiricilerinden uygulama isteyerek ve son olarak değişiklikleri test ederek Tech SEO'da hala harika şeyler yapabilirler.

başlamaya hazır mısın? Bu en önemli sorunlar için kontrol listesini indirin.