Tarama, indeksleme ve Python: bilmeniz gereken her şey

Yayınlanan: 2021-05-31Bu makaleye çok basit bir denklemle başlamak istiyorum: Sayfalarınız taranmazsa, asla dizine eklenmezler ve bu nedenle SEO performansınız her zaman zarar görür (ve kötü kokar).

Bunun bir sonucu olarak, SEO'ların web sitelerini taranabilir hale getirmenin en iyi yolunu bulmaya ve Google'a en önemli sayfalarını sunarak onları dizine eklemeleri ve bu sayfalar üzerinden trafik elde etmeye başlamaları gerekir.

Neyse ki, Screaming Frog, Oncrawl veya Python gibi web sitemizin taranabilirliğini geliştirmemize yardımcı olabilecek birçok kaynağımız var. Python'un tarama kolaylığı ve indeksleme göstergelerinizi analiz etmenize ve iyileştirmenize nasıl yardımcı olabileceğini size göstereceğim. Çoğu zaman, bu tür iyileştirmeler aynı zamanda daha iyi sıralamalar, SERP'lerde daha yüksek görünürlük ve nihayetinde daha fazla kullanıcının web sitenize girmesini sağlar.

1. Python ile indeksleme talep etme

1.1. Google için

Google için indeksleme isteği birkaç şekilde yapılabilir, ancak ne yazık ki bunlardan hiçbirine pek ikna olmadım. Artıları ve eksileri ile size üç farklı seçenek sunacağım:

- Selenium ve Google Arama Konsolu: benim açımdan ve test ettikten sonra ve seçeneklerin geri kalanını bu en etkili çözümdür. Ancak, birkaç denemeden sonra, onu kıracak bir captcha açılır penceresi olması mümkündür.

- Bir site haritasına ping atmak: Site haritalarının istendiği gibi taranmasına kesinlikle yardımcı olur, ancak örneğin web sitesine yeni sayfaların eklenmesi durumunda belirli URL'leri değil.

- Google İndeksleme API'si: Yayıncılar ve iş platformu web siteleri dışında pek güvenilir değildir. Tarama hızlarını artırmaya yardımcı olur, ancak belirli URL'leri dizine eklemez.

Her bir yöntemle ilgili bu hızlı genel bakıştan sonra, onlara tek tek dalalım.

1.1.1. Selenyum ve Google Arama Konsolu

Esasen, bu ilk çözümde yapacağımız şey, Selenium'lu bir tarayıcıdan Google Arama Konsolu'na erişmek ve Google Arama Konsolu ile indekslenmek üzere birçok URL'yi otomatik olarak göndermek için manuel olarak izleyeceğimiz işlemin aynısını çoğaltmaktır.

Not: Bu yöntemi aşırı kullanmayın ve yalnızca içeriği güncellendiyse veya sayfa tamamen yeniyse dizine eklenmesi için bir sayfa gönderin.

Selenium ile Google Arama Konsolu'na giriş yapabilmenin püf noktası, GSC tarama istatistikleri raporu indirme işleminin nasıl otomatikleştirileceğiyle ilgili bu makalede anlattığım gibi, önce OUATH Playground'a erişmektir.

#Bu modülleri içe aktarıyoruz

ithalat zamanı

selenyum içe aktarma web sürücüsünden

webdriver_manager.chrome'dan ChromeDriverManager'ı içe aktarın

selenium.webdriver.common.keys'den Anahtarları içe aktarın

#Selenyum Sürücüsümüzü kuruyoruz

sürücü = webdriver.Chrome(ChromeDriverManager().install())

#Google Hizmetlerine giriş yapmak için OUATH oyun alanı hesabına erişiyoruz

driver.get('https://accounts.google.com/o/oauth2/v2/auth/oauthchooseaccount?redirect_uri=https%3A%2F%2Fdevelopers.google.com%2Foauthplayground&prompt=consent&response_type=code&client_id=407408718usercontent192.apps .com&scope=email&access_type=offline&flowName=GeneralOAuthFlow')

#Xpath ile öğeleri seçmeden ve e-posta adresimizi tanıtmadan önce, oluşturma işleminin tamamlandığından emin olmak için biraz bekleriz.

zaman.uyku(10)

form1=driver.find_element_by_xpath('//*[@]')

form1.send_keys("<e-posta adresiniz>")

form1.send_keys(Keys.ENTER)

#Aynı burada biraz bekleyip ardından şifremizi giriyoruz.

zaman.uyku(10)

form2=driver.find_element_by_xpath('//*[@]/div[1]/div/div[1]/input')

form2.send_keys("<şifreniz>")

form2.send_keys(Keys.ENTER)

Bundan sonra Google Arama Konsolu URL'mize erişebiliriz:

driver.get('https://search.google.com/search-console?resource_id=alan_adiniz”')

zaman.uyku(5)

box=driver.find_element_by_xpath('/html/body/div[7]/div[2]/header/div[2]/div[2]/div[2]/form/div/div/div/div/div" /div[1]/input[2]')

box.send_keys("your_URL")

box.send_keys(Keys.ENTER)

zaman.uyku(5)

indeksleme = driver.find_element_by_xpath("/html/body/div[7]/c-wiz[2]/div/div[3]/span/div/div[2]/span/div[2]/div/div /div[1]/span/div[2]/div/c-wiz[2]/div[3]/span/div/span/span/div/span/span[1]")

indeksleme.tıklama()

zaman.uyku(120)

Ne yazık ki, giriş bölümünde açıklandığı gibi, bir dizi istekten sonra, dizin oluşturma isteğine devam etmek için bir bulmaca captcha gerektirmeye başladığı görülüyor. Otomatik yöntem captcha'yı çözemediğinden, bu, bu çözümü engelleyen bir şeydir.

1.1.2. Bir site haritasına ping atmak

Site Haritası URL'leri ping yöntemi ile Google'a gönderilebilir. Temel olarak, yalnızca aşağıdaki uç noktaya bir parametre olarak site haritası URL'nizi tanıtan bir istekte bulunmanız gerekir:

http://www.google.com/ping?sitemap=URL/of/file

Bu, bu makalede açıkladığım gibi Python ve isteklerle çok kolay bir şekilde otomatikleştirilebilir.

urllib.request'i içe aktar url = "http://www.google.com/ping?sitemap=https://www.example.com/sitemap.xml" yanıt = urllib.request.urlopen(url)

1.1.3. Google Dizine Ekleme API'sı

Google Dizine Ekleme API'si, tarama oranlarınızı iyileştirmek için iyi bir çözüm olabilir, ancak genellikle içeriğinizin dizine eklenmesini sağlamak için çok etkili bir yöntem değildir, çünkü yalnızca web sitenizde bir VideoObject'e gömülü JobPosting veya BroadcastEvent varsa kullanılması gerekir. Ancak siz de deneyip kendiniz test etmek isterseniz sonraki adımları takip edebilirsiniz.

Her şeyden önce, bu API'yi kullanmaya başlamak için Google Cloud Console'a gitmeniz, bir proje ve bir hizmet hesabı kimlik bilgisi oluşturmanız gerekir. Bundan sonra, Kitaplıktan Dizine Ekleme API'sini etkinleştirmeniz ve hizmet hesabı kimlik bilgileriyle birlikte verilen e-posta hesabını Google Search Console'da mülk sahibi olarak eklemeniz gerekir. Bu e-posta adresini mülk sahibi olarak ekleyebilmek için Google Search Console'un eski sürümünü kullanmanız gerekebilir.

Önceki adımları izledikten sonra, bir sonraki kod parçasını kullanarak bu API ile indeksleme ve indeksten arındırma talebinde bulunmaya başlayabileceksiniz:

oauth2client.service_account'tan ServiceAccountCredentials'ı içe aktarın

httplib2'yi içe aktar

KAPSAMLAR = [ "https://www.googleapis.com/auth/indexing" ]

ENDPOINT = "https://indexing.googleapis.com/v3/urlNotifications:yayınla"

client_secrets = "path_to_your_credentials.json"

kimlik bilgileri = ServiceAccountCredentials.from_json_keyfile_name(client_secrets, kapsamlar=KAPSAMLAR)

kimlik bilgileri Yok veya kimlik bilgileri.invalid ise:

kimlik bilgileri = araçlar.run_flow(akış, depolama)

http = kimlik bilgileri.yetkilendir(httplib2.Http())

list_urls = ["https://www.example.com", "https://www.example.com/test2/"]

aralıktaki yineleme için (len(list_urls)):

içerik = '''{

'url': "'''+str(list_urls[yineleme])+'''",

'tür': "URL_UPDATED"

}'''

yanıt, içerik = http.request(ENDPOINT, method="POST", body=content)

yazdır(yanıt)

yazdır(içerik)Dizin kaldırma talebinde bulunmak istiyorsanız, "URL_UPDATED" olan istek türünü "URL_DELETED" olarak değiştirmeniz gerekir. Önceki kod parçası, API'den gelen yanıtları bildirim süreleri ve durumları ile birlikte yazdıracaktır. Durum 200 ise, istek başarıyla yapılmış olacaktır.

1.2. Bing için

Çoğu zaman SEO hakkında konuştuğumuzda aklımıza yalnızca Google gelir, ancak bazı pazarlarda Bing gibi saygın bir pazar payına sahip başka baskın arama motorları ve/veya diğer arama motorları olduğunu unutamayız.

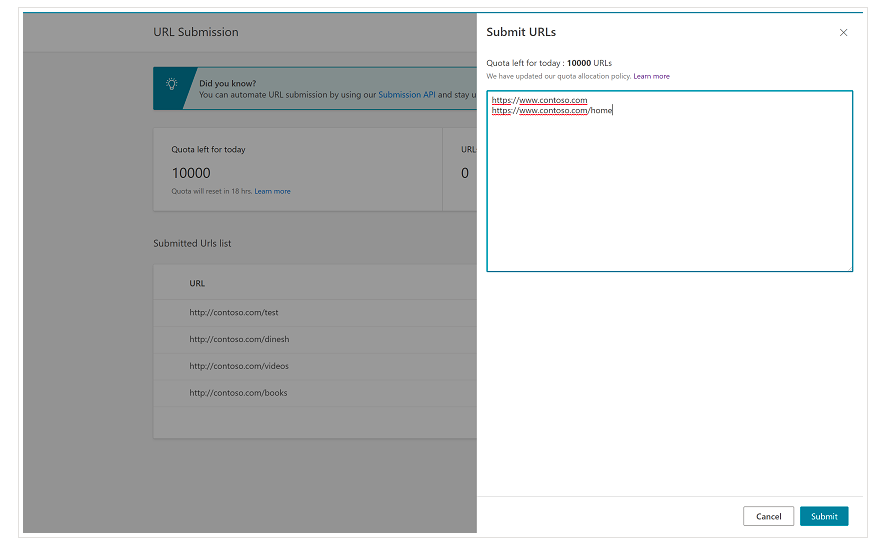

Bing'in, çoğu durumda günde 10.000'e kadar URL'nin gönderilmesini talep etmenizi sağlayan Bing Web Yöneticisi Araçları'nda zaten çok kullanışlı bir özelliğe sahip olduğunu baştan belirtmek önemlidir. Bazen günlük kotanız 10.000 URL'den daha düşük olabilir, ancak ihtiyaçlarınızı karşılamak için daha büyük bir kotaya ihtiyacınız olacağını düşünüyorsanız, bir kota artışı talep etme seçeneğiniz vardır. Bununla ilgili daha fazla bilgiyi bu sayfada okuyabilirsiniz.

URL'lerinizi Bing Web Yöneticisi Araçları'nın normal arayüzünden URL gönderme aracında yalnızca farklı satırlarda tanıtmanız gerekeceğinden, bu özellik gerçekten toplu URL gönderimleri için çok uygundur.

1.2.1. Bing Dizine Ekleme API'si

Bing Dizin Oluşturma API'si, parametre olarak tanıtılması gereken bir API anahtarıyla kullanılabilir. Bu API anahtarı, Bing Web Yöneticisi Araçları'nda API erişim bölümüne gidilerek ve ardından API anahtarı oluşturularak alınabilir.

API anahtarı alındıktan sonra, aşağıdaki kod parçasıyla API ile oynayabiliriz (yalnızca API anahtarınızı ve site URL'nizi eklemeniz gerekir):

içe aktarma istekleri

list_urls = ["https://www.example.com", "https://www.example/test2/"]

list_urls içindeki y için:

url = 'https://ssl.bing.com/webmaster/api.svc/json/SubmitUrlbatch?apikey=yourapikey'

myobj = '{"siteUrl":"https://www.example.com", "urlList":["'+ str(y) +'"]}'

headers = {'Content-type': 'application/json; karakter kümesi=utf-8'}

x = request.post(url, veri=myobj, başlıklar=başlıklar)

print(str(y) + ": " + str(x))Bu, URL'yi ve yanıt kodunu her yinelemede yazdıracaktır. Google İndeksleme API'sinin aksine, bu API her türlü web sitesi için kullanılabilir.

[Örnek Olay] Googlebot için web sitesi taranabilirliğini geliştirerek görünürlüğü artırın

2. Site Haritaları analizi, oluşturulması ve yüklenmesi

Hepimizin bildiği gibi site haritaları, arama motoru botlarına taramalarını istediğimiz URL'leri sağlamak için çok faydalı öğelerdir. Arama motoru botlarının site haritalarımızın nerede olduğunu bilmesini sağlamak için, bunların Google Arama Konsolu ve Bing Web Yöneticisi Araçları'na yüklenmesi ve geri kalan botlar için robots.txt dosyasına eklenmesi amaçlanmıştır.

Python ile site haritalarıyla ilgili temel olarak üç farklı yön üzerinde çalışabiliriz: bunların analizi, oluşturulması, yüklenmesi ve Google Arama Konsolundan silinmesi.

2.1. Python ile site haritası içe aktarma ve analizi

Advertools, Elias Dabbas tarafından oluşturulmuş, site haritası içe aktarma ve diğer birçok SEO görevi için kullanılabilen harika bir kitaplıktır. Aşağıdakileri kullanarak site haritalarını Veri Çerçevelerine aktarabilirsiniz:

sitemap_to_df('https://example.com/robots.txt', recursive=False)

Bu kitaplık, normal XML site haritalarını, haber site haritalarını ve video site haritalarını destekler.

Öte yandan, yalnızca URL'leri site haritasından içe aktarmakla ilgileniyorsanız, kitaplık isteklerini ve BeautifulSoup'u da kullanabilirsiniz.

içe aktarma istekleri

bs4'ten BeautifulSoup'u içe aktarın

r = request.get("https://www.example.com/your_sitemap.xml")

xml = r.metin

çorba = GüzelSoup(xml)

urls = çorba.find_all("loc")

urls = [[x.text] url'lerde x için]

Site haritası içe aktarıldıktan sonra, bu makaledeki Koray Tuğberk'in açıkladığı gibi, ayıklanan URL'ler ile oynayabilir ve bir içerik analizi yapabilirsiniz.

2.2. Python ile site haritaları oluşturma

JC Chouinard'ın bu makalede açıkladığı gibi, bir URL listesinden sitemaps.xml oluşturmak için Python'u da kullanabilirsiniz. Bu, özellikle URL'leri hızla değişen çok dinamik web siteleri için faydalı olabilir ve yukarıda açıklanan ping yöntemiyle birlikte, Google'a yeni URL'leri sağlamak ve hızlı bir şekilde taranmasını ve dizine eklenmesini sağlamak harika bir çözüm olabilir.

Yakın zamanda Greg Bernhardt, site haritaları oluşturmak için Streamlit ve Python ile bir APP oluşturdu.

2.3. Google Arama Konsolundan site haritalarını yükleme ve silme

Google Search Console, esas olarak iki farklı şekilde kullanılabilen bir API'ye sahiptir: web performansı hakkında veri çıkarmak ve site haritalarını işlemek için. Bu yazıda, site haritalarını yükleme ve silme seçeneğine odaklanacağız.

İlk olarak, bir OUATH kimlik bilgisi almak ve Google Arama Konsolu hizmetini etkinleştirmek için Google Cloud Console'dan mevcut bir proje oluşturmak veya kullanmak önemlidir. JC Chouinard, Python ile Google Arama Konsolu API'sine erişmek için izlemeniz gereken adımları ve ilk isteğinizi nasıl yapacağınızı bu yazıda çok iyi anlatıyor. Temel olarak onun kodunu tamamen kullanabiliriz ama sadece bir değişiklik yaparak kapsamlara “https://www.googleapis.com” yerine “https://www.googleapis.com/auth/webmasters” ekleyeceğiz. /auth/webmasters.readonly”, API'yi yalnızca site haritalarını okumak için değil aynı zamanda site haritalarını yüklemek ve silmek için kullanacağız.

API ile bağlantı kurduğumuzda, onunla oynamaya başlayabilir ve bir sonraki kod parçasıyla Google Arama Konsolu özelliklerimizdeki tüm site haritalarını listeleyebiliriz:

doğrulanmış_siteler_urls içindeki site_url için:

yazdır (site_url)

# Gönderilen site haritalarının listesini al

site haritaları = webmasters_service.sitemaps().list(siteUrl=site_url).execute()

site haritalarında 'site haritası' varsa:

sitemap_urls = [s['yol'] site haritalarındaki s için['site haritası']]

yazdır (" " + "\n ".join(sitemap_urls))

Belirli site haritaları söz konusu olduğunda, sonraki bölümlerde detaylandıracağımız üç görevi yerine getirebiliriz: yükleme, silme ve bilgi isteme.

2.3.1. Site haritası yükleme

Python ile bir site haritası yüklemek için yalnızca site URL'sini ve site haritası yolunu belirtmemiz ve bu kod parçasını çalıştırmamız gerekir:

WEB SİTESİ = 'sizinGSC mülkünüz' SITEMAP_PATH = 'https://www.example.com/page-sitemap.xml' webmasters_service.sitemaps().submit(siteUrl=WEBSITE, feedpath=SİTEMAP_PATH).execute()

2.3.2. Bir site haritasını silme

Madalyonun diğer yüzü, bir site haritasını silmek istediğimiz zamandır. Python ile Google Search Console'dan site haritalarını "gönder" yerine "sil" yöntemini kullanarak da silebiliriz.

WEB SİTESİ = 'sizinGSC mülkünüz' SITEMAP_PATH = 'https://www.example.com/page-sitemap.xml' webmasters_service.sitemaps().delete(siteUrl=WEBSITE, feedpath=SİTEMAP_PATH).execute()

2.3.3. Site haritalarından bilgi isteme

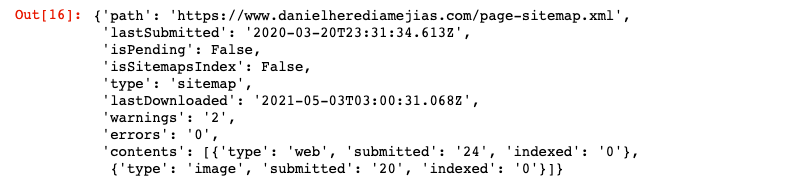

Son olarak “get” yöntemini kullanarak site haritasından da bilgi talep edebiliyoruz.

WEB SİTESİ = 'sizinGSC mülkünüz' SITEMAP_PATH = 'https://www.example.com/page-sitemap.xml' webmasters_service.sitemaps().get(siteUrl=WEBSITE, feedpath=SİTEMAP_PATH).execute()

Bu, aşağıdaki gibi JSON biçiminde bir yanıt döndürür:

3. Dahili bağlantı analizi ve fırsatlar

Uygun bir dahili bağlantı yapısına sahip olmak, arama motoru botlarının web sitenizi taramasını kolaylaştırmak için çok yararlıdır. Çok karmaşık teknik kurulumlara sahip bir dizi web sitesini denetlerken karşılaştığım ana sorunlardan bazıları şunlardır:

- Tıklama etkinlikleriyle tanıtılan bağlantılar: Kısacası, Googlebot düğmeleri tıklamaz, bu nedenle bağlantılarınız bir tıklama etkinliğiyle eklenirse Googlebot bunları izleyemez.

- İstemci tarafında oluşturulmuş bağlantılar: Googlebot ve diğer arama motorlarının JavaScript'i yürütmede çok daha iyi hale gelmesine rağmen, bu onlar için hala oldukça zorlayıcı bir şeydir, bu nedenle bu bağlantıları sunucu tarafında oluşturmak ve bunları ham HTML'de sunmak çok daha iyidir. JavaScript komut dosyalarını çalıştırmalarını beklemek yerine arama motoru botları.

- Oturum açma ve/veya yaş sınırı açılır pencereleri: oturum açma açılır pencereleri ve yaş kapıları, arama motoru botlarının bu "engellerin" arkasındaki içeriği taramasını engelleyebilir.

- Nofollow özniteliğinin aşırı kullanımı: Değerli dahili sayfalara işaret eden birçok nofollow özniteliğinin kullanılması, arama motoru botlarının bunları taramasını engelleyecektir.

- Noindex ve takip: teknik olarak noindex ve takip yönergelerinin birleşimi, arama motoru botlarının o sayfadaki bağlantıları taramasına izin vermelidir. Ancak görünen o ki, Googlebot bir süre sonra bu sayfaları noindex yönergeleriyle taramayı bırakıyor.

Python ile dahili bağlantı yapımızı analiz edebilir ve toplu modda yeni dahili bağlantı fırsatları bulabiliriz.

3.1. Python ile Dahili Bağlantı Analizi

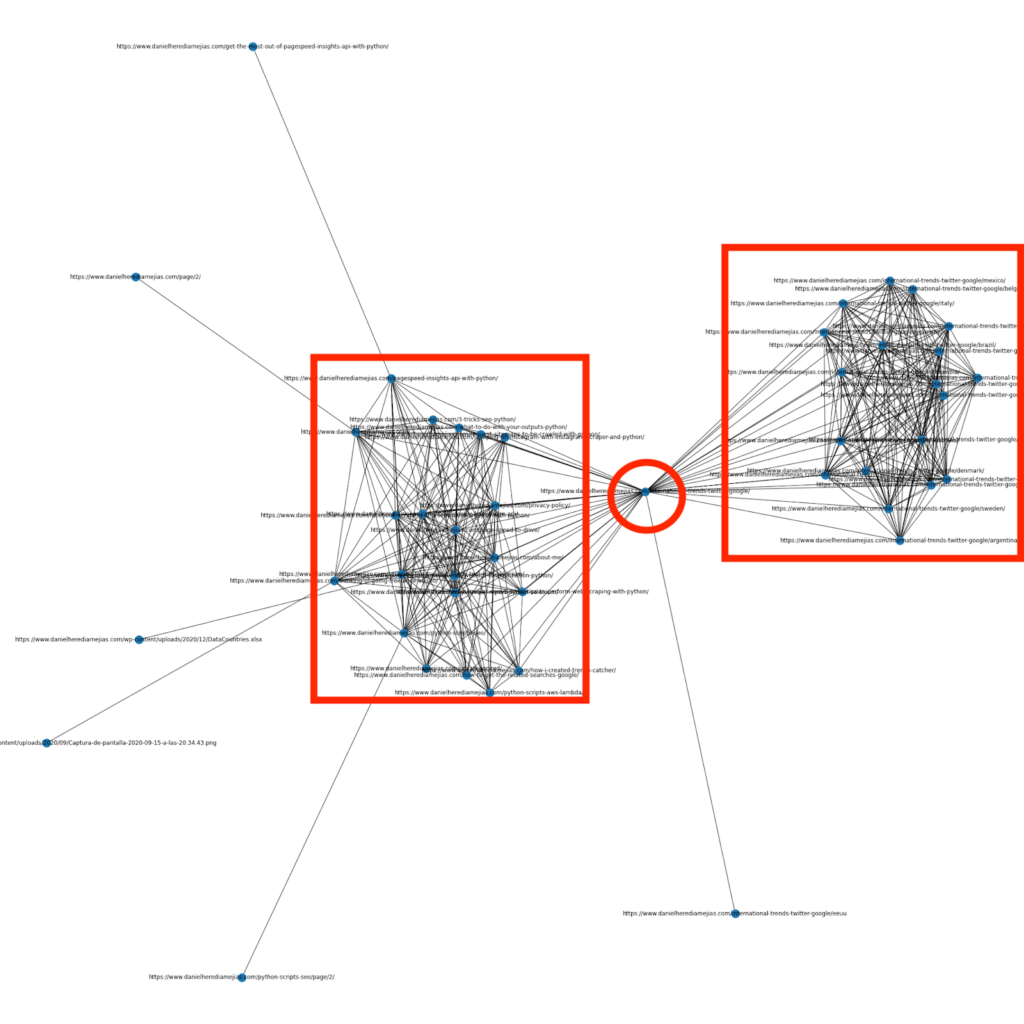

Birkaç ay önce, dahili bağlantı yapısını çok görsel bir şekilde görüntülemek için grafikler oluşturmak için Python ve Networkx kütüphanesinin nasıl kullanılacağı hakkında bir makale yazdım:

Bu, Screaming Frog'dan elde edebileceğinize çok benzer bir şeydir, ancak bu tür analizler için Python kullanmanın avantajı, temelde bu grafiklere dahil etmek istediğiniz verileri seçebilmeniz ve grafik öğelerinin çoğunu kontrol edebilmenizdir. renkler, düğüm boyutları ve hatta eklemek istediğiniz sayfalar gibi.

3.2. Python ile yeni dahili bağlantı fırsatları bulma

Site yapılarını analiz etmenin yanı sıra, bir dizi anahtar kelime ve URL sağlayarak ve içeriklerinde sağlanan terimleri arayan bu URL'ler üzerinde yineleme yaparak yeni dahili bağlantı fırsatları bulmak için Python'dan da yararlanabilirsiniz.

Bu, zaten anahtar kelimeler için sıralamada olan ve dolayısıyla zaten bir tür yetkiye sahip olan bazı sayfalardan güçlü bağlamsal dahili bağlantılar bulmak için Semrush veya Ahrefs dışa aktarma ile çok iyi çalışabilen bir şeydir.

Bu yöntem hakkında daha fazla bilgiyi buradan okuyabilirsiniz.

4. Website Speed, 5xx ve soft hata sayfaları

Google'ın, Google için tarama bütçesinin ne anlama geldiğiyle ilgili bu sayfada belirttiği gibi, sitenizi daha hızlı hale getirmek, kullanıcı deneyimini iyileştirir ve tarama hızını artırır. Öte yandan, geçici hata sayfaları, düşük kaliteli içerik ve sitede yinelenen içerik gibi tarama bütçesini etkileyebilecek başka faktörler de vardır.

4.1. Sayfa hızı ve Python

4.2.1 Python ile web sitenizin hızını analiz etme

Page Speed Insights API, web sitenizin sayfa hızı açısından nasıl performans gösterdiğini analiz etmek ve birçok farklı sayfa hızı metriği (neredeyse 50) artı Önemli Web Verileri hakkında çok sayıda veri elde etmek için çok kullanışlıdır.

Page Speed Insights ile Python ile çalışmak çok basittir, onu kullanmak için yalnızca bir API anahtarı ve istekler gereklidir. Örneğin:

urllib.request'i içe aktar, json url = "https://www.googleapis.com/pagespeedonline/v5/runPagespeed?url=your_URL&strategy=mobile&locale=tr&key=yourAPIKey" #URL'nizi parametre URL'si ile ekleyebileceğinizi ve verileri masaüstü için almak istiyorsanız cihaz parametresini de değiştirebileceğinizi unutmayın. yanıt = urllib.request.urlopen(url) veri = json.loads(response.read())

Ayrıca Python ve Lighthouse Puanlama hesaplayıcısı ile de bu makalede anlatıldığı gibi sayfa hızınızı artırmak için istenen değişiklikleri yapmanız durumunda genel performans puanınızın ne kadar artacağını tahmin edebilirsiniz.

4.2.2 Python ile Görüntü Optimizasyonu ve Yeniden Boyutlandırma

Web sitesi hızıyla ilgili olarak Python, Koray Tugberk ve Greg Bernhardt tarafından yazılan şu makalelerde açıklandığı gibi görüntüleri optimize etmek, sıkıştırmak ve yeniden boyutlandırmak için de kullanılabilir:

- FTP üzerinden Python ile Görüntü Sıkıştırmayı Otomatikleştirin.

- Resimleri Python ile Toplu Olarak Yeniden Boyutlandırın.

- SEO ve UX için Python aracılığıyla görüntüleri optimize edin.

4.2. Python ile 5xx ve diğer yanıt kodu hataları ayıklama

5xx yanıt kodu hataları, sunucunuzun aldığı tüm istekleri karşılayacak kadar hızlı olmadığının göstergesi olabilir. Bu, tarama hızınızı çok olumsuz etkileyebilir ve ayrıca kullanıcı deneyimine zarar verebilir.

Web sitenizin beklendiği gibi çalıştığından emin olmak için Python ve Selenium ile tarama istatistikleri raporunun indirilmesini otomatikleştirebilir ve günlük dosyalarınızı yakından takip edebilirsiniz.

4.3. Python ile yumuşak hata sayfaları çıkarma

Son zamanlarda, Jose Luis Hernando, Node.js ile kapsam raporu çıkarmayı nasıl otomatikleştirebileceğiniz hakkında Hamlet Batista'nın onuruna bir makale yayınladı. Bu, tarama hızınızı olumsuz yönde etkileyebilecek yumuşak hata sayfalarını ve hatta 5xx yanıt hatalarını ayıklamak için harika bir çözüm olabilir.

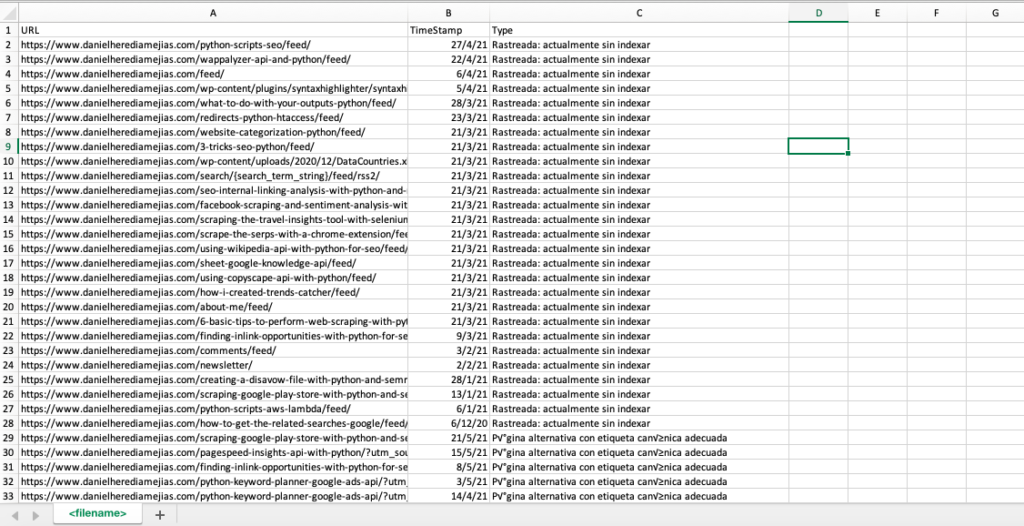

Google Search Console tarafından hatalı, uyarılarla geçerli, geçerli ve hariç tutulan tüm URL'leri tek bir Excel sekmesinde derlemek için aynı işlemi Python ile de çoğaltabiliriz.

Öncelikle bu yazımızda daha önce anlattığımız gibi Python ile Selenium ile Google Search Console'a giriş yapmamız gerekiyor. Bundan sonra, tüm URL durum kutularını seçeceğiz, sayfa başına 100 satıra kadar ekleyeceğiz ve GSC tarafından bildirilen tüm URL türleri üzerinde yinelemeye başlayacağız ve her bir Excel dosyasını indireceğiz.

ithalat zamanı

selenyum içe aktarma web sürücüsünden

webdriver_manager.chrome'dan ChromeDriverManager'ı içe aktarın

selenium.webdriver.common.keys'den Anahtarları içe aktarın

sürücü = webdriver.Chrome(ChromeDriverManager().install())

driver.get('https://accounts.google.com/o/oauth2/v2/auth/oauthchooseaccount?redirect_uri=https%3A%2F%2Fdevelopers.google.com%2Foauthplayground&prompt=consent&response_type=code&client_id=407408718usercontent192.apps .com&scope=email&access_type=offline&flowName=GeneralOAuthFlow')

zaman.uyku(5)

searchBox=driver.find_element_by_xpath('//*[@]')

searchBox.send_keys("<emailaddress>")

searchBox.send_keys(Keys.ENTER)

zaman.uyku(5)

searchBox=driver.find_element_by_xpath('//*[@]/div[1]/div/div[1]/input')

searchBox.send_keys("<parolanız>")

searchBox.send_keys(Keys.ENTER)

zaman.uyku(5)

etki alanınız = str(input("http mülkünüzü veya etki alanınızı buraya girin. Bu bir etki alanıysa şunları ekleyin: 'sc-domain':"))

driver.get('https://search.google.com/search-console/index?resource_https://search.google.com/search-console/index?resource_Tabla')

listvalues = [list_problems[x] for i in range(len(df1["URL"]))]

df1['Type'] = liste değerleri

list_results = df1.values.tolist()

başka:

df2 = pd.read_excel(alanınız.replace("sc-domain:","").replace("/","_").replace(":","_") + "-Kapsam-Drilldown-" + bugün + " (" + str(x) + ").xlsx", 'Tabla')

listvalues = [list_problems[x] for i in range(len(df2["URL"]))]

df2['Tür'] = liste değerleri

list_results = list_results + df2.values.tolist()

df = pd.DataFrame(list_results, column= ["URL","TimeStamp", "Type"])

df.to_csv('<dosyaadı>.csv', başlık=Doğru, indeks=Yanlış, kodlama = "utf-8")

Son çıktı şöyle görünür:

4.4. Python ile günlük dosyası analizi

Google Arama Konsolu'ndaki tarama istatistikleri raporunda bulunan verilerin yanı sıra, arama motoru botlarının web sitenizi nasıl taradığı hakkında daha fazla bilgi almak için Python kullanarak kendi dosyalarınızı da analiz edebilirsiniz. Halihazırda SEO için bir log analizörü kullanmıyorsanız, Python ile log analizinin anlatıldığı SEO Garden'daki bu makaleyi okuyabilirsiniz.

[Ebook] SEO Günlük Analizinden Yararlanmak İçin Dört Kullanım Örneği

5. Nihai sonuçlar

Python'un web sitelerimizin taranmasını ve dizine eklenmesini birçok farklı şekilde analiz etmek ve iyileştirmek için harika bir varlık olabileceğini gördük. Binlerce saatinizi alacak sıkıcı ve manuel görevlerin çoğunu otomatikleştirerek hayatı nasıl daha kolay hale getireceğimizi de gördük.

Ne yazık ki, daha iyi bir çözüm sunma korkusunu bir dereceye kadar anlayabilsem de, şu anda Google tarafından çok sayıda URL için indeksleme talep etmek için sunulan çözümlerle tam olarak ikna olmadığımı söylemeliyim: aşırı kullanmak için.

Bunun aksine, API aracılığıyla ve hatta Bing Web Yöneticisi Araçları'ndaki normal arayüz aracılığıyla URL dizine ekleme talebinde bulunmak için istisnai ve kullanışlı çözümler sunan Bing var.

Google indeksleme API'sinin geliştirilmeye açık olması nedeniyle, erişilebilir ve güncel bir site haritasına sahip olmak, dahili bağlantılarınız, sayfa hızınız, hafif hata sayfalarınız ve yinelenen ve düşük kaliteli içeriğiniz gibi diğer unsurlar, emin olmak için daha da önemli hale gelir. web sitenizin düzgün bir şekilde tarandığını ve en önemli sayfalarınızın dizine eklendiğini.