Web Sitelerinden Verimli Veri Çıkarma için En İyi 25 Web Tarama Aracı

Yayınlanan: 2023-06-15Web Tarama Araçlarına Giriş

Örümcekler veya web kazıyıcılar olarak da bilinen web tarama araçları, analiz ve veri madenciliği amacıyla web sitelerinden değerli veriler çıkarmak isteyen işletmeler için çok önemlidir. Bu araçlar, pazar araştırmasından arama motoru optimizasyonuna (SEO) kadar geniş bir uygulama yelpazesine sahiptir. Çeşitli kamu kaynaklarından veri toplarlar ve bunu yapılandırılmış ve kullanılabilir bir formatta sunarlar. Şirketler, web tarama araçlarını kullanarak haberleri, sosyal medyayı, görselleri, makaleleri, rakipleri ve çok daha fazlasını takip edebilir.

Web sitelerinden hızlı bir şekilde veri çıkarmak için En İyi 25 Web Tarama Aracı

hurda

Scrapy, geliştiricilerin ölçeklenebilir web tarayıcıları oluşturmasına olanak tanıyan popüler bir açık kaynaklı Python tabanlı web tarama çerçevesidir. Web tarayıcılarını uygulamayı ve web sitelerinden veri çıkarmayı kolaylaştıran kapsamlı bir dizi özellik sunar. Scrapy eşzamansızdır, yani istekleri birer birer değil, paralel olarak yapar ve verimli tarama sağlar. Köklü bir web tarama aracı olarak Scrapy, büyük ölçekli web kazıma projeleri için uygundur.

Ana Özellikler

- JSON, CSV ve XML gibi biçimlerde dışa aktarılan özet akışları oluşturur.

- XPath veya CSS ifadeleri ile kaynaklardan veri seçmek ve ayıklamak için yerleşik desteğe sahiptir.

- Örümcekleri kullanarak web sayfalarından otomatik olarak veri çıkarılmasına izin verir.

- Ölçeklenebilir ve hataya dayanıklı mimarisiyle hızlı ve güçlüdür .

- Bir eklenti sistemi ve zengin bir API ile kolayca genişletilebilir .

- Taşınabilirdir , Linux, Windows, Mac ve BSD üzerinde çalışır.

Fiyatlandırma

- Ücretsiz bir araçtır.

Ayrıştırma Merkezi

ParseHub, AJAX teknolojisi, JavaScript, tanımlama bilgileri ve daha fazlasını kullanan web sitelerinden veri toplayabilen bir web tarama aracıdır. Makine öğrenimi teknolojisi, web belgelerini okuyabilir, analiz edebilir ve ardından ilgili verilere dönüştürebilir. ParseHub'ın masaüstü uygulaması Windows, Mac OS X ve Linux işletim sistemlerini destekler. Kullanıcı dostu bir arayüz sunan ParseHub, programcı olmayan ve web sitelerinden veri çıkarmak isteyen kişiler için tasarlanmıştır.

Ana Özellikler

- AJAX, JavaScript, sonsuz kaydırma, sayfalandırma, açılır menüler, girişler ve diğer öğeleri kullanan dinamik web sitelerini kazıyabilir.

- Kullanımı kolaydır ve kodlama becerisi gerektirmez.

- Bulut tabanlıdır ve sunucularında veri depolayabilir.

- IP rotasyonunu , zamanlanmış toplamayı , düzenli ifadeleri , API'yi ve web kancalarını destekler.

- Verileri JSON ve Excel formatlarında dışa aktarabilir.

Fiyatlandırma

- ParseHub'ın hem ücretsiz hem de ücretli planları vardır. Ücretli planların fiyatları aylık 149 dolardan başlar ve yükseltilmiş proje hızları, çalıştırma başına kazınan sayfa sayısında daha yüksek bir sınır ve daha fazla proje oluşturma yeteneği sunar.

ahtapot

Octoparse, kullanıcıların web verilerini kodlamaya ihtiyaç duymadan elektronik tablolara çıkarmalarına olanak tanıyan, istemci tabanlı bir web tarama aracıdır. İşaretle ve tıkla arabirimiyle Octoparse, kodlayıcı olmayanlar için özel olarak oluşturulmuştur. Kullanıcılar, herhangi bir web sitesinden veri toplamak için kendi web tarayıcılarını oluşturabilir ve Octoparse, Amazon, eBay ve Twitter gibi popüler web siteleri için önceden oluşturulmuş kazıyıcılar sağlar. Araç ayrıca planlanmış bulut çıkarma, veri temizleme ve IP proxy sunucularıyla engellemeyi atlama gibi gelişmiş özellikler sunar.

Ana Özellikler

- İşaretle ve tıkla arayüzü : Kazımak istediğiniz web öğelerini üzerlerine tıklayarak kolayca seçebilirsiniz ve Octoparse otomatik olarak veri modellerini belirleyecek ve verileri sizin için çıkaracaktır.

- Gelişmiş mod : Metin girme, düğmelere tıklama, sayfaları kaydırma, listeler arasında gezinme vb. gibi çeşitli eylemlerle kazıma görevlerinizi özelleştirebilirsiniz. Verileri tam olarak bulmak için XPath veya RegEx'i de kullanabilirsiniz.

- Bulut hizmeti : Scraping görevlerinizi Octoparse'ın bulut sunucularında 7/24 çalıştırabilir, verilerinizi bulut platformunda saklayabilirsiniz. Ayrıca, web siteleri tarafından engellenmemek için görevlerinizi planlayabilir ve otomatik IP rotasyonunu kullanabilirsiniz.

- API : Verilerinize API üzerinden erişebilir ve diğer uygulama veya platformlarla entegre edebilirsiniz. Ayrıca Octoparse ile herhangi bir veriyi özel API'lere dönüştürebilirsiniz.

Fiyatlandırma

- Hem ücretsiz hem de ücretli planları var. Ücretli planlar ayda 89 dolardan başlıyor.

WebHarvy

WebHarvy, programcı olmayanlar için tasarlanmış, tıkla ve tıkla web kazıma yazılımıdır. Web sitelerinden metin, resim, URL ve e-postaları otomatik olarak kazıyabilir ve bunları XML, CSV, JSON veya TSV gibi çeşitli biçimlerde kaydedebilir. WebHarvy, hedef web sitelerine erişmek için proxy sunucuları veya VPN hizmetlerini kullanarak anonim taramayı ve dinamik web sitelerini yönetmeyi de destekler.

Ana Özellikler

- Kodlama veya komut dosyası oluşturmadan veri seçmek için işaretle ve tıkla arabirimi

- Otomatik tarama ve kazıma ile çok sayfalı madencilik

- Benzer sayfalardan veya listelerden veri kazımak için kategori kazıma

- E-ticaret sitelerinin ürün detay sayfalarından görsel indirme

- Ekstra yapılandırma olmadan kazıma listeleri veya tabloları için otomatik model algılama

- Giriş anahtar sözcüklerini arama formlarına göndererek anahtar sözcük tabanlı ayıklama

- Kazıma üzerinde daha fazla esneklik ve kontrol için normal ifadeler

- Bağlantıları tıklama, seçenekleri belirleme, kaydırma ve daha fazlası gibi görevleri gerçekleştirmek için otomatik tarayıcı etkileşimi

Fiyatlandırma

- WebHarvy, bir kerelik lisans ücreti olan bir web kazıma yazılımıdır.

- Lisans fiyatları bir yıl için 139 dolardan başlıyor.

güzel çorba

Beautiful Soup, HTML ve XML belgelerini ayrıştırmak için kullanılan açık kaynaklı bir Python kitaplığıdır. Web'den veri çıkarmayı kolaylaştıran bir ayrıştırma ağacı oluşturur. Scrapy kadar hızlı olmasa da, Güzel Çorba esas olarak kullanım kolaylığı ve sorunlar ortaya çıktığında topluluk desteği nedeniyle övülür.

Ana Özellikler

- Ayrıştırma : Beautiful Soup'u farklı türde web belgelerini ayrıştırmak için html.parser, lxml, html5lib vb. gibi çeşitli ayrıştırıcılarla birlikte kullanabilirsiniz.

- Gezinme : Ayrıştırma ağacında find(), find_all(), select(), .children, .parent, .next_sibling vb. Pythonic yöntemlerini ve niteliklerini kullanarak gezinebilirsiniz.

- Arama : İstediğiniz öğeleri bulmak için etiket adları, nitelikler, metin, CSS seçiciler, normal ifadeler vb. gibi filtreleri kullanarak ayrıştırma ağacında arama yapabilirsiniz.

- Değiştirme : Öğeleri ve niteliklerini ekleyerek, silerek, değiştirerek veya düzenleyerek ayrıştırma ağacını değiştirebilirsiniz.

Fiyatlandırma

Beautiful Soup, pip kullanarak kurabileceğiniz ücretsiz ve açık kaynaklı bir kitaplıktır.

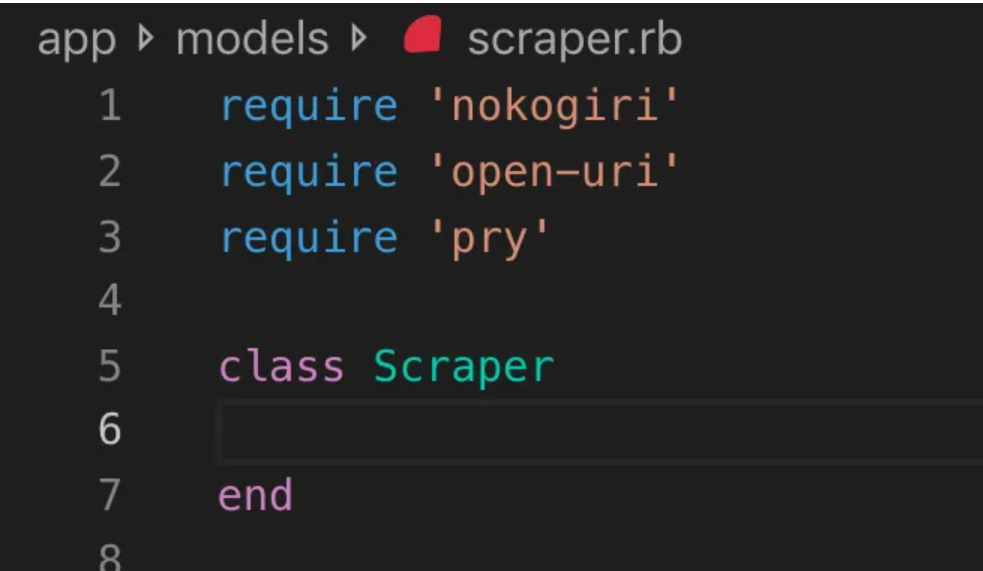

Nokogiri

Nokogiri, web geliştirmede yeni başlayanlar için uygun bir programlama dili olan Ruby'yi kullanarak HTML ve XML belgelerini ayrıştırmayı kolaylaştıran bir web tarama aracıdır. Nokogiri, C'nin libxml2'si ve Java'nın xerces'i gibi yerel ayrıştırıcılara güvenir ve bu da onu web sitelerinden veri ayıklamak için güçlü bir araç haline getirir. Ruby tabanlı bir web tarama kitaplığıyla çalışmak isteyen web geliştiricileri için çok uygundur.

Ana Özellikler

- XML, HTML4 ve HTML5 için DOM Ayrıştırıcı

- XML ve HTML4 için SAX Ayrıştırıcı

- XML ve HTML4 için Ayrıştırıcıyı İtin

- XPath 1.0 aracılığıyla belge arama

- Bazı jquery benzeri uzantılarla CSS3 seçicileri aracılığıyla belge arama

- XSD Şema doğrulaması

- XSLT dönüşümü

- XML ve HTML belgeleri için "Builder" DSL

Fiyatlandırma

- Nokogiri, kullanımı ücretsiz olan açık kaynaklı bir projedir.

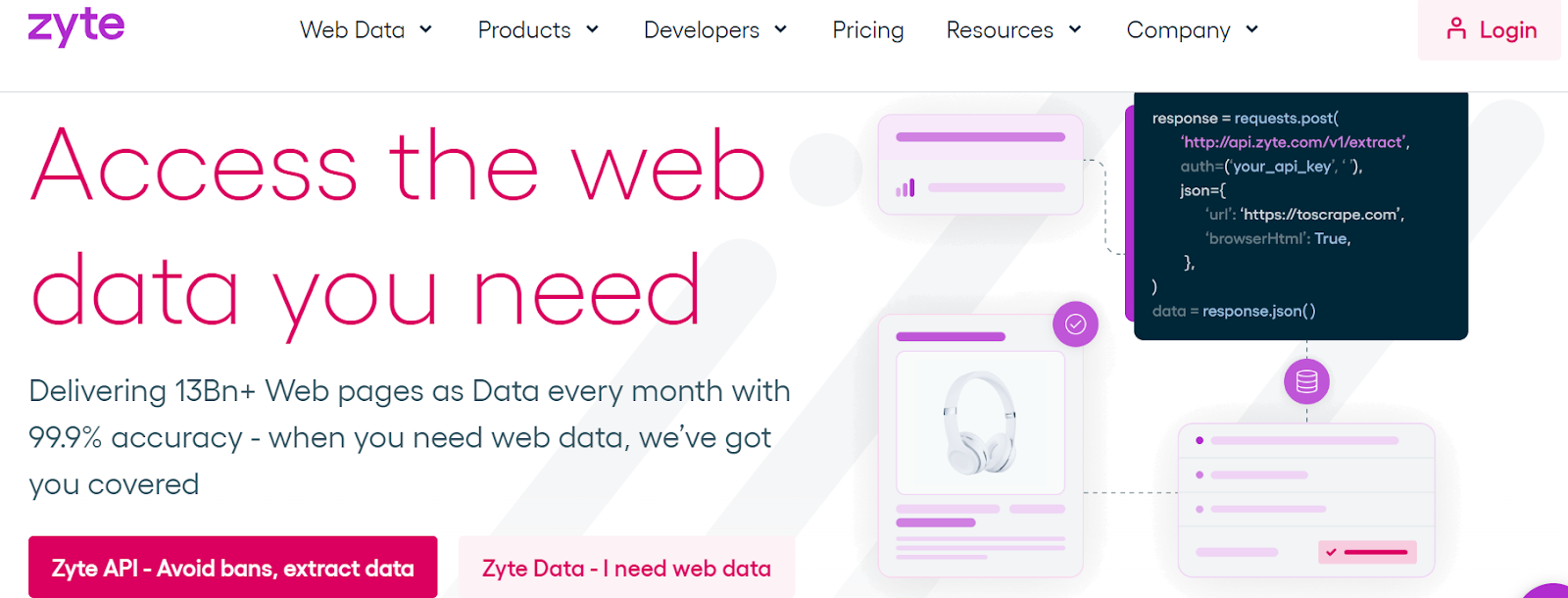

Zyte (Eski adıyla Scrapinghub)

Zyte (eski adıyla Scrapinghub), binlerce geliştiricinin web sitelerinden değerli veriler almasına yardımcı olan bulut tabanlı bir veri çıkarma aracıdır. Açık kaynaklı görsel kazıma aracı, kullanıcıların herhangi bir programlama bilgisi olmadan web sitelerini kazımasına olanak tanır. Zyte, büyük veya bot korumalı siteleri kolayca taramak için bot karşı önlemlerini atlamayı destekleyen akıllı bir proxy döndürücü olan Crawlera'yı kullanır ve kullanıcıların basit bir HTTP API aracılığıyla proxy yönetimi sıkıntısı yaşamadan birden fazla IP'den ve konumdan tarama yapmasına olanak tanır.

Ana Özellikler

- İsteğe bağlı veriler: Zyte'a web sitelerini ve veri gereksinimlerini sağlayın ve Zyte, istenen verileri programınıza göre teslim eder.

- Zyte AP I: En verimli proxy ve ayıklama yapılandırmasını kullanarak web sitelerinden HTML'yi otomatik olarak getirir ve teknik kaygılar olmadan verilere odaklanmanıza olanak tanır.

- Scrapy Cloud : Scrapy örümcekleriniz için, tarayıcılarınızı yönetmek, izlemek ve kontrol etmek için kullanıcı dostu bir web arayüzü içeren, izleme, günlük kaydı ve veri QA araçlarıyla tamamlanan ölçeklenebilir barındırma.

- Otomatik veri çıkarma API'sı : Zyte'ın yapay zeka destekli ayıklama API'si aracılığıyla web verilerine anında erişin ve hızlı bir şekilde kaliteli yapılandırılmış veriler sağlayın. Bu patentli teknoloji ile yeni kaynakların eklenmesi daha kolay hale gelir.

Fiyatlandırma

Zyte, ihtiyacınız olan verilerin karmaşıklığına ve hacmine bağlı olarak esnek bir fiyatlandırma modeline sahiptir. Üç plan arasından seçim yapabilirsiniz:

- Geliştirici: 250.000 istek için ayda 49 ABD doları

- İşletme: 2 milyon istek için ayda 299 ABD doları

- Kurumsal: 10 milyondan fazla istek için özel fiyatlandırma

- Ayda 10.000 istekle Zyte'yi ücretsiz olarak da deneyebilirsiniz.

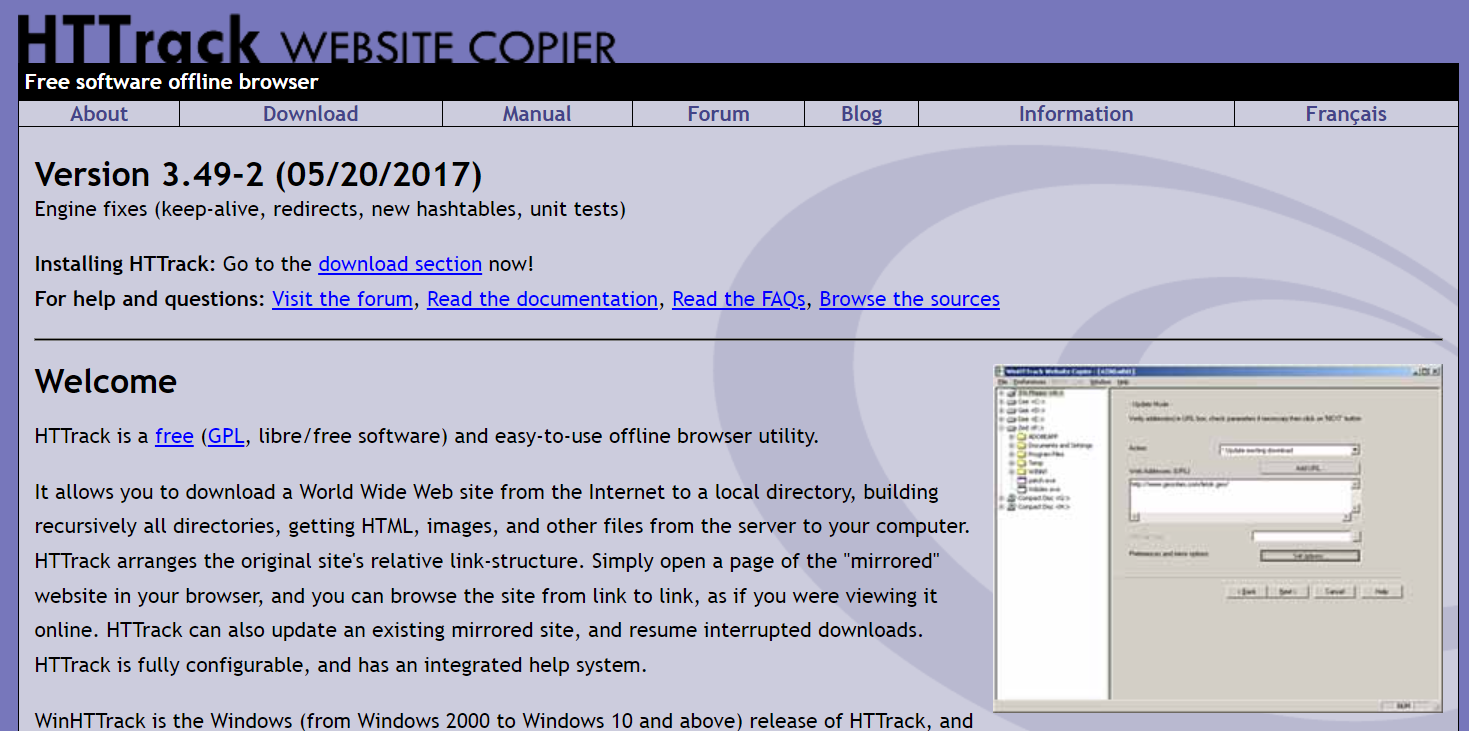

HTTrack

HTTrack, kullanıcıların çevrimdışı tarama için tüm web sitelerini veya belirli web sayfalarını yerel cihazlarına indirmelerine olanak tanıyan ücretsiz ve açık kaynaklı bir web tarama aracıdır. Bir komut satırı arabirimi sunar ve Windows, Linux ve Unix sistemlerinde kullanılabilir.

Ana Özellikler

- Orijinal sitenin ilgili bağlantı yapısını korur.

- Mevcut bir yansıtılmış siteyi güncelleyebilir ve kesintiye uğrayan indirmeleri devam ettirebilir.

- Tamamen yapılandırılabilir ve entegre bir yardım sistemine sahiptir.

- Windows, Linux, OSX, Android vb. gibi çeşitli platformları destekler.

- Bir komut satırı sürümüne ve bir grafik kullanıcı arabirimi sürümüne sahiptir.

Fiyatlandırma

- HTTrack, GNU GPL kapsamında lisanslanan ücretsiz bir yazılımdır.

apaçi somunu

Apache Nutch, genellikle veri analizi gibi alanlarda kullanılan genişletilebilir, açık kaynaklı bir web tarayıcısıdır. İçeriği HTTPS, HTTP veya FTP gibi protokoller aracılığıyla getirebilir ve metin bilgilerini HTML, PDF, RSS ve ATOM gibi belge biçimlerinden çıkarabilir.

Ana Özellikler

- Büyük veri hacimlerini toplu olarak işlemek için harika olan Apache Hadoop veri yapılarını temel alır.

- Geliştiricilerin medya tipi ayrıştırma, veri alma, sorgulama ve kümeleme için eklentiler oluşturmasına izin veren oldukça modüler bir mimariye sahiptir.

- Windows, Linux, OSX, Android vb. gibi çeşitli platformları destekler.

- Bir komut satırı sürümüne ve bir grafik kullanıcı arabirimi sürümüne sahiptir.

- Ayrıştırma için Apache Tika, indeksleme için Apache Solr ve Elasticsearch ve depolama için Apache HBase ile entegre olur.

Fiyatlandırma

- Apache Nutch, Apache License 2.0 altında lisanslanan ücretsiz bir yazılımdır.

Helyum Kazıyıcı

Helium Scraper, kodlamaya ihtiyaç duymadan kullanıcılar tarafından özelleştirilebilen ve kontrol edilebilen görsel bir web veri tarama aracıdır. Proxy döndürme, hızlı ayıklama gibi gelişmiş özellikler ve Excel, CSV, MS Access, MySQL, MSSQL, XML veya JSON gibi birden çok veri biçimini destekler.

Ana Özellikler

- Hızlı Çıkarma : Çıkarma görevlerini otomatik olarak ayrı tarayıcılara devredin

- Büyük Veri : SQLite veritabanı 140 terabayta kadar tutabilir

- Veritabanı Oluşturma : Çıkarılan verilere dayalı olarak tablo ilişkileri oluşturulur

- SQL Oluşturma : Dışa aktarma veya giriş verileri için tabloları hızla birleştirin ve filtreleyin

- API Çağrısı : Web kazıma ve API çağrısını tek bir projeye entegre edin

- Metin Manipülasyonu : Ayıklanan metni eşleştirmek, bölmek veya değiştirmek için işlevler oluşturun

- JavaScript Desteği: Herhangi bir web sitesine özel JavaScript kodu enjekte edin ve çalıştırın

- Proxy Döndürme : Bir proxy listesi girin ve herhangi bir aralıkta döndürün

- Benzer Eleman Tespiti : Bir veya iki numuneden benzer elementleri tespit eder

- Liste Algılama : Web sitelerindeki listeleri ve tablo satırlarını otomatik olarak algıla

- Veri Dışa Aktarma : Verileri CSV, Excel, XML, JSON veya SQLite'a aktarın

- Zamanlama : Komut satırından veya Windows Görev Zamanlayıcı'dan başlatılabilir

Fiyatlandırma

- Temel lisans, kullanıcı başına 99 ABD dolarıdır.

İçerik Yakalayıcı (Sequentum)

Content Grabber, işletmeleri hedef alan ve kullanıcıların bağımsız web tarama aracıları oluşturmasına olanak tanıyan bir web tarama yazılımıdır. Üçüncü taraf veri analitiği veya raporlama uygulamalarıyla entegrasyon, güçlü betik düzenleme ve hata ayıklama arabirimleri ve verileri Excel raporlarına, XML'e, CSV'ye ve çoğu veritabanına dışa aktarma desteği gibi gelişmiş özellikler sunar.

Ana Özellikler

- Kullanımı kolay işaretle ve tıkla arayüzü : HTML öğelerine dayalı eylemleri otomatik olarak algıla

- Sağlam API : Mevcut veri boru hatlarıyla kolay sürükle ve bırak entegrasyonunu destekler

- Özelleştirme : Kazıma aracılarınızı Python, C#, JavaScript, Normal İfadeler gibi yaygın kodlama dilleriyle özelleştirin

- Entegrasyon : Veri zenginleştirme için üçüncü taraf yapay zeka, makine öğrenimi, NLP kitaplıkları veya API'leri entegre edin

- Güvenilirlik ve Ölçek : Uçtan uca operasyonların gerçek zamanlı izlenmesinin keyfini çıkarırken altyapı maliyetlerini düşük tutun

- Yasal Uyumluluk : Yükümlülüklerinizi azaltın ve masraflı davalar ve düzenleyici cezalarla ilişkili riski azaltın

- Veri Dışa Aktarma : Verileri herhangi bir formatta dışa aktarın ve herhangi bir uç noktaya teslim edin

- Zamanlama : Kazıma aracılarınızı komut satırından veya Windows Görev Zamanlayıcı'dan başlatın

Fiyatlandırma

- Temel lisansın yıllık maliyeti 27.500 ABD dolarıdır ve yazılımı bir bilgisayarda kullanmanıza izin verir.

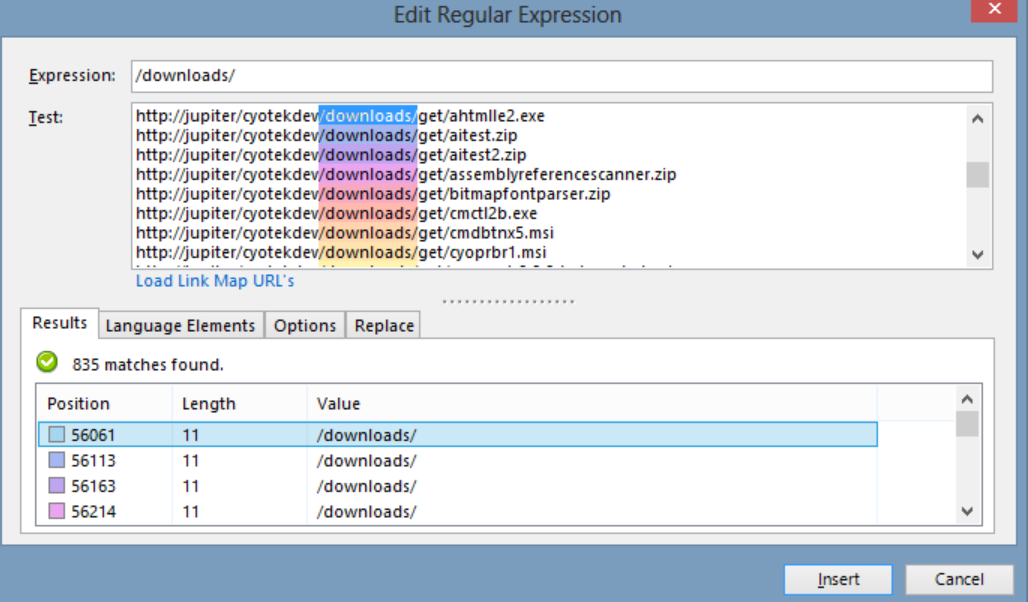

Cyotek WebKopyası

Cyotek WebCopy, kullanıcıların çevrimdışı referans için kısmi veya tam web sitelerini yerel olarak sabit disklerine kopyalamalarına izin veren ücretsiz bir web sitesi tarayıcısıdır. Bir web sitesindeki bağlantıları algılayıp izleyebilir ve yerel yolla eşleştirmek için bağlantıları otomatik olarak yeniden eşleyebilir. Ancak WebCopy, sanal bir DOM veya herhangi bir JavaScript ayrıştırma biçimi içermez, bu nedenle yoğun JavaScript kullanımı nedeniyle dinamik web sitesi düzenlerini doğru şekilde işlemeyebilir.

Ana Özellikler

- HTML öğelerini temel alan otomatik eylem algılamalı, kullanımı kolay işaretle ve tıkla arayüzü

- Basit sürükle ve bırak işlevi aracılığıyla mevcut veri boru hatlarıyla sorunsuz entegrasyon için sağlam API

- Kazıma aracılarını belirli ihtiyaçlara uyarlamak için Python, C#, JavaScript ve Normal İfadeler gibi popüler kodlama dillerini kullanan özelleştirme seçenekleri

- Kazınmış verileri zenginleştirmek için üçüncü taraf yapay zeka, makine öğrenimi, NLP kitaplıkları veya API'lerle entegrasyon yetenekleri

- Uygun maliyetli operasyonlar için gerçek zamanlı izleme ile güvenilir ve ölçeklenebilir altyapı

- Sorumluluğu azaltmak ve dava ve düzenleyici para cezaları riskini azaltmak için yasal uyumluluk özellikleri

- İstenilen herhangi bir formatta veri aktarımı ve çeşitli uç noktalara teslimat

- Zamanlama seçenekleri, kazıma aracılarının komut satırından veya Windows Görev Zamanlayıcı'dan başlatılmasına izin verir

Fiyatlandırma

- Temel lisansın yıllık maliyeti 27.500 ABD dolarıdır ve yazılımı bir bilgisayarda kullanmanıza izin verir.

80 bacak

80legs, özelleştirilmiş gereksinimlere göre yapılandırılabilen güçlü bir web tarama aracıdır. Ayıklanan verileri anında indirme seçeneğiyle birlikte büyük miktarda verinin alınmasını destekler. Araç, kullanıcıların tarayıcı oluşturması, verileri yönetmesi ve daha fazlası için bir API sunar. Ana özelliklerinden bazıları, kazıyıcı özelleştirme, web kazıma istekleri için IP sunucuları ve web taramalarını özel davranışlarla yapılandırmak için JS tabanlı bir uygulama çerçevesi içerir.

Ana Özellikler

- Ölçeklenebilir ve hızlı : Eşzamanlı 50.000'den fazla istekle günde 2 milyara kadar sayfayı tarayabilirsiniz.

- Esnek ve özelleştirilebilir: Tarama mantığını ve veri ayıklamayı kontrol etmek için kendi kodunuzu kullanabilir veya yerleşik araçları ve şablonları kullanabilirsiniz.

Fiyatlandırma

- 100.000 URL/tarama için 29$/ay'dan 10 milyon URL/tarama için 299$/ay'a kadar ihtiyaçlarınıza göre farklı fiyatlandırma planları arasından seçim yapabilirsiniz.

Webhose.io

Webhose.io, kullanıcıların dünyanın her yerinden çevrimiçi kaynakları tarayarak ve çeşitli temiz biçimlerde sunarak gerçek zamanlı veriler elde etmelerini sağlar. Bu web gezgini aracı, geniş bir kaynak dizisini kapsayan çoklu filtreler kullanarak verileri tarayabilir ve farklı dillerdeki anahtar kelimeleri daha fazla ayıklayabilir. Kullanıcılar, kazınmış verileri XML, JSON ve RSS formatlarında kaydedebilir ve geçmiş verilerine Arşivinden erişebilir. Webhose.io, tarama veri sonuçlarıyla 80'e kadar dili destekleyerek, kullanıcıların araç tarafından taranan yapılandırılmış verileri kolayca dizine eklemesine ve aramasına olanak tanır.

Ana Özellikler

- Birden çok biçim : Verileri XML, JSON, RSS veya Excel biçimlerinde alabilirsiniz.

- Yapılandırılmış sonuçlar : İhtiyaçlarınıza göre normalleştirilmiş, zenginleştirilmiş ve kategorize edilmiş veriler elde edebilirsiniz.

- Geçmiş veriler : Son 12 ay veya daha fazlasına ait arşivlenmiş verilere erişebilirsiniz.

- Geniş kapsam : 80 dilde ve 240 ülkede bir milyondan fazla kaynaktan veri alabilirsiniz.

- Çeşitli kaynaklar : Haber sitelerinden, bloglardan, forumlardan, mesaj panolarından, yorumlardan, incelemelerden ve daha fazlasından veri alabilirsiniz.

- Hızlı entegrasyon : Webhose.io'yu basit bir REST API ile dakikalar içinde sistemlerinize entegre edebilirsiniz.

Fiyatlandırma

- Ayda ücretsiz olarak 1000 istekte bulunmanıza izin veren ücretsiz bir planı vardır. Ayrıca, bir fiyat teklifi için onlarla iletişime geçebileceğiniz özel planları da vardır.

Mozenda

Mozenda, kullanıcıların tek bir kod satırı yazmadan web verilerini çıkarmalarına olanak tanıyan bulut tabanlı bir web kazıma yazılımıdır. Veri çıkarma sürecini otomatikleştirir ve programlanmış veri çıkarma, veri temizleme ve IP proxy sunucuları ile engellemeyi atlama gibi özellikler sunar. Mozenda, kullanıcı dostu arayüzü ve güçlü kazıma yetenekleriyle işletmeler için tasarlanmıştır.

Ana Özellikler

- Metin analizi: Doğal dil işleme tekniklerini kullanarak herhangi bir web sitesinden metin verilerini çıkarabilir ve analiz edebilirsiniz.

- Görüntü çıkarma: Web sayfalarından görüntüleri indirip kaydedebilir veya boyut, biçim, çözünürlük vb. görüntü meta verilerini çıkarabilirsiniz.

- Farklı veri toplama: HTML, XML, JSON, RSS vb. gibi birden çok kaynaktan ve biçimden veri toplayabilirsiniz.

- Belge çıkarma: Optik karakter tanıma (OCR) veya metin çıkarma yöntemlerini kullanarak PDF, Word, Excel ve diğer belge türlerinden veri çıkarabilirsiniz.

- E-posta adresi çıkarma : Normal ifadeler veya model eşleştirme kullanarak web sayfalarından veya belgelerden e-posta adreslerini bulabilir ve çıkarabilirsiniz.

Fiyatlandırma

- Ücretli plan ayda 99 dolardan başlıyor.

UiPath

UiPath, ücretsiz web kazıma için bir robotik süreç otomasyonu (RPA) yazılımıdır. Çoğu üçüncü taraf uygulamasından web ve masaüstü verilerini taramayı otomatikleştirir. Windows ile uyumlu olan UiPath, birden çok web sayfasındaki tablo ve desen tabanlı verileri çıkarabilir. Yazılım ayrıca karmaşık kullanıcı arabirimlerini daha fazla taramak ve işlemek için yerleşik araçlar sunar.

Ana Özellikler

- Metin analizi : E-posta adresi çıkarma gibi görevler için doğal dil işleme, normal ifadeler ve kalıp eşleştirmeyi kullanarak metin verilerini ayıklayın ve analiz edin.

- Görüntü çıkarma : Web sayfalarından görüntüleri indirin ve kaydedin, boyut, biçim ve çözünürlük dahil olmak üzere görüntü meta verilerini çıkarın.

- Farklı veri toplama : Diğer çevrimiçi hizmetlere ve API'lere bağlanmak için entegrasyon yetenekleriyle HTML, XML, JSON, RSS gibi çeşitli kaynaklardan ve biçimlerden veri toplayın.

- Belge çıkarma : OCR veya metin çıkarma yöntemlerini kullanarak PDF, Word, Excel ve diğer belge türlerinden veri çıkarın. Belge anlama özellikleriyle farklı belge türlerinde ve yapılarında bilgileri işleyin ve çıkarın.

- Web otomasyonu : Oturum açma, sayfalar arasında gezinme, form doldurma, düğmelere tıklama gibi web tabanlı etkinlikleri otomatikleştirin. Eylemleri yakalamak ve otomasyon komut dosyaları oluşturmak için kaydedici özelliğini kullanın.

Fiyatlandırma

- ücretli plan ayda 420 dolardan başlıyor.

OutWit Merkezi

OutWit Hub, kullanıcıların web aramalarını kolaylaştırmak için düzinelerce veri çıkarma özelliğine sahip bir Firefox eklentisidir. Bu web gezgini aracı, sayfalara göz atabilir ve ayıklanan bilgileri uygun bir biçimde saklayabilir. OutWit Hub, ihtiyaç başına küçük veya çok büyük miktarda veriyi ayıklamak için tek bir arayüz sunar ve çeşitli web sitelerinden birkaç dakika içinde veri çıkarmak için otomatik aracılar oluşturabilir.

Ana Özellikler

- Web içeriğini görüntüleyin ve dışa aktarın: Bir web sayfasında bulunan bağlantıları, belgeleri, görüntüleri, kişileri, veri tablolarını, RSS beslemelerini, e-posta adreslerini ve diğer öğeleri görüntüleyebilirsiniz. Ayrıca bunları HTML, SQL, CSV, XML, JSON veya diğer biçimlerde dışa aktarabilirsiniz.

- Verileri tablolarda ve listelerde düzenleyin: Tablolarda ve listelerde topladığınız verileri sıralayabilir, filtreleyebilir, gruplandırabilir ve düzenleyebilirsiniz. Ayıklamak istediğiniz verileri seçmek için birden fazla kriter de kullanabilirsiniz.

- Otomatik işlevler kurun : Basit veya gelişmiş komutlar kullanarak herhangi bir web sitesinden veri çıkarabilen özel kazıyıcılar oluşturmak için kazıyıcı özelliğini kullanabilirsiniz. Web'de gezinme ve kazıma görevlerini otomatikleştirmek için makro özelliğini de kullanabilirsiniz.

- Sorgular ve URL'ler oluşturun: Anahtar sözcüklere veya kalıplara dayalı sorgular oluşturmak için sorgu özelliğini kullanabilirsiniz. Kalıplara veya parametrelere dayalı olarak URL'ler oluşturmak için URL özelliğini de kullanabilirsiniz.

Fiyatlandırma

- Light lisansı ücretsizdir ve tamamen çalışır durumdadır, ancak otomasyon özelliklerini içermez ve çıkarıcıya bağlı olarak ayıklamayı bir veya birkaç yüz satırla sınırlar.

- Pro lisansının yıllık maliyeti 110 ABD dolarıdır ve Light lisansının tüm özelliklerinin yanı sıra otomasyon özellikleri ve sınırsız çıkarma içerir.

Görsel Kazıyıcı

Visual Scraper, bir SaaS platformu olmanın yanı sıra, veri dağıtım hizmetleri ve müşteriler için yazılım çıkarıcılar oluşturma gibi web kazıma hizmetleri de sunar. Bu web tarama aracı, indirmeden URL yönetimine ve içerik çıkarmaya kadar bir tarayıcının tüm yaşam döngüsünü kapsar. Kullanıcıların projeleri belirli zamanlarda çalışacak veya dizileri her dakika, gün, hafta, ay veya yılda bir tekrar edecek şekilde planlamasına olanak tanır. Visual Scraper, sık sık haberleri, güncellemeleri ve forumları ayıklamak isteyen kullanıcılar için idealdir. Ancak resmi web sitesi şu anda güncellenmemiş gibi görünüyor ve bu bilgiler güncel olmayabilir.

Ana Özellikler

- Kullanımı kolay arayüz

- Birden çok veri biçimini destekler (CSV, JSON, XML, vb.)

- Sayfalandırma, AJAX ve dinamik web sitelerini destekler

- Proxy sunucularını ve IP rotasyonunu destekler

- Zamanlama ve otomasyonu destekler

Fiyatlandırma

- Aylık 39,99 dolardan başlayan ücretsiz bir planı ve ücretli planları vardır.

İthalat.io

Import.io, kullanıcıların herhangi bir kod yazmadan belirli bir web sayfasından verileri içe aktarıp CSV'ye dışa aktarmalarını sağlayan bir web kazıma aracıdır. Binlerce web sayfasını dakikalar içinde kolayca kazıyabilir ve kullanıcıların gereksinimlerine göre 1000'den fazla API oluşturabilir. Import.io, web verilerini yalnızca birkaç tıklamayla bir kullanıcının uygulamasına veya web sitesine entegre ederek web kazımayı kolaylaştırır.

Ana Özellikler

- İşaretle ve tıkla seçim ve eğitim

- Kimliği doğrulanmış ve etkileşimli çıkarma

- Görüntü indirmeleri ve ekran görüntüleri

- Premium proxy'ler ve ülkeye özgü çıkarıcılar

- CSV, Excel, JSON çıkışı ve API erişimi

- Veri kalitesi HDS'si ve raporlama

- E-posta, bilet, sohbet ve telefon desteği

Fiyatlandırma

- Başlangıç: 5.000 sorgu için ayda 199 ABD doları

Dexi.io

Dexi.io, kullanıcıların herhangi bir web sitesinden tarayıcılarına dayalı olarak verileri sıyırmasına izin veren ve bir kazıma görevi oluşturmak için üç tür robot sağlayan tarayıcı tabanlı bir web tarayıcısıdır - Extractor, Crawler ve Pipes. Ücretsiz yazılım, anonim web proxy sunucuları sağlar ve çıkarılan veriler, veriler arşivlenmeden önce iki hafta boyunca Dexi.io'nun sunucularında barındırılır veya kullanıcılar, çıkarılan verileri doğrudan JSON veya CSV dosyalarına aktarabilir. Gerçek zamanlı veri ayıklamaya ihtiyaç duyan kullanıcılar için ücretli hizmetler sunar.

Ana Özellikler

- İşaretle ve tıkla seçim ve eğitim

- Kimliği doğrulanmış ve etkileşimli çıkarma

- Görüntü indirmeleri ve ekran görüntüleri

- Premium proxy'ler ve ülkeye özgü çıkarıcılar

- CSV, Excel, JSON çıkışı ve API erişimi

- Veri kalitesi HDS'si ve raporlama

- E-posta, bilet, sohbet ve telefon desteği

Fiyatlandırma

- Standart: 1 işçi için ayda 119 ABD Doları veya yılda 1.950 ABD Doları

kuklacı

Puppeteer, Google tarafından geliştirilen ve programcıların Chrome'u veya Chromium'u DevTools Protokolü üzerinden kontrol etmesi için bir API sağlayan bir Düğüm kitaplığıdır. Kullanıcıların, Puppeteer ve Node.js ile bir web kazıma aracı oluşturmasına olanak tanır. Kuklacı, ekran görüntüleri almak veya web sayfalarının PDF'lerini oluşturmak, form gönderimlerini/veri girişini otomatikleştirmek ve otomatik test için araçlar oluşturmak gibi çeşitli amaçlar için kullanılabilir.

Ana Özellikler

- Web sayfalarının ekran görüntülerini ve PDF'lerini oluşturun

- Web sitelerinden verileri tarayın ve kazıyın

- Form gönderimini, kullanıcı arabirimi testini, klavye girişini vb. otomatikleştirin.

- Performans ölçümlerini ve izlerini yakalayın

- Chrome uzantılarını test edin

- Başsız veya başsız modda çalıştırın

Fiyatlandırma

- Puppeteer ücretsiz ve açık kaynaklıdır.

paletli4j

Crawler4j, web'de gezinmek için basit bir arayüze sahip açık kaynaklı bir Java web tarayıcısıdır. Kullanıcıların bellek kullanımında verimli olurken çok iş parçacıklı tarayıcılar oluşturmasına olanak tanır. Crawler4j, basit ve özelleştirilebilir bir Java tabanlı web tarama çözümü isteyen geliştiriciler için çok uygundur.

Ana Özellikler

- Normal ifadeler kullanılarak hangi URL'lerin taranması ve hangilerinin göz ardı edilmesi gerektiğini belirtmenize olanak tanır.

- İndirilen sayfaları yönetmenize ve onlardan veri çıkarmanıza olanak tanır.

- Robots.txt protokolüne uyar ve izin verilmeyen sayfaların taranmasını engeller.

- HTML, resimler ve diğer dosya türlerini tarayabilir.

- İstatistikleri toplayabilir ve aynı anda birden çok tarayıcı çalıştırabilir.

Fiyatlandırma

- Crawler4j, kendi web tarayıcılarınızı kolayca kurmanıza ve çalıştırmanıza izin veren açık kaynaklı bir Java projesidir.

Ortak Tarama

Common Crawl, araştırma, analiz ve eğitim amaçları için açık bir web verileri topluluğu sağlayan bir web tarama aracıdır.

Ana Özellikler

- Kullanıcılara ham web sayfası verileri, çıkarılan meta veriler ve metin gibi web tarama verilerine ve Ortak Tarama Dizini'ne erişim sunar.

Fiyatlandırma

- Bu ücretsiz ve herkesin erişebileceği web tarama verileri, çeşitli veri analizi görevleri için geliştiriciler, araştırmacılar ve işletmeler tarafından kullanılabilir.

mekanik çorba

MechanicalSoup, Mechanize kitaplığından ilham alan, Beautiful Soup kitaplığına dayalı web sitelerini ayrıştırmak için kullanılan bir Python kitaplığıdır. Çerezleri saklamak, yönlendirmeleri, köprüleri takip etmek ve bir web sitesindeki formları işlemek için harikadır.

Ana Özellikler

- MechanicalSoup, karmaşık programlama görevleriyle uğraşmak zorunda kalmadan web sitelerine göz atmak ve bu sitelerdeki verileri ayıklamak için basit bir yol sunar.

Fiyatlandırma

- Ücretsiz bir araçtır.

Düğüm Paletli

Node Crawler, Node.js platformuyla web sitelerini taramak için popüler ve güçlü bir pakettir. Cheerio'ya dayalı olarak çalışır ve istek sayısını ve aralarında geçen süreyi sınırlamak da dahil olmak üzere, kullanıcıların web'de gezinme veya kazıma yöntemini özelleştirmek için birçok seçenekle birlikte gelir. Node Crawler, web tarama projeleri için Node.js ile çalışmayı tercih eden geliştiriciler için idealdir.

Ana Özellikler

- Kullanımı kolay

- Olay güdümlü API

- Yapılandırılabilir yeniden denemeler ve zaman aşımları

- Otomatik kodlama algılama

- Otomatik tanımlama bilgisi işleme

- Otomatik yönlendirme yönetimi

- Otomatik gzip/söndürme işlemi

Fiyatlandırma

- Ücretsiz bir araçtır.

Bir Web Tarama Aracı Seçerken Dikkate Alınması Gereken Faktörler

Fiyatlandırma

Seçilen aracın fiyatlandırma yapısını göz önünde bulundurun ve hiçbir gizli maliyet olmaksızın şeffaf olduğundan emin olun. Net bir fiyatlandırma modeli sunan ve mevcut özellikler hakkında ayrıntılı bilgi sağlayan bir şirket seçin.

Kullanım kolaylığı

Kullanıcı dostu olan ve kapsamlı teknik bilgi gerektirmeyen bir web tarama aracı seçin. Birçok araç, işaretle ve tıkla arabirimleri sunarak programcı olmayanların web sitelerinden veri çıkarmasını kolaylaştırır.

ölçeklenebilirlik

Web tarama aracının, ayıklamanız gereken veri hacmini işleyip işlemediğini ve işinizle birlikte büyüyüp büyüyemeyeceğini değerlendirin. Bazı araçlar küçük ölçekli projeler için daha uygunken, diğerleri büyük ölçekli veri çıkarma için tasarlanmıştır.

Veri Kalitesi ve Doğruluğu

Web tarama aracının ayıklanan verileri kullanılabilir bir biçimde temizleyebildiğinden ve düzenleyebildiğinden emin olun. Doğru analiz için veri kalitesi çok önemlidir, bu nedenle verimli veri temizleme ve düzenleme özellikleri sağlayan bir araç seçin.

Müşteri desteği

Sorunlar ortaya çıktığında size yardımcı olması için duyarlı ve yardımcı müşteri desteğine sahip bir web tarama aracı seçin. Onlarla iletişime geçerek ve bilinçli bir karar vermeden önce yanıt vermelerinin ne kadar sürdüğünü not ederek müşteri desteğini test edin.

Çözüm

Web tarama araçları, pazar araştırması, SEO ve rekabet analizi gibi çeşitli amaçlarla web sitelerinden değerli verileri çıkarmak isteyen işletmeler için çok önemlidir. Fiyatlandırma, kullanım kolaylığı, ölçeklenebilirlik, veri kalitesi ve doğruluğu ve müşteri desteği gibi faktörleri göz önünde bulundurarak ihtiyaçlarınıza uygun doğru web tarama aracını seçebilirsiniz. Yukarıda belirtilen en iyi 25 web tarama aracı, programcı olmayanlardan geliştiricilere kadar çok çeşitli kullanıcılara hitap ederek herkes için uygun bir araç olduğundan emin olur. Ayrıca, web sitenizin içeriğini optimize etmek ve sıralamanızı yükseltmek için Scalenut ile 7 günlük ücretsiz deneme sürümüne kaydolabilirsiniz.