SEO günlük dosyası analizine giriş

Yayınlanan: 2021-05-17Günlük analizi, arama motorlarının sitelerimizi nasıl okuduğunu analiz etmenin en kapsamlı yoludur. SEO'lar, dijital pazarlamacılar ve web analitiği uzmanları her gün trafik, kullanıcı davranışları ve dönüşümler hakkında diyagramlar gösteren araçlar kullanır. SEO'lar genellikle Google'ın sitelerini Google Arama Konsolu aracılığıyla nasıl taradığını anlamaya çalışır.

Öyleyse… bir SEO, bir arama motorunun siteyi doğru bir şekilde okuyup okumadığını kontrol etmek için neden diğer araçları analiz etmelidir? Tamam, temel bilgilerle başlayalım.

Günlük dosyaları nedir?

Günlük dosyası, sunucu web'in, web sitesinde botlar veya kullanıcılar tarafından talep edilen her bir kaynak için bir satır yazdığı bir dosyadır. Her satır, istekle ilgili şunları içerebilen verileri içerir:

arayan IP, tarih, gerekli kaynak (sayfa, .css, .js, …), kullanıcı aracısı, yanıt süresi, …

Bir satır şöyle görünecek:

66.249.**.** - - [13/Apr/2021:00:07:31 +0200] "GET /***/x_*** HTTP/1.1" 200 40960 "-" "Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)" "www.***.it" "-"

Taranabilirlik ve Güncellenebilirlik

Her sayfanın üç temel SEO durumu vardır:

- taranabilir

- indekslenebilir

- sıralanabilir

Günlük analizi perspektifinden, bir sayfanın indekslenebilmesi için bir bot tarafından okunması gerektiğini biliyoruz. Ve aynı şekilde, zaten bir arama motoru tarafından indekslenen içeriğin, arama motorunun indekslerinde güncellenmesi için yeniden taranması gerekir.

Maalesef Google Search Console'da bu ayrıntı düzeyine sahip değiliz: Googlebot'un son üç ayda sitedeki bir sayfayı kaç kez okuduğunu ve web sunucusunun ne kadar hızlı yanıt verdiğini kontrol edebiliriz.

Bir botun bir sayfayı okuyup okumadığını nasıl kontrol edebiliriz? Tabii ki, günlük dosyaları ve bir günlük dosyası analizörü kullanarak.

SEO'ların neden günlük dosyalarını analiz etmesi gerekiyor?

Günlük dosyası analizi, SEO'ların (ve Sistem Yöneticilerinin de) şunları anlamasını sağlar:

- Bir bot tam olarak ne okur

- Bot ne sıklıkla okur?

- Harcanan zaman (ms) açısından tarama maliyeti ne kadardır?

Günlük analiz aracı, bilgileri "yol"a, dosya türüne veya yanıt süresine göre gruplayarak günlüklerin analiz edilmesini sağlar. Harika bir günlük analiz aracı, günlük dosyalarından elde edilen bilgileri Google Arama Konsolu (tıklamalar, gösterimler, ortalama konumlar) veya Google Analytics gibi diğer veri kaynaklarıyla birleştirmemize de olanak tanır.

Oncrawl Günlük Analiz Aracı

Günlük dosyalarında ne aranmalı?

Günlük dosyalarındaki en önemli bilgi parçalarından biri, günlük dosyalarında olmayan bilgilerdir. Gerçekten, şaka yapmıyorum. Bir sayfanın neden dizine eklenmediğini veya en son sürümüne güncellenmediğini anlamanın ilk adımı, botun (örneğin Googlebot) sayfayı okuyup okumadığını kontrol etmektir.

Bunu takiben, sayfa sık sık güncelleniyorsa, bir botun sayfayı veya site bölümünü ne sıklıkla okuduğunu kontrol etmek önemli olabilir.

Bir sonraki adım, hangi sayfaların botlar tarafından en sık okunduğunu kontrol etmektir. Bunları izleyerek, şu sayfaların olup olmadığını kontrol edebilirsiniz:

- çok sık okunmayı hak ediyor

- veya sayfadaki bir şey sürekli, kontrol dışı değişikliklere neden olduğu için çok sık okunur

Örneğin, birkaç ay önce üzerinde çalıştığım bir site, garip bir URL'de çok yüksek bir bot okuma sıklığına sahipti. Bot, bu sayfanın bir JS betiği tarafından oluşturulan bir URL'den geldiğini ve bu sayfanın, sayfa her yüklendiğinde değişen bazı hata ayıklama değerleriyle damgalandığını ortaya çıkardı… Bu ifşanın ardından, iyi bir SEO kesinlikle bunu düzeltmek için doğru çözümü bulabilir. tarama bütçe deliği.

Tarama bütçesi

Tarama bütçesi? Bu ne? Her sitenin arama motorları ve botlarıyla ilgili metaforik bütçesi vardır. Evet: Google, siteniz için bir tür bütçe belirler. Bu hiçbir yerde kaydedilmez, ancak iki şekilde "hesaplayabilirsiniz":

- Google Arama Konsolu Tarama istatistikleri raporunu kontrol etme

- günlük dosyalarını kontrol etme, "Googlebot" içeren kullanıcı aracısı tarafından onları grepleme ( filtreleme ) ( En iyi sonuçları, bu kullanıcı aracılarının doğru Google IP'leriyle eşleştiğinden emin olursanız alırsınız… )

Site ilginç içerikle güncellendiğinde veya içeriği düzenli olarak güncellediğinde veya site iyi geri bağlantılar aldığında tarama bütçesi artar.

Sitenizde tarama bütçesinin nasıl harcandığı aşağıdakiler tarafından yönetilebilir:

- dahili bağlantılar (takip edin / takip etmeyin!)

- noindex / kurallı

- robots.txt (dikkat: bu, kullanıcı aracısını "engeller")

zombi sayfaları

Benim için "zombi sayfaları", önemli bir süre boyunca herhangi bir organik trafik veya bot ziyareti almayan, ancak bunlara işaret eden dahili bağlantılara sahip tüm sayfalardır.

Bu sayfa türü çok fazla tarama bütçesi kullanabilir ve dahili bağlantılar nedeniyle gereksiz yere sayfa sıralaması alabilir. Bu durum çözülebilir:

- Bu sayfalar siteye gelen kullanıcılar için faydalı ise onları noindex olarak ayarlayıp iç linklerini de nofollow olarak ayarlayabiliriz ( veya disallow robots.txt kullanabiliriz ama buna dikkat edin… )

- Bu sayfalar siteye gelecek kullanıcılar için kullanışlı değilse, onları kaldırabilir (ve 410 veya 404 durum kodu döndürebilir) ve tüm dahili bağlantıları kaldırabiliriz.

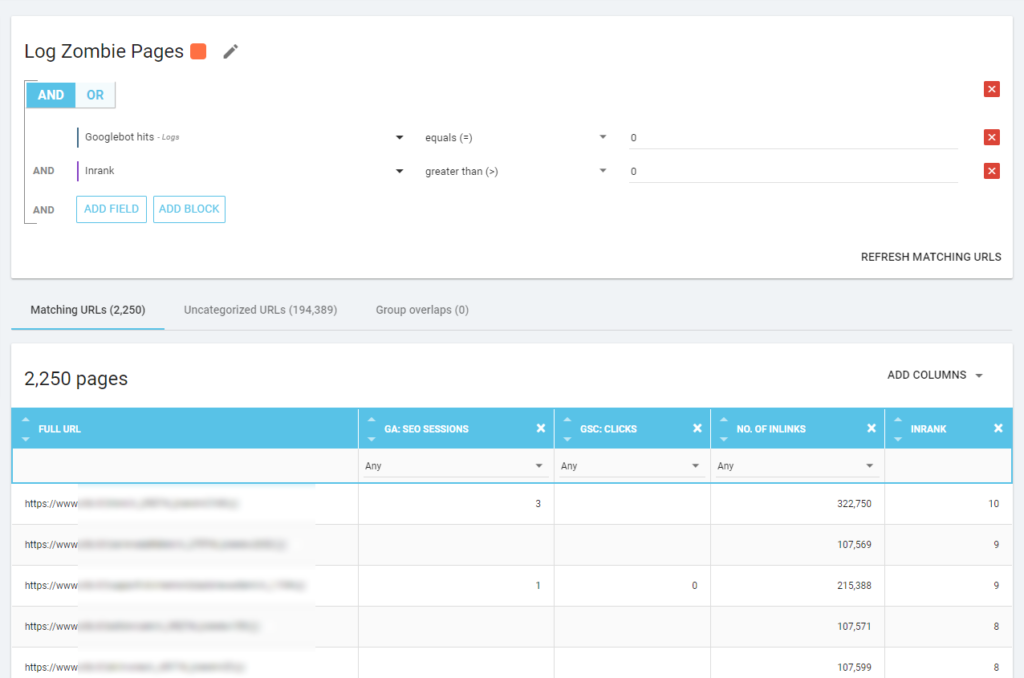

Oncrawl ile aşağıdakilere dayalı bir "zombi raporu" oluşturabiliriz:

- GSC gösterimleri

- GSC tıklamaları

- GA oturumları

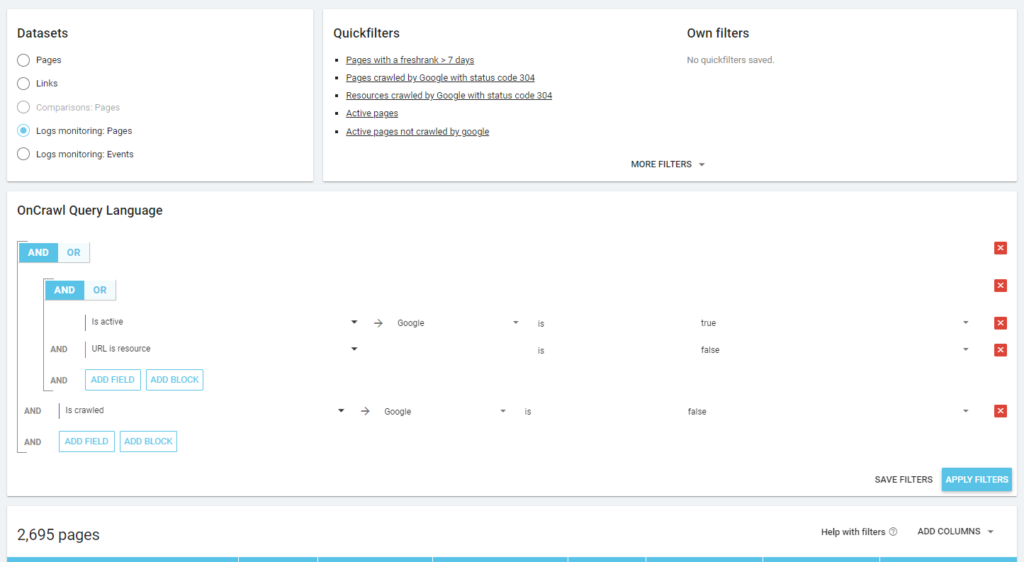

Zombi sayfalarını ortaya çıkarmak için günlük olaylarını da kullanabiliriz: örneğin bir 0 olay filtresi tanımlayabiliriz. Bunu yapmanın en kolay yollarından biri bir Segmentasyon oluşturmaktır. Aşağıdaki örnekte, tüm sayfaları şu kriterlere göre filtreliyorum: Googlebot isabeti yok, ancak Inrank var (bu, bu sayfaların kendilerine işaret eden dahili bağlantılara sahip olduğu anlamına gelir).

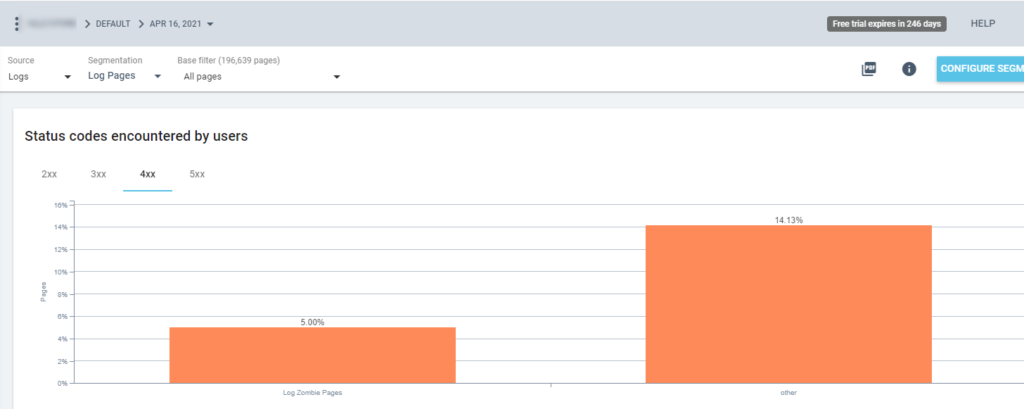

Artık bu segmentasyonu tüm Oncrawl raporlarında kullanabiliriz. Bu, herhangi bir grafikten içgörü elde etmemizi sağlar, örneğin: kaç tane "zombi günlük sayfası" 200 durum kodu döndürür?

yetim sayfalar

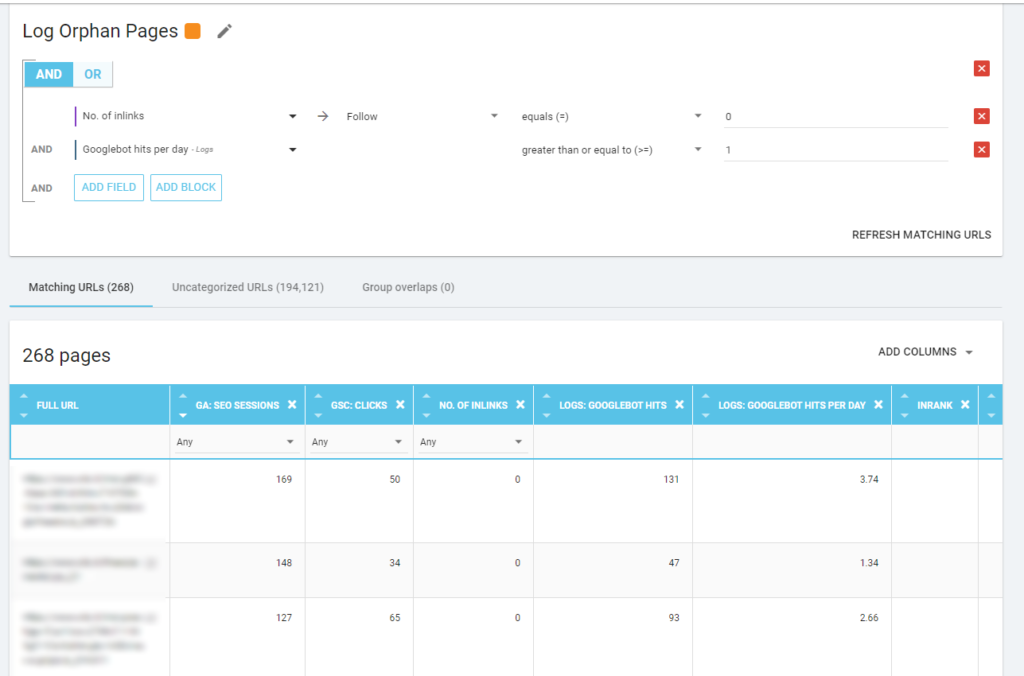

Benim için, "Yetim sayfalar", önemli metriklerde (GA Oturumu, GSC Gösterimi, Günlük isabetleri, …) yüksek değeri olan ve sayfa sıralamasını paylaşmak için kendilerine işaret eden herhangi bir dahili bağlantıya sahip olmayan tüm sayfalardır. ve sayfanın önemini belirtin.

"Zombi sayfaları"nda olduğu gibi, günlük tabanlı bir rapor oluşturmanın en iyi yolu yeni bir segmentasyon oluşturmaktır.

WOW, oturumları ve isabetleri olan ve bağlantı içermeyen ne kadar çok sayfa var!

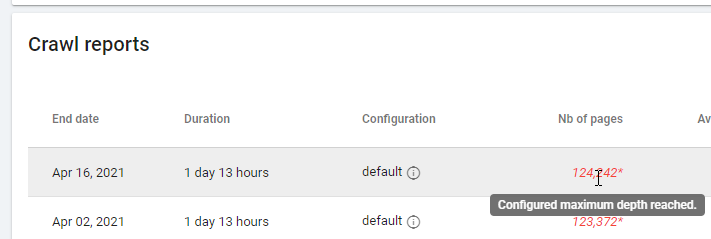

"Sıfır Takip Bağlantısı"na dayalı bir raporu kontrol ederken lütfen tarama durumuna dikkat edin: Oncrawl tüm siteyi mi yoksa yalnızca birkaç sayfayı mı tarayabildi? Bunu projenin ana sayfasında görebilirsiniz:

Maksimum derinliğe ulaşılmışsa:

- Tarama yapılandırmanızı kontrol edin

- Site yapınızı kontrol edin

Günlük dosyaları ve Oncrawl

Oncrawl, varsayılan gösterge tablolarında ne sunuyor?

Canlı kayıt

Bu gösterge panosu, botlar sitenizi ziyaret eder etmez ve günlük dosyalarından gelen bilgiler tamamen işlenmeden önce, botların sitelerinizi nasıl okuduğuyla ilgili önemli bilgileri kontrol etmek için kullanışlıdır. Bundan en iyi şekilde yararlanmak için günlük dosyalarını sık sık yüklemenizi öneririm: Bunu Amazon S3 için olduğu gibi bağlayıcılar aracılığıyla FTP aracılığıyla veya web arabirimi aracılığıyla manuel olarak yapabilirsiniz.

İlk grafik sitenizin ne sıklıkta ve hangi bot tarafından okunduğunu gösterir. Aşağıda görebileceğiniz örnekte, masaüstü ve mobil erişimleri kontrol edebiliriz. Bu durumda, yalnızca Googlebot için filtrelenen günlük dosyalarını Oncrawl'a gönderdik:

Mobil okumaların hala çok yüksek olduğunu görmek ilginç: normal mi? Bu duruma göre değişir... Analiz ettiğimiz site hala "mobil-ilk dizin" içindedir, ancak tam olarak yanıt veren bir web sitesi değildir: dinamik bir hizmet veren web sitesidir (Google'ın dediği gibi) ve Google hala her iki sürümü de kontrol eder!

Bir başka ilginç diyagram ise “Sayfa grubuna göre bot isabetleri”. Varsayılan olarak Oncrawl, URL yollarına dayalı olarak gruplar oluşturur. Ancak, birlikte analiz edilmesi en mantıklı URL'leri gruplandırmak için grupları manuel olarak ayarlayabiliriz.

Gördüğünüz gibi sarı kazanır! Ürün yoluna sahip URL'leri temsil eder, bu nedenle, özellikle Google'ın ücretli Alışveriş kampanyaları olduğu için bu kadar yüksek bir etkiye sahip olması normaldir.

Ve… evet, Google'ın satıcı özet akışıyla ilgili ürün durumunu kontrol etmek için standart Googlebot'u kullandığını az önce onayladık!

tarama davranışı

Bu pano, "Canlı günlük"e benzer bilgiler gösterir, ancak bu bilgiler tamamen işlenmiştir ve gün, hafta veya aya göre toplanmıştır. Burada istediğiniz kadar zamanda geriye gidebileceğiniz bir tarih aralığı (başlangıç/bitiş) belirleyebilirsiniz. Günlük analizinde daha fazla ilerlemek için iki yeni diyagram var:

- Tarama davranışı: taranan sayfalar ile yeni taranan sayfalar arasındaki oranı kontrol etmek için

- Günlük tarama sıklığı

Bu diyagramları okumanın en iyi yolu, sonuçları site eylemlerine bağlamaktır:

- Sayfaları taşıdın mı?

- Bazı bölümleri güncelledin mi?

- Yeni içerik yayınladınız mı?

SEO etkisi

SEO için optimize edilmiş sayfaların botlar tarafından okunup okunmadığını izlemek önemlidir. “Yetim sayfalar” hakkında yazdığımız gibi, en önemli/güncellenmiş sayfaların botlar tarafından okunmasını sağlamak, en güncel bilgilerin arama motorlarına sunulabilmesi için önemlidir.

Oncrawl, arama motorlarından organik trafik alan sayfaları belirtmek için “Aktif sayfalar” kavramını kullanır. Bu kavramdan yola çıkarak, aşağıdakiler gibi bazı temel sayıları gösterir:

- SEO ziyaretleri

- SEO aktif sayfalar

- SEO aktif oranı (taranan tüm sayfalar içindeki aktif sayfaların oranı)

- Fresh Rank (botun sayfayı ilk okuması ile ilk organik ziyareti arasında geçen ortalama süre)

- Etkin sayfalar taranmadı

- Yeni etkin sayfalar

- Etkin sayfaların günlük tarama sıklığı

Oncrawl'ın felsefesinde olduğu gibi, tek bir tıklamayla, tıkladığımız metrik tarafından filtrelenen bilgi gölünün derinliklerine inebiliriz! Örneğin: taranmayan etkin sayfalar hangileridir? Tek tık…

keşif akıl sağlığı

Bu son gösterge panosu, bo'nun tarama kalitesini veya daha doğru bir şekilde sitenin kendisini arama motorlarına ne kadar iyi sunduğunu kontrol etmemizi sağlar:

- Durum kodu analizi

- Güne göre durum kodu analizi

- Sayfa grubuna göre durum kodu analizi

- Tepki süresi analizi

İyi bir SEO çalışması için zorunludur:

- dahili bağlantılardan gelen 301 yanıt sayısını azaltın

- 404/410 yanıtlarını dahili bağlantılardan kaldırın

- yanıt süresini optimize edin, çünkü Googlebot tarama kalitesi yanıt süresiyle doğrudan ilişkilidir: sitenizdeki yanıt süresini yarıya indirmeye çalışın ve (birkaç gün içinde) taranan sayfaların miktarının iki katına çıktığını göreceksiniz.

Günlük Analizi bilimi ve Oncrawl'ın Veri Gezgini

Şimdiye kadar standart Oncrawl raporlarını ve bunların segmentasyonlar ve sayfa grupları aracılığıyla özel bilgiler elde etmek için nasıl kullanılacağını gördük.

Ancak log analizinin özü, yanlış bir şeyin nasıl bulunacağını anlamaktır. Genellikle analizin başlangıç noktası, zirveleri kontrol etmek ve bunları trafikle ve hedeflerinizle karşılaştırmaktır:

- en çok taranan sayfalar

- en az taranan sayfalar

- en çok taranan kaynaklar (sayfalar değil)

- dosya türüne göre tarama frekansları

- 3xx / 4xx durum kodlarının etkisi

- 5xx durum kodlarının etkisi

- daha yavaş taranan sayfalar

- …

Daha derine inmek ister misin? Güzel… veri eklemeniz gerekiyor. Ve Oncrawl, Data Explorer gibi gerçekten güçlü bir araç sunuyor.

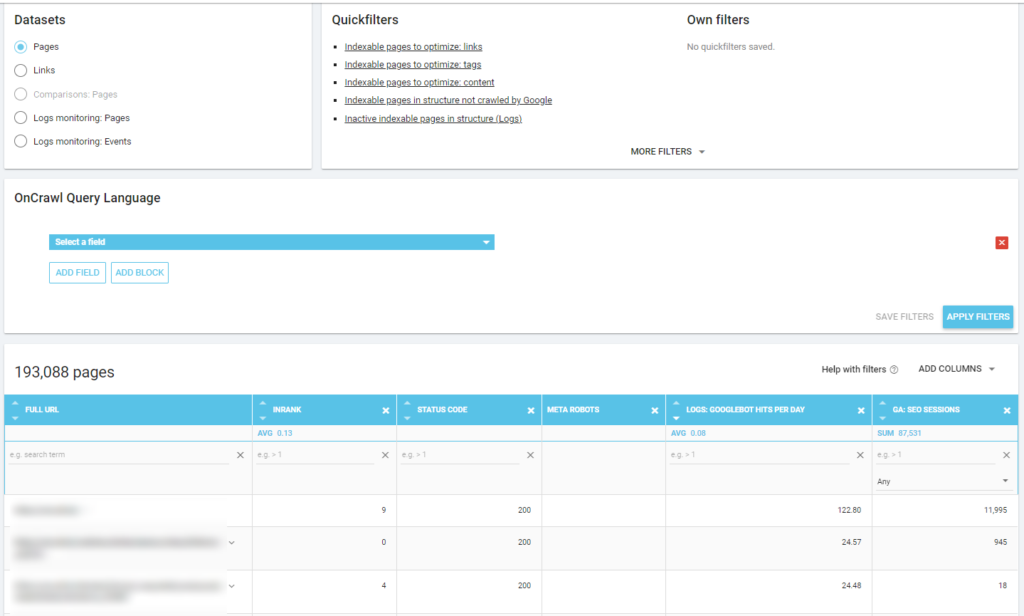

Bir önceki ekran görüntüsünde de görebileceğiniz gibi (aktif sayfalar taranmamış), analiz çerçevenize göre istediğiniz tüm raporları oluşturabilirsiniz.

Örneğin:

- botlar tarafından çok fazla taranan en kötü organik trafik sayfaları

- botlar tarafından çok fazla taranan en iyi organik trafik sayfaları

- çok sayıda SERP gösterimi olan daha yavaş sayfalar

- …

Aşağıda, SEO oturumlarının sayısıyla ilgili olarak en çok taranan sayfaların hangileri olduğunu nasıl kontrol ettiğimi görebilirsiniz:

paket servisler

Günlük analizi kesinlikle teknik değildir: mümkün olan en iyi şekilde yapmak için teknik becerileri, SEO becerilerini ve pazarlama becerilerini birleştirmemiz gerekir.

Çoğu zaman, müşterimizin günlük dosyalarına erişimi olmadığı veya maliyetli bir analiz olabileceği için bir analiz “SEO kontrol listesinden” çıkarılır.

Gerçek şu ki, günlükler, botların sitelerimizde nereye gittiğini gerçekten kontrol etmek ve sunucularımızın onlara nasıl yanıt verdiğini bilmek için tek kaynaktır.

Oncrawl gibi bir araç teknik gereksinimleri büyük ölçüde azaltabilir: sadece günlük dosyalarını yükleyin ve analiz etmeye başlayın!