Robots.txt คืออะไร: ความหมาย ความสำคัญ และตัวอย่าง

เผยแพร่แล้ว: 2022-07-11คุณอาจเคยได้ยินเกี่ยวกับ Google ที่รวบรวมข้อมูลเว็บไซต์ของเราและหน้าเว็บต่างๆ บนอินเทอร์เน็ต แล้วแสดงบนหน้าผลการค้นหาของพวกเขา

ก็คือ robots.txt บอก Google ว่าไซต์ใดกำลังติดตามอัลกอริธึมและไซต์ใดไม่ปฏิบัติตาม ในคู่มือนี้ เราได้แบ่งปันทุกสิ่งที่คุณจำเป็นต้องรู้เกี่ยวกับ robots.txt ตัวอย่าง และวิธีการทำงาน

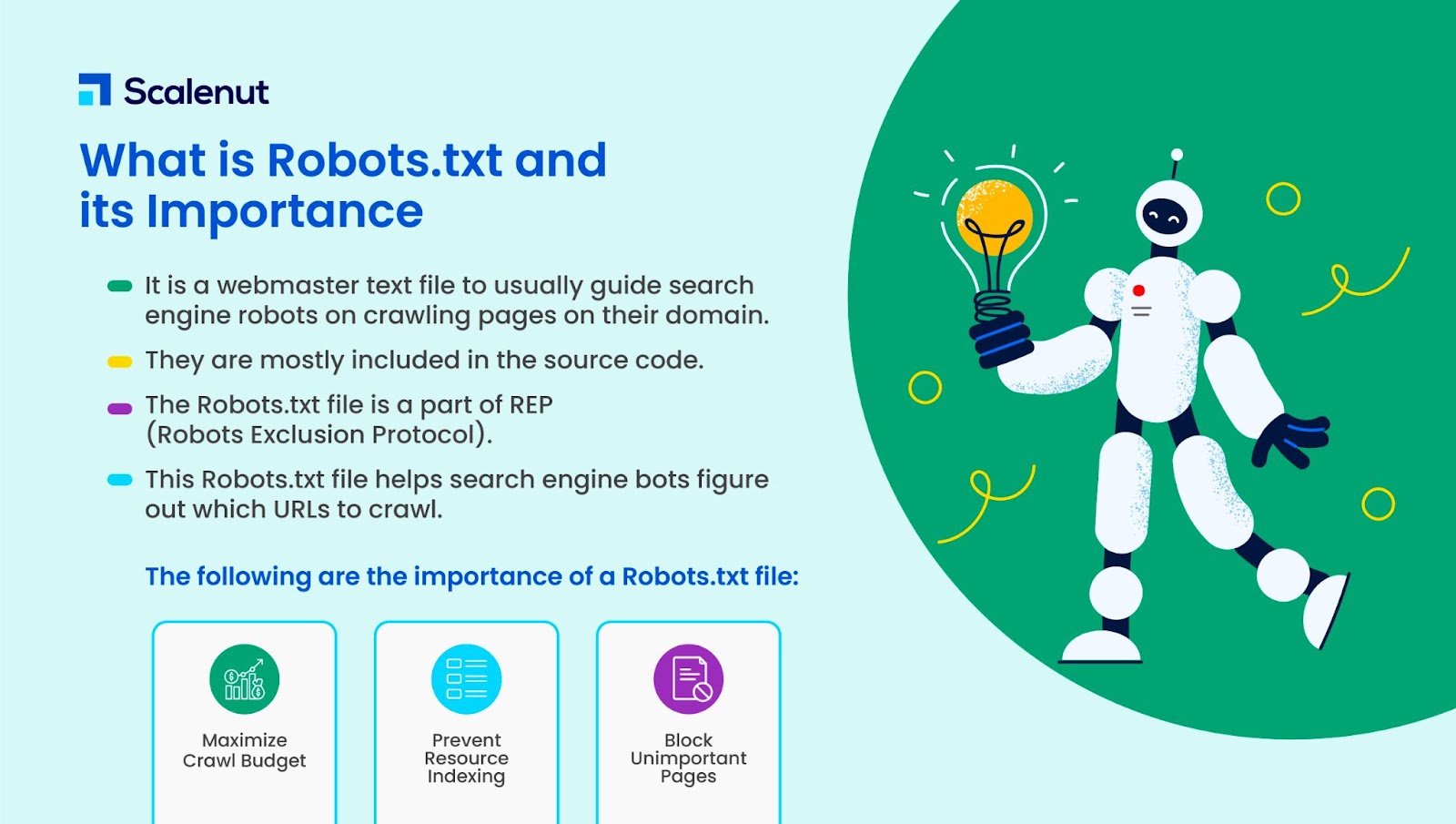

Robots.txt คืออะไร

Robots.txt เป็นไฟล์ข้อความของผู้ดูแลเว็บเพื่อแนะนำเว็บโรบ็อต (โดยปกติคือโรบ็อตของเครื่องมือค้นหา) ในการรวบรวมข้อมูลหน้าเว็บในโดเมนของตน ไฟล์ robots.txt หรืออีกนัยหนึ่งคือชุดคำสั่งสำหรับบอท

Robots.txt รวมอยู่ในซอร์สโค้ดสำหรับเว็บไซต์ส่วนใหญ่

ไฟล์ robots.txt เป็นส่วนหนึ่งของ Robots Exclusion Protocol (REP) มันกำหนดวิธีที่โรบ็อตรวบรวมข้อมูลหน้าเว็บ ค้นหาและจัดทำดัชนีเนื้อหา และให้บริการข้อมูลนั้นแก่ผู้ที่ต้องการ

Robots.txt ช่วยให้บอทของเครื่องมือค้นหาเข้าใจว่า URL ใดที่ควรรวบรวมข้อมูลในเว็บไซต์ของคุณ

ทำไม Robots.txt ถึงมีความสำคัญ?

มีเหตุผลหลักสามประการที่ how.txt สามารถช่วยคุณได้:

- เพิ่มงบประมาณการรวบรวมข้อมูลสูงสุด: งบประมาณการรวบรวมข้อมูลคือจำนวนหน้าที่ Google bots จัดทำดัชนีในกรอบเวลา Robots.txt สามารถช่วยบล็อกหน้าเนื้อหาที่ไม่สำคัญหรือซ้ำกัน และเน้นเฉพาะหน้าที่มีความสำคัญต่อคุณ เพิ่มงบประมาณการรวบรวมข้อมูลสูงสุดและเพิ่มการมองเห็น

- หลีกเลี่ยงการจัดทำดัชนีทรัพยากร: Robots.txt สามารถจัดทำดัชนีหรือยกเลิกการจัดทำดัชนีทรัพยากร เช่น PDF หรือรูปภาพ ดังนั้น สามารถใช้ noindex หรือหน้าที่มีการป้องกันด้วยรหัสผ่านเพื่อบล็อกหน้าหรือทรัพยากร คุณสามารถตรวจสอบหน้าที่จัดทำดัชนีโดยใช้คอนโซลการค้นหาของ Google และดูว่าบ็อตรวบรวมข้อมูลหน้าที่คุณต้องการจัดทำดัชนีหรือไม่

- บล็อกหน้าที่ไม่สำคัญ: มีบางหน้าในเว็บไซต์ของคุณที่คุณไม่ต้องการให้แสดงในผลการค้นหาของ Google สิ่งเหล่านี้อาจเป็นหน้าเข้าสู่ระบบหรือเวอร์ชันที่จัดทำ/ทดสอบของเว็บไซต์ของคุณ เมื่อใช้ robots.txt คุณสามารถบล็อกหน้าเหล่านี้และเน้นเฉพาะหน้าที่มีความสำคัญเท่านั้น

Robots.txt ตัวอย่าง

ตัวอย่างของ robots.txt ได้แก่:

ตัวแทนผู้ใช้: Googlebot

ไม่อนุญาต: /nogooglebot/

ตัวแทนผู้ใช้: *

อนุญาต: /

แผนผังเว็บไซต์: http://www.example.com/sitemap.xml

ในทำนองเดียวกันสำหรับเสิร์ชเอ็นจิ้น Bing จะไป:

ตัวแทนผู้ใช้: Bingbot

ไม่อนุญาต: /example-subfolder/blocked-page.html

ไวยากรณ์ช่วยให้โปรแกรมรวบรวมข้อมูลหลีกเลี่ยงการรวบรวมข้อมูลของบางหน้า

เป็นที่น่าสังเกตว่าแต่ละโดเมนย่อยต้องมีไฟล์ robots.txt ของตัวเอง

ตัวอย่างเช่น ในขณะที่ www.cloudflare.com มีไฟล์ของตัวเอง โดเมนย่อยของ Cloudflare ทั้งหมด (blog.cloudflare.com, community.cloudflare.com และอื่นๆ) ก็ต้องการโดเมนของตัวเองเช่นกัน

ไฟล์ Robots.txt ทำงานอย่างไร

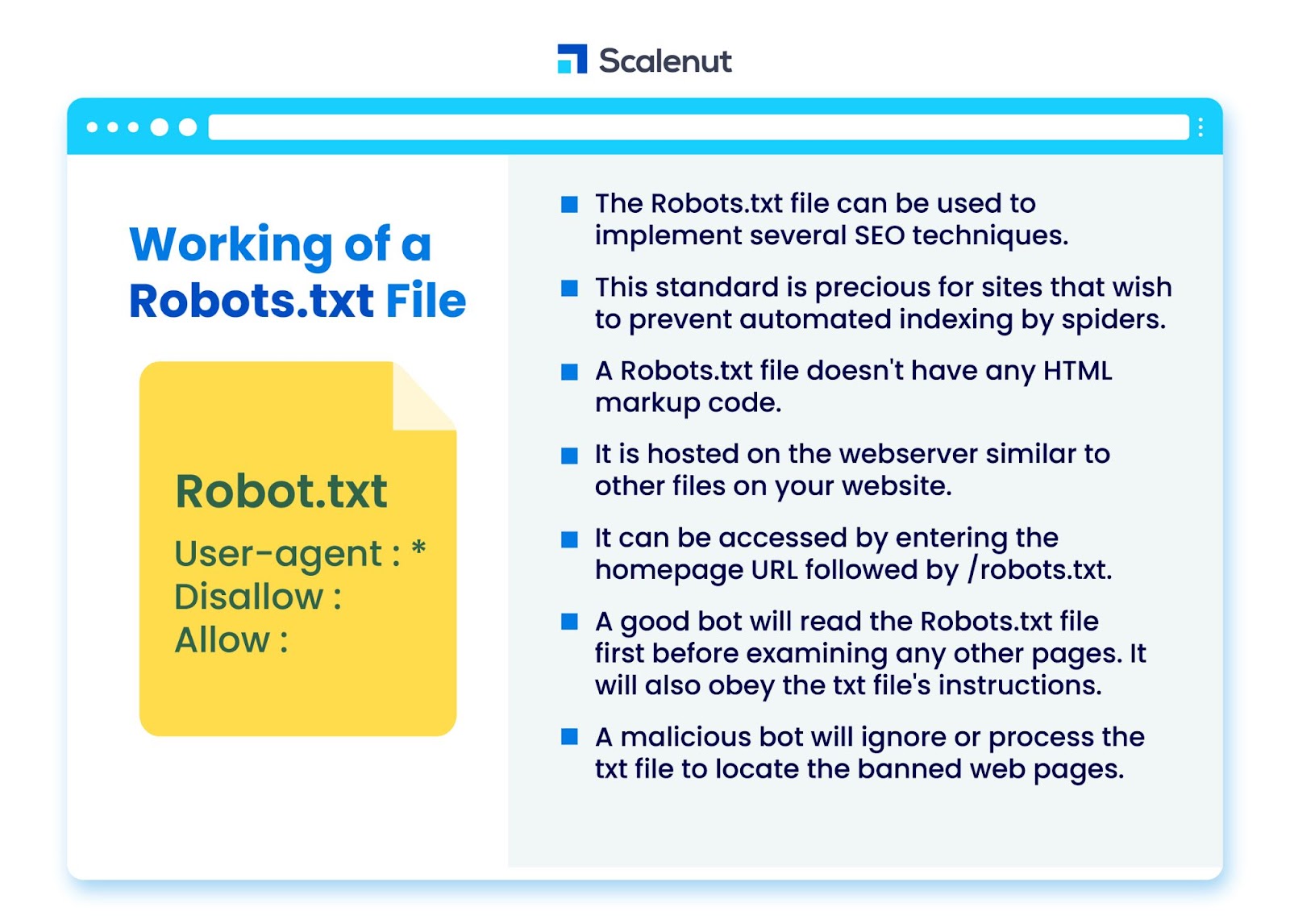

ไฟล์ robots.txt สามารถใช้เพื่อใช้เทคนิคการเพิ่มประสิทธิภาพกลไกค้นหา (SEO) ได้หลายอย่าง เช่น หน้าเว็บที่ไม่ได้จัดทำดัชนี หรือ robots txt ไม่อนุญาตบางส่วนหรือทั้งหมดของเว็บไซต์โดยโปรแกรมบอท

มาตรฐานนี้มีประโยชน์อย่างยิ่งสำหรับไซต์ที่ต้องการป้องกันไม่ให้สไปเดอร์สร้างดัชนีเนื้อหาผ่านกระบวนการอัตโนมัติ เช่น ซอฟต์แวร์การค้นหาและการจัดอันดับหน้าโดยใช้โปรแกรมรวบรวมข้อมูลเว็บอัตโนมัติ

robots.txt เป็นไฟล์ที่ไม่มีโค้ดมาร์กอัป HTML มันถูกโฮสต์บนเว็บเซิร์ฟเวอร์ เช่นเดียวกับไฟล์อื่นๆ ในเว็บไซต์ของคุณ

สามารถเข้าถึงได้โดยป้อน URL หน้าแรกตามด้วย /robots.txt ตัวอย่างทั่วไปคือ https://www.xyz.com/robots.txt

เนื่องจากไฟล์ไม่ได้เชื่อมโยงกับที่อื่นบนไซต์ ผู้เข้าชมจึงไม่น่าจะเจอไฟล์นั้น แต่บอทของโปรแกรมรวบรวมข้อมูลเว็บส่วนใหญ่จะค้นหาไฟล์ก่อนที่จะสร้างดัชนีส่วนที่เหลือของไซต์

บอทที่ดี เช่น โปรแกรมรวบรวมข้อมูลของ Google หรือบอทฟีดข่าว จะอ่านไฟล์ robots.txt ก่อนตรวจสอบหน้าอื่นๆ ในไซต์และปฏิบัติตามคำแนะนำ

บอทที่เป็นอันตรายจะเพิกเฉยหรือประมวลผลไฟล์ robots.txt เพื่อค้นหาหน้าเว็บที่ถูกแบน

Robots.txt การบล็อก

Robots.txt ประกอบด้วยคำแนะนำในการแจ้งให้โรบ็อตทราบถึงกฎการบล็อกในเว็บไซต์ที่ค้นหาได้อย่างอื่นซึ่งจัดทำดัชนีโดย Googlebot ซึ่งมีจุดประสงค์เพื่อป้องกันไม่ให้โปรแกรมรวบรวมข้อมูลเข้าถึงหน้าเว็บที่มีเนื้อหาบางอย่าง

ไม่มีผลกับผู้ใช้ทั่วไปหรือบอทที่เพิ่งเรียกดูไซต์โดยไม่ต้องรวบรวมข้อมูล

เมื่อเวลาผ่านไป เว็บไซต์ต่างๆ ได้บล็อกแอปบนอุปกรณ์เคลื่อนที่ JavaScript และส่วนอื่นๆ ของเว็บไซต์โดยใช้วิธีนี้ในขณะที่ยังอนุญาตองค์ประกอบบางอย่าง เช่น รูปภาพ

โปรโตคอลใดที่ใช้ในไฟล์ Robots.txt

โปรโตคอลเป็นรูปแบบสำหรับส่งคำสั่งหรือคำสั่งในระบบเครือข่าย ไฟล์ Robots.txt ใช้โปรโตคอลที่หลากหลาย โปรโตคอลหลักเรียกว่า Robots Exclusion Protocol

มันแนะนำบอทเกี่ยวกับเว็บไซต์และแหล่งข้อมูลที่ควรหลีกเลี่ยง

โปรโตคอลแผนผังเว็บไซต์เป็นอีกโปรโตคอลหนึ่งที่ใช้สำหรับไฟล์ robots.txt ซึ่งถือได้ว่าเป็นโปรโตคอลสำหรับการรวมหุ่นยนต์

แผนผังเว็บไซต์แจ้งโปรแกรมรวบรวมข้อมูลเว็บเกี่ยวกับหน้าที่พวกเขาสามารถเข้าถึงได้ ซึ่งช่วยให้มั่นใจว่าบอทของโปรแกรมรวบรวมข้อมูลจะไม่มองข้ามหน้าที่สำคัญใดๆ

Sitemap คืออะไร?

แผนผังเว็บไซต์เป็นไฟล์ XML ที่อธิบายข้อมูลที่โปรแกรมรวบรวมข้อมูลเว็บใช้ในการแสดงหน้าเว็บไซต์ของคุณ แผนผังเว็บไซต์แสดงรายการ URL ทั้งหมดบนเว็บไซต์ของคุณ รวมถึงชื่อและคำอธิบาย และข้อมูลที่เกี่ยวข้องอื่นๆ

เอกสารนี้ช่วยให้เครื่องมือค้นหาจัดทำดัชนีรายการเหล่านี้ได้อย่างถูกต้อง เพื่อให้ผู้เข้าชมสามารถค้นหาได้อย่างรวดเร็วโดยใช้เครื่องมือค้นหาหรือระบบนำทางอื่นๆ

User-Agent คืออะไร?

User-agent ตัวแทนผู้ใช้: *disallow: /nogooglebot/ user-agent user-agent: Googlebot

ไม่อนุญาตกฎของ robots.txt ทั้งหมด โดยไม่คำนึงถึง user-agent ซึ่งจะป้องกันไม่ให้โปรแกรมรวบรวมข้อมูลเว็บเข้าถึงเว็บไซต์ของคุณ ซึ่งมักใช้โดยเว็บไซต์ที่มีความอ่อนไหวต่อข้อกังวลเรื่องความเป็นส่วนตัว (และไม่ต้องการให้ข้อมูลของผู้ใช้ถูกเปิดเผย)

ชื่อตัวแทนผู้ใช้บอทเครื่องมือค้นหาทั่วไป ได้แก่:

Google :

- Googlebot

- Googlebot-Image (สำหรับรูปภาพ)

- Googlebot-News (สำหรับข่าวสาร)

- Googlebot-Video (สำหรับวิดีโอ)

บิง:

- บิงบอท

- MSNBot-Media (สำหรับรูปภาพและวิดีโอ)

ไป่ตู้:

- ไบดัสไปเดอร์

ไฟล์ .txt คืออะไร

TXT เป็นนามสกุลไฟล์ข้อความที่สนับสนุนโดยโปรแกรมแก้ไขข้อความจำนวนมาก

ไม่มีคำจำกัดความคงที่ของไฟล์ข้อความ ในขณะที่มีรูปแบบยอดนิยมมากมาย รวมถึง ASCII (รูปแบบข้ามแพลตฟอร์ม) และ ANSI (ใช้กับแพลตฟอร์ม DOS และ Windows) TXT เป็นตัวย่อของ TeXT ข้อความ/ธรรมดาเป็นประเภท MIME

ในไฟล์ข้อความ robots.txt กฎแต่ละข้อจะระบุรูปแบบของ URL ที่เข้าถึงได้โดยโปรแกรมรวบรวมข้อมูลทั้งหมดหรือโปรแกรมรวบรวมข้อมูลที่ระบุเท่านั้น

แต่ละบรรทัดควรขึ้นต้นด้วยโคลอนเดี่ยว (:) และมี 1–3 บรรทัด โดยไม่สนใจบรรทัดว่าง แต่ละบรรทัดจะถูกตีความว่าเป็นชื่อไฟล์ ซึ่งสามารถเป็นแบบสัมบูรณ์หรือสัมพันธ์กับไดเร็กทอรีที่วางไว้

Web Robots เหมือนกับ Robots.txt หรือไม่

เครื่องมือค้นหาบางตัวอาจไม่รองรับคำสั่ง txt

คำแนะนำในไฟล์ robots.txt ไม่สามารถบังคับให้โปรแกรมรวบรวมข้อมูลเข้าชมไซต์ของคุณได้ มันขึ้นอยู่กับโปรแกรมรวบรวมข้อมูลที่จะติดตามพวกเขา ในทางตรงกันข้าม Googlebot และโปรแกรมรวบรวมข้อมูลเว็บที่มีชื่อเสียงอื่นๆ จะปฏิบัติตามกฎในไฟล์ robots.txt

จะใช้งาน Robots.txt ได้อย่างไร

ไฟล์ robots.txt สามารถใช้งานได้ในโปรแกรมแก้ไขข้อความเกือบทุกชนิด ตัวอย่างเช่น Notepad, TextEdit, vi และ emacs อาจสร้างไฟล์ robots.txt ที่ถูกต้องทั้งหมด

ต่อไปนี้เป็นกฎในการปฏิบัติตาม robots.txt:

- ชื่อไฟล์ควรเป็น robots.txt

- ไฟล์ robots.txt สามารถใช้เพื่อจำกัดการเข้าถึงโดเมนย่อย (เช่น https://website.example.com/robots.txt) หรือพอร์ตที่ไม่ได้มาตรฐาน

- ไฟล์ robots.txt ต้องอยู่ในรูปแบบ UTF-8 (ซึ่งรวมถึง ASCII) Google อาจปฏิเสธอักขระที่ไม่อยู่ในช่วง UTF-8 ซึ่งอาจทำให้ข้อบังคับของ robots.txt ไม่ถูกต้อง

- ไฟล์ robots.txt มักพบในไดเร็กทอรีรากของโฮสต์เว็บไซต์ที่ใช้ไฟล์นั้น หากต้องการเปิดใช้งานการรวบรวมข้อมูลบน URL ทั้งหมด เช่น https://www.example.com/ จะต้องพบไฟล์ robots.txt ที่ https://www.example.com/robots.txt ไม่สามารถวางไว้ในไดเร็กทอรีย่อย (เช่น https://example.com/pages/robots.txt)

ข้อจำกัดของไฟล์ Robots.txt

ข้อจำกัดของไฟล์ robots.txt มีดังนี้

- เครื่องมือค้นหาทั้งหมดไม่สนับสนุน Robots.txt: ไฟล์ Robots.txt ไม่สามารถบังคับให้โปรแกรมรวบรวมข้อมูลเข้าชมไซต์ของคุณได้ มันขึ้นอยู่กับโปรแกรมรวบรวมข้อมูลที่จะติดตามพวกเขา แม้ว่า Googlebot และโปรแกรมรวบรวมข้อมูลเว็บอื่นๆ ที่น่าเชื่อถือจะปฏิบัติตามคำแนะนำในไฟล์ robots.txt แต่โปรแกรมรวบรวมข้อมูลอื่นๆ อาจไม่ปฏิบัติตาม

- โปรแกรมรวบรวมข้อมูลที่แตกต่างกันตีความไวยากรณ์ต่างกัน: แม้ว่าสไปเดอร์เว็บที่มีชื่อเสียงจะปฏิบัติตามคำสั่งในไฟล์ robots.txt แต่โปรแกรมรวบรวมข้อมูลแต่ละรายการอาจตีความคำสั่งต่างกัน

- หน้าที่ไม่อนุญาตสามารถจัดทำดัชนีได้หากมีการเชื่อมโยงไปยังหน้าอื่น: แม้ว่า Google จะไม่รวบรวมข้อมูลหรือจัดทำดัชนีเนื้อหาที่ไฟล์ robots.txt ได้จำกัด แต่อาจค้นหาและจัดทำดัชนี URL ที่ไม่อนุญาตหากมีการเชื่อมโยงจากตำแหน่งอื่นบนอินเทอร์เน็ต

ด้วยเหตุนี้ ที่อยู่ URL และข้อมูลอื่นๆ ที่เปิดเผยต่อสาธารณะ เช่น anchor text ในลิงก์ที่ไปยังหน้าอาจยังคงปรากฏในผลการค้นหาของ Google

คำถามที่พบบ่อย

ไตรมาสที่ 1 robots.txt ไปที่ไซต์ใด

ตอบ: โดยทั่วไป ไฟล์ robots.txt จะอยู่ในไดเรกทอรีรากของเว็บไซต์ของคุณ แต่ไฟล์สามารถอยู่ที่ใดก็ได้ในเว็บไซต์ของคุณที่คุณต้องการจำกัดการเข้าถึง

ไตรมาสที่ 2 ไฟล์ robots.txt จำเป็นหรือไม่

ตอบ: คำตอบสั้นๆ คือ ไม่ ไฟล์ robots.txt ไม่จำเป็นสำหรับเว็บไซต์ หากบ็อตเข้าชมเว็บไซต์ของคุณและไม่มีไฟล์ robots.txt บอทจะรวบรวมข้อมูลและจัดทำดัชนีหน้าเว็บตามปกติ จำเป็นต้องใช้ไฟล์ .txt เฉพาะในกรณีที่คุณต้องการควบคุมสิ่งที่จะรวบรวมข้อมูลได้มากขึ้นเท่านั้น

ไตรมาสที่ 3 robots.txt ปลอดภัยหรือไม่

คำตอบ: ไฟล์ robots.txt ไม่ใช่ความเสี่ยงด้านความปลอดภัยในตัวของมันเอง และการใช้งานอย่างเหมาะสมอาจแสดงถึงแนวปฏิบัติที่ดีด้วยเหตุผลที่ไม่เกี่ยวกับความปลอดภัย คุณไม่ควรคาดหวังว่าเว็บโรบ็อตทั้งหมดจะปฏิบัติตามคำแนะนำในไฟล์

ไตรมาสที่ 4 การเข้าใช้ robots.txt ผิดกฎหมายหรือไม่

ตอบ: ไฟล์ robots.txt เป็นใบอนุญาตที่เจ้าของเว็บไซต์บอกเป็นนัย หากคุณทราบไฟล์ robots.txt การขูดไซต์ต่อไปโดยไม่ได้รับอนุญาตอาจถูกมองว่าเป็นการเข้าถึงหรือการแฮ็กโดยไม่ได้รับอนุญาต

Q5. ความล่าช้าในการรวบรวมข้อมูลใน robots txt คืออะไร

ตอบ: คำสั่งการชะลอการรวบรวมข้อมูลเป็นวิธีที่บอกให้โปรแกรมรวบรวมข้อมูลทำงานช้าลงเพื่อไม่ให้เว็บเซิร์ฟเวอร์ทำงานหนักเกินไป

บทสรุป

Robots.txt เป็นไฟล์ธรรมดาที่มีพลังมหาศาล ถ้ารู้วิธีใช้ดีๆ ก็สามารถช่วย SEO ได้ การสร้างประเภทที่ถูกต้องของ robots.txt หมายความว่าคุณกำลังปรับปรุง SEO และประสบการณ์ผู้ใช้ของคุณด้วย

บอทจะสามารถนำเสนอเนื้อหาของคุณใน SERP ในแบบที่คุณต้องการให้มองเห็นได้หากคุณอนุญาตให้รวบรวมข้อมูลสิ่งที่ถูกต้อง

หากคุณต้องการเรียนรู้เพิ่มเติมเกี่ยวกับ SEO และปัจจัยสำคัญ ลองดูบล็อกอื่นๆ ของ Scalenut