การตรวจสอบ SEO ทางเทคนิค 11 ขั้นตอนที่รวดเร็วและสกปรกสำหรับเว็บไซต์โดยรวม Heath

เผยแพร่แล้ว: 2020-02-27SEO ทางเทคนิคมีความสำคัญเพราะเป็นจุดเริ่มต้นของโครงการใดๆ จากมุมมองของผู้เชี่ยวชาญ SEO ทุกเว็บไซต์เป็นโครงการใหม่ เว็บไซต์ควรมีรากฐานที่มั่นคงเพื่อให้ได้ผลลัพธ์ที่ดีและเข้าถึง KPI ที่สำคัญที่สุดใน SEO เช่นการจัดอันดับ

ทุกครั้งที่ฉันเริ่มโครงการใหม่ สิ่งแรกที่ฉันทำคือการตรวจสอบ SEO ด้านเทคนิค ส่วนใหญ่แล้ว การแก้ไขปัญหาทางเทคนิคจะได้ผลลัพธ์ที่น่าอัศจรรย์ทันทีที่มีการรวบรวมข้อมูลเว็บไซต์อีกครั้ง

เป็นเรื่องตลกสำหรับฉันเมื่อมีคนพูดถึงเนื้อหาและเนื้อหาเพิ่มเติม แต่พวกเขาไม่ได้พูดอะไรเกี่ยวกับเทคนิค SEO สิ่งหนึ่งที่แน่นอนคือความสมบูรณ์ของเว็บไซต์และเทคนิค SEO เป็นสองสิ่งที่สำคัญที่จะมีความสำคัญในปี 2020 ฉันไม่ได้หมายความว่าเนื้อหานั้นไม่สำคัญ มี แต่หากไม่ได้แก้ไขปัญหาทางเทคนิคบนเว็บไซต์ ฉันไม่คิดว่าเนื้อหาจะให้ผลลัพธ์ได้

ฉันเคยเห็นกรณีที่หน้าที่สำคัญถูกบล็อกโดยคำสั่งในไฟล์ robots.txt หรือหน้าหมวดหมู่หรือบริการที่สำคัญที่สุดถูกทำลายหรือถูกบล็อกโดยเมตาโรบ็อต เช่น noindex, nofollow เป็นไปได้อย่างไรที่จะประสบความสำเร็จโดยไม่จัดลำดับความสำคัญโดยแก้ไขปัญหาเหล่านี้

เป็นเรื่องน่าประหลาดใจที่เห็นจำนวน SEO ที่ไม่ทราบวิธีระบุปัญหาด้านเทคโนโลยีเพื่อรายงานให้ผู้เชี่ยวชาญด้านการพัฒนาเว็บไซต์แก้ไข ฉันจำได้ครั้งหนึ่งขณะทำงานในสายงานบริษัท ฉันได้สร้างใบตรวจสอบรายการตรวจสอบ Tech SEO เพื่อให้ทีมของฉันใช้ ในขณะนั้น ฉันรู้ว่าการมีแผ่นงานแก้ไขด่วนแบบนี้สามารถช่วยทีมได้อย่างมหาศาลและสร้างกำลังใจอย่างรวดเร็วให้กับลูกค้า นั่นเป็นเหตุผลที่ฉันพิจารณาถึงความสำคัญสูงสุดในการลงทุนในเครื่องมือ/ซอฟต์แวร์ที่สามารถช่วยคุณในการวินิจฉัย SEO ด้านเทคนิคและคำแนะนำ

มาเริ่มขั้นตอนปฏิบัติจริงเกี่ยวกับวิธีการตรวจสอบ SEO เทคโนโลยีอย่างรวดเร็ว ซึ่งจะสร้างความแตกต่างอย่างมาก นี่คือการออกกำลังกายสั้นๆ ที่จะใช้เวลาทำประมาณหนึ่งชั่วโมง แม้ว่าคุณจะไม่ใช่มืออาชีพก็ตาม สำหรับฉันโดยใช้เครื่องมือ Tech SEO เช่น OnCrawl เพื่อกรอไปข้างหน้าอย่างรวดเร็วในห้านาทีโดยไม่ต้องทำงานด้วยตนเองทั้งหมดทำให้ชีวิตของฉันง่ายขึ้น

ฉันจะพูดถึงสิ่งสำคัญที่สุดที่ควรตรวจสอบเมื่อดำเนินการตรวจสอบ SEO ด้านเทคนิค มีหลายสิ่งที่เราสามารถตรวจสอบปัญหาในหน้าได้ แต่ฉันต้องการเน้นเฉพาะสิ่งที่จะสร้างปัญหาการจัดทำดัชนีและการรวบรวมข้อมูลโดยสิ้นเปลืองงบประมาณ การจัดลำดับความสำคัญนี้เป็นวิธีการเพื่อให้แน่ใจว่า Googlebot จะรวบรวมข้อมูลหน้าที่สำคัญที่สุด

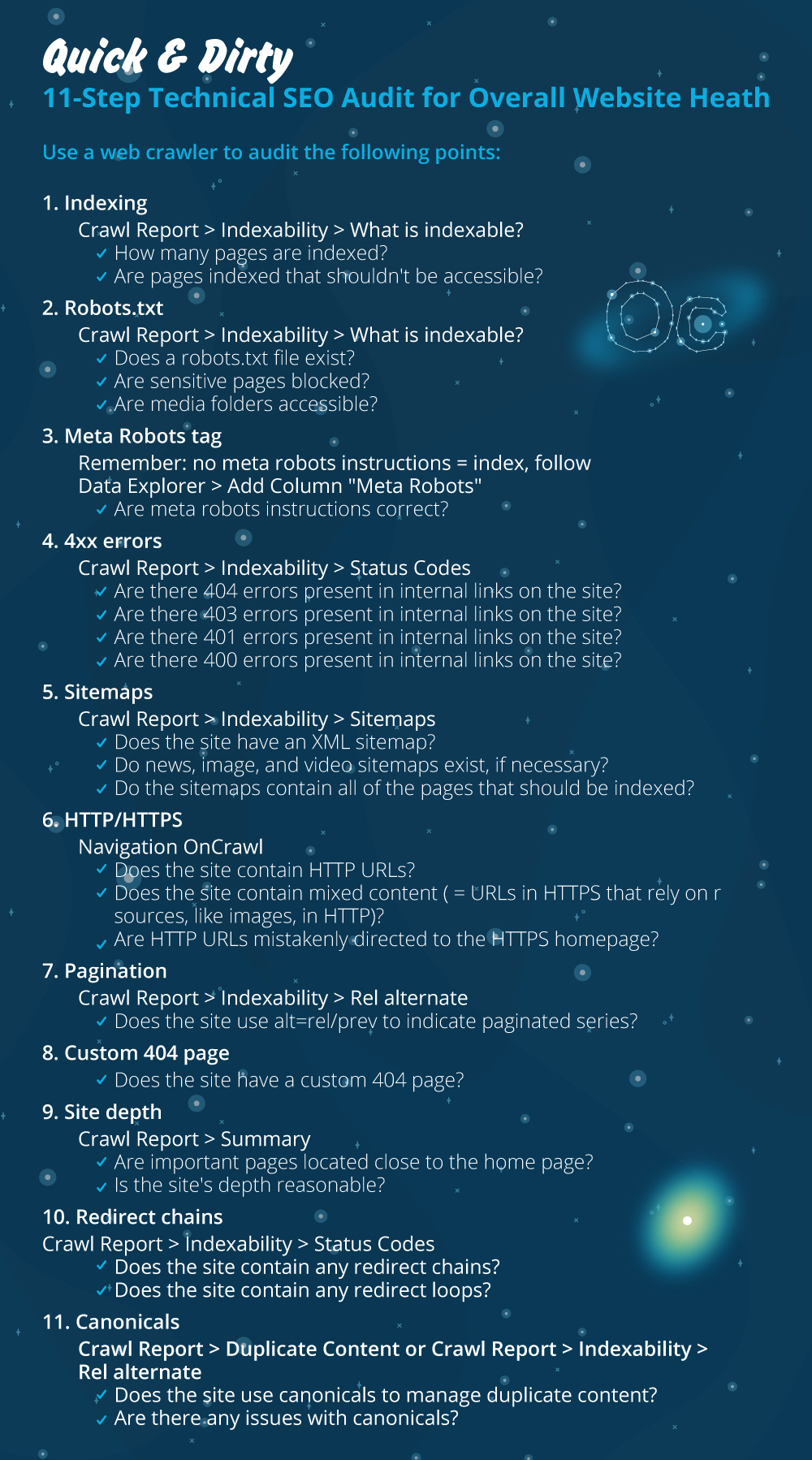

- การจัดทำดัชนี

- ไฟล์ Robots.txt

- แท็กโรบ็อต Meta

- ข้อผิดพลาด 4xx

- แผนผังเว็บไซต์

- HTTP/HTTPS (ปัญหาด้านความปลอดภัยของเว็บไซต์ เนื้อหาแบบผสม และเนื้อหาที่ซ้ำกัน)

- การแบ่งหน้า

- 404 หน้า

- ความลึกและโครงสร้างของไซต์

- โซ่เปลี่ยนเส้นทางยาว

- การนำแท็ก Canonical ไปใช้

1) การจัดทำดัชนี

นี่เป็นสิ่งแรกที่ต้องตรวจสอบ หลายครั้งที่การจัดทำดัชนีอาจได้รับผลกระทบจากการกำหนดค่าปลั๊กอินหรือข้อผิดพลาดเล็กๆ น้อยๆ แต่ผลกระทบต่อความสามารถในการค้นหาอาจมีขนาดใหญ่ เนื่องจากในปัจจุบันมีหน้าเว็บที่จัดทำดัชนีมากกว่า 6.16 พันล้านหน้า คุณต้องเข้าใจว่าเสิร์ชเอ็นจิ้นใดๆ ก็ตามกำลังพยายาม และแม้แต่ Google ก็จำเป็นต้องจัดลำดับความสำคัญของหน้าที่เกี่ยวข้องมากที่สุดสำหรับประสบการณ์ของผู้ใช้ ถ้าคุณไม่คิดที่จะทำสิ่งต่างๆ ให้ Googlebot ง่ายขึ้น คู่แข่งของคุณจะทำให้สำเร็จและได้รับความไว้วางใจมากขึ้นที่มาพร้อมกับเว็บไซต์ที่ดี

เมื่อมีปัญหาในการจัดทำดัชนี ปัญหาสุขภาพเว็บไซต์ของคุณจะสะท้อนให้เห็นการสูญเสียการเข้าชมที่เกิดขึ้นเอง กระบวนการสร้างดัชนีหมายความว่าเสิร์ชเอ็นจิ้นรวบรวมข้อมูลหน้าเว็บและจัดระเบียบข้อมูลที่เสนอใน SERP ในภายหลัง ผลลัพธ์ขึ้นอยู่กับความเกี่ยวข้องสำหรับความตั้งใจของผู้ใช้ หากหน้าเว็บไม่สามารถหรือมีปัญหาในการรวบรวมข้อมูล หน้าอื่นที่อยู่ในช่องเดียวกันจะได้เปรียบกว่า

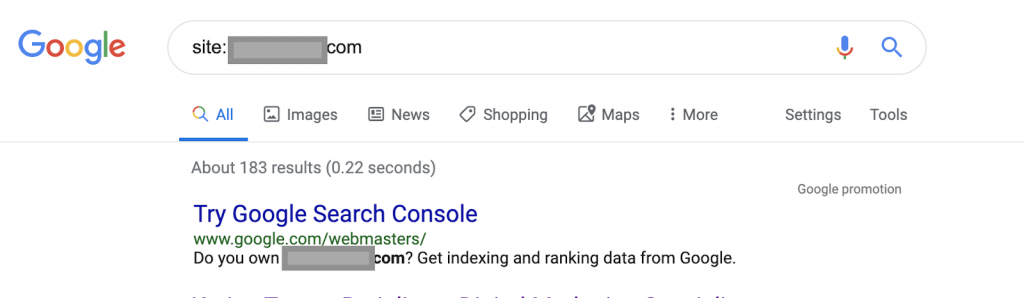

การใช้ตัวดำเนินการค้นหาเช่น:

เว็บไซต์: www.abc.com

ข้อความค้นหาจะส่งกลับ 183 หน้าที่จัดทำดัชนีโดย Google นี่เป็นการประมาณคร่าวๆ ของจำนวนหน้าที่ Google จัดทำดัชนี คุณสามารถตรวจสอบ Google Search Console สำหรับจำนวนที่แน่นอนได้

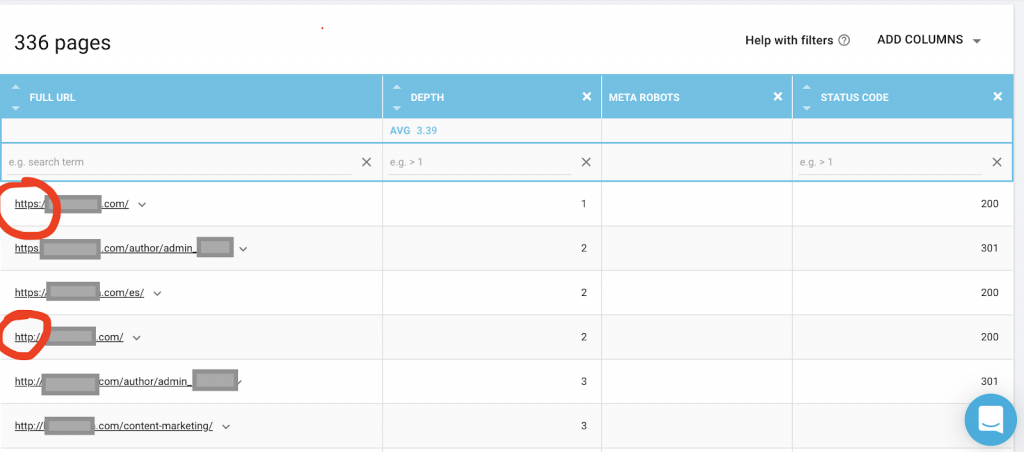

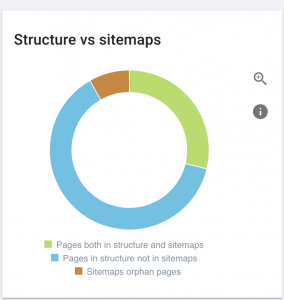

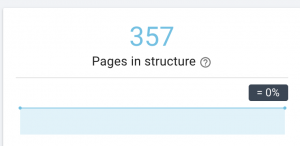

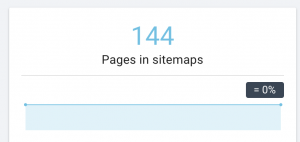

คุณควรใช้โปรแกรมรวบรวมข้อมูลเว็บ เช่น OnCrawl เพื่อแสดงรายการหน้าเว็บทั้งหมดที่ Google สามารถเข้าถึงได้ ซึ่งแสดงหมายเลขอื่นดังที่คุณเห็นด้านล่าง:

เว็บไซต์นี้มีหน้าที่สามารถรวบรวมข้อมูลได้เกือบสองเท่าของหน้าที่จัดทำดัชนี

ซึ่งอาจเปิดเผยปัญหาเนื้อหาที่ซ้ำกัน หรือแม้แต่ปัญหาเวอร์ชันความปลอดภัยของเว็บไซต์ระหว่างปัญหา HTTP และ HTTPS ฉันจะพูดถึงเรื่องนี้ในบทความนี้

ในกรณีนี้ เว็บไซต์ถูกย้ายจาก HTTP เป็น HTTPS เราเห็นใน OnCrawl ว่าหน้า HTTP ถูกเปลี่ยนเส้นทางแล้ว Googlebot ยังคงเข้าถึงทั้งเวอร์ชัน HTTP และ HTTPS ได้ และอาจรวบรวมข้อมูลหน้าที่ซ้ำกันทั้งหมด แทนที่จะจัดลำดับความสำคัญของหน้าที่สำคัญที่สุดที่เจ้าของต้องการจัดอันดับ ทำให้สิ้นเปลืองงบประมาณในการรวบรวมข้อมูล

ปัญหาทั่วไปอีกประการหนึ่งในบรรดาเว็บไซต์ที่ถูกละเลยหรือเว็บไซต์ขนาดใหญ่ เช่น ไซต์อีคอมเมิร์ซคือปัญหาเนื้อหาแบบผสม ในการสรุปเรื่องยาว ปัญหาจะเกิดขึ้นเมื่อเพจที่มีการรักษาความปลอดภัยของคุณมีทรัพยากร เช่น ไฟล์มีเดีย (บ่อยที่สุด: รูปภาพ) ที่โหลดจากเวอร์ชันที่ไม่ปลอดภัย

วิธีแก้ไข:

คุณสามารถขอให้นักพัฒนาเว็บบังคับให้หน้า HTTP ทั้งหมดเป็นเวอร์ชัน HTTPS และเปลี่ยนเส้นทางที่อยู่ HTTP ไปยัง HTTPS ได้เมื่อใช้รหัสสถานะ 301

สำหรับปัญหาเนื้อหาแบบผสม คุณสามารถตรวจสอบแหล่งที่มาของหน้าได้ด้วยตนเองและค้นหาแหล่งข้อมูลที่โหลดเป็น “src=http://example.com/media/images” ซึ่งแทบจะเป็นไปไม่ได้เลยที่จะทำมันโดยเฉพาะสำหรับเว็บไซต์ขนาดใหญ่ นั่นเป็นเหตุผลที่เราต้องใช้เครื่องมือ SEO ทางเทคนิค

2) ไฟล์ Robots.txt:

ไฟล์ robots.txt จะบอกเจ้าหน้าที่รวบรวมข้อมูลว่าหน้าใดที่พวกเขาไม่ควรรวบรวมข้อมูล คู่มือข้อมูลจำเพาะ Robots.txt ระบุว่ารูปแบบไฟล์ต้องเป็นข้อความธรรมดาที่มีขนาดสูงสุด 500KB

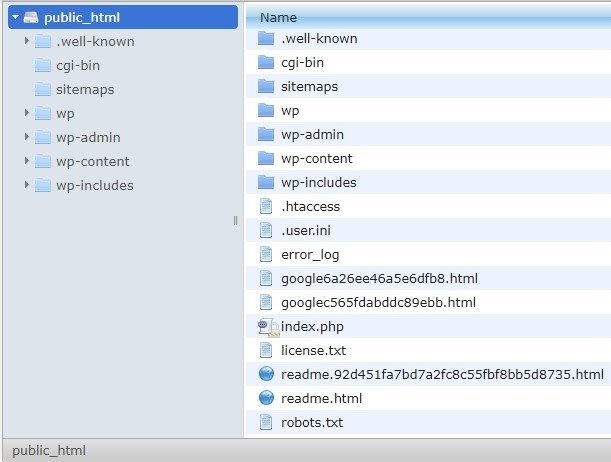

ฉันจะแนะนำให้เพิ่มแผนผังเว็บไซต์ใน robots.txt.file ไม่ใช่ทุกคนที่ทำเช่นนี้ แต่ฉันเชื่อว่าเป็นแนวปฏิบัติที่ดี ต้องวางไฟล์ robots.txt ในเซิร์ฟเวอร์ที่โฮสต์ของคุณใน public_html และไปต่อจากโดเมนราก

เราสามารถใช้คำสั่งในไฟล์ robots.txt เพื่อป้องกันไม่ให้เครื่องมือค้นหารวบรวมข้อมูลหน้าหรือหน้าที่ไม่จำเป็นซึ่งมีข้อมูลที่ละเอียดอ่อน เช่น หน้าผู้ดูแลระบบ เทมเพลต หรือตะกร้าสินค้า (/cart, /checkout, /login, โฟลเดอร์เช่น /tag ที่ใช้ในบล็อก) โดยการเพิ่มหน้าเหล่านี้ในไฟล์ robots.txt

คำแนะนำ : ตรวจสอบให้แน่ใจว่าคุณจะไม่บล็อกโฟลเดอร์ไฟล์มีเดีย เพราะจะเป็นการยกเว้นรูปภาพ วิดีโอ หรือสื่ออื่นๆ ที่โฮสต์เองจากการจัดทำดัชนี สื่อมีความสำคัญมากสำหรับความเกี่ยวข้องของหน้า เช่นเดียวกับการจัดอันดับทั่วไปและการเข้าชมสำหรับรูปภาพหรือวิดีโอ

3) แท็ก Meta Robots

นี่คือโค้ด HTML ส่วนหนึ่งที่สั่งให้เครื่องมือค้นหารวบรวมข้อมูลและจัดทำดัชนีหน้า โดยมีลิงก์ทั้งหมดภายในหน้านั้นหรือไม่ แท็ก HTML จะอยู่ในส่วนหัวของหน้าเว็บของคุณ มีแท็ก HTML ทั่วไป 4 แท็กสำหรับโรบ็อต:

- ไม่ปฏิบัติตาม

- ติดตาม

- ดัชนี

- ไม่มีดัชนี

เมื่อไม่มีแท็ก meta robots ปรากฏ เครื่องมือค้นหาจะติดตามและจัดทำดัชนีเนื้อหาตามค่าเริ่มต้น

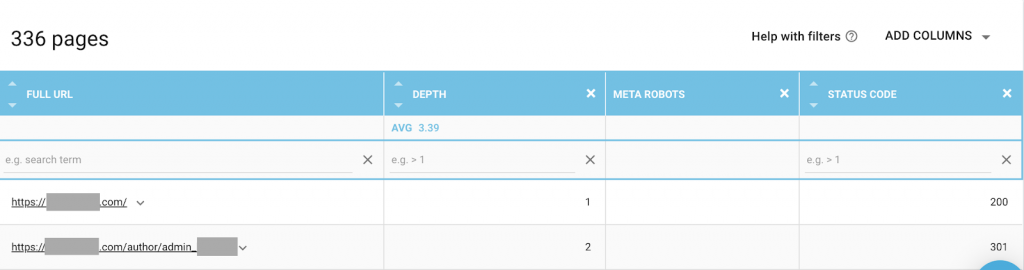

คุณสามารถใช้ชุดค่าผสมที่เหมาะสมกับความต้องการของคุณมากที่สุด ตัวอย่างเช่น โดยใช้ OnCrawl ฉันพบว่า "หน้าผู้เขียน" จากเว็บไซต์นี้ไม่มีเมตาโรบ็อต ซึ่งหมายความว่าตามค่าเริ่มต้น ทิศทางคือ (“ติดตาม ดัชนี”)

นี่ควรเป็น (“noindex, nofollow”)

ทำไม

แต่ละกรณีจะแตกต่างกัน แต่เว็บไซต์นี้เป็นบล็อกส่วนตัวขนาดเล็ก มีผู้เขียนเพียงคนเดียวที่เผยแพร่ในบล็อก และโดเมนคือชื่อของผู้แต่ง ในกรณีนี้ หน้า "ผู้เขียน" จะไม่ให้ข้อมูลเพิ่มเติมแม้ว่าจะสร้างโดยแพลตฟอร์มบล็อกก็ตาม

สถานการณ์อื่นอาจเป็นเว็บไซต์ที่หมวดหมู่ในบล็อกมีความสำคัญ เมื่อเจ้าของต้องการอันดับสำหรับหมวดหมู่บนบล็อกของเขาหรือเธอ เมตาโรบ็อตควรเป็น (“ติดตาม จัดทำดัชนี”) หรือค่าเริ่มต้นในหน้าหมวดหมู่

ในสถานการณ์ที่แตกต่างกัน สำหรับเว็บไซต์ขนาดใหญ่และมีชื่อเสียงซึ่งผู้เชี่ยวชาญ SEO รายใหญ่เขียนบทความที่ตามด้วยชุมชน ชื่อผู้เขียนใน Google ทำหน้าที่เป็นแบรนด์ ในกรณีนี้ คุณอาจต้องการสร้างดัชนีชื่อผู้แต่ง

อย่างที่คุณเห็น เมตาโรบ็ อตสามารถใช้ได้หลายวิธี

วิธีแก้ไข:

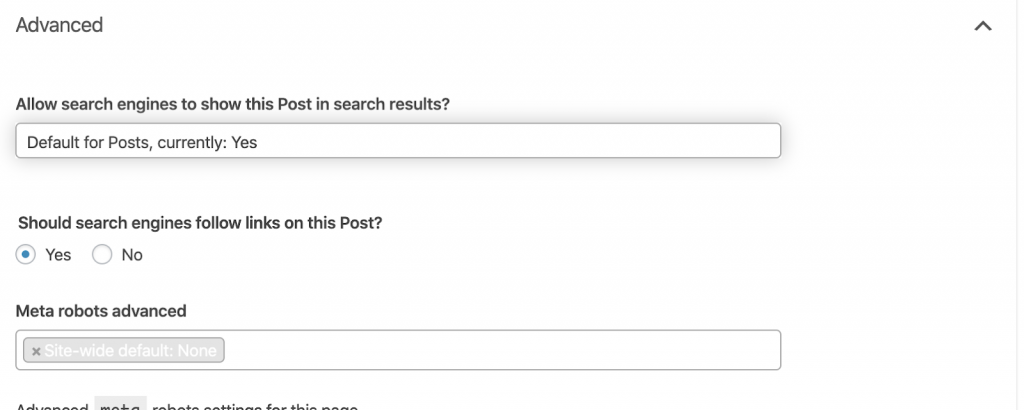

ขอให้นักพัฒนาเว็บเปลี่ยนเมตาแท็กโรบ็อตตามที่คุณต้องการ ในกรณีข้างต้นสำหรับเว็บไซต์ขนาดเล็ก ฉันสามารถทำได้โดยไปที่แต่ละหน้าแล้วเปลี่ยนด้วยตนเอง หากคุณใช้ WordPress คุณสามารถเปลี่ยนได้จากการตั้งค่า RankMath หรือ Yoast

4) ข้อผิดพลาด 4xx:

นี่เป็นข้อผิดพลาดในฝั่งไคลเอ็นต์ และอาจเป็น 401, 403 และ 404

- 404 ไม่พบหน้า:

ข้อผิดพลาดนี้เกิดขึ้นเมื่อไม่มีหน้าเว็บตามที่อยู่ URL ที่จัดทำดัชนี อาจถูกย้ายหรือลบ และที่อยู่เก่าไม่ได้รับการเปลี่ยนเส้นทางอย่างถูกต้องโดยใช้ฟังก์ชันเว็บเซิร์ฟเวอร์ 301 ข้อผิดพลาด 404 เป็นประสบการณ์ที่ไม่ดีสำหรับผู้ใช้และแสดงถึงปัญหา SEO ทางเทคนิคที่ควรแก้ไข เป็นสิ่งที่ดีที่จะตรวจสอบ 404 บ่อยๆ และแก้ไข และไม่ปล่อยให้พวกเขาถูกลองซ้ำแล้วซ้ำอีกสำหรับเจ้าหน้าที่รวบรวมข้อมูลที่สิ้นเปลืองงบประมาณ

วิธีแก้ไข:

เราจำเป็นต้องค้นหาที่อยู่ที่ส่งคืน 404 และแก้ไขโดยใช้การเปลี่ยนเส้นทาง 301 หากเนื้อหายังคงมีอยู่ หรือหากเป็นรูปภาพ ก็สามารถแทนที่ด้วยไฟล์ใหม่ที่มีชื่อไฟล์เดียวกันได้

- 401 ไม่ได้รับอนุญาต

นี่เป็นปัญหาการอนุญาต ข้อผิดพลาด 401 มักเกิดขึ้นเมื่อต้องมีการตรวจสอบสิทธิ์ เช่น ชื่อผู้ใช้และรหัสผ่าน

วิธีแก้ไข:

มีสองตัวเลือก: ตัวเลือกแรกคือการบล็อกหน้าจากเครื่องมือค้นหาโดยใช้ robots.txt ตัวเลือกที่สองคือการลบข้อกำหนดการตรวจสอบสิทธิ์

- 403 ต้องห้าม

ข้อผิดพลาดนี้คล้ายกับข้อผิดพลาด 401 ข้อผิดพลาด 403 เกิดขึ้นเนื่องจากหน้ามีลิงก์ที่ไม่สามารถเข้าถึงได้โดยสาธารณะ

วิธีแก้ไข:

เปลี่ยนข้อกำหนดในเซิร์ฟเวอร์เพื่ออนุญาตให้เข้าถึงหน้า (เฉพาะในกรณีที่เป็นข้อผิดพลาด) หากคุณต้องการเข้าถึงหน้านี้ไม่ได้ ให้ลบลิงก์ภายในและภายนอกทั้งหมดออกจากหน้า

- 400 คำขอไม่ถูกต้อง

กรณีนี้เกิดขึ้นเมื่อเบราว์เซอร์ไม่สามารถสื่อสารกับเว็บเซิร์ฟเวอร์ได้ ข้อผิดพลาดนี้มักเกิดขึ้นกับไวยากรณ์ URL ที่ไม่ถูกต้อง

วิธีแก้ไข:

ค้นหาลิงก์ไปยัง URL เหล่านี้และแก้ไขไวยากรณ์ หากไม่สามารถแก้ไขได้ คุณจะต้องติดต่อนักพัฒนาเว็บเพื่อแก้ไข

หมายเหตุ: เราพบข้อผิดพลาด 400 รายการด้วยเครื่องมือหรือใน Google Console

5) แผนผังเว็บไซต์

แผนผังเว็บไซต์คือรายการ URL ทั้งหมดที่เว็บไซต์มีอยู่ การมีแผนผังเว็บไซต์ช่วยเพิ่มความสามารถในการค้นหา เนื่องจากช่วยให้โปรแกรมรวบรวมข้อมูลค้นหาและทำความเข้าใจเนื้อหาของคุณ

เรามีแผนผังเว็บไซต์ประเภทต่างๆ และเราจำเป็นต้องตรวจสอบให้แน่ใจว่าแผนผังเว็บไซต์ทั้งหมดอยู่ในสภาพดี

แผนผังเว็บไซต์ที่เราควรมีคือ:

- แผนผังเว็บไซต์ HTML: นี่จะอยู่ในเว็บไซต์ของคุณและจะช่วยให้ผู้ใช้นำทางและค้นหาหน้าต่างๆ ในเว็บไซต์ของคุณ

- แผนผังเว็บไซต์ XML: นี่คือไฟล์ที่จะช่วยให้เสิร์ชเอ็นจิ้นสามารถรวบรวมข้อมูลเว็บไซต์ของคุณได้ (ตามแนวทางปฏิบัติที่ดีที่สุด ควรรวมไว้ในไฟล์ robots.txt ของคุณ)

- แผนผังเว็บไซต์วิดีโอ XML: เหมือนกับด้านบน

- แผนผังเว็บไซต์ของรูปภาพ XML: เหมือนกับด้านบน ขอแนะนำให้สร้างแผนผังเว็บไซต์แยกต่างหากสำหรับรูปภาพ วิดีโอ และเนื้อหา

สำหรับเว็บไซต์ขนาดใหญ่ ขอแนะนำให้มีแผนผังเว็บไซต์หลายรายการเพื่อให้รวบรวมข้อมูลได้ดียิ่งขึ้น เนื่องจากแผนผังเว็บไซต์ไม่ควรมี URL มากกว่า 50,000 รายการ

เว็บไซต์นี้มีปัญหาแผนผังเว็บไซต์

เราแก้ไขอย่างไร:

เราแก้ไขปัญหานี้โดยสร้างแผนผังเว็บไซต์ต่างๆ สำหรับเนื้อหา รูปภาพ และวิดีโอ จากนั้น เราส่งผ่าน Google Search Console และสร้างแผนผังเว็บไซต์ HTML สำหรับเว็บไซต์ด้วย เราไม่ต้องการนักพัฒนาเว็บสำหรับสิ่งนี้ เราสามารถใช้เครื่องมือออนไลน์ฟรีเพื่อสร้างแผนผังเว็บไซต์

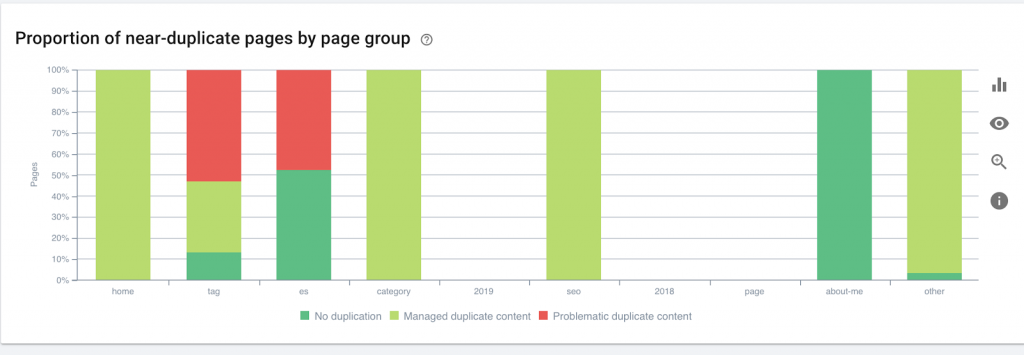

6) HTTP/HTTPS (เนื้อหาที่ซ้ำกัน)

เว็บไซต์หลายแห่งมีปัญหาเหล่านี้จากการโยกย้ายจาก HTTP เป็น HTTPS ในกรณีนี้ เว็บไซต์จะแสดงเวอร์ชัน HTTP และ HTTPS ในเครื่องมือค้นหา ผลที่ตามมาของปัญหาทางเทคนิคทั่วไปนี้ การจัดอันดับจึงลดลง ปัญหาเหล่านี้ยังสร้างปัญหาเนื้อหาที่ซ้ำกัน

![]()

วิธีแก้ไข:

ขอให้นักพัฒนาเว็บแก้ไขปัญหานี้โดยบังคับให้ HTTP ทั้งหมดเป็น HTTPS

หมายเหตุ : อย่าเปลี่ยนเส้นทาง HTTP ทั้งหมดไปยังโฮมเพจ HTTPS เพราะจะทำให้เกิดข้อผิดพลาด soft 404 (คุณควรพูดสิ่งนี้กับนักพัฒนาเว็บ จำไว้ว่าพวกเขาไม่ใช่ SEO)

7) การแบ่งหน้า

นี่คือการใช้แท็ก HTML ("rel = prev" และ "rel = next") ที่สร้างความสัมพันธ์ระหว่างหน้า และแสดงเครื่องมือค้นหาว่าเนื้อหาที่นำเสนอในหน้าต่างๆ ควรระบุหรือเกี่ยวข้องกับหน้าเดียว การแบ่งหน้าใช้เพื่อจำกัดเนื้อหาสำหรับ UX และน้ำหนักของหน้าสำหรับส่วนทางเทคนิค โดยให้มีขนาดไม่เกิน 3MB เราสามารถใช้เครื่องมือฟรีเพื่อตรวจสอบเลขหน้า

การแบ่งหน้าควรมีการอ้างอิงในตัวเองและระบุ "rel = prev" และ "rel = next" ข้อมูลที่ซ้ำกันเพียงอย่างเดียวคือชื่อเมตาและคำอธิบายเมตา แต่นักพัฒนาสามารถเปลี่ยนแปลงสิ่งนี้เพื่อสร้างอัลกอริธึมขนาดเล็กได้ ดังนั้นทุกหน้าจะมีการสร้างชื่อเมตาและคำอธิบายเมตา

วิธีแก้ไข:

ขอให้นักพัฒนาเว็บติดตั้งแท็ก HTML ที่มีการแบ่งหน้าด้วยแท็ก self-canonical

โปรแกรมรวบรวมข้อมูล SEO Oncrawl

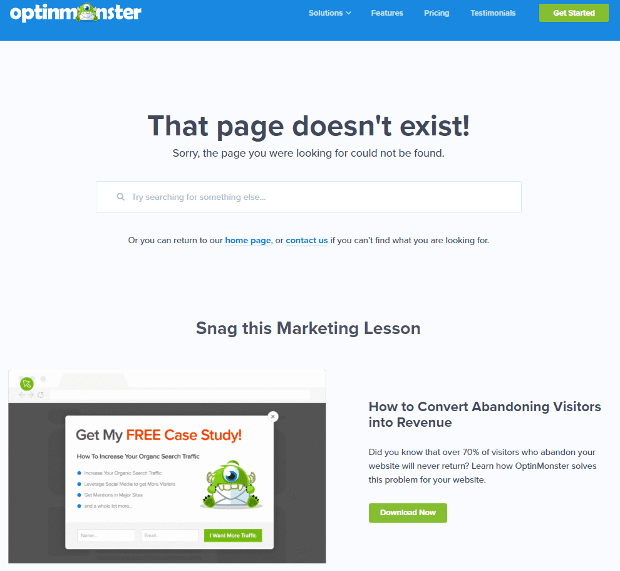

8) กำหนดเอง 404 ไม่พบหน้า

การตอบสนอง 404 ตามที่เราพูดถึงก่อนหน้านี้คือข้อผิดพลาด " ไม่พบ " ที่นำผู้ใช้ไปยังลิงก์เสียหรือหน้าที่ไม่มีอยู่ นี่เป็นโอกาสในการเปลี่ยนเส้นทางผู้ใช้ไปยังที่ที่ถูกต้อง มีตัวอย่างที่ดีของหน้า 404 ที่กำหนดเอง นี่คือสิ่งที่ต้องมี

นี่คือตัวอย่างหน้าที่กำหนดเอง 404 ที่ยอดเยี่ยม:

วิธีแก้ไข:

สร้างหน้า 404 ที่กำหนดเอง: ลองนึกถึงสิ่งที่น่าทึ่งที่จะเพิ่มเข้าไป ทำให้ข้อผิดพลาดนี้เป็นโอกาสสำหรับธุรกิจของคุณ

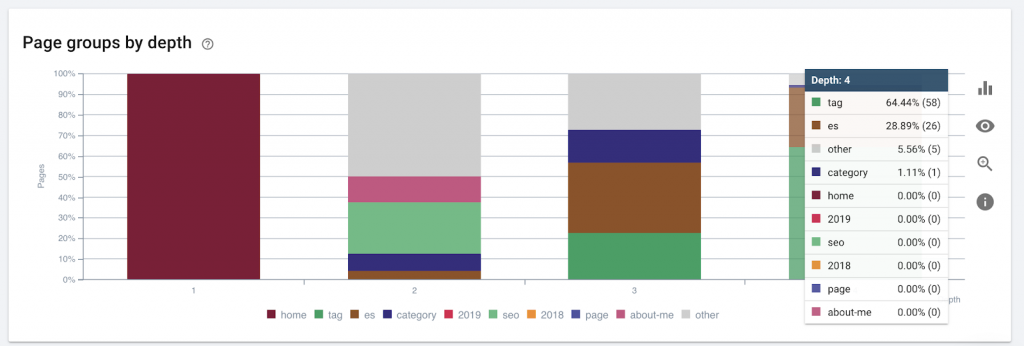

9) ความลึกของไซต์/โครงสร้าง

ความลึกของหน้าคือจำนวนคลิกที่หน้าของคุณตั้งอยู่จากโดเมนราก John Mueller จาก Google กล่าวว่า "หน้าที่ใกล้กับหน้าแรกมีน้ำหนักมากกว่า" ตัวอย่างเช่น สมมติว่าหน้านี้จำเป็นต้องมีการนำทางต่อไปนี้จึงจะสามารถเข้าถึงได้:

หน้า "พรม" อยู่ห่างจากหน้าแรก 4 คลิก ขอแนะนำไม่ให้มีหน้าเว็บอยู่ห่างจากบ้านเกินกว่า 4 คลิก เนื่องจากเครื่องมือค้นหามีปัญหาในการรวบรวมข้อมูลหน้าเว็บที่ลึกกว่านั้น

กราฟิกนี้แสดงกลุ่มเพจตามความลึก ช่วยให้เราเข้าใจว่าโครงสร้างของเว็บไซต์จำเป็นต้องทำใหม่หรือไม่

วิธีแก้ไข:

หน้าที่สำคัญที่สุดควรอยู่ใกล้กับหน้าแรกสำหรับ UX มากที่สุด เพื่อให้เข้าถึงได้ง่ายโดยผู้ใช้ และเพื่อโครงสร้างเว็บไซต์ที่ดีขึ้น เป็นสิ่งสำคัญมากที่จะต้องพิจารณาเรื่องนี้ในขณะที่สร้างโครงสร้างเว็บไซต์หรือปรับโครงสร้างเว็บไซต์

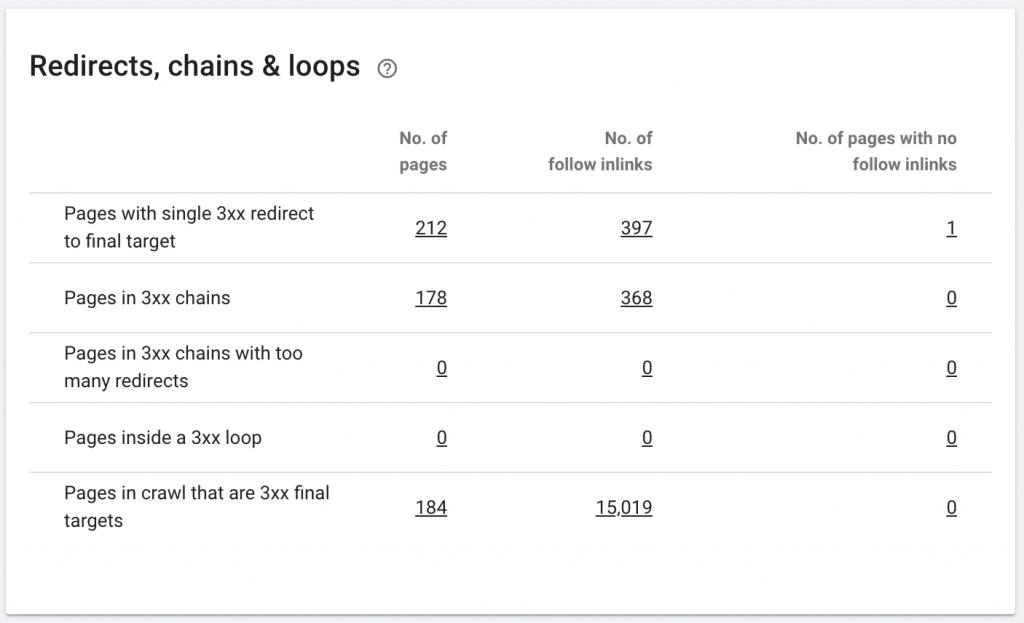

10. เปลี่ยนเส้นทางโซ่

ห่วงโซ่การเปลี่ยนเส้นทางคือเมื่อมีชุดของการเปลี่ยนเส้นทางเกิดขึ้นระหว่าง URL กลุ่มการเปลี่ยนเส้นทางเหล่านี้อาจสร้างการวนซ้ำ นอกจากนี้ยังนำเสนอปัญหาต่อ Googlebot และทำให้เสียงบประมาณในการรวบรวมข้อมูล

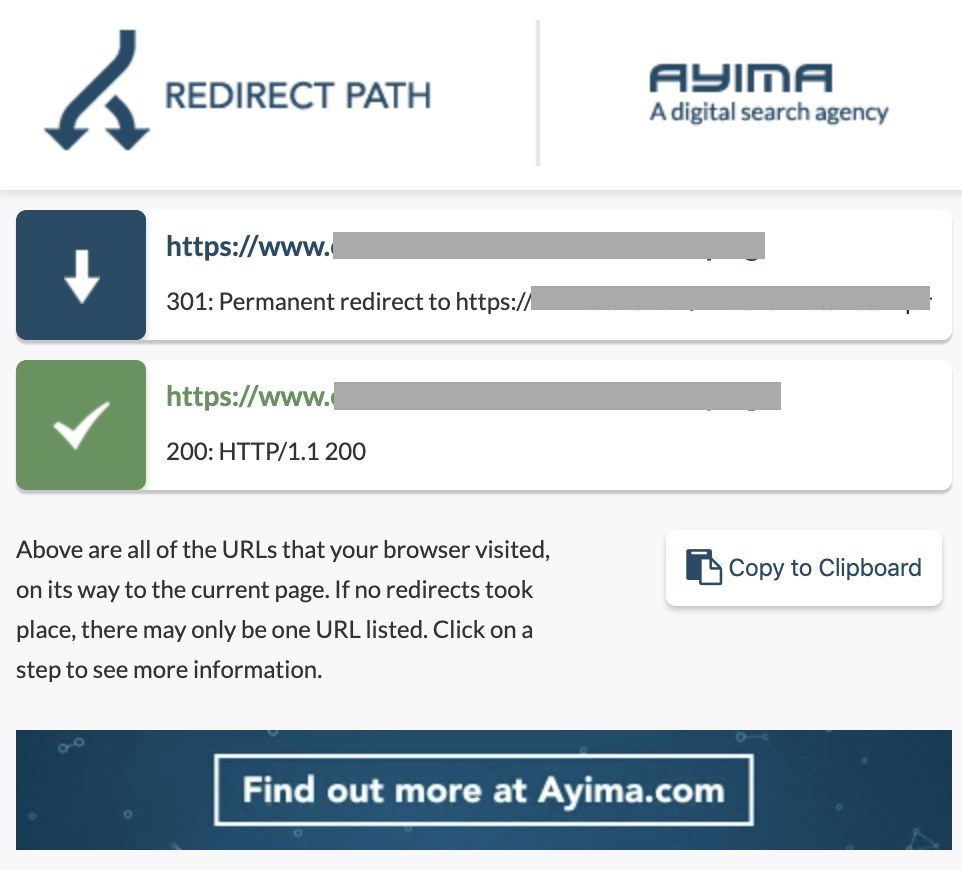

เราสามารถระบุกลุ่มของการเปลี่ยนเส้นทางได้โดยใช้เส้นทางการเปลี่ยนเส้นทางส่วนขยายของ Chrome หรือใน OnCrawl

วิธีแก้ไข:

การแก้ไขปัญหานี้ง่ายมากหากคุณใช้งานเว็บไซต์ WordPress เพียงไปที่การเปลี่ยนเส้นทางและมองหาเชน - ลบลิงก์ทั้งหมดที่เกี่ยวข้องกับเชนหากการเปลี่ยนแปลงเหล่านั้นเกิดขึ้นมากกว่า 2-3 เดือนที่ผ่านมาและปล่อยให้เปลี่ยนเส้นทางล่าสุดไปยัง URL ปัจจุบัน นักพัฒนาเว็บสามารถช่วยเรื่องนี้ได้ด้วยการทำการเปลี่ยนแปลงทั้งหมดที่จำเป็นในไฟล์ .htaccess หากจำเป็น คุณสามารถตรวจสอบและเปลี่ยนการเปลี่ยนเส้นทางแบบยาวได้ในปลั๊กอิน SEO ของคุณ

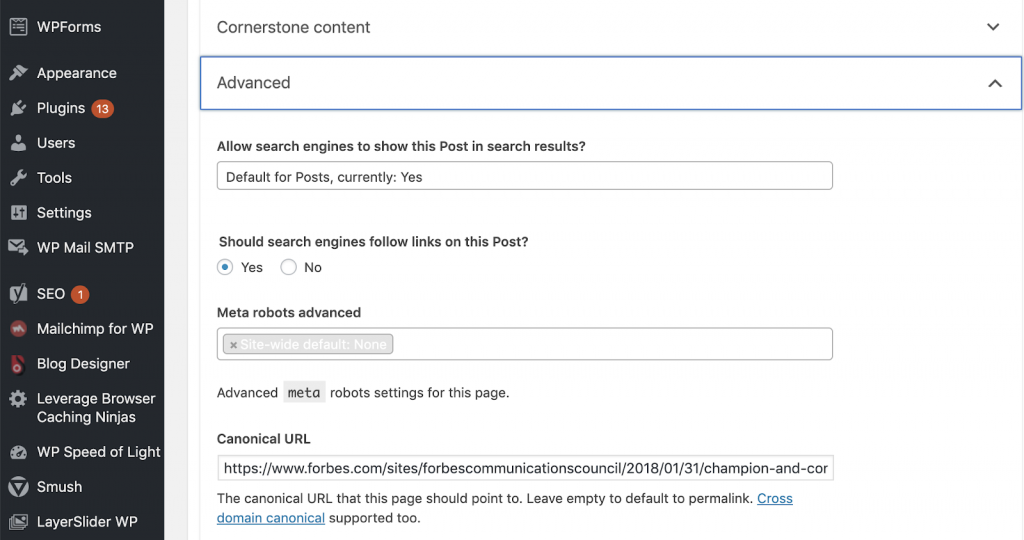

11) Canonicals

แท็กบัญญัติจะบอกเครื่องมือค้นหาว่า URL เป็นสำเนาของหน้าอื่น นี่เป็นปัญหาใหญ่ที่มีอยู่ในเว็บไซต์หลายแห่ง การไม่นำ Canonical ไปใช้อย่างถูกวิธี หรือไม่ใช้เลย จะทำให้เกิดปัญหาด้านเนื้อหาที่ซ้ำกัน

Canonicals มักใช้ในเว็บไซต์อีคอมเมิร์ซที่สามารถพบได้หลายครั้งในหมวดหมู่ต่างๆ เช่น ขนาด สี ฯลฯ

คุณสามารถใช้ OnCrawl เพื่อบอกว่าหน้าเว็บของคุณมีแท็กตามรูปแบบบัญญัติหรือไม่ และมีการติดตั้งใช้งานอย่างถูกต้องหรือไม่ จากนั้นคุณสามารถสำรวจและแก้ไขปัญหาต่างๆ ได้

เราแก้ไขอย่างไร:

เราสามารถแก้ไขปัญหาตามรูปแบบบัญญัติได้โดยใช้ Yoast SEO หากเราทำงานบน WordPress เราไปที่แดชบอร์ดของ WordPress จากนั้นไปที่ Yoast -setting – ขั้นสูง

ดำเนินการตรวจสอบของคุณเอง

SEO ที่ต้องการเริ่มเจาะลึกเกี่ยวกับ SEO ด้านเทคนิคจำเป็นต้องมีคำแนะนำขั้นตอนง่ายๆ ในการปฏิบัติตามเพื่อปรับปรุงประสิทธิภาพ SEO พูดคุยเกี่ยวกับ SEO ด้านเทคนิคกับ John Shehata รองประธานฝ่าย Audience Grow ที่ Conde Nast และผู้ก่อตั้ง NewzDash ในวัน Global Marketing Day ในนิวยอร์คเมื่อเดือนตุลาคม 2019 ที่ผ่านมา

นี่คือสิ่งที่เขาพูดกับฉัน:

“ผู้คนจำนวนมากในอุตสาหกรรม SEO ไม่ได้ใช้เทคนิค ไม่ใช่ว่า SEO ทุกคนจะเข้าใจวิธีการเขียนโค้ดและเป็นการยากที่จะขอให้ผู้คนทำสิ่งนี้ บางบริษัท สิ่งที่พวกเขาทำคือจ้างนักพัฒนาและฝึกอบรมให้พวกเขากลายเป็น SEO เพื่อเติมเต็มช่องว่างด้านเทคนิค SEO”

ในความเห็นของฉัน SEO ที่ไม่มีความรู้เกี่ยวกับโค้ดทั้งหมดยังคงทำได้ดีที่ Tech SEO โดยการรู้วิธีดำเนินการตรวจสอบ ระบุองค์ประกอบหลัก การรายงาน ขอให้นักพัฒนาเว็บใช้งาน และสุดท้ายทดสอบการเปลี่ยนแปลง

พร้อมที่จะเริ่มต้นหรือยัง ดาวน์โหลดรายการตรวจสอบสำหรับประเด็นสำคัญเหล่านี้