บทนำสู่การวิเคราะห์ไฟล์บันทึก SEO

เผยแพร่แล้ว: 2021-05-17การวิเคราะห์บันทึกเป็นวิธีที่ละเอียดที่สุดในการวิเคราะห์ว่าเครื่องมือค้นหาอ่านเว็บไซต์ของเราอย่างไร SEO ทุกวัน นักการตลาดดิจิทัล และผู้เชี่ยวชาญด้านการวิเคราะห์เว็บใช้เครื่องมือที่แสดงไดอะแกรมเกี่ยวกับการเข้าชม พฤติกรรมผู้ใช้ และ Conversion SEO มักจะพยายามทำความเข้าใจว่า Google รวบรวมข้อมูลไซต์ของตนผ่าน Google Search Console อย่างไร

เหตุใด SEO จึงควรวิเคราะห์เครื่องมืออื่นๆ เพื่อตรวจสอบว่าเสิร์ชเอ็นจิ้นอ่านเว็บไซต์อย่างถูกต้องหรือไม่ โอเค มาเริ่มกันที่พื้นฐานกันก่อน

ไฟล์บันทึกคืออะไร?

ล็อกไฟล์เป็นไฟล์ที่เว็บเซิร์ฟเวอร์เขียนแถวสำหรับทุกๆ ทรัพยากรบนเว็บไซต์ที่บอทหรือผู้ใช้ร้องขอ แต่ละแถวมีข้อมูลเกี่ยวกับคำขอ ซึ่งอาจรวมถึง:

IP ผู้โทร, วันที่, ทรัพยากรที่ต้องการ (หน้า, .css, .js, …), ตัวแทนผู้ใช้, เวลาตอบสนอง, ...

แถวจะมีลักษณะดังนี้:

66.249.**.** - - [13/Apr/2021:00:07:31 +0200] "GET /***/x_*** HTTP/1.1" 200 40960 "-" "Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)" "www.***.it" "-"

ความสามารถในการรวบรวมข้อมูลและการปรับปรุง

ทุกหน้ามีสถานะ SEO พื้นฐานสามสถานะ:

- คลานได้

- จัดทำดัชนีได้

- จัดอันดับได้

จากมุมมองของการวิเคราะห์บันทึก เรารู้ว่าบอทจะต้องอ่านหน้าในการจัดทำดัชนี และในทำนองเดียวกัน เนื้อหาที่จัดทำดัชนีแล้วโดยเครื่องมือค้นหาจะต้องถูกรวบรวมข้อมูลซ้ำเพื่ออัปเดตในดัชนีของเครื่องมือค้นหา

ขออภัย ใน Google Search Console เราไม่มีรายละเอียดในระดับนี้: เราสามารถตรวจสอบว่า Googlebot ได้อ่านหน้าบนไซต์กี่ครั้งในช่วงสามเดือนที่ผ่านมา และเว็บเซิร์ฟเวอร์ตอบสนองได้เร็วเพียงใด

เราจะตรวจสอบว่าบอทอ่านหน้าได้อย่างไร? แน่นอนโดยใช้ไฟล์บันทึกและตัววิเคราะห์ไฟล์บันทึก

ทำไม SEO ต้องวิเคราะห์ไฟล์บันทึก

การวิเคราะห์ไฟล์บันทึกช่วยให้ SEO (และผู้ดูแลระบบด้วย) เข้าใจ:

- สิ่งที่บอทอ่าน

- บอทอ่านบ่อยแค่ไหน

- ค่าใช้จ่ายในการรวบรวมข้อมูลในแง่ของเวลาที่ใช้ไป (มิลลิวินาที)

เครื่องมือวิเคราะห์บันทึกช่วยให้สามารถวิเคราะห์บันทึกโดยการจัดกลุ่มข้อมูลตาม "เส้นทาง" ตามประเภทไฟล์ หรือตามเวลาตอบสนอง เครื่องมือวิเคราะห์บันทึกที่ยอดเยี่ยมยังช่วยให้เรารวมข้อมูลที่ได้รับจากไฟล์บันทึกกับแหล่งข้อมูลอื่นๆ เช่น Google Search Console (การคลิก การแสดงผล อันดับเฉลี่ย) หรือ Google Analytics

ตัววิเคราะห์บันทึกการรวบรวมข้อมูล

สิ่งที่ต้องค้นหาในไฟล์บันทึก

ข้อมูลสำคัญชิ้นหนึ่งในไฟล์บันทึกคือสิ่งที่ไม่ได้อยู่ในไฟล์บันทึก จริงๆ ฉันไม่ได้ล้อเล่นนะ ขั้นตอนแรกในการทำความเข้าใจว่าเหตุใดหน้าเว็บจึงไม่ได้รับการจัดทำดัชนีหรือไม่อัปเดตเป็นเวอร์ชันล่าสุดคือการตรวจสอบว่าบอท (เช่น Googlebot) ได้อ่านแล้วหรือไม่

ต่อจากนี้ หากหน้ามีการอัปเดตบ่อยครั้ง การตรวจสอบความถี่ที่บอทอ่านหน้าหรือส่วนของเว็บไซต์อาจเป็นสิ่งสำคัญ

ขั้นตอนต่อไปคือการตรวจสอบว่าหน้าใดที่บอทอ่านบ่อยที่สุด โดยการติดตาม คุณสามารถตรวจสอบว่าหน้าเหล่านี้:

- ควรค่าแก่การอ่านบ่อยๆ

- หรือถูกอ่านบ่อยเพราะบางสิ่งบนหน้าทำให้เกิดการเปลี่ยนแปลงอย่างต่อเนื่อง อยู่เหนือการควบคุม

ตัวอย่างเช่น หลายเดือนก่อน ไซต์ที่ฉันทำงานอยู่มีความถี่ในการอ่านบอทใน URL แปลก ๆ สูงมาก บอทเปิดเผยว่าหน้านี้มาจาก URL ที่สร้างโดยสคริปต์ JS และหน้านี้ถูกประทับตราด้วยค่าดีบักบางอย่างที่เปลี่ยนแปลงทุกครั้งที่โหลดหน้า... หลังจากการเปิดเผยนี้ SEO ที่ดีสามารถค้นหาวิธีแก้ปัญหาที่ถูกต้องได้อย่างแน่นอน รวบรวมข้อมูลหลุมงบประมาณ

งบประมาณการรวบรวมข้อมูล

รวบรวมข้อมูลงบประมาณ? มันคืออะไร? ทุกไซต์มีงบประมาณเชิงเปรียบเทียบที่เกี่ยวข้องกับเครื่องมือค้นหาและบอท ใช่: Google กำหนดประเภทของงบประมาณสำหรับไซต์ของคุณ สิ่งนี้ไม่ได้บันทึกไว้ที่ใด แต่คุณสามารถ "คำนวณ" ได้สองวิธี:

- การตรวจสอบรายงานสถิติการรวบรวมข้อมูลของ Google Search Console

- ตรวจสอบไฟล์บันทึก grepping ( กรอง ) โดย user-agent ที่มี “Googlebot” ( คุณจะได้ผลลัพธ์ที่ดีที่สุดหากคุณแน่ใจว่า user-agent เหล่านี้ตรงกับ IP ของ Google ที่ถูกต้อง… )

งบประมาณการรวบรวมข้อมูลจะเพิ่มขึ้นเมื่อไซต์ได้รับการอัปเดตด้วยเนื้อหาที่น่าสนใจ หรือเมื่อมีการอัปเดตเนื้อหาเป็นประจำ หรือเมื่อไซต์ได้รับลิงก์ย้อนกลับที่ดี

วิธีจัดการงบประมาณการรวบรวมข้อมูลในไซต์ของคุณสามารถจัดการได้โดย:

- ลิงค์ภายใน (ติดตาม / nofollow ด้วย!)

- noindex / บัญญัติ

- robots.txt (ระวัง: สิ่งนี้ “บล็อก” ตัวแทนผู้ใช้)

หน้าซอมบี้

สำหรับฉัน "หน้าซอมบี้" คือหน้าเว็บทั้งหมดที่ไม่มีการเข้าชมแบบออร์แกนิกหรือการเข้าชมจากบอทเป็นระยะเวลานาน แต่มีลิงก์ภายในที่ชี้ไปยังหน้าเหล่านั้น

หน้าประเภทนี้สามารถใช้งบประมาณการรวบรวมข้อมูลมากเกินไป และสามารถรับอันดับของหน้าโดยไม่จำเป็นเนื่องจากลิงก์ภายใน สถานการณ์นี้สามารถแก้ไขได้:

- หากหน้าเหล่านี้มีประโยชน์สำหรับผู้ใช้ที่เข้ามาในไซต์ เราสามารถตั้งค่าให้เป็น noindex และตั้งค่าลิงก์ภายในให้เป็น nofollow ( หรือใช้ disallow robots.txt แต่ระวังด้วย… )

- หากหน้าเหล่านี้ไม่เป็นประโยชน์สำหรับผู้ใช้ที่เข้ามายังไซต์ เราสามารถลบออกได้ (และส่งคืนรหัสสถานะ 410 หรือ 404) และลบลิงก์ภายในทั้งหมด

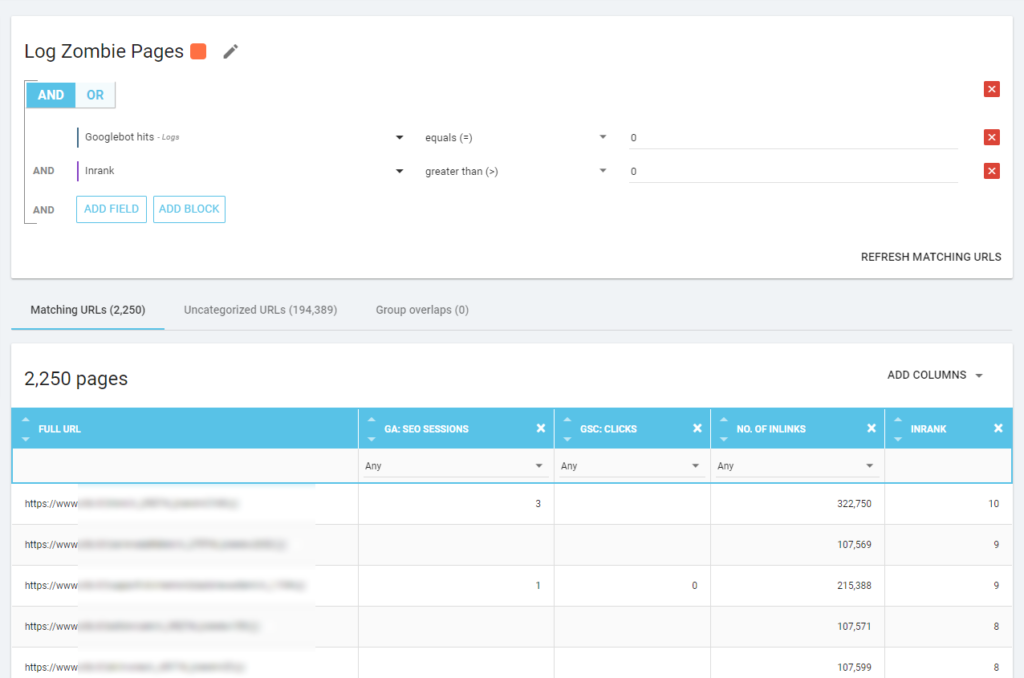

ด้วย Oncrawl เราสามารถสร้าง "รายงานซอมบี้" ตาม:

- การแสดงผล GSC

- คลิก GSC

- เซสชัน GA

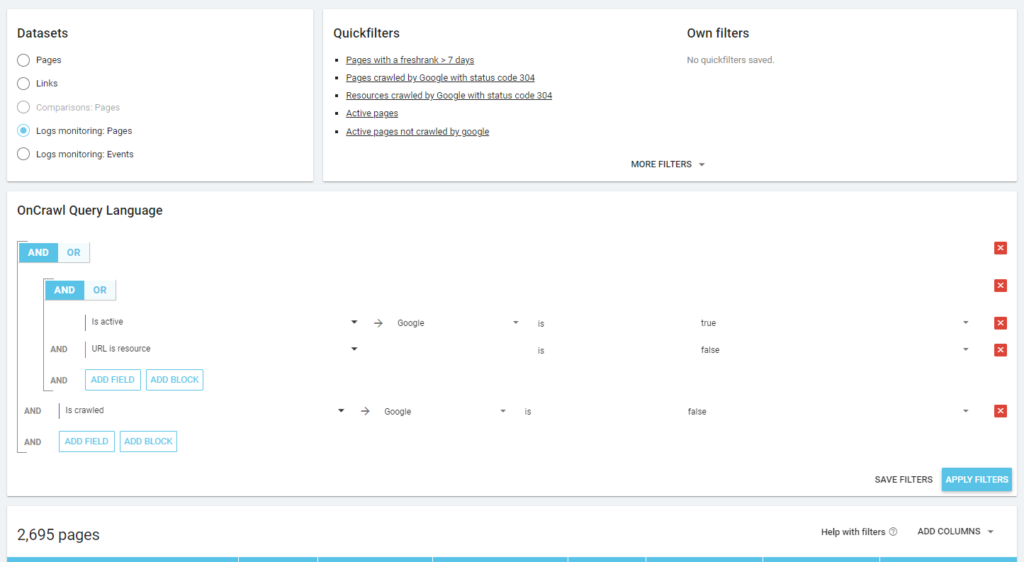

เรายังสามารถใช้บันทึกเหตุการณ์เพื่อเปิดเผยหน้าซอมบี้ เช่น เราสามารถกำหนดตัวกรองเหตุการณ์ 0 ได้ วิธีที่ง่ายที่สุดในการทำเช่นนี้คือการสร้างการแบ่งกลุ่ม ในตัวอย่างด้านล่าง ฉันกรองทุกหน้าด้วยเกณฑ์ต่อไปนี้: ไม่มี Googlebot hits แต่มีอันดับ (ซึ่งหมายความว่าหน้าเหล่านี้มีลิงก์ภายในที่ชี้ไปที่หน้าเหล่านี้)

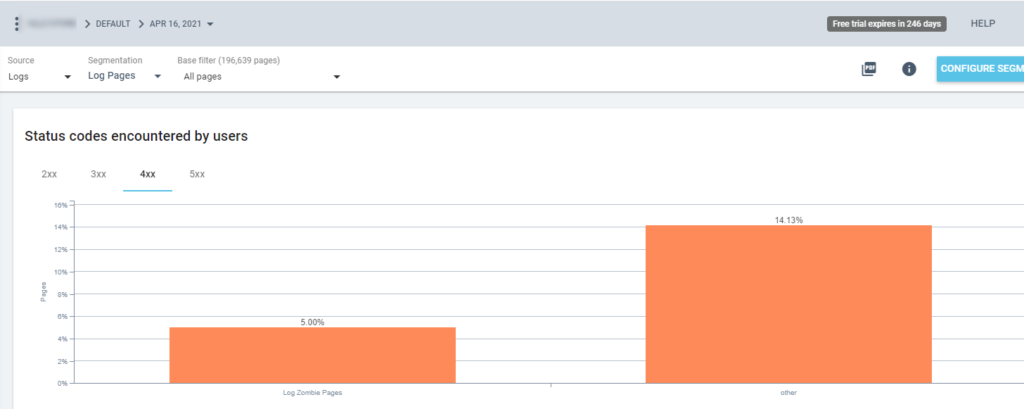

ตอนนี้เราจึงใช้การแบ่งกลุ่มนี้ในรายงาน Oncrawl ทั้งหมดได้แล้ว ข้อมูลนี้ช่วยให้เราได้รับข้อมูลเชิงลึกจากกราฟิกต่างๆ เช่น "ล็อกหน้าซอมบี้" จำนวนเท่าใดที่ส่งคืนรหัสสถานะ 200 รายการ

เพจเด็กกำพร้า

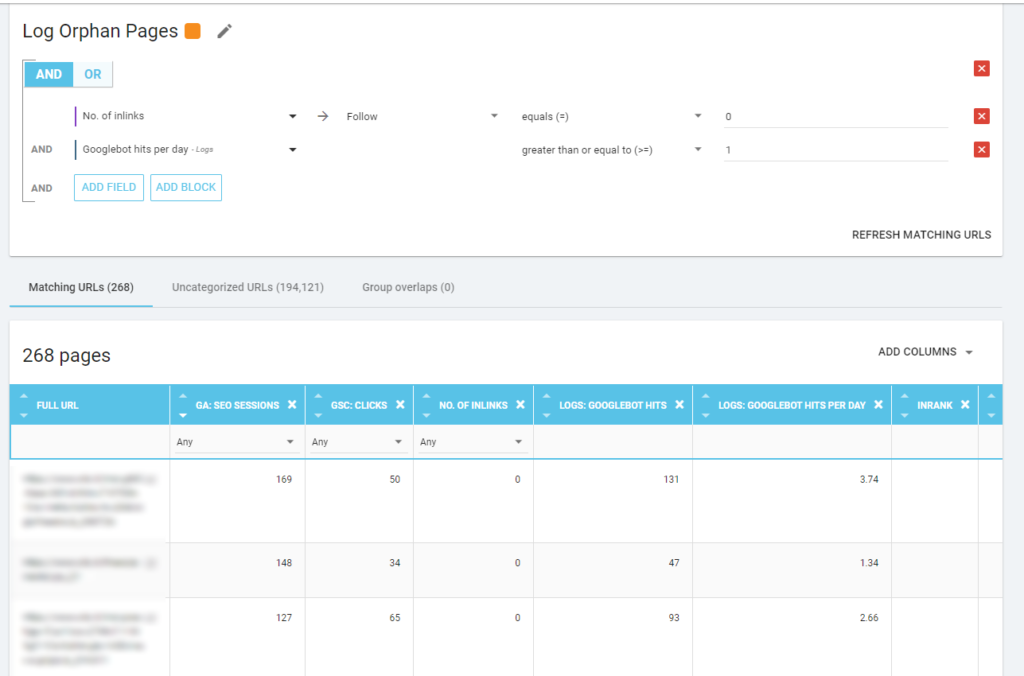

สำหรับฉัน “หน้าเด็กกำพร้า” ที่ควรค่าแก่การดูอย่างระมัดระวังคือหน้าทั้งหมดที่มีคุณค่าสูงในตัวชี้วัดที่สำคัญ (เซสชัน GA, การแสดงผล GSC, ฮิตบันทึก, …) ที่ไม่มีลิงก์ภายในที่ชี้ไปยังหน้าเหล่านั้นเพื่อแบ่งปันอันดับของหน้า และระบุความสำคัญของหน้า

เช่นเดียวกับ "หน้าซอมบี้" การสร้างรายงานตามบันทึก วิธีที่ดีที่สุดคือการสร้างการแบ่งกลุ่มใหม่

ว้าว ช่างเป็นหน้าเว็บที่มีเซสชันและการเข้าชมจำนวนมากและไม่มีลิงก์เลย!

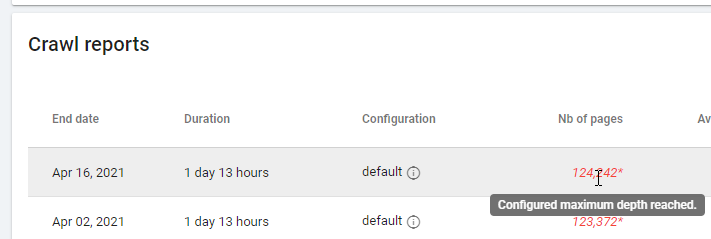

เมื่อตรวจสอบรายงานตาม "Zero Follow Inlinks" โปรดให้ความสนใจกับสถานะการรวบรวมข้อมูล: Oncrawl สามารถรวบรวมข้อมูลไซต์ทั้งหมดหรือเพียงไม่กี่หน้าได้หรือไม่ คุณสามารถดูสิ่งนี้ได้ในหน้าหลักของโครงการ:

หากถึงระดับความลึกสูงสุด:

- ตรวจสอบการกำหนดค่าการรวบรวมข้อมูลของคุณ

- ตรวจสอบโครงสร้างเว็บไซต์ของคุณ

ไฟล์บันทึกและ Oncrawl

Oncrawl เสนออะไรในแดชบอร์ดเริ่มต้น

บันทึกสด

แดชบอร์ดนี้มีประโยชน์ในการตรวจสอบข้อมูลสำคัญเกี่ยวกับวิธีที่บอทอ่านเว็บไซต์ของคุณ ทันทีที่บอทเยี่ยมชมเว็บไซต์ และก่อนที่ข้อมูลจากไฟล์บันทึกจะได้รับการประมวลผลอย่างสมบูรณ์ เพื่อให้ได้ประโยชน์สูงสุด ฉันแนะนำให้อัปโหลดไฟล์บันทึกบ่อยๆ: คุณสามารถทำได้ผ่าน FTP, ผ่านตัวเชื่อมต่อเช่นตัวเชื่อมต่อสำหรับ Amazon S3 หรือคุณสามารถทำได้ด้วยตนเองผ่านเว็บอินเตอร์เฟส

แผนภูมิแรกแสดงความถี่ในการอ่านไซต์ของคุณ และโดยบ็อตใด ในตัวอย่างที่คุณเห็นด้านล่าง เราสามารถตรวจสอบการเข้าถึงเดสก์ท็อปและมือถือได้ ในกรณีนี้ เราได้ส่งไฟล์บันทึกที่กรองเฉพาะสำหรับ Googlebot ไปยัง Oncrawl:

น่าสนใจที่จะเห็นว่าปริมาณการอ่านบนมือถือยังคงสูงมาก เป็นเรื่องปกติหรือไม่? ขึ้นอยู่กับ... ไซต์ที่เรากำลังวิเคราะห์ยังคงอยู่ใน "ดัชนีเพื่ออุปกรณ์เคลื่อนที่เป็นอันดับแรก" แต่ไม่ใช่เว็บไซต์ที่ตอบสนองอย่างสมบูรณ์: เป็นเว็บไซต์ที่ให้บริการแบบไดนามิก (ตามที่ Google เรียก) และ Google ยังคงตรวจสอบทั้งสองเวอร์ชัน!

ไดอะแกรมที่น่าสนใจอีกอันคือ “Bot hits by page group” ตามค่าเริ่มต้น Oncrawl จะสร้างกลุ่มตามเส้นทาง URL แต่เราสามารถตั้งค่ากลุ่มด้วยตนเองเพื่อจัดกลุ่ม URL ที่เหมาะสมที่สุดในการวิเคราะห์ร่วมกัน

อย่างที่คุณเห็น สีเหลืองชนะ! ซึ่งแสดงถึง URL ที่มีเส้นทางผลิตภัณฑ์ ดังนั้นจึงเป็นเรื่องปกติที่จะมีผลกระทบสูง โดยเฉพาะอย่างยิ่งเนื่องจากเรามีแคมเปญ Shopping แบบชำระเงินของ Google

และ… ใช่ เราเพิ่งยืนยันว่า Google ใช้ Googlebot มาตรฐานเพื่อตรวจสอบสถานะผลิตภัณฑ์ที่เกี่ยวข้องกับฟีดผู้ขาย!

พฤติกรรมการรวบรวมข้อมูล

แดชบอร์ดนี้แสดงข้อมูลที่คล้ายกับ "บันทึกสด" แต่ข้อมูลนี้ได้รับการประมวลผลอย่างสมบูรณ์และรวบรวมตามวัน สัปดาห์ หรือเดือน ที่นี่คุณสามารถกำหนดช่วงวันที่ (เริ่มต้น/สิ้นสุด) ซึ่งสามารถย้อนเวลากลับไปได้มากเท่าที่คุณต้องการ มีไดอะแกรมใหม่สองไดอะแกรมเพื่อเพิ่มเติมเกี่ยวกับการวิเคราะห์บันทึก:

- พฤติกรรมการตระเวน: เพื่อตรวจสอบอัตราส่วนระหว่างหน้าที่รวบรวมข้อมูลและหน้าที่รวบรวมข้อมูลใหม่

- ความถี่ในการรวบรวมข้อมูลต่อวัน

วิธีที่ดีที่สุดในการอ่านไดอะแกรมเหล่านี้คือการเชื่อมต่อผลลัพธ์กับการกระทำของไซต์:

- ย้ายเพจแล้วเหรอ?

- คุณได้อัปเดตบางส่วนหรือไม่?

- คุณเผยแพร่เนื้อหาใหม่หรือไม่?

ผลกระทบต่อ SEO

สำหรับ SEO สิ่งสำคัญคือต้องตรวจสอบว่าบอทอ่านหน้าเว็บที่ปรับให้เหมาะสมหรือไม่ ในขณะที่เราเขียนเกี่ยวกับ "หน้าเด็กกำพร้า" สิ่งสำคัญคือต้องตรวจสอบให้แน่ใจว่าบอทอ่านหน้าที่สำคัญที่สุด/ที่อัปเดต เพื่อให้ข้อมูลที่อัปเดตที่สุดพร้อมใช้งานสำหรับเครื่องมือค้นหาเพื่อให้สามารถจัดอันดับได้

Oncrawl ใช้แนวคิดของ "หน้าที่ใช้งานอยู่" เพื่อระบุหน้าที่ได้รับการเข้าชมอินทรีย์จากเครื่องมือค้นหา เริ่มต้นจากแนวคิดนี้ จะแสดงตัวเลขพื้นฐานบางอย่าง เช่น:

- การเข้าชม SEO

- SEO หน้าที่ใช้งาน

- อัตราส่วนการใช้งาน SEO (สัดส่วนของหน้าที่ใช้งานในทุกหน้าที่รวบรวมข้อมูล)

- อันดับสด (เวลาเฉลี่ยที่ผ่านไประหว่างเวลาที่บอทอ่านหน้าเว็บเป็นครั้งแรกและการเข้าชมแบบออร์แกนิกครั้งแรก)

- ไม่มีการรวบรวมข้อมูลหน้าที่ใช้งานอยู่

- เพจที่ใช้งานใหม่

- ความถี่ในการรวบรวมข้อมูลต่อวันของหน้าเว็บที่ใช้งานอยู่

ตามปรัชญาของ Oncrawl ด้วยการคลิกเพียงครั้งเดียว เราสามารถเจาะลึกเข้าไปในคลังข้อมูล กรองโดยเมตริกที่เราคลิก! ตัวอย่างเช่น หน้าใดที่ไม่มีการรวบรวมข้อมูล คลิกเดียว…

สติสัมปชัญญะ

แดชบอร์ดสุดท้ายนี้ช่วยให้เราตรวจสอบคุณภาพของการรวบรวมข้อมูลของ bo หรือแม่นยำยิ่งขึ้นว่าไซต์นำเสนอตัวเองต่อเครื่องมือค้นหาได้ดีเพียงใด:

- การวิเคราะห์รหัสสถานะ

- วิเคราะห์รหัสสถานะตามวัน

- วิเคราะห์รหัสสถานะตามกลุ่มเพจ

- การวิเคราะห์เวลาตอบสนอง

จำเป็นสำหรับงาน SEO ที่ดีเพื่อ:

- ลดจำนวนการตอบกลับ 301 จากลิงก์ภายใน

- ลบการตอบกลับ 404/410 ออกจากลิงก์ภายใน

- ปรับเวลาตอบสนองให้เหมาะสม เนื่องจากคุณภาพการรวบรวมข้อมูลของ Googlebot เกี่ยวข้องโดยตรงกับเวลาตอบสนอง: พยายามลดเวลาตอบสนองบนไซต์ของคุณลงครึ่งหนึ่งแล้วคุณจะเห็น (ภายในสองสามวัน) ว่าปริมาณของหน้าที่รวบรวมข้อมูลจะเพิ่มขึ้นเป็นสองเท่า

ศาสตร์แห่งการวิเคราะห์บันทึกและ Data Explorer ของ Oncrawl

จนถึงตอนนี้ เราได้เห็นรายงาน Oncrawl มาตรฐานและวิธีใช้รายงานเหล่านี้เพื่อรับข้อมูลที่กำหนดเองผ่านการแบ่งกลุ่มและกลุ่มเพจ

แต่แก่นของการวิเคราะห์บันทึกคือการทำความเข้าใจวิธีค้นหาสิ่งผิดปกติ โดยปกติ จุดเริ่มต้นของการวิเคราะห์คือการตรวจสอบยอดและเปรียบเทียบกับการเข้าชมและวัตถุประสงค์ของคุณ:

- หน้าที่รวบรวมข้อมูลมากที่สุด

- หน้าที่รวบรวมข้อมูลน้อยที่สุด

- ทรัพยากรที่รวบรวมข้อมูลมากที่สุด (ไม่ใช่หน้า)

- ความถี่ในการรวบรวมข้อมูลตามประเภทของไฟล์

- ผลกระทบของรหัสสถานะ 3xx / 4xx

- ผลกระทบของรหัสสถานะ 5xx

- หน้าที่รวบรวมข้อมูลช้าลง

- …

คุณต้องการที่จะไปลึก? ดี… คุณต้องเพิ่มข้อมูล และ Oncrawl ก็มีเครื่องมือที่ทรงพลังอย่าง Data Explorer

ดังที่คุณเห็นในภาพหน้าจอก่อนหน้านี้ (หน้าที่ใช้งานอยู่ไม่ได้รวบรวมข้อมูล) คุณสามารถสร้างรายงานทั้งหมดที่คุณต้องการตามกรอบงานการวิเคราะห์ของคุณ

ตัวอย่างเช่น:

- หน้าปริมาณการใช้ข้อมูลอินทรีย์ที่แย่ที่สุดที่มีการรวบรวมข้อมูลจำนวนมากโดยบอท

- หน้าการเข้าชมแบบออร์แกนิกที่ดีที่สุดที่มีการรวบรวมข้อมูลโดยบอทมากเกินไป

- หน้าที่ช้ากว่าด้วยการแสดงผล SERP จำนวนมาก

- …

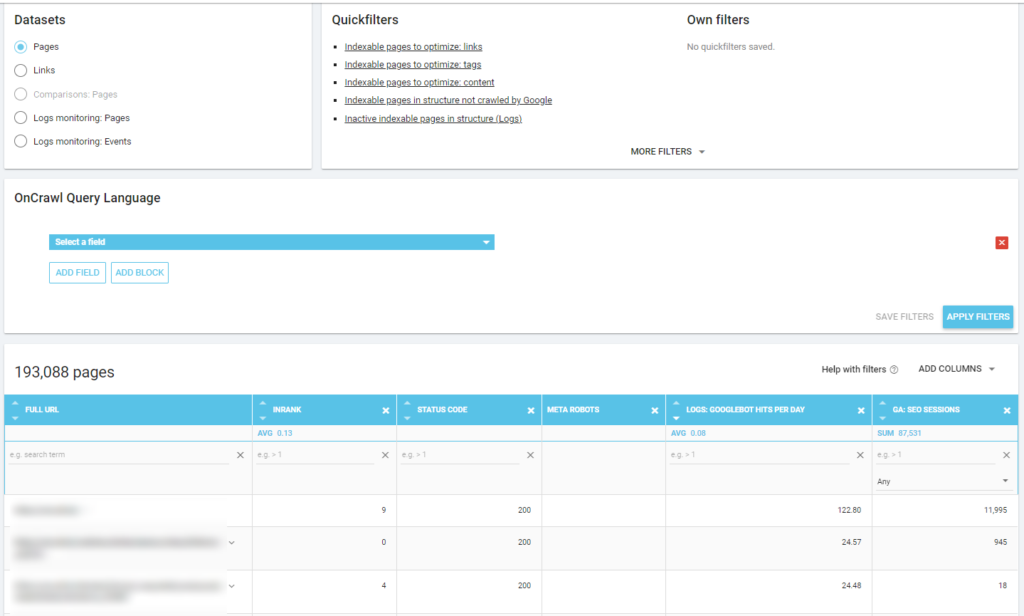

ด้านล่างนี้ คุณสามารถดูวิธีที่ฉันได้ตรวจสอบหน้าที่รวบรวมข้อมูลมากที่สุดซึ่งเกี่ยวข้องกับจำนวนเซสชัน SEO ของพวกเขา:

ซื้อกลับบ้าน

การวิเคราะห์บันทึกไม่ใช่เทคนิคอย่างเคร่งครัด หากต้องการทำสิ่งนี้ให้ดีที่สุด เราจำเป็นต้องรวมทักษะทางเทคนิค ทักษะ SEO และทักษะทางการตลาดเข้าด้วยกัน

บ่อยครั้งที่การวิเคราะห์ไม่รวมอยู่ใน “รายการตรวจสอบ SEO” เนื่องจากลูกค้าของเราไม่มีสิทธิ์เข้าถึงไฟล์บันทึกหรือเพราะอาจเป็นการวิเคราะห์ที่มีค่าใช้จ่ายสูง

ความจริงก็คือบันทึกเป็นแหล่งข้อมูลเพียงแหล่งเดียวที่จะตรวจสอบว่าบ็อตกำลังไปที่ใดในไซต์ของเรา และรู้ว่าเซิร์ฟเวอร์ของเราตอบสนองอย่างไร

เครื่องมืออย่าง Oncrawl สามารถลดข้อกำหนดทางเทคนิคได้อย่างมาก เพียงแค่อัปโหลดไฟล์บันทึกและเริ่มวิเคราะห์!