เคล็ดลับประหยัดเวลา 5 ข้อโดยใช้ OnCrawl

เผยแพร่แล้ว: 2017-06-21วิธีใช้ประโยชน์จากคุณลักษณะขั้นสูงของ OnCrawl เพื่อปรับปรุงประสิทธิภาพของคุณในระหว่างการตรวจสอบ SEO รายวัน

OnCrawl เป็นเครื่องมือ SEO ที่ทรงพลังที่ช่วยให้คุณติดตามและเพิ่มประสิทธิภาพการมองเห็นเว็บไซต์อีคอมเมิร์ซ ผู้เผยแพร่ออนไลน์ หรือแอปพลิเคชันของเสิร์ชเอ็นจิ้น เครื่องมือนี้สร้างขึ้นจากหลักการง่ายๆ ประการหนึ่ง: ช่วยให้ผู้จัดการการเข้าชมประหยัดเวลาในกระบวนการวิเคราะห์และในการจัดการโครงการ SEO รายวัน

นอกเหนือจากการเป็นเครื่องมือตรวจสอบในสถานที่ซึ่งใช้แพลตฟอร์ม SaaS ที่ได้รับการสนับสนุนโดย API ที่รวมข้อมูลเว็บไซต์ทั้งหมดเข้าด้วยกันแล้ว ยังเป็นเครื่องมือวิเคราะห์บันทึกที่ทำให้การแยกข้อมูลและการวิเคราะห์จากไฟล์เซิร์ฟเวอร์บันทึกง่ายขึ้น

ความเป็นไปได้ของ OnCrawl นั้นค่อนข้างกว้าง แต่ต้องได้รับการฝึกฝน ในบทความนี้ เราจะแบ่งปันเคล็ดลับที่ช่วยประหยัดเวลา 5 ข้อสำหรับการใช้งานโปรแกรมรวบรวมข้อมูล SEO และตัววิเคราะห์บันทึกประจำวันของคุณ

1# วิธีจัดหมวดหมู่ URL HTTP และ HTTPS

การโยกย้าย HTTPS เป็นประเด็นร้อนในแวดวง SEO เพื่อจัดการกับขั้นตอนสำคัญนี้อย่างสมบูรณ์ การติดตามพฤติกรรมของบอทบนโปรโตคอลทั้งสองอย่างถูกต้องเป็นสิ่งสำคัญ

ประสบการณ์แสดงให้เห็นว่าบอทใช้เวลามากหรือน้อยในการเปลี่ยนจาก HTTP เป็น HTTPS โดยสมบูรณ์ โดยเฉลี่ย การเปลี่ยนแปลงนั้นใช้เวลาสองสามสัปดาห์หรือหลายเดือน ขึ้นอยู่กับปัจจัยภายนอกและภายในที่เกี่ยวข้องกับคุณภาพและการย้ายข้อมูลของไซต์

เพื่อให้เข้าใจอย่างชัดเจนถึงขั้นตอนการเปลี่ยนแปลงนั้น ซึ่งงบประมาณการรวบรวมข้อมูลของคุณได้รับผลกระทบอย่างมาก คุณควรตรวจสอบการโจมตีของบอทอย่างชาญฉลาด ดังนั้นจึงจำเป็นต้องวิเคราะห์บันทึกของเซิร์ฟเวอร์ บอทในฐานะผู้ใช้ทั่วไปจะทิ้งเครื่องหมายไว้บนทุกหน้า ทรัพยากร และคำขอที่เขาสร้าง บันทึกของคุณเป็นเจ้าของพอร์ตที่ส่งสายเหล่านี้ คุณจึงสามารถตรวจสอบคุณภาพการย้ายข้อมูลของเว็บไซต์ HTTPS ได้

วิธีการตั้งค่า http vs https เฉพาะของกลุ่มเพจ

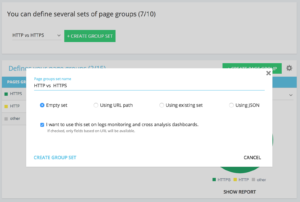

ในหน้าแรกของโครงการขั้นสูง คุณจะพบปุ่ม "การตั้งค่า" ที่มุมขวาบน จากนั้นเลือกเมนู "กำหนดค่ากลุ่มเพจ" เมื่ออยู่ที่นี่ ให้สร้าง "สร้างชุดกลุ่ม" ใหม่และตั้งชื่อเป็น "HTTP vs HTTPS"

ในการเข้าถึงบันทึกของคุณ จำเป็นต้องเลือกตัวเลือก "ฉันต้องการใช้ชุดนี้ในการตรวจสอบบันทึกและแดชบอร์ดการวิเคราะห์ข้าม"

- HTTPS : “URL แบบเต็ม” / “เริ่มต้นด้วย” / https

- HTTP : “URL แบบเต็ม” / “ไม่ขึ้นต้นด้วย” / https

เมื่อบันทึกแล้วคุณจะเข้าถึงมุมมองของการย้ายข้อมูล HTTPS ของคุณ (หากคุณได้เพิ่มพอร์ตคำขอในบรรทัดบันทึกของคุณ คุณสามารถดูคำแนะนำของเราได้)

ค้นหา QuickFilters ของเราได้ใน Data Explorer สร้างขึ้นเพื่อให้ง่ายต่อการเข้าถึงตัวชี้วัด SEO ที่สำคัญบางอย่าง เช่น ลิงก์ที่ชี้ไปที่ 404, 500 หรือ 301/302 หน้าที่ช้าเกินไปหรือไม่ดีเกินไป เป็นต้น

นี่คือรายการทั้งหมด:

- 404 ข้อผิดพลาด

- 5xx ข้อผิดพลาด

- เพจที่ใช้งาน

- หน้าที่ใช้งานอยู่ไม่ได้รวบรวมข้อมูลโดย Google

- หน้าที่ใช้งานอยู่ซึ่งมีรหัสสถานะที่ Google พบแตกต่างจาก200

- Canonical ไม่ตรงกัน

- ไม่ได้ตั้งค่าตามรูปแบบบัญญัติ

- หน้าที่จัดทำดัชนีได้

- ไม่มีหน้าที่จัดทำดัชนีได้

- เพจที่ใช้งานเด็กกำพร้า

- เพจเด็กกำพร้า

- หน้าที่รวบรวมข้อมูลโดย Google

- หน้าที่รวบรวมข้อมูลโดย Google และ OnCrawl

- หน้าในโครงสร้างที่ไม่ได้รวบรวมข้อมูลโดย Google

- หน้าที่ชี้ไปที่ข้อผิดพลาด 3xx

- หน้าที่ชี้ไปที่ข้อผิดพลาด 4xx

- หน้าที่ชี้ไปที่ข้อผิดพลาด 5xx

- หน้าที่มี h1 . ไม่ดี

- หน้าที่มี h2 . ไม่ดี

- หน้าที่มีคำอธิบายเมตาที่ไม่ดี

- หน้าที่มีชื่อเรื่องไม่ดี

- หน้าที่มีปัญหาการทำซ้ำ HTML

- หน้าที่มีอินลิงก์น้อยกว่า 10 หน้า

- เปลี่ยนเส้นทาง 3xx

- หน้าหนักเกินไป

- หน้าช้าเกินไป

แต่บางครั้ง QuickFilters เหล่านี้ไม่ได้ตอบข้อกังวลทางธุรกิจทั้งหมดของคุณ ในกรณีนั้น คุณสามารถเริ่มจากหนึ่งในนั้นและสร้าง “ตัวกรองของตัวเอง” โดยเพิ่มชิ้นส่วนในตัวกรองและบันทึกเพื่อค้นหาตัวกรองของคุณอย่างรวดเร็วทุกครั้งที่คุณเชื่อมต่อกับเครื่องมือ

ตัวอย่างเช่น จากลิงก์ที่ชี้ไปที่ 4xx คุณสามารถเลือกกรองลิงก์ที่มีจุดยึดว่าง : "Anchor" / "is" / "" และบันทึกตัวกรองนั้น เมื่อบันทึกแล้วสามารถปรับเปลี่ยนได้หลายครั้งตามต้องการ

ตอนนี้คุณสามารถเข้าถึง "Quickfilter" นั้นได้โดยตรงในรายการ "Select a Quickfilter" ที่ด้านล่างของส่วน "Own" ตามที่เห็นในภาพหน้าจอด้านล่าง

3# วิธีการตั้งค่าฟิลด์ที่กำหนดเองที่เกี่ยวข้องกับ DataLayer?

คุณสามารถใช้การแบ่งกลุ่มของประเภทเพจที่เกี่ยวข้องของคุณเมื่อคุณกำหนดแท็กเครื่องมือวิเคราะห์ของคุณเป็นต้น โค้ดเฉพาะนั้นน่าสนใจมากในการแบ่งกลุ่มหรือข้ามข้อมูลจาก OnCrawl กับข้อมูลภายนอกของคุณ

เพื่อให้คุณสามารถสร้าง "คอลัมน์สำคัญ" สำหรับการวิเคราะห์ของคุณ เราสามารถดึงโค้ดเหล่านี้ออกระหว่างการรวบรวมข้อมูลและนำกลับมาเป็นประเภทข้อมูลของโครงการของคุณ

ตัวเลือก "ฟิลด์ที่กำหนดเอง" ช่วยให้สามารถขูดองค์ประกอบใดๆ จากหน้าซอร์สโค้ดได้ด้วย regex หรือ XPath ภาษาเหล่านี้มีคำจำกัดความและกฎเกณฑ์ของตนเอง คุณสามารถค้นหาข้อมูลเกี่ยวกับ XPath ได้ที่นี่และเกี่ยวกับ regex ที่นี่

ใช้กรณีที่ 1: ดึงข้อมูล datalayer จากซอร์สโค้ดของหน้า

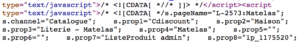

รหัสที่จะวิเคราะห์:

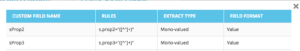

วิธีแก้ไข : ใช้ “regex” : s.prop2=”([^”]+)” / Extract : Mono-value / Field Format : Value

- ค้นหา s.prop2=" สตริงอักขระ

- ขูดอักขระทั้งหมดที่ไม่ใช่ “ (อักขระตัวแรกตามข้อมูลเพื่อแยก)

- สตริงที่จะแยกสามารถพบได้ก่อนปิด “

หลังจากการตระเวน ใน data explorer คุณจะพบในคอลัมน์ sProp2, sProp3 หรือในฟิลด์ ชื่อ ข้อมูลที่แยกออกมา:

ใช้XPATH

รหัสที่จะวิเคราะห์:

คุณเพียงแค่ต้องคัดลอก/วางองค์ประกอบ Xpath ที่คุณต้องการขูดโดยตรงจากตัววิเคราะห์โค้ดของ Chrome โปรดใช้ความระมัดระวัง หากโค้ดแสดงผลใน JavaScript คุณจะต้องตั้งค่าโปรเจ็กต์การขูดแบบกำหนดเอง ภาษา Xpath นั้นทรงพลังมากและสามารถจัดการได้ยาก ดังนั้นหากคุณต้องการความช่วยเหลือ โปรดติดต่อผู้เชี่ยวชาญของเรา

ใช้กรณีที่ 3: การทดสอบการมีอยู่ของแท็กการวิเคราะห์ระหว่างขั้นตอนการรับสัญญาณ

ใช้ regex

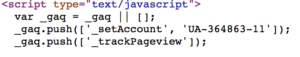

รหัสที่จะวิเคราะห์:

วิธีแก้ไข : ใช้ “regex” : '_setAccount', 'UA-364863-11' / Extract : ตรวจสอบว่ามีอยู่หรือไม่

คุณจะได้รับใน Data Explorer เป็น "จริง" หากพบสตริง "เท็จ" ในทางตรงกันข้าม

4# วิธีแสดงภาพความถี่ในการรวบรวมข้อมูลของ Google ในแต่ละส่วนของเว็บไซต์ของคุณ

งบประมาณการรวบรวมข้อมูลเป็นหัวใจสำคัญของปัญหา SEO มีการเชื่อมโยงอย่างลึกซึ้งกับแนวคิด "ความสำคัญของหน้า" และการจัดกำหนดการรวบรวมข้อมูลของ Google เราทราบหลักการเหล่านี้ ซึ่งนำมาใช้ในสิทธิบัตรของ Google ตั้งแต่ปี 2012 ให้สังคม Mountain View เพิ่มประสิทธิภาพทรัพยากรที่ทุ่มเทให้กับการรวบรวมข้อมูลเว็บโดยเฉพาะ

Google ไม่ได้ใช้พลังงานเท่ากันในทุกส่วนของเว็บไซต์ของคุณ ความถี่ในการรวบรวมข้อมูลในแต่ละส่วนของเว็บไซต์ของคุณช่วยให้คุณได้รับข้อมูลเชิงลึกที่แม่นยำเกี่ยวกับความสำคัญของหน้าเว็บต่อสายตาของ Google

บอทของ Google รวบรวมข้อมูลหน้าที่สำคัญมากกว่าเนื่องจากงบประมาณการรวบรวมข้อมูลเชื่อมโยงกับทักษะการจัดอันดับหน้าอย่างลึกซึ้ง

โปรเจ็กต์ OnCrawl Advanced ช่วยให้คุณเห็นงบประมาณการตระเวนได้ตามปกติในส่วน "การตรวจสอบบันทึก" / "พฤติกรรมการรวบรวมข้อมูล" / "พฤติกรรมการรวบรวมข้อมูลตามกลุ่ม"

คุณจะเห็นว่ากลุ่ม “โฮมเพจ” มีความถี่ในการรวบรวมข้อมูลสูงสุด เป็นเรื่องปกติเพราะ Google มองหาบทความใหม่ๆ อยู่เสมอ และบทความเหล่านั้นมักปรากฏอยู่ในหน้าแรก แนวคิดเกี่ยวกับความสำคัญของเพจมีความเกี่ยวข้องอย่างยิ่งกับแนวคิดของ Google Freshness หน้าแรกของคุณเป็นหน้าที่สำคัญที่สุดในการจัดลำดับความสำคัญของงบประมาณการรวบรวมข้อมูลของ Google จากนั้น การปรับให้เหมาะสมจะกระจายไปยังหน้าอื่นๆ เกี่ยวกับความลึกและความนิยม

ความแตกต่างของความถี่ในการมองเห็นนั้นยากเพียงใด คุณจึงต้องคลิกที่กลุ่มที่คุณต้องการลบ (โดยคลิกที่คำอธิบาย) และดูข้อมูลที่แสดงขึ้น

5# วิธีทดสอบรหัสสถานะจากรายการ URL หลังจากการโยกย้าย

เมื่อคุณต้องการทดสอบรหัสสถานะอย่างรวดเร็วจากชุดของ URL คุณสามารถแก้ไขการตั้งค่าของการรวบรวมข้อมูลใหม่ได้:

- เพิ่ม URL เริ่มต้นทั้งหมด (ปุ่ม "เพิ่ม URL เริ่มต้น")

- กำหนดความลึกสูงสุด 1

การรวบรวมข้อมูลที่กำหนดเองนี้จะส่งคืนข้อมูลเชิงคุณภาพเกี่ยวกับชุด URL นี้

คุณจะสามารถตรวจสอบได้ว่าการเปลี่ยนเส้นทางได้รับการตั้งค่าอย่างดีหรือปฏิบัติตามวิวัฒนาการของรหัสสถานะเมื่อเวลาผ่านไป ลองนึกถึงข้อดีของการรวบรวมข้อมูลอย่างสม่ำเสมอ คุณจะสามารถติดตาม URL เก่าได้โดยอัตโนมัติ

ทำไมคุณไม่สร้างแดชบอร์ดอัตโนมัติผ่าน API ของเราและสร้างการตรวจสอบการทดสอบอัตโนมัติในประเด็นเหล่านี้

เราหวังว่าการแฮ็กเหล่านี้จะช่วยคุณปรับปรุงประสิทธิภาพโดยใช้ OnCrawl เรายังมีเทคนิคขั้นสูงมากมายที่จะแสดงให้คุณเห็น โปรดแบ่งปัน #oncrawlhacks ของคุณกับเราทาง Twitter เราดีใจที่ผู้ใช้ของเราสามารถสนุกสนานกับเครื่องมือของเราได้มากเท่ากับที่เรามี