5 เหตุผลดีๆ ในการรวมข้อมูลการรวบรวมข้อมูลและบันทึกข้อมูล

เผยแพร่แล้ว: 2018-03-27ความเข้าใจข้อมูลล็อกไฟล์ใน SEO เพิ่มมากขึ้นในชุมชน SEO ไฟล์บันทึกเป็นเพียงการนำเสนอเชิงคุณภาพของสิ่งที่เกิดขึ้นบนเว็บไซต์เท่านั้น แต่เรายังต้องสามารถทำให้พวกเขาพูดได้อย่างมีประสิทธิภาพ

การเข้าชม SEO ที่แน่นอนและพฤติกรรมของบอทมีอยู่ในไฟล์บันทึกของคุณ ในทางกลับกัน ข้อมูลจากรายงานการรวบรวมข้อมูลของคุณสามารถให้ความรู้ที่ดีเกี่ยวกับประสิทธิภาพในไซต์ของคุณได้ คุณต้องรวมไฟล์บันทึกและรวบรวมข้อมูลเพื่อเน้นมิติใหม่เมื่อวิเคราะห์เว็บไซต์ของคุณ

บทความนี้จะแสดงวิธีที่ยอดเยี่ยมห้าวิธีในการรวมข้อมูลการรวบรวมข้อมูลและล็อกไฟล์ แน่นอนว่ายังมีอีกมากที่คุณสามารถใช้ได้

1# การตรวจจับหน้าเด็กกำพร้าและรวบรวมข้อมูลการเพิ่มประสิทธิภาพงบประมาณ

เพจเด็กกำพร้าคืออะไร? หาก URL ปรากฏในบันทึกโดยไม่อยู่ในสถาปัตยกรรมของไซต์ URL นี้จะเรียกว่า เด็กกำพร้า

Google มีดัชนีมหาศาล! เมื่อเวลาผ่านไป มันจะเก็บ URL ทั้งหมดที่ค้นพบบนเว็บไซต์ของคุณไว้ แม้ว่าจะไม่มีอยู่ในสถาปัตยกรรมอีกต่อไป (การเปลี่ยนแปลงกระสุน หน้าที่ถูกลบ การโยกย้ายเว็บไซต์โดยสมบูรณ์ ลิงก์ภายนอกที่มีข้อผิดพลาด หรือการแปลง) เห็นได้ชัดว่าการปล่อยให้ Google รวบรวมข้อมูลที่เรียกว่าเพจที่ไม่มีผู้ดูแลเหล่านี้อาจมีผลกระทบต่อการเพิ่มประสิทธิภาพงบประมาณการรวบรวมข้อมูลของคุณ หาก URL ที่ล้าสมัยใช้งบประมาณการรวบรวมข้อมูลของคุณ การทำเช่นนี้จะป้องกันไม่ให้ URL อื่นๆ ถูกรวบรวมข้อมูลอย่างสม่ำเสมอมากขึ้นและจะส่งผลต่อ SEO ของคุณ

เมื่อรวบรวมข้อมูลเว็บไซต์ของคุณ OnCrawl จะผ่านลิงก์ทั้งหมดเพื่อค้นหาสถาปัตยกรรมที่สมบูรณ์ของเว็บไซต์ของคุณ ในทางกลับกัน ระหว่างการตรวจสอบไฟล์บันทึก OnCrawl จะรวบรวมข้อมูลจาก Google bots hit และ SEO visits

ความแตกต่างระหว่าง URL ที่ Google รู้จักกับ URL ที่เชื่อมโยงในสถาปัตยกรรมนั้นมีความสำคัญมาก การเพิ่มประสิทธิภาพ SEO ที่มีจุดมุ่งหมายเพื่อแก้ไขลิงก์ที่ลืมหรือเสีย และลดหน้ากำพร้าเป็นสิ่งสำคัญ

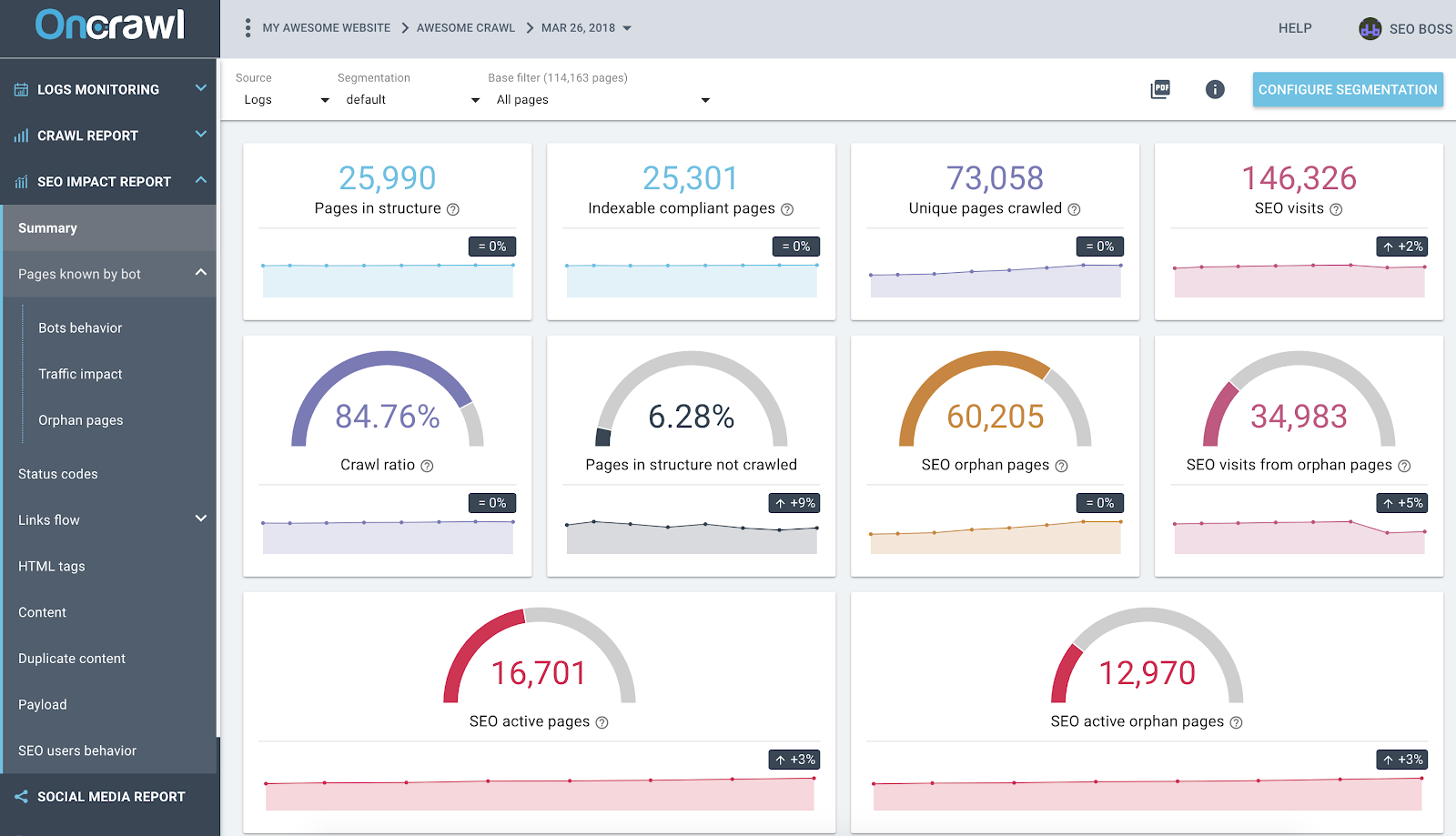

รายงานผลกระทบ OnCrawl SEO ตามบันทึกและการวิเคราะห์ข้อมูลข้ามการรวบรวมข้อมูล

ภาพหน้าจอด้านบนแสดงสถานะของบันทึกและข้อมูลการรวบรวมข้อมูลของคุณ คุณสามารถสังเกตได้อย่างรวดเร็วว่า:

- หน้า 25,990 อยู่ในโครงสร้าง – พบโดยโปรแกรมรวบรวมข้อมูลของเราและคำนึงถึงลิงก์ทั้งหมดที่ติดตามบนเว็บไซต์

- Google รวบรวมข้อมูล 73,058 หน้า ซึ่งมากกว่าโครงสร้าง 3 เท่า

- อัตราส่วนการรวบรวมข้อมูล 84% – (หน้าที่รวบรวมข้อมูล OnCrawl + หน้าที่ใช้งานจากบันทึก + หน้าที่รวบรวมข้อมูลของ Google ) / หน้าที่รวบรวมข้อมูลของ Google;

- ไม่มีการรวบรวมข้อมูลหน้าภายในมากกว่า 6% - เพียงคลิกที่ถังสีดำเพื่อดูรายการหน้าเหล่านี้ใน Data Explorer

- หน้าเด็กกำพร้า 60K – ส่วนต่างระหว่างหน้าในโครงสร้างและหน้าที่รวบรวมข้อมูลโดย Google

- 34K SEO เข้าชมในหน้าเหล่านี้ – ดูเหมือนว่าจะมีปัญหาในการเชื่อมโยงภายใน!

แนวทางปฏิบัติที่ดีที่สุด: OnCrawl ช่วยให้คุณได้เปรียบในการสำรวจข้อมูลที่อยู่เบื้องหลังกราฟหรือเมตริกแต่ละรายการ เพียงแค่คลิกที่กราฟ ด้วยวิธีนี้ คุณจะได้รับรายการ URL ที่สามารถดาวน์โหลดได้ ซึ่งได้รับการกรองโดยตรงในขอบเขตที่คุณกำลังสำรวจ

2# ค้นหาว่า URL ใดใช้งบประมาณการรวบรวมข้อมูลมากที่สุด (หรือน้อยที่สุด)

เหตุการณ์ทั้งหมดจากการเข้าชมบ็อตของ Google เป็นที่รู้จักโดยแพลตฟอร์มข้อมูล OnCrawl สิ่งนี้ช่วยให้คุณทราบ – สำหรับแต่ละ URL – ข้อมูลทั้งหมดที่รวบรวมตามเวลา

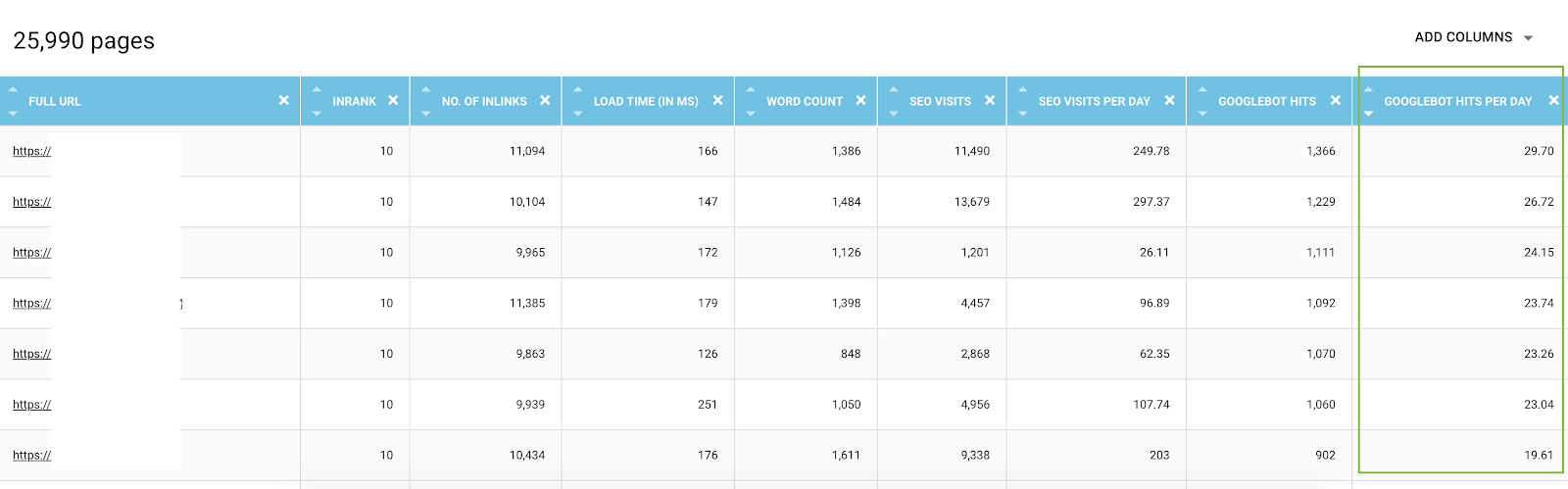

ใน Data Explorer คุณสามารถเพิ่มสำหรับแต่ละคอลัมน์ Hit ของบอต URL (ในช่วง 45 วัน) และ Hit ตามวันและตามบอท ซึ่งเป็นมูลค่าเฉลี่ยต่อวัน ข้อมูลเหล่านี้มีค่าในการประเมินการใช้งบประมาณการรวบรวมข้อมูลของ Google คุณมักจะพบว่างบประมาณนี้ไม่เท่ากันในทุกไซต์

รายการ URL ทั้งหมดจาก Data Explorer พร้อมเมตริกการรวบรวมข้อมูลและกรองตาม Hit ของบอทตามวัน

อันที่จริง ปัจจัยบางอย่างสามารถทริกเกอร์หรือลดงบประมาณการตระเวนได้ จากนั้นเราได้จัดทำรายการตัวชี้วัดที่สำคัญที่สุดในบทความนี้เกี่ยวกับความสำคัญของหน้า Google ความลึก จำนวนลิงก์ที่ชี้ไปยังหน้า จำนวนคำสำคัญ ความเร็วของหน้า InRank (ความนิยมภายใน) ส่งผลต่อการรวบรวมข้อมูลของบอท คุณจะได้เรียนรู้เพิ่มเติมในย่อหน้าต่อไปนี้

3# รู้จักหน้า SEO ที่ดีที่สุดของคุณ หน้า SEO ที่แย่ที่สุดของคุณและกำหนดปัจจัยความสำเร็จของเพจ

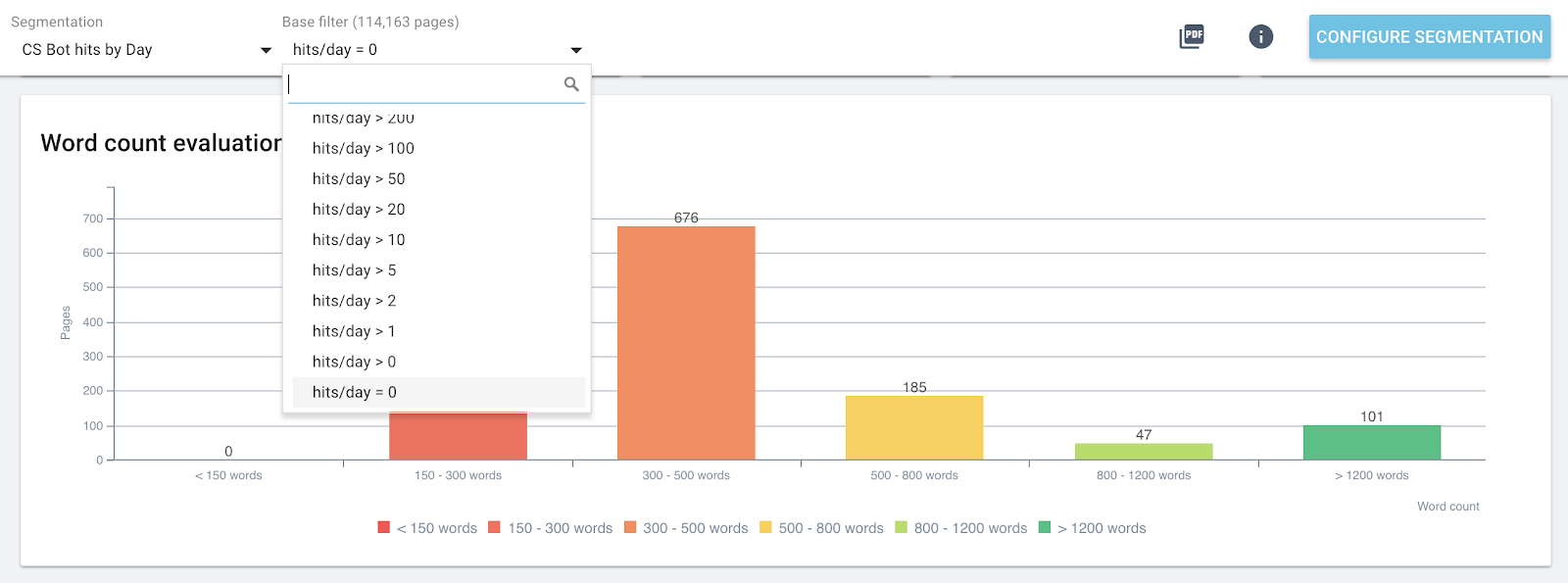

เมื่อใช้ Data Explorer คุณจะสามารถเข้าถึงตัววัดหลักเกี่ยวกับหน้าต่างๆ ได้ แต่การเปรียบเทียบหลายร้อยบรรทัดและตัววัดเข้าด้วยกันอาจทำได้ยาก การใช้คอลัมน์เพื่อแบ่งกลุ่มตาม Hit ของบอทตามวันและการเข้าชม SEO ตามวันเป็นพันธมิตรในการทำเหมืองข้อมูลของคุณ

- ดาวน์โหลด CS - Bot Hits by Day และ CS - SEO เข้าชมตามไฟล์ JSON รายวัน;

- เพิ่มเป็นการแบ่งกลุ่มใหม่

ที่จริงแล้ว คุณสามารถสร้างการแบ่งกลุ่มตามค่าสองค่านี้ที่เกิดจากการวิเคราะห์บันทึกเพื่อให้มีการกระจายหน้าของคุณตามกลุ่มเป็นครั้งแรก แต่คุณยังสามารถกรองผ่านแต่ละกลุ่มของการแบ่งเซ็กเมนต์เหล่านี้เพื่อตรวจหาได้อย่างรวดเร็ว ในรายงาน OnCrawl แต่ละหน้า ซึ่งหน้าใดไม่ถึงค่าที่คาดไว้

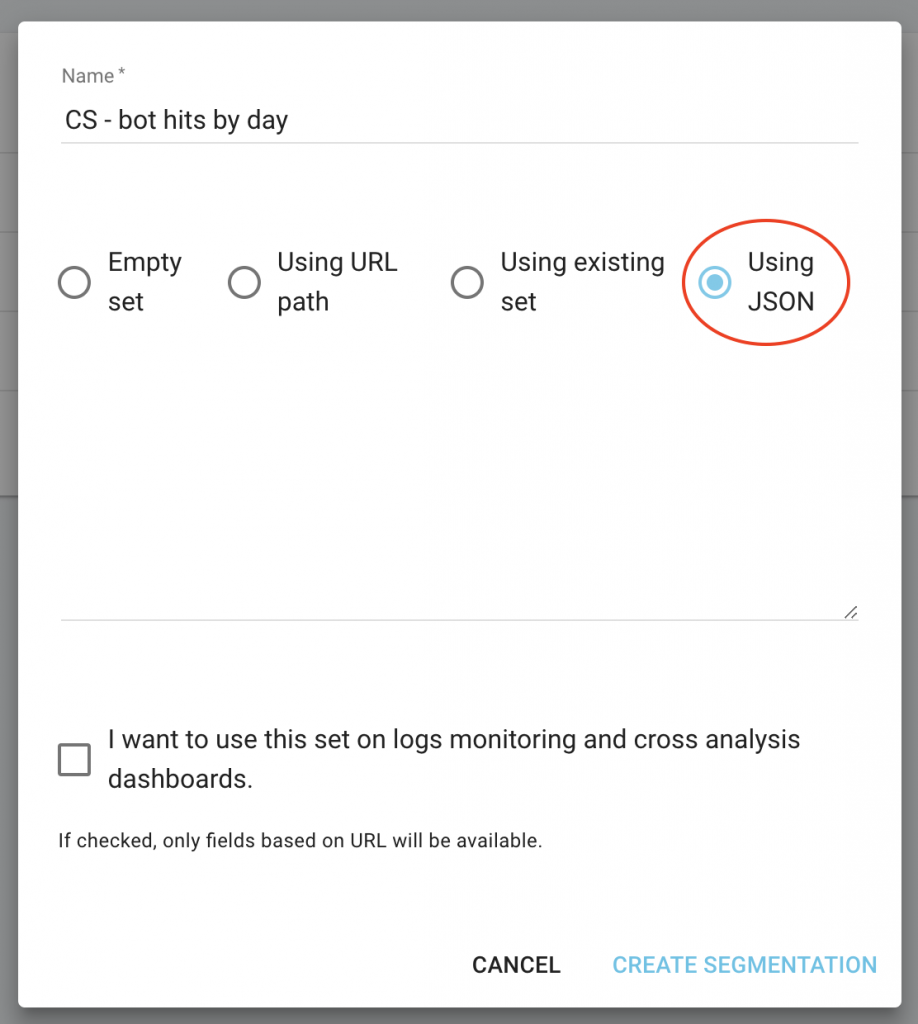

ในหน้าแรกของโครงการ ให้คลิกที่ปุ่ม "กำหนดค่าการแบ่งส่วน"

จากนั้นสร้างการแบ่งส่วนใหม่

ใช้การนำเข้า JSON โดยเลือกความจุ “การใช้ JSON” และคัดลอก/วางไฟล์ที่คุณดาวน์โหลด

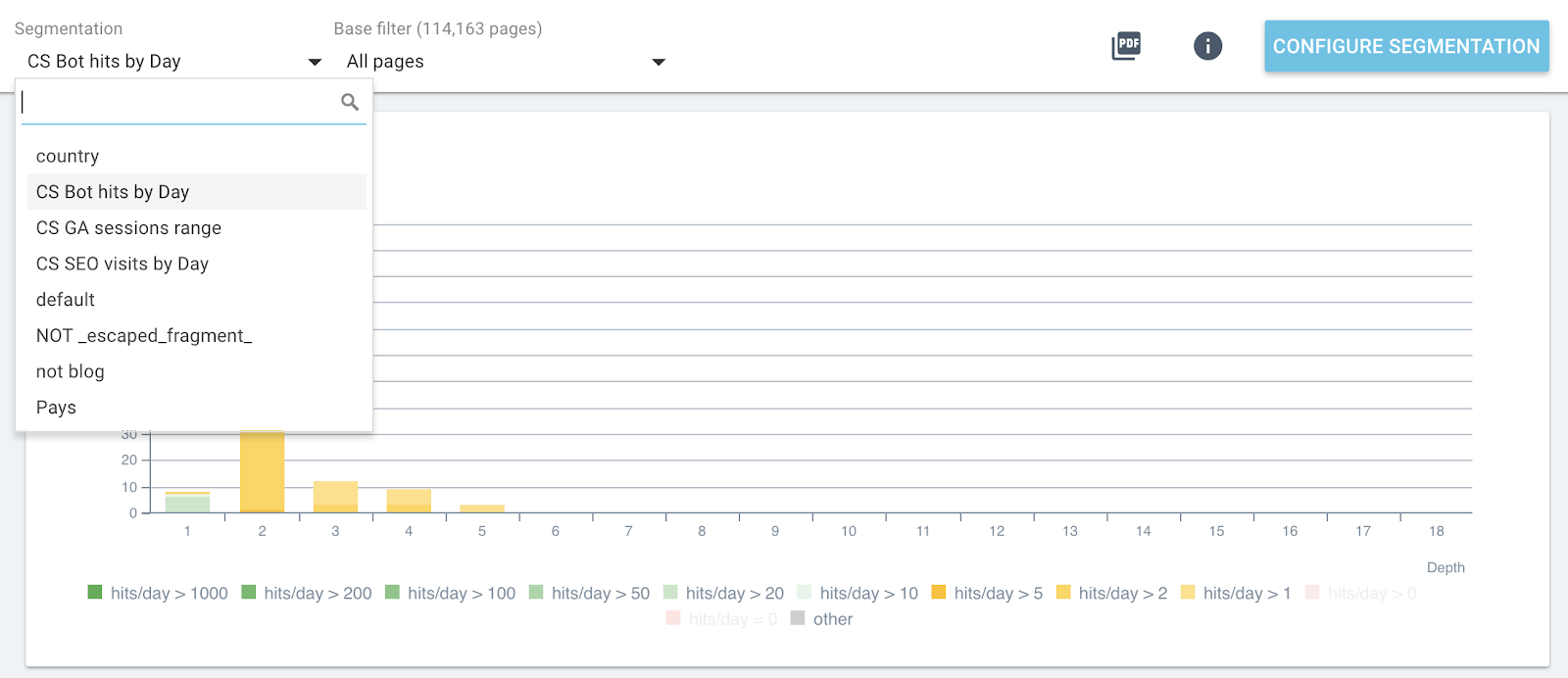

ตอนนี้คุณสามารถสลับการแบ่งกลุ่มโดยใช้เมนูด้านบนในแต่ละรายงาน

การเปลี่ยนแปลงการแบ่งกลุ่มแบบสดในรายงาน OnCrawl ทั้งหมด

วิธีนี้จะทำให้คุณเห็นผลกระทบของเมตริกที่คุณกำลังวิเคราะห์และเกี่ยวข้องกับหน้าเว็บที่จัดกลุ่มตาม Hit ของบอทหรือการเข้าชม SEO ในแต่ละกราฟิก

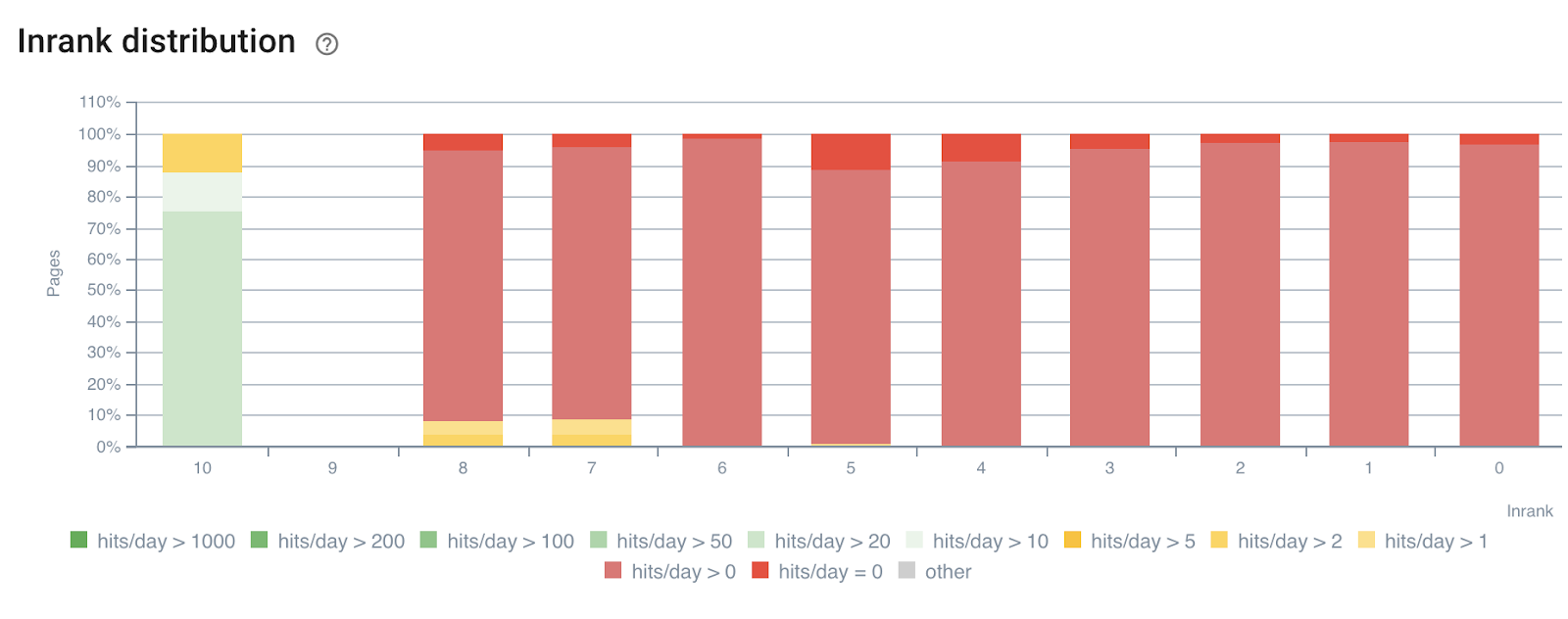

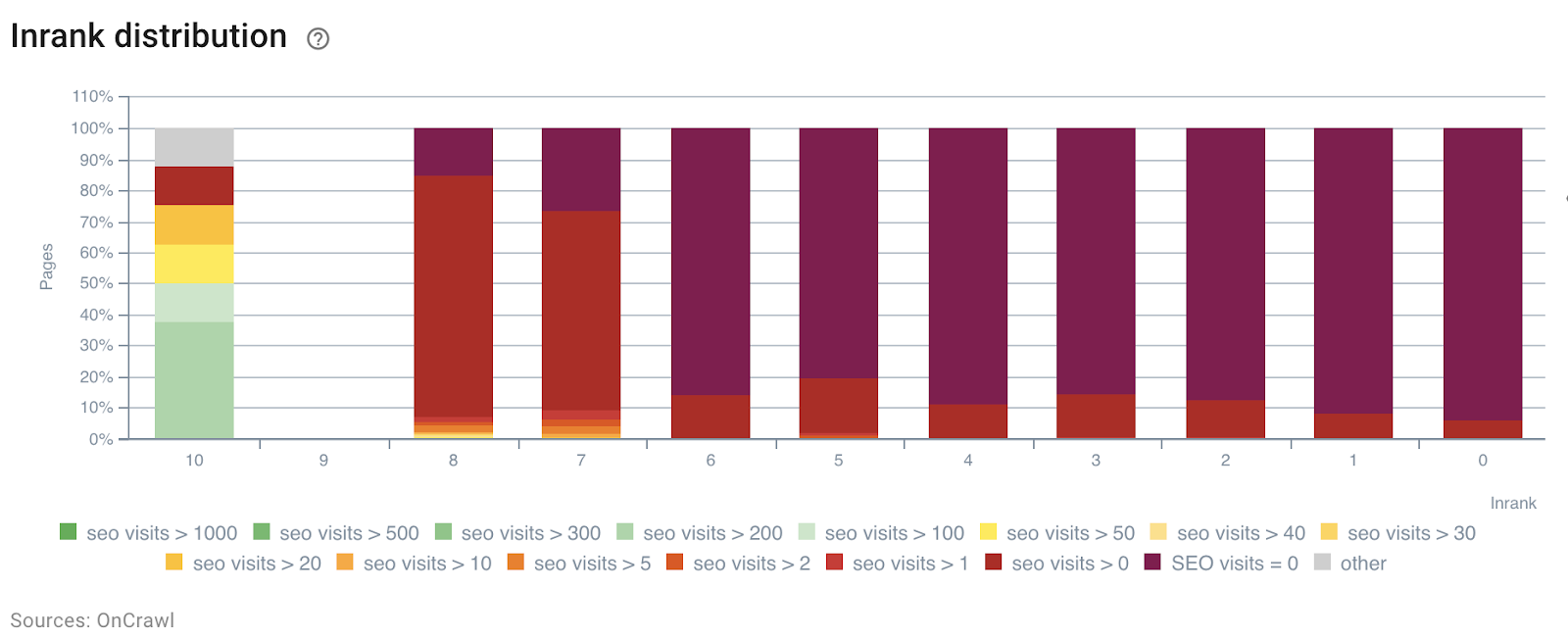

ในตัวอย่างต่อไปนี้ เราได้ใช้ส่วนเหล่านี้เพื่อทำความเข้าใจผลกระทบของความนิยมภายใน InRank โดยพิจารณาจากพลังของลิงก์ตามความลึก นอกจากนี้ การเข้าชมจากบอทและ SEO ยังสัมพันธ์กันในแกนเดียวกัน

การกระจาย InRank โดยบอทฮิตตามวัน

การกระจาย InRank ตามการเข้าชม SEO ตามวัน

ความลึก (จำนวนคลิกจากหน้าแรก) มีผลกระทบอย่างชัดเจนต่อทั้ง Hit ของบอทและการเข้าชม SEO

ในทำนองเดียวกัน คุณสามารถเลือกกลุ่มเพจแต่ละกลุ่มแยกกันเพื่อเน้นข้อมูลจากหน้าที่เข้าชมหรือเข้าชมมากที่สุด

ซึ่งช่วยให้ตรวจจับหน้าเว็บได้อย่างรวดเร็วว่าจะทำงานได้ดีขึ้นหากได้รับการปรับให้เหมาะสม จำนวนคำในหน้า ความลึกหรือจำนวนลิงก์ขาเข้า เป็นต้น

เพียงเลือกการแบ่งกลุ่มและกลุ่มหน้าที่คุณต้องการวิเคราะห์

การกระจายคำในหน้าสำหรับกลุ่มที่มีบอท 0 ตัวต่อวัน

4# กำหนดค่าเกณฑ์เพื่อเพิ่มงบประมาณการรวบรวมข้อมูลและการเข้าชม SEO สูงสุด

รายงานผลกระทบ SEO – รวบรวมข้อมูลและบันทึกการวิเคราะห์ข้ามข้อมูล – สามารถตรวจจับค่าเกณฑ์ที่ช่วยเพิ่มการเข้าชม SEO ความถี่ในการรวบรวมข้อมูล หรือการค้นพบหน้าเว็บ

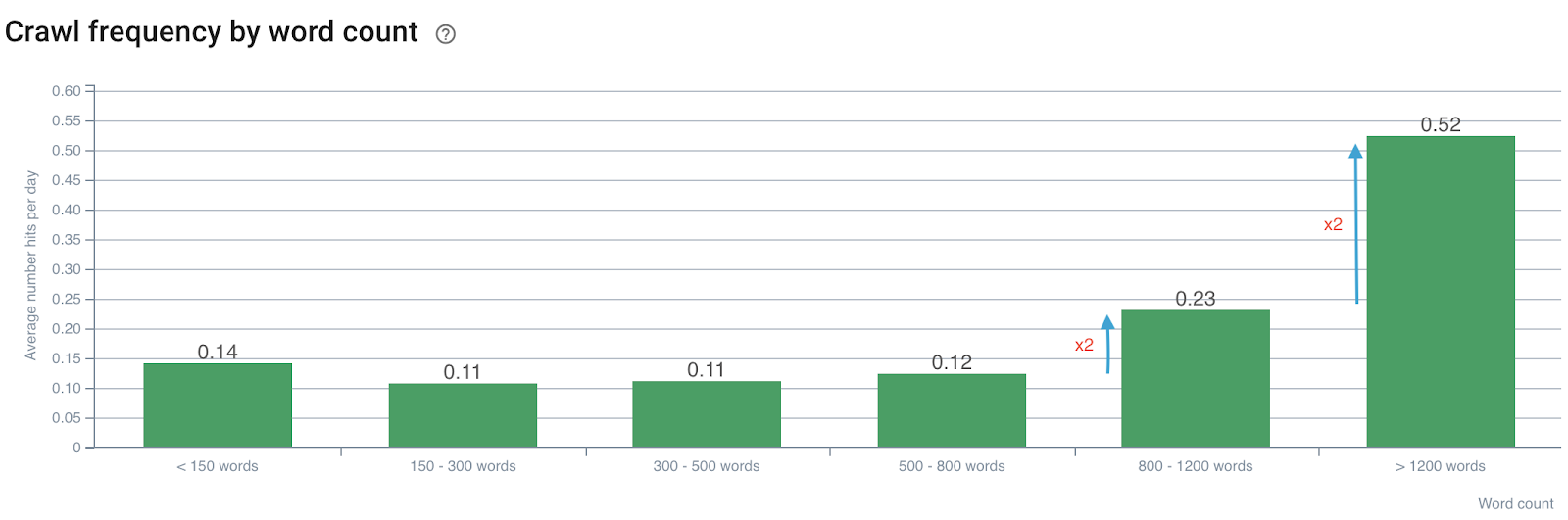

ผลกระทบของจำนวนคำต่อความถี่ในการรวบรวมข้อมูล

ความถี่ในการรวบรวมข้อมูลตามจำนวนคำ

เราทราบว่าความถี่ในการรวบรวมข้อมูลจะเพิ่มขึ้นเป็นสองเท่าเมื่อจำนวนคำเกิน 800 จากนั้นจะเพิ่มขึ้นเป็นสองเท่าเมื่อจำนวนคำในหน้าเกิน 1200 คำ

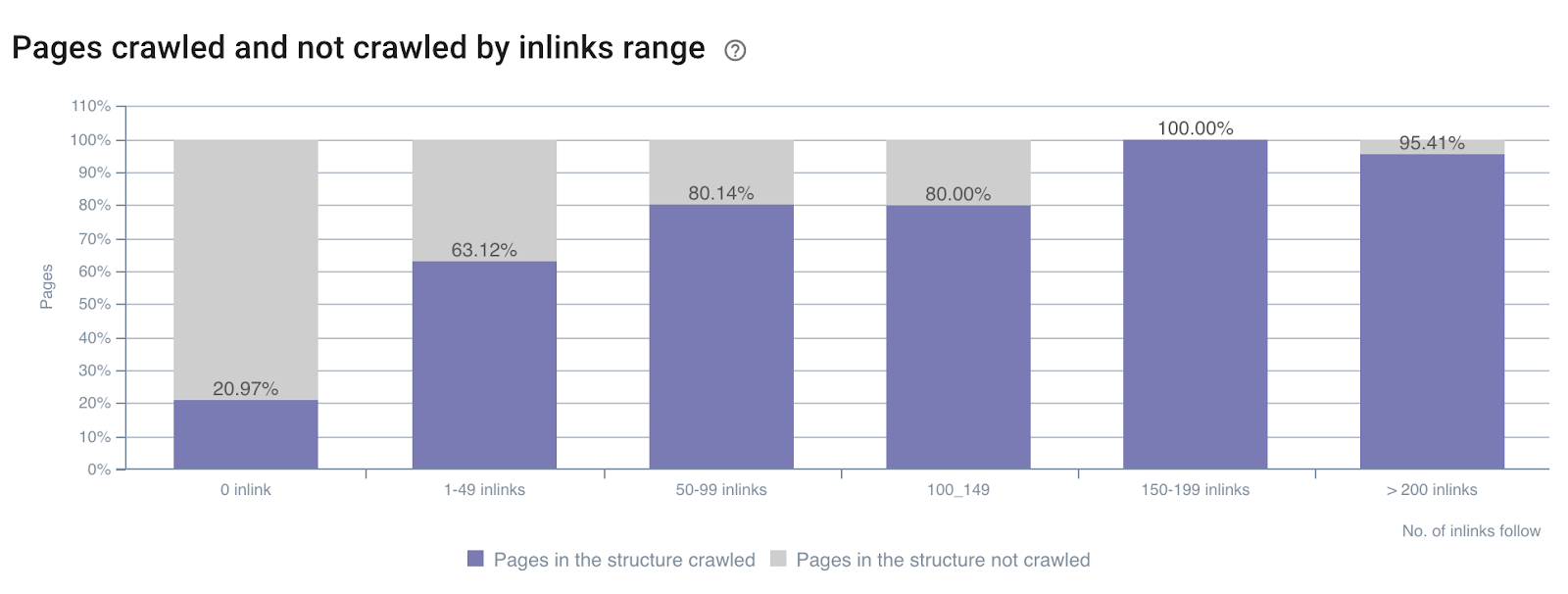

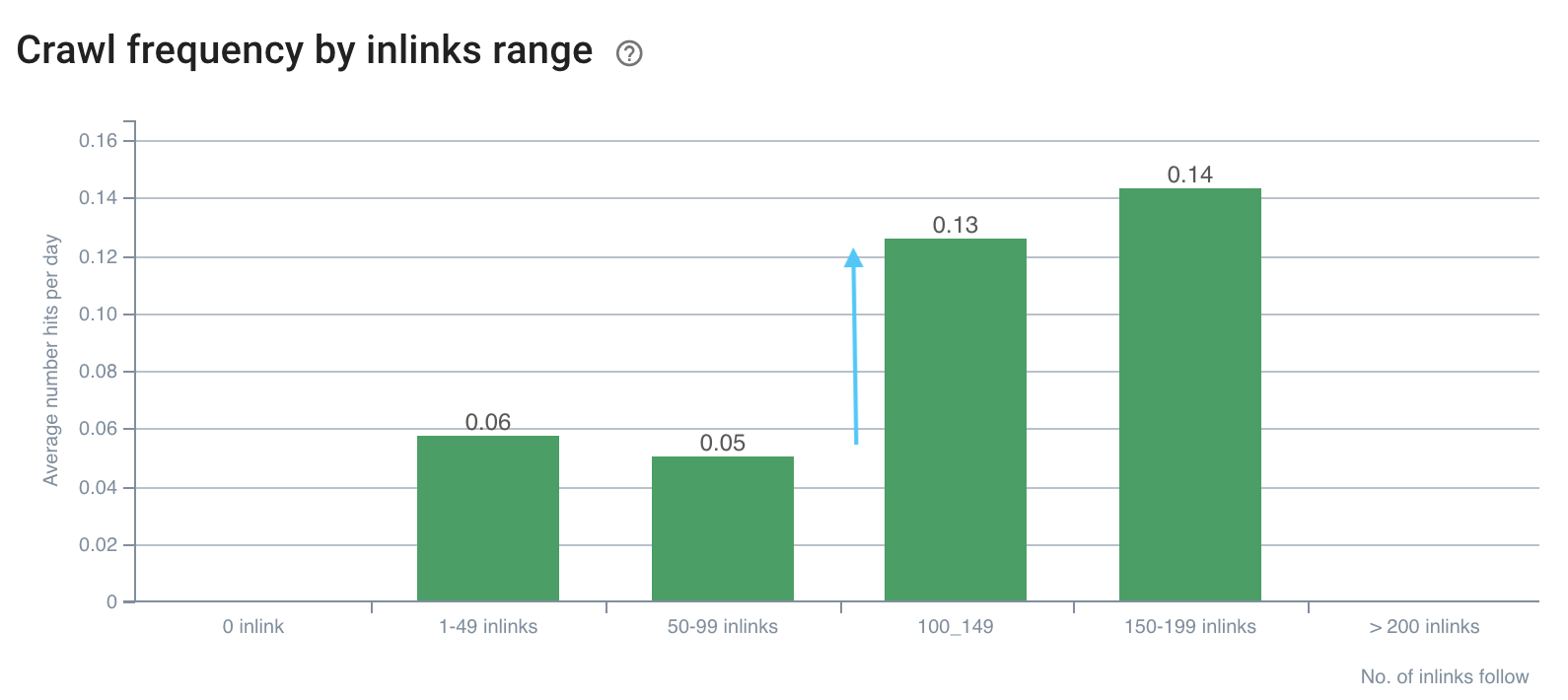

ผลกระทบของจำนวนอินลิงก์ต่ออัตราส่วนการรวบรวมข้อมูล

อัตราการรวบรวมข้อมูลตามจำนวนอินลิงก์ทั่วทั้งไซต์

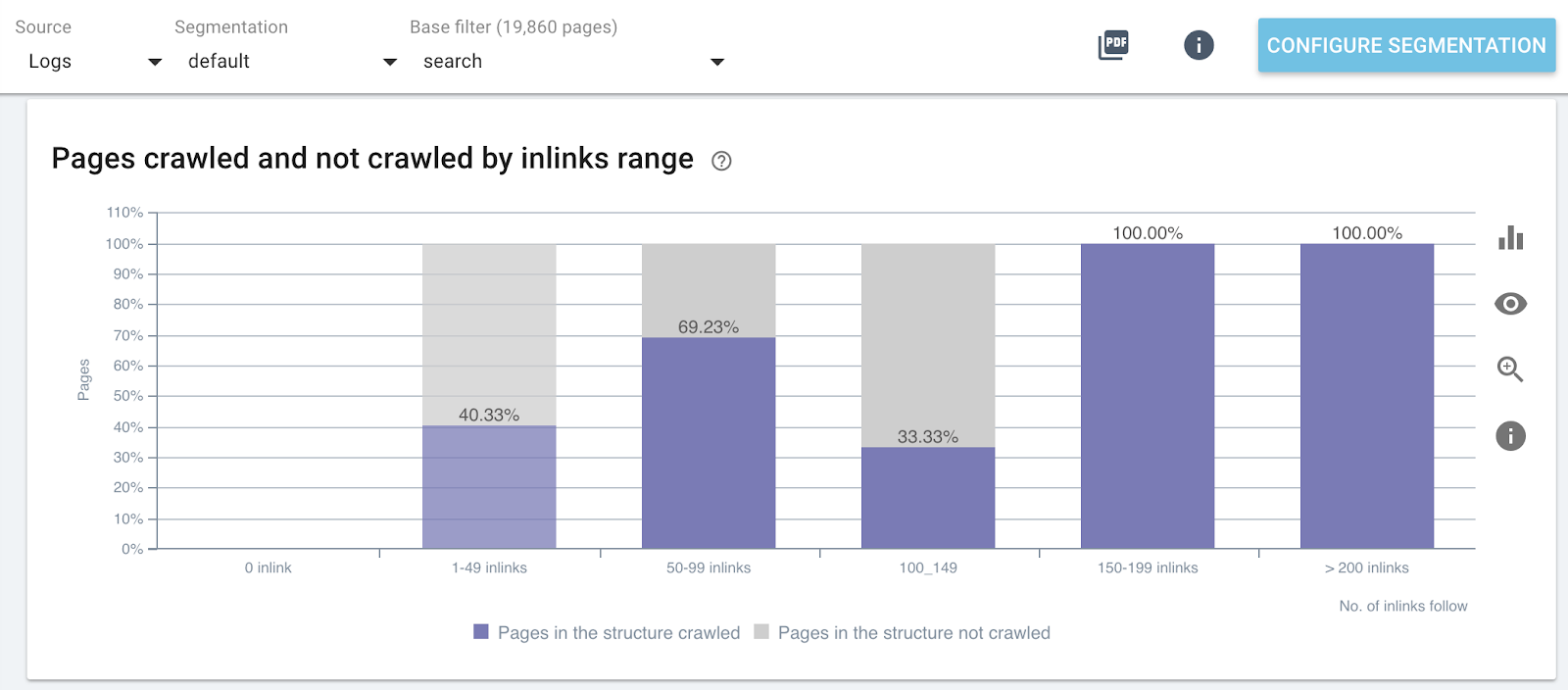

อัตราส่วนการรวบรวมข้อมูลตามจำนวนลิงก์ในส่วนต่างๆ ของเว็บไซต์ (หน้าค้นหา)

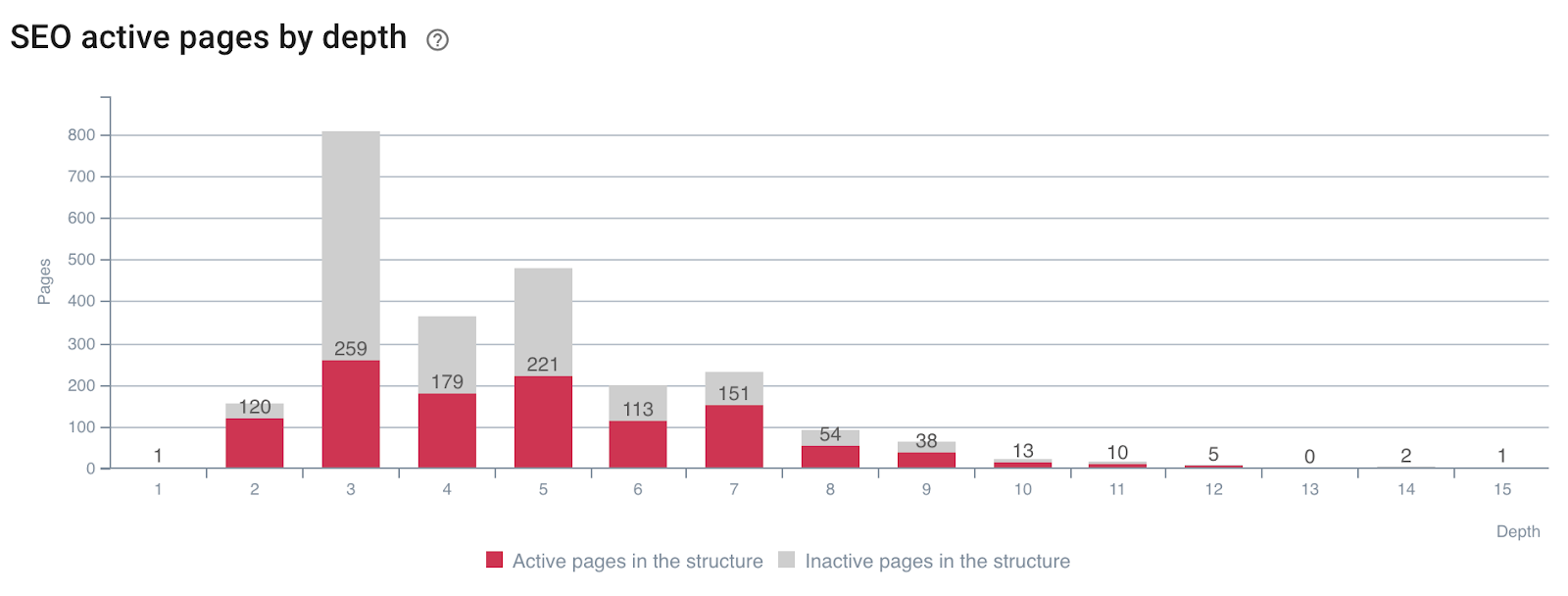

ผลกระทบของความลึกต่อการใช้งานของเพจ

หน้าที่สร้างการเข้าชม SEO (หรือไม่) ตามความลึก

คุณจะเห็นได้ว่าการมีเมตริกไซต์ที่ถูกต้องระหว่างการรวบรวมข้อมูลและการข้ามข้อมูลบันทึก ช่วยให้คุณตรวจพบได้ทันทีว่าจำเป็นต้องมีการเพิ่มประสิทธิภาพ SEO ใดบ้างเพื่อจัดการการรวบรวมข้อมูลของ Google และปรับปรุงการเข้าชม SEO ของคุณ

5# กำหนดว่าปัจจัยการจัดอันดับ SEO ส่งผลต่อความถี่ในการรวบรวมข้อมูลของคุณอย่างไร

ลองนึกภาพถ้าคุณรู้ค่าที่จะกำหนดเป้าหมายเพื่อเพิ่ม SEO ของคุณให้สูงสุด? นั่นคือสิ่งที่ทำการวิเคราะห์ข้อมูลข้าม! ช่วยให้คุณกำหนดได้อย่างแม่นยำ สำหรับแต่ละเมตริก ซึ่งความถี่ในการรวบรวมข้อมูลตามเกณฑ์ อัตราการรวบรวมข้อมูล หรือความกระฉับกระเฉงจะถูกขยายให้ใหญ่สุด

เราเห็นข้างต้น – ในตัวอย่างเกี่ยวกับจำนวนคำต่อหน้าและความถี่ในการรวบรวมข้อมูล – ว่ามีค่าทริกเกอร์ความถี่ในการรวบรวมข้อมูล ช่องว่างเหล่านี้ต้องได้รับการวิเคราะห์และเปรียบเทียบสำหรับหน้าเว็บแต่ละประเภท เนื่องจากเรากำลังมองหาการเพิ่มขึ้นอย่างรวดเร็วในพฤติกรรมของบอทหรือการเข้าชม SEO

เช่นเดียวกับที่นำเสนอด้านล่าง:

ความถี่ในการรวบรวมข้อมูลมีช่องว่างในลิงก์มากกว่า 100 รายการ

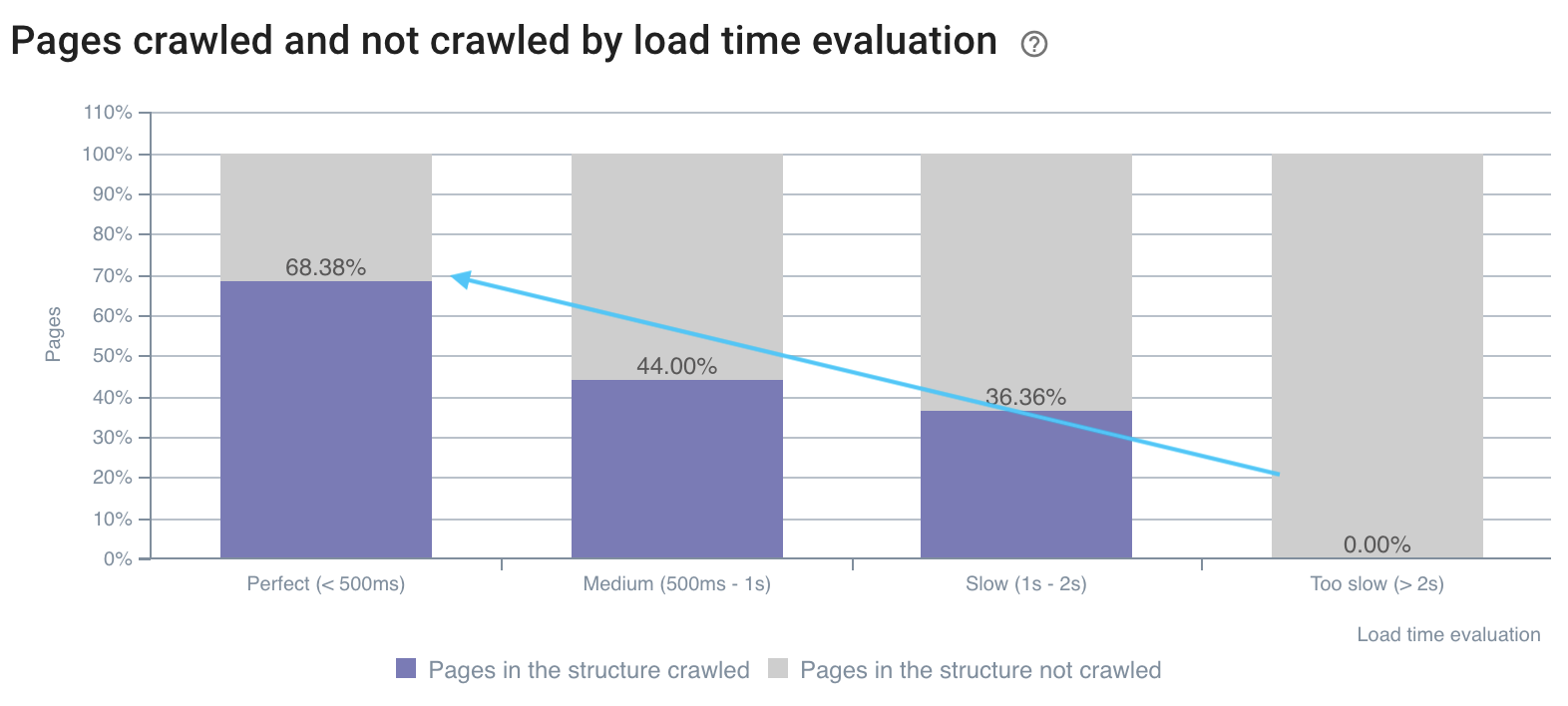

อัตราการรวบรวมข้อมูลจะดีกว่าในหน้าที่รวดเร็ว

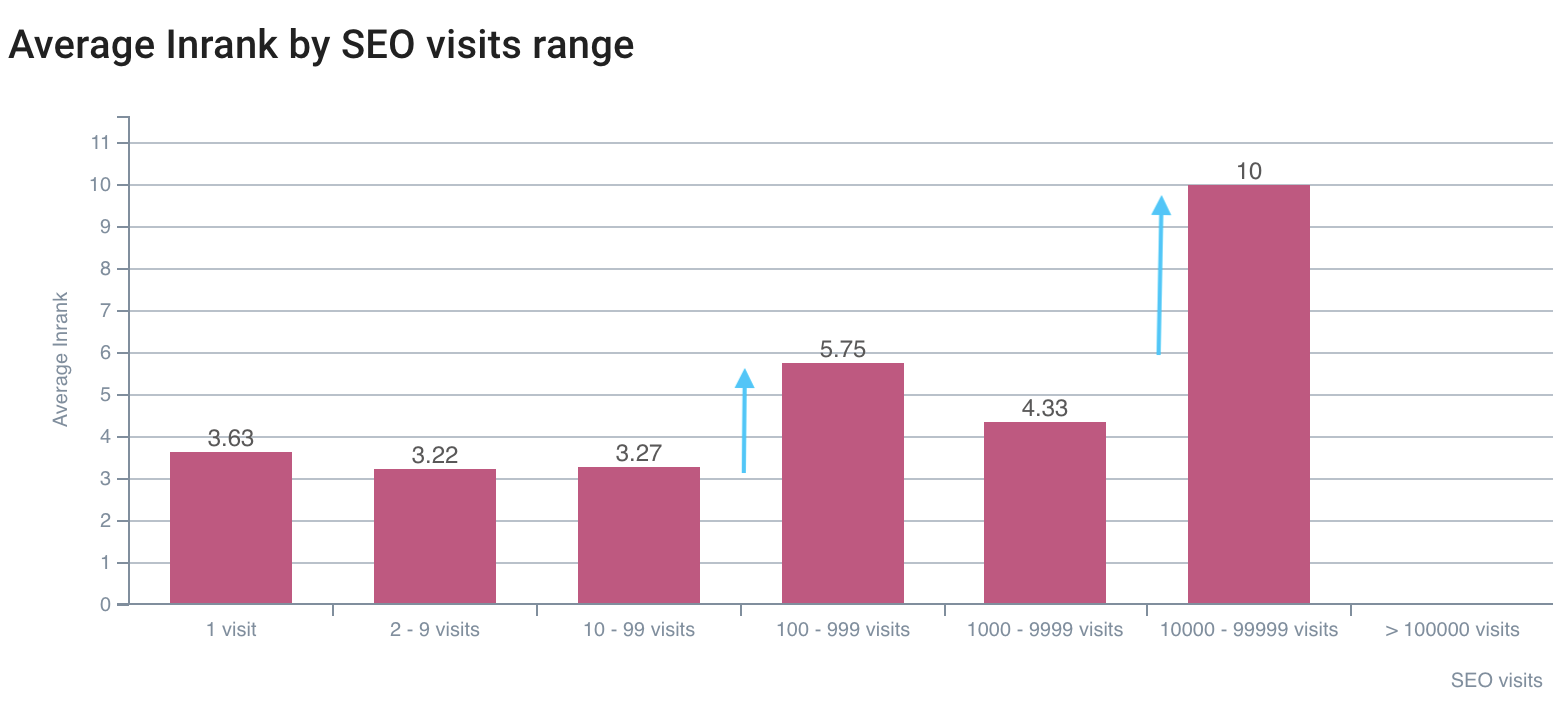

ช่องว่างแรกในการเข้าชม SEO อยู่ที่ InRank 5,75 ที่ดีที่สุดคือ InRank 10 (หน้าแรก)

การรวมข้อมูลการรวบรวมข้อมูลและบันทึกทำให้คุณสามารถเปิดกล่องดำของ Google และกำหนดผลกระทบของตัวชี้วัดของคุณต่อการรวบรวมข้อมูลและการเข้าชมของบอทได้อย่างแม่นยำ เมื่อนำการเพิ่มประสิทธิภาพของคุณไปใช้กับการวิเคราะห์เหล่านี้ คุณสามารถปรับปรุง SEO ของคุณได้ในขณะที่เผยแพร่แต่ละรายการ การใช้งานขั้นสูงนี้มีความทนทานทันเวลา เนื่องจากคุณสามารถตรวจจับค่าใหม่ที่จะเข้าถึงได้ในการวิเคราะห์ข้ามข้อมูลแต่ละครั้ง

เคล็ดลับอื่นๆ เกี่ยวกับการวิเคราะห์ข้อมูลข้ามที่คุณต้องการแชร์