Что такое A/A-тестирование и почему маркетологи должны о нем заботиться?

Опубликовано: 2017-05-18Вы проходили через этот сценарий? Вы настраиваете A/B-тест, чтобы узнать, приведет ли ваша новая комбинация кнопки и заголовка к большему количеству конверсий…

Вы направляете одинаковый трафик на обе свои целевые страницы после клика — контрольную и вариантную — и останавливаетесь через месяц, когда ваше программное обеспечение объявляет ваш вариант победителем с уверенностью 99%…

Вы внедряете новый «выигрышный» дизайн, но через несколько бизнес-циклов повышение коэффициента конверсии на 50 % никак не влияет на вашу прибыль. Вы запутались. Ты раздражен…

И вы, вероятно, стали жертвой ложноположительного результата теста.

Что такое ложноположительный результат теста?

Почему повышение коэффициента конверсии на 50 % не приводит к увеличению продаж? Причина, по словам Лэнса Джонса из Copyhackers, в том, что его, вероятно, не существовало.

Вполне возможно (даже вероятно), что вы не заметите роста продаж или доходов от вашего теста, потому что этого никогда не было. Возможно, вы неосознанно получили «ложноположительный результат» в своем тесте, известный как статистическая ошибка типа I, также известная как неправильное отклонение истинной нулевой гипотезы. Это полный рот, так что я просто помню это как ложное срабатывание.

Со ртом или без, но эти статистические ошибки 1-го типа встречаются чаще, чем вы думаете. Подсчитано, что около 80% результатов теста AB являются мнимыми.

Нажмите, чтобы твитнуть

Если вы принимаете ключевые решения на основе ложных срабатываний, в лучшем случае вы оставляете оптимизацию на волю случая. В худшем случае вы на самом деле ухудшаете коэффициент конверсии ваших целевых страниц после клика.

К счастью, есть несколько способов борьбы с ядовитыми данными. Один из них похож на метод тестирования, с которым вы, вероятно, уже знакомы…

Что такое А/А-тестирование?

A/B-тестирование включает в себя направление трафика на две разные страницы — исходную (ваш контроль) и другую версию (ваш вариант), чтобы увидеть, какая из них работает лучше.

Точно так же A/A-тестирование включает в себя направление трафика на две страницы, чтобы увидеть, какая из них работает лучше. Но в отличие от A/B-тестирования, A/A-тестирование сравнивает две идентичные страницы друг с другом — и вместо того, чтобы обнаружить рост, их цель состоит в том, чтобы не найти разницы между вашим контролем и вариацией.

Зачем вам А/А тест?

Мы не виним вас за то, что вы почесали затылок, задаваясь вопросом: «Что, черт возьми, даст сравнение двух одинаковых страниц друг с другом?»

Это может звучать глупо, но некоторые профессиональные тестировщики используют этот метод для проверки своих A/B-тестов перед их тестированием. (Хм?)

Точные результаты испытаний требуют большего, чем статистическая значимость

Любой может провести A/B-тестирование, но немногие могут провести действительное A/B-тестирование (помните: только около 20% результатов тестов на самом деле являются законными).

Для получения точных тестовых данных требуется нечто большее, чем достижение статистической значимости с помощью большого и репрезентативного размера выборки. Чтобы быть уверенным в своих результатах, вы должны убедиться, что образец не испорчен рядом угроз достоверности.

Одна из таких угроз, инструментальный эффект, — это то, с чем А/А-тесты лучше всего справляются.

Что такое инструментальный эффект?

Защита от угроз достоверности начинается еще до того, как вы начнете A/B-тестирование. Эффект прибора, говорит Пип Ладжа из CXL, отравляет результаты большинства тестов:

Это самая распространенная проблема. Это когда что-то происходит с инструментами тестирования (или инструментами), что приводит к ошибочным данным в тесте. Часто это происходит из-за неправильной реализации кода на веб-сайте и искажает все результаты.

Вот почему при настройке теста важно убедиться, что ваши инструменты настроены правильно и работают так, как должны. Если это не так, могут возникнуть следующие распространенные проблемы:

- Неправильная отчетность по ключевым показателям эффективности. Всего одна ошибка в одном инструменте может исказить ваши данные, поэтому никогда не следует полагаться на одну платформу для отслеживания всей информации о ваших тестах. По крайней мере, интегрируйтесь с Google Analytics, чтобы дважды проверить точность показателей, которые вы видите в своем программном обеспечении для тестирования и отслеживании веб-сайтов. Чтобы получить еще лучшие результаты, трижды проверьте с помощью другого инструмента. С подозрением относитесь к любым отчетам, которые не совпадают относительно близко.

- проблемы с отображением целевой страницы после клика. Небольшие ошибки в коде могут привести к серьезным угрозам достоверности, например, к проблемам с отображением во время A/B-тестирования. Вот почему так важно убедиться, что ваши целевые страницы после клика выглядят так, как они должны выглядеть на всех устройствах и во всех браузерах, и чтобы на ваших посетителей не влиял так называемый «эффект мерцания». Среди прочего, медленный веб-сайт может вызвать эту проблему, которая возникает, когда ваш элемент управления на мгновение отображается вашему посетителю непосредственно перед изменением.

- Слишком ранняя остановка теста. Некоторое программное обеспечение для тестирования преждевременно объявляет выигрышную страницу — когда размер выборки недостаточно велик или не соответствует вашему целевому клиенту. Помните: достижение статистической значимости не означает, что пора прекращать тест. Чем дольше вы его запускаете, тем точнее будут ваши результаты.

Любая из этих (и многих других) проблем может привести к ложноположительному результату в конце вашего теста, поэтому Peep предупреждает тестировщиков быть бдительными:

Когда вы настраиваете тест, наблюдайте за ним как ястреб. Обратите внимание, что каждая отслеживаемая вами цель и показатель записываются. Если какая-то метрика не отправляет данные (например, добавить данные о кликах в корзину), остановите тест, найдите и устраните проблему и начните заново, сбросив данные.

Но не все чувствуют себя комфортно, сразу же приступая к A/B-тестированию обеими ногами, особенно при использовании нового программного обеспечения. Поэтому, в качестве дополнительной меры предосторожности, некоторые практикующие специалисты проводят A/A-тестирование, чтобы оценить свои инструменты перед началом A/B-тестирования.

Если ваш эксперимент настроен правильно, в конце теста A/A обе страницы должны появиться с одинаковым коэффициентом конверсии. Однако, как показывают следующие тестеры, это происходит не всегда.

Примеры A/A-тестирования

Действительно ли ложные срабатывания так распространены? Может ли одна страница действительно превзойти свой клон? Эти ребята использовали A/A-тестирование, чтобы выяснить это, и рассказали о своих выводах в следующих постах в блоге…

1. Сплит-тестирование домашней страницы выявило основные недостатки популярных инструментов тестирования

11 ноября 2012 года команда Copyhackers начала сплит-тест A/A на своей домашней странице, как показано на рисунке ниже:

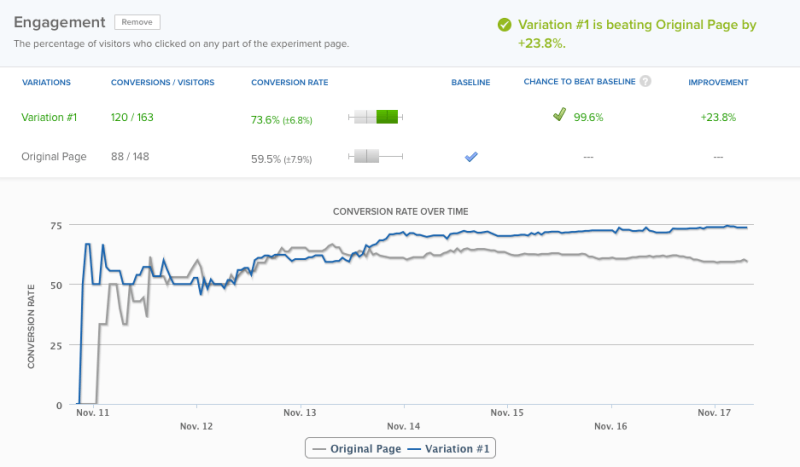

18-го числа — через 6 дней — их инструмент для тестирования объявил победителем с 95-процентной уверенностью. Однако ради точности команда решила провести тест еще один день, после чего их программное обеспечение объявило победителя с уровнем достоверности 99,6%:

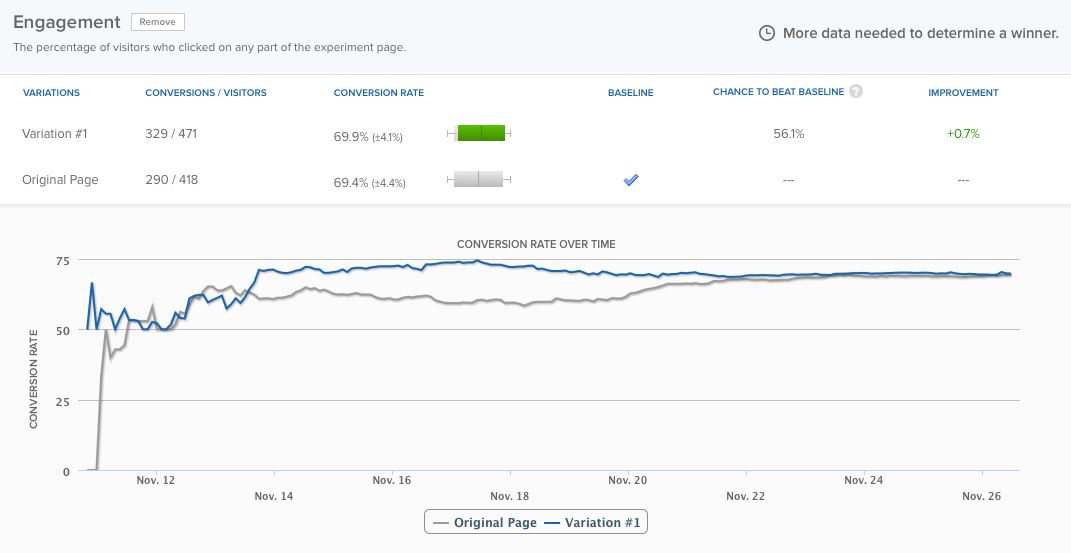

Их домашняя страница работала почти на 24% лучше, чем та же самая страница , и, согласно программному обеспечению, вероятность того, что результат был ложноположительным, составляла всего 0,4%. Тем не менее, команда провела тест еще около трех дней, и в конце концов различия сравнялись:

Но дело не в этом. Дело в том, что инструмент тестирования слишком рано объявил победителя. Если бы команда Copyhackers не поддерживала его в рабочем состоянии, они бы ошибочно предположили, что в их эксперименте возникла проблема. Подробнее о тесте читайте здесь.

2. A/A-тестирование: как я увеличил конверсию на 300 %, абсолютно ничего не делая

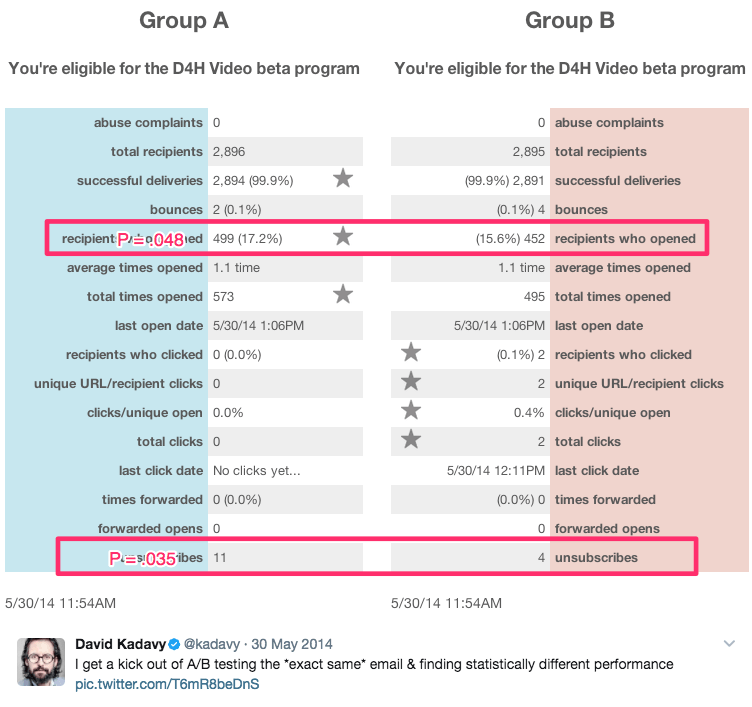

Это саркастическое название принадлежит автору и самопровозглашенному «выздоравливающему предпринимателю» Дэвиду Кадави, который в течение 8 месяцев провел ряд A/A-тестов на 750 000 подписчиков электронной почты. За это время он получил статистически значимые результаты, например:

Среди этих результатов были:

- Электронная почта открывается на 9% больше

- Увеличение количества кликов на 300%

- На 51% ниже процент отписок

Он говорит:

Для многих предприимчивых предпринимателей (включая меня в прошлом) это выглядело как «Ого, вы увеличили количество открытий на 10%!» Они могут даже ввести его в калькулятор значимости Visual Website Optimizer и увидеть, что p = 0,048. «Это статистически значимо!» они (или я) могли бы воскликнуть.

Правда в том, что все это были А/А-тесты. Содержимое, протестированное друг против друга, было идентичным. Смотрите больше его результатов здесь.

Стоит ли проводить А/А-тесты?

Ответ на этот вопрос зависит от того, кого вы спросите.

Нил Пател, который постоянно наблюдал значительный рост конверсии, который не приносил увеличения доходов, говорит: «Очень важно, чтобы вы сначала провели A/A-тестирование, поскольку это поможет вам не тратить время на неточное программное обеспечение».

С другой стороны, Пип Ладжа из CXL говорит, что сами по себе A/A-тесты — пустая трата времени. Так кто прав?

Две основные проблемы с A/A-тестированием

С теоретической точки зрения A/A-тестирование имеет большой смысл. Прежде всего, точность наиболее важна при проведении A/B-тестирования, а тестирование вашего теста — лишь один из многих способов убедиться в этом.

Однако в реальных условиях тестирования A/A-тесты могут принести больше вреда, чем пользы. Крейг Салливан объясняет:

Для меня проблема всегда заключается в потреблении реального трафика и времени тестирования из-за необходимости предварительной загрузки времени выполнения теста периодом A/A-тестирования. Если я попытаюсь запустить 40 тестов в месяц, это подорвет мою способность запускать материал. Я бы предпочел полдня на тестирование QA эксперимента, чем 2-4 недели A/A-тестирования, чтобы проверить, все ли в порядке.

Это проблема номер один. Тесты A/A требуют реального времени и трафика, которые вы могли бы использовать, чтобы узнать больше о посетителях вашего сайта с помощью тестов A/B.

Вторая проблема иллюстрируется примером из компании Copyhackers. Как и тесты A/B, тесты A/A необходимо тщательно разрабатывать и контролировать, поскольку они также подвержены ложным срабатываниям.

Другими словами, ваш A/A-тест может сказать вам, что одна страница работает лучше, чем другая, когда это не так (такая вероятность намного выше, чем вы думаете — около 50%).

Если бы команда Copyhackers прислушалась к своему тестовому инструменту и объявила победителя всего за шесть дней, они потратили бы еще больше времени, пытаясь выяснить, почему их домашняя страница работает лучше, чем ее идентичный близнец (хотя на самом деле это не так). .

Основное преимущество A/A-тестирования

Несмотря на эти проблемы, A/A-тестирование может помочь вам выявить еще более серьезные проблемы во время реальных тестов. Когда на результаты этих тестов вы опираетесь при принятии важных бизнес-решений, это большое преимущество, которое следует учитывать.

Если вы решите провести А/А-тестирование, есть потенциально менее расточительный способ, который называется А/А/В-тестирование.

Сравнение A/A/B-тестирования и A/A-тестирования

Традиционный метод A/A-тестирования тратит впустую трафик, потому что по завершении он ничего не говорит вам о ваших посетителях. Но если вы добавите к этому тесту вариант «В», то может. Вот разница между ними:

- А/А-тест = 2 идентичные страницы, протестированные друг против друга.

- Тест A/A/B = 2 идентичные страницы и один вариант, протестированные друг против друга.

Тест A/A/B разделяет ваш трафик на три сегмента, что означает, что для достижения статистической значимости потребуется больше времени. Но преимущество в том, что как только вы это сделаете, у вас будут данные как о вашем инструменте тестирования, так и о ваших посетителях.

Сравните результаты A и A, чтобы определить, можете ли вы доверять своему тесту. Если они статистически похожи, сравните результаты A и B. Если нет, вам придется отбросить результаты всего теста (который занял больше времени, чем традиционный A/A-тест). так как ваш трафик сегментирован по трем направлениям).

Перевешивают ли преимущества A/A-тестирования недостатки?

Одни специалисты говорят «да», другие — «нет». Эндрю Первый из Leadplum, кажется, думает, что ответ находится где-то между:

A/A-тестирование, вероятно, не должно быть ежемесячным мероприятием, но когда вы настраиваете новый инструмент, стоит потратить время на проверку ваших данных. Если вы перехватите неверные данные сейчас, вы будете более уверены в результатах тестирования через несколько месяцев.

В конце концов, решать вам. Если вы используете новый инструмент, возможно, стоит последовать совету Эндрю. Однако, если вы этого не сделаете, вероятно, лучше последовать примеру Крейга Салливана и вместо этого установить строгий процесс контроля качества перед тестированием. Сэкономьте свое время, ресурсы и трафик для A/B-тестирования.

Получите максимальную отдачу от своих усилий по тестированию и цифровых рекламных кампаний, подпишитесь на демонстрацию Instapage Enterprise сегодня.