12 лучших инструментов веб-скрейпинга в 2022 году для извлечения онлайн-данных

Опубликовано: 2022-06-27Инструменты веб-скрапинга — это программное обеспечение, разработанное специально для упрощения процесса извлечения данных с веб-сайтов. Извлечение данных — довольно полезный и широко используемый процесс, однако он также может легко превратиться в сложный и беспорядочный бизнес, требующий большого количества времени и усилий.

Итак, что делает парсер?

Веб-скрапер использует ботов для извлечения структурированных данных и контента с веб-сайта путем извлечения основного HTML-кода и данных, хранящихся в базе данных.

При извлечении данных , от предотвращения блокировки вашего IP-адреса до правильного анализа исходного веб-сайта, создания данных в совместимом формате и очистки данных, происходит множество подпроцессов. К счастью, веб-скрейперы и инструменты очистки данных сделать этот процесс простым, быстрым и надежным.

- Часто информация, которую нужно извлечь онлайн, слишком велика, чтобы ее можно было извлечь вручную. Именно поэтому компании, использующие инструменты веб-скрапинга, могут собирать больше данных за более короткий промежуток времени и с меньшими затратами.

- Кроме того, компании, извлекающие выгоду из парсинга данных, в долгосрочной перспективе вырываются на шаг вперед в конкурентной борьбе.

В этом посте вы найдете список из 12 лучших инструментов веб-скрейпинга, сравниваемых на основе их функций, цены и простоты использования.

12 лучших инструментов для веб-скрейпинга Вот список лучших инструментов для веб-скрейпинга:

- Люминати (BrightData)

- Scrape.do

- Скребок

- АвесAPI

- ParseHub

- Диффбот

- Октопарс

- Соскобпчела

- Грепср

- API парсера

- Скрапи

- Импорт.ио

| Инструменты веб-скрейпинга | Стоимость 1 000 000 вызовов API | Ротация IP | JS-рендеринг | Геолокация |

|---|---|---|---|---|

| Scrape.do | $99/м | |||

| API парсера | $99/м | |||

| Скребок | $90/м | |||

| АвесAPI | $800/м | ✘ | ||

| ParseHub | $499/м | ✘ | ||

| Диффбот | $899/м | |||

| Октопарс | $75/м | ✘ | ||

| Соскобпчела | $99/м | |||

| Люминати | Плати как сможешь | |||

| Грепср | $999/м | ✘ | ||

| Скрапи | Свободно | ✘ | ✘ | ✘ |

| Импорт.ио | По заявке | ✘ |

Инструменты веб-парсера ищут новые данные вручную или автоматически. Они извлекают обновленные или новые данные, а затем сохраняют их, чтобы вы могли легко получить к ним доступ. Эти инструменты полезны для всех, кто пытается собирать данные из Интернета.

Например, инструменты веб-скрапинга можно использовать для сбора данных о недвижимости, данных об отелях с ведущих туристических порталов, данных о продуктах, ценах и отзывах для веб-сайтов электронной коммерции и многого другого. Итак, в основном, если вы спрашиваете себя, «где я могу очистить данные», это инструменты очистки данных.

Теперь давайте посмотрим на список лучших инструментов для парсинга веб-страниц в сравнении , чтобы ответить на вопрос; какой лучший инструмент для парсинга веб-страниц?

1. Соскоблить.сделать

Scrape.do — это простой в использовании инструмент веб-скребка, предоставляющий масштабируемый, быстрый API-интерфейс веб-скрейпера в конечной точке. По экономической эффективности и возможностям Scrape.do занимает первое место в списке. Как вы увидите в продолжении этого поста, Scrape.do — один из самых дешевых инструментов для парсинга веб-страниц.

- В отличие от своих конкурентов, Scrape.do не взимает дополнительную плату за Google и другие веб-сайты, которые трудно парсить.

-Он предлагает лучшее соотношение цена/качество на рынке парсинга Google (SERP). (5 000 000 SERP за 249 долларов США)

-Кроме того, у Scrape.do средняя скорость сбора анонимных данных из Instagram составляет 2-3 секунды, а вероятность успеха составляет 99%.

-Скорость его шлюза также в 4 раза выше, чем у конкурентов.

-Кроме того, этот инструмент обеспечивает доступ к резидентным и мобильным прокси в два раза дешевле.

Вот некоторые из его других особенностей.

Функции

- Вращающиеся прокси; позволяет парсить любой сайт. Scrape.do ротирует каждый запрос к API, используя свой пул прокси.

- Неограниченная пропускная способность на всех тарифах

- Полностью настраиваемый

- Плата взимается только за успешные запросы

- Опция геотаргетинга для более чем 10 стран

- Рендеринг JavaScript, который позволяет очищать веб-страницы, требующие рендеринга JavaScript.

- Параметр суперпрокси: позволяет собирать данные с веб-сайтов с защитой от IP-адресов центров обработки данных.

Цены: тарифные планы начинаются с $29/м. План Pro стоит 99 долларов США в месяц за 1 300 000 вызовов API.

Начать работу с Scrape.do

2. BrightData (Люминати)

BrightData — веб-скребок с открытым исходным кодом для извлечения данных. Это сборщик данных, обеспечивающий автоматизированный и настраиваемый поток данных.

Функции

- Разблокировщик данных

- Управление прокси без кода, с открытым исходным кодом

- Сканер поисковой системы

- Прокси-API

- Расширение для браузера

Каптерра Рейтинг: 4.9/5

Цены. Цены варьируются в зависимости от выбранных решений: Proxy Infrastructure, Data Unblocker, Data Collector и дополнительных функций. Посетите веб-сайт Luminati.io для получения подробной информации.

Начните парсить с BrightData

3. АвесАПИ

AvesAPI — это инструмент API SERP (страницы результатов поисковой системы), который позволяет разработчикам и агентствам извлекать структурированные данные из поиска Google.

В отличие от других сервисов в нашем списке, AvesAPI уделяет особое внимание данным, которые вы будете извлекать, а не более широкому анализу веб-страниц. Поэтому он лучше всего подходит для SEO-инструментов и агентств, а также для специалистов по маркетингу.

Этот парсер представляет собой интеллектуальную распределенную систему, способную с легкостью извлекать миллионы ключевых слов. Это означает отказ от трудоемкой ручной проверки результатов поисковой выдачи и избегания CAPTCHA.

Функции:

Получайте структурированные данные в формате JSON или HTML в режиме реального времени

Получите топ-100 результатов из любого места и языка

Географический поиск для местных результатов

Анализировать данные о товарах при покупках

Недостаток: поскольку этот инструмент был основан совсем недавно, трудно сказать, как настоящие пользователи относятся к продукту. Тем не менее, то, что обещает продукт, по-прежнему превосходно, попробуйте его бесплатно и убедитесь в этом сами.

Цены: цены на AvesAPI вполне доступны по сравнению с другими инструментами веб-скрейпинга. Кроме того, вы можете попробовать сервис бесплатно.

Платные планы начинаются с 50 долларов в месяц за 25 тысяч поисковых запросов.

4. ПарсХаб

ParseHub — это бесплатный веб-скрейпер, разработанный для извлечения онлайн-данных. Этот инструмент поставляется в виде загружаемого настольного приложения. Он предоставляет больше возможностей, чем большинство других парсеров, например, вы можете очищать и загружать изображения/файлы, загружать файлы CSV и JSON. Вот список других его функций.

Функции

- Ротация IP

- Облако для автоматического хранения данных

- Запланированный сбор (для сбора данных ежемесячно, еженедельно и т. д.)

- Регулярные выражения для очистки текста и HTML перед загрузкой данных

- API и вебхуки для интеграции

- ОТДЫХА API

- Формат JSON и Excel для загрузки

- Получить данные из таблиц и карт

- Бесконечная прокрутка страниц

- Получить данные для входа в систему

Цены: Да, ParseHub предлагает множество функций, но большинство из них не включены в его бесплатный план. Бесплатный план покрывает 200 страниц данных за 40 минут и 5 общедоступных проектов.

Цены на планы начинаются от $149/м. Таким образом, я могу предположить, что большее количество функций стоит дороже. Если ваш бизнес небольшой, возможно, лучше всего использовать бесплатную версию или один из более дешевых парсеров из нашего списка.

5. Диффбот

Diffbot — еще один инструмент веб-скрейпинга, который предоставляет извлеченные данные с веб-страниц. Этот парсер данных является одним из лучших экстракторов контента. Он позволяет автоматически идентифицировать страницы с помощью функции Analyze API и извлекать продукты, статьи, обсуждения, видео или изображения.

Функции

- API продукта

- Чистый текст и HTML

- Структурированный поиск для просмотра только подходящих результатов

- Визуальная обработка, которая позволяет очищать большинство веб-страниц, отличных от английского.

- Формат JSON или CSV

- Статья, продукт, обсуждение, видео, API извлечения изображений

- Пользовательские элементы управления сканированием

- Полностью размещенная SaaS

Цена: 14-дневная бесплатная пробная версия. Ценовые планы начинаются с 299 долларов за м, что довольно дорого и является недостатком инструмента. Однако вам решать, нужны ли вам дополнительные функции, предоставляемые этим инструментом, и оценивать его экономическую эффективность для вашего бизнеса.

6. Октопарс

Octoparse выделяется как простой в использовании инструмент для очистки веб-страниц без кода . Он предоставляет облачные сервисы для хранения извлеченных данных и чередования IP-адресов, чтобы предотвратить блокировку IP-адресов. Вы можете запланировать парсинг на любое конкретное время. Кроме того, он предлагает функцию бесконечной прокрутки. Результаты загрузки могут быть в форматах CSV, Excel или API.

Кто это для? Octoparse лучше всего подходит для не-разработчиков, которым нужен удобный интерфейс для управления процессами извлечения данных.

Каптерра Рейтинг : 4.6/5

Цена: доступен бесплатный план с ограниченными функциями. Тарифные планы начинаются от $75/м.

7. Пчела-скребок

ScrapingBee — еще один популярный инструмент для извлечения данных. Он отображает вашу веб-страницу так, как если бы это был настоящий браузер, позволяя управлять тысячами безголовых экземпляров с помощью последней версии Chrome.

Таким образом, они утверждают, что работа с безголовыми браузерами, как это делают другие веб-скребки, тратит время и потребляет вашу оперативную память и процессор. Что еще предлагает ScrapingBee?

Функции

- Рендеринг JavaScript

- Ротация прокси

- Общие задачи парсинга в Интернете, такие как парсинг недвижимости, мониторинг цен, извлечение отзывов без блокировки.

- Парсинг страниц результатов поисковой системы

- Взлом роста (генерация потенциальных клиентов, извлечение контактной информации или социальных сетей).

Цены: тарифные планы ScrapingBee начинаются с 29 долларов за м.

8. Скребок

Scrapingdog — это инструмент для парсинга веб-страниц, который упрощает работу с прокси-серверами, браузерами и CAPTCHA. Этот инструмент предоставляет HTML-данные любой веб-страницы за один вызов API. Одной из лучших особенностей Scraping Dog является то, что он также имеет доступ к LinkedIn API. Вот другие важные особенности Scrapingdog:

Функции

- Меняет IP-адрес с каждым запросом и обходит все CAPTCHA для парсинга без блокировки.

- Рендеринг JavaScript

- Вебхуки

- Безголовый хром

Кто это для? Scrapingdog предназначен для всех, кто нуждается в парсинге веб-страниц, от разработчиков до тех, кто не является разработчиком.

Цены: Тарифные планы начинаются от $20/м. Функция рендеринга JS доступна как минимум для стандартного плана, который стоит 90 долларов США за м. LinkedIn API доступен только для тарифного плана pro ($200/м.)

9. Грепср

Разработанный для создания решений для очистки данных, Grepsr может помочь вашим программам привлечения потенциальных клиентов, а также сбору конкурентных данных, агрегации новостей и сбору финансовых данных. Веб-скрапинг для генерации лидов или парсинг лидов позволяет вам извлекать адреса электронной почты.

Знаете ли вы, что использование всплывающих окон также является очень простым и эффективным способом привлечения потенциальных клиентов? С помощью конструктора всплывающих окон Popupsmart вы можете создавать привлекательные всплывающие окна с подпиской, настраивать расширенные правила таргетинга и просто собирать потенциальных клиентов со своего веб-сайта.

Плюс есть бесплатная версия.

Создайте свое первое всплывающее окно за 5 минут.

Теперь, что касается Grepsr, давайте взглянем на выдающиеся возможности этого инструмента.

Функции

- Данные лидогенерации

- Ценообразование и конкурентные данные

- Финансовые и рыночные данные

- Мониторинг распределительной цепи

- Любые пользовательские требования к данным

- API готов

- Данные социальных сетей и многое другое

Цены: ценовые планы начинаются от 199 долларов за источник. Это немного дорого, так что это может быть недостатком. Тем не менее, это зависит от потребностей вашего бизнеса.

10. API парсера

Scraper API — это прокси-API для парсинга веб-страниц. Этот инструмент помогает вам управлять прокси-серверами, браузерами и CAPTCHA, поэтому вы можете получить HTML-код с любой веб-страницы, выполнив вызов API.

Функции

- Ротация IP

- Полностью настраиваемый (заголовки запроса, тип запроса, IP-геолокация, безголовый браузер)

- Рендеринг JavaScript

- Неограниченная пропускная способность со скоростью до 100 Мбит/с

- 40+ миллионов IP-адресов

- 12+ геолокаций

Цены: платные планы начинаются с 29 долларов США за м, однако самый дешевый план не включает геотаргетинг и рендеринг JS, и он ограничен.

Стартовый план ($99/м) включает только геолокацию в США и без рендеринга JS. Чтобы воспользоваться всеми преимуществами геолокации и рендеринга JS, вам необходимо приобрести бизнес-план стоимостью 249 долларов США в месяц.

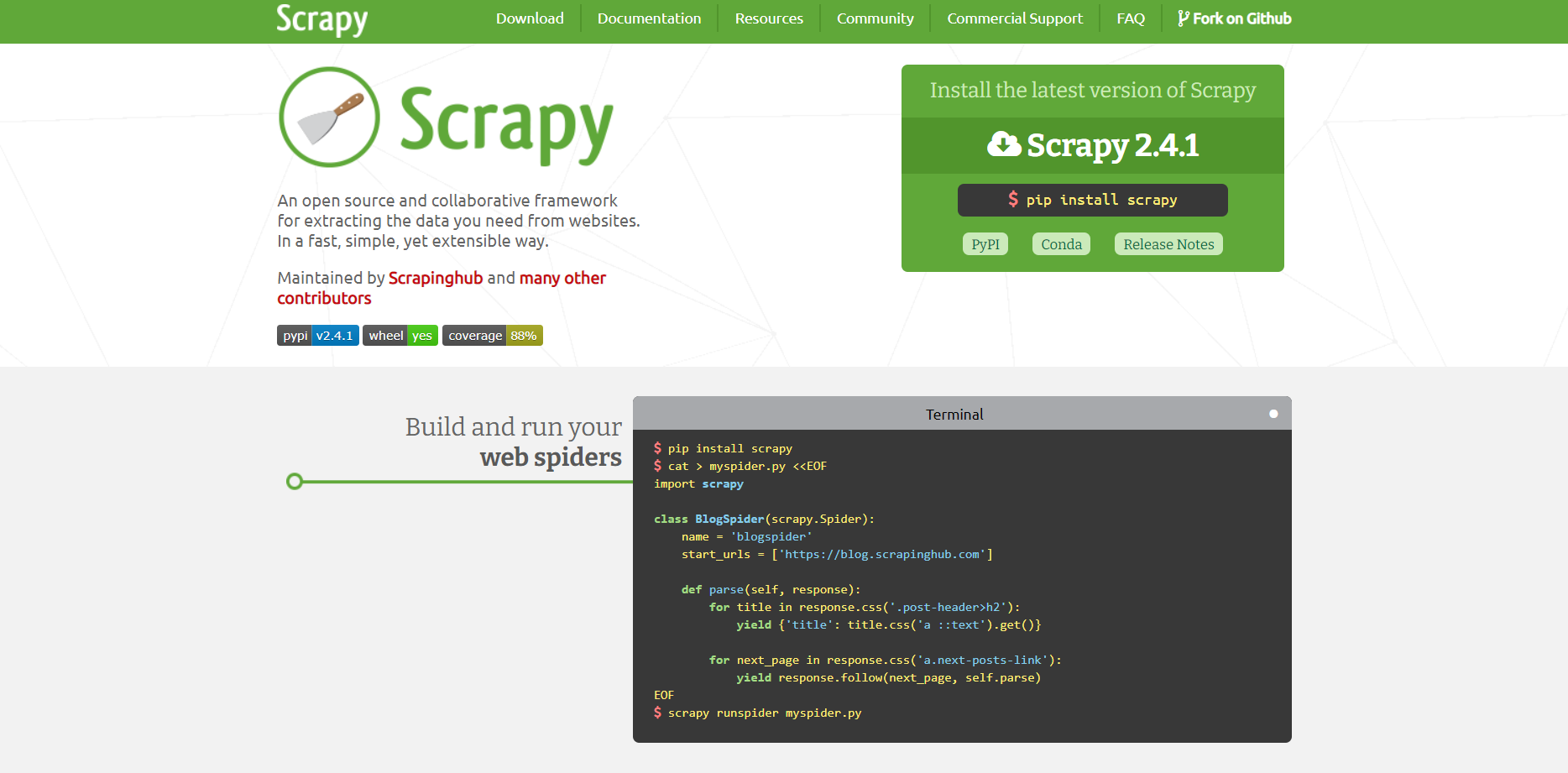

11. Скрепи

Еще один в нашем списке лучших инструментов для веб-скрейпинга — Scrapy. Scrapy — это платформа для совместной работы с открытым исходным кодом, предназначенная для извлечения данных с веб-сайтов. Это библиотека парсинга веб-страниц для разработчиков Python , которые хотят создавать масштабируемые поисковые роботы.

Этот инструмент полностью бесплатный.

12. Импорт.ио

Инструмент веб-скрейпинга Import.io помогает собирать данные в любом масштабе. Он предлагает оперативное управление всеми вашими веб-данными, обеспечивая при этом точность, полноту и надежность.

Import.io предлагает конструктор для формирования собственных наборов данных путем импорта данных с определенной веб-страницы, а затем экспорта извлеченных данных в CSV. Кроме того, он позволяет создавать более 1000 API на основе ваших требований.

Import.io поставляется в виде веб-инструмента вместе с бесплатными приложениями для Mac OS X, Linux и Windows.

Хотя Import.io предоставляет полезные функции, этот инструмент веб-скрейпинга также имеет некоторые недостатки, о которых я должен упомянуть.

Рейтинг Каптерры: 3,6/5. Причиной такой низкой оценки являются его минусы. Большинство пользователей жалуются на отсутствие поддержки и слишком большие затраты.

Цены: Цена по заявке через планирование консультации.

Заворачивать

Я попытался перечислить лучшие инструменты веб-скрейпинга, которые облегчат вашу работу по извлечению данных в Интернете. Я надеюсь, что вы найдете этот пост полезным при выборе парсера данных. Есть ли у вас какие-либо другие инструменты для парсинга веб-страниц, которые вы используете и предлагаете? Я хотел бы услышать. Вы можете написать в комментариях.

Предлагаемые статьи:

- 10 лучших инструментов оптимизации изображений и CDN для увеличения скорости сайта

- 10 лучших инструментов извлечения и поиска электронной почты LinkedIn

- 21 лучший CRO-инструмент для повышения конверсии и UX (бесплатно и платно)

Спасибо за ваше время.