Как повысить рейтинг с более оптимизированным краулинговым бюджетом

Опубликовано: 2018-09-06На ранжирование влияет множество факторов — внешние ссылки, использование ключевых слов, скорость сайта и многое другое. Но когда вы начинаете оптимизировать свой сайт, вам нужно помнить, что для того, чтобы все ваши усилия по оптимизации окупились, ваш сайт должен быть просканирован и проиндексирован.

Способ сканирования вашего веб-сайта определяется вашим краулинговым бюджетом — количеством посещений вашего сайта роботом Googlebot в течение определенного периода времени. И видимость вашего сайта зависит от того, насколько хорошо сбалансирован краулинговый бюджет.

Почему краулинговый бюджет влияет на видимость вашего сайта в Google?

Бюджет сканирования ограничен. Это создает несколько проблем:

- Если краулинговый бюджет не оптимизирован, робот Googlebot посещает не все страницы сайта. В результате они не индексируются и не ранжируются в результатах поиска.

- Обновленные страницы могут долгое время не получать внимания робота Googlebot из-за частоты сканирования страниц другого веб-сайта. Это негативно влияет на вашу временную шкалу SEO: пока Google не знает о ваших усилиях по оптимизации, ваша видимость в поисковой выдаче не улучшится.

Итак, чтобы обеспечить регулярное посещение всех важных страниц, необходимо оптимизировать краулинговый бюджет. Вот как вы можете это сделать.

Как определить текущий краулинговый бюджет

Чтобы выяснить, нуждается ли ваш краулинговый бюджет в оптимизации, сначала проверьте, хватает ли его вообще. По словам Гэри Иллиса из Google, только крупные сайты действительно должны расставлять приоритеты для сканирования, особенно те, которые автоматически генерируют множество URL-адресов на основе параметров. Если вы считаете, что ваш сайт требует дополнительной балансировки краулингового бюджета, вот как начать.

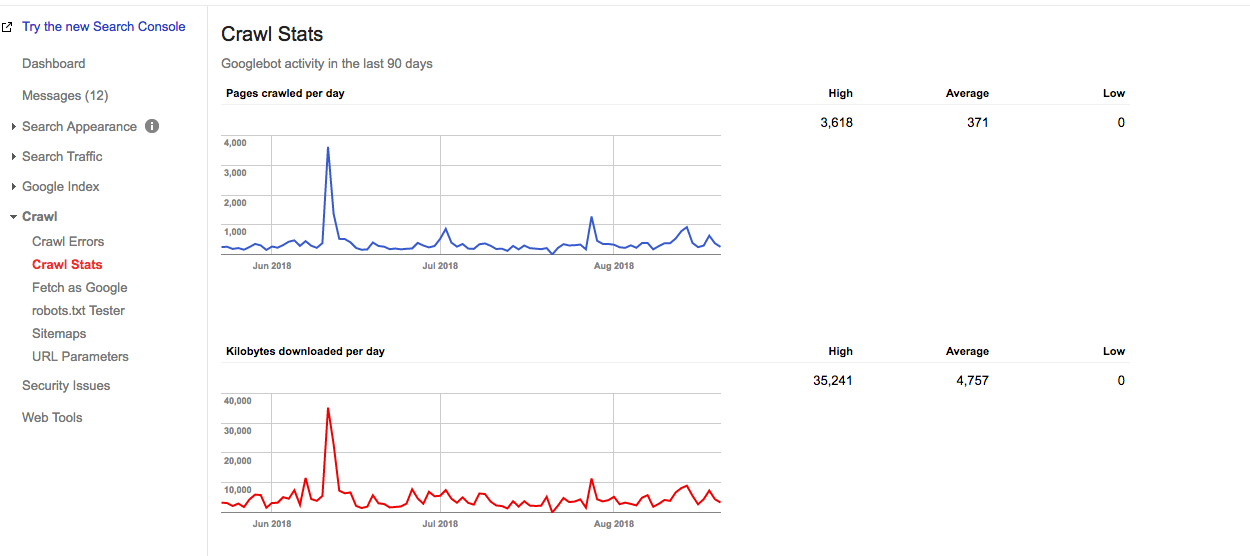

В Google Search Console вы можете найти статистику сканирования вашего текущего сайта и узнать подробности вашего краулингового бюджета.

Примерный краулинговый бюджет можно рассчитать так:

Среднее количество просканированных страниц в день x количество дней в месяце =

Приблизительный краулинговый бюджет

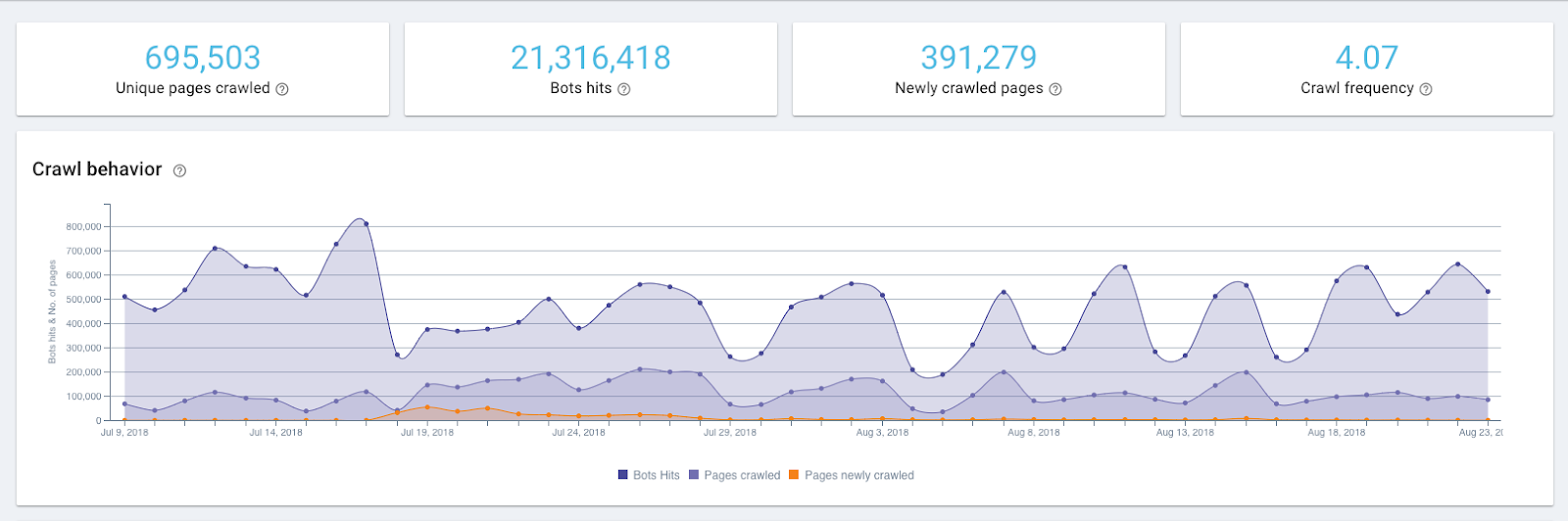

Например, из приведенного ниже отчета видно, что на этом веб-сайте Google сканирует 371 страницу в день.

График статистики сканирования в Google Search Console

Таким образом, примерный краулинговый бюджет этого сайта составляет:

371 х 30 = 11130

Но чтобы точно знать, как часто поисковые роботы Google попадают на ваш сайт, вам нужно проверить журналы сервера. Google Search Console показывает совокупный краулинговый бюджет для 12 ботов, и чтобы увидеть точное распределение краулингового бюджета, вам понадобится инструмент для анализа журналов.

Взлеты и падения на графике обхода могут быть признаком проблемы, но это не всегда так. Например, всплеск на графике выше представляет собой повторно отправленную карту сайта, которая является триггером для повторного посещения веб-сайта роботом Googlebot.

Как оптимизировать краулинговый бюджет

Чтобы оптимизировать краулинговый бюджет, вам нужно придерживаться простого правила:

Убедитесь, что то, что нужно сканировать, сканируется, а то, что не нужно сканировать, не сканируется.

Это означает, что важные страницы получают достаточно внимания, а те, которые не приносят никакой ценности вашему сайту, остаются без внимания. Вот точные шаги, которые приведут вас туда.

1. Убедитесь, что все ваши важные страницы доступны роботу Googlebot (например, не заблокированы в robots.txt).

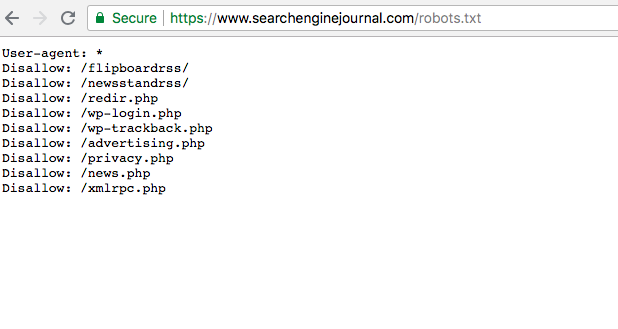

Удивительно, но очень часто важные страницы имеют статус дезавуирования в файле robots.txt. Так они игнорируются роботом Googlebot и, таким образом, скрываются от индексации. Ваша задача — убедиться, что страницы, которые вы хотите просканировать, не имеют такого статуса и доступны для сканеров.

Вы можете найти файл robots.txt в Google Search Console. Чтобы убедиться, что ваши важные страницы не будут дезавуированы, просто просмотрите файл.

2. Проверьте общее состояние вашего сайта, так как оно влияет на частоту посещений роботом Google (также известное как ограничение скорости сканирования).

Как говорит сам Google, предел скорости сканирования — это максимальная скорость загрузки для данного сайта. Проще говоря, он указывает, сколько параллельных подключений может создать робот Googlebot для сканирования сайта и как долго он должен ждать между выборками. Когда скорость сайта высока, лимит увеличивается, и робот Googlebot создает больше одновременных подключений. Когда скорость отклика сайта низкая или он возвращает ошибки сервера, лимит уменьшается, и робот Googlebot сканирует меньше.

Таким образом, способ сканирования вашего сайта также зависит от состояния сайта. Это включает в себя скорость сайта, удобство для мобильных устройств, количество ошибок 404 и т. д.

С помощью этих инструментов можно проверить работоспособность сайта.

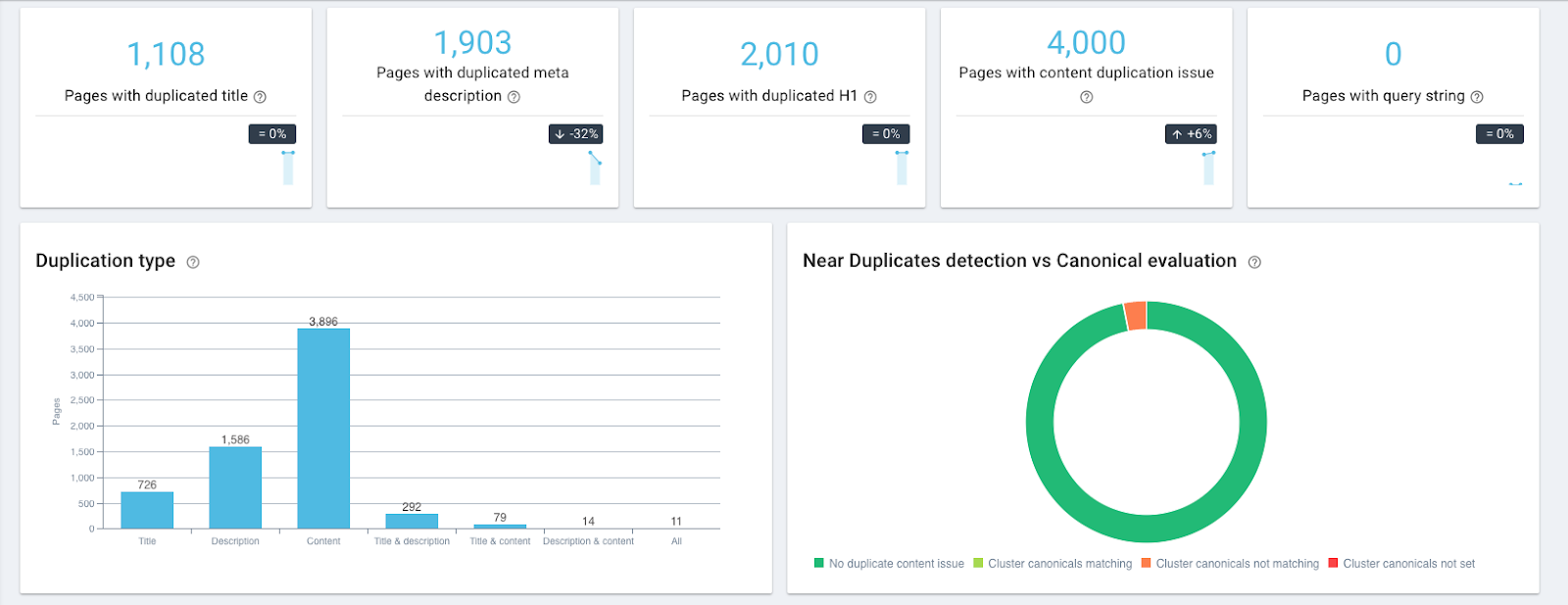

- OnCrawl позволяет находить страницы с дублирующимся и почти дублирующимся контентом, 404 и страницы-сироты (на которые нет внутренних ссылок, указывающих на них) и т. д.

Дублирование виджетов контента в OnCrawl

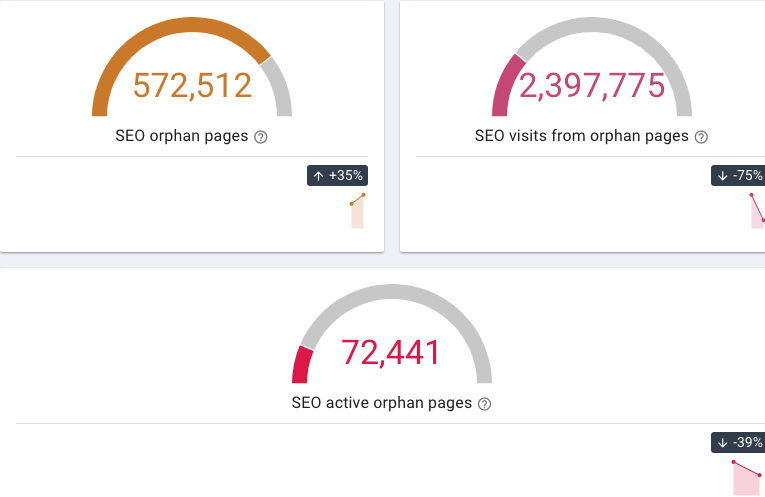

Виджеты потерянных страниц в OnCrawl

- Google Mobile-Friendly Test проверяет удобство веб-сайта для мобильных устройств.

- Скорость сайта можно проверить с помощью бесплатных инструментов PageSpeed Insights или GTmetrix.

Затем вы можете отслеживать частоту сканирования с помощью анализатора файлов журнала, такого как OnCrawl, и видеть, чаще ли робот Googlebot посещает ваши страницы.

3. Исключите страницы, которые не приносят пользователям никакой ценности

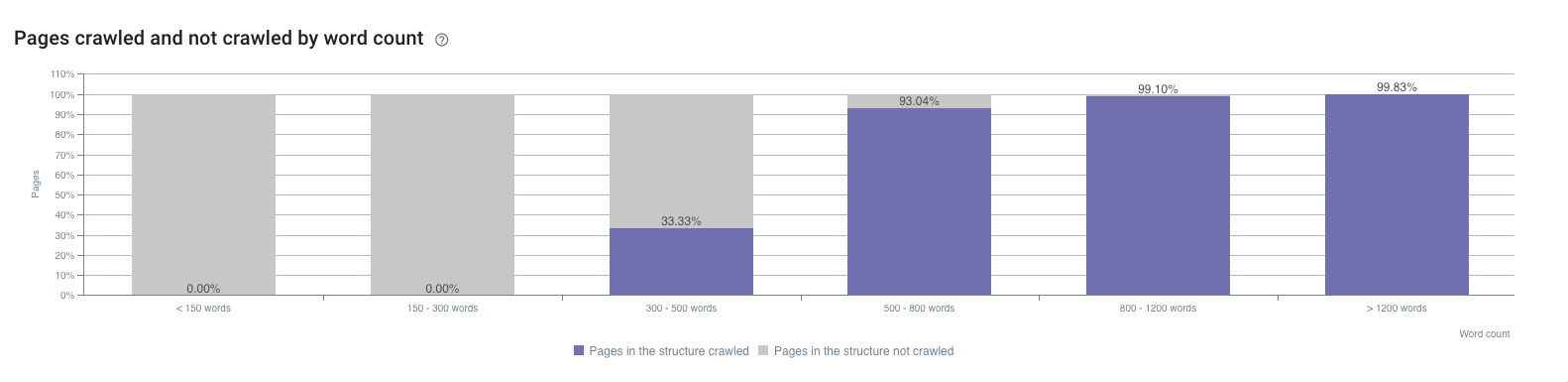

Это страницы со слабым или отсутствующим контентом, технические страницы и т. д. Поскольку они проиндексированы и имеют мало показов, их можно найти в консоли поиска Google. Еще одно место, где их можно найти, — это отчет OnCrawl’s SEO Impact. Например, он показывает влияние количества слов на частоту сканирования.

Например, распространенной проблемой для крупных сайтов электронной коммерции является многогранная навигация. Райан Стюарт рассказывает об этом в своем видео об оптимизации краулингового бюджета (вы можете перейти к 7:20, чтобы проверить это, но все видео также чрезвычайно полезно). Когда пользователь выбирает категорию на веб-сайте, ее параметр добавляется к URL-адресу страницы. По словам робота Googlebot, с этого момента это другой URL-адрес, требующий отдельного посещения. Поскольку количество возможных комбинаций категорий огромно и может значительно перегрузить краулинговый бюджет, такие страницы необходимо отфильтровывать.

Аналогичная проблема возникает, когда идентификатор сеанса помещается в URL-адреса. Такие страницы также должны быть отфильтрованы.

4. Расставьте приоритеты для своих страниц, чтобы наиболее важные из них сканировались чаще

Страница важна, если она имеет большой потенциал трафика.

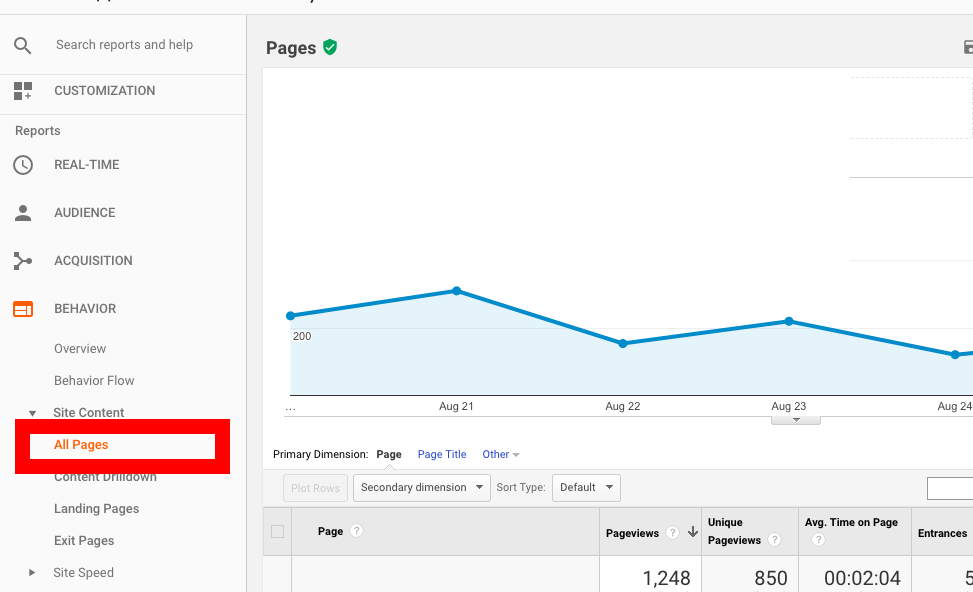

Во-первых, это те страницы, которые уже имеют большую посещаемость; вы можете обнаружить их в Google Analytics. В разделе «Отчет о поведении » перейдите в раздел « Контент сайта » → « Все страницы » и отсортируйте страницы по количеству просмотров.

Во-вторых, это страницы, чьи позиции улучшаются, а значит, их популярность растет. Такие страницы можно найти в Google Search Console, но из-за ограниченных параметров фильтрации может пройти некоторое время, прежде чем вы их обнаружите.

Альтернативой может быть использование AccuRanker, так как он позволяет вам увидеть, какие страницы имеют растущую тенденцию видимости. Чтобы начать использовать его, вы можете импортировать список ключевых слов из Google Search Console в один клик, а затем определить, какие страницы являются наиболее перспективными.

Кроме того, есть способ определить страницы, которые могут иметь дополнительный SEO-трафик в следующие недели и месяцы. Это включает в себя некоторую игру с Google Search Console API и Google Data Studio, но результат несколько удивителен. Используя целевые страницы в качестве параметра и показы, клики по URL-адресам и CTR URL-адресов в качестве показателей, вы можете найти страницы, популярность которых растет быстрее, чем другие.

Когда вы узнаете, какие страницы требуют приоритета, вот что вы можете сделать, чтобы убедиться, что они сканируются чаще:

- Переместите наиболее важные страницы ближе к главной или даже разместите там ссылку на них. Например, вы можете добавить ссылку на страницу в разделы «Навигация» или «Специальные предложения».

- Установите 301 редиректы на все категории страниц, в которых нет товаров (нет в наличии/сезонные товары). Не забудьте отключить эту переадресацию, как только нужный товар появится в наличии.

5. Обеспечьте достаточное количество внутренних ссылок на страницу

Внутренние ссылки имеют решающее значение для сканирования как основного пути для робота Googlebot. Без внутренней ссылки на странице она просто не сможет двигаться вперед. Таким образом, добавляя ссылки, ведущие на страницу, вы увеличиваете ее шансы на раннее индексирование.

Например, если вы хотите, чтобы старая страница сканировалась чаще, добавьте ссылку, ведущую на нее, на свои новые страницы. Когда робот Googlebot посещает новую страницу, он также повторно индексирует старую.

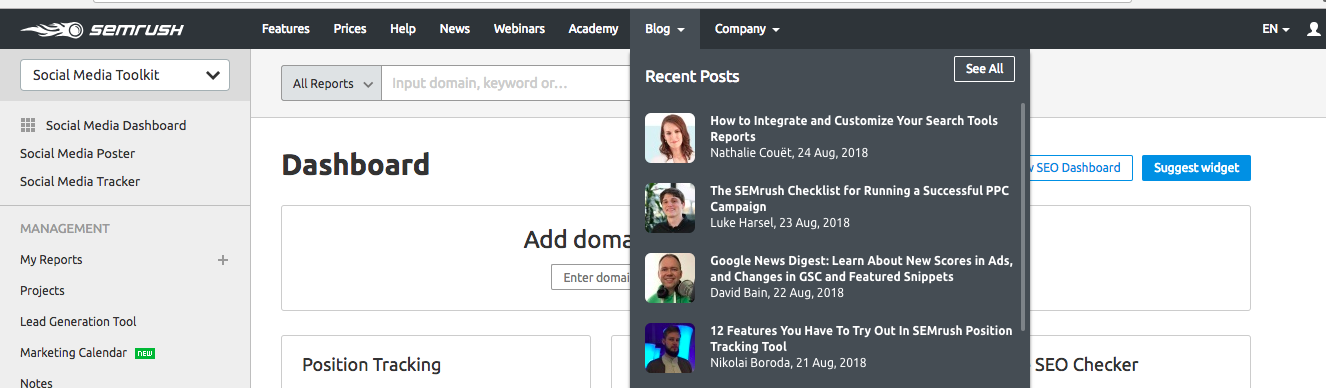

Добавляя ссылку на страницу в меню навигации веб-сайта, вы также делаете его легко доступным для пользователей и для робота Googlebot. SEMrush использует эту технику для ускорения сканирования новых сообщений в блогах. Все новые статьи появляются в разделе « Последние сообщения » на своей главной странице и, таким образом, получают приоритет от Googlebot.

Этот метод также можно использовать для ускорения индексации страниц новых продуктов на веб-сайтах электронной коммерции.

Подведение итогов

Как было сказано выше, оптимизация краулингового бюджета более важна для крупных сайтов с разветвленной структурой, таких как сайты электронной коммерции. Но поскольку правильное сканирование страниц является основой SEO и напрямую влияет на видимость в поисковой выдаче, вы можете пересмотреть статистику сканирования и сбалансировать бюджет сканирования, чтобы ускорить результаты ваших усилий по SEO.

Базовый набор инструментов для оптимизации краулингового бюджета включает:

- Google Search Console для просмотра текущей оценки краулингового бюджета.

- Аудиторы работоспособности сайта, такие как OnCrawl, для поиска дублирующегося контента, 404 страниц, потерянных страниц и т. д.

- Инструменты для проверки совместимости вашего сайта с мобильными устройствами, такие как Google Mobile-Friendly Test.

- Средство проверки скорости сайта, например PageSpeed Insights или GTmetrix.

- Инструменты для поиска страниц с высоким потенциалом популярности — уже имеющих большой трафик (вы можете увидеть их в Google Analytics) или страниц с растущей тенденцией видимости (можно найти с помощью AccuRanker).