Что такое Robots.txt: определение, важность и примеры

Опубликовано: 2022-07-14Возможно, вы слышали о том, что Google сканирует наш веб-сайт и страницы в Интернете, а затем отображает их на странице результатов поиска.

Что ж, robots.txt сообщает Google, какие сайты следуют их алгоритмам, а какие нет. В этом руководстве мы поделились всем, что вам нужно знать о robots.txt, примерах и принципах их работы.

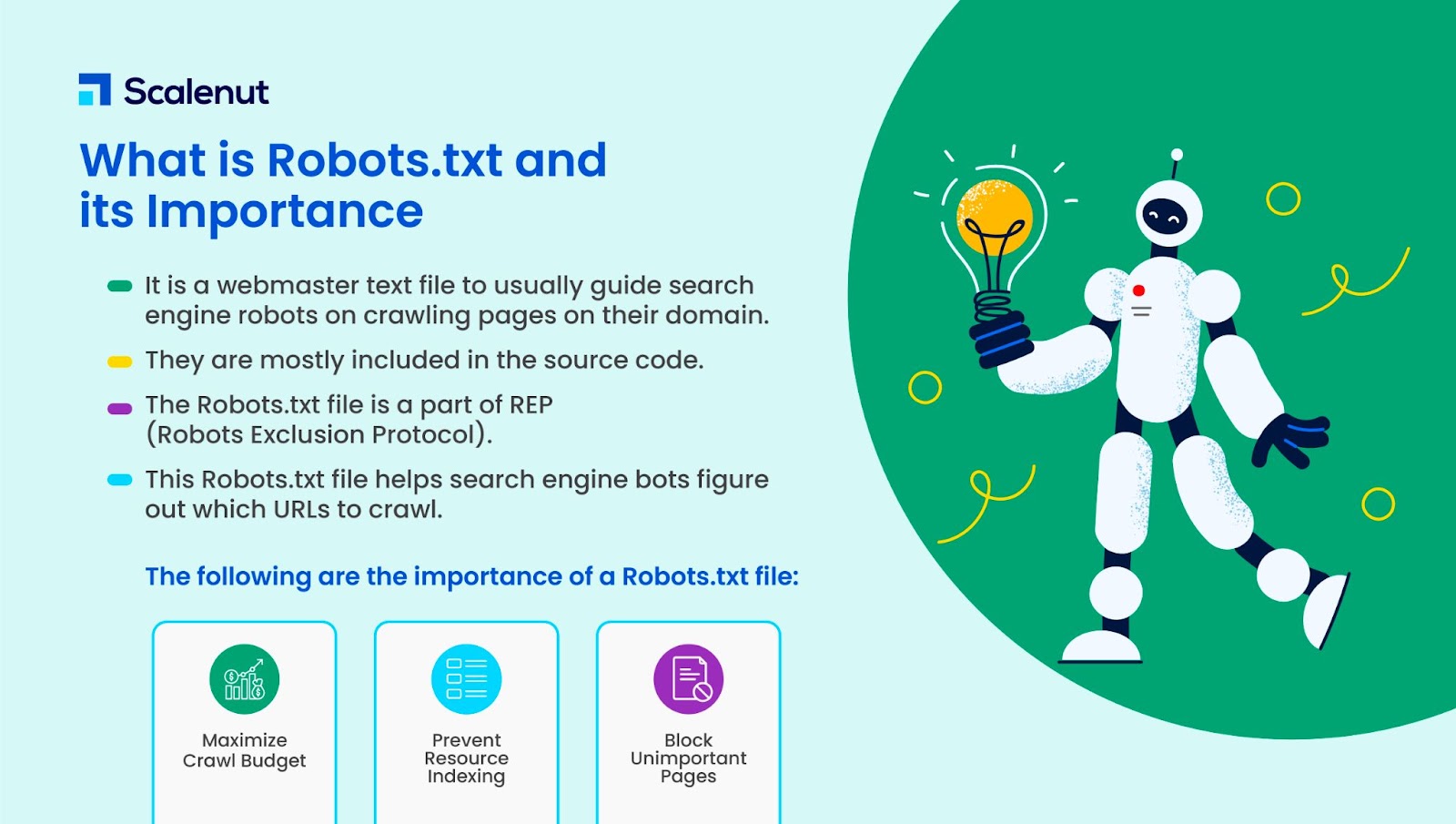

Что такое Robots.txt?

Robots.txt — это текстовый файл веб-мастера, который помогает веб-роботам (обычно роботам поисковых систем) сканировать страницы своего домена. Другими словами, файл robots.txt представляет собой набор инструкций для ботов.

Robots.txt включен в исходный код большинства веб-сайтов.

Файл robots.txt является частью протокола исключения роботов (REP). Он определяет, как роботы сканируют веб-страницы, находят и индексируют контент и предоставляют эту информацию людям, которые в ней нуждаются.

Robots.txt помогает роботам поисковых систем понять, какие URL-адреса на вашем сайте им следует сканировать.

Почему файл robots.txt важен?

В основном есть три причины, по которым файл .txt может вам помочь:

- Максимальный краулинговый бюджет: краулинговый бюджет — это количество страниц, которые роботы Google индексируют за определенный период времени. Robots.txt может помочь заблокировать неважные или повторяющиеся страницы с контентом и сосредоточиться только на важных для вас страницах, максимизируя ваш краулинговый бюджет и повышая видимость.

- Избегайте индексации ресурсов: Robots.txt может индексировать или деиндексировать ресурсы, такие как PDF-файлы или изображения. Таким образом, для блокировки страниц или ресурсов можно использовать неиндексированные или защищенные паролем страницы. Вы можете проверить проиндексированные страницы с помощью консоли поиска Google и посмотреть, сканируют ли боты страницы, которые вы хотите проиндексировать.

- Блокировать неважные страницы. На вашем веб- сайте есть страницы, которые вы не хотите показывать в результатах поиска Google. Это может быть страница входа или тестовая версия вашего сайта. Используя robots.txt, вы можете заблокировать эти страницы и сосредоточиться только на тех страницах, которые имеют значение.

Примеры robots.txt

Некоторые примеры файла robots.txt:

Агент пользователя: Googlebot

Запретить: /nogooglebot/

Пользовательский агент: *

Разрешать: /

Карта сайта: http://www.example.com/sitemap.xml

Точно так же для поисковой системы Bing это выглядит так:

Агент пользователя: Bingbot

Запретить: /example-subfolder/blocked-page.html

Синтаксис помогает сканеру избежать сканирования определенной страницы.

Стоит отметить, что для каждого поддомена нужен свой файл robots.txt.

Например, хотя www.cloudflare.com имеет свой собственный файл, все поддомены Cloudflare (blog.cloudflare.com, community.cloudflare.com и т. д.) также требуют своего собственного файла.

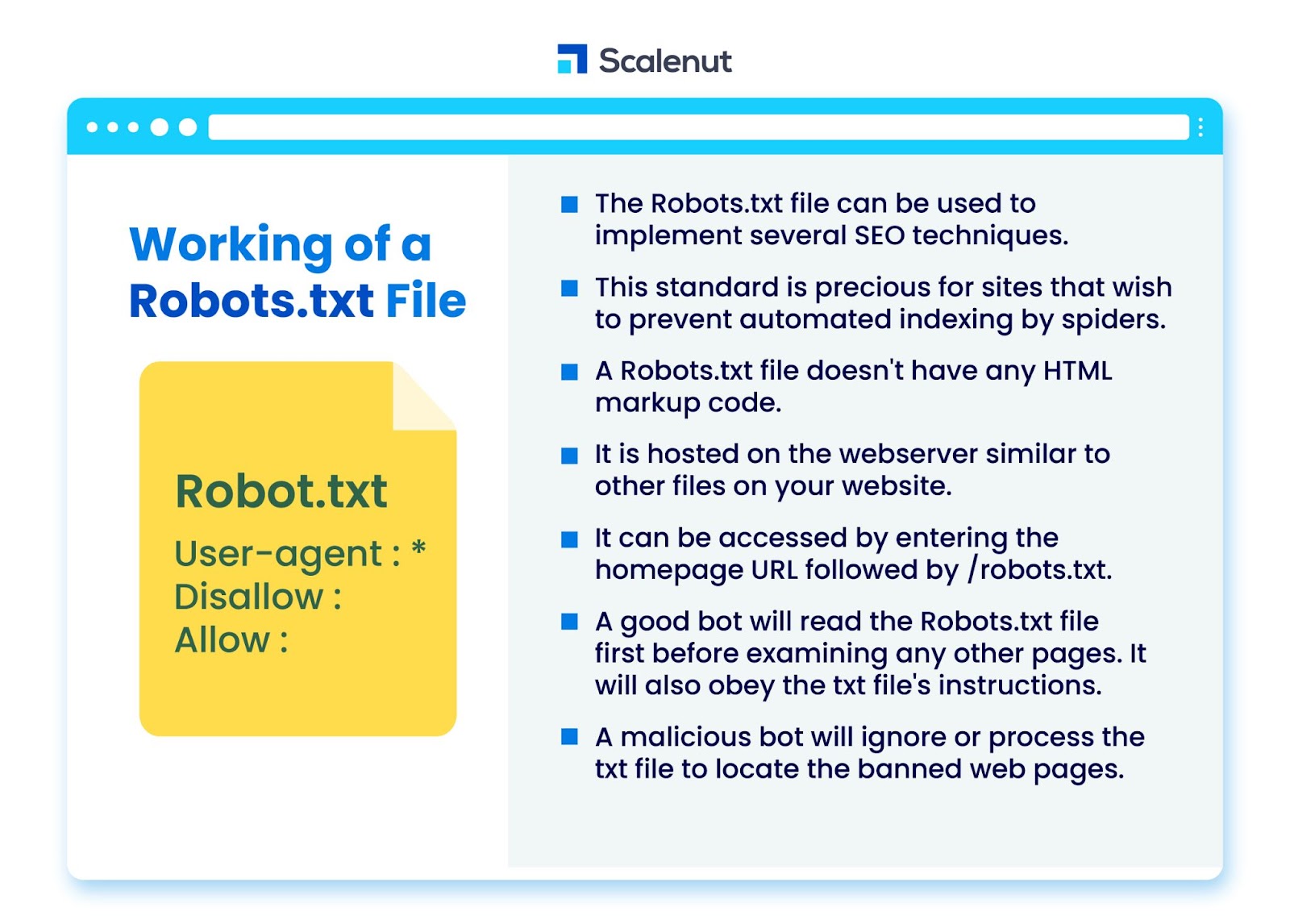

Как работает файл robots.txt?

Файл robots.txt можно использовать для реализации нескольких методов поисковой оптимизации (SEO), таких как неиндексированные страницы или robots txt, запрещающие бот-программам все или определенные части сайта.

Стандарт особенно ценен для сайтов, которые не хотят, чтобы пауки индексировали их контент с помощью автоматизированных процессов, таких как программное обеспечение для поиска и ранжирования страниц с использованием автоматических поисковых роботов.

robots.txt — это файл без кода разметки HTML. Он размещается на веб-сервере, как и другие файлы на вашем сайте.

Доступ к нему можно получить, введя URL-адрес домашней страницы, а затем /robots.txt. Общий пример — https://www.xyz.com/robots.txt.

Поскольку на этот файл больше нигде на сайте нет ссылок, посетители вряд ли наткнутся на него, но большинство роботов поисковых роботов будут искать его, прежде чем проиндексировать остальную часть сайта.

Хороший бот, такой как поисковый робот Google или бот новостной ленты, сначала прочитает файл robots.txt, прежде чем проверять любые другие страницы на сайте, и будет следовать инструкциям.

Вредоносный бот либо проигнорирует, либо обработает файл robots.txt, чтобы найти запрещенные веб-страницы.

Блокировка robots.txt

Robots.txt содержит инструкции для информирования роботов о любых правилах блокировки на доступном для поиска веб-сайте, проиндексированном Googlebot, которые предназначены для предотвращения доступа сканера к страницам с определенным содержанием.

Это не влияет на обычных пользователей или ботов, которые просто просматривают сайты, не сканируя их.

Со временем веб-сайты блокировали мобильные приложения, JavaScript и другие части своего сайта, используя этот метод, но по-прежнему разрешали некоторые элементы, такие как изображения.

Какие протоколы используются в файле robots.txt?

Протокол — это формат для передачи инструкций или приказов в сети. Файлы robots.txt используют различные протоколы. Основной протокол известен как протокол исключения роботов.

Он инструктирует ботов, какие сайты и ресурсы следует избегать.

Протокол Sitemaps — это еще один протокол, который используется для файлов robots.txt. Это можно рассматривать как протокол включения робота.

Файлы Sitemap информируют поисковые роботы о том, к каким страницам они могут получить доступ. Это помогает гарантировать, что бот-сканер не пропустит ни одной важной страницы.

Что такое карта сайта?

Карта сайта — это XML-файл, описывающий информацию, используемую поисковыми роботами для отображения страниц вашего сайта. На карте сайта перечислены все URL-адреса вашего веб-сайта, включая их заголовки и описания, а также другую связанную информацию.

Этот документ помогает поисковым системам правильно индексировать эти элементы, чтобы посетители могли быстро найти их с помощью поисковых систем или других навигационных систем.

Что такое User-Agent?

User-agent user-agent: *disallow: /nogooglebot/ user-agent user-agent: Googlebot

Запретить все правила robots.txt, независимо от пользовательского агента. Это предотвратит доступ любого поискового робота к вашему сайту. Это чаще всего используется веб-сайтами, чувствительными к проблемам конфиденциальности (и, следовательно, не желающими раскрывать данные своих пользователей).

Общие имена пользовательских агентов ботов поисковых систем включают:

Гугл :

- Googlebot

- Googlebot-Image (для изображений)

- Googlebot-Новости (для новостей)

- Googlebot-Video (для видео)

Бинг:

- Бингбот

- MSNBot-Media (для изображений и видео)

Байду:

- Байдуспайдер

Что такое файл .txt?

TXT — это расширение текстового файла, поддерживаемое многими текстовыми редакторами.

Не существует такого статического определения текстового файла, хотя есть несколько популярных форматов, включая ASCII (кроссплатформенный формат) и ANSI (используемый на платформах DOS и Windows). TXT — это сокращение от TeXT. Text/plain — это тип MIME.

В текстовом файле robots.txt каждое правило определяет шаблон URL-адресов, к которым могут получить доступ все поисковые роботы или только определенные поисковые роботы.

Каждая строка должна начинаться с одного двоеточия (:) и содержать 1–3 строки, игнорируя пустые строки. Каждая строка интерпретируется как имя файла, которое может быть абсолютным или относительным относительно каталога, в котором он находится.

Являются ли веб-роботы такими же, как robots.txt?

Некоторые поисковые системы могут не поддерживать директивы txt.

Инструкции в файлах robots.txt не могут заставить поисковых роботов посетить ваш сайт; краулер должен следовать за ними. Напротив, Googlebot и другие известные поисковые роботы следуют правилам файла robots.txt.

Как внедрить robots.txt?

Файл robots.txt можно реализовать практически в любом текстовом редакторе. Notepad, TextEdit, vi и emacs, например, могут генерировать законные файлы robots.txt.

Ниже приведены правила, которым следует следовать robots.txt:

- Имя файла должно быть robots.txt.

- Файл robots.txt можно использовать для ограничения доступа к субдоменам (например, https://website.example.com/robots.txt) или нестандартным портам.

- Файл robots.txt должен быть в формате UTF-8 (включая ASCII). Google может отклонять символы, не входящие в диапазон UTF-8, что может привести к аннулированию правил robots.txt.

- Файл robots.txt обычно находится в корневом каталоге узла веб-сайта, к которому он применяется. Чтобы включить сканирование по всем URL-адресам, таким как https://www.example.com/, файл robots.txt должен находиться по адресу https://www.example.com/robots.txt. Его нельзя поместить в подкаталог (например, https://example.com/pages/robots.txt).

Ограничения файла robots.txt

Вот ограничения файла robots.txt:

- Все поисковые системы не поддерживают Robots.txt: файлы robots.txt не могут заставить сканеры посетить ваш сайт; краулер должен следовать за ними. В то время как Googlebot и другие заслуживающие доверия поисковые роботы будут следовать инструкциям в файле robots.txt, другие поисковые роботы могут этого не делать.

- Разные поисковые роботы интерпретируют синтаксис по-разному: хотя авторитетные веб-пауки придерживаются директив в файле robots.txt, каждый поисковый робот может интерпретировать директивы по-разному.

- Запрещенная страница может быть проиндексирована, если она связана с другими страницами: хотя Google не будет сканировать или индексировать контент, ограниченный файлом robots.txt, он может найти и проиндексировать запрещенный URL-адрес, если на него есть ссылки из других мест в Интернете.

В результате URL-адрес и, возможно, другая общедоступная информация, такая как текст привязки в ссылках на страницу, могут по-прежнему отображаться в результатах поиска Google.

Часто задаваемые вопросы

Q1. Куда идет файл robots.txt на сайте?

Ответ: Файл robots.txt обычно размещается в корневом каталоге вашего веб-сайта, но он может находиться в любом месте вашего сайта, доступ к которому вы хотите ограничить.

Q2. Нужен ли файл robots.txt?

Ответ: Короткий ответ — нет. Файл robots.txt не нужен для веб-сайта. Если бот посещает ваш сайт и у него нет файла robots.txt, он будет сканировать и индексировать страницы, как обычно. Файл .txt требуется только в том случае, если вы хотите больше контролировать то, что сканируется.

Q3. Безопасен ли файл robots.txt?

Ответ: Файл robots.txt сам по себе не представляет угрозы безопасности, и его правильное использование может представлять собой хорошую практику по причинам, не связанным с безопасностью. Не следует ожидать, что все веб-роботы будут следовать инструкциям в файле.

Q4. Является ли доступ к robots.txt незаконным?

Ответ: Файл robots.txt — это лицензия, которую подразумевает владелец веб-сайта. Если вы знаете о файле robots.txt, то продолжение очистки их сайта без разрешения может быть расценено как несанкционированный доступ или взлом.

Q5. Что такое задержка сканирования в robots txt?

Ответ: Директива Crawl-delay — это способ заставить сканеры снизить скорость, чтобы веб-сервер не был перегружен.

Вывод

Robots.txt — это простой файл, обладающий большими возможностями. Если вы знаете, как правильно его использовать, это может помочь SEO. Создание правильного типа robots.txt означает, что вы также улучшаете SEO и пользовательский опыт.

Боты смогут представить ваш контент в поисковой выдаче так, как вы хотите, если вы позволите им сканировать правильные вещи.

Если вы хотите узнать больше о SEO и важных факторах, ознакомьтесь со многими другими блогами Scalenut.