Дайджест вебинара: живой SEO-аудит и файлы журналов с Биллом Харцером

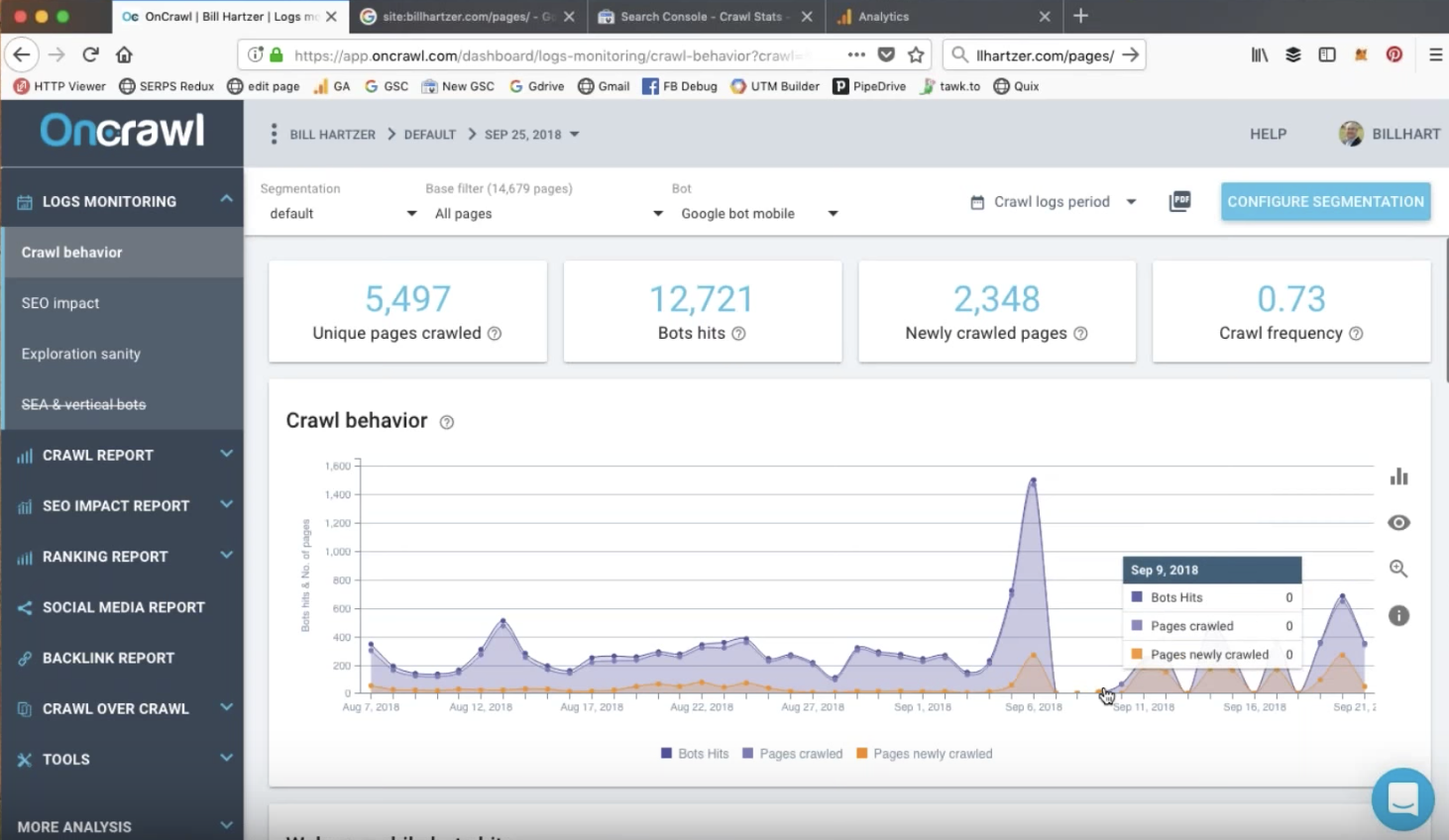

Опубликовано: 2018-10-0225 сентября OnCrawl пригласил Билла Харцера на вебинар, посвященный анализу лог-файлов и тому, почему это важно для SEO-аудита. Он просмотрел свой собственный веб-сайт, чтобы показать влияние оптимизации на активность ботов и частоту сканирования.

Представляем Билла Харцера

Билл Харцер — SEO-консультант и эксперт по доменным именам с более чем 20-летним опытом. Билл известен во всем мире как эксперт в своей области и недавно дал интервью CBS News как один из ведущих экспертов страны по поиску.

В ходе этого часового веб-семинара Билл показывает нам свои файлы журналов и обсуждает, как он их использует в контексте аудита сайта. Он представляет различные инструменты, которые он использует для проверки производительности сайта и поведения ботов на своем сайте.

Наконец, Билл отвечает на вопросы о том, как использовать OnCrawl для визуализации значимых результатов, и дает советы другим специалистам по поисковой оптимизации.

Как получить доступ к файлам журнала через плагин cPanel для WordPress

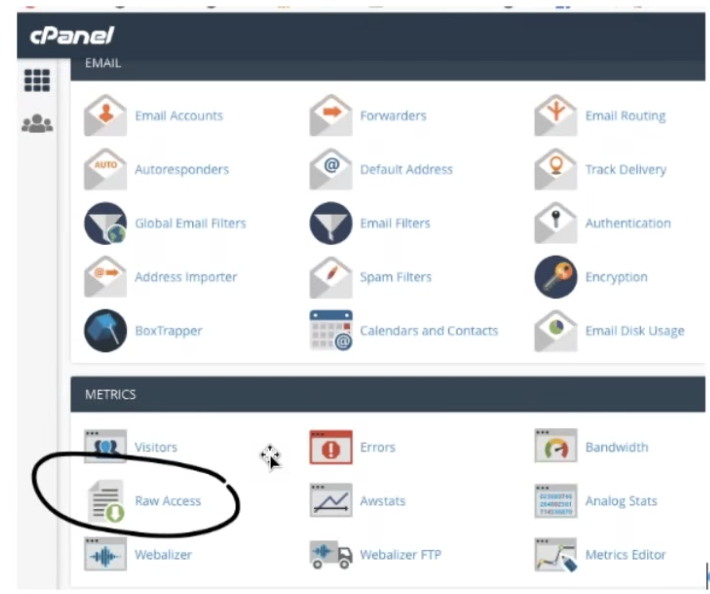

Если ваш веб-сайт построен на WordPress и вы используете плагин cPanel, вы можете найти журналы своего сервера прямо в интерфейсе WordPress.

Перейдите в «Метрики», затем в «Необработанный доступ». Там вы можете скачать файлы ежедневных журналов из файлового менеджера, а также заархивированные архивы старых файлов журналов.

Изучите содержимое файла журнала

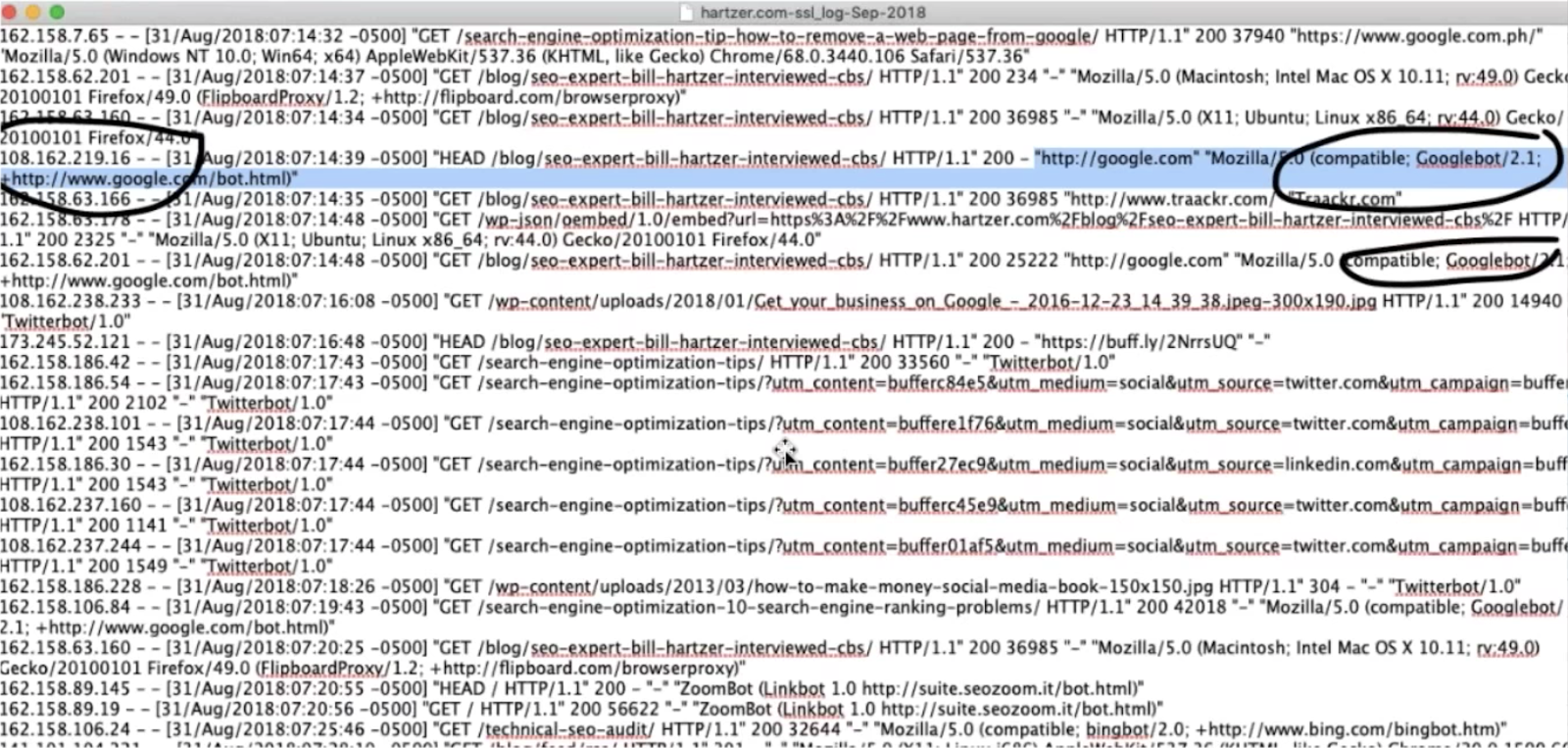

Лог-файл — это большой текстовый файл, который содержит информацию обо всех посетителях вашего сайта, включая ботов. Вы можете открыть его с помощью обычного текстового редактора.

Нетрудно определить потенциальных обращений ботов от googlebot или bing, которые идентифицируют себя в файлах журнала, хотя рекомендуется подтвердить идентификацию бота с помощью поиска IP.

Вы также можете найти других ботов, которые сканируют ваш сайт, но могут быть вам бесполезны. Вы можете заблокировать этим ботам доступ к вашему сайту.

OnCrawl будет обрабатывать необработанную аналитику в ваших файлах журналов, чтобы дать вам четкое представление о ботах, которые посещают ваш сайт.

Использование файлов журнала для получения дополнительной информации о статистике сканирования

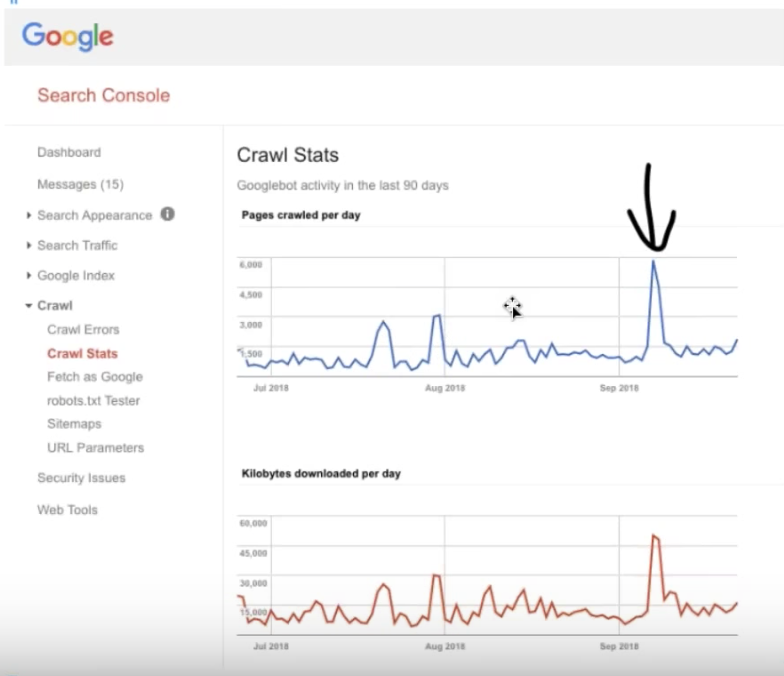

Информация о статистике сканирования доступна в старой версии Google Search Console в разделе «Сканирование» > «Статистика сканирования» приобретает новый смысл по сравнению с информацией в ваших файлах журналов.

Вы должны знать, что данные, отображаемые в Google Search Console, не ограничиваются SEO-ботами Google и поэтому могут быть менее полезными, чем более точная информация, которую вы можете получить, проанализировав свои файлы журналов.

Недавние случаи необычной активности сканирования

Билл смотрит на три недавних всплеска, видимых в статистике сканирования в Google Search Console. Они соответствуют крупным событиям, которые вызывают повышенную активность сканирования.

Всплеск индексации Mobile First

Поначалу может показаться, что всплеск 7 сентября в Google Search Console не связан с событиями на сайте. Однако анализ журнала в OnCrawl дал подсказки:

Анализ файлов журналов позволяет нам увидеть разбивку различных ботов, которые Google использует для сканирования страниц. Становится ясно, что активность настольного робота Googlebot резко снизилась до этой даты и что этот всплеск — в отличие от более ранних, меньших всплесков — почти полностью состоял из посещений уникальных, уже проиндексированных страниц мобильным ботом Google.

50-процентное увеличение органического трафика, зарегистрированное Google Analytics, подтвердило, что этот всплеск соответствует индексации сайта Mobile First в начале сентября, за несколько недель до оповещения, отправленного Google!

Изменение структуры URL для сайта

В середине августа Билл внес изменения в структуру своего URL, чтобы сделать его более удобным для SEO.

Консоль поиска Google зафиксировала два больших всплеска сразу после этой модификации, подтверждая, что Google идентифицирует основные события сайта и использует их в качестве сигналов для повторного сканирования URL-адресов веб-сайта.

Когда мы наблюдаем разбивку этих обращений в OnCrawl, становится очевидным, что второй всплеск не является всплеском, но высокая скорость сканирования страниц на этом веб-сайте сохраняется в течение нескольких дней. Ясно, что Google уловил изменения, что Билл может подтвердить, наблюдая за различиями в активности сканирования в течение нескольких дней после его изменений.

Полезные отчеты и функции OnCrawl для проведения технического аудита

SEO-посещения и SEO-активные страницы

OnCrawl обрабатывает данные вашего файла журнала, чтобы предоставить точную информацию о посещениях SEO или посетителях-людях, прибывающих из списков поисковой системы Google.

Вы можете отслеживать количество посещений или просматривать SEO-активные страницы, которые представляют собой отдельные страницы на веб-сайте, получающие органический трафик.

Одна вещь, на которую вы, возможно, захотите обратить внимание в рамках аудита, это причина, по которой некоторые рейтинговые страницы не получают органического трафика (или, другими словами, не являются SEO-активными страницами).

Свежий ранг

Такие показатели, как Fresh Rank OnCrawl, предоставляют важную информацию. В данном случае: средняя задержка в днях между первым сканированием страницы Google и первым посещением страницы с помощью SEO.

#FreshRank помогает узнать, сколько дней нужно сканировать страницу в первый раз и получить первое посещение #SEO #oncrawlwebinar pic.twitter.com/WVojWXKStC

— OnCrawl (@OnCrawl) 25 сентября 2018 г.

Стратегии продвижения контента и разработка обратных ссылок могут помочь быстрее получить трафик для новой страницы. Некоторые страницы на сайте в этом аудите, такие как посты в блогах, которые продвигались в социальных сетях, получили гораздо более низкий рейтинг свежести.

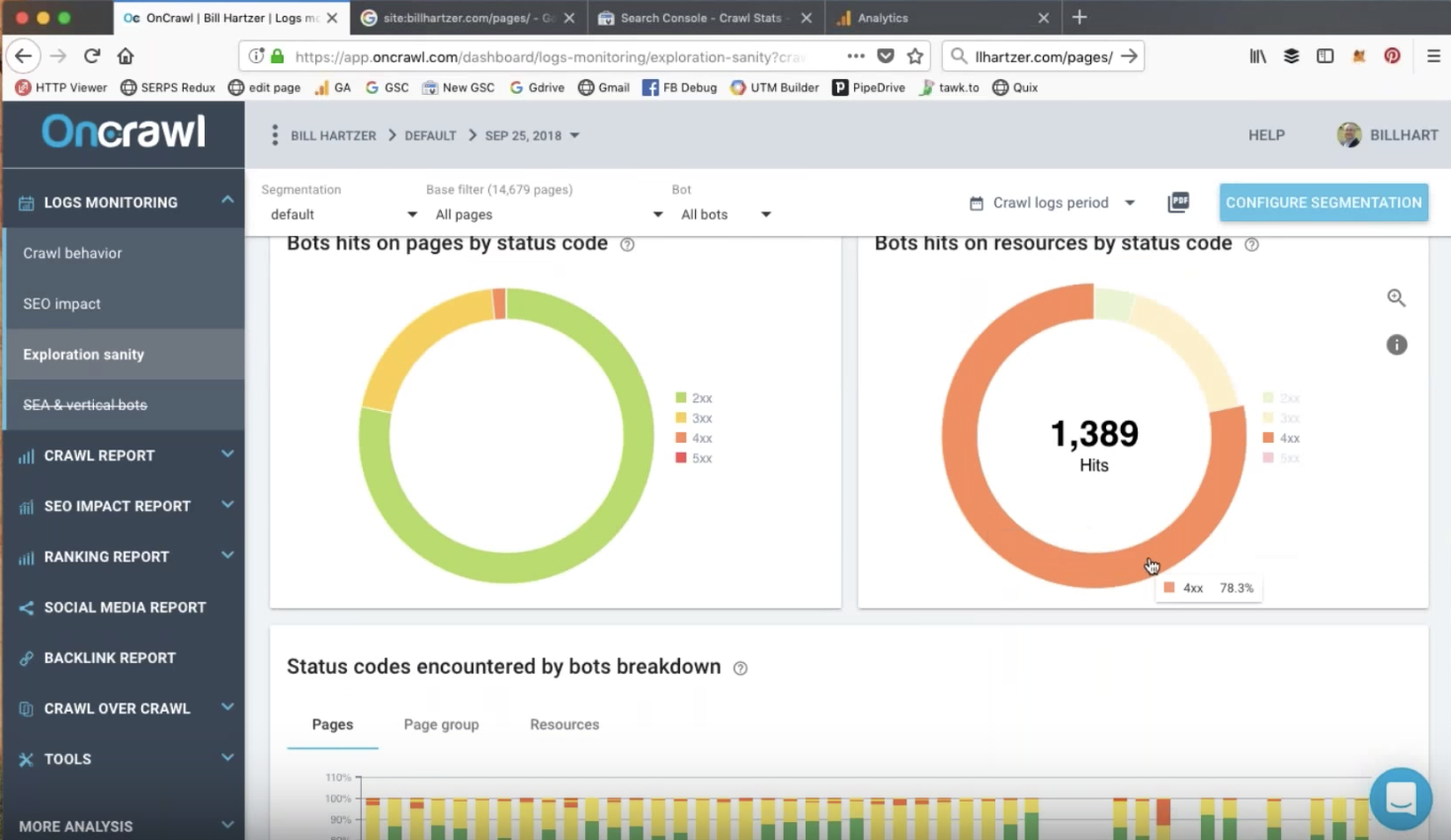

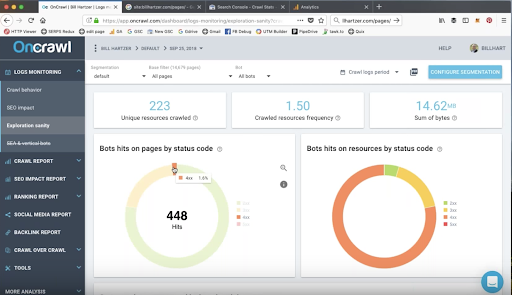

Бот заходит на страницы и ресурсы по коду статуса

Боты могут посещать URL-адреса, которые возвращают ошибки 404 или 410. Это может касаться таких ресурсов, как CSS, JavaScript, PDF-файлы или файлы изображений.

Это элементы, которые вы определенно хотите исследовать во время аудита. Перенаправление этих URL-адресов и удаление внутренних ссылок на них может обеспечить быструю победу.

Во время аудита может быть полезно вести заметки об элементах, которые необходимо устранить, например URL-адресах, которые возвращают ботам ошибки статуса.

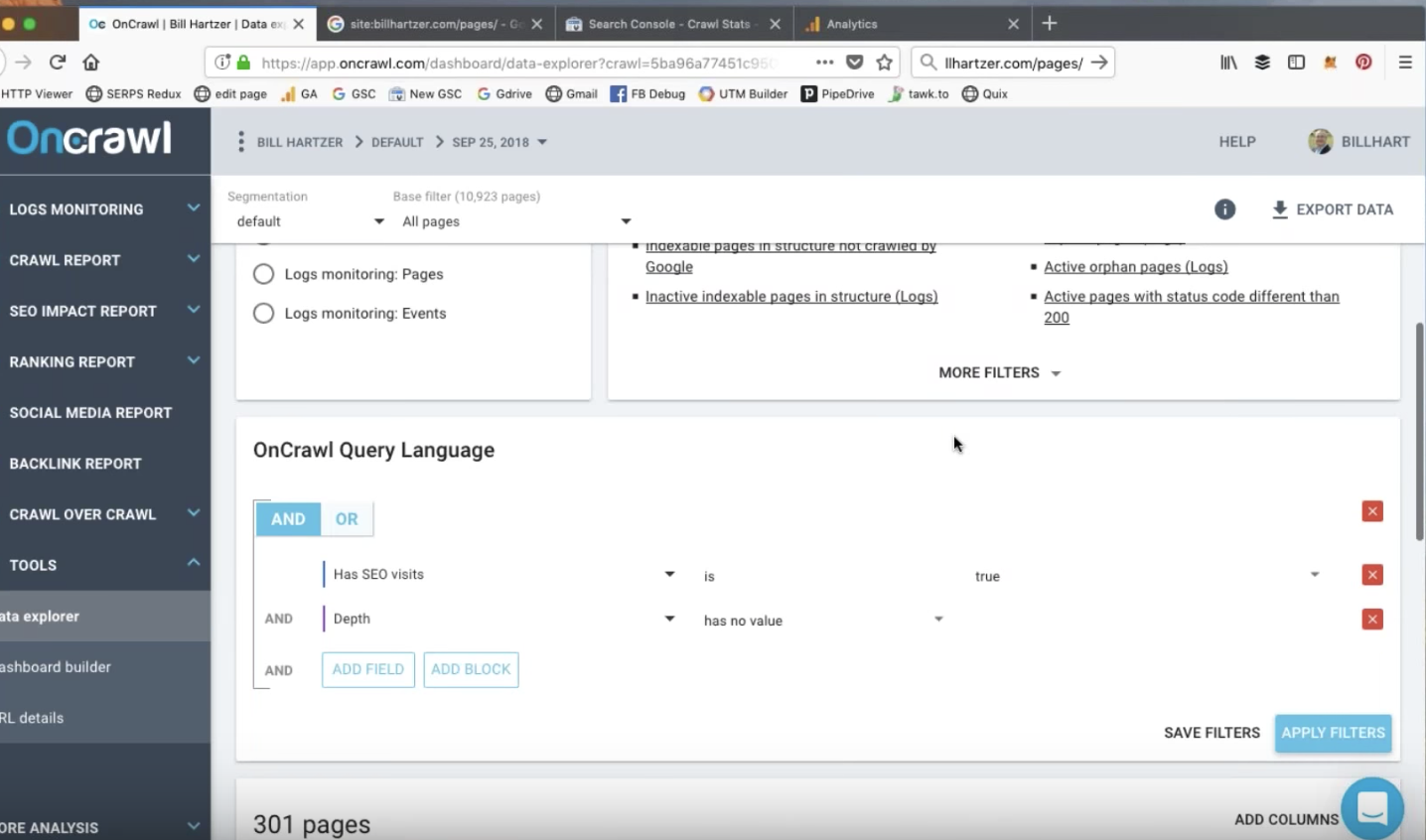

Отчеты обозревателя данных: настраиваемые отчеты

Обозреватель данных OnCrawl предлагает быстрые фильтры для создания отчетов, которые могут вас заинтересовать, но вы также можете получать свои собственные отчеты на основе интересующих вас критериев. Например, вы можете захотеть провести опрос SEO-активных страниц с отказами и высоким временем загрузки.

Отчеты обозревателя данных: активные потерянные страницы

Сочетая аналитику, сканирование и данные файла журнала, OnCrawl может помочь вам обнаружить страницы с обычными посещениями людьми, которые не всегда приносят пользу вашему сайту. Преимущество использования данных из файлов журнала заключается в том, что вы можете обнаружить каждую посещенную страницу вашего сайта, включая страницы, на которых может не быть кода Google Analytics.

Билл смог определить органические посещения SEO на страницах RSS-каналов, вероятно, по ссылкам из внешних источников. Эти страницы являются сиротами на его сайте; у них нет «родительской» страницы, которая ссылается на них. Эти страницы не приносят никакой дополнительной ценности его SEO-стратегии, но все же получают несколько посещений за счет органического трафика.

Эти страницы — отличные кандидаты для начала оптимизации.

Поисковая аналитика для рейтинга ключевых слов

Данные для ранжирования можно получить из Google Search Console. Непосредственно в старой версии Google Search Console можно перейти в раздел «Поисковый трафик», затем «Поисковая аналитика» и просмотреть «Клики», «Показы», «CTR» и «Позиции» за последние 90 дней.

OnCrawl предоставляет четкие отчеты о том, как эта информация относится ко всему сайту, позволяя сравнивать общее количество страниц на сайте, количество страниц рейтинга и количество страниц, на которые нажимают.

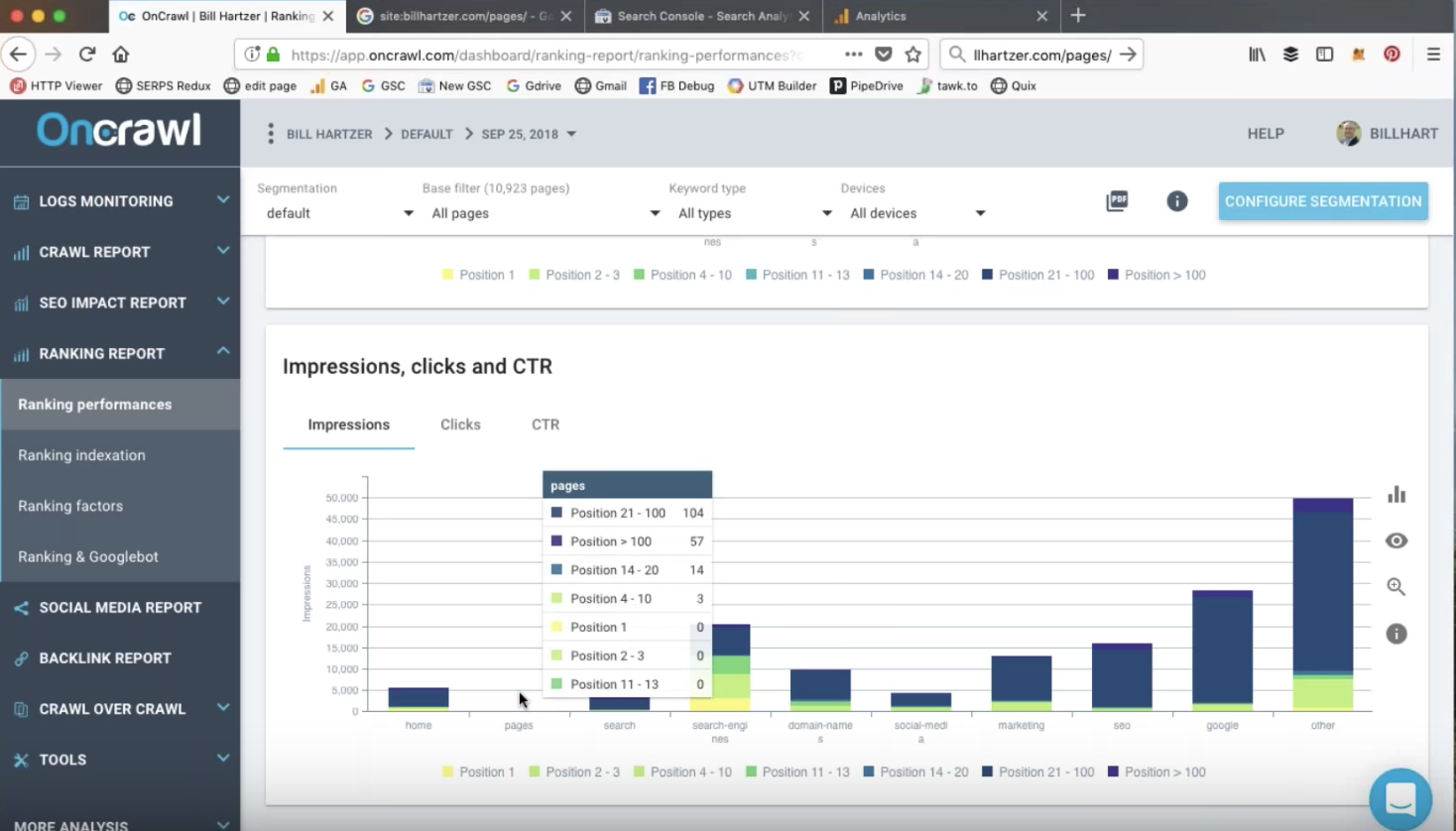

Показы, CTR и клики

Сегментация сайта позволяет вам с одного взгляда определить, какие типы или группы страниц на вашем сайте ранжируются и на какой странице результатов.

В этом аудите Билл может использовать метрику OnCrawl, чтобы определить типы страниц, которые обычно занимают высокие позиции. Он знает, что это те типы страниц, которые он должен продолжать создавать, чтобы увеличить посещаемость веб-сайта.

Клики на страницах рейтинга тесно связаны с позицией в рейтинге: позиции более 10 больше не находятся на первой странице результатов поиска, после чего количество кликов резко упадет для большинства ключевых слов.

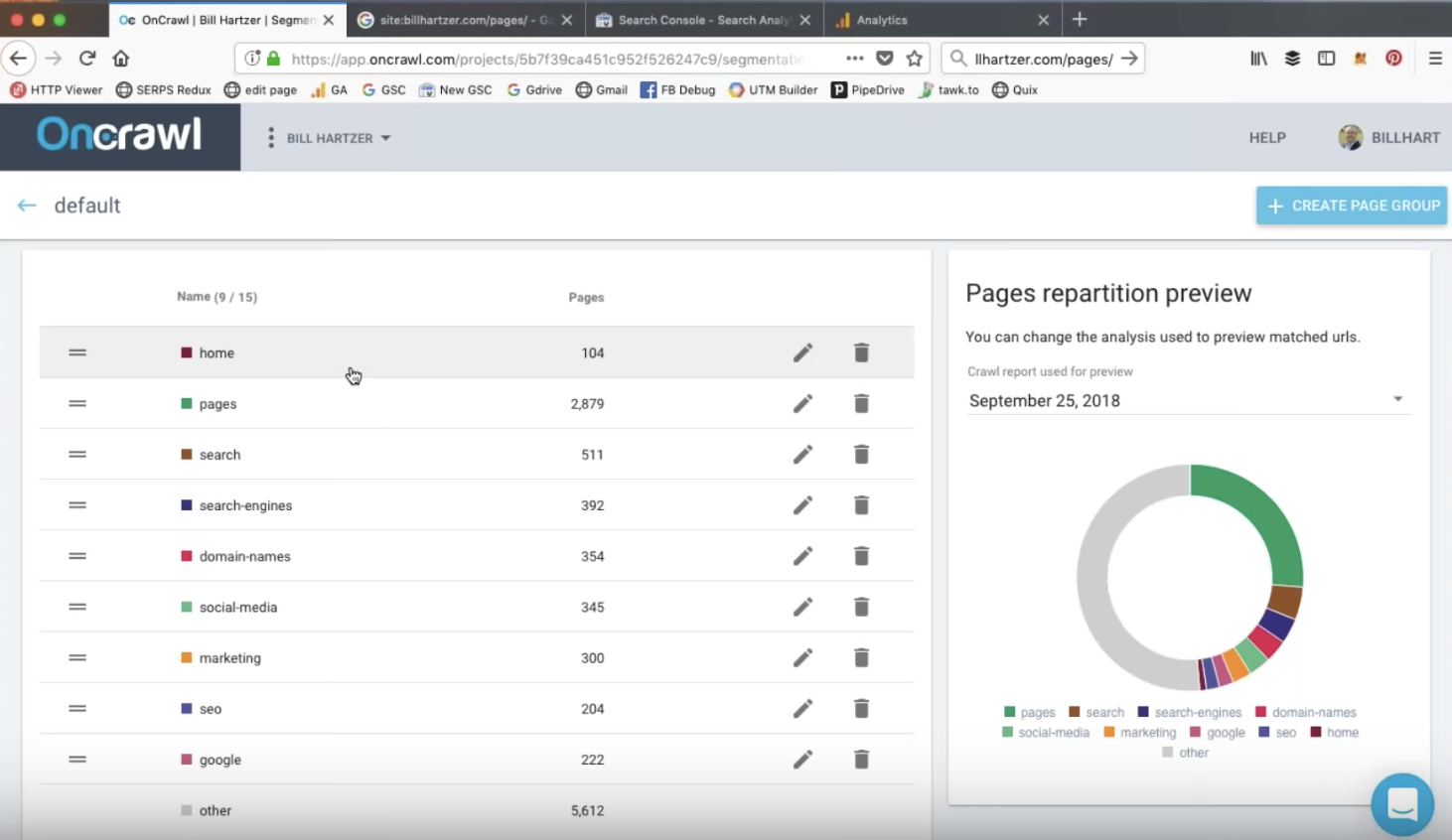

Сегментация сайта

Сегментация OnCrawl — это способ сгруппировать ваши страницы в значимые наборы. Хотя предоставляется автоматическая сегментация, вы можете редактировать фильтры или создавать свои собственные сегментации с нуля. Используя фильтры языка запросов OnCrawl, вы можете включать или исключать страницы из группы на основе множества различных критериев.

На сайте, который Билл просматривает на вебинаре, сегментация основана на различных каталогах на веб-сайте.

Страницы в структуре > просканированы > ранжированы > активны

В отчете о рейтинге OnCrawl диаграмма «Страницы в структуре > просканированные > ранжированные > активные» может предупредить вас о проблемах с ранжированием и посещаемостью ваших страниц.

Эта диаграмма показывает вам:

- Страницы в структуре: количество страниц, на которые можно попасть по разным ссылкам на вашем сайте.

- Просканировано: страницы, просканированные Google.

- Ранжированные: страницы, которые появились в поисковой выдаче Google.

- Активные: страницы, которые получили органические посещения.

Ваш аудит захочет рассмотреть причины различий между столбцами на этом графике.

Однако различия между количеством страниц в структуре и количеством просканированных страниц могут быть преднамеренными, например, если вы запрещаете Google сканировать определенные страницы, запрещая роботам в файле robots.txt. Это то, что вы хотите проверить во время аудита.

Вы можете просмотреть такие данные в OnCrawl, нажав на график.

Основные выводы

Анализ файлов журналов помогает выявлять всплески обращений ботов и ежедневно отслеживать активность ботов #oncrawlwebinar

Сегодняшний вебинар с @bhartzer pic.twitter.com/3DAC5d36j9— OnCrawl (@OnCrawl) 25 сентября 2018 г.

Ключевые выводы этого вебинара включают в себя:

- Большие изменения в структуре веб-сайта могут привести к большим изменениям в активности сканирования.

- Бесплатные инструменты Google сообщают об агрегированных, усредненных или округленных данных таким образом, что они могут показаться неточными.

- Лог-файлы позволяют увидеть реальное поведение ботов и органические посещения. В сочетании с данными сканирования и ежедневным мониторингом они представляют собой мощный инструмент для обнаружения всплесков.

- Точные данные необходимы для понимания того, почему и что произошло, а этого можно достичь только путем перекрестного анализа аналитики, сканирования, ранжирования и, в частности, данных файла журнала в таком инструменте, как OnCrawl.

Попробуйте OnCrawl бесплатно

Заинтересованы ли вы в применении этих методов на своем сайте для получения практических результатов аудита?

Пропустили в прямом эфире? Смотрите повтор!

Даже если вы не смогли принять участие в живом веб-семинаре или не смогли остаться на полный сеанс, вы все равно можете просмотреть его полную версию.