7 ключевых шагов к обучению и совершенствованию на основе результатов A/B-тестирования

Опубликовано: 2021-04-13

Ваш A/B-тест только что завершился, но вы не видите ожидаемых результатов.

Все остальные делятся кейсами, в которых они увидели огромный рост всего лишь за изменение цвета кнопки или небольшую настройку, но ваш тест не дал никакого улучшения конверсии или, что еще хуже, вместо этого, похоже, вы потеряли деньги, и теперь вам нужно представить это вашему боссу.

Ну, а что, если твой тест на самом деле не проигрышный?

Что, если это замаскированный победитель?

А если это проигрыш, что, если проигрышный тест на самом деле является хорошей вещью?

В этом руководстве мы собираемся помочь вам получить более глубокое представление о результатах вашего A/B-тестирования, чтобы вы могли проанализировать и разбить их, чтобы найти золото.

Мы расскажем, почему изучение ваших A/B-тестов так важно, и почему проигравшие могут принести вам продажи. Мы делимся процессом, которому вы можете следовать, чтобы вы могли полностью анализировать свои тесты шаг за шагом и чувствовать себя уверенно в том, что вы видите, выигрываете или терпите неудачу.

Более того, мы поможем вам перейти от беспокойства по поводу данных и нежелания проверять свою аналитику к уверенности в том, что вы будете делиться своими результатами с коллегами.

Итак, давайте погрузимся…

Зачем вам нужно учиться на A/B-тестах?

Во-первых, это очевидная стоимость. Каждый тест стоит денег для настройки. Если у вас есть убыточные варианты, вы также увидите падение продаж для этого варианта.

Однако вот в чем дело:

A/B-тестирование (и CRO в целом) — это не только способ заработать больше денег. Речь идет о покупке данных . Данные о вашей аудитории могут помочь вам лучше понять их и предоставить лучший продукт и услугу. Затем это приводит к увеличению продаж и улучшению качества обслуживания клиентов, а также к пониманию новых предложений продуктов.

Чем больше вы узнаете о людях, которым служите, тем лучше у вас получается. Вот почему так важно тестировать и тестировать часто, даже если большинство тестов терпит неудачу.

Мы не одиноки в этом мышлении либо.

На самом деле, когда мы изучили наши внутренние данные о 28 304 тестах с помощью нашего инструмента, а также беседы с экспертными агентствами по тестированию, мы обнаружили, что большинство компаний находят только 1 победителя из каждых 10 тестов, в то время как агентства обычно видят 1 победителя из каждых. 4.

И я знаю, о чем ты думаешь,

Конечно, это означает, что я теряю деньги в 90% случаев с каждым тестом?

Да, но только для половины вашей тестовой аудитории. Другая половина по-прежнему видит ваш сайт и конвертируется, как обычно.

Кроме того, данные, которые вы получаете, помогают вам выяснить, что не работает, чтобы вы могли узнать, что работает. Вы тестируете, учитесь, снова тестируете и продолжаете, пока не найдете то, что работает.

А те 10% тестов, которые действительно выигрывают?

Они могут обеспечить постоянный постепенный рост, который можно улучшать снова и снова, прежде чем масштабировать его на вашем сайте на каждой похожей странице для большего воздействия.

В этом и прелесть роста конверсии на цифровой платформе. Увеличение трафика всего на 1% может оказать огромное влияние на ваш бизнес как сейчас, так и в отношении всего трафика в будущем. Фактически, Джефф Безос думает в том же духе, называя Amazon и их цель тестирования и улучшения «лучшим местом в мире, где можно потерпеть неудачу» в своем ежегодном отчете для акционеров:

Учитывая 10-процентный шанс на 100-кратный выигрыш, вы должны принимать эту ставку каждый раз. Но вы все равно будете ошибаться девять раз из десяти .

Джефф Безос, Amazon

Тем не менее, увеличение продаж и более точная информация — не единственные преимущества A/B-тестирования.

Выполнение тестов позволяет вам отойти от блокирующих тем и теории групп. Вместо того, чтобы тратить месяцы на обсуждение возможных изменений в веб-дизайне и ничего не делать, примите меры и протестируйте его, освободив свою команду, чтобы сосредоточиться на других вещах. (Только не забудьте проверить его эффект, прежде чем запускать его!)

Кроме того, вы можете узнать что-то новое о своей аудитории, о чем вам может рассказать ТОЛЬКО A/B-тестирование.

Разработка теории и опросы клиентов — это здорово, но важнее всего то, что ваша аудитория на самом деле делает на вашем сайте, а не только то, что они говорят. Понимание ваших тестов поможет вам подтвердить или опровергнуть эти идеи и отзывы.

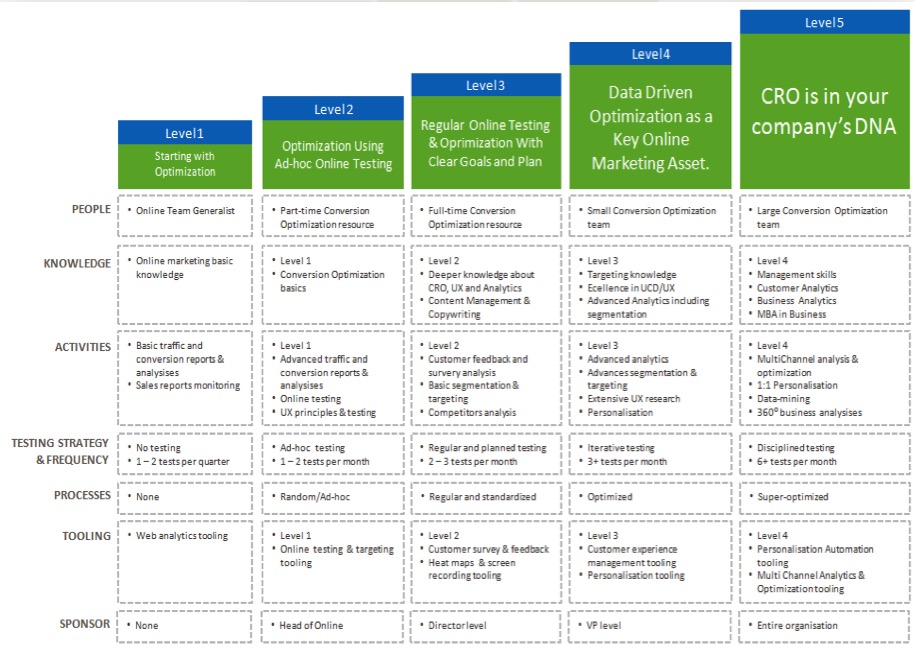

Чем лучше вы понимаете свои результаты, тем увереннее вы становитесь в своем тестировании, что позволяет вам «созревать» ваши усилия по CRO и чаще запускать тесты и, возможно, даже начать создавать команду тестирования внутри компании.

Теперь, когда вы видите преимущества обучения на каждом тесте A/B, давайте проведем вас через простой процесс анализа каждого нового теста, который вы запускаете…

7-этапный процесс изучения ваших A/B-тестов (наряду с системами, которые вы можете использовать для улучшения будущих тестов)

Мы разбили это на 7 ключевых шагов, которым нужно следовать.

У вас могут не быть всех рекомендуемых здесь методов или инструментов, но, увидев, насколько они подходят, вы сможете оценить их ценность и решить, хотите ли вы интегрировать их в свои будущие тесты.

Шаг № 1: Убедитесь, что ваши данные точны, достоверны и значимы

Это самая важная часть всего этого процесса. Убедитесь, что информация, которую вы имеете в своем тесте, является точной и достоверной, чтобы вы могли быть уверены в результатах.

Так как же убедиться, что результаты ваших тестов дают вам данные, которым вы можете доверять?

Ну, есть несколько вещей, которые вы можете сделать…

Проверьте точность вашего инструмента

Теперь, большинство людей пропускают это. Не стесняйтесь пропустить его, если ваш сайт не посещает более 10 000 посетителей в месяц. Технически это не обязательно для начала работы с CRO и лучше всего работает с сайтами с большим объемом трафика, но было бы упущением не включить его здесь, поскольку большие сайты действительно могут увидеть разницу.

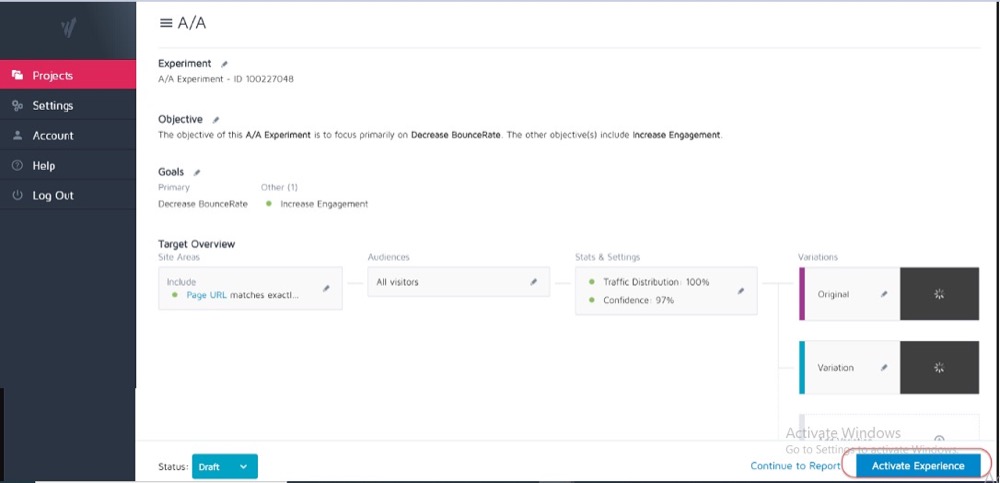

В идеале вы уже провели A/A-тестирование вашего текущего инструмента тестирования, чтобы увидеть, насколько он точен и есть ли у него какие-либо проблемы.

Как?

Вы запускаете простой сплит-тест с двумя идентичными копиями веб-страницы, а затем отслеживаете результаты на этих двух идентичных страницах.

Поскольку между ними нет различий, ваши результаты должны быть одинаковыми для каждой страницы. Однако могут быть некоторые расхождения, вызванные инструментом и тем, как он измеряет или отслеживает ваши данные.

Зная это заранее, вы сможете получить допуск на точность результатов вашего тестирования и использовать его в качестве ориентира для всех будущих тестов.

Пример

Если вы заметили, что ваш A/A-тест показал разницу в 0,5% в коэффициенте конверсии между двумя идентичными страницами, то вы можете опасаться любых результатов теста, которые показывают победителя, когда разница между контрольной и вариантом составляет всего 0,5%.

Вы можете установить внутренние правила, в которых говорится, что тест должен показать повышение на 1% или выше, прежде чем вы поверите в результат. Опять же, вам действительно нужно запустить тест A/A только один раз, когда вы пробуете новый инструмент или если вы считаете, что ваш текущий инструмент может иметь некоторые проблемы с отчетами или настроен неправильно.

A/A-тесты лучше всего работают с сайтами с большим трафиком, поскольку выборочные данные, необходимые для точной проверки, могут быть довольно большими, но разница в 1% ошибки может быть огромной.

Запустите тест достаточно долго, чтобы получить достоверное представление о том, как ваши клиенты взаимодействуют с вашим сайтом.

Итак, теперь, когда вы доверяете своему инструменту, вы хотите провести тест в течение 2-4 недель, даже если вы получите достаточно конверсий, чтобы статистически иметь возможность отключить его раньше.

Почему?

Потому что ваша аудитория часто будет по-разному взаимодействовать с вашим сайтом в зависимости от дня недели или определенных периодов месяца.

Пример

Если бы людям из вашей аудитории платили по четвергам, вы бы заметили всплеск, который вы могли бы пропустить, если бы ваш тест проводился только с понедельника по среду, верно?

Точно так же другие пользователи могут получать оплату раз в две недели или ежемесячно, что снова искажает ваши результаты, если ваши тесты не выполнялись достаточно долго, чтобы включить их в него. Вы просто предполагали бы более низкие продажи или трафик для пропущенных раз.

Как узнать, когда заканчивать тест? Подробнее о Статистическая значимость A/B-тестирования: как и когда завершать тестирование

Будьте в курсе любых внутренних или внешних факторов, которые могут повлиять на ваши результаты

Это уникальные или запланированные события, которые могут исказить ваши данные.

Например, если ваш генеральный директор или компания были в новостях или если вы проводите какие-либо текущие маркетинговые кампании или рекламные акции, а также любые внешние факторы, такие как национальные праздники или даже случайные всплески трафика.

Все это может повлиять на посещаемость вашего сайта, а затем изменить точность результатов за этот период.

Правдивая история:

Около 6 лет назад у меня была компания по производству одежды для серфинга.

Однажды наш трафик вырос примерно на 800% из ниоткуда, и наш показатель отказов подскочил. Мы не проводили никаких новых маркетинговых кампаний, поэтому я провел небольшое расследование, чтобы выяснить, откуда приходит трафик.

Выяснилось, что на одной из наших футболок было название продукта, совпадающее с названием новой песни корейской поп-группы, и в течение 2 дней мы ранжировались по ней и привлекали посетителей.

Конечно, эта новая аудитория совершенно не заинтересовалась нашим продуктом и вскоре ушла.

Сумасшедший, верно?

В другой раз мой маркетинговый блог начал ранжироваться по бренду телекомпании, и произошло то же самое. У нас всплески трафика от неправильной аудитории.

Каким бы случайным это ни было, такие вещи могут произойти, поэтому будьте в курсе таких внешних или внутренних событий. Вы всегда можете проверить свою аналитику, чтобы узнать, откуда пришел трафик, а затем перезапустить тест, когда все вернется на круги своя.

Обязательно получите достаточно данных

Вы хотите убедиться, что в вашем тесте достаточно конверсий, чтобы получить правильное представление о том, как он работает.

Наличие контрольного и варианта всего с 50 общими конверсиями и лишь небольшой разницей между ними недостаточно, чтобы получить какое-либо представление о вашей аудитории, даже если результаты теста были каким-то образом статистически значимыми. Большинство экспертов сходятся во мнении, что около 300+ конверсий на вариант обычно является хорошим эмпирическим правилом (и даже больше, если вы хотите сегментировать позже).

Чем больше набор данных, тем проще найти информацию в анализе после тестирования.

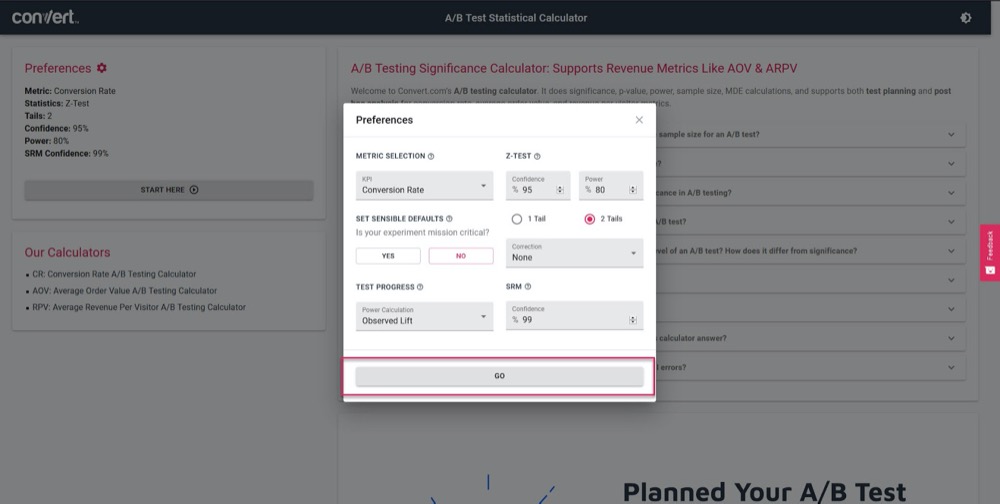

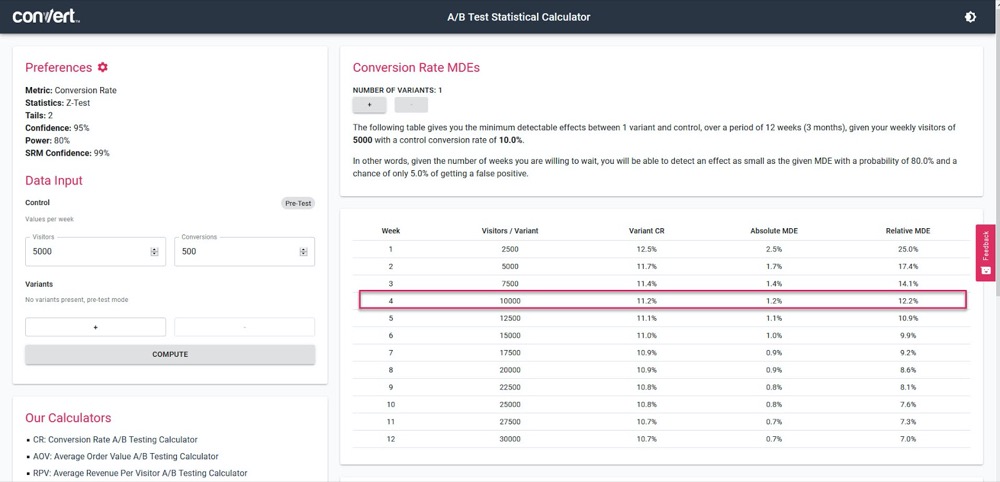

Используйте наш калькулятор значимости A/B-тестирования, чтобы получить представление о том, насколько точным будет ваш тест, исходя из 4-недельного цикла продаж и информации с вашей текущей «контрольной» страницы.

Просто установите параметры теста:

Затем укажите, сколько трафика ваш тест должен получать в неделю, а также количество конверсий на вашей текущей странице, а затем узнайте точность и процент подъема, который сможет рассчитать ваш тест.

В приведенном выше примере мы можем измерить всего лишь 1,2% роста через 4 недели. (Если мы хотим получить более высокую точность, просто запустите тест дольше или увеличьте объем трафика в тесте.)

Получите статистически значимые результаты

Вот почему статистическая значимость важна, но не является самым важным фактором при тестировании.

Да, вы хотите, чтобы ваш тест выполнялся достаточно долго, чтобы увидеть достоверность результатов 95-99%, но вы также хотите убедиться, что все остальные факторы, которые мы рассмотрели выше, затронуты.

Почему?

Даже тест A/A может показать 95% уверенность в том, что одна версия лучше, чем ее идентичная копия, если она не работает достаточно долго.

(Он мог случайным образом увидеть все конверсии в одной версии в один день и ни одной в другой.)

Слишком много новых тестировщиков останавливают кампанию, как только она достигает «статистического сигнала», что приводит к получению ложных данных. Вот почему мы рекомендуем вам получить статистическую значимость 95% или выше, но ТАКЖЕ провести тест на 2-4 циклах продаж, с более чем 300 конверсиями и с достаточно большим размером выборки.

Если вы сделаете все это, вы можете быть уверены, что ваш тест даст вам достоверные и точные результаты.

Я не могу не подчеркнуть, насколько важно запустить тест, чтобы вы соответствовали этим критериям.

Слишком ранний вызов теста может дать вам ложную информацию, которая может привести к:

- Не найти потенциального победителя, так как у вас недостаточно информации,

- Запуск менее эффективных кампаний, потому что вы думаете, что они являются победителями, но на самом деле у них более низкий коэффициент конверсии,

- Или, что еще хуже, вы можете получить ложную уверенность в этих результатах, а затем использовать то, что вы узнали, для масштабирования на другие части вашего сайта, тем самым усиливая эти негативные эффекты.

Знаете ли вы, как ваш инструмент A/B-тестирования делает выводы о выигрышных вариантах? Нажмите здесь, чтобы использовать наш калькулятор значимости A/B-тестирования.

Примечание:

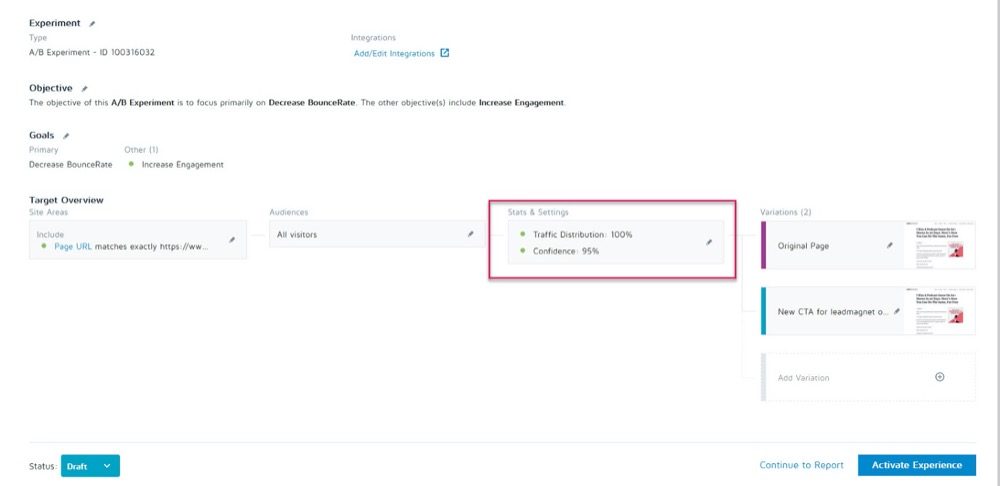

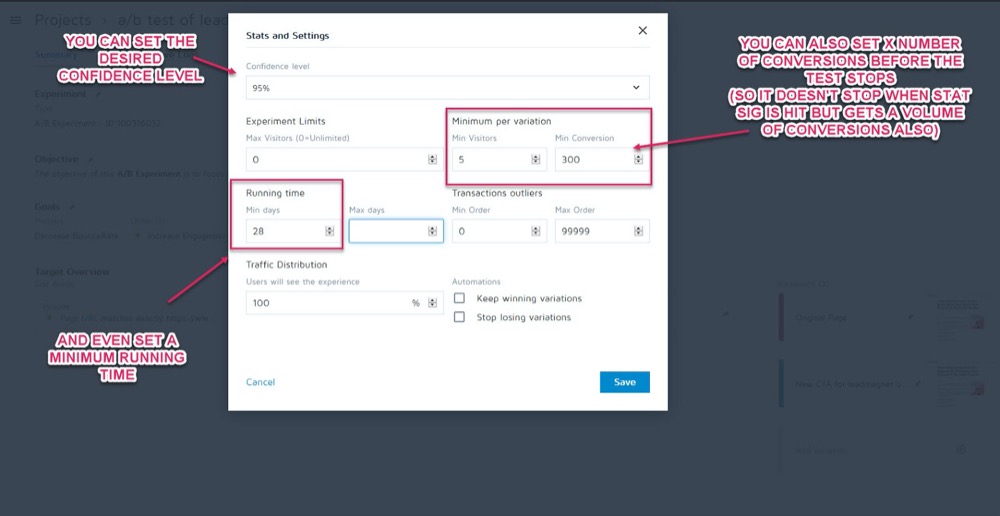

Вы можете установить их в качестве параметров перед запуском теста в разделе «Статистика и настройки» вашего эксперимента в приложении Convert Experiences.

Затем вы можете установить желаемый уровень достоверности, минимальное время выполнения и количество конверсий, которые необходимо достичь, прежде чем можно будет вызвать тест.

Как только вы убедитесь, что ваши данные точны, пришло время их проанализировать…

Шаг № 2. Проверьте свои микро-, макро- и защитные показатели

Большинство людей посмотрят на тест и примут победителя или проигравшего за чистую монету, исходя из того, что им говорит инструмент.

Проблема, конечно, в том, что инструмент может сказать вам, как работает ваш тест, только на основе критериев, которые вы для него установили. Как тестировщики CRO, мы всегда хотим понять, «как» и «почему» привели к таким результатам, чтобы мы могли учиться на них.

Сейчас мы проведем несколько проверок, но сначала я расскажу о трех самых важных. Вот где вступает в действие отслеживание микро- и макрорезультатов.

Позволь мне объяснить:

- Микроотслеживание — это отслеживание цели, для которой вы оптимизировали свой тест, а именно большего количества кликов, регистраций и т. д.

- Отслеживание макросов изучает влияние на показатель Northstar для вашего бизнеса, которым обычно являются продажи.

Почему это важно?

Иногда рост микрособытия на тестовой странице не влияет на макрос, как вы могли бы подумать.

Пример

Допустим, вы тестируете CTA на странице захвата лидов, и проигравшая получает меньше лидов, чем контрольная.

Кажется очевидным, какой тест выиграл, верно?

Но при дальнейшем изучении вашей аналитики вы замечаете, что лиды, которые прошли этот «проигрышный» тест, на самом деле конвертировались намного выше на бэкэнде и создали гораздо большую рентабельность инвестиций.

Почему это произошло?

Возможно, ваша текущая страница привлекает более широкую аудиторию и конвертирует больше потенциальных клиентов, но ваш новый «проигрышный» вариант на самом деле привлекает людей, которые готовы купить прямо сейчас.

В этом примере проигрышная кампания на самом деле будет страницей, с которой вы хотели бы работать, поскольку она намного лучше конвертируется с вашей метрикой Northstar.

Помните о своей конечной цели и сосредоточьте свои усилия на том, что больше всего на нее влияет.

Однако микро- и макрорезультаты — это еще не все, что вам нужно искать.

Если вы еще этого не сделали, рассмотрите возможность добавления показателей Guardrail в свои кампании.

Это основные показатели, за которыми вы хотите следить при внесении любых других изменений, чтобы, если они начнут падать, вы могли откатить или остановить определенные методы тестирования, потому что их производительность слишком важна.

В Uber мы проводим сотни экспериментов в любой момент времени. Цель этих экспериментов — постоянно улучшать наши продукты и пользовательский опыт. Однако иногда экспериментатор может иметь в виду некоторые ключевые показатели и не знать о влиянии на несколько других показателей, важных для команды и компании в целом, и по мере проведения эксперимента эти неотслеживаемые показатели могут регрессировать.

Чтобы обнаруживать и устранять такие сценарии, мы создали нашу экспериментальную платформу мониторинга. Цель состоит в том, чтобы определить и контролировать несколько показателей ограждения, которые мы не хотим ухудшать во время проведения эксперимента. Мы применяем вариант последовательной методологии A/B для постоянного мониторинга этих показателей ограждения и обнаружения любой регрессии между экспериментальной и контрольной группой эксперимента. При обнаружении регрессии мы отправляем оповещения владельцу эксперимента .

Суман Бхаттачарья, старший специалист по данным, Uber

Пример

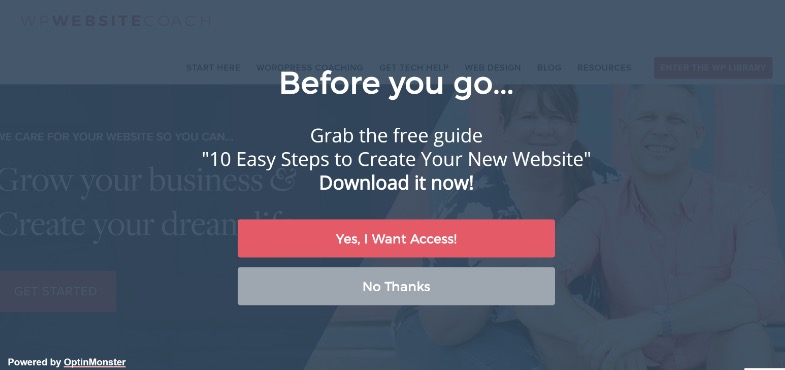

Допустим, вы хотите привлечь больше потенциальных клиентов с помощью полноэкранных всплывающих окон.

Для некоторых сайтов это работает отлично, но не всегда. (Вот почему мы тестируем!)

Возможно, вы установили полноэкранное всплывающее окно и стали получать больше лидов на этой странице, но ваши приветственные письма этим новым подписчикам не доставляются.

Оказывается, люди подписывались на поддельные электронные письма только для того, чтобы всплывающие окна перестали отображаться.

Вы не хотите, чтобы в вашем списке адресов электронной почты были фальшивые лиды, поскольку они могут снизить результаты доставки вашей электронной почты реальным подписчикам. Вы также не должны хотеть ухудшить пользовательский опыт настолько, чтобы ваша аудитория почувствовала, что им нужно подделать свою электронную почту.

Поскольку электронный маркетинг является основной частью вашего процесса продаж, вы решили настроить оповещение, чтобы вы знали, превышает ли показатель отказов по электронной почте заданное значение во время проведения A/B-тестов на странице захвата лидов.

Это будет ваша метрика ограждения. В этом примере вы видите, что он не работает, и решаете использовать менее навязчивые методы захвата потенциальных клиентов.

Имеет ли это смысл?

Показатели Guardrail — это не только захват потенциальных клиентов и показатель отказов. Это ключевые показатели, падение которых не должно влиять на взаимодействие с пользователем.

Чтобы предотвратить ухудшение пользовательского опыта, а также убедиться, что вы также улучшаете важные показатели, определите несколько защитных показателей, которые, если они упадут до определенного порога, помешают вам двигаться вперед с развертыванием предполагаемого « выигрышный» вариант. Это также помогает положить конец спорам между оптимизацией конверсии и рекомендациями по UX или бренду .

Алекс Биркетт, Omniscient Digital

Вам решать, что это за показатели для вашего бизнеса. Используйте их, чтобы увидеть, есть ли у вас реальный выигрыш, или вы просто обмениваете рост одного результата на проигрыш в более важной области.

Если вам нужно вдохновение, ознакомьтесь со списком общих показателей безопасности в экспериментах и тестировании, составленным Беном Лабеем:

Затем внесите соответствующие изменения.

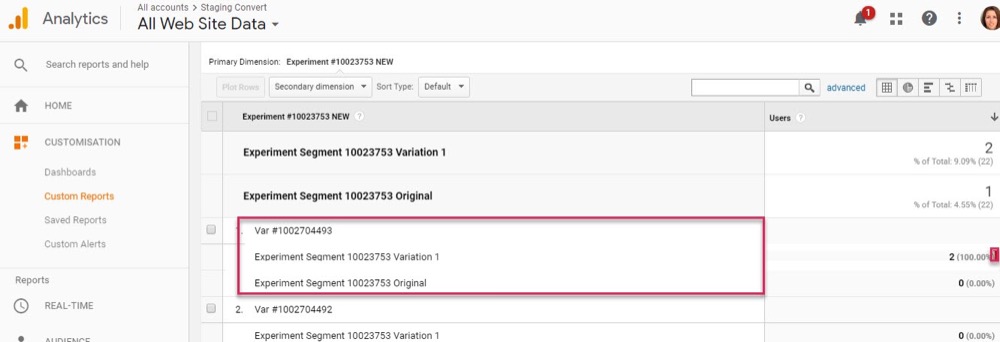

Пока у вас есть приложение Convert Experiences, настроенное с вашей аналитикой и расширенными сегментами, вы сможете найти эту информацию, быстро осмотревшись. Проверьте влияние каждой вариации на вашу метрику Northstar, а также на ваши «ограждения», чтобы вы не просто выбрали победителя инструмента тестирования.

Теперь, когда вы рассмотрели основные показатели, давайте немного подробнее рассмотрим ваши результаты…

Шаг № 3: идите глубже и сегментируйте свои результаты

Помните, что когда дело доходит до тестирования, среднее значение — ложь .

Средний результат может дать вам только общую информацию, основанную на комбинации нескольких точек данных. Вам решать, почему произошел такой результат, а затем заглянуть глубже, потому что это не всегда то, чем кажется.

Мы уже видели это, когда на результаты макросов влияли изменения микротестов, но сегменты аналитики могут дать еще более глубокое понимание.

Пример

Допустим, вы проводите тест на получение большего количества лидов. На первый взгляд контроль и вариант имеют одинаковую конверсию посетителей в подписчиков.

Однако при более глубоком рассмотрении вы заметите, что на настольных компьютерах новый вариант почти вдвое превышает коэффициент конверсии по сравнению с контрольным, а на мобильных устройствах он равен нулю, в результате чего среднее значение страницы кажется идентичным контрольному.

Явно что-то не так, но почему так?

Возможно, новый вариант просто неправильно загружается на мобильных устройствах, или, возможно, форма не работает на определенных устройствах, поэтому мобильные пользователи, которые хотели подписаться, на самом деле не могли этого сделать. И если вы исправите эту проблему, может случиться так, что ваш вариант «равного результата» на самом деле сможет намного превзойти контрольный вариант.

Вы можете найти эти вещи только тогда, когда будете работать над тем, чтобы получить больше информации о своих результатах.

С каждым тестом вы будете экспериментировать, получая информацию, которая будет способствовать более разумной сегментации, которая приведет к новым выводам, которые в конечном итоге приведут вас к более осмысленной стратегии .

Шанель Маллинз, Shopify

Сегментация заключается не только в поиске ошибок, но и в поиске других сведений о пользователях.

Может быть, страница и элемент управления работают нормально, но если вы посмотрите глубже, вы заметите, что в этом новом тесте некоторые каналы трафика конвертируются намного выше, чем другие?

Часто у вас будут одни сегменты с низкой эффективностью, а другие с повышенной эффективностью. Затем это может стать основой для новых кампаний по персонализации или стратегий платного или органического трафика.

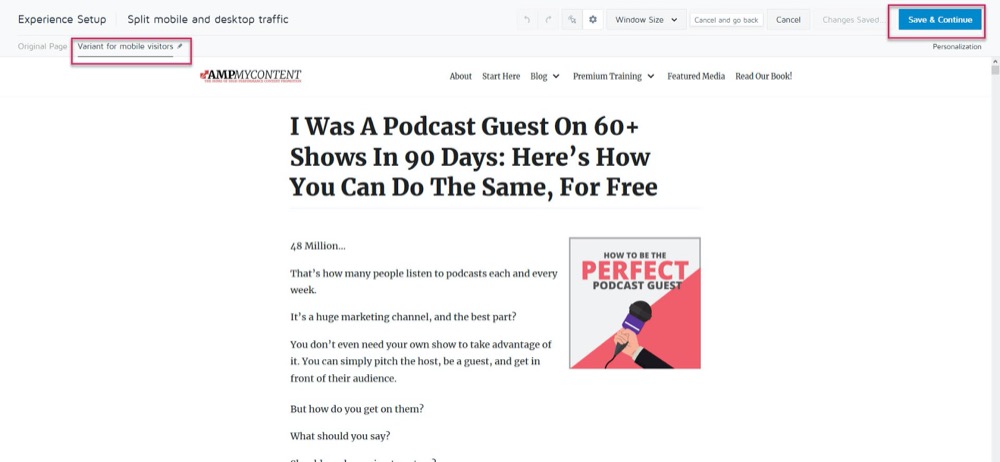

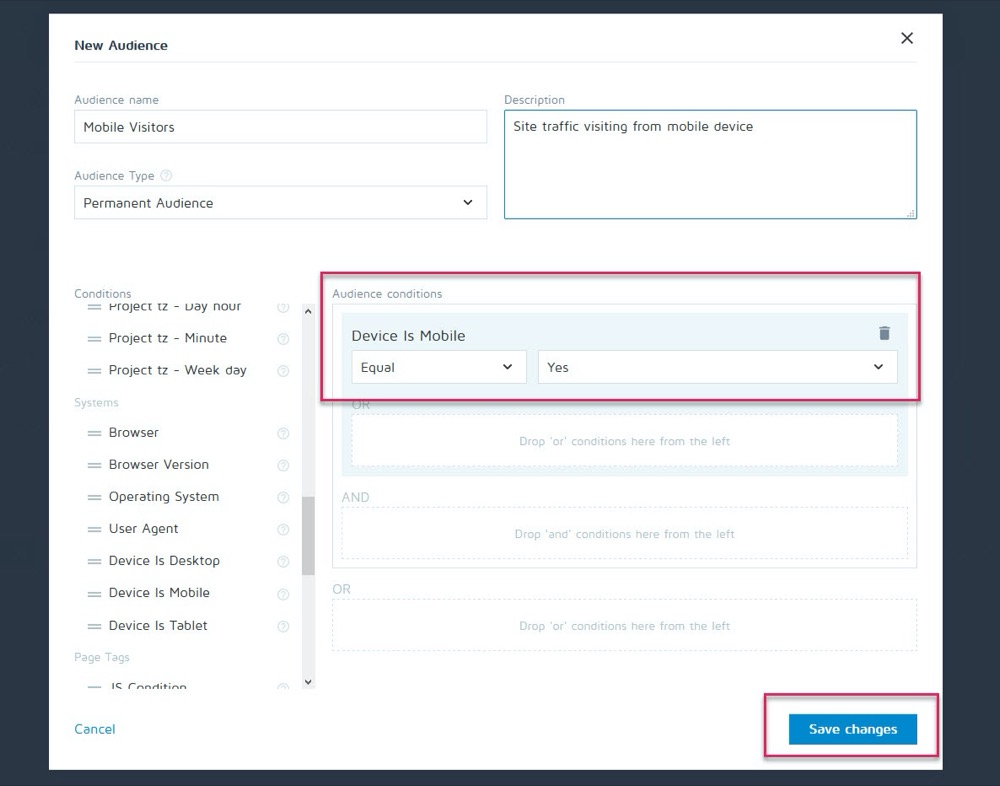

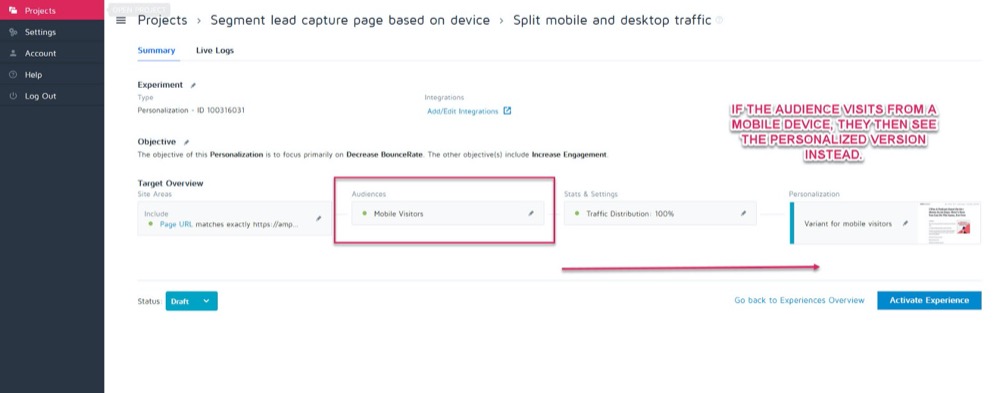

Возможно, элемент управления лучше всего конвертируется на ПК, но новый вариант конвертирует лучше на мобильных устройствах. Скажем, например, вы хотите выбрать, какая версия будет отображаться на основе того, как зритель видит ваш сайт.

Используя функцию персонализации Convert, вы можете настроить этот мобильный выигрышный вариант как персонализацию только для этой аудитории.

Затем вы сможете показывать новую версию, когда посетитель заходит с любого мобильного устройства.

Но если они столкнутся с настольным компьютером, вместо этого они увидят настольную версию.

Существует целая куча различных методов персонализации, которые вы можете использовать, но только после того, как получите представление о своих кампаниях.

Ключ к анализу сегментов — всегда смотреть на свои результаты, чтобы узнать, ПОЧЕМУ что-то произошло.

Смотреть на:

- Новая и вернувшаяся аудитория . Возвращает ли один вариант людей чаще? Превращает ли кто-то больше холодных/новых членов аудитории?

- Источник трафика. Один канал работает лучше, чем другие? Не могли бы вы больше сосредоточиться здесь?

- Просмотры страниц. Особенно, если ваша тестовая страница пытается привлечь трафик на вашу страницу продаж. Отсутствие кликов по одной версии может означать, что у вас сломана кнопка или проблема с призывом к действию.

- Показатель отказов. Это может указывать на неработающую ссылку/медленную загрузку/плохой UX или даже на неправильную аудиторию.

- Операционная система,

- Мобильный против рабочего стола.

- Используемое устройство.

Небольшой отказ от ответственности:

Чтобы получить точное представление о каждом канале при такой сегментации, вам нужно МНОГО данных. Хорошее эмпирическое правило — провести тест примерно в 10 раз больше конверсий, чем обычно (или 300 конверсий на канал, а не только на вариант страницы).

Вы можете подумать: «Мы никак не можем получить достаточно трафика для проведения такого теста ». Или, если вы это сделаете, это может занять месяцы, чтобы это произошло.

Даже если это так, не пренебрегайте анализом сегментов.

Почему?

Даже если у вас может быть недостаточно конверсий в каждом сегменте, чтобы делать выводы на основе данных, это может дать вам некоторые важные сведения, если вы начнете замечать такие проблемы, как просмотры страниц без кликов или немедленный показатель отказов .

Все это может указывать на неработающий тест и помочь вам найти потенциально пропущенного победителя. Идите вперед и ищите любые серьезные падения и проблемы. Все ли работало на каждой платформе и устройстве?

В идеале вы проверили их все перед тестом, но что-то может сломаться в середине теста, поэтому проверьте еще раз.

У меня лично WordPress автоматически обновлялся в середине кампании, из-за чего формы захвата лидов внезапно переставали работать в середине теста. Всегда проверяйте, и если вы видите что-то, что разрушает точность ваших результатов, остановите тест, устраните проблему, а затем запустите снова.

А если бы все нормально работало?

Давайте посмотрим и выясним, ПОЧЕМУ люди не предприняли ваших действий…

Шаг № 4: Проверьте поведение пользователя для получения дополнительной информации

В идеале у вас должно быть качественное отслеживание поверх вашего инструмента тестирования.

Почему?

Потому что это часто может дать вам представление о вашем варианте, который вы бы упустили при обычном тестировании.

Запомнить:

Инструменты количественного тестирования , такие как Convert, расскажут вам, что произошло. Мы можем предоставить вам необработанные числовые данные о том, сколько людей нажали или не нажали, и помочь настроить каждый A/B-тест.

Но добавление качественных инструментов помогает понять, ПОЧЕМУ произошло действие. Они позволяют вам увидеть, что делал пользователь, и получить больше информации об их действиях.

(Тесты обычно терпят неудачу либо из-за плохого выполнения, либо из-за понимания аудитории, и только увидев, что пошло не так, мы можем решить эту проблему.)

Используя такой инструмент, как Hotjar, вы можете запустить ряд качественных тестов и даже получить данные прямо на панель управления Convert с нашей встроенной интеграцией.

Чтобы получить более глубокое представление, настройте интеграцию Hotjar — Convert и попробуйте описанную ниже тактику.

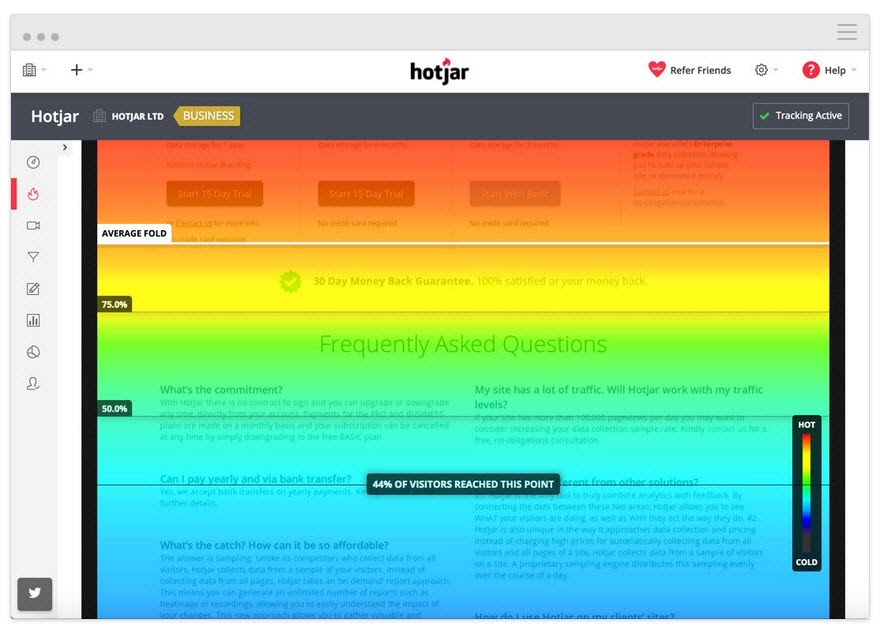

Отслеживайте, как далеко пользователь читает

Добавьте инструмент тепловой карты на свою страницу, чтобы увидеть, доходит ли ваша аудитория до вашего CTA. Если нет, вы можете снова запустить тест и переместить CTA выше на странице.

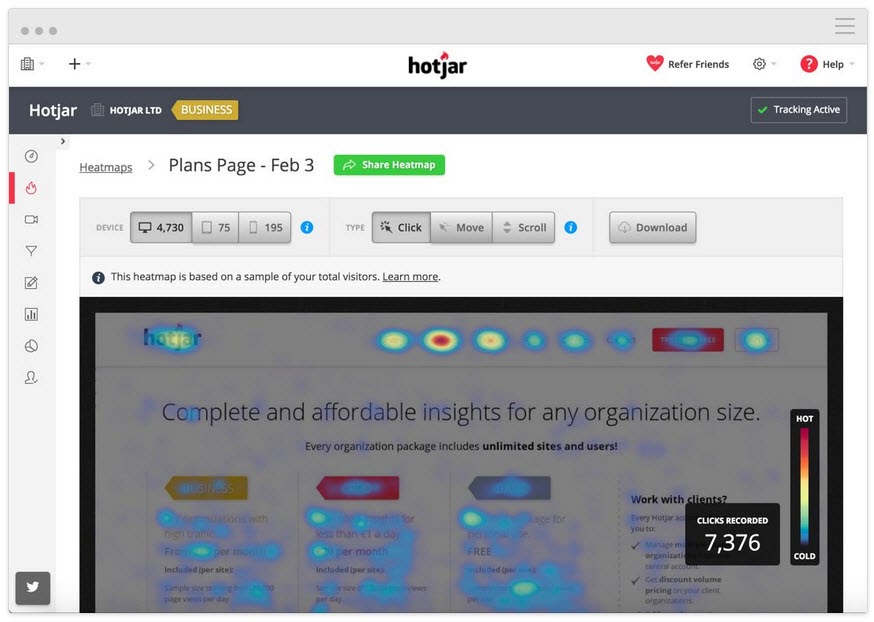

Отслеживайте, на что пользователи нажимают, но не должны

Нажимают ли они на стратегические призывы к действию или это случайный текст, который, по их мнению, может быть ссылкой?

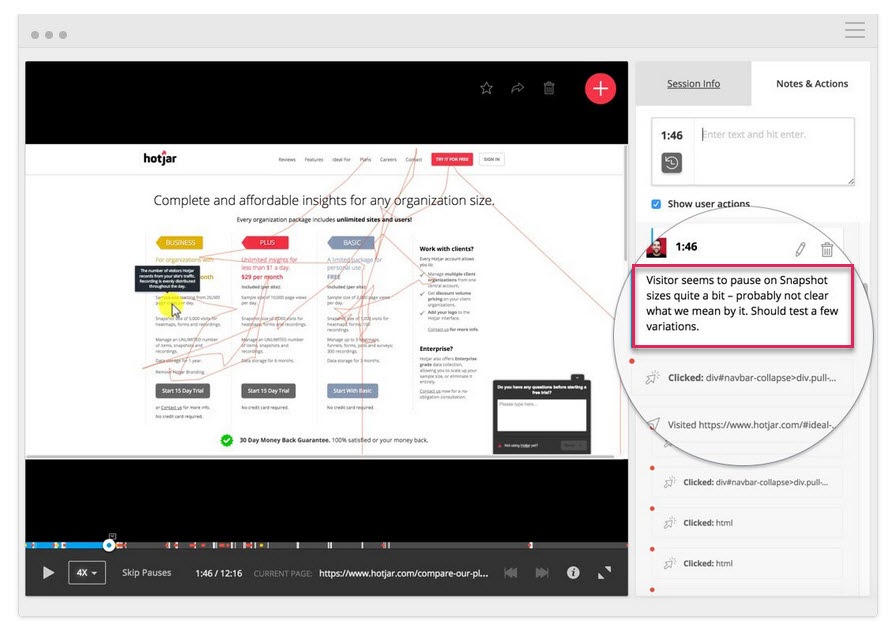

Смотрите записи экрана, чтобы увидеть, на что они не нажимают, но должны

Они не нажимают на вашу кнопку CTA, даже если прокручивают страницу достаточно далеко, чтобы ее увидеть? Щелкают, но не открывается? Видят ли они это, но не понимают, что это кнопка, на которую нужно нажать?

Вы можете смотреть все это и даже добавлять заметки, когда эти вещи появляются.

Помочь могут не только тепловые карты и инструменты отслеживания кликов.

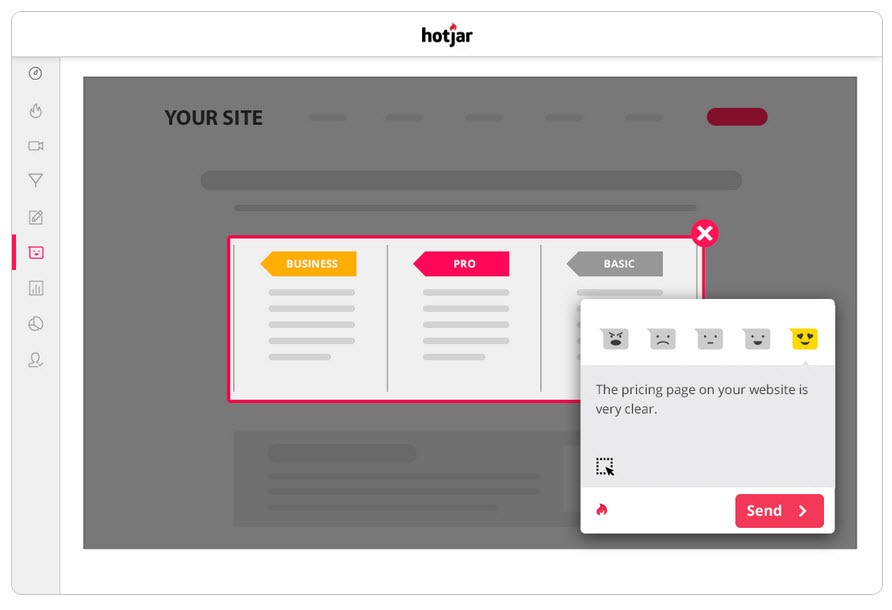

Проводите опросы для своей аудитории

Опросы помогают вам не только получить обратную связь о том, что заставило вашу аудиторию действовать (или остановить их), но и дать вам язык, который она использует для описания этого.

В копирайтинге мы называем это «зеркальным языком», и он невероятно эффективен для связи с пользователем. Такое ощущение, что вы не только признаете их проблему, но и понимаете ее лучше, чем кто-либо другой, поскольку описываете ее теми же словами, что и они.

Два отличных способа использовать опросы вместе с инструментом A/B-тестирования:

- Выход из опросов о намерениях . Определите тех, кто не использует новую версию, чтобы узнать, что их остановило.

Есть ли причина, по которой вы не подписались/не купили сегодня?

- Опросы после покупки/конверсии. Найдите тех, кто принимает вариант, и посмотрите, есть ли какие-то точки преткновения и мотивирующие факторы.

Что заставило вас принять решение сегодня?» Было ли что-то, что чуть не помешало вам принять решение?

Вы даже можете запустить аналогичные опросы на элементе управления, если вам нужна дополнительная информация. Все это поможет вам понять, как выполнялся тест, чтобы вы могли повторять и улучшать его.

Говоря о которых…

Шаг № 5. Учитесь на проигрыше тестов

Самое главное, когда дело доходит до проигрышного теста, — это извлечь урок из результата. Нет такой вещи, как плохой тест, если вы можете извлечь из него информацию, чтобы улучшить или лучше понять свою аудиторию.

A/B-тестирование — это интерактивный процесс. Мы проваливаемся вперед, пока обретаем понимание. Вы часто можете узнать гораздо больше, пройдя проигрышный тест до победителя, чем просто выиграв сразу.

До сих пор мы делали 3 вещи:

- Убедившись, что данные испытаний точны,

- Глядя на необработанные результаты для любых проблем, и

- Пытаемся понять наших пользователей и их действия.

Этот шаг представляет собой скорее эвристический подход, который поможет вам понять распространенные проблемы, которые могут привести к сбою (при условии, что тестовые данные точны и все кнопки CTA работают), и проанализировать свой подход и гипотезу.

Была ли ваша гипотеза ошибочной или ваш тест был неверным?

Это распространенная проблема, особенно среди новых тестировщиков.

Вы проводили тест на основе каких-то ошеломляющих метрик или идей, которые не соответствовали реальному KPI?

Пример

Допустим, вы хотите увеличить продажи со страницы, но по какой-то причине решили вместо этого протестировать настройки кнопок социальных сетей. (Даже если у вас нет данных, чтобы показать, что большее количество репостов в социальных сетях влияет на ваши продажи.)

Звучит безумно, но вы будете удивлены, как часто такое случается.

Спроси себя:

Совпала ли цель моего тестирования с основным KPI и каким образом это могло повлиять на него?

Если это не так, то все в порядке, но убедитесь, что следующий тест выравнивается лучше.

Мы терпим неудачу, мы учимся, мы пробуем снова.

При следующем тесте обязательно сосредоточьтесь на своих основных показателях KPI и на том, как вы можете на них повлиять, а также предоставьте тесту четкий сценарий выигрыша/неудачи.

Мы хотим, чтобы эта страница привлекала больше потенциальных клиентов, поэтому мы тестируем то, что заставляет их подписаться, а это значит, что мы хотим создать лучший CTA.

или же

Мы хотим, чтобы эта страница привлекала больше потенциальных клиентов, и мы обнаружили, что пользователи не прокручивают страницу до нашего CTA, поэтому мы тестируем его поднятие вверх по странице.

Согласование вашего теста с вашей целью приведет вас к правильному пути, но даже в этом случае он все равно может не увидеть больше конверсий…

Гипотеза оказалась верной, и тест совпал, но изменений в результатах по-прежнему не было

Это может произойти в 90% случаев, и именно поэтому большинство тестов терпят неудачу.

Пример №1

Ваши пользовательские данные показывают, что пользователи недостаточно доверяют вашему сайту. Вы добавили факторы доверия, такие как социальное доказательство, отзывы пользователей, SSL-сертификаты, но количество конверсий все еще не увеличилось.

Означает ли это, что вы должны остановиться и попробовать новый тест или угол?

Нисколько…

Ваша первоначальная гипотеза могла быть верной, но ваш тест просто нужно улучшить или выполнить лучше, прежде чем вы увидите какой-либо эффект.

Вы можете попробовать добавить больше факторов доверия или даже изменить те, которые у вас есть, чтобы они больше выделялись. Возможно, перефразируйте язык, используемый в них, чтобы помочь им лучше общаться с вашей аудиторией.

Все эти вещи по-прежнему совпадают с первоначальной гипотезой, вам просто нужно протестировать больше версий, чтобы найти победителя.

Пример #2

CXL провела 6 различных тестовых кампаний на этой целевой странице, чтобы привлечь больше потенциальных клиентов для сертификации водителей грузовиков.

Они увеличили количество подписок с 12,1% до 79,3% благодаря дальнейшему улучшению страницы.

(Почти во всех этих тестовых кампаниях было предпринято несколько попыток с использованием одной и той же гипотезы, прежде чем они увидели рост. Только после этого они двигались дальше и тестировали, чтобы улучшить другие элементы на странице.)

A/B-тестирование — это повторяющийся процесс. Вы должны продолжать тестировать и настраивать, чтобы найти улучшения, и даже лучшие в своем деле могут найти победителя только в 10% случаев.

Если бы гипотетически вы были организацией и каждый тест, который вы проводили, был успешным, то, на мой взгляд, это был бы красный флаг.

Это звучит нелогично, но для меня это показывает, что вы только тестируете очевидные вещи и не принимаете на себя достаточного риска, чтобы действительно сдвинуться с мертвой точки .

Дебора О’Мэлли, «Угадай тест»

Всегда приятно учиться у лучших, и мы рады поделиться интервью, которое мы взяли у Деборы. Мы говорили о том, почему тесты никогда не бывают неудачными, и о важности правильного мышления при тестировании. Чтобы помочь вам начать с правильной ноги, послушайте наше интервью здесь.

Это означает, что вам может понадобиться 9 тестов, прежде чем вы увидите положительный результат, так что не сдавайтесь.

Ваши тесты должны следовать системе приоритетов от наибольшего влияния к наименьшему. Выполняя дополнительные тесты и внося изменения для улучшения текущей кампании, вы увидите гораздо больший эффект, чем переход к тесту с меньшей важностью, потому что вы не видите немедленных результатов с текущей.

И если он по-прежнему не видит подъема с небольшими изменениями, рассмотрите возможность проведения инновационного теста, в котором вы запускаете другой дизайн.

Это могут быть качели для забора, но иногда это может быть изменение, которое вам нужно внести.

Что, если после всех этих тестов и доработок вариант все равно будет неудачным?

Таким образом, данные верны, и вы испробовали каждую настройку и даже внесли большие новаторские изменения во всю страницу, но она все равно не будет работать лучше, чем элемент управления.

Может показаться, что это не так, но на самом деле это ХОРОШО.

Почему?

Потому что вы узнали, что не работает с вашей аудиторией!

Так много веб-сайтов вносят огромные радикальные изменения, ничего не тестируя, и просто внедряют их, несмотря ни на что.

Спросите себя об этом:

Если этот вариант страницы конвертируется всего на 1% хуже, чем ваш текущий контрольный вариант, сколько денег вы сэкономили, сначала протестировав его, а не внедряя?

Back in 2014, Marks and Spencer decided to update their entire website without testing it with a sample audience first.

Результат?

Their online sales dropped by 8.1% in 3 months, causing a loss of $55 million.

This is why testing and finding losers is a really good thing because even losing tests can save you money.

What if the Test and the Variant Have Identical Results?

You checked everything, it all works, you've segmented down and gone into the nitty-gritty, but there's just no discernible difference between your current page and your new variant.

You've even tried complete page overhauls but through some fluke of math, your new page still converts at the same rate as the old one.

In this case, it's simply the dealer's choice.

Does the new variation more actively represent your brand and style?

If so, choose whichever you wish to use. The results are still the same but you are happier with the design.

Note: This should be the only time that you do this. Branding should not sacrifice results; it should aid them, as seen in the previous example.

Step #6: Double Down on Winners and Continue to Improve Them

So far we've been covering losing campaigns, but what if you got a winner right out of the gate?

First off, congratulations!

Second, let's make sure you actually have a winner. Oftentimes, things can happen to affect your results and give you a false positive (ie we think it's a winner but we implement it and nothing happens.)

Go ahead and run the test again with just your control and the winning variant and prove the lift in results first before you make any changes to your site.

Then if it really is a winner? Don't stop there, continue to improve it!

Iterative improvements of a new winning campaign are the easiest new test to run. With each new improvement, you'll see more ongoing ROI. You can even take what you learned with your winning test and then roll it out across similar pages on your site for further tests and see if it also adds lift there too.

Step #7: Create a Learning Repository for Future Tests

This step is relevant to both winning and losing tests.

Not only will it help you with future tests, but it will also help your QA team diagnose any broken campaigns faster, as they can see where issues have appeared in the past.

Better still?

It will help you document your results for clients or your boss, while also standardizing your reporting processes and ramping up your test velocity.

Вот как это работает:

You're going to create a master archive or learning repository of all past tests. A place to document your previous wins and losses that you can use to both reference for new campaigns and share with stakeholders or customers.

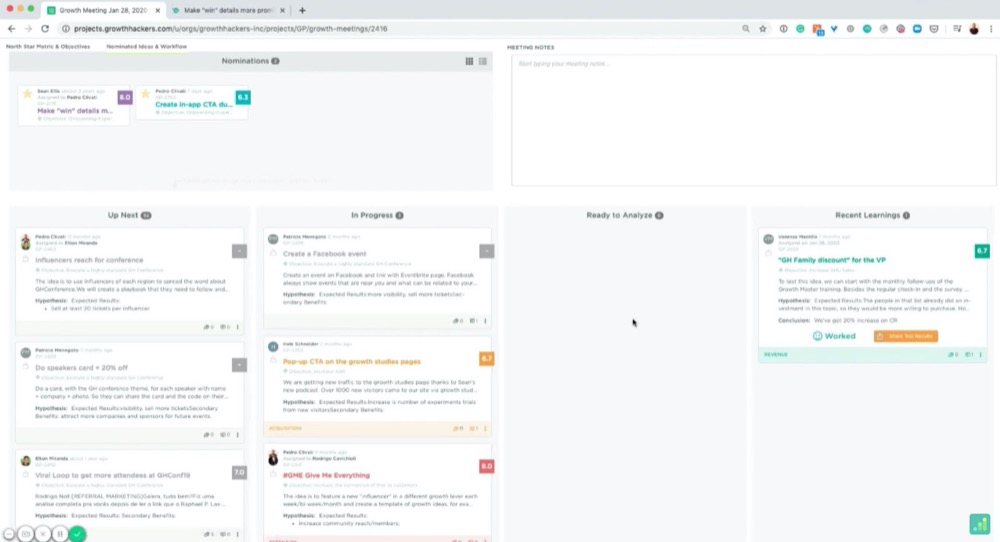

You can use a folder on your computer for this, but, if you really want to get organized, there's a great tool called GrowthHackers experiments.

Its main goal is to help marketing growth teams communicate and organize campaigns, but you can easily use it to manage your CRO testing and learnings. It will even pull in results from your test tool and allows you to archive each test. (You can simply tag and then add them to the repository.)

Whatever you decide to use, here are some best practices:

Organizing Your Tests

You probably have your own naming conventions but if you're just starting, I recommend naming each test like so:

“Goal – Campaign – Test Date”

Например:

“CTR lift test – XYZ client – March 1st-14th 2021”

This way, you can organize tests by goals to get inspiration for future tests, search through and find them for client campaigns, or look back on your experiments month by month.

Then, if you wanted to run a CTR test later on, you can swipe through them and see what ideas worked or failed in the past.

How Do We Create Documents for the Learning Repository?

Feel free to add screenshots of your testing tools graphs, confidence, and power level or any data that you think is relevant.

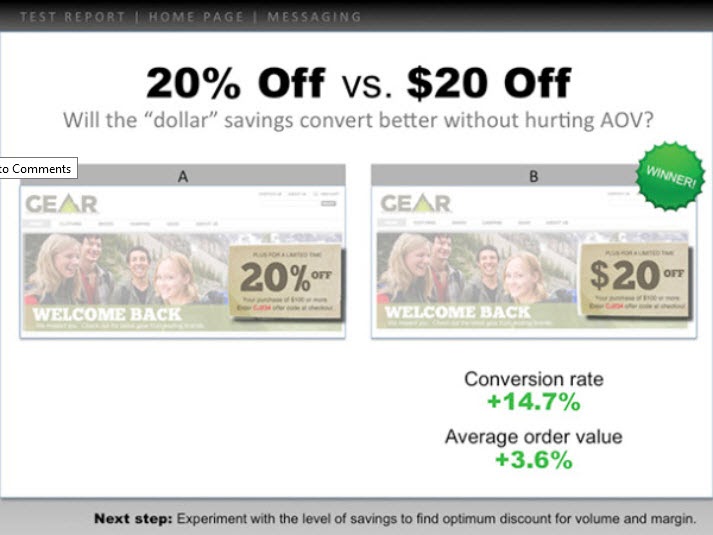

However, I highly recommend creating a slide with the following information:

- The hypothesis and how you came up with the idea (any survey data or information).

- A headline with the test goal.

- A screenshot of the control, the winning variant, and any other failed versions/tests that got some lift but not as much. (Highlight the key elements so you can spot what changed without having to look too hard.)

- Add the micro goal and its percentage lift. (Perhaps 3.2% CTR)

- Then add the macro goal and its percentage lift. (AVG order value up 2.2%, etc.)

Вот пример:

You can use these slides to present the test information to anyone else who needs them, while also having a simple file to understand the test at a moment's notice.

Pretty handy, right?

Now that you've analyzed your test and recorded the results, let's walk you through how to present this to your boss in a way that even if the test failed, they're still happy to see your findings…

How To Present This Information To Your Boss (Even When Your Campaigns Failed)

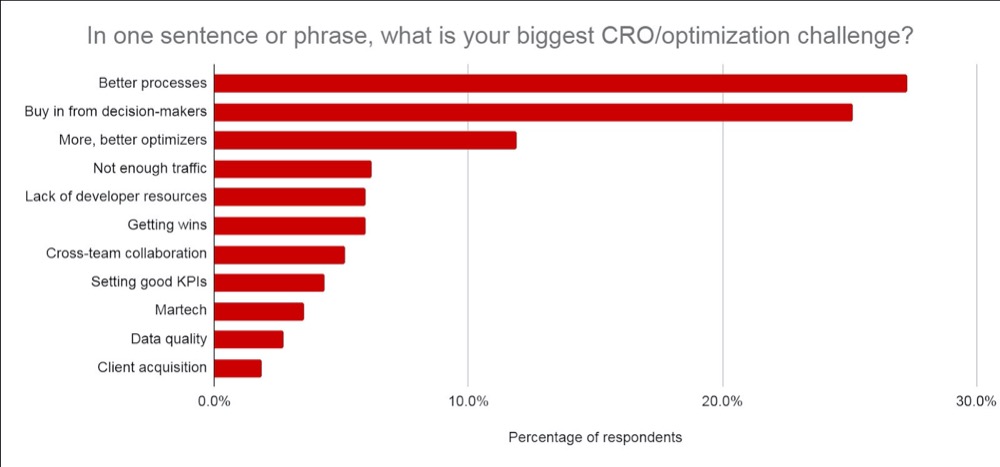

Don't worry if you feel anxious about this, you're not alone. In fact, according to CXL's state of the industry report, presenting test information or getting buy-in from your stakeholders is consistently one of the biggest struggles CROs face.

We've covered the best ways to communicate this information before, but I want to give you a few extra tips on how to get your test results across (even if your test failed).

Tip #1: Get Everyone On Board With CRO and Its Realities as Soon as Possible

Ideally, you covered this when you first broached the topic of running A/B tests but it never hurts to recap.

Make sure they understand that A/B testing is a continual learning process that's more about understanding your audience and improving their experience. The lift in ROI is simply a byproduct of taking action on each test and implementing what you learn, regardless of if it wins or fails.

Winners give lift and losers give insight into where to improve.

No test is ever wasted but the majority of them do fail. You're looking at roughly 1/10 winners for most people's tests and agencies are around 1/4.

Be clear on how many tests fail and the need to run more tests to find winners.

Tip #2: Present the Information as Simply as You Can

Not everyone can read graphs easily. Even if they can, it still means that it takes effort to understand the context of what they are seeing.

The more effort it takes to understand something, the more frustrating it can be and can cause you to lose the other person's attention.

(Top tip for landing pages btw ^^)

Break it down nice and simple by using the slides from your learning repository.

It should already include:

- Чему вы научились заранее и как пришли к идее теста.

- То, что вы тестировали. Покажите контроль, варианты и победителя.

- Как это работало на микро- и макроуровне. Включите результаты.

Finally, add any insights you drew from tests to decide on your next important action to take. (Improve execution, test new variations, new hypothesis, etc.)

Providing insight into what happened is HUGE.

Ваш босс больше заботится о том, чему вы научились, чем о результатах, так как на них можно действовать. Поделившись этим и предложив идеи, что делать дальше, вы поможете им увидеть, что вы контролируете ситуацию, и поможет им чувствовать себя уверенно перед дальнейшими тестами.

Совет № 3: сделайте так, чтобы они хорошо выглядели

Сделайте еще один шаг и добавьте данные, которые им важны:

- Если тест не удался, расскажите, почему вы думаете, что он не удался . Добавьте рентабельность инвестиций, сэкономленную за счет невыполнения неудачного теста, и то, как это повлияет на MRR и ARR.

- Если он выиграл, дайте представление о полученной рентабельности инвестиций и о том, как это влияет на годовой доход / MRR и ARR , а также о любой возможности дальнейшего масштабирования и увеличения рентабельности инвестиций. (т. е. вы могли протестировать страницу захвата лидов и увидеть прирост при настройке макета. У вас может быть 30 других подобных страниц, к которым вы могли бы применить этот тест, которые могут увидеть потенциальный прирост.)

- Если тест был плоским, поделитесь своими мыслями о том, что, по вашему мнению, произошло и что делать дальше. (Лучшее исполнение, новый вариант, полное изменение или более согласованный тест и т. д.)

Конечно, влияние ARR + MRR или YOY — это приблизительная оценка, но она показывает потенциальное влияние и ценность вашего тестирования. Это то, что волнует вашего босса и о чем он, возможно, думает, когда видит ваши результаты.

Поверьте мне, когда вы представляете свою информацию таким образом, вы заметите, что она передается намного легче. Вы переходите от того, чтобы рассматривать тест как «потерянные деньги» или пустую трату времени, вместо этого сосредотачиваетесь на потенциальной экономии, фактической прибыли и потенциальном дальнейшем росте.

Мало того, вы также сможете доказать свою ценность, проведя еще больше тестов, совершенствуя свои усилия по CRO и увеличивая скорость тестирования.

Вывод

Вот оно.

К настоящему времени вы должны чувствовать себя гораздо более уверенно в том, как анализировать и извлекать уроки из результатов ваших A/B-тестов, и иметь возможность представить эту информацию своему начальнику или кому-либо еще, независимо от того, как прошли ваши тесты.

Просто следуйте этому руководству, чтобы упростить послетестовый анализ каждого нового A/B-теста, который вы проводите!