Сколько A/B-тестов нужно проводить в месяц?

Опубликовано: 2023-01-19

Это важный вопрос, который необходимо учитывать для успеха вашей программы тестирования.

Запустите слишком много тестов, и вы можете тратить ресурсы, не получая никакой пользы от каждого отдельного эксперимента.

Но проведите слишком мало тестов, и вы можете упустить важные возможности оптимизации, которые могли бы принести больше конверсий.

Итак, учитывая эту загадку, какова идеальная частота тестирования?

Чтобы помочь ответить на этот вопрос, $en$e взглянет на некоторые из самых успешных и прогрессивных команд экспериментаторов в мире.

Amazon — одно из таких имен, которое приходит на ум.

Гигант электронной коммерции также является гигантом экспериментов. На самом деле, Amazon, как говорят, проводит более 12 000 экспериментов в год! Эта сумма составляет примерно тысячу экспериментов в месяц.

Говорят, что такие компании, как Google и Microsoft Bing, придерживаются аналогичного темпа.

Согласно Википедии, гиганты поисковых систем проводят более 10 000 A/B-тестов в год или около 800 тестов в месяц.

И не только поисковые системы работают с такой скоростью.

Booking.com — еще одно заметное имя в области экспериментов. Сообщается, что сайт бронирования путешествий проводит более 25 000 тестов в год, что составляет более 2 тысяч тестов в месяц или 70 тестов в день!

Тем не менее, как показывают исследования, в среднем компания проводит всего 2-3 теста в месяц.

Итак, если большинство компаний проводят всего несколько тестов в месяц, а некоторые из лучших в мире проводят тысячи экспериментов в месяц, сколько тестов вы должны проводить в идеале?

В истинном стиле CRO ответ таков: это зависит от обстоятельств.

От чего это зависит? Необходимо учитывать ряд важных факторов.

Идеальное количество A/B-тестов для запуска определяется конкретной ситуацией и такими факторами, как размер выборки, сложность идей тестирования и доступные ресурсы.

6 факторов, которые следует учитывать при проведении A/B-тестирования

Есть 6 важных факторов, которые следует учитывать при принятии решения о том, сколько тестов нужно запускать в месяц. Они включают

- Требования к размеру выборки

- Организационная зрелость

- Доступные ресурсы

- Сложность тестовых идей

- Сроки тестирования

- Эффекты взаимодействия

Давайте углубимся в каждый.

Требования к размеру выборки

В A/B-тестировании размер выборки описывает объем трафика, необходимый для проведения надежного теста.

Чтобы провести статистически достоверное исследование, вам нужна большая репрезентативная выборка пользователей.

Хотя теоретически вы можете провести эксперимент всего с несколькими пользователями, вы не получите очень значимых результатов.

Небольшие размеры выборки все же могут давать статистически значимые результаты

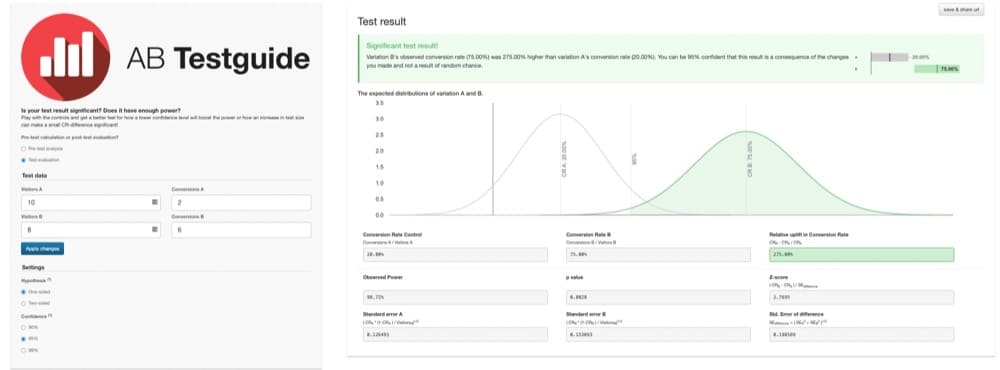

Например, представьте себе A/B-тест, в котором только 10 пользователей увидели конвертацию версии A и 2. И только 8 пользователей увидели версию B, из которых 6 конвертировались.

Как видно из этой диаграммы, результаты статистически значимы:

Версия B превосходит на 275%. Но эти выводы не очень заслуживают доверия. Размер выборки слишком мал для получения значимых результатов.

Исследование недостаточно мощное. Он не содержит большой репрезентативной выборки пользователей.

Поскольку тест недостаточно мощный, результаты подвержены ошибкам. И неясно, произошел ли результат случайно или одна версия действительно лучше.

По такой небольшой выборке легко сделать неверные выводы.

Правильно настроенные тесты

Чтобы преодолеть эту ловушку, A/B-тесты должны быть достаточно мощными с большой репрезентативной выборкой пользователей.

Насколько велик достаточно большой?

На этот вопрос можно ответить, выполнив простые расчеты размера выборки.

Чтобы проще всего рассчитать требования к размеру выборки, я предлагаю использовать калькулятор размера выборки. Их много.

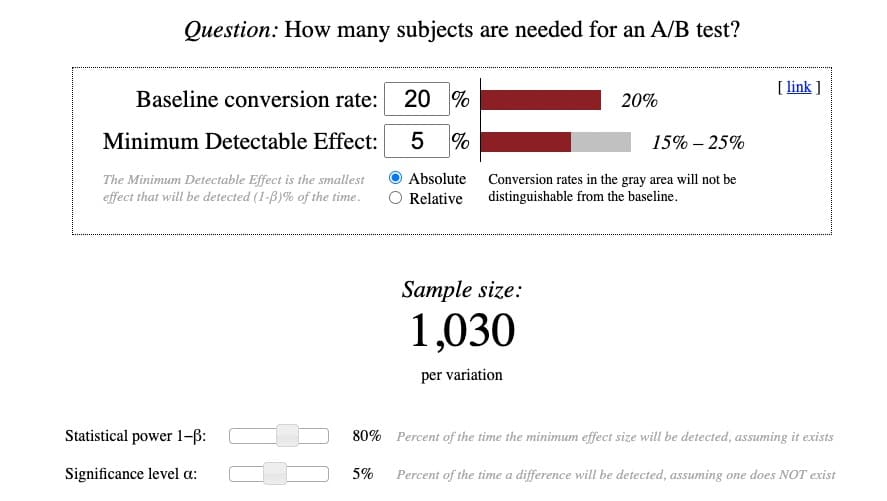

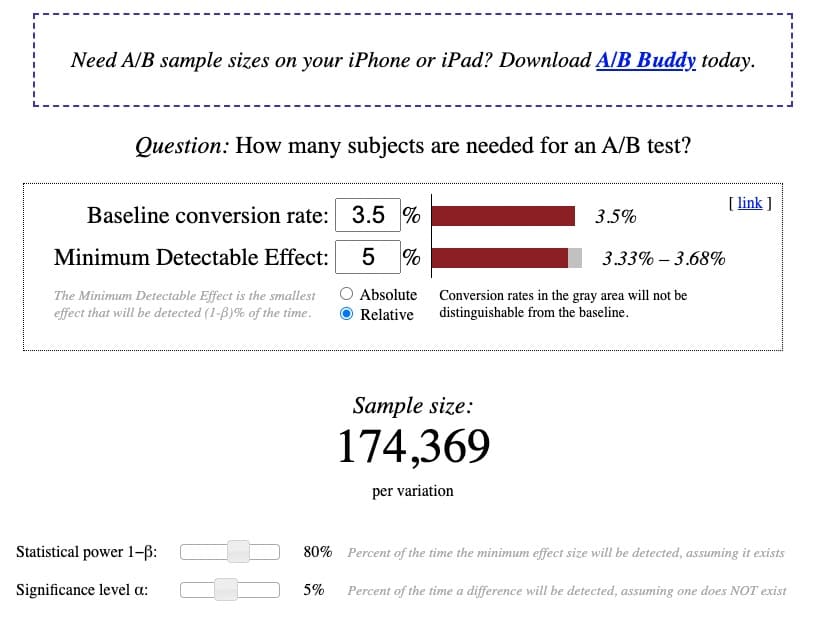

Мне больше всего нравится метод Эвана Миллера, потому что он гибкий и тщательный. Кроме того, если вы понимаете, как им пользоваться, вы сможете понять практически любой существующий калькулятор.

Вот как выглядит калькулятор Эвана Миллера:

Хотя сами расчеты довольно просты, понять терминологию, стоящую за ними, непросто. Итак, я попытался прояснить комплекс:

Базовый коэффициент конверсии

Базовый коэффициент конверсии — это существующий коэффициент конверсии контрольной или исходной версии. Обычно при настройке A/B-теста он помечается как «версия A».

Вы должны быть в состоянии найти этот коэффициент конверсии в своей аналитической платформе.

Если вы никогда не проводили A/B-тестирование или не знаете базовый коэффициент конверсии, сделайте наиболее обоснованное предположение.

Средний коэффициент конверсии для большинства сайтов, отраслевых вертикалей и типов устройств составляет от 2 до 5%. Итак, если вы действительно не уверены в своем базовом коэффициенте конверсии, проявите осторожность и начните с 2% базового уровня.

Чем ниже базовый коэффициент конверсии, тем больший размер выборки вам потребуется. Наоборот.

Минимальный обнаруживаемый эффект (MDE)

Минимальный обнаруживаемый эффект (MDE) звучит как сложная концепция. Но его становится намного легче понять, если разбить термин на три части:

- Минимум = наименьший

- Обнаруживаемый = хотите, чтобы вы пытались обнаружить или найти, запустив эксперимент

- Эффект = разница конверсии между контролем и лечением

Таким образом, минимальный обнаруживаемый эффект — это наименьший прирост конверсии, который вы надеетесь обнаружить, запустив тест.

Некоторые сторонники чистоты данных будут утверждать, что это определение на самом деле описывает минимальный эффект интереса (MEI). Как бы вы ни называли это, цель состоит в том, чтобы предвидеть, насколько большой прирост конверсии вы ожидаете получить, запустив тест.

Хотя это упражнение может показаться очень спекулятивным, вы можете использовать калькулятор размера выборки, подобный этому, или статистический калькулятор A/B-тестирования Convert для расчета ожидаемого MDE.

Как правило, приемлемым считается MDE 2-5%. Все, что намного выше, обычно нереально при выполнении теста с действительно хорошим питанием.

Чем меньше MDE, тем больше требуется размер выборки. Наоборот.

MDE может быть выражен как абсолютное или относительное количество.

Абсолют

Абсолютный MDE — это необработанная разница между коэффициентом конверсии контроля и варианта.

Например, если базовый коэффициент конверсии составляет 2,77%, и вы ожидаете, что вариант достигнет абсолютного MDE +3%, абсолютная разница составит 5,77%.

Родственник

Напротив, относительный эффект выражает процентную разницу между вариантами.

Например, если базовый коэффициент конверсии составляет 2,77 %, и вы ожидаете, что вариант достигнет относительного MDE +3 %, относительная разница составит 2,89 %.

Как правило, большинство экспериментаторов используют относительное процентное увеличение, поэтому, как правило, лучше всего представлять результаты таким образом.

Статистическая мощность 1−β

Мощность относится к вероятности обнаружения эффекта или разницы в конверсии, если предположить, что он действительно существует.

При тестировании ваша цель состоит в том, чтобы убедиться, что у вас достаточно мощности для значимого обнаружения различий, если они существуют, без ошибок. Поэтому более высокая мощность всегда лучше. Но компромисс в том, что для этого требуется больший размер выборки.

Степень 0,80 считается стандартной передовой практикой. Таким образом, вы можете оставить его в качестве диапазона по умолчанию на этом калькуляторе.

Это количество означает, что с вероятностью 80%, если есть эффект, вы точно обнаружите его без ошибок. Таким образом, есть только 20% шанс, что вы пропустите правильное обнаружение эффекта. Риск, на который стоит пойти.

Уровень значимости α

В очень простом определении альфа-уровень значимости — это частота ложных срабатываний или процент времени, в течение которого будет обнаружена разница в конверсии, даже если ее на самом деле не существует.

В соответствии с передовой практикой A/B-тестирования ваш уровень значимости должен быть 5% или ниже. Так что вы можете просто оставить его по умолчанию на этом калькуляторе.

Уровень значимости α, равный 5 %, означает, что вы с вероятностью 5 % обнаружите разницу между контролем и вариантом, когда разницы на самом деле не существует.

Опять же, риск оправдан.

Оценка требований к размеру выборки

С этими числами, подключенными к вашему калькулятору, вы теперь можете убедиться, что на вашем сайте достаточно трафика для запуска теста с надлежащим питанием в течение стандартного периода времени от 2 до 6 недель.

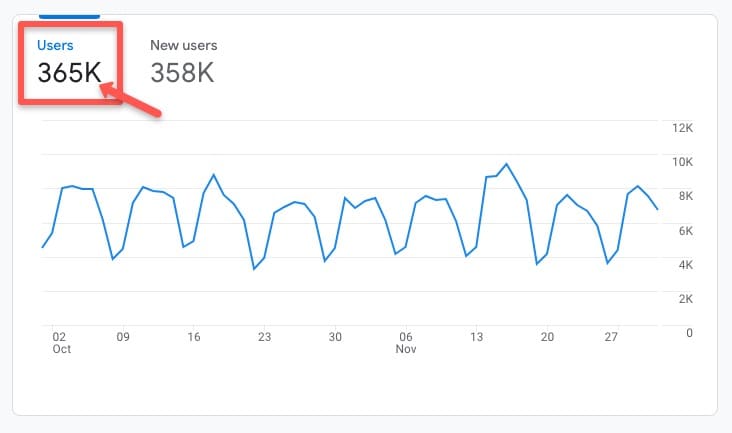

Чтобы проверить это, зайдите на предпочитаемую вами аналитическую платформу и посмотрите на исторический средний уровень трафика сайта или страницы, которую вы хотите протестировать, за конечный период времени.

Например, в этой учетной записи Google Analytics 4 (GA4), перейдя на вкладку « Жизненный цикл» > «Приобретение» > «Обзор приобретения », вы можете увидеть, что за последний исторический период времени с октября по ноябрь 2022 года было 365 тысяч пользователей:

Основываясь на существующем базовом коэффициенте конверсии 3,5 %, относительном MDE 5 %, при стандартной мощности 80 % и стандартном уровне значимости 5 %, калькулятор показывает, что размер выборки составляет 174 369 посетителей на вариант, необходимый для правильного проведения анализа. A/B-тест с питанием:

Предполагая, что тенденции трафика останутся относительно стабильными в ближайшие месяцы, разумно ожидать, что сайт наберет около 365 тысяч пользователей или (365 тысяч/2 варианта) 182 тысячи посетителей на вариант в разумные сроки тестирования.

Требования к размеру выборки достижимы, что дает зеленый свет для проведения теста.

Важное примечание: это упражнение по проверке требований к размеру выборки всегда должно выполняться ДО проведения любого исследования, чтобы вы знали, достаточно ли у вас трафика для запуска теста с правильной мощностью.

Кроме того, при выполнении теста НИКОГДА не следует останавливать его до того, как будут достигнуты предварительно рассчитанные требования к размеру выборки, даже если результаты появятся значительно раньше.

Преждевременное объявление победителя или проигравшего до выполнения требований к размеру выборки — это то, что известно как «подглядывание» и является опасной практикой тестирования, которая может привести к тому, что вы сделаете неверные вызовы до того, как результаты будут полностью сброшены.

Сколько тестов вы можете запустить, если у вас достаточно трафика?

Предполагая, что сайт или страницы, которые вы хотите протестировать, соответствуют требованиям к размеру выборки, сколько тестов вы можете запустить?

Ответ, опять же, это зависит.

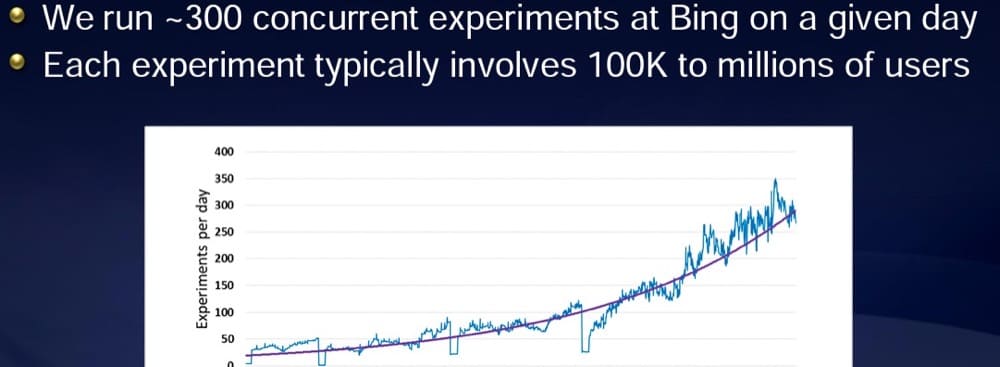

Согласно презентации Ронни Кохави, бывшего вице-президента Microsoft по экспериментам Bing, Microsoft обычно проводит более 300 экспериментов в день.

Но у них есть трафик, чтобы сделать это.

В каждом эксперименте участвует более 100 тысяч пользователей:

Чем больше ваш доступный трафик, тем больше тестов вы можете запустить.

В любом тесте вы должны убедиться, что у вас достаточно большой размер выборки для проведения эксперимента с правильной мощностью.

Если вы небольшая организация с более ограниченным трафиком, рассмотрите возможность проведения меньшего количества тестов более высокого качества.

В конце концов, дело не в том, сколько тестов вы проводите, а в результате ваших экспериментов.

Варианты, если вы не можете выполнить требования к размеру выборки

Если вы обнаружите, что не можете выполнить требования к размеру выборки, не расстраивайтесь. Эксперименты не для вас. У вас есть несколько возможных вариантов экспериментов:

- Сосредоточьтесь на привлечении трафика

Даже крупные сайты могут иметь низкий трафик на определенных страницах.

Если вы обнаружите, что трафик сайта или трафик на определенных страницах не соответствует требованиям к размеру выборки, подумайте о том, чтобы сосредоточить усилия на привлечении большего трафика.

Для этого вы можете применить агрессивную тактику поисковой оптимизации (SEO), чтобы занять более высокое место в поисковых системах и получить больше кликов.

Вы также можете получать платный трафик через такие каналы, как Google Ads, реклама LinkedIn или даже рекламные баннеры.

Оба этих действия по привлечению могут помочь увеличить веб-трафик и дать вам больше возможностей проверить, что лучше всего конвертируется с пользователями.

Однако если вы используете платный трафик для соответствия требованиям к размеру выборки, рассмотрите возможность сегментации результатов тестирования по типу трафика, поскольку поведение посетителей может различаться в зависимости от источника трафика.

- Оцените, является ли A/B-тестирование лучшим методом экспериментов для вас.

Хотя A/B-тестирование считается золотым стандартом экспериментов, результаты хороши настолько, насколько хороши данные, лежащие в их основе.

Если вы обнаружите, что у вас недостаточно трафика для запуска полноценного теста, вы можете подумать, действительно ли A/B-тестирование является лучшим вариантом эксперимента для вас.

Существуют и другие подходы, основанные на исследованиях, которые требуют гораздо меньших выборок и все же могут дать невероятно ценные сведения об оптимизации.

Тестирование пользовательского опыта (UX), опросы потребителей, экзит-поллы или интервью с клиентами — вот несколько других методов экспериментов, которые вы можете попробовать в качестве альтернативы A/B-тестированию.

- Реализовать результаты могут предоставлять только направленные данные

Но если вы по-прежнему намерены проводить A/B-тестирование, вы все равно можете запускать тесты.

Просто имейте в виду, что результаты могут быть не совсем точными и будут предоставлять только «направленные данные», указывающие на вероятный, а не полностью заслуживающий доверия результат.

Поскольку результаты могут быть не совсем верными, вам следует внимательно следить за эффектом конверсии с течением времени.

Тем не менее, часто более важными, чем точные цифры конверсии, являются цифры на банковском счете. Если они растут, вы знаете, что работа по оптимизации работает.

Тестирование зрелости

Помимо требований к размеру выборки, еще одним фактором, влияющим на частоту тестирования, является уровень зрелости тестирующей организации.

Тестирование зрелости — это термин, используемый для описания того, насколько укоренилось экспериментирование в организационной культуре и насколько передовыми являются методы экспериментирования.

В таких организациях, как Amazon, Google, Bing и Booking, которые проводят тысячи тестов в месяц, есть прогрессивные и зрелые команды тестировщиков.

Это не случайно.

Частота тестирования, как правило, тесно связана с уровнем зрелости организации.

Если экспериментирование укоренилось в организации, руководство стремится к нему. Кроме того, сотрудников во всей организации обычно поощряют поддерживать эксперименты и расставлять приоритеты, и они могут даже помогать предлагать идеи для тестирования.

Когда эти факторы объединяются, гораздо проще запустить целесообразную программу тестирования.

Если вы надеетесь ускорить тестирование, может быть полезно сначала взглянуть на уровень зрелости вашей организации.

Начните с оценки таких вопросов, как

- Насколько важны эксперименты для топ-менеджеров?

- Какие ресурсы предоставляются для стимулирования экспериментов?

- Какие каналы связи доступны для сообщения обновлений тестирования?

Если ответ «нет» или близок к этому, подумайте о том, чтобы сначала поработать над созданием культуры тестирования.

По мере того, как ваша организация примет более прогрессивную культуру экспериментирования, естественно, будет легче наращивать темпы тестирования.

Чтобы узнать, как создать культуру экспериментирования, ознакомьтесь с такими ресурсами, как эта статья и эта.

Ограничения в ресурсах

Предполагая, что у вас уже есть определенная организационная поддержка, следующая проблема, с которой нужно бороться, — это нехватка ресурсов.

Время, деньги и человеческая сила — все это ограничения, которые могут ограничить вашу способность к тестированию. И тестировать быстро.

Чтобы преодолеть ограничения ресурсов, может быть полезно начать с оценки сложности теста.

Сбалансируйте простые и сложные тесты

Как экспериментатор, вы можете запускать тесты, которые варьируются от очень простых до безумно сложных.

Простые тесты могут включать оптимизацию таких элементов, как текст или цвет, обновление изображений или перемещение отдельных элементов на странице.

Сложные тесты могут включать изменение нескольких элементов, изменение структуры страницы или обновление воронки конверсии. Эти виды тестов часто требуют глубокой работы по кодированию.

Запустив тысячи A/B-тестов, я обнаружил, что полезно иметь смесь из примерно ⅗ более простых и ⅖ более сложных тестов, которые выполняются одновременно все время.

Более простые тесты могут дать вам быстрые и легкие победы.

Но более масштабные тесты с более масштабными изменениями часто дают больший эффект. Фактически, согласно некоторым исследованиям по оптимизации, чем больше и более сложные тесты вы выполняете, тем больше вероятность вашего успеха. Так что не бойтесь часто запускать большие свинг-тесты.

Просто имейте в виду, что взамен вы потратите больше ресурсов на разработку и создание теста. И нет никакой гарантии, что он выиграет.

Тест на основе доступных человеческих ресурсов

Если вы CRO-стратег в одиночку или работаете с небольшой командой, ваши возможности ограничены. Будь то простые или сложные, вы можете найти 2-5 тестов в месяц.

Напротив, если вы работаете в организации, в которой есть специальная команда исследователей, стратегов, дизайнеров, разработчиков и специалистов по контролю качества, вы, вероятно, сможете проводить от десятков до сотен тестов в месяц.

Чтобы определить, сколько тестов вы должны выполнить, оцените доступность ваших человеческих ресурсов.

В среднем простой тест может занять от 3 до 6 часов, чтобы придумать идею, создать макет, спроектировать, разработать, внедрить, обеспечить контроль качества и отслеживать результаты.

С другой стороны, очень сложный тест может занять более 15-20 часов.

В месяце около 730 часов, так что вам нужно быть очень расчетливым в отношении тестов и количества тестов, которые вы выполняете в течение этого драгоценного времени.

Планируйте и расставляйте приоритеты для своих тестовых идей

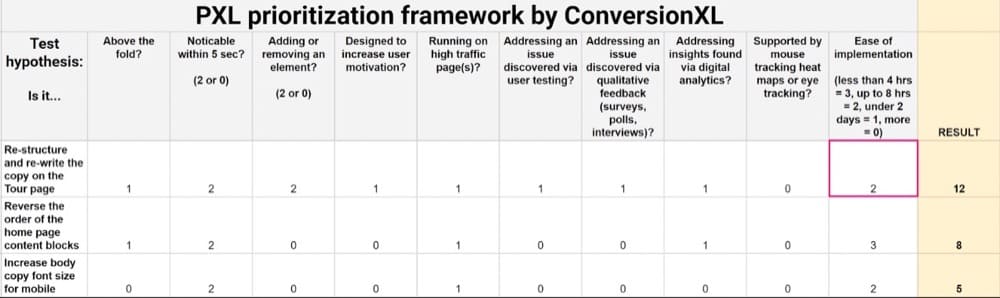

Чтобы помочь вам наметить оптимальную структуру тестирования, рассмотрите возможность использования системы определения приоритетов тестирования, такой как PIE, ICE или PXL.

Эти фреймворки предоставляют количественный метод для ранжирования ваших лучших идей тестирования, оценки простоты реализации и оценки того, какие тесты с наибольшей вероятностью повысят конверсию.

После проведения этой оценки ваш приоритетный список тестовых идей будет выглядеть примерно так:

После ранжирования лучших идей тестирования рекомендуется также создать дорожную карту тестирования, чтобы визуально спланировать график тестирования и следующие шаги.

Ваша дорожная карта может выглядеть примерно так:

Он должен включать:

- Список идей, которые вы планируете протестировать, постранично.

- Сколько времени, по вашему мнению, займет каждый этап тестирования (дизайн, разработка, контроль качества и т. д.).

- Как долго вы планируете выполнять каждый тест, исходя из предварительно рассчитанных требований к размеру выборки. Вы можете рассчитать требования к продолжительности теста с помощью калькулятора продолжительности теста, подобного этому.

Наметив свои идеи для тестирования, вы сможете более точно определить частоту и емкость тестирования.

По мере того, как вы заполняете свою дорожную карту тестирования, может стать совершенно ясно, что количество тестов, которые вы можете запустить, зависит от имеющихся у вас ресурсов.

Стоит ли запускать несколько тестов одновременно?

Но только потому, что вы можете что-то сделать, не всегда означает, что вы должны это делать.

Когда дело доходит до одновременного запуска нескольких тестов, ведутся большие споры о наилучшем подходе.

Статьи, подобные этой, лидера Experiment Nation Роммила Сантьяго поднимают спорный вопрос: можно ли одновременно запускать несколько A/B-тестов?

Некоторые экспериментаторы скажут, что ни в коем случае!

Они будут утверждать, что вы должны запускать только один тест, по одной странице за раз. В противном случае вы не сможете должным образом изолировать какой-либо эффект.

Раньше я был в этом лагере, потому что так меня учили почти десять лет назад.

Мне было строго сообщено, что вы должны запускать только один тест, с одним изменением, на одной странице, в одно время. Я действовал с таким настроем много лет — к большому разочарованию встревоженных клиентов, которые хотели получить больше результатов быстрее.

Однако эта статья Тимоти Чана, бывшего специалиста по данным в Facebook, а ныне ведущего специалиста по данным в Statsig, полностью изменила мое мнение.

В своей статье Чан утверждает, что интерактивные эффекты сильно переоценены.

На самом деле одновременный запуск нескольких тестов не только не проблема; это действительно единственный способ проверить!

Эта позиция подтверждается данными за время его работы в Facebook, где Чан видел, как гигант социальных сетей успешно проводил сотни экспериментов одновременно, многие из них даже на одной странице.

Эксперты по данным, такие как Ронни Кохави и Хазьер Пурхалхали, согласны с тем, что эффекты взаимодействия маловероятны. И на самом деле, лучший способ проверки на успех — запускать несколько тестов несколько раз на постоянной основе.

Таким образом, при рассмотрении частоты тестирования не беспокойтесь о взаимных эффектах перекрывающихся тестов. Тестируйте свободно.

Резюме

В A/B-тестировании не существует оптимального количества A/B-тестов, которые вы должны выполнить.

Идеальное число — это то, что подходит для вашей уникальной ситуации.

Это число основано на нескольких факторах, включая ограничения размера выборки вашего сайта, сложность тестирования идей, а также доступную поддержку и ресурсы.

В конце концов, дело не столько в количестве проведенных тестов, сколько в качестве тестов и полученных результатах. Один тест, который дает большой подъем, гораздо более ценен, чем несколько безрезультатных тестов, которые не двигают стрелку.

Тестирование действительно важнее количества!

Чтобы узнать больше о том, как извлечь максимальную пользу из программы A/B-тестирования, ознакомьтесь с этой статьей Convert.