Как справиться с SEO-миграцией сайта

Опубликовано: 2017-10-13В жизненном цикле веб-сайта этапы SEO-миграции веб-сайта являются важными моментами, во время которых вы должны обращать внимание на многие детали, чтобы не оказывать негативного влияния на SEO.

Каждая миграция сайта отличается. Миграция не означает мгновенных результатов, но это идеальное время для улучшения вашего SEO. Нужно понимать, что когда сайт развивается, поисковые системы не всегда находятся в одном и том же времени и что у него будет более или менее важное время адаптации. Тем не менее, это самое подходящее время для веб-сайта, чтобы улучшить техническое качество, обогащать код с помощью HTML5 и json-ld, разделять благодаря архитектуре внутренних ссылок, редакционному богатству и возвращать сильные сигналы SEO для поисковых систем.

Существует несколько типов миграции сайта в зависимости от происходящих изменений, обычно включающих один или несколько из следующих элементов:

- Хостинг / IP-адрес

- Доменное имя

- структура URL

- Архитектура сайта

- Содержание

- Концепт дизайна

Миграция самых сложных сайтов предполагает изменение большинства (или всего) вышеперечисленного.

Если редизайн SEO организован правильно, будет один до и один после миграции. Потратьте время, чтобы понять болевые точки сайта и поработать над их исправлением. Повысьте производительность, упростите сканирование. Вы будете победителем в долгосрочной перспективе.

В этой статье мы познакомим вас с лучшими практиками безопасного SEO-миграции веб-сайта.

Ключевые шаги, действия и документы SEO-миграции веб-сайта

Контролируемая миграция — это хорошо подготовленная миграция. Таким образом, вы будете эффективны, если выполните ряд структурирующих шагов. Эти шаги также позволят вам накопить набор документов и данных, на которые вы можете положиться в течение всего цикла миграции, а затем оценить положительное (или отрицательное) влияние миграции.

Вот таблица, в которой перечислены действия и документы миграции в соответствии с целями:

| ЦЕЛИ | ДЕЙСТВИЯ | ДОКУМЕНТЫ |

| Изображение веб-сайта | – Предварительные данные журнала сервера CrawlAggregate. | Отчеты о сканировании Технические файлы (robots.txt, карты сайта, старые файлы перенаправления) Таблица просканированных/непросканированных URL-адресов, потерянных страниц и частоты сканирования в день для каждого |

| Компилировать, агрегировать и хранить данные из внешних инструментов | – Чтение данныхGoogle Analytics, Omniture, AT Internet, Search Consoles (Bing/Google), SemRush, MyPoseo, Majestic, SEObserver,… | Экспорт позиций, кликабельности и показов по выражениям/нишам Экспорт аналитических данных Экспорт обратных ссылок, TF/CF, ниша, Экспорт ключевых слов из ниш Поиск по ключевой фразе Пересечение данных |

| Определение областей для улучшения | – Аудит и анализ данных | Список задач |

| Предметный приоритет | – Оценка достижений/усилий | Матрица ROI |

| Характеристики | – Оценка достижений/усилий | Выражение требования с приложением для оптимизированных для SEO кодов |

| Производство | - Разработка – Внедрение знаний | Командное обсуждение критических моментов Код качества |

| Проверка модификаций | – Технический рецепт – Проверка кодаГарантия кода | Отчет о сравнительном сканировании Ежедневная коррекция Отчет Валидация тестов, которые будут сыграны в день D |

| Жить | – Развертывание нового кода и файлов (карты сайта, robots.txt, перенаправления) – Проверка целостности нового сайта - Объявление новых карт сайта – Принудительно сканировать поисковую систему с помощью Search Console. | Передача нового кода в производство Обеспечьте наличие актуальных XML-файлов карты сайта. Проверка роботов. текстовая оптимизация Файл перенаправления, если применимо Иметь ожидаемый и стабильный код в рабочей среде |

| Живой мониторинг | - ползать по ползанию – Сканирование перенаправленных URL-адресов | Назад к сравнению данных Отчет о разработке KPI |

Сбор и анализ данных перед миграцией

Предварительное сканирование

Понимание проблем сайта необходимо для подготовки спецификаций и ключевых показателей эффективности мониторинга миграции. Для того, чтобы лучше узнать сайт и определить области для улучшения, мы предлагаем вам сделать полную фотографию сайта перед миграцией.

Для этого запустите обход по тем же принципам, что и Google: с учетом роботов. txt, за которым следуют ссылки со строкой запроса. Если ваша миграция включает несколько поддоменов, OnCrawl позволяет вам обнаруживать и сканировать поддомены.

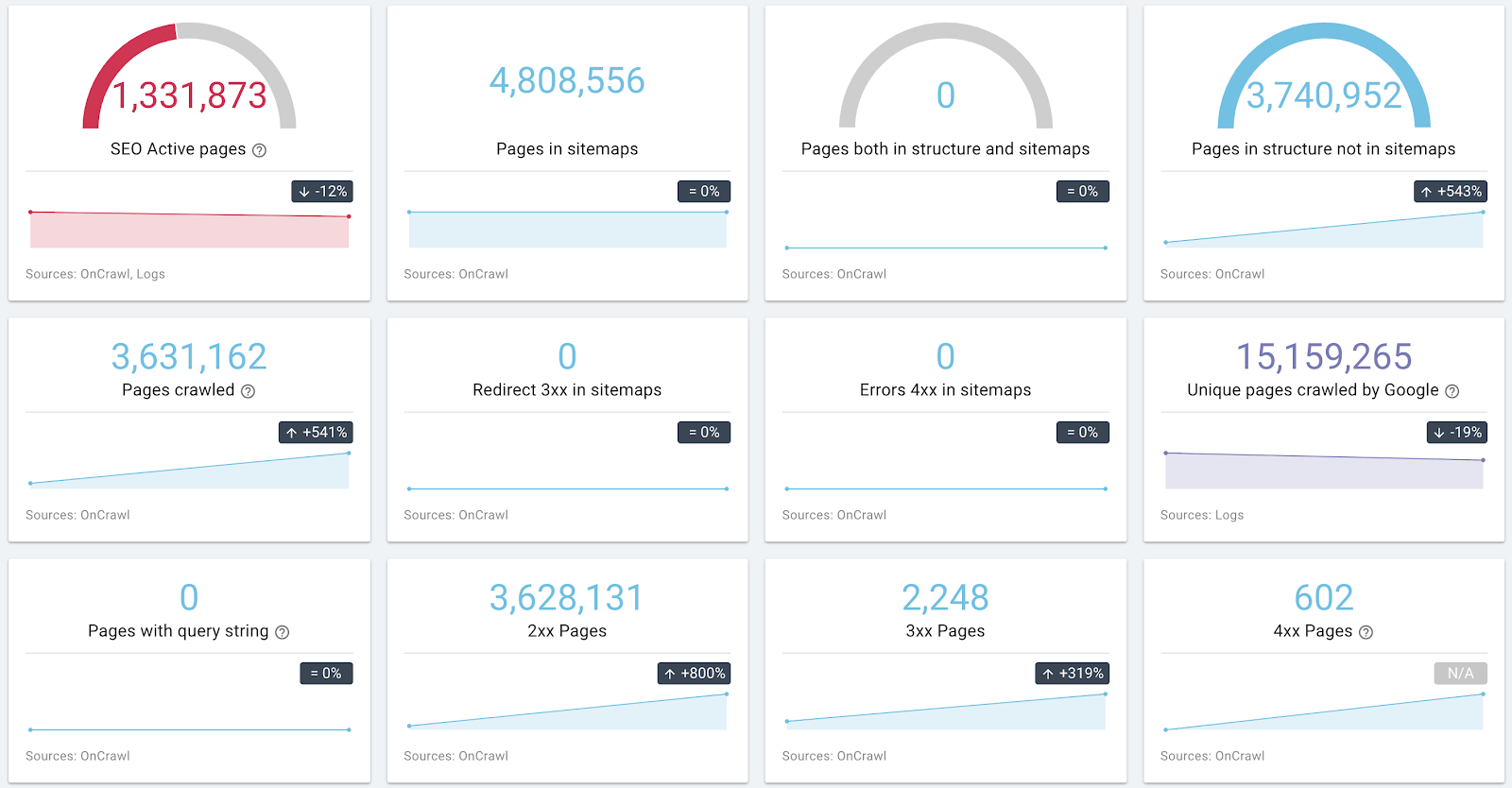

Пример информации об архитектуре и состоянии сайта

Если у вас есть возможность собирать данные журнала, сделайте это для каждого URL. Перекрестные данные сканирования/журналов можно использовать для определения факторов успеха для набора страниц.

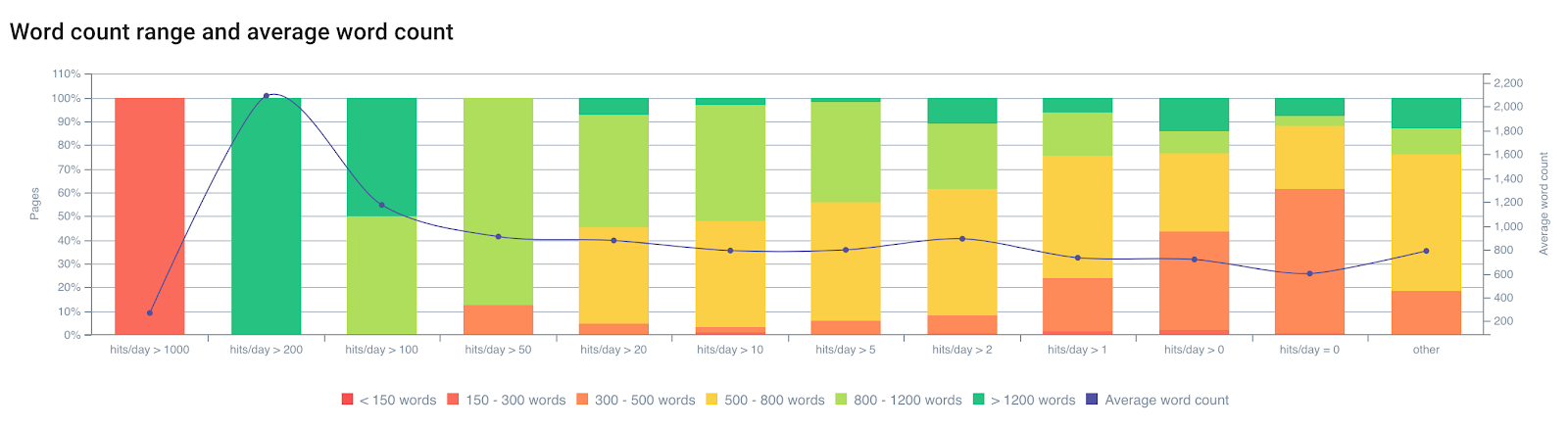

Просмотр количества обращений бота/день по количеству слов

По опыту мы знаем, что на сканирование Google влияют несколько факторов на странице. Google не просматривает все страницы с одинаковой частотой. Его индекс не обновляется для этих страниц, поэтому он будет стремиться понизить их рейтинг. Устаревшая страница в индексе уже не обязательно является «лучшим ответом» на запрос пользователя. Существует тесная связь между частотой сканирования, обновлением индекса и ранжированием.

Страница будет меньше сканироваться, если:

- Это слишком глубоко в архитектуре;

- Он не содержит достаточного количества одного текста;

- Не хватает внутренних ссылок (в том числе и внешних);

- Он недостаточно быстро загружается или слишком тяжелый;

- … и т.д.

Чтобы узнать больше о влиянии факторов на странице на сканирование Google, вы можете прочитать статью «Страница важности Google», которая позволит вам узнать больше о патентах Google, связанных с «Планированием сканирования».

Предварительное сканирование позволяет узнать ваш сайт. Это также позволит вам классифицировать страницы, которые будут страницами проверки оптимизации. Ваш предварительный анализ должен будет принять во внимание эти данные, чтобы скорректировать факторы, негативно влияющие на сканирование.

Чтение данных из внешних инструментов

Консоль поиска Google / Консоль поиска Bing / Консоль поиска Bing

В поисковой консоли Google и Bing вы найдете как качественные, так и количественные данные. Сбор этих данных для отслеживания улучшений является хорошей практикой.

Мы приглашаем вас еще раз перепроверить эти данные, чтобы понять, каковы общие черты страниц, которые позиционируют себя, отсутствующие ключевые слова или проблемы, связанные с ошибками мобильных устройств/AMP или SEO.

Важные данные для хранения: количество и типы ошибок, краулинговый бюджет (количество обращений в день) и время загрузки, улучшение HTML, количество проиндексированных страниц, позиция/CTR/показы по выражениям и URL-адресам.

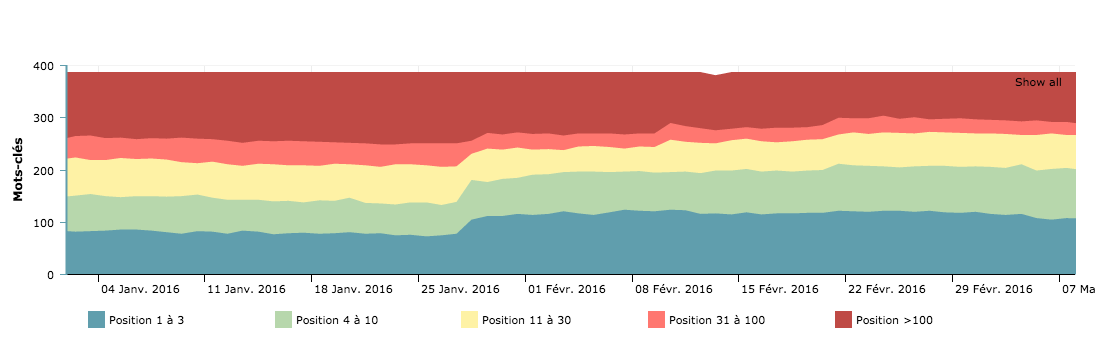

Просмотренные страницы по дням — кривая бюджета сканирования для сравнения до и после миграции.

Эти представления поисковых систем позволяют понять, как они интерпретируют ваш сайт. Он также является основой для мониторинга KPI после миграции. Важно учитывать ошибки SEO, о которых сообщают поисковые системы, чтобы исправить их в первую очередь.

Рейтинг и видимость

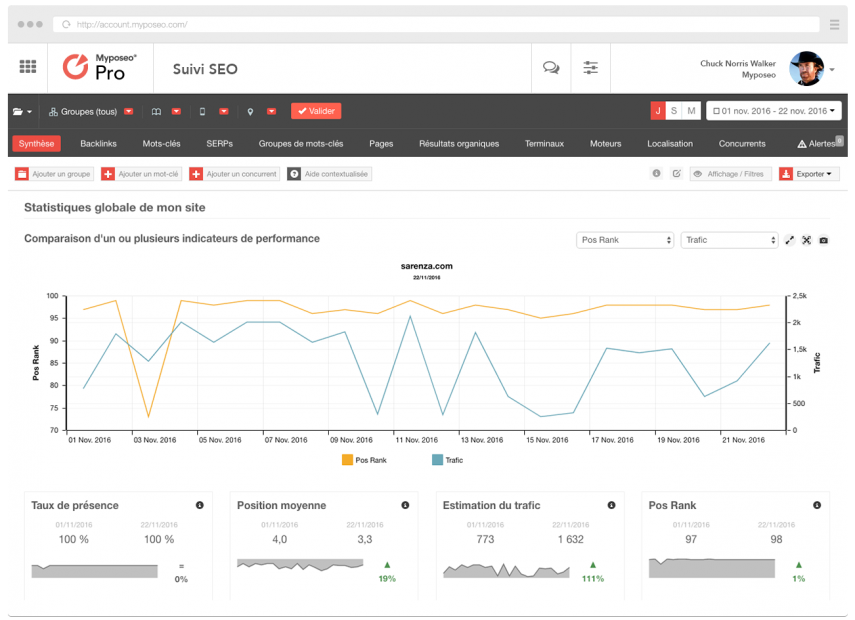

Инструменты отслеживания позиционирования, такие как MyPoseo, упрощают изучение видимости сайта и ключевых слов.

В дополнение к данным Google Search Console вам необходимо знать уровень видимости в вашей нише. Эти данные будут необходимы для анализа после миграции.

Аналитика

Решения для отслеживания и аналитики можно использовать для сбора данных об использовании ваших пользователей. Они также являются источником информации о производительности ваших страниц с точки зрения органических посещений, показателя отказов, конверсионных туннелей, маршрутов и привлекательности сайта. Вам необходимо экспортировать данные, которые позволят вам определить области для улучшения и сохранить их для анализа в реальном времени.

Экспорт всех URL-адресов, которые получили хотя бы одно посещение за последние 12 месяцев с помощью Google Analytics, — это один из способов получить большое количество ценных проиндексированных страниц.

Классифицируйте целевые страницы для определения приоритетов ваших действий, не пропускайте непросмотренные страницы и еще раз попытайтесь определить факторы производительности, чтобы вдохновить вас на свои рекомендации.

Сегментация

После предварительного сканирования и записи внешних данных у вас будет полное представление о периметре миграции. На основе анализа вы можете создавать наборы страниц, которые можно сгруппировать по разным показателям, чтобы квалифицировать миграцию.

С помощью OnCrawl можно создать 10 наборов или набор из 15 групп страниц. Почему бы не использовать эту функцию для создания наборов миграции?

Создайте классификацию по каждой из областей для улучшения. OnCrawl позволяет создавать группы на основе более чем 350 метрик — плохие, тяжелые, дублированные, не посещаемые роботами, мало посещаемые пользователями, со слишком малым количеством входящих ссылок или слишком глубокие, например. Они позволят вам апостериорно подтвердить редизайн.

Совет для профессионалов: вы можете сгруппировать все страницы, которые отвечают более чем за 1 секунду, страницы с плохой скоростью сканирования и пересечением данных ранжирования и поведения людей — CTR в GSC или показатель отказов в аналитике. Вы сможете принимать правильные решения.

Перекрестная проверка данных сканирования, журналов и аналитики — лучший способ выполнить полный и реалистичный анализ вашей миграции.

Страницы для редактирования, создания, удаления

Благодаря собранным данным вы сможете определить страницы с наибольшим количеством посещений, страницы с наиболее важными коэффициентами дублирования контента, отсутствующие страницы в вашей архитектуре и т. д.

Вы должны иметь в виду, что реструктуризация, в дополнение к исправлению наиболее серьезных проблем SEO и соответствия требованиям SEO, также должна позволить вашему сайту обогатиться и перестроиться вокруг ключевых предложений пользователей движка. Они ищут своими словами данные, присутствующие на ваших страницах. Работа по исследованию и семантической корректировке — это задача, которой часто пренебрегают, но она обеспечивает наилучшие результаты с точки зрения ранжирования.

Необходимо добавить новый хаб и целевые страницы, чтобы они наилучшим образом соответствовали потребностям пользователей. Они должны быть согласованы с запросами, по которым сайт наименее удачно позиционируется.

[Пример успеха] Не позволяйте редизайну наносить ущерб SEO

Управление внутренними ссылками

Внутренние ссылки сейчас более чем когда-либо являются одним из ключевых факторов успешной реструктуризации SEO. Вариация анкоров, оптимизация внутреннего распространения популярности и семантическое выравнивание анкоров — мощные союзники.

Представление оптимизированной внутренней перелинковки с OnCrawl

Потратьте время, чтобы понять, как популярность ваших страниц распределяется по различным блокам ссылок. Постарайтесь максимально сократить количество нерелевантных ссылок на своих страницах. Лучший пример — мегаменю.

Избегайте делать ссылки на все страницы со всех страниц; это контрпродуктивно. Удалите из HTML-кода ссылки, которые не относятся к одному и тому же бункеру, сохранив при этом ссылки на заголовки категорий.

Навигация также является ловушкой для роботов. Попробуйте создать ярлыки между страницами, используя алгоритм, позволяющий переходить к ближайшим единицам, десяткам, сотням.

Старайтесь максимально варьировать анкоры, указывающие на страницы. Это позволяет вам показать механизмам, что вы используете широкое семантическое поле, и способствует оценке важности страницы и, следовательно, сканированию страниц.

Также подумайте об уменьшении или сегментации ссылок в нижнем колонтитуле, чтобы избежать создания непривлекательных и очень популярных страниц. Ссылки CGU или подписки на новостную рассылку, а также исходящие ссылки с вашего домена — это столько же внутренних утечек PageRank. Также следите за ссылками на социальные сети, эти сайты часто больше, чем ваш, и они поглощают Page Rank вашего сайта.

перенаправление

Эта деятельность требует большого внимания, потому что что-то может пойти не так. Важно получить текущие правила перенаправления, чтобы затем можно было сопоставить их с новой древовидной структурой, если таковая имеется. Старые правила перенаправления необходимо обновить, чтобы избежать строк перенаправления.

Также необходимо проверить, чтобы все старые URL-адреса перенаправляли в 301 на новые.

Тестовое сканирование можно выполнить, экспортировав список всех старых URL-адресов и добавив их в начальные URL-адреса с максимальной глубиной 1.

В конкретном случае миграции HTTPS (с изменением структуры URL или без него) убедитесь, что все внутренние ссылки были обновлены (внутренние ссылки со страницы HTTPS на страницу HTTP отсутствуют). Для выполнения этой операции есть Custom Fields OnCrawl.

Совет для профессионалов: создайте страницы ярлыков для ваших страниц, которые будут ранжироваться (страницы продуктов благодаря страницам-хабам), улучшите время загрузки, увеличьте объем контента страниц, создайте карты сайта и исправьте страницы-сироты, канонические страницы, сократите дублированный контент…

Важно подчеркнуть, что страницы с высоким трафиком требуют особого внимания, но в SEO важен каждый URL.

Важно подчеркнуть, что страницы с высоким трафиком требуют особого внимания, но в SEO важен каждый URL.

Фаза рецепта

Этот важный этап миграции — это период, в течение которого вы должны следить за любой ошибкой в исходных кодах или в понимании выражений потребности.

Защита платформы разработки поисковой системы

Htpasswd — это рекомендуемое решение, позволяющее поисковым системам не видеть просканированные промежуточные URL-адреса. Этот метод также гарантирует, что вы не запустите блокирующий файл robots.txt или мета-роботов «запретить». Это случается чаще, чем кажется.

Совет для профессионалов: ваш сайт в разработке ДОЛЖЕН быть ISO, чтобы гарантировать код будущего сайта.

Проверяйте качество доставки каждого кода

На этом этапе вы должны убедиться, что сайт движется в правильном направлении, регулярно запуская сканирование на платформе рецептов. Мы рекомендуем вам создать Crawl Over Crawl, чтобы сравнить две версии вместе.

Не поленитесь проверить это:

- Перенос сока ссылок и внутренняя перелинковка;

- Эволюция глубины страницы;

- Ошибки 40x и ссылки на эти страницы;

- Ошибки 50x и ссылки на эти страницы;

- Качество заголовка, метаописания и тегов роботов;

- Качество исходного кода и дублирование элементов контента.

Убедитесь, что код соответствует требованиям W3C. Мы часто забываем об этом, но это одна из первых рекомендаций Google, чтобы семантические данные не содержали ошибок, чтобы исходные коды были на уровне амбиций и чтобы правила оптимизации применялись по всему периметру.

Совет : старые правила перенаправления необходимо обновить, чтобы перенаправления не указывали на новые перенаправления.

Нужно проверить, чтобы все старые урлы перенаправляли в 301 на новые. Тестовое сканирование можно выполнить, экспортировав список всех старых URL-адресов и добавив их в начальный URL-адрес с максимальной глубиной 1.

Карта сайта. XML-файлы

Когда код станет стабильным и все URL-адреса будут обнаружены тестовым поисковым роботом, вы можете экспортировать все URL-адреса сайта. Это позволяет вам создать файл sitemap.xml (или sitemap_index.xml).

Добавьте адреса в файл robots.txt и поместите их в корень сайта (как рекомендовано в спецификации карты сайта, доступной здесь).

Совет для профессионалов: создание карты сайта по большому разделу сайта позволит вам самостоятельно отслеживать индексацию каждой части сайта в Google Search Console.

Создайте файл карты сайта со всеми вашими старыми перенаправленными URL-адресами, чтобы заставить поисковые системы передавать каждый из них.

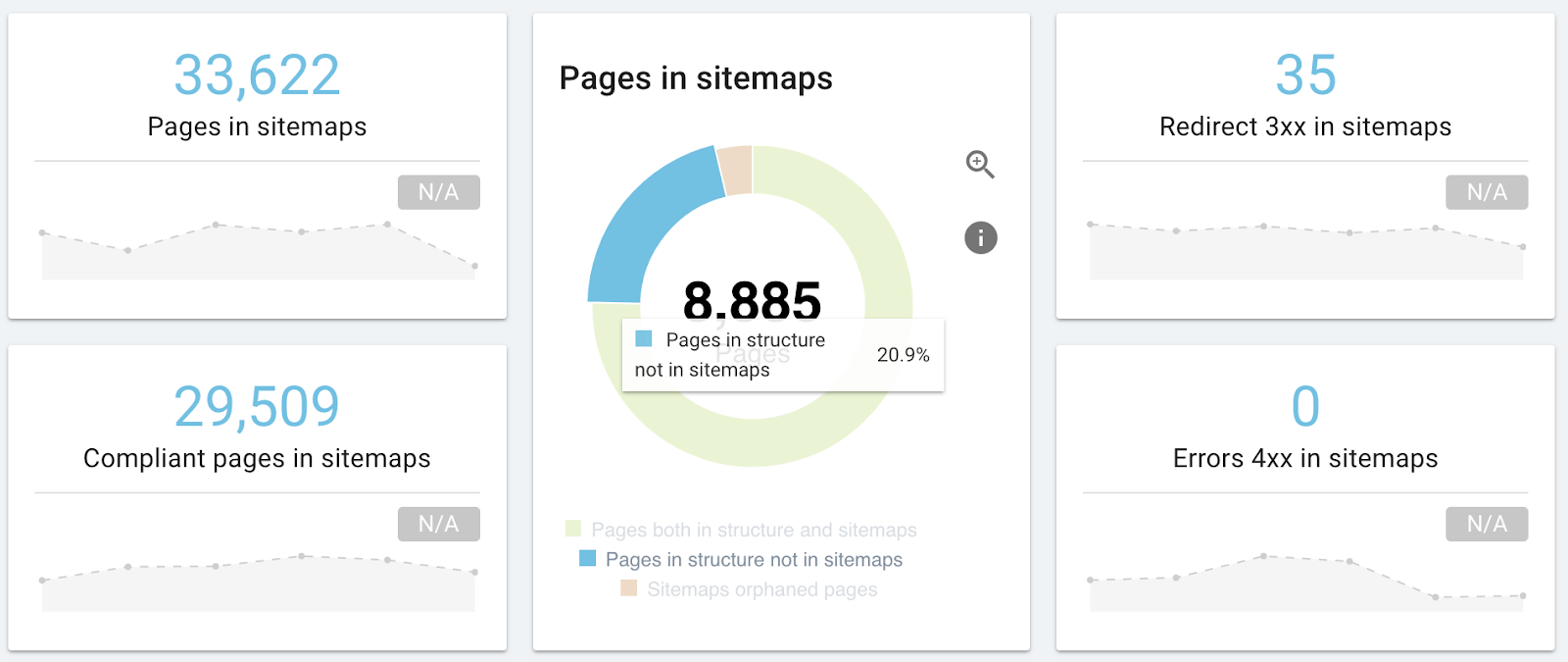

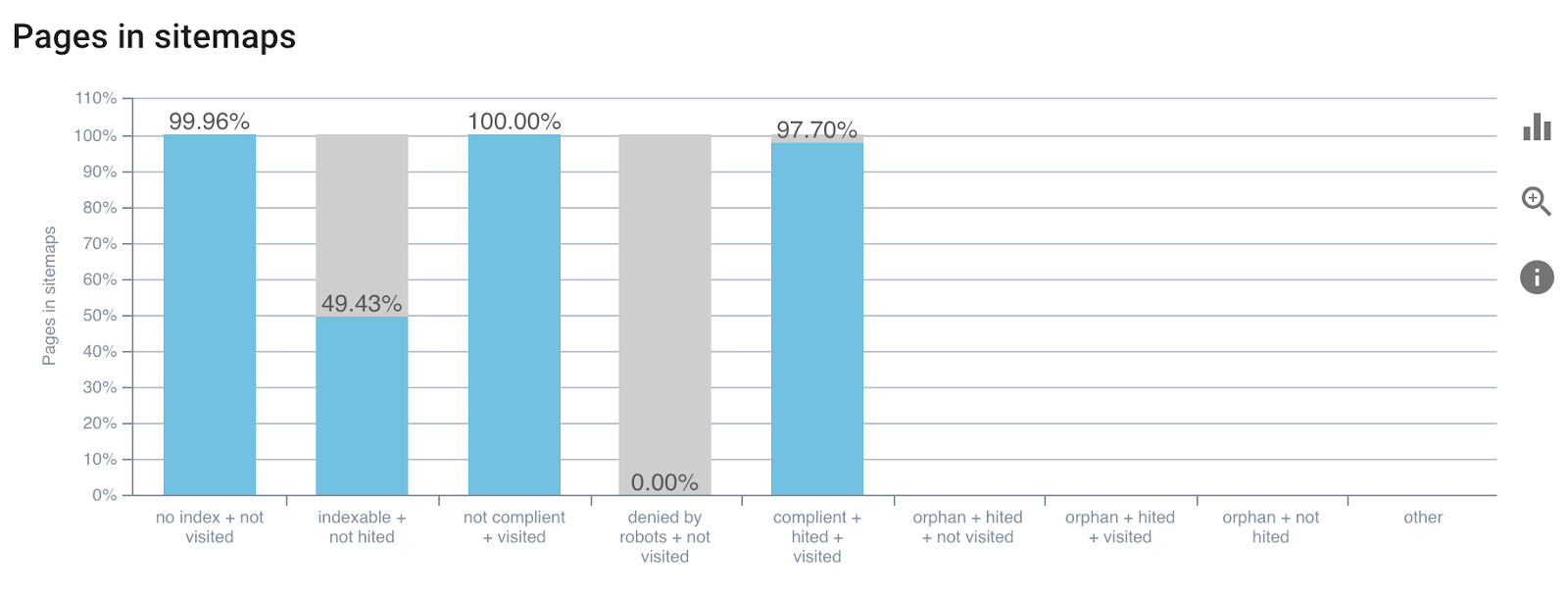

Последняя версия OnCrawl будет включать отчет, связанный с изучением файла sitemap.xml. Это позволит вам убедиться, что вы не пропустили URL-адреса, что ваши карты сайта не указывают на страницы, канонический URL-адрес которых отличается от URL-адреса, или что они указывают на 404.

Пример отчета об анализе карты сайта

Чтобы узнать больше о картах сайта. XML.

День перехода на живую версию

Рецепт завершен, и код подтвержден всеми игроками. Таким образом, у вас есть все сигналы зеленого цвета, чтобы передать новый код в прямом эфире. SEO не пострадает, потому что важные страницы заслуживают особого внимания. Однако вы также являетесь гарантом всех действий, совершаемых на стороне Google.

Вот список ваших задач как SEO-специалиста:

- Проверьте файл robots.txt;

- Проверить код онлайн;

- Проверьте карты сайта в Интернете;

- Проверить перенаправления;

Если все в порядке:

- Заставить мотор ползать

- Проверяйте журналы и коды состояния в реальном времени

Вы можете запускать специальные обходы для каждого шага, цель состоит в том, чтобы квалифицировать страницы, поэтому используйте обходы на более узких периметрах, чтобы увеличить скорость реакции.

Совет: определите сканирование с максимальной глубиной 1, чтобы проверить эталонные страницы ваших изменений, не тестируя весь сайт.

Живое продолжение

После онлайн-запуска вы должны иметь возможность сравнить SEO до и после и убедиться, что миграция оказала положительное влияние или минимально отрицательное.

Как только новый сайт будет запущен и запущен, необходимо отслеживать влияние любых изменений. В качестве первого шага еженедельно отслеживайте рейтинги и индексацию. Подсчитано, что вам придется подождать короткий месяц, чтобы сделать выводы, поэтому вы должны быть терпеливы.

Проверьте производительность сайта в Инструментах для веб-мастеров на наличие необычных аномалий после переноса.

Следите за показателями индексации и кеширования ваших страниц поисковыми системами, прежде чем проверять рейтинг.

Как мы уже говорили во введении, движкам потребуется некоторое время, чтобы адаптироваться к вашей новой версии, и в этот период позиции могут быть весьма нестабильными.

Запуск Crawl Over Crawl (Crawl Over Crawl Comparison) до и после миграции для сравнения ваших данных — лучший способ повысить эффективность.

Выводы

Миграция — важное и часто полезное время для SEO. OnCrawl будет сопровождать вас на этих этапах. От начального сканирования до отслеживания метрик проверки и анализа реакции поисковой системы благодаря журналам ваша операционная работа будет упрощена.