Как справляться с стадом ботов и спорами с пауками для рейтинга?

Опубликовано: 2020-01-23

Поисковые роботы Google индексируют каждую часть контента, которую вы публикуете на своем веб-сайте. Эти поисковые роботы представляют собой запрограммированные программы, которые переходят по ссылкам и кодам и передают их алгоритму. Затем алгоритм индексирует его и добавляет ваш контент в обширную базу данных. Таким образом, всякий раз, когда пользователь выполняет поиск по ключевому слову, поисковая система извлекает и ранжирует соответствующие результаты из базы данных уже проиндексированных страниц.

Google назначает краулинговый бюджет каждому веб-сайту, и поисковые роботы соответствующим образом выполняют сканирование вашего сайта. Вы должны управлять краулинговым бюджетом и использовать его, чтобы обеспечить интеллектуальное сканирование и индексацию всего вашего веб-сайта.

В этом посте вы можете узнать об уловках и инструментах, позволяющих справиться с тем, как боты/пауки или поисковые роботы поисковых систем сканируют и индексируют ваш сайт.

1. Оптимизация директивы Disallow для Robot.txt:

Robots.txt — это текстовый файл со строгим синтаксисом, который работает как руководство для поисковых роботов, чтобы определить, как сканировать ваш сайт. Файл robots.txt сохраняется в репозиториях вашего веб-сайта, откуда поисковые роботы ищут URL-адреса. Чтобы оптимизировать этот Robots.txt или «Протокол исключения роботов», вы можете использовать некоторые приемы, которые могут помочь сканерам Google сканировать URL-адреса вашего сайта для более высокого рейтинга.

Одним из таких приемов является использование «Директивы о запрете» , это похоже на размещение вывески «Запретная зона» в определенных разделах вашего сайта. Чтобы оптимизировать директиву Disallow, вы должны понимать первую линию защиты: «Пользовательские агенты».

Что такое директива агента пользователя?

Каждый файл Robots.txt состоит из одного или нескольких правил, среди которых наиболее важным является правило пользовательского агента. Это правило предоставляет сканерам доступ и запрет на доступ к определенному списку на веб-сайте.

Таким образом, директива пользовательского агента используется для обращения к конкретному сканеру и предоставления ему инструкций о том, как выполнить сканирование.

Типы поисковых роботов Google, которые обычно используются:

Запретить директиву:

Теперь, узнав о боте, которому поручено сканирование вашего сайта, вы можете оптимизировать различные его разделы в зависимости от типа пользовательского агента. Некоторые важные приемы и примеры, которым вы можете следовать, чтобы оптимизировать директиву disallow на вашем веб-сайте:

- Используйте полное имя страницы, которое может отображаться в браузере, для использования в директиве disallow.

- Если вы хотите перенаправить поисковый робот из пути к каталогу, используйте знак «/».

- Используйте * для префикса пути, суффикса или всей строки.

Примеры использования директив disallow:

# Пример 1: Блокировать только Googlebot

Агент пользователя: Googlebot

Запретить: /

# Пример 2: заблокировать Googlebot и Adsbot

Агент пользователя: Googlebot

Агент пользователя: AdsBot-Google

Запретить: /

# Пример 3: Блокировать все сканеры, кроме AdsBot

Пользовательский агент: *

Запретить: /

2. Неиндексная директива для Robots.txt:

Когда другие веб-сайты ссылаются на ваш сайт, есть вероятность, что URL-адрес, который вы не хотите, чтобы сканер индексировал, может быть раскрыт. Чтобы решить эту проблему, вы можете использовать директиву non-index. Давайте посмотрим, как мы можем применить директиву non-index к Robots.txt:

Есть два способа применить директиву non-index для вашего веб-сайта:

<Мета> Теги:

Мета-теги — это текстовые фрагменты, описывающие содержание вашей страницы в краткой прозрачной форме, которая позволяет посетителям узнать, что будет дальше? Мы можем использовать то же самое, чтобы избежать индексации страницы поисковыми роботами.

Во-первых, поместите метатег «<meta name= «robots» content=» noindex»>» в раздел «<head>» вашей страницы, который вы не хотите, чтобы поисковые роботы индексировали.

Для поисковых роботов Google вы можете использовать «<meta name=»googlebot» content=»noindex»/>» в разделе «<head>».

Поскольку различные сканеры поисковых систем ищут ваши страницы, они могут по-разному интерпретировать вашу директиву об отсутствии индекса. В связи с этим ваши страницы могут появиться в результатах поиска.

Таким образом, было бы полезно, если бы вы определили директивы для страниц в соответствии с поисковыми роботами или пользовательскими агентами.

Вы можете использовать следующие метатеги для применения директивы к различным поисковым роботам:

<meta name="googlebot" content="noindex">

<meta name="googlebot-news" content="nosnippet">

Тег X-Robots:

Мы все знаем о заголовках HTTP, которые используются в качестве ответов на запрос клиента или поисковой системы о дополнительной информации, связанной с вашими веб-страницами, такой как местоположение или сервер, предоставляющий ее. Теперь, чтобы оптимизировать эти ответы заголовков HTTP для директивы non-index, вы можете добавить теги X-Robots в качестве элемента ответа заголовка HTTP для любого заданного URL-адреса вашего веб-сайта.

Вы можете комбинировать различные теги X-Robots с ответами заголовков HTTP. Вы можете указать различные директивы в списке, разделенном запятой. Ниже приведен пример ответа заголовка HTTP с различными директивами в сочетании с тегами X-Robots.

HTTP/1.1 200 ОК

Дата: вторник, 25 января 2020 г., 21:42:43 по Гринвичу

(…)

X-Robots-Тэг: noarchive

X-Robots-Tag: unavailable_after: 25 июля 2020 г., 15:00:00 по тихоокеанскому времени

(…)

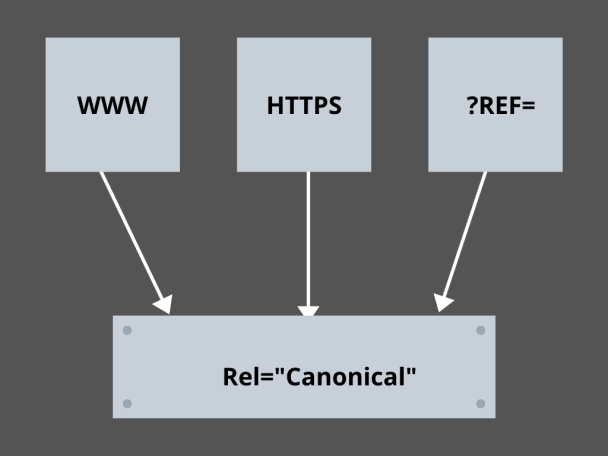

3. Освоение канонических ссылок:

Какого фактора в SEO сегодня больше всего боятся? Рейтинги? Движение? Нет! Это боязнь того, что поисковые системы накажут ваш сайт за дублированный контент. Таким образом, пока вы разрабатываете стратегию своего краулингового бюджета, вам нужно быть осторожным, чтобы не раскрыть дублированный контент.

Здесь овладение каноническими ссылками поможет вам решить проблемы с дублирующимся контентом. Слово «дублированный контент» — это не то, что оно означает. Давайте возьмем пример двух страниц веб-сайта электронной коммерции:

Например, у вас есть веб-сайт электронной коммерции с парой идентичных страниц для смарт-часов, и обе имеют схожий контент. Когда роботы поисковых систем сканируют ваш URL-адрес, они проверяют наличие дублирующегося контента и могут выбрать любой из URL-адресов. Чтобы перенаправить их на нужный вам URL, для страниц можно установить каноническую ссылку. Давайте посмотрим, как вы можете это сделать:

- Выберите любую страницу из двух страниц для вашей канонической версии.

- Выберите тот, который получает больше посетителей.

- Теперь добавьте rel="canonical" на свою неканоническую страницу.

- Перенаправить ссылку неканонической страницы на каноническую страницу.

- Обе ссылки на ваши страницы будут объединены в одну каноническую ссылку.

4. Структурирование веб-сайта:

Поисковым роботам нужны маркеры и вывески, чтобы помочь им обнаружить важные URL-адреса вашего сайта, и если вы не структурируете свой веб-сайт, поисковым роботам будет сложно выполнить сканирование ваших URL-адресов. Для этого мы используем карты сайта, потому что они предоставляют сканерам ссылки на все важные страницы вашего сайта.

Стандартные форматы карты сайта для веб-сайтов или даже приложений, разработанных в процессе разработки мобильных приложений, — это карты сайта XML, Atom и RSS. Чтобы оптимизировать сканирование, вам необходимо объединить XML-карты сайта и каналы RSS/Atom.

- Поскольку XML-карты сайта предоставляют поисковым роботам указания ко всем страницам вашего веб-сайта или приложения.

- А канал RSS/Atom предоставляет сканерам обновления на ваших страницах веб-сайта.

- Поскольку XML-карты сайта предоставляют поисковым роботам указания ко всем страницам вашего веб-сайта или приложения.

5. Навигация по страницам:

Навигация по страницам важна для пауков и даже для посетителей вашего сайта. Эти загрузки ищут страницы на вашем веб-сайте, а предопределенная иерархическая структура может помочь поисковым роботам находить страницы, которые важны для вашего веб-сайта. Другие шаги, которые необходимо выполнить для лучшей навигации по страницам:

- Сохраняйте кодирование в HTML или CSS.

- Иерархически упорядочивайте свои страницы.

- Используйте неглубокую структуру веб-сайта для лучшей навигации по страницам.

- Старайтесь, чтобы меню и вкладки в заголовке были минимальными и конкретными.

- Это поможет упростить навигацию по страницам.

6. Избегайте ловушек для пауков:

Ловушки для пауков — это бесконечные URL-адреса, указывающие на один и тот же контент на одних и тех же страницах, когда сканеры сканируют ваш сайт. Это больше похоже на стрельбу холостыми. В конечном итоге это съест ваш краулинговый бюджет. Эта проблема обостряется с каждым сканированием, и считается, что ваш веб-сайт имеет дублированный контент, поскольку каждый URL-адрес, который сканируется в ловушке, не будет уникальным.

Вы можете выйти из ловушки, заблокировав раздел через Robots.txt, или использовать одну из директив Follow или no Follow для блокировки определенных страниц. Наконец, вы можете решить проблему технически, остановив появление бесконечных URL-адресов.

7. Структура ссылок:

Перелинковка — одна из важнейших частей оптимизации сканирования. Поисковые роботы могут лучше находить ваши страницы с хорошо структурированными ссылками на вашем сайте. Вот некоторые из ключевых приемов создания отличной структуры ссылок:

- Использование текстовых ссылок, так как поисковые системы легко их сканируют: <a href="new-page.html">текстовая ссылка</a>

- Использование описательного анкорного текста в ваших ссылках

- Предположим, у вас есть веб-сайт тренажерного зала, и вы хотите разместить ссылки на все видео о тренажерном зале. Вы можете использовать такую ссылку: Не стесняйтесь просматривать все наши <a href="videos.html">видео о тренажерных залах</a>.

8. HTML-блаженство:

Очистка ваших HTML-документов и поддержание минимального размера полезной нагрузки HTML-документов очень важны, поскольку это позволяет сканерам быстро сканировать URL-адреса. Еще одним преимуществом оптимизации HTML является то, что ваш сервер сильно загружается из-за нескольких обходов поисковыми системами, и это может замедлить загрузку вашей страницы, что не является хорошим признаком для SEO или сканирования поисковыми системами. Оптимизация HTML может уменьшить нагрузку сканирования на сервер, обеспечивая быструю загрузку страниц. Это также помогает в устранении ошибок сканирования из-за тайм-аутов сервера или других важных проблем.

9. Вставьте это просто:

Ни один веб-сайт сегодня не будет предлагать контент без отличных изображений и видео, поддерживающих контент, поскольку именно это делает их контент визуально более привлекательным и доступным для поисковых роботов. Но если этот встроенный контент не оптимизирован, он может снизить скорость загрузки, отталкивая сканеры от вашего контента, который может ранжироваться.

Здесь, придерживаясь HTML для вашего встроенного контента, вы можете добиться лучшего сканирования из поисковых систем. Такие технологии, как AJAX, Javascript и т. д., неплохо предоставляют новые функции, но они также усложняют сканирование поисковыми системами.

Вывод:

С большим вниманием к SEO и более высокому трафику каждый владелец веб-сайта ищет лучшие способы справиться с стадом ботов и спорами с пауками. Но решения заключаются в детальной оптимизации, которую вам необходимо выполнить на вашем веб-сайте, и в сканировании URL-адресов, которые могут сделать сканирование поисковой системы более конкретным и оптимизированным, чтобы представить лучшее из вашего веб-сайта, который может занять более высокое место на страницах результатов поисковой системы.