Бюджет сканирования Google: как он работает и как увеличить свой

Опубликовано: 2021-03-02Для каждого веб-сайта в Интернете у Google есть фиксированный бюджет, определяющий, сколько страниц их боты могут и хотят сканировать. Интернет — это большое пространство, поэтому робот Googlebot может тратить очень мало времени на сканирование и индексирование наших веб-сайтов. Оптимизация краулингового бюджета — это процесс, который гарантирует, что нужные страницы наших веб-сайтов попадут в индекс Google и в конечном итоге будут показаны пользователям, выполняющим поиск.

Рекомендации Google по оптимизации краулингового бюджета довольно ограничены, поскольку робот Googlebot сканирует большинство веб-сайтов, не достигая своего лимита. Но корпоративные сайты и сайты электронной коммерции с тысячами целевых страниц рискуют исчерпать свой бюджет. Исследование 2018 года даже показало, что поисковые роботы Google не смогли просканировать более половины веб-страниц крупных сайтов в ходе эксперимента.

Влияние на то, как расходуется краулинговый бюджет, может быть более сложной технической оптимизацией для стратегов. Но для корпоративных сайтов и сайтов электронной коммерции стоит постараться максимально увеличить краулинговый бюджет там, где это возможно. С помощью нескольких настроек владельцы сайтов и SEO-стратеги могут направить робота Googlebot на регулярное сканирование и индексирование наиболее эффективных страниц.

Как Google определяет краулинговый бюджет?

Бюджет сканирования — это, по сути, время и ресурсы, которые Google готов потратить на сканирование вашего сайта. Уравнение выглядит следующим образом:

Бюджет сканирования = Скорость сканирования + Спрос на сканирование

Авторитет домена, обратные ссылки, скорость сайта, ошибки сканирования и количество целевых страниц — все это влияет на скорость сканирования веб-сайта. Более крупные сайты обычно имеют более высокую скорость сканирования, в то время как более мелкие сайты, более медленные сайты или сайты с чрезмерным количеством перенаправлений и ошибок сервера обычно сканируются реже.

Google также определяет краулинговый бюджет по «сканирующему спросу». Популярные URL-адреса имеют более высокий спрос на сканирование, потому что Google хочет предоставить пользователям самый свежий контент. Google не любит устаревший контент в своем индексе, поэтому страницы, которые не сканировались какое-то время, также будут иметь более высокий спрос. Если ваш веб-сайт подвергается миграции, Google увеличит спрос на сканирование, чтобы быстрее обновлять свой индекс с вашими новыми URL-адресами.

Бюджет сканирования вашего веб-сайта может колебаться и, конечно же, не является фиксированным. Если вы улучшите хостинг сервера или скорость сайта, робот Googlebot может начать сканировать ваш сайт чаще, зная, что это не замедляет работу пользователей в Интернете. Чтобы лучше понять текущую среднюю скорость сканирования вашего сайта, просмотрите отчет о сканировании в консоли поиска Google.

Каждому ли веб-сайту нужно беспокоиться о своем краулинговом бюджете?

Небольшим веб-сайтам, которые сосредоточены только на ранжировании нескольких целевых страниц, не нужно беспокоиться о краулинговом бюджете. Но более крупные веб-сайты — особенно нездоровые сайты с большим количеством неработающих страниц и переадресаций — могут легко достичь предела сканирования.

Типы крупных веб-сайтов, которые больше всего рискуют исчерпать свой краулинговый бюджет, обычно имеют десятки тысяч целевых страниц. В частности, краулинговые бюджеты негативно сказываются на крупных веб-сайтах электронной коммерции. Я сталкивался с несколькими корпоративными веб-сайтами, на которых значительная часть целевых страниц не проиндексирована, что означает нулевой шанс ранжирования в Google.

Есть несколько причин, по которым сайты электронной коммерции должны уделять больше внимания тому, на что расходуется их краулинговый бюджет.

- Многие сайты электронной коммерции программно создают тысячи целевых страниц для своих SKU или для каждого города или штата, где они продают свою продукцию.

- Эти типы сайтов регулярно обновляют свои целевые страницы, когда товаров нет в наличии, добавляются новые продукты или происходят другие изменения запасов.

- Сайты электронной коммерции склонны к дублированию страниц (например, страниц продуктов) и идентификаторов сеансов (например, файлов cookie). Оба они воспринимаются роботом Googlebot как URL-адреса с низкой добавленной стоимостью, что негативно влияет на скорость сканирования.

Еще одна проблема, связанная с влиянием на краулинговый бюджет, заключается в том, что Google может увеличить или уменьшить его в любое время. Хотя карта сайта является важным шагом для крупных веб-сайтов по улучшению сканирования и индексации их наиболее важных страниц, этого недостаточно для того, чтобы Google не превысил ваш краулинговый бюджет на страницах с низкой ценностью или с низкой эффективностью.

Так как же веб-мастера могут оптимизировать краулинговый бюджет?

Хотя владельцы сайтов могут устанавливать более высокие ограничения на сканирование в своих учетных записях Google Search Console, этот параметр не гарантирует увеличение количества запросов на сканирование и не влияет на то, какие страницы в конечном итоге сканирует Google. Может показаться, что наиболее естественным решением будет заставить Google чаще сканировать ваш веб-сайт, но существует очень ограниченная оптимизация, которая напрямую связана с увеличением скорости сканирования.

Мы все знаем, что хорошее составление бюджета заключается не в увеличении лимита расходов; речь идет о том, чтобы быть более избирательным в том, на что вы тратите свои деньги. Когда вы применяете ту же концепцию к краулинговому бюджету, это может дать огромные результаты. Вот несколько стратегических шагов, которые помогут Google расходовать ваш бюджет в ваших интересах.

Шаг 1. Определите, какие страницы Google на самом деле сканирует на вашем сайте.

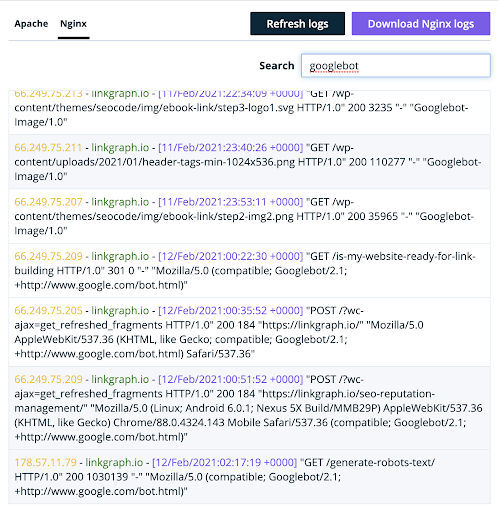

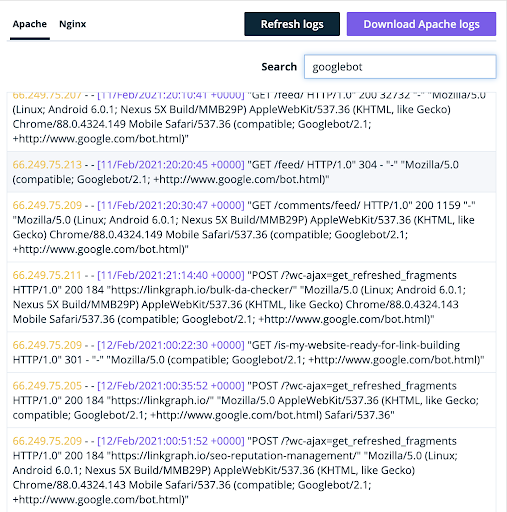

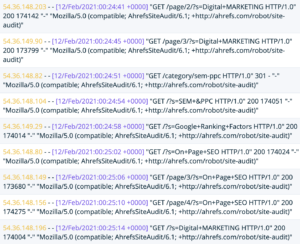

До недавнего времени отчет о сканировании Google Search Console сообщал владельцам сайтов только о том, сколько запросов на сканирование их сайт получил в определенные дни. Хотя новый отчет Google Crawl Stats Report предоставляет гораздо более подробную информацию о сканировании, лучшее место для понимания того, как Google сканирует ваш сайт, по-прежнему находится в файлах журнала вашего сервера.

Когда Google посещает ваш сайт, они используют определенный пользовательский агент. Это позволяет вашему серверу понять, что трафик на самом деле является роботом Googlebot, а не реальным человеком.

(Там же вы найдете бота Bingbot и Ahrefs).

Анализатор журнала сканирования

Владельцы сайтов, которые проанализируют содержимое этого файла журнала, получат массу информации о краулинговом бюджете Google для своего сайта. Файл покажет несколько вещей:

- Какие страницы посещает пользовательский агент

- Сколько страниц просматривает этот агент в день

- Независимо от того, является ли какая-либо из просканированных страниц 404 или поврежденной

В идеале вы хотите, чтобы Google сканировал целевые страницы на вашем веб-сайте, оптимизированные для ключевых слов с наивысшим значением. Кроме того, владельцы сайтов никогда не должны тратить краулинговый бюджет на ошибки 404. Консоль поиска Google покажет вам только некоторые из ваших программных ошибок 404, но вы можете идентифицировать их все в журналах вашего сервера.

Получив более подробную информацию о том, какие страницы вашего веб-сайта сканируются, выполните следующие действия:

- Добавьте теги robots. Если робот Googlebot сканирует эти ошибки 404 или неработающие страницы, приоритетом номер один должно быть добавление тегов robots [noindex, nofollow], чтобы предотвратить сканирование и индексирование этих страниц роботом Googlebot.

- Настройте карту сайта: если журналы вашего сервера показывают, что Google не сканирует ваши потенциально высокоэффективные страницы, поместите их выше в карте сайта, чтобы убедиться, что они сканируются.

Шаг 2. Примите тот факт, что не все ваши целевые страницы должны занимать высокие позиции в Google.

Основная причина, по которой так много корпоративных веб-сайтов тратят впустую свой краулинговый бюджет, заключается в том, что они позволяют Google сканировать каждую целевую страницу на своем сайте. Многие веб-сайты даже любят помещать все свои страницы в мобильное приложение, чтобы Google мог найти и просканировать их все. Это ошибка, потому что на самом деле не все наши целевые страницы будут ранжироваться.

Какова ценность целевой страницы в индексе Google? Ранжирование и конвертация. Если на вашем веб-сайте есть целевые страницы, которые не приносят пользу, ранжируясь по нескольким ключевым словам или конвертируя посетителей сайта в потенциальных клиентов и доход, зачем вообще рисковать, позволяя Google сканировать их?

Владельцы корпоративных сайтов и сайтов электронной коммерции должны знать, какие страницы их веб-сайтов оптимизированы для конверсии и имеют наибольшие шансы на ранжирование и конверсию. Затем они должны использовать все возможные преимущества, чтобы убедиться, что Google расходует краулинговый бюджет на эти высокоэффективные страницы.

Целевые страницы вашего веб-сайта с высоким рейтингом и потенциалом конверсии стоят того, чтобы тратить краулинговый бюджет. Вот несколько советов, которые помогут роботу Googlebot включить эти страницы в ваш бюджет.

- Уменьшите количество страниц в карте сайта . Сосредоточьтесь только на тех страницах, которые действительно имеют хорошие шансы на ранжирование и получение органического трафика.

- Удалите неэффективные или ненужные страницы . Удалите те страницы, которые не приносят никакой ценности, потому что у них нет ранжирования, конверсии или функционального назначения.

- Содержимое обрезается . Сократите страницы, которые на самом деле не получают органического трафика, и перенаправьте их на другие целевые страницы вашего сайта, которые релевантны и получают трафик. Обратите внимание, что перенаправления съедают часть вашего краулингового бюджета, поэтому старайтесь использовать их экономно и никогда не используйте их дважды подряд.

Любому владельцу сайта трудно отказаться от контента, но гораздо проще запретить Google сканировать определенные страницы, чем заставить Google увеличить общий бюджет сканирования. Очистка вашего сайта, чтобы поисковые роботы Google с большей вероятностью находили и индексировали лучшие материалы, является главным приоритетом, если вы хотите разумно расходовать свой краулинговый бюджет.

Шаг 3. Используйте внутренние ссылки, чтобы повысить эффективность страниц для поисковых роботов Google.

После того как вы определили, какие страницы сканирует Google, добавили необходимые теги роботов, удалили или обрезали неэффективные страницы и внесли изменения в карту сайта, поисковые роботы Google будут более склонны тратить свой бюджет на нужные страницы вашего веб-сайта.

Но чтобы по-настоящему максимизировать этот бюджет, ваши страницы должны иметь все необходимое для ранжирования. Лучшие практики SEO на странице являются ключевыми, но более продвинутая техническая стратегия заключается в использовании вашей внутренней структуры ссылок для повышения эффективности этих потенциально высокоэффективных страниц.

Точно так же, как Googlebot имеет ограниченный краулинговый бюджет, ваш веб-сайт имеет только определенную долю сайта в зависимости от его присутствия в Интернете. Вы несете ответственность за то, чтобы разумно сконцентрировать свой капитал. Это означает направление капитала сайта на те страницы, которые нацелены на ключевые слова, по которым у вас есть хорошие шансы ранжироваться, и на те, которые приносят вам трафик с нужными клиентами, теми, которые могут конвертироваться и действительно имеют экономическую ценность.

Эта стратегия SEO известна как скульптура PageRank. Если у вас есть большой веб-сайт с тысячами целевых страниц, продвинутый стратег может провести эксперименты по SEO, чтобы оптимизировать внутренний ссылочный профиль вашего веб-сайта для лучшего распределения PageRank. Если вы новый веб-сайт, вы можете опередить кривую, включив моделирование PageRank в архитектуру вашего сайта и думая о ценности сайта с каждой новой целевой страницей, которую вы создаете.

Вот две из моих любимых стратегий анализа моих страниц, чтобы определить, какие из них получат наибольшую пользу от моделирования PageRank.

- Найдите страницы своего веб-сайта с хорошим трафиком, но с недостаточным PageRank . Найдите способы получить на эти страницы больше внутренних ссылок и отправить туда больше PageRank. Добавление их в верхний или нижний колонтитул вашего веб-сайта — отличный способ сделать это быстро, но не переусердствуйте со ссылками в меню навигации.

- Сосредоточьтесь на страницах, которые имеют много внутренних ссылок, но не получают много трафика, поисковых показов и рейтинга по очень небольшому количеству ключевых слов . Страницы, получающие много внутренних ссылок, обычно имеют высокий PageRank. Если они не используют этот PageRank для привлечения органического трафика на ваш сайт, они тратят его впустую. Лучше переместить этот PageRank на страницы, которые действительно могут сдвинуть иглу.

Понимание роли, которую играет каждая ссылка на вашем веб-сайте не только в отправке робота Googlebot по вашему веб-сайту, но и в распределении вашего ссылочного капитала, является последним шагом в оптимизации краулингового бюджета. Правильная внутренняя структура ссылок может привести к значительному улучшению рейтинга ваших страниц с деньгами. В конце концов, лучший способ потратить краулинговый бюджет — это целевые страницы, которые, скорее всего, принесут доход в ваш карман.

После внесения изменений следите за рейтингом ключевых слов для этих улучшенных страниц в инструменте Google Search Console. Если рейтинг этих страниц улучшается, это показывает, что оптимизация краулингового бюджета работает. Затем, когда вы добавляете новые страницы на свой веб-сайт, будьте более избирательны в том, заслуживают ли они того, чтобы поглотить ваш краулинговый бюджет. Если нет, продолжайте направлять поисковые роботы только на те страницы, которые наиболее эффективны для вашего бренда.