25 лучших инструментов веб-сканирования для эффективного извлечения данных с веб-сайтов

Опубликовано: 2023-06-15Введение в инструменты веб-сканирования

Инструменты веб-сканирования, также известные как пауки или веб-скраперы, необходимы для предприятий, которые хотят извлекать ценные данные с веб-сайтов для анализа и интеллектуального анализа данных. Эти инструменты имеют широкий спектр применения, от исследования рынка до поисковой оптимизации (SEO). Они собирают данные из различных общедоступных источников и представляют их в структурированном и удобном для использования формате. Используя инструменты веб-сканирования, компании могут отслеживать новости, социальные сети, изображения, статьи, конкурентов и многое другое.

25 лучших инструментов веб-сканирования для быстрого извлечения данных с веб-сайтов

Скрапи

Scrapy — это популярная платформа для сканирования веб-страниц с открытым исходным кодом на основе Python, которая позволяет разработчикам создавать масштабируемые поисковые роботы. Он предлагает полный набор функций, упрощающих внедрение поисковых роботов и извлечение данных с веб-сайтов. Scrapy является асинхронным, что означает, что он выполняет запросы не по одному, а параллельно, что приводит к эффективному сканированию. Как хорошо зарекомендовавший себя инструмент веб-сканирования, Scrapy подходит для крупномасштабных проектов веб-скрейпинга.

Ключевая особенность

- Он генерирует экспорт фидов в таких форматах, как JSON, CSV и XML.

- Он имеет встроенную поддержку для выбора и извлечения данных из источников с помощью выражений XPath или CSS.

- Это позволяет автоматически извлекать данные с веб-страниц с помощью пауков.

- Он быстрый и мощный , с масштабируемой и отказоустойчивой архитектурой.

- Он легко расширяется благодаря системе подключаемых модулей и богатому API.

- Он портативный , работает на Linux, Windows, Mac и BSD.

Цены

- Это бесплатный инструмент.

ParseHub

ParseHub — это инструмент веб-сканера, который может собирать данные с веб-сайтов, использующих технологию AJAX, JavaScript, файлы cookie и многое другое. Его технология машинного обучения может читать, анализировать, а затем преобразовывать веб-документы в соответствующие данные. Настольное приложение ParseHub поддерживает операционные системы Windows, Mac OS X и Linux. Предлагая удобный интерфейс, ParseHub предназначен для непрограммистов, которые хотят извлекать данные с веб-сайтов.

Ключевая особенность

- Он может очищать динамические веб-сайты , которые используют AJAX, JavaScript, бесконечную прокрутку, разбиение на страницы, раскрывающиеся списки, входы в систему и другие элементы.

- Он прост в использовании и не требует навыков кодирования.

- Он основан на облаке и может хранить данные на своих серверах.

- Он поддерживает ротацию IP , сбор по расписанию , регулярные выражения , API и веб-хуки.

- Он может экспортировать данные в форматах JSON и Excel .

Цены

- У ParseHub есть как бесплатные, так и платные планы. Цены на платные планы начинаются от 149 долларов в месяц и предлагают повышенную скорость проектов, более высокий лимит на количество страниц, очищаемых за один запуск, и возможность создавать больше проектов.

Октопарс

Octoparse — это клиентский инструмент для сканирования веб-страниц, который позволяет пользователям извлекать веб-данные в электронные таблицы без необходимости кодирования. Благодаря интерфейсу «укажи и щелкни» Octoparse специально создан для непрограммистов. Пользователи могут создавать свои собственные поисковые роботы для сбора данных с любого веб-сайта, а Octoparse предоставляет готовые парсеры для таких популярных веб-сайтов, как Amazon, eBay и Twitter. Инструмент также предлагает расширенные функции, такие как запланированное извлечение из облака, очистка данных и обход блокировки с помощью IP-прокси-серверов.

Ключевая особенность

- Интерфейс «укажи и щелкни» : вы можете легко выбрать веб-элементы, которые хотите очистить, щелкнув по ним, и Octoparse автоматически определит шаблоны данных и извлечет данные для вас.

- Расширенный режим : вы можете настроить свои задачи очистки с помощью различных действий, таких как ввод текста, нажатие кнопок, прокрутка страниц, просмотр списков и т. д. Вы также можете использовать XPath или RegEx для точного поиска данных.

- Облачный сервис : вы можете запускать свои задачи парсинга на облачных серверах Octoparse 24/7 и хранить свои данные на облачной платформе. Вы также можете планировать свои задачи и использовать автоматическую ротацию IP-адресов, чтобы избежать блокировки веб-сайтами.

- API : вы можете получить доступ к своим данным через API и интегрировать их с другими приложениями или платформами. Вы также можете превратить любые данные в собственные API с помощью Octoparse.

Цены

- У него есть как бесплатные, так и платные планы. Платные планы начинаются с 89 долларов в месяц.

WebHarvy

WebHarvy — это программное обеспечение для парсинга веб-страниц, разработанное для непрограммистов. Он может автоматически очищать текст, изображения, URL-адреса и электронные письма с веб-сайтов и сохранять их в различных форматах, таких как XML, CSV, JSON или TSV. WebHarvy также поддерживает анонимное сканирование и обработку динамических веб-сайтов, используя прокси-серверы или службы VPN для доступа к целевым веб-сайтам.

Ключевая особенность

- Интерфейс «укажи и щелкни» для выбора данных без кодирования или сценариев

- Многостраничный майнинг с автоматическим сканированием и очисткой

- Скрапинг категории для сбора данных с похожих страниц или списков

- Загрузка изображений со страниц сведений о продукте на веб-сайтах электронной коммерции

- Автоматическое обнаружение шаблонов для очистки списков или таблиц без дополнительной настройки

- Извлечение на основе ключевых слов путем отправки входных ключевых слов в формы поиска

- Регулярные выражения для большей гибкости и контроля над очисткой

- Автоматическое взаимодействие с браузером для выполнения таких задач, как переход по ссылкам, выбор параметров, прокрутка и т. д.

Цены

- WebHarvy — это программное обеспечение для просмотра веб-страниц, за лицензию на которое взимается разовая плата.

- Стоимость их лицензии начинается от 139 долларов в год.

Красивый суп

Beautiful Soup — это библиотека Python с открытым исходным кодом, используемая для анализа документов HTML и XML. Он создает дерево синтаксического анализа, которое упрощает извлечение данных из Интернета. Хотя Beautiful Soup не так быстр, как Scrapy, его в основном хвалят за простоту использования и поддержку сообщества при возникновении проблем.

Ключевая особенность

- Синтаксический анализ : Beautiful Soup можно использовать с различными парсерами, такими как html.parser, lxml, html5lib и т. д., для анализа различных типов веб-документов.

- Навигация : вы можете перемещаться по дереву синтаксического анализа, используя методы и атрибуты Python, такие как find(), find_all(), select(), .children, .parent, .next_sibling и т. д.

- Поиск : Вы можете выполнять поиск в дереве синтаксического анализа, используя фильтры, такие как имена тегов, атрибуты, текст, селекторы CSS, регулярные выражения и т. д., чтобы найти нужные элементы.

- Изменение : вы можете изменить дерево синтаксического анализа, добавив, удалив, заменив или отредактировав элементы и их атрибуты.

Цены

Beautiful Soup — это бесплатная библиотека с открытым исходным кодом, которую вы можете установить с помощью pip.

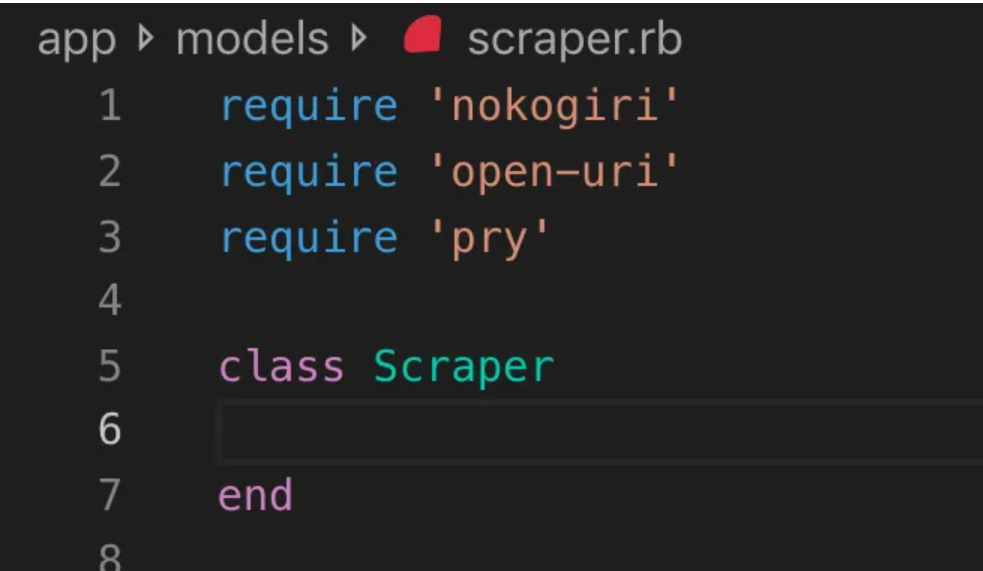

Нокогири

Nokogiri — это инструмент веб-сканера, который упрощает анализ документов HTML и XML с помощью Ruby, языка программирования, удобного для начинающих в веб-разработке. Nokogiri опирается на собственные синтаксические анализаторы, такие как libxml2 C и xerces Java, что делает его мощным инструментом для извлечения данных с веб-сайтов. Он хорошо подходит для веб-разработчиков, которые хотят работать с библиотекой веб-сканирования на основе Ruby.

Ключевая особенность

- Парсер DOM для XML, HTML4 и HTML5

- Парсер SAX для XML и HTML4

- Push Parser для XML и HTML4

- Поиск документов через XPath 1.0

- Поиск документов с помощью селекторов CSS3 с некоторыми расширениями, подобными jquery.

- Проверка схемы XSD

- XSLT-преобразование

- DSL «Builder» для документов XML и HTML

Цены

- Nokogiri — это проект с открытым исходным кодом, который можно использовать бесплатно.

Zyte (ранее Scrapinghub)

Zyte (ранее Scrapinghub) — это облачный инструмент для извлечения данных, который помогает тысячам разработчиков извлекать ценные данные с веб-сайтов. Его инструмент визуальной очистки с открытым исходным кодом позволяет пользователям очищать веб-сайты без каких-либо знаний в области программирования. Zyte использует Crawlera, интеллектуальный ротатор прокси, который поддерживает обход мер противодействия ботам для простого сканирования больших или защищенных ботами сайтов и позволяет пользователям сканировать с нескольких IP-адресов и мест без проблем с управлением прокси через простой HTTP API.

Ключевая особенность

- Данные по запросу: предоставьте Zyte веб-сайты и требования к данным, и они доставят запрошенные данные в соответствии с вашим графиком.

- Zyte AP I: автоматически извлекает HTML-код с веб-сайтов, используя наиболее эффективную конфигурацию прокси-сервера и извлечения, что позволяет вам сосредоточиться на данных без технических проблем.

- Scrapy Cloud : масштабируемый хостинг для ваших пауков Scrapy с удобным веб-интерфейсом для управления, мониторинга и контроля ваших сканеров, а также с инструментами мониторинга, ведения журнала и контроля качества данных.

- API автоматического извлечения данных . Мгновенный доступ к веб-данным с помощью API извлечения Zyte на основе искусственного интеллекта, что позволяет быстро получать качественные структурированные данные. Благодаря этой запатентованной технологии подключение новых источников становится проще.

Цены

Zyte имеет гибкую модель ценообразования, которая зависит от сложности и объема необходимых вам данных. Вы можете выбрать один из трех планов:

- Разработчик: 49 долларов в месяц за 250 000 запросов.

- Бизнес: 299 долларов США в месяц за 2 миллиона запросов.

- Предприятие: Индивидуальные цены для более 10 млн запросов

- Вы также можете бесплатно попробовать Zyte с 10 000 запросов в месяц.

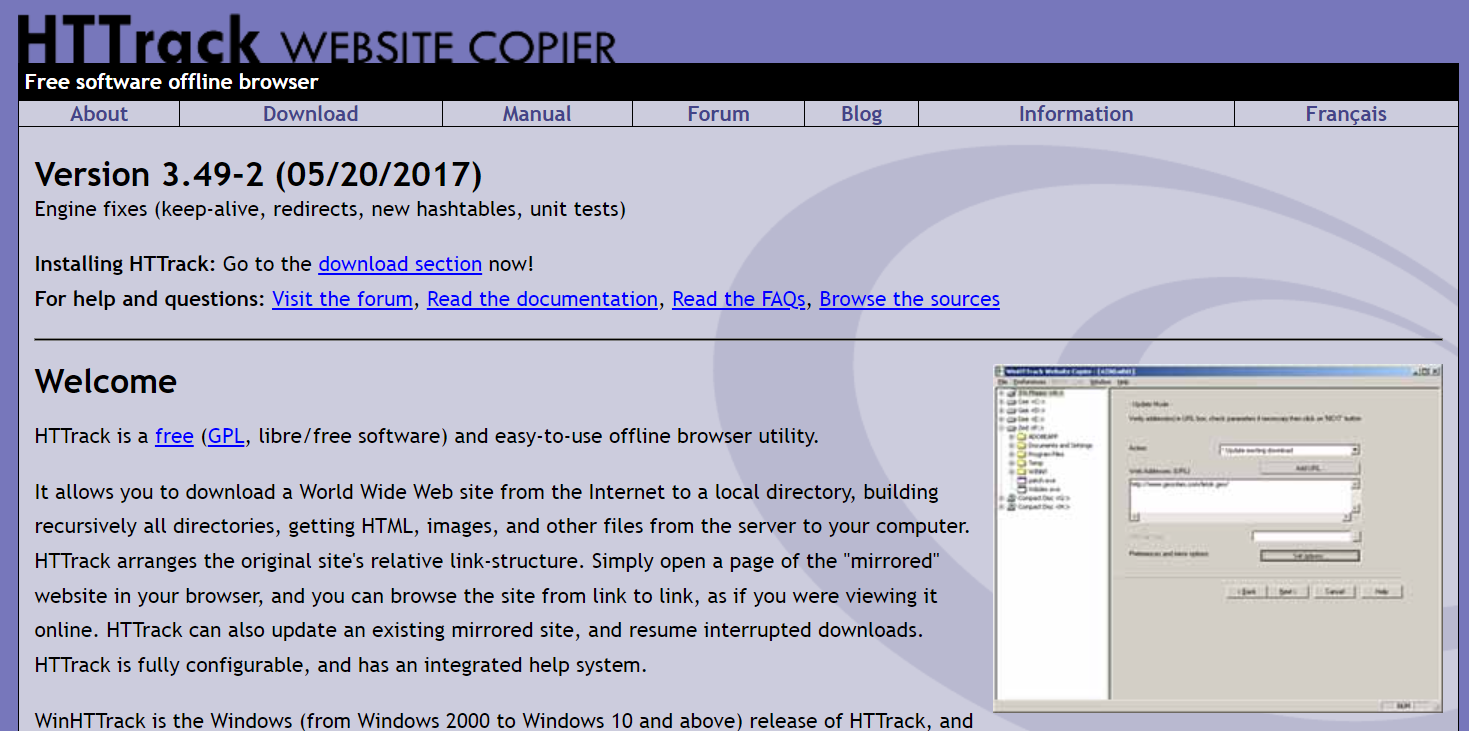

HTTrack

HTTrack — это бесплатный инструмент для сканирования веб-страниц с открытым исходным кодом, который позволяет пользователям загружать целые веб-сайты или определенные веб-страницы на свое локальное устройство для просмотра в автономном режиме. Он предлагает интерфейс командной строки и может использоваться в системах Windows, Linux и Unix.

Ключевая особенность

- Он сохраняет относительную ссылочную структуру исходного сайта.

- Он может обновлять существующий зеркальный сайт и возобновлять прерванные загрузки.

- Он полностью настраиваемый и имеет встроенную справочную систему.

- Он поддерживает различные платформы, такие как Windows, Linux, OSX, Android и т. д.

- Он имеет версию для командной строки и версию с графическим интерфейсом пользователя.

Цены

- HTTrack — это бесплатное программное обеспечение под лицензией GNU GPL.

Апач Натч

Apache Nutch — это расширяемый поисковый робот с открытым исходным кодом, часто используемый в таких областях, как анализ данных. Он может получать контент по таким протоколам, как HTTPS, HTTP или FTP, и извлекать текстовую информацию из таких форматов документов, как HTML, PDF, RSS и ATOM.

Ключевая особенность

- Он основан на структурах данных Apache Hadoop, которые отлично подходят для пакетной обработки больших объемов данных.

- Он имеет модульную архитектуру, позволяющую разработчикам создавать подключаемые модули для синтаксического анализа типов мультимедиа, извлечения данных, запросов и кластеризации.

- Он поддерживает различные платформы, такие как Windows, Linux, OSX, Android и т. д.

- Он имеет версию для командной строки и версию с графическим интерфейсом пользователя.

- Он интегрируется с Apache Tika для синтаксического анализа, Apache Solr и Elasticsearch для индексации и Apache HBase для хранения.

Цены

- Apache Nutch — это бесплатное программное обеспечение под лицензией Apache License 2.0.

Гелиевый скребок

Helium Scraper — это визуальный инструмент для сканирования веб-данных, который может быть настроен и контролироваться пользователями без необходимости кодирования. Он предлагает расширенные функции, такие как ротация прокси, быстрое извлечение и поддержка нескольких форматов данных, таких как Excel, CSV, MS Access, MySQL, MSSQL, XML или JSON.

Ключевая особенность

- Быстрое извлечение : автоматически делегируйте задачи извлечения отдельным браузерам.

- Большие данные : база данных SQLite может содержать до 140 терабайт.

- Генерация базы данных : отношения таблиц генерируются на основе извлеченных данных.

- Генерация SQL : быстро объединяйте и фильтруйте таблицы для экспорта или ввода данных.

- Вызов API : интегрируйте веб-скрапинг и вызовы API в один проект.

- Обработка текста : создавайте функции для сопоставления, разделения или замены извлеченного текста.

- Поддержка JavaScript: внедряйте и запускайте собственный код JavaScript на любом веб-сайте.

- Ротация прокси : введите список прокси и меняйте их через любой заданный интервал.

- Обнаружение похожих элементов : Обнаруживает похожие элементы в одном или двух образцах.

- Обнаружение списков : автоматическое обнаружение списков и строк таблиц на веб-сайтах.

- Экспорт данных : экспорт данных в CSV, Excel, XML, JSON или SQLite.

- Планирование : запускается из командной строки или планировщика заданий Windows.

Цены

- Базовая лицензия стоит 99 долларов за пользователя.

Захват контента (Sequentum)

Content Grabber — это программное обеспечение для сканирования веб-страниц, ориентированное на предприятия, которое позволяет пользователям создавать автономные агенты для сканирования веб-страниц. Он предлагает расширенные функции, такие как интеграция со сторонними приложениями для анализа данных или отчетов, мощные возможности редактирования сценариев и интерфейсы отладки, а также поддержку экспорта данных в отчеты Excel, XML, CSV и большинство баз данных.

Ключевая особенность

- Простой в использовании интерфейс «укажи и щелкни» : автоматическое определение действий на основе элементов HTML.

- Надежный API : поддерживает простую интеграцию методом перетаскивания с существующими конвейерами данных.

- Настройка : настройте свои агенты парсинга с помощью распространенных языков кодирования, таких как Python, C#, JavaScript, регулярные выражения.

- Интеграция : интегрируйте сторонние библиотеки AI, ML, NLP или API для обогащения данных.

- Надежность и масштабируемость . Снизьте затраты на инфраструктуру и наслаждайтесь мониторингом сквозных операций в режиме реального времени.

- Юридическое соответствие : уменьшите свою ответственность и снизьте риск, связанный с дорогостоящими судебными исками и нормативными штрафами.

- Экспорт данных : экспорт данных в любой формат и доставка в любую конечную точку

- Планирование : запускайте агенты парсинга из командной строки или планировщика заданий Windows.

Цены

- Базовая лицензия стоит 27 500 долларов в год и позволяет использовать программное обеспечение на одном компьютере.

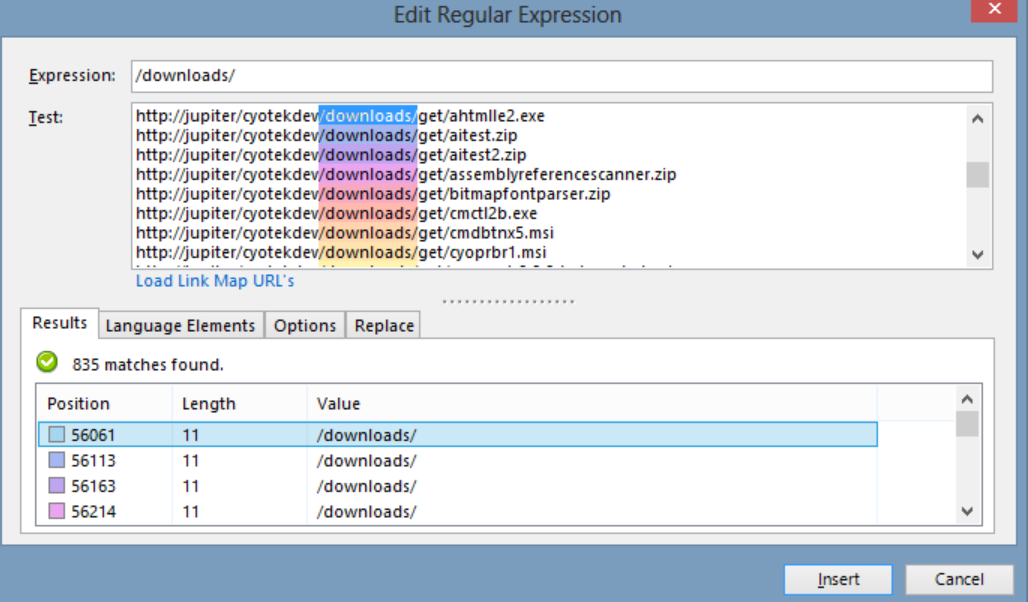

Cyotek WebCopy

Cyotek WebCopy — бесплатный сканер веб-сайтов, который позволяет пользователям частично или полностью копировать веб-сайты локально на жесткий диск для использования в автономном режиме. Он может обнаруживать и переходить по ссылкам на веб-сайте, а также автоматически переназначать ссылки в соответствии с локальным путем. Однако WebCopy не включает виртуальную модель DOM или какую-либо форму синтаксического анализа JavaScript, поэтому он может неправильно обрабатывать динамические макеты веб-сайтов из-за интенсивного использования JavaScript.

Ключевая особенность

- Простой в использовании интерфейс «укажи и щелкни» с автоматическим определением действий на основе элементов HTML.

- Надежный API для бесшовной интеграции с существующими конвейерами данных с помощью простой функции перетаскивания.

- Варианты настройки с использованием популярных языков программирования, таких как Python, C#, JavaScript и регулярные выражения, для адаптации агентов парсинга к конкретным потребностям.

- Возможности интеграции со сторонними библиотеками AI, ML, NLP или API для обогащения очищенных данных.

- Надежная и масштабируемая инфраструктура с мониторингом в реальном времени для рентабельных операций

- Функции соблюдения правовых норм для снижения ответственности и снижения риска судебных исков и штрафов регулирующих органов

- Экспорт данных в любой желаемый формат и доставка в различные конечные точки

- Параметры расписания позволяют запускать агенты парсинга из командной строки или планировщика заданий Windows.

Цены

- Базовая лицензия стоит 27 500 долларов в год и позволяет использовать программное обеспечение на одном компьютере.

80 ног

80legs — это мощный инструмент веб-сканирования, который можно настроить в соответствии с индивидуальными требованиями. Он поддерживает извлечение больших объемов данных вместе с возможностью мгновенной загрузки извлеченных данных. Инструмент предлагает пользователям API для создания поисковых роботов, управления данными и многого другого. Некоторые из его основных функций включают настройку парсера, IP-серверы для запросов веб-скрейпинга и платформу приложений на основе JS для настройки веб-сканирования с индивидуальным поведением.

Ключевая особенность

- Масштабируемость и скорость : вы можете сканировать до 2 миллиардов страниц в день с более чем 50 000 одновременных запросов.

- Гибкость и настраиваемость: вы можете использовать свой собственный код для управления логикой сканирования и извлечения данных или использовать встроенные инструменты и шаблоны.

Цены

- Вы можете выбрать один из различных тарифных планов в зависимости от ваших потребностей, начиная с 29 долларов США в месяц за 100 000 URL-адресов за сканирование до 299 долларов США в месяц за 10 миллионов URL-адресов за сканирование.

Webhose.io

Webhose.io позволяет пользователям получать данные в режиме реального времени, просматривая онлайн-источники со всего мира и представляя их в различных чистых форматах. Этот веб-сканер может сканировать данные и дополнительно извлекать ключевые слова на разных языках, используя несколько фильтров, охватывающих широкий спектр источников. Пользователи могут сохранять очищенные данные в форматах XML, JSON и RSS и получать доступ к данным истории из своего архива. Webhose.io поддерживает до 80 языков с результатами сканирования данных, что позволяет пользователям легко индексировать и искать структурированные данные, просканированные инструментом.

Ключевая особенность

- Несколько форматов : вы можете получать данные в форматах XML, JSON, RSS или Excel.

- Структурированные результаты : вы можете получить данные, которые нормализованы, обогащены и классифицированы в соответствии с вашими потребностями.

- Исторические данные : вы можете получить доступ к архивным данным за последние 12 месяцев или более.

- Широкий охват : вы можете получить данные из более чем миллиона источников на 80 языках и в 240 странах.

- Разнообразие источников . Вы можете получать данные с новостных сайтов, блогов, форумов, досок объявлений, комментариев, обзоров и многого другого.

- Быстрая интеграция : вы можете интегрировать Webhose.io в свои системы за считанные минуты с помощью простого REST API.

Цены

- У него есть бесплатный план, который позволяет вам делать 1000 запросов в месяц бесплатно. У него также есть индивидуальные планы, с которыми вы можете связаться для получения предложения.

Мозенда

Mozenda — это облачное программное обеспечение для парсинга веб-страниц, которое позволяет пользователям извлекать веб-данные без написания единой строки кода. Он автоматизирует процесс извлечения данных и предлагает такие функции, как извлечение данных по расписанию, очистка данных и обход блокировки с помощью IP-прокси-серверов. Mozenda разработана для бизнеса с удобным интерфейсом и мощными возможностями парсинга.

Ключевая особенность

- Анализ текста: вы можете извлекать и анализировать текстовые данные с любого веб-сайта, используя методы обработки естественного языка.

- Извлечение изображения: вы можете загружать и сохранять изображения с веб-страниц или извлекать метаданные изображения, такие как размер, формат, разрешение и т. д.

- Сбор разрозненных данных: вы можете собирать данные из нескольких источников и форматов, таких как HTML, XML, JSON, RSS и т. д.

- Извлечение документа. Вы можете извлекать данные из документов PDF, Word, Excel и других типов, используя методы оптического распознавания символов (OCR) или извлечения текста.

- Извлечение адресов электронной почты . Вы можете находить и извлекать адреса электронной почты с веб-страниц или документов с помощью регулярных выражений или сопоставления с образцом.

Цены

- Платный план начинается с 99 долларов в месяц.

UiPath

UiPath — это программное обеспечение для роботизированной автоматизации процессов (RPA) для бесплатного парсинга веб-страниц. Он автоматизирует сканирование веб-данных и данных на рабочем столе из большинства сторонних приложений. Совместимый с Windows, UiPath может извлекать табличные данные и данные на основе шаблонов на нескольких веб-страницах. Программное обеспечение также предлагает встроенные инструменты для дальнейшего сканирования и обработки сложных пользовательских интерфейсов.

Ключевая особенность

- Анализ текста . Извлекайте и анализируйте текстовые данные с помощью обработки естественного языка, регулярных выражений и сопоставления с образцом для таких задач, как извлечение адреса электронной почты.

- Извлечение изображения : загружайте и сохраняйте изображения с веб-страниц, извлекайте метаданные изображения, включая размер, формат и разрешение.

- Сбор разрозненных данных . Собирайте данные из различных источников и форматов, таких как HTML, XML, JSON, RSS, с возможностями интеграции для подключения к другим онлайн-сервисам и API.

- Извлечение документов . Извлечение данных из документов PDF, Word, Excel и других типов с использованием методов оптического распознавания символов или извлечения текста. Обрабатывайте и извлекайте информацию из различных типов и структур документов с помощью функций понимания документов.

- Веб-автоматизация : автоматизация веб-действий, таких как вход в систему, навигация по страницам, заполнение форм, нажатие кнопок. Используйте функцию записи для записи действий и создания сценариев автоматизации.

Цены

- платный план начинается с 420 долларов в месяц.

АутВит Хаб

OutWit Hub — это надстройка для Firefox с десятками функций извлечения данных, упрощающих поиск пользователей в Интернете. Этот веб-сканер может просматривать страницы и сохранять извлеченную информацию в правильном формате. OutWit Hub предлагает единый интерфейс для извлечения крошечных или огромных объемов данных по мере необходимости и может создавать автоматических агентов для извлечения данных с различных веб-сайтов за считанные минуты.

Ключевая особенность

- Просмотр и экспорт веб-контента: вы можете просматривать ссылки, документы, изображения, контакты, таблицы данных, RSS-каналы, адреса электронной почты и другие элементы, содержащиеся на веб-странице. Вы также можете экспортировать их в HTML, SQL, CSV, XML, JSON или другие форматы.

- Организуйте данные в таблицах и списках. Вы можете сортировать, фильтровать, группировать и редактировать данные, которые вы собираете в таблицах и списках. Вы также можете использовать несколько критериев для выбора данных, которые хотите извлечь.

- Настройте автоматические функции : вы можете использовать функцию парсера для создания пользовательских парсеров, которые могут извлекать данные с любого веб-сайта с помощью простых или расширенных команд. Вы также можете использовать функцию макросов для автоматизации задач просмотра веб-страниц и парсинга.

- Создание запросов и URL-адресов. Вы можете использовать функцию запросов для создания запросов на основе ключевых слов или шаблонов. Вы также можете использовать функцию URL для создания URL-адресов на основе шаблонов или параметров.

Цены

- Лицензия Light бесплатна и полностью функциональна, но она не включает функции автоматизации и ограничивает извлечение одной или несколькими сотнями строк, в зависимости от экстрактора.

- Лицензия Pro стоит 110 долларов в год и включает в себя все функции лицензии Light, а также функции автоматизации и неограниченное извлечение.

Визуальный скребок

Visual Scraper, помимо того, что является платформой SaaS, также предлагает услуги веб-скрапинга, такие как услуги по доставке данных и создание программных экстракторов для клиентов. Этот инструмент веб-сканирования охватывает весь жизненный цикл сканера, от загрузки, управления URL-адресами до извлечения контента. Это позволяет пользователям планировать выполнение проектов в определенное время или повторять последовательности каждую минуту, день, неделю, месяц или год. Visual Scraper идеально подходит для пользователей, которые хотят часто извлекать новости, обновления и форумы. Однако официальный сайт, похоже, сейчас не обновляется, и эта информация может быть устаревшей.

Ключевая особенность

- Простой в использовании интерфейс

- Поддерживает несколько форматов данных (CSV, JSON, XML и т. д.)

- Поддерживает нумерацию страниц, AJAX и динамические веб-сайты.

- Поддерживает прокси-серверы и ротацию IP-адресов

- Поддерживает планирование и автоматизацию

Цены

- У него есть бесплатный план и платные планы, начиная с 39,99 долларов в месяц.

Импорт.ио

Import.io — это инструмент веб-скрейпинга, который позволяет пользователям импортировать данные с определенной веб-страницы и экспортировать их в CSV без написания кода. Он может легко очистить тысячи веб-страниц за считанные минуты и создать более 1000 API-интерфейсов на основе требований пользователей. Import.io интегрирует веб-данные в пользовательское приложение или веб-сайт всего за несколько кликов, упрощая веб-скрапинг.

Ключевая особенность

- Укажи и щелкни выбор и обучение

- Аутентифицированное и интерактивное извлечение

- Загрузка изображений и скриншоты

- Премиум-прокси и экстракторы для конкретных стран

- Вывод в формате CSV, Excel, JSON и доступ к API

- SLA качества данных и отчетность

- Электронная почта, тикет, чат и поддержка по телефону

Цены

- Стартер: 199 долларов в месяц за 5000 запросов.

Dexi.io

Dexi.io — это веб-сканер на основе браузера, который позволяет пользователям собирать данные на основе своего браузера с любого веб-сайта и предоставляет три типа роботов для создания задачи очистки — Extractor, Crawler и Pipes. Бесплатное программное обеспечение предоставляет анонимные веб-прокси-серверы, а извлеченные данные будут размещаться на серверах Dexi.io в течение двух недель, прежде чем данные будут заархивированы, или пользователи могут напрямую экспортировать извлеченные данные в файлы JSON или CSV. Он предлагает платные услуги для пользователей, которым требуется извлечение данных в режиме реального времени.

Ключевая особенность

- Укажи и щелкни выбор и обучение

- Аутентифицированное и интерактивное извлечение

- Загрузка изображений и скриншоты

- Премиум-прокси и экстракторы для конкретных стран

- Вывод в формате CSV, Excel, JSON и доступ к API

- SLA качества данных и отчетность

- Электронная почта, тикет, чат и поддержка по телефону

Цены

- Стандарт: 119 долларов в месяц или 1950 долларов в год на 1 работника.

Кукольник

Puppeteer — это библиотека Node, разработанная Google, предоставляющая программистам API для управления Chrome или Chromium по протоколу DevTools. Он позволяет пользователям создавать инструмент для очистки веб-страниц с помощью Puppeteer и Node.js. Puppeteer можно использовать для различных целей, таких как создание снимков экрана или создание PDF-файлов веб-страниц, автоматизация отправки форм/ввода данных и создание инструментов для автоматизированного тестирования.

Ключевая особенность

- Создание скриншотов и PDF-файлов веб-страниц

- Сканирование и сбор данных с веб-сайтов

- Автоматизируйте отправку форм, тестирование пользовательского интерфейса, ввод с клавиатуры и т. д.

- Захват показателей производительности и трассировки

- Протестируйте расширения Chrome

- Бегать в безголовом или головокружительном режиме

Цены

- Puppeteer является бесплатным и открытым исходным кодом.

Crawler4j

Crawler4j — это веб-сканер Java с открытым исходным кодом и простым интерфейсом для сканирования Интернета. Это позволяет пользователям создавать многопоточные сканеры, эффективно используя память. Crawler4j хорошо подходит для разработчиков, которым требуется простое и настраиваемое решение для сканирования веб-страниц на основе Java.

Ключевая особенность

- Он позволяет указать, какие URL-адреса следует сканировать, а какие следует игнорировать с помощью регулярных выражений.

- Он позволяет обрабатывать загруженные страницы и извлекать из них данные.

- Он соблюдает протокол robots.txt и не сканирует запрещенные страницы.

- Он может сканировать HTML, изображения и другие типы файлов.

- Он может собирать статистику и одновременно запускать несколько поисковых роботов.

Цены

- Crawler4j — это проект Java с открытым исходным кодом, который позволяет легко настраивать и запускать собственные поисковые роботы.

Общий обход

Common Crawl — это инструмент веб-сканера, который предоставляет открытый корпус веб-данных для исследовательских, аналитических и образовательных целей.

Ключевая особенность

- Он предлагает пользователям доступ к данным веб-сканирования, таким как необработанные данные веб-страницы, извлеченные метаданные и текст, а также к общему индексу сканирования.

Цены

- Эти бесплатные и общедоступные данные веб-сканирования могут использоваться разработчиками, исследователями и предприятиями для различных задач анализа данных.

МеханическийСуп

MechanicalSoup — это библиотека Python, используемая для анализа веб-сайтов, основанная на библиотеке Beautiful Soup, вдохновленная библиотекой Mechanize. Он отлично подходит для хранения файлов cookie, перехода по перенаправлениям, гиперссылкам и обработки форм на веб-сайте.

Ключевая особенность

- MechanicalSoup предлагает простой способ просмотра и извлечения данных с веб-сайтов без необходимости решать сложные задачи программирования.

Цены

- Это бесплатный инструмент.

Обходчик узлов

Node Crawler — это популярный и мощный пакет для сканирования веб-сайтов на платформе Node.js. Он работает на основе Cheerio и имеет множество параметров для настройки того, как пользователи сканируют или очищают веб-страницы, включая ограничение количества запросов и времени между ними. Node Crawler идеально подходит для разработчиков, которые предпочитают работать с Node.js для своих проектов веб-сканирования.

Ключевая особенность

- Легко использовать

- API, управляемый событиями

- Настраиваемые повторы и тайм-ауты

- Автоматическое определение кодировки

- Автоматическая обработка файлов cookie

- Автоматическая обработка перенаправления

- Автоматическая обработка gzip/deflate

Цены

- Это бесплатный инструмент.

Факторы, которые следует учитывать при выборе инструмента веб-сканирования

Цены

Учитывайте структуру ценообразования выбранного инструмента и убедитесь, что она прозрачна и не содержит скрытых затрат. Выбирайте компанию, которая предлагает четкую модель ценообразования и предоставляет подробную информацию о доступных функциях.

Простота использования

Выберите инструмент веб-сканирования, который удобен для пользователя и не требует обширных технических знаний. Многие инструменты предлагают интерфейсы «укажи и щелкни», что упрощает извлечение данных с веб-сайтов для непрограммистов.

Масштабируемость

Подумайте, сможет ли инструмент веб-сканирования обрабатывать тот объем данных, который вам нужно извлечь, и сможет ли он расти вместе с вашим бизнесом. Некоторые инструменты больше подходят для небольших проектов, а другие предназначены для крупномасштабного извлечения данных.

Качество и точность данных

Убедитесь, что инструмент веб-сканирования может очищать и упорядочивать извлеченные данные в удобном для использования формате. Качество данных имеет решающее значение для точного анализа, поэтому выберите инструмент, обеспечивающий эффективную очистку и организацию данных.

Служба поддержки

Выберите инструмент веб-сканирования с отзывчивой и полезной поддержкой клиентов, которая поможет вам в случае возникновения проблем. Проверьте поддержку клиентов, связавшись с ними и отметив, сколько времени им потребуется, чтобы ответить, прежде чем принять обоснованное решение.

Заключение

Инструменты веб-сканирования необходимы для предприятий, которые хотят извлекать ценные данные с веб-сайтов для различных целей, таких как исследование рынка, SEO и конкурентный анализ. Принимая во внимание такие факторы, как цена, простота использования, масштабируемость, качество и точность данных, а также поддержка клиентов, вы можете выбрать правильный инструмент веб-сканирования, который соответствует вашим потребностям. 25 лучших инструментов веб-сканирования, упомянутых выше, предназначены для широкого круга пользователей, от непрограммистов до разработчиков, гарантируя, что для каждого найдется подходящий инструмент. Вы также можете подписаться на 7-дневную бесплатную пробную версию Scalenut, чтобы оптимизировать содержимое своего веб-сайта и улучшить свой рейтинг.