57 распространенных ошибок A/B-тестирования и как их избежать

Опубликовано: 2021-06-15

Вы проводите A/B-тесты, но не уверены, что они работают правильно?

Хотите узнать о распространенных ошибках при A/B-тестировании, чтобы не терять драгоценное время на неработающую кампанию?

Что ж, хорошие новости! В этой статье мы познакомим вас с 57 распространенными (а иногда и необычными) ошибками A/B-тестирования, которые мы видим, чтобы вы могли либо обойти их, либо понять, когда они происходят, и быстро их исправить.

Мы разбили их на 3 ключевых раздела:

- Ошибки до начала тестирования,

- Проблемы, которые могут возникнуть во время теста,

- И ошибки, которые вы можете сделать после завершения теста.

Вы можете просто прочитать и посмотреть, делаете ли вы что-то из этого самостоятельно.

И помни:

Каждый сбой — это ценный урок, как при тестировании, так и при ошибках настройки. Главное учиться у них!

Итак, давайте погрузимся…

- Распространенные ошибки A/B-тестирования, которые можно совершить еще до запуска теста

- №1. Нажимаем что-то живое перед тестированием!

- № 2. Отсутствие фактического A/B-тестирования

- №3. Не тестировать, чтобы увидеть, работает ли инструмент

- № 4. Использование некачественного инструмента и перепрошивка контента

- № 5. Нет тестового контроля качества

- № 6. Работает ли новое лечение/вариант?

- № 7. Не следуя гипотезе и просто проверяя любую старую вещь

- №8. Наличие непроверяемой гипотезы

- № 9. Не ставить четкую цель для своего теста заранее

- №10. Сосредоточенность на поверхностных метриках

- № 11. Использование только количественных данных для формирования тестовых идей

- № 12. Копирование ваших конкурентов

- № 13. Только тестирование «лучших отраслевых практик»

- № 14. Сосредоточьтесь сначала на задачах с небольшим воздействием, когда доступно большое вознаграждение/легко висящие плоды.

- № 15. Тестирование нескольких вещей одновременно и незнание того, какое изменение вызвало результат

- № 16. Не проведен надлежащий предварительный анализ

- № 17. Неправильная маркировка тестов

- № 18. Запуск тестов по неправильному URL

- № 19. Добавление произвольных правил отображения в тест

- № 20. Тестирование неправильного трафика для вашей цели

- № 21. Невозможность исключить вернувшихся посетителей из теста и искажение результатов

- № 22. Не удалять ваши IP-адреса из теста

- № 23. Отсутствие сегментации вариантов контрольной группы (сетевой эффект)

- № 24. Запуск тестов во время сезонных событий или крупных событий сайта/платформы

- № 25. Игнорирование культурных различий

- № 26. Запуск нескольких связанных кампаний одновременно

- № 27. Неравное взвешивание трафика

- Распространенные ошибки A/B-тестирования, которые вы можете совершить во время тестирования

- № 28. Не работает достаточно долго, чтобы получить точные результаты

- № 29. Вертолетный мониторинг / подглядывание

- № 30. Не отслеживание отзывов пользователей (особенно важно, если тест влияет на прямое, немедленное действие)

- № 31. Внесение изменений в процессе тестирования

- № 32. Изменение % распределения трафика в середине теста или удаление неэффективных

- № 33. Не останавливать тест, когда у вас есть точные результаты

- № 34. Эмоционально вкладываться в проигрышные варианты

- № 35. Запуск тестов слишком долго и отслеживание падает

- № 36. Не использовать инструмент, позволяющий остановить/выполнить тест!

- Распространенные ошибки A/B-тестирования, которые вы можете совершить после завершения теста

- № 37. Сдаюсь после одного теста!

- № 38. Отказ от хорошей гипотезы до того, как вы проверите все ее версии

- № 39. Ожидание огромных выигрышей все время

- № 40. Не проверяется валидность после теста

- № 41. Не правильно прочитали результаты

- № 42. Не смотреть результаты по сегментам

- № 43. Не учиться на результатах

- № 44. Принимая проигравших

- № 45. Не принимать меры по результатам

- № 46. Не повторять и улучшать победы

- № 47. Не делиться успешными выводами с другими областями или отделами

- № 48. Не тестировать эти изменения в других отделах

- № 49. Слишком много итераций на одной странице

- № 50. Недостаточно тестирования!

- № 51. Не документирование тестов

- № 52. Забыть о ложных срабатываниях и не перепроверять кампании с большим подъемом

- № 53. Не отслеживание результатов нижестоящих

- № 54. Не учитывают эффекты первичности и новизны, что может привести к искажению результатов лечения.

- № 55. Изменения текущего периода рассмотрения

- № 56. Не проводить повторное тестирование через X раз

- № 57. Только тестирование пути, а не продукта

- Вывод

Распространенные ошибки A/B-тестирования, которые можно совершить еще до запуска теста

№1. Нажимаем что-то живое перед тестированием!

У вас может быть фантастический новый дизайн страницы или веб-сайта, и вы действительно хотите запустить его в жизнь, не тестируя.

Откладывать!

Сначала запустите быстрый тест, чтобы увидеть, как это работает. Вы не хотите внедрять радикальные изменения без получения каких-либо данных, иначе вы можете потерять продажи и конверсии.

Иногда это новое изменение может привести к существенному падению производительности. Так что дайте ему быстрый тест в первую очередь.

№ 2. Отсутствие фактического A/B-тестирования

A/B-тест работает, запуская один источник трафика на контрольную страницу и вариант этой страницы. Цель состоит в том, чтобы выяснить, заставят ли внесенные вами изменения повысить конверсию аудитории и предпринять какие-либо действия.

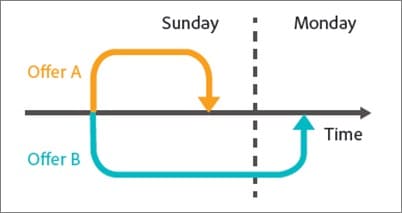

Дело в том, что для того, чтобы убедиться, что этот тест является контролируемым и справедливым, нам нужно запустить этот тест с определенными параметрами. Нам нужны одни и те же источники трафика, просматривающие кампанию в течение одного и того же периода времени, чтобы у нас не было внешних факторов, влияющих на один тест, а не на другой.

Некоторые люди делают ошибку, запуская тест последовательно. Они запускают свою текущую страницу в течение X времени, затем новую версию в течение X времени после этого, а затем измеряют разницу.

Эти результаты не совсем точны, поскольку во время этих тестовых периодов могло произойти многое. Вы можете получить всплеск нового трафика, запустить мероприятие, в результате чего две страницы будут иметь совершенно разные аудитории и результаты.

Поэтому убедитесь, что вы проводите настоящее A/B-тестирование, в котором вы распределяете трафик между двумя версиями и тестируете их одновременно.

№3. Не тестировать, чтобы увидеть, работает ли инструмент

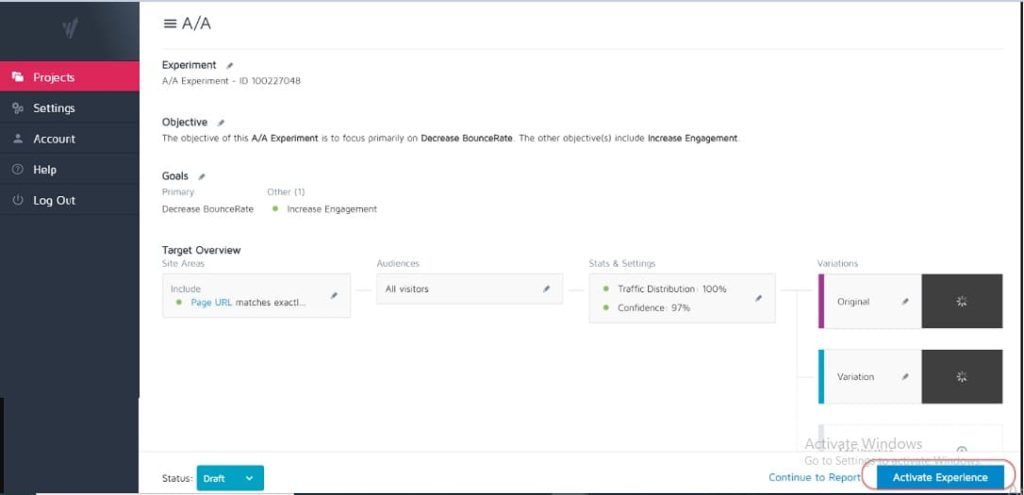

Ни один инструмент тестирования не является точным на 100%. Лучшее, что вы можете сделать, когда начинаете, — это запустить A/A-тест, чтобы увидеть, насколько точен ваш инструмент.

Как? Просто запустите тест, в котором вы разделяете трафик 50:50 между одной страницей. (Убедитесь, что это страница, на которой ваша аудитория может конвертировать, чтобы вы могли измерить конкретный результат.)

Почему?

Поскольку обе группы вашей аудитории видят одну и ту же страницу, результаты конверсии должны быть одинаковыми на обеих сторонах теста, верно?

Ну, иногда это не так, что означает, что ваш инструмент может быть настроен неправильно. Так что идите вперед и проверьте свой инструмент тестирования, прежде чем запускать какие-либо кампании.

№ 4. Использование некачественного инструмента и перепрошивка контента

Некоторые инструменты просто не так хороши, как другие. Они выполняют свою работу, но борются с нагрузкой трафика или «мигают» и мерцают.

На самом деле это может привести к провалу вашего теста, даже если у вас есть потенциально выигрышный вариант.

Допустим, вы проводите сплит-тестирование изображения на своей странице. Страница управления загружается нормально, но изменение между новым тестовым изображением и оригиналом мерцает всего на долю секунды. (Или, может быть, каждый раз, когда пользователь прокручивает страницу вверх и вниз.)

Это может отвлекать и вызывать проблемы с доверием, снижая коэффициент конверсии.

На самом деле, ваше новое изображение теоретически может конвертироваться даже лучше, но мерцание инструмента снижает результаты, давая вам неточный тест этого изображения.

Убедитесь, что у вас есть достаточно хороший инструмент для тестирования.

(Это настолько важный фактор пользовательского опыта, что Google в настоящее время корректирует свой рейтинг для сайтов, на которых нет мерцающих или движущихся элементов).

№ 5. Нет тестового контроля качества

Супер простая ошибка, но вы проверили, что все работает?

- Вы проходили процесс продажи?

- Есть другие? (И на некешированных устройствах, потому что иногда то, что сохраняется в вашем браузере, не соответствует тому, как выглядит страница.)

- Страницы загружаются нормально? Они медленные? Схемы перепутались?

- Все кнопки работают?

- Отслеживание доходов работает?

- Вы проверили, что страница работает на нескольких устройствах?

- Есть ли у вас отчеты об ошибках, если что-то сломается?

Все это стоит проверить ДО того, как вы начнете запускать трафик для какой-либо кампании.

Получите наш Контрольный список обеспечения качества для A/B-тестов. Это заполняемый PDF-файл, к которому вам захочется возвращаться каждый раз, когда вы проверяете тест.

№ 6. Работает ли новое лечение/вариант?

Точно так же, проверили ли вы, работает ли ваш новый вариант, прежде чем запускать тест?

Это может быть упущенной частью тестирования QA, но кампании часто могут работать со сломанными кнопками, старыми ссылками и многим другим. Сначала проверьте, а потом тестируйте.

№ 7. Не следуя гипотезе и просто проверяя любую старую вещь

Некоторые люди просто тестируют что-либо, не задумываясь.

У них появляется идея для изменения, и они хотят протестировать ее, но без реального анализа того, как страница в настоящее время конвертируется, или даже того, почему тестируемое изменение может иметь значение. (Возможно, они снижают конверсию, но даже не знают об этом, так как они еще не отслеживают базовый результат).

Формирование гипотезы о том, в чем заключается проблема, ее причина и способ ее решения, будет иметь огромное значение для вашей программы тестирования.

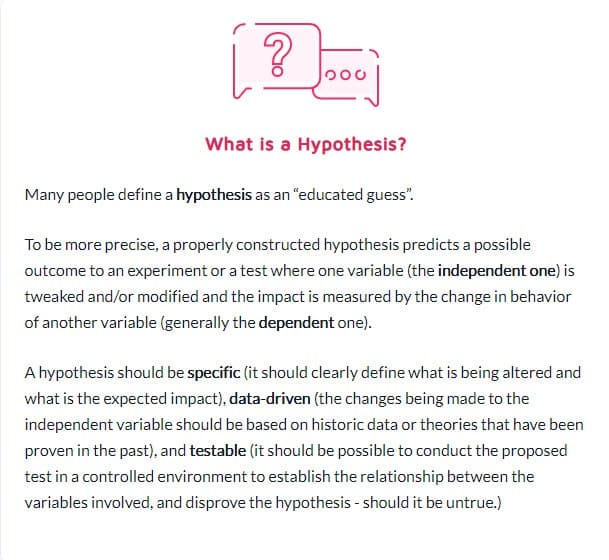

№8. Наличие непроверяемой гипотезы

Не каждая гипотеза верна. Это хорошо. На самом деле это слово буквально означает: «У меня есть идея, основанная на информации X, и я думаю, что Y может произойти в обстоятельствах Z».

Но вам понадобится гипотеза, которую можно проверить, то есть ее можно доказать или опровергнуть путем тестирования. Поддающиеся проверке гипотезы приводят инновации в движение и способствуют активному экспериментированию. Они могут привести либо к успеху (в этом случае ваша догадка была верна), либо к неудаче, показывая, что вы все время были неправы. Но они дадут вам представление. Это может означать, что ваш тест должен быть выполнен лучше, ваши данные были неверными/прочитаны неправильно, или вы нашли что-то, что не работает, что часто дает представление о новом тесте, который может работать намного лучше.

№ 9. Не ставить четкую цель для своего теста заранее

Когда у вас есть гипотеза, вы можете использовать ее, чтобы согласовать с конкретным результатом, которого хотите достичь.

Иногда люди просто запускают кампанию и смотрят, что изменилось, но вы определенно получите больше потенциальных клиентов/конверсий или продаж, если у вас будет четкое представление о том, в каком конкретном элементе вы хотите увидеть рост.

(Это также мешает вам увидеть падение важного элемента, но считать тест выигрышным, потому что он «получил больше акций».)

Говоря о которых…

№10. Сосредоточенность на поверхностных метриках

Ваш тест всегда должен быть привязан к метрикам Guardrail или какому-то элементу, напрямую влияющему на ваши продажи. Если это больше лидов, то вы должны с точностью до доллара знать, сколько стоит лид и ценность повышения коэффициента конверсии.

В то же время обычно следует избегать метрик, которые не связаны с измеримым результатом или не влияют на него. Больше лайков на Facebook не обязательно означает больше продаж. Удалите эти кнопки социальных сетей и просто посмотрите, сколько лидов вы получите. Будьте осторожны с метриками тщеславия и помните, что если одна утечка устранена, это не означает, что нет другой утечки в другом месте!

Вот список общих показателей для экспериментальных программ, составленный Беном Лабеем:

№ 11. Использование только количественных данных для формирования тестовых идей

Использование количественных данных для получения идей — это прекрасно, но в этом есть и небольшой изъян. Особенно, если мы используем только данные из нашей аналитики.

Почему?

Из наших данных мы можем знать, что X человек не кликнули, но мы можем не знать, почему.

- Кнопка находится слишком низко на странице?

- Это неясно?

- Соответствует ли это тому, что хочет зритель?

- Он вообще работает?

Лучшие тестировщики также слушают свою аудиторию. Они узнают, что им нужно, что движет ими вперед и что их сдерживает, а затем используют это для формулирования новых идей, тестов и письменных текстов.

Иногда ваших пользователей сдерживают проблемы с доверием и неуверенность в себе. В других случаях это ясность и ломаные формы или плохой дизайн. Суть в том, что количественные данные не всегда могут вам сказать, поэтому всегда спрашивайте свою аудиторию и используйте их для планирования.

№ 12. Копирование ваших конкурентов

Готовы к секрету?

Большую часть времени ваши конкуренты просто наживаются на этом. Если у них нет кого-то, кто проводил долгосрочные кампании по повышению эффективности, они могут просто пробовать что-то, чтобы увидеть, что работает, иногда без использования каких-либо данных для своих идей.

И даже тогда то, что работает у них, может не работать у вас. Так что да, используйте их для вдохновения, но не ограничивайте свои тестовые идеи только тем, что вы видите в них. Вы даже можете выйти за пределы своей отрасли в поисках вдохновения и посмотреть, не породит ли это каких-то гипотез.

№ 13. Только тестирование «лучших отраслевых практик»

Опять же, то, что работает для одного, не всегда работает для другого.

Например, изображения-слайдеры обычно имеют ужасную производительность, но на некоторых сайтах они могут увеличить количество конверсий. Тестируйте все. Вам нечего терять, и все можно приобрести.

№ 14. Сосредоточьтесь сначала на задачах с небольшим воздействием, когда доступно большое вознаграждение/легко висящие плоды.

Мы все можем быть виновны в том, что сосредоточиваемся на мелочах. У нас может быть страница, которую мы хотим улучшить, протестировать дизайн макета, изображения и даже цвета кнопок. (Лично у меня есть страница продаж, которая находится на пятой итерации.)

Дело в том, что, вероятно, есть гораздо более важные страницы для тестирования прямо сейчас.

Приоритет воздействия больше всего:

- Будет ли эта страница напрямую влиять на продажи?

- Есть ли другие страницы в процессе продаж, которые сильно отстают?

Если это так, сосредоточьтесь на них в первую очередь.

Повышение на 1% на продающей странице — это здорово, но повышение на 20% на странице, которая приводит их туда, может быть гораздо важнее. (Особенно, если именно на этой странице вы теряете большую часть своей аудитории.)

Иногда мы ищем не только больше подъемной силы, но и исправление чего-то, что является узким местом.

Испытайте и улучшите самое большое влияние, самое низкое висит в первую очередь. Это то, что делают агентства, и именно поэтому они проводят такое же количество тестов, как и внутренние команды, но с более высоким ROI. Агентства получают на 21% больше выигрышей при том же объеме тестов!

№ 15. Тестирование нескольких вещей одновременно и незнание того, какое изменение вызвало результат

Нет ничего плохого в том, чтобы проводить радикальные тесты, когда вы одновременно меняете несколько вещей и полностью переделываете дизайн страницы.

На самом деле, эти радикальные редизайны иногда могут иметь наибольшее влияние на ваш ROI, даже если у вас низкий трафик, и особенно если вы находитесь на плато и, кажется, не можете получить больше подъема.

Но имейте в виду, что не каждое A/B-тестирование должно быть направлено на такие радикальные изменения. В 99% случаев мы просто тестируем изменение одной вещи, например

- Новые заголовки

- Новые изображения

- Новый макет того же контента

- Новые цены и т.д.

Ключевым моментом при выполнении одноэлементного теста является именно это. Держите свой тест только на ОДНОМ изменении элемента, чтобы вы могли видеть, что имеет значение, и учиться на этом. Слишком много изменений, и вы не знаете, что сработало.

№ 16. Не проведен надлежащий предварительный анализ

Достаточно ли посетителей в вашей тестовой группе? Стоит ли вообще тратить время на тест?

Делать математику! Убедитесь, что у вас достаточно трафика, прежде чем запускать тест, иначе это просто пустая трата времени и денег. Многие тесты терпят неудачу из-за недостаточного трафика или плохой чувствительности (или того и другого).

Выполните предварительный анализ, чтобы определить размер выборки и минимальный обнаруживаемый эффект для вашего эксперимента. Калькулятор значимости A / B-тестирования, такой как Convert, сообщит вам размер выборки и MDE для вашего теста, что поможет вам решить, стоит ли его запускать. Вы также можете использовать эту информацию, чтобы определить, как долго должен выполняться тест и насколько малый подъем вы не хотели бы пропустить, прежде чем сделать вывод, был ли тест успешным или нет.

№ 17. Неправильная маркировка тестов

Супер простая ошибка, но она случается. Вы неправильно маркируете тесты, а затем получаете неправильные результаты. Вариант выигрывает, но он называется контролем, и тогда вы никогда не реализуете выигрыш и остаетесь с проигравшим!

Всегда перепроверяйте!

№ 18. Запуск тестов по неправильному URL

Еще одна простая ошибка. Либо URL-адрес страницы был введен неправильно, либо тест выполняется на «тестовом сайте», где вы вносили изменения, а не на рабочей версии.

Это может выглядеть нормально для вас, но на самом деле не будет загружаться для вашей аудитории.

№ 19. Добавление произвольных правил отображения в тест

Опять же, вам нужно проверить одну вещь с вашим лечением и ничего больше.

Если это изображение, проверьте изображение. Все остальное должно быть одинаковым, включая время суток, когда люди могут видеть обе страницы!

Некоторые инструменты позволяют вам тестировать разное время суток, чтобы увидеть, как работает трафик в разные периоды времени. Это полезно, если вы хотите увидеть, когда ваш лучший трафик на вашем сайте, но не полезно, если страницы разделены по тому, кто их видит, И имеют разные варианты.

Например, трафик нашего собственного блога падает по выходным (как и у большинства бизнес-блогов).

Представьте, если бы мы запускали тест пн-ср на контрольной странице, а потом на обработке показывали трафик с пт-вс? У него будет гораздо меньший трафик для тестирования и, вероятно, другие результаты.

№ 20. Тестирование неправильного трафика для вашей цели

В идеале при проведении теста вы должны убедиться, что тестируете только один сегмент своей аудитории. Обычно это новые органические посетители, чтобы увидеть, как они реагируют на ваш первый раз на вашем сайте.

Иногда вам может понадобиться протестировать повторных посетителей, подписчиков электронной почты или даже платный трафик. Хитрость заключается в том, чтобы тестировать только один из них за раз, чтобы вы могли получить точное представление о том, как эта группа работает с этой страницей.

При настройке теста выберите аудиторию, с которой вы хотите работать, и удалите все остальные, которые могут исказить результат, например вернувшиеся посетители.

№ 21. Невозможность исключить вернувшихся посетителей из теста и искажение результатов

Мы называем это загрязнением образца.

По сути, если посетитель увидит страницу вашего сайта, вернется и увидит ваш вариант, то он отреагирует совсем иначе, чем если бы он увидел только одну из них.

Они могут быть сбиты с толку, отскакивать или даже конвертироваться выше просто из-за этих дополнительных взаимодействий.

Дело в том, что это приводит к тому, что ваши данные становятся загрязненными и менее точными. В идеале вы хотите использовать инструмент, который рандомизирует, какую страницу они видят, но затем всегда показывает им одну и ту же версию, пока тест не закончится.

№ 22. Не удалять ваши IP-адреса из теста

Говоря о загрязнении образцов, вот еще один способ загрязнить ваши данные (и в любом случае это хорошая практика для аналитики).

Обязательно заблокируйте IP-адреса вас и ваших сотрудников в инструменте аналитики и тестирования. Последнее, что вам нужно, это чтобы вы или член команды «отмечались» на странице и были отмечены в вашем тесте.

№ 23. Отсутствие сегментации вариантов контрольной группы (сетевой эффект)

Еще один вариант загрязнения, который встречается редко, но может случиться, особенно если у вас есть сеть для вашей аудитории.

Вот пример.

Допустим, у вас есть платформа, где ваша аудитория может общаться. Возможно, страница Facebook или раздел комментариев, но КАЖДЫЙ может получить к нему доступ.

В этой ситуации у вас могут быть люди, которые видят одну страницу, а другие видят вариант, но все они находятся в одной социальной сети. Это может фактически исказить ваши данные, поскольку они могут повлиять на выбор друг друга и взаимодействие со страницей. Linkedin сегментирует свою аудиторию при тестировании новых функций, чтобы предотвратить проблемы с сетевым эффектом.

В идеале вы хотите разделить связь между двумя тестовыми группами, пока тест не будет завершен.

№ 24. Запуск тестов во время сезонных событий или крупных событий сайта/платформы

Если вы не тестируете сезонное событие, вы никогда не захотите запускать тестовую кампанию во время праздников или любого другого крупного события, такого как специальная распродажа или мировое событие.

Иногда ты ничего не можешь с собой поделать. У вас будет тестовый запуск, а Google просто внедряет новое обновление ядра и портит ваши источники трафика в середине кампании *кашель*.

Лучше всего просто перезапустить после того, как все стихнет.

№ 25. Игнорирование культурных различий

У вас может быть цель для страницы, но вы также запускаете глобальную кампанию с несколькими вариантами, отображаемыми на разных языках и в разных странах.

Это необходимо учитывать при проведении теста. Некоторые изменения могут быть внесены глобально, например, простое изменение макета или добавление сигналов доверия и т. д.

В других случаях вам необходимо учитывать культурные различия. Как люди видят макет, как они рассматривают изображения и аватары на вашей странице.

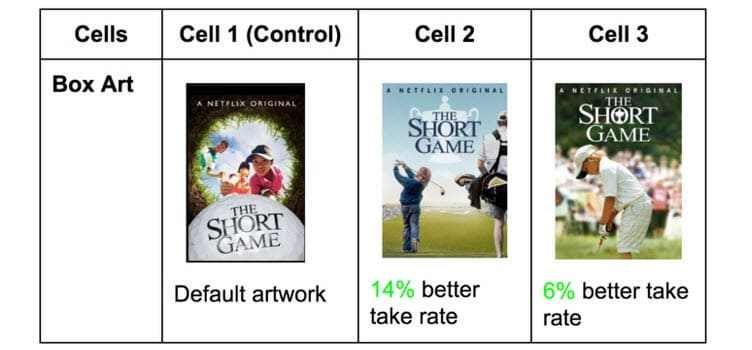

Netflix делает это с миниатюрами всех своих шоу, проверяя различные элементы, которые могут понравиться разной аудитории (вместо этого с участием конкретных актеров, известных в этой стране).

То, что получает клики в одной стране, может быть совершенно другим в других. Вы не узнаете, пока не проверите!

№ 26. Запуск нескольких связанных кампаний одновременно

Легко увлечься и захотеть запустить несколько тестов одновременно.

Просто помните: вы можете запускать несколько тестов для одинаковых точек в процессе продаж одновременно, но не запускайте несколько тестов для нескольких связанных точек в воронке.

Вот что я имею в виду.

Вы можете довольно легко запустить тесты на каждой странице лидогенерации, которая у вас есть, одновременно.

Тем не менее, вы не хотели бы тестировать лид-страницы, страницы продаж и страницы оформления заказа одновременно, так как это может ввести в процесс тестирования очень много разных элементов, требующих огромных объемов трафика и конверсий, чтобы получить какую-либо полезную информацию.

Мало того, каждый элемент может вызывать разные эффекты на следующей странице, как хорошие, так и плохие. Если у вас нет сотен тысяч посетителей в неделю, вам, вероятно, будет сложно получить точные результаты.

Так что наберитесь терпения и тестируйте только один этап за раз или страницы, которые не связаны в процессе.

Примечание:

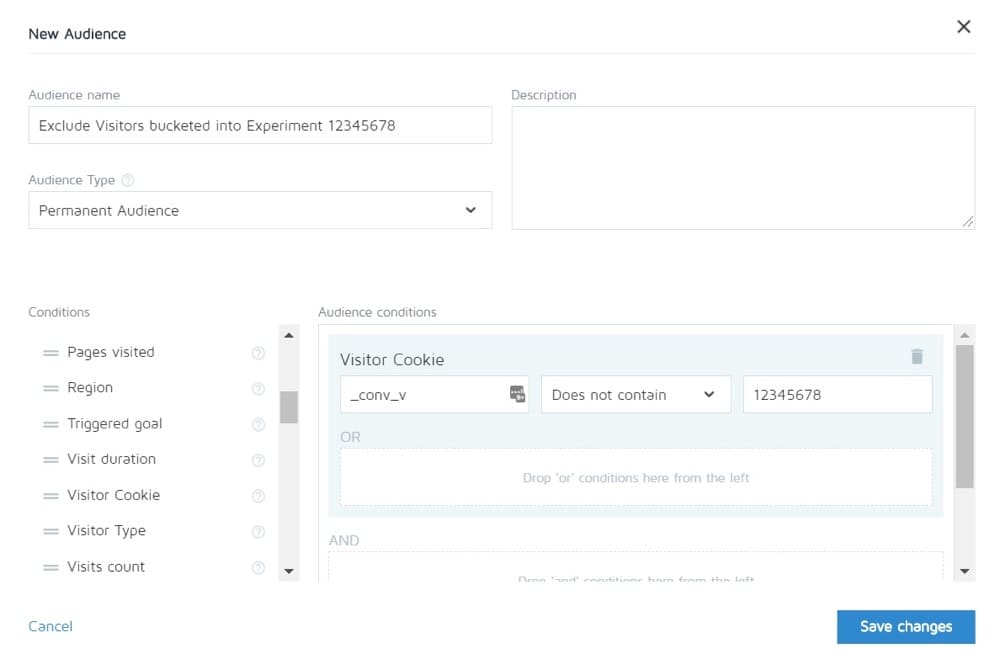

Преобразование позволяет исключить людей из одного эксперимента из просмотра любых других. Таким образом, теоретически вы можете протестировать полный цикл продаж, а затем увидеть контроль только на других страницах.

№ 27. Неравное взвешивание трафика

Неважно, используете ли вы A/B, A/B/n или многофакторный тест. Вам необходимо выделить одинаковый объем трафика для каждой версии, чтобы получить точные данные.

Установите их равными с самого начала. Большинство инструментов позволяют это сделать.

Распространенные ошибки A/B-тестирования, которые вы можете совершить во время тестирования

№ 28. Не работает достаточно долго, чтобы получить точные результаты

Есть 3 важных фактора, которые следует учитывать, если вы хотите провести тестирование и получить точные результаты:

- Статистическая значимость,

- Цикл продаж и

- Размер образца.

Итак, давайте сломаем это.

Большинство людей заканчивают тесты, как только их инструмент тестирования сообщает им, что один результат лучше другого, И результат является статистически значимым, т.е. если тест продолжает работать таким образом, то это определенный победитель.

Дело в том, что иногда вы можете довольно быстро достичь «статистического сигнала» с небольшим объемом трафика. Случайным образом все конверсии происходят на одной странице и ни одной на другой.

Хотя так будет не всегда. Может быть тест запущен, день зарплаты и у вас в этот день куча продаж.

Вот почему мы должны учитывать цикл продаж. Продажи и трафик могут колебаться в зависимости от дня недели или месяца. Чтобы получить более точное представление о том, как работает ваш тест, в идеале вам нужно запустить его продолжительностью от 2 до 4 недель.

Наконец, у вас есть размер выборки.

Если вы проводите тест в течение месяца, вы, вероятно, получите достаточно трафика, чтобы получить точные результаты. Слишком мало, и тест просто не сможет дать вам уверенность в том, что он будет работать должным образом.

Итак, как правило,

- Пойдите для рейтинга достоверности 95%.

- Бежать месяц.

- Выясните, какой размер выборки вам нужен заранее, и не останавливайте тест, пока он не будет достигнут, ИЛИ вы не получите какой-нибудь потрясающий результат, который без тени сомнения докажет, что у вас есть победитель.

№ 29. Вертолетный мониторинг / подглядывание

Подглядывание — это термин, используемый для описания того, когда тестер просматривает свой тест, чтобы увидеть, как он работает.

В идеале мы никогда не хотим смотреть на наш тест после его запуска и никогда не принимаем решения по нему, пока он не завершит полный цикл с правильным размером выборки и не достигнет статистической значимости.

Однако… Что делать, если тест не выполняется?

А если что-то сломается?

Ну, в таком случае, вы же не хотите ждать месяц, чтобы увидеть, что он сломан, верно? Вот почему я всегда проверяю, дает ли тест результаты в контроле и варианте, через 24 часа после запуска.

Если я вижу, что они получают трафик и клики/конверсии, я ухожу и позволяю им делать свое дело. Я НЕ принимаю решений, пока тест не завершится.

№ 30. Не отслеживание отзывов пользователей (особенно важно, если тест влияет на прямое, немедленное действие)

Допустим, тест получает клики и трафик распределяется, так что он *выглядит* работающим, но вдруг вы начинаете получать отчеты о том, что люди не могут заполнить форму продажи. (Или, что еще лучше, вы получили автоматическое оповещение о том, что метрика ограждения упала ниже допустимого уровня.)

Что ж, тогда первой вашей мыслью должно быть, что что-то сломалось.

Это не всегда. Возможно, вы получаете клики от аудитории, которая не находит отклика в вашем предложении, но на всякий случай стоит проверить эту форму.

Если он сломан, исправьте его и перезапустите.

№ 31. Внесение изменений в процессе тестирования

Возможно, это было ясно из последних нескольких пунктов, но мы никогда не хотим вносить какие-либо изменения в тест после его запуска.

Конечно, что-то может сломаться, но это единственное изменение, которое мы должны сделать. Мы не меняем дизайн, не копируем и вообще ничего.

Если тест работает, позвольте ему работать, и пусть данные решат, что работает.

№ 32. Изменение % распределения трафика в середине теста или удаление неэффективных

Точно так же, как мы не меняем тестируемые страницы, мы не удаляем какие-либо варианты и не меняем распределение трафика в середине теста.

Почему?

Допустим, вы проводите A/B/n-тест с контролем и тремя вариантами. Вы запускаете тест и через неделю шаловливо подглядываете и замечаете, что 2 версии работают отлично, а одна плохо.

Теперь было бы заманчиво отключить «проигрышный» вариант и перераспределить трафик между другими вариантами, верно? Черт возьми… вы могли бы даже захотеть взять эти дополнительные 25% трафика и просто отправить их лучшему исполнителю, но не делайте этого.

Почему?

Это перераспределение не только повлияет на производительность теста, но может напрямую повлиять на результаты и на то, как они отображаются в инструменте создания отчетов.

Всех пользователей, которые ранее были привязаны к удаленному варианту, необходимо будет переназначить на другой вариант, и через короткий промежуток времени они увидят измененную веб-страницу, что может повлиять на их поведение и последующий выбор.

Вот почему вы никогда не меняете трафик и не отключаете варианты на полпути. (А также почему вы не должны подглядывать!)

№ 33. Не останавливать тест, когда у вас есть точные результаты

Иногда вы просто забыли остановить тест!

Он продолжает работать и направляет 50% вашей аудитории на более слабую страницу и 50% на победителя. Ой!

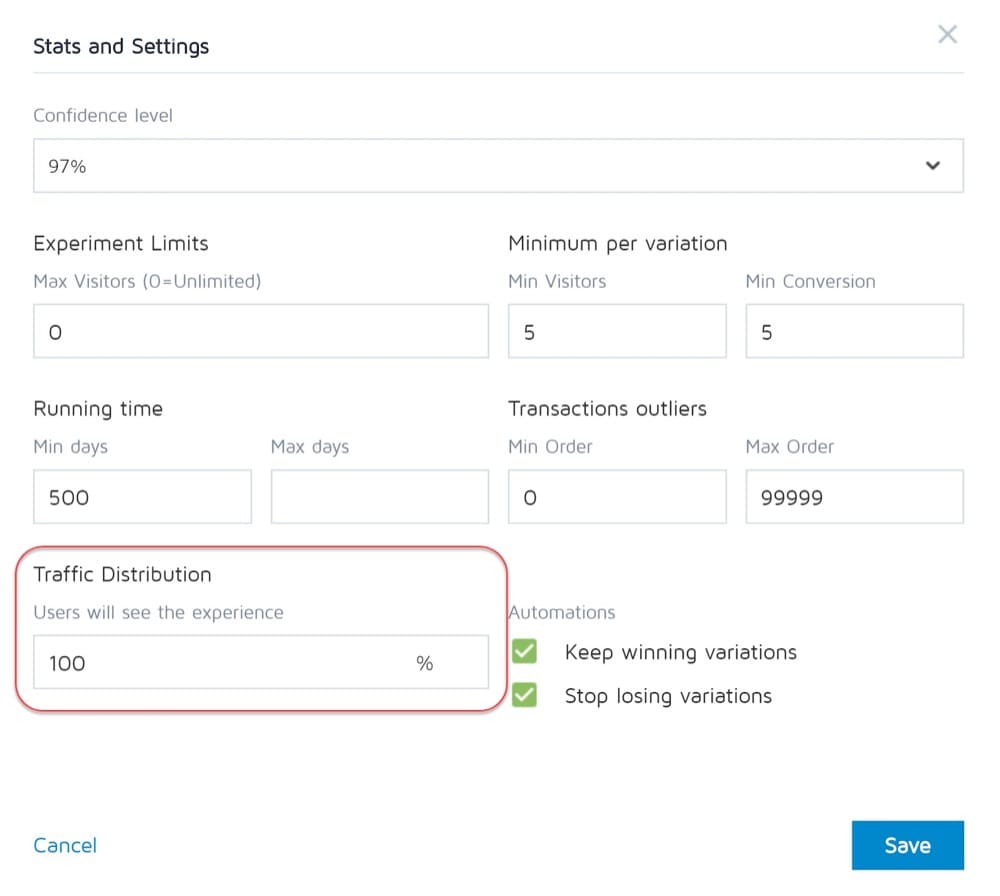

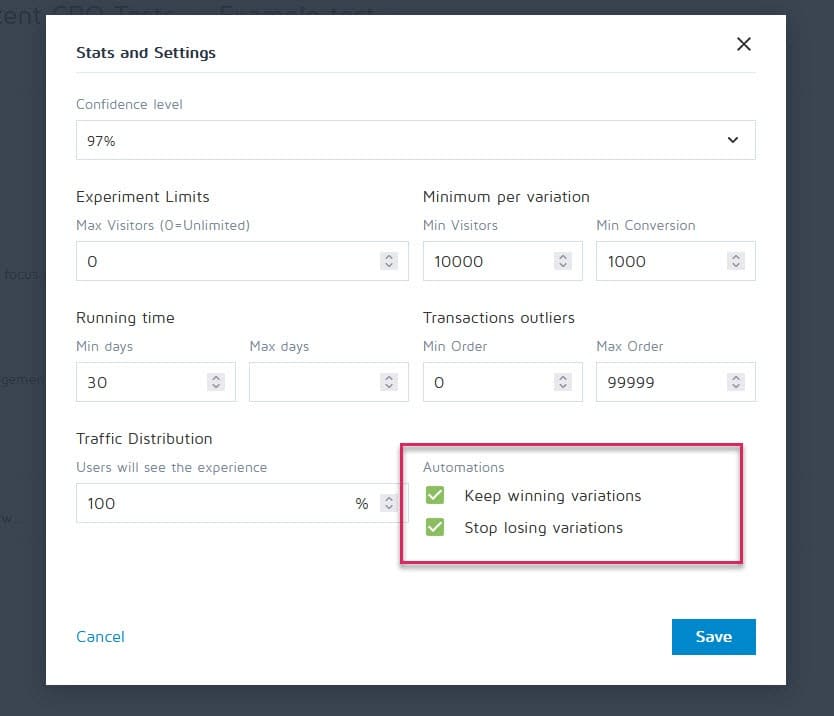

К счастью, такие инструменты, как Convert Experiences, можно настроить так, чтобы остановить кампанию и автоматически показать победителя, когда она соответствует определенным критериям (таким как размер выборки, статистический показатель, конверсии и временные рамки).

№ 34. Эмоционально вкладываться в проигрышные варианты

Как тестировщики, мы должны быть беспристрастными. Однако иногда у вас может быть определенный дизайн или идея, которые вам просто нравятся, и вы убеждены, что они должны были победить, поэтому вы продолжаете продлевать тест все дольше и дольше, чтобы увидеть, продвинется ли он вперед.

Стяните пластырь.

У вас может быть хорошая идея, которую просто нужно улучшить, но вы не сможете сделать это, пока не завершите текущий тест.

№ 35. Запуск тестов слишком долго и отслеживание падает

Вот еще одна потенциальная проблема загрязнения образца.

Если вы проводите тест более 4 недель, есть вероятность, что вы увидите, что файлы cookie пользователей исчезнут. Это может привести к отсутствию отслеживания событий, но они могут даже вернуться и снова загрязнить выборочные данные.

№ 36. Не использовать инструмент, позволяющий остановить/выполнить тест!

Еще одна редкая проблема.

Некоторые программы тестирования настаивают на создании жестко закодированных тестов. т.е. разработчик и инженер строят кампанию с нуля.

Однако это не очень хорошо, когда тест закончился, и вам нужно дождаться, пока тот же разработчик выключит его и установит выигрышный вариант. Это не только разочаровывает, но и может серьезно замедлить количество тестов, которые вы можете запустить, и даже рентабельность инвестиций страницы в ожидании ее запуска.

Распространенные ошибки A/B-тестирования, которые вы можете совершить после завершения теста

№ 37. Сдаюсь после одного теста!

9 из 10 тестов обычно проваливаются.

Это означает, что вам нужно провести 10 тестов, чтобы определить победителя. Это требует усилий, но оно того стоит, так что не останавливайтесь после одной кампании!

№ 38. Отказ от хорошей гипотезы до того, как вы проверите все ее версии

Неудача может просто означать, что ваша гипотеза верна, но ее нужно реализовать лучше.

Попробуйте новые способы, новый дизайн, новый макет, новые изображения, новые аватары, новый язык. У вас есть идея, и посмотрите, сможете ли вы реализовать ее лучше.

CXL потребовалась 21 итерация, чтобы улучшить страницу своего клиента, но коэффициент конверсии увеличился с 12,1% до 79,3%.

№ 39. Ожидание огромных выигрышей все время

Дело в том, что вы можете получить огромный выигрыш только в 1 из каждых 10 или более выигрышных кампаний.

Хорошо. Мы продолжаем тестировать и улучшать, потому что даже увеличение на 1% со временем смешивается. Улучшите его и доведите до 2%, и теперь вы удвоили эффективность.

Какие типы тестов дают наилучшие результаты?

Правда в том, что разные эксперименты дают разные результаты. Согласно исследованию Якуба Линовски, основанному на более чем 300 тестах, эксперименты с компоновкой, как правило, приводят к лучшим результатам.

Какой тип экрана труднее всего оптимизировать? То же исследование показывает, что это экраны оформления заказа (средний эффект +0,4% по результатам 25 тестов).

№ 40. Не проверяется валидность после теста

Итак, испытание закончено. Вы бегали достаточно долго, видели результаты и получили статистику, но можете ли вы доверять точности данных?

Возможно, что-то сломалось во время тестирования. Проверить никогда не помешает.

№ 41. Не правильно прочитали результаты

О чем на самом деле говорят ваши результаты? Неспособность прочитать их правильно может легко лишить потенциального победителя и показаться полным неудачником.

- Погрузитесь глубоко в свою аналитику.

- Посмотрите на любые качественные данные, которые у вас есть.

Что сработало, а что нет? Почему так случилось?

Чем больше вы понимаете свои результаты, тем лучше.

№ 42. Не смотреть результаты по сегментам

Всегда стоит нырнуть немного глубже.

Например, может показаться, что новый вариант плохо конвертируется, но на мобильных устройствах он увеличивает конверсию на 40%!

Вы можете узнать это, только сегментировав результаты. Посмотрите на используемые устройства и результаты там. Возможно, вы найдете ценную информацию!

Просто помните о значении размера вашего сегмента. Возможно, у вас недостаточно трафика для каждого сегмента, чтобы полностью доверять ему, но вы всегда можете запустить тест только для мобильных устройств (или любого другого канала) и посмотреть, как он работает.

№ 43. Не учиться на результатах

Проигрыш тестов может дать вам представление о том, что вам нужно улучшить или провести дополнительные исследования. Самое неприятное для CRO — видеть клиентов, которые отказываются учиться на том, что они только что видели. У них есть данные, но они не используют их…

№ 44. Принимая проигравших

Или, что еще хуже, берут проигрышный вариант.

Может быть, они предпочитают дизайн, а коэффициент конверсии отличается всего на 1%, но со временем эти эффекты усиливаются. Возьмите эти маленькие победы!

№ 45. Не принимать меры по результатам

Опять еще хуже?

Добиться победы, но не реализовать ее! У них есть данные, и они просто ничего не делают с ними. Никаких изменений, никаких прозрений, никаких новых тестов.

№ 46. Не повторять и улучшать победы

Иногда вы можете получить лифт, но это еще не все. Как мы уже говорили ранее, очень редко каждая победа дает двузначный прирост.

Но это не значит, что вы не можете достичь этого, запуская новые итерации и улучшения и прокладывая себе путь на 1% за раз.

Все это складывается, так что продолжайте совершенствоваться!

№ 47. Не делиться успешными выводами с другими областями или отделами

Одна из самых важных вещей, которые мы наблюдаем в гиперуспешных/зрелых CRO-командах, — это то, что они делятся своими достижениями и выводами с другими отделами компании.

Это дает другим отделам представление о том, как они могут улучшить свою работу.

- Найдите какой-нибудь выигрышный экземпляр продающей страницы? Предварительно создайте его в своих объявлениях, чтобы привлечь их на страницу!

- Найдите стиль лид-магнита, который отлично работает? Протестируйте его на всем сайте.

№ 48. Не тестировать эти изменения в других отделах

И это ключ здесь. Даже если вы делитесь информацией с другими отделами, вам все равно следует проверить, как это работает.

Стильный дизайн, который поднимает настроение в одной области, может ухудшить другие, поэтому всегда проверяйте!

№ 49. Слишком много итераций на одной странице

Мы называем это достижением «локального максимума».

Страница, на которой вы проводите тесты, зависла, и вы просто не можете получить от нее больше прибавки.

Вы можете попробовать радикально изменить дизайн, но что дальше?

Просто перейдите на другую страницу в процессе продаж и улучшите ее. (По иронии судьбы, это в любом случае может привести к более высокой рентабельности инвестиций.)

Повышение конверсии продающей страницы с 10% до 11% может быть менее важным, чем увеличение конверсии страницы, которая привлекает к ней трафик, с 2% до 5%, поскольку вы существенно увеличите трафик на предыдущей странице более чем в два раза.

Если вы сомневаетесь, найдите следующий по важности тест в своем списке и начните улучшать его. Вы даже можете обнаружить, что это помогает конверсии на застрявшей странице, просто предоставляя ей лучшие перспективы.

№ 50. Недостаточно тестирования!

Тесты требуют времени, и мы можем запустить их сразу не так много.

Так что мы можем сделать?

Просто сократите время простоя между тестами!

Завершите тест, проанализируйте результат и повторите или запустите другой тест. (В идеале, поставьте их в очередь и будьте готовы к работе).

Таким образом, вы увидите гораздо более высокую отдачу от вашего времени инвестиций.

№ 51. Не документирование тестов

Еще одна привычка зрелых CRO-команд — создание внутренней базы данных тестов, в которую входят данные о странице, гипотеза, что сработало, что нет, подъем и т. д.

Вы можете не только извлечь уроки из старых тестов, но и предотвратить случайное повторное выполнение теста.

№ 52. Забыть о ложных срабатываниях и не перепроверять кампании с большим подъемом

Иногда результат слишком хорош, чтобы быть правдой. Либо что-то было настроено или записано неправильно, либо это 1 из 20 тестов дает ложноположительный результат.

Так что ты можешь сделать?

Просто повторно запустите тест, установите высокий уровень достоверности и убедитесь, что вы проводите его достаточно долго.

№ 53. Не отслеживание результатов нижестоящих

При отслеживании результатов тестирования также важно помнить о конечной цели и отслеживать нижестоящие показатели, прежде чем определить победителя.

Технически новый вариант может получить меньше кликов, но увеличить продажи от людей, которые нажимают.

В этом случае эта страница на самом деле будет более прибыльной, если предположить, что трафик, по которому кликают, также продолжает конвертироваться…

№ 54. Не учитывают эффекты первичности и новизны, что может привести к искажению результатов лечения.

Допустим, вы ориентируетесь не только на новых посетителей с изменением, но и на весь трафик.

Мы по-прежнему сегментируем их, поэтому 50 % видят оригинал, а 50 % — новую версию, но мы разрешаем посетителям из прошлого участвовать в кампании. Это означает, что люди, которые видели ваш сайт раньше, читали ваш контент, видели ваши призывы к действию и т. д.

Кроме того, на время кампании они видят только свою конкретную тестовую версию.

Когда вы вносите новое изменение, оно может оказать эффект новизны на вашу предыдущую аудиторию.

Может быть, они все время видят один и тот же призыв к действию, а теперь просто игнорируют его, верно? В этом случае новая кнопка призыва к действию или дизайн могут получить поддержку от прошлых посетителей не потому, что они хотят этого больше сейчас, а потому, что это новое и интересное.

Иногда вы можете даже получить больше кликов, потому что макет изменился, и они изучают дизайн.

Из-за этого вы обычно получаете первоначальный подъем в ответ, но со временем он стихает.

Ключевым моментом при проведении теста является сегментация аудитории и проверка того, реагируют ли новые посетители так же хорошо, как старые.

Если он намного ниже, то это может быть эффект новизны, когда старые пользователи щелкают мышью. Если он находится на том же уровне, у вас может быть новый победитель.

В любом случае, дайте ему проработать полный цикл и сбалансировать.

№ 55. Изменения текущего периода рассмотрения

Еще одна вещь, которую следует учитывать при тестировании, — это любой вариант, который может изменить период рассмотрения аудитории.

Что я имею в виду?

Допустим, вы обычно не получаете немедленных продаж. Лиды могут иметь 30-дневный или даже более длительный цикл продаж.

Если вы тестируете призыв к действию, который напрямую влияет на их время на обдумывание и покупку, это исказит ваши результаты. Во-первых, ваш элемент управления может получить продажи, но не в период тестирования, поэтому вы их упустите.

Другой сценарий: если у вас есть CTA, который предлагает сделку, цену чего-либо еще, что заставляет их хотеть действовать сейчас, то это почти всегда будет искажать ваши результаты, чтобы эта версия выглядела так, как будто она намного лучше конвертируется.

Имейте это в виду и просматривайте свою аналитику во время и после теста, чтобы быть уверенным.

№ 56. Не проводить повторное тестирование через X раз

Речь идет не столько об определенной странице или ошибке теста, сколько о философии тестирования.

Да, у вас может быть потрясающая страница, и да, вы могли сделать 20 итераций, чтобы получить то, что есть сегодня.

Дело в том, что через несколько лет вам, возможно, придется снова переработать всю эту страницу. Среда меняется, язык и термины используются, продукт может быть изменен.

Всегда будьте готовы вернуться к старой кампании и повторно протестировать ее. (Еще одна причина, по которой наличие репозитория для тестирования отлично работает.)

№ 57. Только тестирование пути, а не продукта

Почти все мы сосредотачиваемся на пути к продаже и тестируем для этого. Но реальность такова, что продукт также можно тестировать и улучшать с помощью A/B, и он может даже предложить более высокий подъем.

Подумайте об айфоне.

Apple протестировала свой веб-сайт и улучшила его, но итерации и улучшения продукта продолжают приносить еще больший рост.

Теперь у вас может не быть физического продукта. У вас может быть программа или цифровое предложение, но узнать больше о потребностях вашей аудитории и протестировать ее, а затем вернуть ее на свою страницу продаж может быть ОГРОМНЫМ с точки зрения роста.

Вывод

Итак, у вас есть это. 57 распространенных и необычных ошибок A/B-тестирования, которые мы наблюдаем, и способы их избежать.

Вы можете использовать это руководство, чтобы обойти эти проблемы во всех будущих кампаниях.