Ce este testarea A/A și de ce ar trebui să le pese marketerilor?

Publicat: 2017-05-18Ai trecut prin acest scenariu? Ai configurat un test A/B pentru a descoperi dacă noua ta combinație de buton și titlu va genera mai multe conversii...

Generați trafic egal atât către paginile de destinație post-clic — controlul și variația — și vă opriți după o lună, când software-ul dvs. declară varianta dvs. câștigătoare cu 99% de încredere...

Lansați noul design „câștigător”, dar câteva cicluri de afaceri mai târziu, acea creștere cu 50% a ratei de conversie nu arată niciun impact asupra profitului dvs. Ești confuz. esti enervat…

Și probabil că ești victima unui rezultat fals pozitiv al testului.

Ce este un rezultat fals pozitiv al testului?

De ce acea creștere a ratei de conversie de 50% nu se traduce în mai multe vânzări? Motivul, spune Lance Jones de la Copyhackers, este că probabil că nu a existat.

Este absolut posibil (chiar probabil) să nu observați creșterea vânzărilor sau a veniturilor din testul dvs., deoarece nu a fost niciodată acolo. Este posibil să fi primit, fără să știți, un „fals pozitiv” în testul dumneavoastră – cunoscut sub numele de eroare statistică de tip I, altfel cunoscut sub numele de respingere incorectă a unei ipoteze nule adevărate. Este o gură, așa că pur și simplu îmi amintesc ca pe un fals pozitiv.

Cu gură sau nu, aceste erori statistice de tip 1 sunt mai frecvente decât ați crede. Se estimează că aproximativ 80% din rezultatele testelor AB sunt imaginare.

Faceți clic pentru a trimite pe Tweet

Dacă luați decizii cheie pe baza unor false pozitive, în cel mai bun caz, lăsați optimizarea la voia întâmplării. În cel mai rău caz, de fapt înrăutăți rata de conversie a paginilor de destinație post-clic.

Din fericire, există câteva modalități de a combate datele otrăvitoare. Una dintre ele este similară cu o metodă de testare cu care probabil ești deja familiarizat...

Ce este testarea A/A?

Testarea A/B implică direcționarea traficului către două pagini diferite — o versiune originală (controlul dvs.) și o altă versiune (variația dvs.) — pentru a vedea care are performanțe mai bune.

În mod similar, testarea A/A implică conducerea traficului către două pagini pentru a vedea care are performanțe mai bune. Dar, spre deosebire de un test A/B, un test A/A pune două pagini identice una împotriva celeilalte - și, în loc să descopere un lift, scopul lor este să nu găsească nicio diferență între controlul și variația dvs.

De ce ai face un test A/A?

Nu te învinovățim că te-ai zgâriat în cap, întrebându-ne „Ce naiba ar realiza testarea a două pagini identice una împotriva celeilalte?”

Poate suna prostesc, dar este o tehnică pe care unii testeri profesioniști o folosesc pentru a-și testa testul A/B înainte de a testa. (Huh?)

Rezultatele exacte ale testelor necesită mai mult decât o semnificație statistică

Oricine poate rula un test A/B, dar puțini pot rula un test A/B valid (rețineți: doar aproximativ 20% din rezultatele testelor sunt de fapt legitime).

Producerea de date exacte de testare implică mai mult decât atingerea semnificației statistice cu o dimensiune a eșantionului mare și reprezentativă. Pentru a avea încredere în rezultatele dvs., trebuie să vă asigurați că eșantionul nu este afectat de o serie de amenințări de valabilitate.

Una dintre aceste amenințări, efectul instrumentului, este ceea ce testele A/A sunt cele mai utile pentru combatere.

Care este efectul instrumentului?

Protecția împotriva amenințărilor de valabilitate începe chiar înainte de a începe testarea A/B. Efectul instrumentului, spune Peep Laja de la CXL, este ceea ce otrăvește cele mai multe rezultate ale testelor:

Aceasta este cea mai frecventă problemă. Este atunci când se întâmplă ceva cu instrumentele (sau instrumentele) de testare care provoacă date defecte în test. Se datorează adesea implementării greșite a codului pe site și va distorsiona toate rezultatele.

De aceea, atunci când configurați un test, este important să vă asigurați că instrumentele dvs. sunt configurate corect și funcționează așa cum ar trebui. Dacă nu sunt, pot apărea aceste probleme comune:

- Raportarea greșită a indicatorilor cheie de performanță. O singură eroare într-un singur instrument vă poate amesteca datele, motiv pentru care nu ar trebui să vă bazați niciodată pe o platformă unică pentru a urmări toate informațiile de testare. Cel puțin, integrați-vă cu Google Analytics pentru a verifica din nou dacă valorile pe care le vedeți în software-ul dvs. de testare și în urmărirea site-urilor web sunt corecte. Pentru rezultate și mai bune, verificați de trei ori cu un alt instrument. Fiți suspicios față de orice rapoarte care nu se potrivesc relativ strâns.

- probleme de afișare a paginii de destinație după clic. Micile greșeli de codare pot provoca mari amenințări de valabilitate, cum ar fi probleme de afișare, în timpul testului A/B. De aceea, este esențial să vă asigurați că paginile dvs. de destinație post-clic arată așa cum ar trebui să fie pe toate dispozitivele și browserele și că vizitatorii dvs. nu sunt afectați de ceva numit „efectul de pâlpâire”. Printre altele, un site web lent poate cauza această problemă, care apare atunci când controlul dvs. este afișat momentan vizitatorului dvs. chiar înainte de variație.

- Oprirea unui test prea devreme. Unele software de testare vor declara o pagină câștigătoare prematur - atunci când dimensiunea unui eșantion nu este suficient de mare sau nu este reprezentativă pentru clientul țintă. Rețineți: atingerea semnificației statistice nu înseamnă că este timpul să vă opriți testul. Cu cât îl rulați mai mult, cu atât rezultatele dvs. vor fi mai precise.

Oricare dintre aceste probleme (și multe altele) poate duce la un fals pozitiv la încheierea testului, motiv pentru care Peep îi avertizează pe testeri să fie vigilenți:

Când configurați un test, urmăriți-l ca un șoim. Observați că fiecare obiectiv și valoare pe care le urmăriți sunt înregistrate. Dacă o anumită valoare nu trimite date (de exemplu, adăugați în coșul de date despre clicuri), opriți testul, găsiți și remediați problema și începeți de la capăt prin resetarea datelor.

Dar nu toată lumea se simte confortabil să sară imediat la testarea A/B cu ambele picioare – mai ales când folosește un software nou. Deci, ca măsură suplimentară de precauție, unii practicieni testează A/A pentru a-și evalua instrumentele înainte de a începe testarea A/B.

Dacă experimentul este configurat corect, la sfârșitul unui test A/A, ambele pagini ar trebui să apară cu o rată de conversie similară. Totuși, așa cum arată următorii testeri, acest lucru nu se întâmplă întotdeauna.

Exemple de testare A/A

Sunt fals pozitive într-adevăr atât de comune? Poate o pagină să depășească cu adevărat clona sa? Acești tipi au folosit teste A/A pentru a afla și și-au dezvăluit constatările în următoarele postări de blog...

1. Testul împărțit în pagina de pornire dezvăluie deficiențele majore ale instrumentelor de testare populare

Pe 11 noiembrie 2012, echipa Copyhackers a început un test de împărțire A/A pe pagina lor de pornire, ilustrată mai jos:

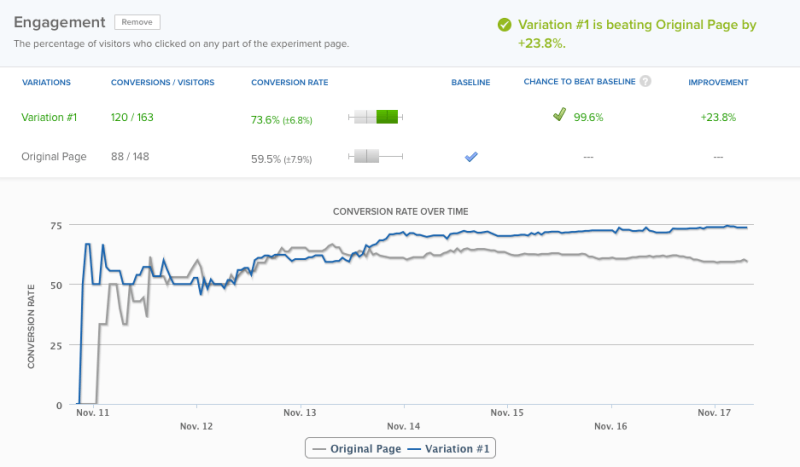

Pe 18 - 6 zile mai târziu - instrumentul lor de testare a declarat câștigător cu 95% încredere. Din motive de acuratețe, totuși, echipa a decis să mai lase testul să ruleze încă o zi – moment în care software-ul lor a declarat câștigător la un nivel de încredere de 99,6%:

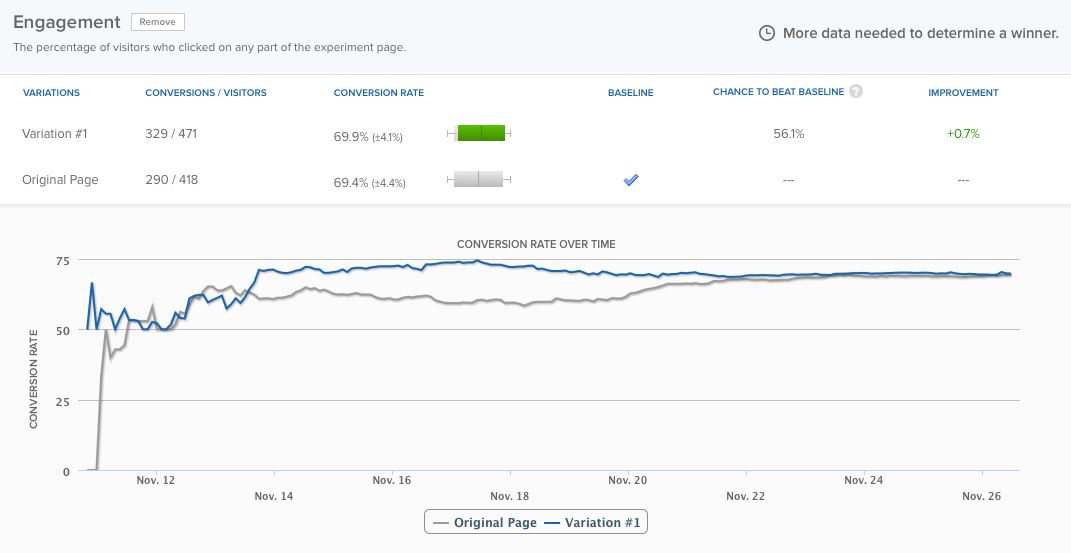

Pagina lor de pornire avea performanțe cu aproape 24% mai bune decât aceeași pagină și existau doar 0,4% șanse ca rezultatul să fie fals pozitiv, potrivit software-ului. Totuși, echipa a lăsat testul să ruleze încă trei zile, iar diferențele s-au uniformizat în cele din urmă:

Dar nu asta este ideea. Ideea este: instrumentul de testare a declarat un câștigător prea devreme. Dacă echipa Copyhackers nu ar fi continuat să funcționeze, ar fi presupus în mod incorect că a existat o problemă cu experimentul lor. Citiți mai multe despre test aici.

2. Testare A/A: Cum am crescut conversiile cu 300% fără a face absolut nimic

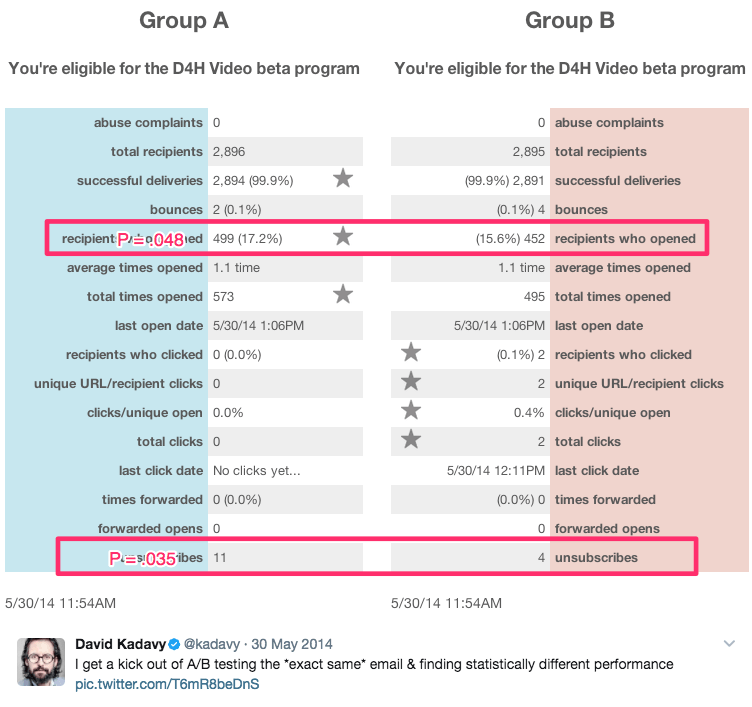

Acest titlu sarcastic provine de la autorul și autoproclamatul „recuperator wantrepreneur”, David Kadavy, care a efectuat o serie de teste A/A timp de 8 luni pe 750.000 de abonați la e-mail. În acest timp, el a generat rezultate semnificative statistic, precum acestea:

Printre aceste rezultate au fost:

- Se deschide o creștere de 9% a e-mailului

- O creștere de 300% a clicurilor

- O rată de dezabonare cu 51% mai mică

El spune:

Pentru mulți dintre cei care doresc (inclusiv fostul meu eu), acest lucru arată ca „oh, wow, ați crescut deschiderile cu 10%!” Ei pot chiar să-l introducă în calculatorul de semnificație al Optimizatorului de site web vizual și să vadă că p=.048. „Este semnificativ statistic!” ei (sau eu) am putea exclama.

Adevărul este, totuși, toate acestea au fost teste A/A. Conținutul testat unul împotriva celuilalt a fost identic. Vezi mai multe dintre rezultatele sale aici.

Ar trebui să faceți teste A/A?

Răspunsul la această întrebare depinde de cine întrebi.

Neil Patel, care a continuat să vadă creșteri mari de conversie care nu au echivalat cu mai multe venituri, spune „Este foarte important să efectuați mai întâi un test A/A, deoarece acest lucru vă va ajuta să vă asigurați că nu pierdeți timpul cu software inexact.”

Pe de altă parte, Peep Laja de la CXL spune că testele A/A în sine sunt o pierdere de timp. Deci cine are dreptate?

Cele două probleme majore cu testarea A/A

Din punct de vedere teoretic, testarea A/A are foarte mult sens. Mai presus de toate, acuratețea este cea mai importantă atunci când rulați un test A/B, iar testarea testului este doar una dintre multele modalități de a vă asigura.

În mediile de testare din lumea reală, totuși, testele A/A au potențialul de a face mai mult rău decât bine. Craig Sullivan explică:

Pentru mine, problema este consumul de trafic real și timpul de testare, deoarece trebuie să preîncărcați timpul de rulare a testului cu o perioadă de testare A/A. Dacă încerc să rulez 40 de teste pe lună, acest lucru îmi va paraliza capacitatea de a obține lucruri live. Prefer să am o jumătate de zi de testare QA pe experiment decât să rulez 2-4 săptămâni de testare A/A pentru a verifica alinierea.

Asta e problema unu. Testele A/A costă timp real și trafic pe care l-ați putea folosi pentru a afla mai multe despre vizitatorii site-ului dvs. cu testele A/B.

Problema a doua este exemplificată în studiul de caz de la Copyhackers. La fel ca testele A/B, testele A/A trebuie proiectate și monitorizate cu atenție, deoarece sunt de asemenea susceptibile la rezultate fals pozitive.

Cu alte cuvinte, testul A/A vă poate spune că o pagină are performanțe mai bune decât cealaltă, atunci când nu este (acea șansă este mult mai mare decât credeți - în jur de 50%)

Dacă echipa de la Copyhackers ar fi ascultat instrumentul lor de testare și ar fi declarat câștigător la doar șase zile, ar fi petrecut și mai mult timp încercând să descopere de ce pagina lor de pornire avea performanțe mai bune decât geamănul ei identic (când chiar nu era) .

Beneficiul major al testării A/A

În ciuda acestor probleme, testarea A/A are potențialul de a vă ajuta să detectați probleme și mai mari în timpul testelor reale . Atunci când rezultatele acestor teste sunt cele pe care vă bazați deciziile importante de afaceri, acesta este un avantaj puternic de luat în considerare.

Dacă decideți să testați A/A, există o modalitate potențial mai puțin risipitoare de a face acest lucru, numită testare A/A/B.

Testarea A/A/B vs. testarea A/A

Metoda tradițională de testare A/A risipește trafic, deoarece nu vă spune nimic despre vizitatorii dvs. la încheierea ei. Dar, dacă adăugați o variație „B” la acel test, s-ar putea. Iată diferența dintre cele două:

- Test A/A = 2 pagini identice testate una față de cealaltă

- Test A/A/B = 2 pagini identice și o variantă testată una față de cealaltă

Un test A/A/B împarte traficul în trei segmente, ceea ce înseamnă că va dura mai mult pentru a atinge semnificația statistică. Dar partea pozitivă este că, odată ce o faci, vei avea date atât despre instrumentul tău de testare, cât și despre vizitatori.

Comparați rezultatele A vs. A pentru a determina dacă puteți avea încredere în testul dvs. Dacă sunt similare din punct de vedere statistic, comparați rezultatele A vs. B. Dacă nu sunt, totuși, va trebui să aruncați rezultatele întregului test (care a durat mai mult decât un test tradițional A/A pentru a rula deoarece traficul dvs. este segmentat în trei moduri).

Beneficiile testării A/A depășesc dezavantajele?

Unii experți spun „da”, în timp ce alții spun „nu”. Andrew First de la Leadplum pare să creadă că răspunsul se află undeva între:

Testarea A/A probabil că nu ar trebui să fie o afacere lunară, dar atunci când configurați un nou instrument, merită să vă faceți timp pentru a vă testa datele. Dacă interceptați date proaste acum, veți fi mai încrezător în rezultatele testării dvs. luni după linie.

În cele din urmă, depinde de tine. Dacă utilizați un instrument nou, poate fi înțelept să urmați sfatul lui Andrew. Dacă nu ești, totuși, probabil cel mai bine este să urmezi exemplul lui Craig Sullivan și, în schimb, să stabilești un proces riguros de pre-testare QA. Economisiți timp, resurse și trafic pentru testarea A/B.

Profitați la maximum de eforturile dvs. de testare și de campaniile de anunțuri digitale, înscrieți-vă pentru o demonstrație Instapage Enterprise astăzi.