Cum să începeți să vă clasați mai sus cu un buget de accesare cu crawlere mai bine optimizat

Publicat: 2018-09-06Există mai mulți factori care afectează clasamentele - linkuri externe, utilizarea cuvintelor cheie, viteza site-ului și multe, multe altele. Dar când începeți să vă optimizați site-ul, ceea ce trebuie să rețineți este că, pentru ca toate eforturile dvs. de optimizare de a plăti, site-ul dvs. trebuie accesat cu crawlere și indexat.

Modul în care este accesat cu crawlere site-ul dvs. este determinat de bugetul dvs. de accesare cu crawlere - numărul de ori când Googlebot vă vizitează site-ul într-o anumită perioadă de timp. Iar vizibilitatea site-ului dvs. depinde de cât de bine este echilibrat bugetul de accesare cu crawlere.

De ce bugetul de accesare cu crawlere afectează vizibilitatea site-ului dvs. în Google?

Bugetul de accesare cu crawlere este limitat. Asta creează mai multe provocări:

- Când bugetul de accesare cu crawlere nu este optimizat, nu toate paginile site-ului sunt vizitate de Googlebot. Prin urmare, acestea nu sunt indexate și nu se clasează în rezultatele căutării.

- Paginile actualizate nu pot primi atenție de la Googlebot pentru o lungă perioadă de timp din cauza frecvenței de accesare cu crawlere a paginilor celorlalte site-uri web. Acest lucru vă afectează negativ cronologia SEO: atâta timp cât Google nu știe despre eforturile dvs. de optimizare, vizibilitatea dvs. SERP nu se va îmbunătăți.

Deci, pentru a vă asigura că toate paginile importante sunt vizitate în mod regulat, bugetul de accesare cu crawlere trebuie optimizat. Iată cum o poți face.

Cum să determinați bugetul actual de accesare cu crawlere

Pentru a vă da seama dacă bugetul dvs. de accesare cu crawlere necesită optimizare, verificați mai întâi dacă nu aveți nevoie de el. Potrivit lui Gary Illyes de la Google, doar site-urile mari trebuie să prioritizeze ceea ce să acceseze cu crawlere, în special cele care generează automat o mulțime de adrese URL pe baza parametrilor. Dacă credeți că site-ul dvs. necesită o echilibrare suplimentară a bugetului de accesare cu crawlere, iată cum puteți începe.

În Google Search Console, puteți găsi statisticile de accesare cu crawlere a site-ului dvs. actual și puteți afla detaliile bugetului de accesare cu crawlere.

Bugetul aproximativ pentru accesare cu crawlere poate fi calculat astfel:

Numărul mediu de pagini accesate cu crawlere pe zi x numărul de zile dintr-o lună =

Bugetul aproximativ pentru accesare cu crawlere

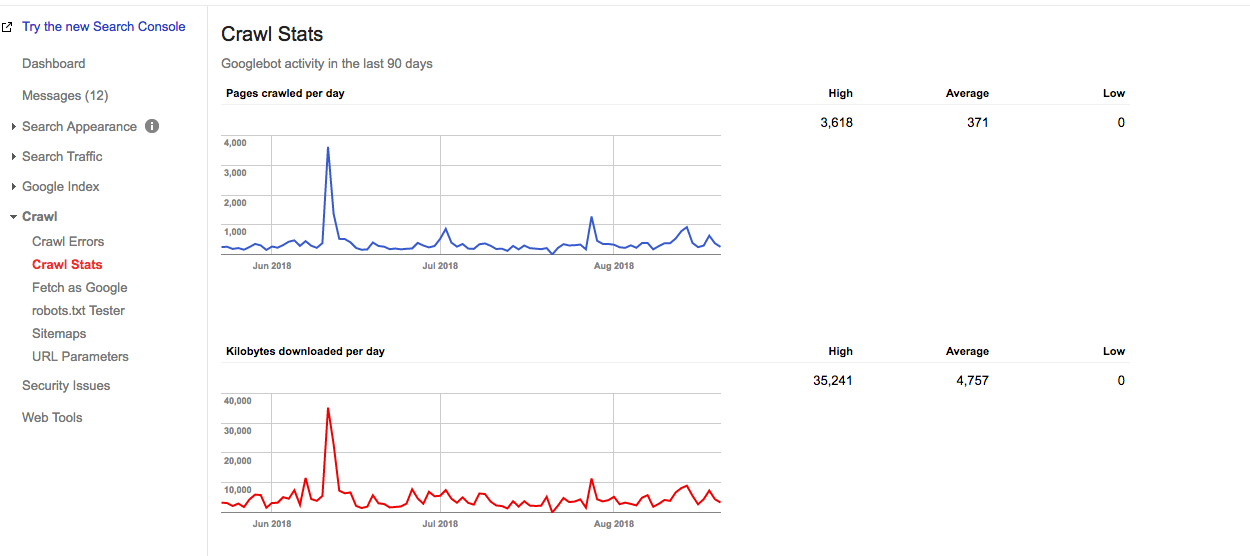

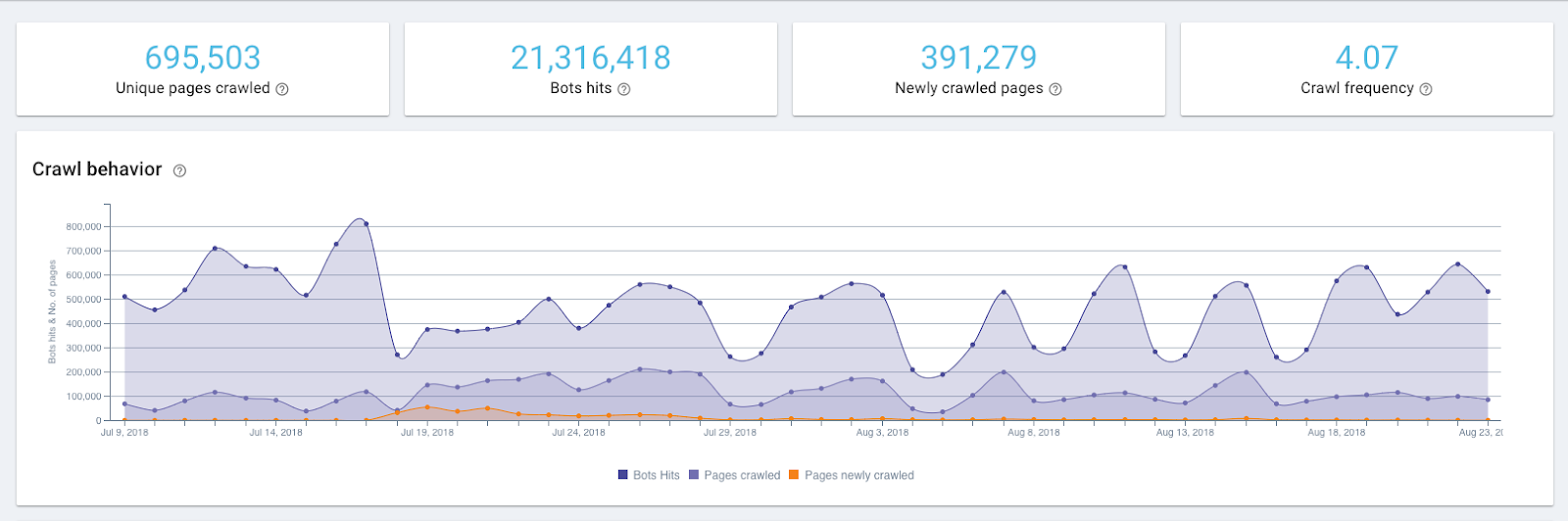

De exemplu, dintr-un raport de mai jos, puteți vedea că pe acest site Google accesează cu crawlere 371 de pagini pe zi.

Graficul Statistici de accesare cu crawlere în Google Search Console

Astfel, un buget de accesare cu crawlere aproximativ al acestui site web este:

371 x 30 = 11130

Dar pentru a ști exact cât de des accesează crawlerele Google site-ul dvs., trebuie să verificați jurnalele serverului. Google Search Console arată bugetul de accesare cu crawlere agregat pentru 12 roboți și, pentru a vedea distribuția exactă a bugetului de accesare cu crawlere, veți avea nevoie de un instrument de analiză a jurnalelor.

Sușurile și coborâșurile din graficul de accesare cu crawlere pot fi un semn al unei probleme, dar nu este întotdeauna cazul. De exemplu, un vârf în graficul de mai sus reprezintă un sitemap retrimis, care este un declanșator pentru ca un Googlebot să revină site-ul.

Cum să vă optimizați bugetul de accesare cu crawlere

Pentru a optimiza bugetul de accesare cu crawlere, trebuie să respectați o regulă simplă:

Asigurați-vă că ceea ce trebuie accesat cu crawlere este accesat cu crawlere, iar ceea ce nu trebuie accesat cu crawlere nu este accesat cu crawlere.

Asta înseamnă că paginile importante primesc suficientă atenție, iar cele care nu aduc nicio valoare site-ului tău sunt omise. Iată pașii exacti care te vor duce acolo.

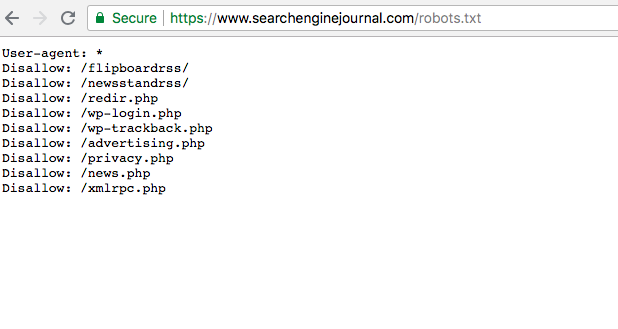

1. Asigurați-vă că toate paginile dvs. importante sunt accesibile de Googlebot (de exemplu, nu sunt blocate în robots.txt)

În mod surprinzător, este foarte comun când paginile importante au o stare de respingere în fișierul robots.txt. În acest fel, ele sunt ignorate de Googlebot și, astfel, sunt ascunse de indexare. Sarcina dvs. este să vă asigurați că paginile pe care doriți să le accesați cu crawlere nu au această stare și sunt accesibile crawlerelor.

Puteți găsi fișierul robots.txt în Google Search Console. Pentru a vă asigura că paginile dvs. importante nu sunt respinse, doar răsfoiți fișierul.

2. Verificați starea generală a site-ului dvs., deoarece aceasta afectează frecvența vizitelor Googlebot (cunoscută și sub denumirea de limită a ratei de accesare cu crawlere)

După cum spune Google însuși, limita ratei de accesare cu crawlere este rata maximă de preluare pentru un anumit site. Mai simplu spus, specifică câte conexiuni paralele poate crea un robot Google pentru a accesa cu crawlere site-ul și cât timp ar trebui să aștepte între preluări. Când viteza site-ului este mare și, limita crește și Googlebot creează mai multe conexiuni simultane. Când rata de răspuns a site-ului este scăzută sau returnează erori de server, limita scade și Googlebot accesează cu crawlere mai puțin.

Astfel, modul în care este accesat cu crawlere site-ul dvs. este afectat și de starea de sănătate a site-ului. Aceasta include viteza site-ului, compatibilitatea cu dispozitivele mobile, numărul de erori 404 etc.

Sănătatea site-ului poate fi verificată cu aceste instrumente.

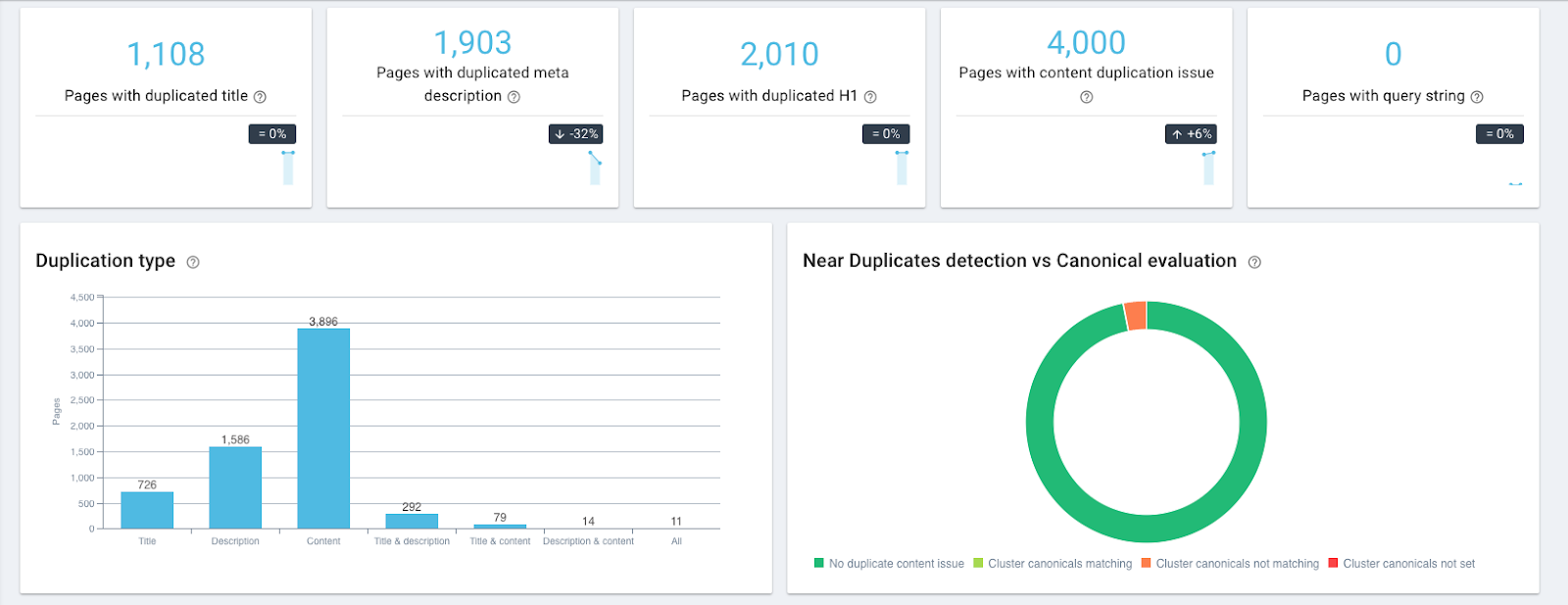

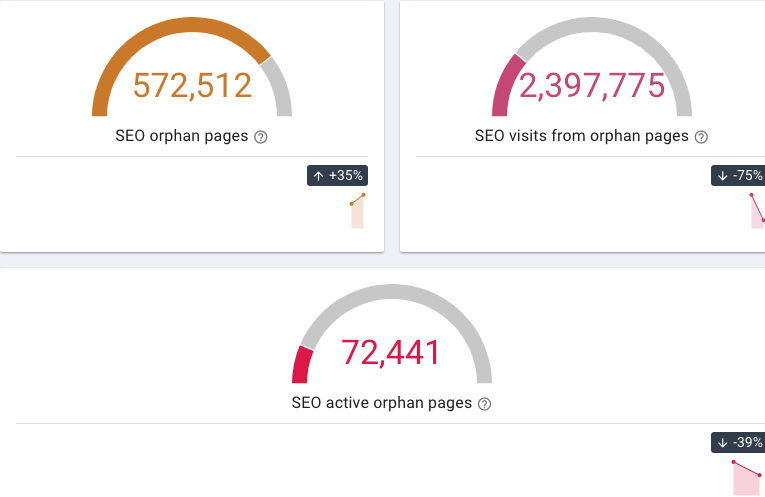

- OnCrawl vă permite să găsiți pagini cu conținut duplicat și aproape duplicat, pagini 404 și orfane (care nu au link-uri interne care să trimită către acesta) etc.

Widgeturi de conținut duplicat în OnCrawl

Widgeturi pentru pagini orfane în OnCrawl

- Testul de compatibilitate cu dispozitivele mobile de la Google verifică compatibilitatea cu dispozitivele mobile a unui site web

- Viteza site-ului poate fi verificată cu ajutorul instrumentelor gratuite PageSpeed Insights sau GTmetrix.

Puteți monitoriza apoi frecvența accesării cu crawlere folosind un analizor de fișiere jurnal precum OnCrawl și puteți vedea dacă Googlebot a accesat paginile mai des.

3. Excludeți paginile care nu aduc utilizatorilor nicio valoare

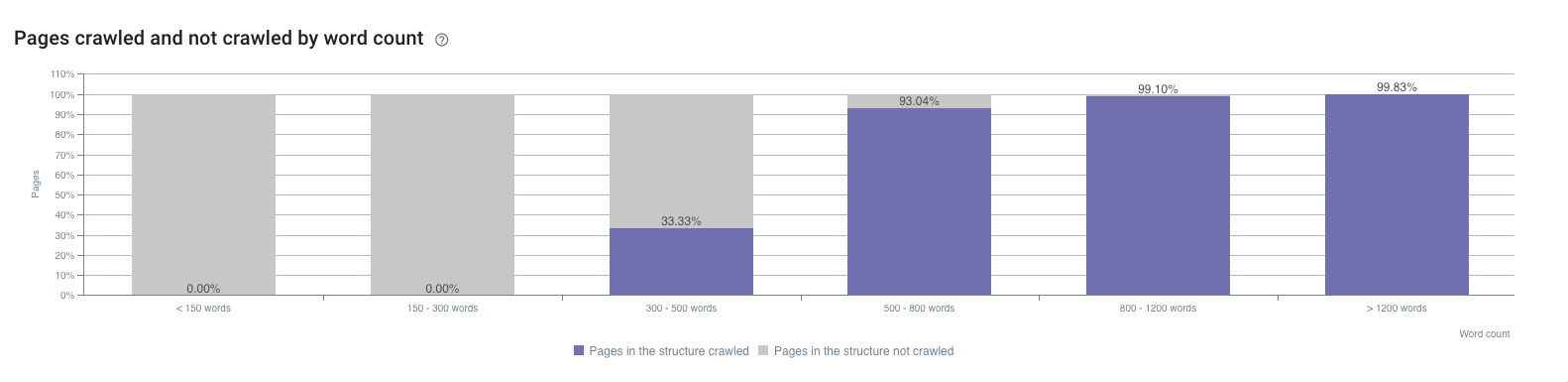

Acestea sunt paginile care au conținut slab sau inexistent, pagini tehnice etc. Deoarece sunt indexate și au puține impresii, pot fi găsite în Google Search Console. Un alt loc pentru a le identifica este raportul OnCrawl SEO Impact. De exemplu, arată impactul numărului de cuvinte asupra frecvenței de accesare cu crawlere.

De exemplu, o problemă comună pentru site-urile mari de comerț electronic este navigarea cu fațete. Ryan Stewart vorbește despre asta în videoclipul său despre optimizarea bugetului de accesare cu crawlere (puteți sări la 7:20 pentru a verifica acest lucru, dar întregul videoclip este, de asemenea, extrem de util). Când utilizatorul selectează o categorie pe un site web, parametrul acestuia este adăugat la adresa URL a paginii. Potrivit Googlebot, din acel moment, este o adresă URL diferită și necesită o vizită separată. Deoarece numărul de combinații posibile de categorii este mare și poate supraîncărca în mod semnificativ bugetul de accesare cu crawlere, astfel de pagini trebuie filtrate.

O problemă similară apare atunci când un identificator de sesiune este plasat în interiorul adreselor URL. Asemenea pagini ar trebui, de asemenea, filtrate.

4. Prioritizează-ți paginile astfel încât cele mai importante să fie accesate cu crawlere mai des

Pagina este importantă dacă are un potențial mare de trafic.

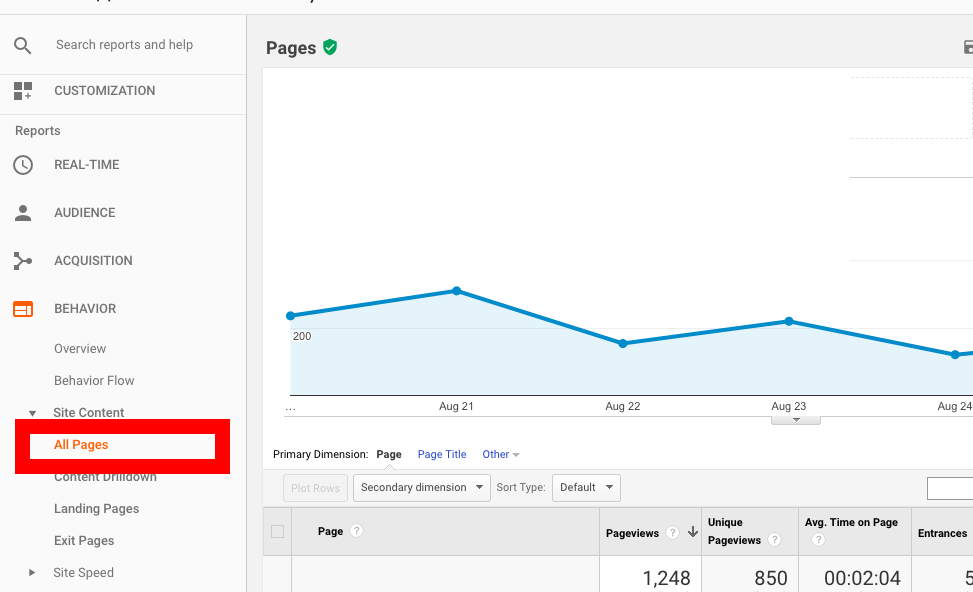

În primul rând, acestea sunt paginile care au deja mult trafic; le puteți identifica în Google Analytics. Sub Raportul de comportament , accesați Conținutul site -ului → Toate paginile și sortați paginile după numărul de afișări de pagină.

În al doilea rând, paginile ale căror poziții se îmbunătățesc, ceea ce înseamnă că sunt în creștere în popularitate. Astfel de pagini pot fi găsite în Google Search Console, dar cu opțiunile de filtrare limitate, ar putea dura ceva timp până să le descoperi.

O alternativă ar fi să utilizați AccuRanker, deoarece vă permite să vedeți ce fel de pagini au o tendință de vizibilitate în creștere. Pentru a începe să-l utilizați, puteți importa lista de cuvinte cheie din Google Search Console cu un singur clic și apoi puteți identifica ce pagini sunt cele mai promițătoare.

În plus, există o modalitate de a identifica paginile care pot avea trafic SEO suplimentar în următoarele săptămâni și luni. Implică câteva jocuri cu Google Search Console API și Google Data Studio, dar rezultatul este oarecum uimitor. Folosind Paginile de destinație ca dimensiune și Afișare, clicuri URL și CTR URL ca valori, puteți găsi paginile care cresc în popularitate mai repede decât celelalte.

Când aflați ce pagini necesită prioritizare, iată ce puteți face pentru a vă asigura că sunt accesate cu crawlere mai des:

- Mutați cele mai importante pagini mai aproape de pagina principală sau chiar prezentați linkul către ele acolo. De exemplu, puteți adăuga un link către o pagină la secțiunile Navigare sau „Oferte speciale”.

- Pune redirecționări 301 în toate categoriile de pagini care nu au produse (produse epuizate/produse sezoniere). Nu uitați să dezactivați acea redirecționare odată ce produsul în cauză este din nou în stoc.

5. Furnizați suficiente link-uri interne către pagină

Linkurile interne sunt esențiale pentru accesarea cu crawlere ca principală cale pentru Googlebot. Fără un link intern pe o pagină, pur și simplu nu poate merge mai departe. Deci, prin adăugarea de link-uri care duc la o pagină, creșteți șansele acesteia de a fi indexată mai devreme.

De exemplu, dacă doriți ca o pagină veche să fie accesată cu crawlere mai des, adăugați un link care să conducă la ea în paginile dvs. noi. Când Googlebot vizitează noua pagină, o va reindexa și pe cea veche.

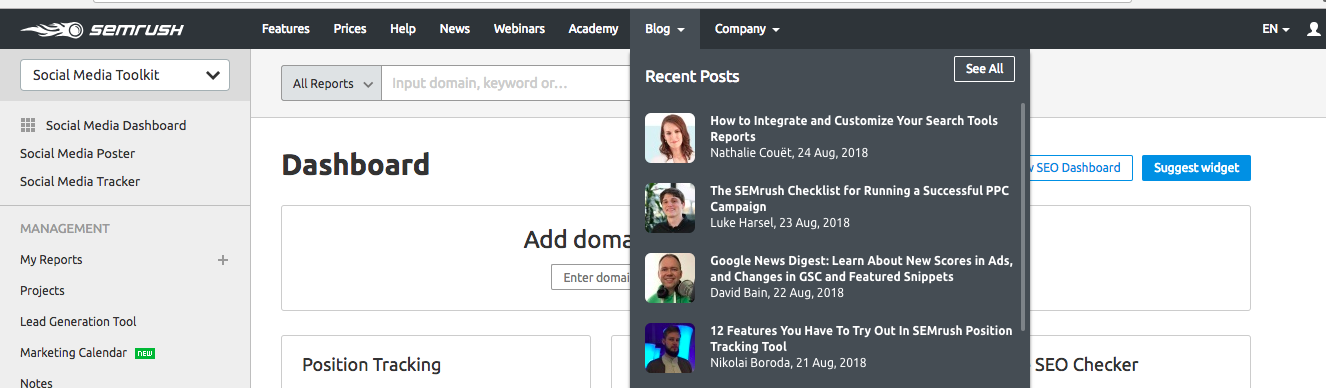

Adăugând linkul paginii în meniul de navigare al site-ului, îl faceți ușor accesibil de către utilizatori și de Googlebot. SEMrush folosește această tehnică pentru a accelera accesarea cu crawlere a noilor sale postări de blog. Toate articolele noi apar în secțiunea Postări recente de pe pagina lor principală și, astfel, sunt prioritizate de Googlebot.

Această tehnică poate fi folosită și pentru a accelera indexarea noilor pagini de produse pe site-urile de comerț electronic.

Încheierea

După cum sa menționat mai sus, optimizarea bugetului de accesare cu crawlere este mai importantă pentru site-urile mai mari cu o structură ramificată, cum ar fi site-urile de comerț electronic. Dar, deoarece accesarea corectă cu crawlere a paginii este fundamentul SEO și afectează direct vizibilitatea SERP, poate doriți să vă revizuiți statisticile de accesare cu crawlere și să echilibrați bugetul de accesare cu crawlere pentru a accelera rezultatele eforturilor dvs. de SEO.

Setul de instrumente de bază pentru optimizarea bugetului de accesare cu crawlere include:

- Google Search Console pentru a vedea estimarea actuală a bugetului pentru accesare cu crawlere

- Auditorii de sănătate a site-ului, cum ar fi OnCrawl, pentru a găsi conținut duplicat, 404 pagini, pagini orfane etc.

- Instrumente pentru a verifica compatibilitatea cu dispozitivele mobile ale site-ului dvs., cum ar fi Testul de compatibilitate cu dispozitivele mobile de la Google

- Verificator de viteză a site-ului, cum ar fi PageSpeed Insights sau GTmetrix

- Instrumente pentru a găsi paginile cu un potențial de popularitate ridicat — cele care au deja mult trafic (le puteți vedea în Google Analytics) sau cele cu un trend de vizibilitate în creștere (pot fi găsite cu ajutorul AccuRanker).