SEO într-o lume cu doi algoritmi: Pubcon Keynote de Rand Fishkin

Publicat: 2022-06-12 Rand dedică această prezentare Danei Lookadoo, care ne va fi mereu alături.

Rand dedică această prezentare Danei Lookadoo, care ne va fi mereu alături.

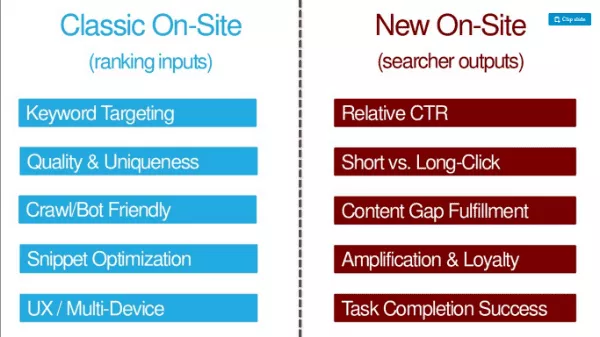

TL:DR a acestui autor: Pe lângă factorii tradiționali de optimizare SEO (intrări de clasare, cum ar fi direcționarea cuvintelor cheie, calitatea și unicitatea, ușurința cu crawlere/bot, optimizarea fragmentelor, optimizarea UX/multi-dispozitiv), SEO trebuie să optimizeze pentru rezultatele căutării ( cum ar fi CTR, clicuri lungi, îndeplinirea decalajului de conținut, amplificare și loialitate, succes la finalizarea sarcinilor).

Iată de unde puteți obține prezentarea: http://bit.ly/twoalgo

Îți amintești când aveam un singur loc de muncă? A trebuit să facem pagini perfect optimizate. Echipa de calitate a căutării ar obține o clasare și a folosit link-urile ca semnal major. Până în 2007, spam-ul pe linkuri era omniprezent. Fiecare SEO este obsedat de jocurile de apărare turn pentru că ne place să optimizăm. Chiar și în 2012, s-a părut că Google face mincinoși din lumea SEO cu pălărie albă (-Wil Reynolds).

Rand spune astăzi că această afirmație nu mai este adevărată. Conținutul autentic și excelent este recompensat de Google mai bine decât a fost vreodată. Google a șters practicile vechi de școală prin combaterea unor lucruri precum spamul de linkuri. Și au valorificat teama și incertitudinea de penalizare pentru a menține site-urile la linie. De multe ori este atât de periculos să folosim dezaprobări, încât mulți dintre noi ucid link-uri care oferă valoare site-urilor noastre, deoarece ne este atât de frică de penalități.

Google a devenit mai inteligent

Google a devenit, de asemenea, bun la descoperirea intenției. Ei privesc limba și nu doar cuvintele cheie.

Ei prezic rezultate diverse.

Și-au dat seama când vrem noi prospețime.

Ele pot separa interogările de navigare de cele informaționale. Ele conectează entitățile la subiecte și cuvinte cheie. Chiar și mărcile au devenit o formă de entități. Bill Slawski a remarcat că Google menționează mărci într-un număr de brevete depuse.

Google este mult mai în concordanță cu declarațiile lor publice. În cea mai mare parte, au o politică care se potrivește celui mai bun mod de a face marketing în căutare astăzi.

Poziția Google cu privire la învățarea automată s-a schimbat

În timpul acestor progrese, echipa Google pentru calitatea căutării a suferit o revoluție. La început, Google a respins învățarea automată în algoritmul lor de clasare organică. Google a spus că învățarea automată nu le-a lăsat să dețină, să controleze și să înțeleagă factorii din algoritm. Dar, mai recent, comentariile lui Amit Singhal sugerează că unele dintre acestea s-au schimbat.

În 2012, Google a publicat o lucrare despre modul în care utilizează învățarea automată pentru a prezice rata de clic pe anunțuri. Inginerii Google au apelat la sistemul lor SmartASS (se pare că acesta este de fapt numele sistemului!). Până în 2013, Matt Cutts a vorbit la Pubcon despre modul în care Google ar putea folosi învățarea automată (ML) în mod public în căutarea organică.

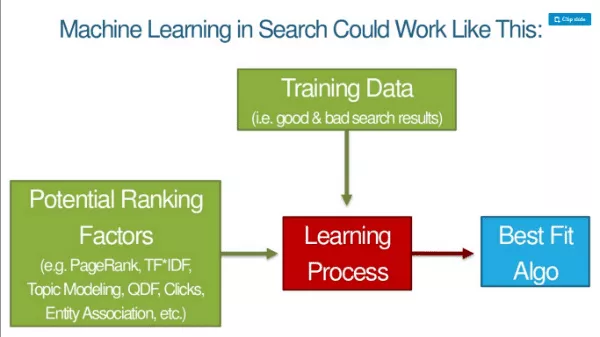

Pe măsură ce ML preia mai mult din algoritmul Google, bazele clasamentelor se schimbă. Google este public despre modul în care utilizează ML în recunoașterea și clasificarea imaginilor. Ei iau factori pe care i-ar putea folosi pentru a clasifica imaginile și apoi adaugă date de antrenament (lucruri care spun că ceva mașinii este o pisică, un câine, o maimuță etc.) și există un proces de învățare care îi duce la un algoritm de cea mai bună potrivire. Apoi, ei pot aplica acel model datelor live peste tot.

Prezentarea de diapozitive a reprezentantului Google Jeff Dean despre Deep Learning este o citire obligatorie pentru SEO. Rand spune că aceasta este o lectură esențială și nu prea dificilă de consumat. Jeff Dean este un coleg Google și cineva de care îi place să-și bată joc de mult la Google: „Viteza luminii într-un vid era înainte de aproximativ 35 de mile pe oră. Până când Jeff Dean a petrecut un weekend optimizând fizica.”

Sarituri, clicuri, timp de ședere — toate aceste lucruri sunt calități ale procesului de învățare automată, iar algoritmul încearcă să imite experiențele bune SERP. Vorbim despre un algoritm pentru a construi algoritmi. Google nu furnizează factori de clasare. Mașina le determină singură. Datele de antrenament sunt rezultate bune de căutare.

Ce înseamnă Deep Learning pentru SEO?

Google nu va ști de ce ceva se clasează sau dacă o variabilă se află în algoritm. Între cititor și Rand, nu seamănă foarte mult cu lucrurile pe care le spun Google acum? ;)

Valorile de succes ale interogărilor vor fi tot ceea ce contează pentru mașini:

- Raportul de clic lung spre scurt

- CTR relativ față de alte rezultate

- Rata de căutare care efectuează căutări similare suplimentare

- Rata de partajare/amplificare față de alte rezultate

- Valori de implicare a utilizatorilor pe întregul domeniu

- Valori privind implicarea utilizatorilor pe pagină (Cum? Prin utilizarea Chrome și Android)

Dacă multe rezultate pe un SERP fac toate cele de mai sus, atunci vor continua să includă asta. Vom optimiza mai mult pentru rezultatele căutării. Acestea vor fi probabil criteriile SEO pe site în viitor.

Bine, dar aceste valori ne afectează astăzi? În 2014, Moz a făcut un test de interogări și clicuri. De atunci, a fost mult mai greu să mutați acul cu interogări și clicuri brute. Google se prinde de clicuri brute și manipulări de interogări.

La SMX Advanced, Gary Illyes a spus că utilizarea clicurilor direct în clasamente nu ar avea prea mult sens cu acel zgomot. El a spus că erau oameni care produc zgomot în clicuri, strigând pe Rand Fishkin. - Caz inchis! Sau este … ?

Dar dacă am încerca clicuri lungi versus clicuri scurte? La 11:39 am pe 21 iunie , Rand le-a cerut oamenilor să facă un test în care au dat rapid clic înapoi pe rezultatul nr. 1 și apoi au făcut clic și s-au oprit pe rezultatul nr. 4. Rezultatul nr. 4 a rămas la poziția SERP nr. 1 timp de aproximativ 12 ore. Acest lucru ne spune că rezultatele căutării afectează clasamentele. (PS Acest lucru este greu de replicat. Nu o faceți, pentru că este magie întunecată.)

Ceea ce ar trebui să faci sunt lucruri care vor face în mod natural oamenii să dorească să facă clic pe rezultatul tău în SERP.

O alegere a doi algoritmi

Acesta este motivul pentru care Rand spune că optimizăm pentru doi algoritmi. Trebuie să alegem cum ne echilibrăm munca. Ciocan pe semnale de odinioară? Ei încă mai lucrează. Linkurile încă funcționează. Textul ancora mișcă în continuare acul. Dar putem vedea la orizont mai clar decât oricând înainte încotro se îndreaptă Google.

SEO on-site clasic (intrări de clasare) vs. SEO on-site nou (ieșiri de căutare):

Folosirea ambelor contează pentru că există doi algoritmi.

Elemente noi de SEO

Să vorbim despre cele cinci elemente noi ale SEO modern.

1. Depășește CTR-ul tău mediu

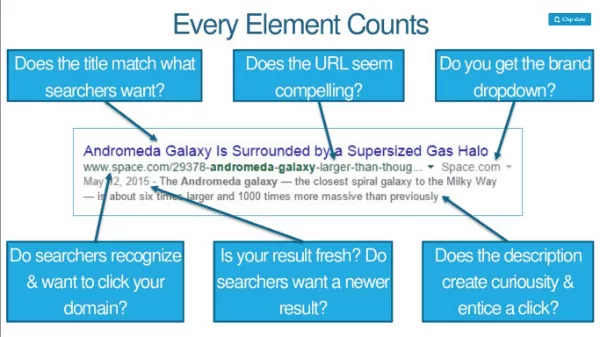

Optimizarea titlului, metadescrierea și URL-ul puțin pentru cuvinte cheie, dar mult pentru clicuri. Dacă vă clasați pe locul 3, dar vă puteți crește CTR-ul, puteți câștiga un spor în clasament. Fiecare element contează. Căutătorii recunosc și doresc să facă clic pe domeniul dvs.? URL-ul pare convingător? Primiți un meniu derulant al mărcii?

Creșteți CTR prin branding sau căutări de marcă și vă poate oferi un impuls suplimentar. Eforturile de branding (cum ar fi publicitatea la TV, radio, PPC) au un impact asupra CTR. Bugetul mărcii ajută la rata de clic relativă și tot felul de alte semnale de clasare, iar această creștere cauzează o parte din acest lucru.

Cu intervalele mai precise și personalizabile ale Google Trends, puteți urmări efectiv efectele evenimentelor și anunțurilor asupra volumului de interogări de căutare. De exemplu, există o creștere a interogărilor „fitbit” după ce Fitbit a difuzat anunțuri în NFL duminica.

2. Depășirea listelor SERP ale colegilor în ceea ce privește implicarea

Împreună, pogo-sticking-ul și clicurile lungi pot determina în mare măsură locul în care vă clasați (și pentru cât timp). Ce îi influențează? Iată o listă de verificare SEO pentru o implicare mai bună:

- Conținut care satisface nevoile conștiente și inconștiente ale celui care caută

- Viteză, viteză și mai multă viteză

- Oferă cel mai bun UX pe fiecare browser

- Convingerea vizitatorilor să intre mai adânc în site-ul dvs

- Evitarea funcțiilor care deranjează sau descurajează vizitatorii

Exemplu: The New York Times are elemente grafice de mare implicare, care le solicită vizitatorilor să deseneze cel mai bun rezultat al unui grafic.

3. Completarea lacunelor în cunoștințele vizitatorilor

Google caută semnale care să arate că o pagină îndeplinește toate nevoile unui căutător. Modelele ML pot observa că prezența anumitor cuvinte, expresii și subiecte prezic căutări mai reușite. Clasamentele merg către pagini/site-uri care umple golurile în cunoștințele celor care caută. SFAT: Consultați API-ul Alchemy sau MonkeyLearn. Rulați-vă conținutul prin ele pentru a vedea cum funcționează din perspectiva ML.

4. Câștigă mai multe acțiuni, link-uri și loialitate pe vizită

Datele de la Buzzsumo și Moz arată că foarte puține articole câștigă acțiuni/linkuri și că acestea două nu au nicio corelație. Oamenii împărtășesc o mulțime de lucruri pe care nu le-au citit niciodată. Google clasifică aproape cu siguranță diferite tipuri de SERP-uri diferit. O mulțime de acțiuni despre informații medicale, de exemplu, nu vor muta rezultatul în sus în clasament; acuratețea va fi mai importantă.

Un nou KPI: Partajări și linkuri la 1.000 de vizite. Vizite unice prin distribuiri + linkuri.

De asemenea, este esențial să știi ce îi face pe oameni să se întoarcă sau îi împiedică să facă acest lucru.

Nu avem nevoie de conținut mai bun, avem nevoie de conținut de 10X (adică conținut care este de 10 ori mai bun decât cel mai bun în prezent).

5. Îndeplinirea sarcinii celui care caută (nu doar interogarea acestuia)

Sarcină = ceea ce doresc să realizeze atunci când fac acea interogare. Google nu vrea o cale de căutare multiplă de interogări concentrate continuu. Ei doresc o căutare amplă pentru care să completeze toți pașii și tu să-ți îndeplinești sarcina.

Motorul de căutare ar putea folosi datele din fluxul de clic pentru a ajuta la clasarea unui site mai sus, chiar dacă acesta nu are semnale tradiționale de clasare. O pagină care răspunde la interogarea inițială poate să nu fie suficientă, mai ales dacă concurenții permit finalizarea sarcinii.

Algo 1: Google

Algo 2: Subset de umanitate care interacționează cu conținutul dvs. (în și în afara rezultatelor căutării)

„Fă pagini pentru oameni, nu pentru motoare” este un sfat teribil.

Motoarele au nevoie de multe dintre lucrurile pe care le-am făcut întotdeauna și ar fi bine să continuăm să facem asta. Oamenii au nevoie de lucruri suplimentare și mai bine facem și asta.

Linkuri bonus:

- http://bit.ly/10Xcontent

- http://bit.ly/sharesvslinks