Analiza fișierelor jurnal: alternativa inteligentă la Google Analytics

Publicat: 2022-03-08Știi ce se întâmplă pe site-ul tău în fiecare zi? Primul lucru care vă vine în minte atunci când răspundeți la această întrebare ar fi cel mai probabil să folosiți instrumente de urmărire a audienței și a comportamentului. Există multe astfel de instrumente disponibile pe piață, inclusiv: Google Analytics, At Internet, Matomo, Fathom Analytics și Simple Analytics pentru a numi doar câteva. Deși aceste instrumente ne permit să avem o imagine de ansamblu destul de bună asupra a ceea ce se întâmplă la un moment dat pe site-urile noastre web, practicile etice utilizate de aceste instrumente, mai precis Google Analytics, sunt din nou puse sub semnul întrebării.

Acest lucru sugerează că există și alte surse de date care în prezent nu sunt exploatate suficient de toți proprietarii de site-uri web: jurnalele.

Instrumente de analiză și GDPR (concentrare pe Google Analytics)

Datele cu caracter personal au devenit un subiect sensibil în Franța de la implementarea Regulamentului general privind protecția datelor (GDPR) și crearea Comisiei Naționale pentru Informatică și Libertăți (CNIL). Protecția datelor a devenit o prioritate.

Deci, site-ul dvs. este încă „compatibil cu GDPR”?

Dacă aruncăm o privire pe toate site-urile web, putem constata că mulți au găsit o modalitate de a ocoli regulile folosind cookie-urile lor (banere de colectare a datelor) pentru a aduna informațiile de care au nevoie, în timp ce alții încă aderă cu strictețe la reglementările oficiale.

Prin colectarea acestor informații, instrumentele de analiză a datelor ne permit să analizăm de unde provine publicul și comportamentul vizitatorilor. Acest tip de analiză necesită un plan de etichetare impecabil pentru a colecta cele mai fiabile și precise date posibile și, în cele din urmă, datele colectate sunt rezultatul fiecărei acțiuni și eveniment de pe un site.

În urma mai multor reclamații, CNIL a decis să pună la cunoştinţă Google Analytics, făcându-l ilegal în Franţa, deocamdată. Această sancțiune provine din aparenta lipsă de supraveghere în ceea ce privește transferul de date cu caracter personal către serviciile de informații din Statele Unite, deși informațiile vizitatorilor fuseseră anterior colectate cu consimțământ. Evoluțiile ar trebui monitorizate îndeaproape.

În acest context actual, cu acces limitat sau inexistent la Google Analytics, ar putea fi interesant să ne uităm la alte opțiuni de colectare a datelor. O compilație a evenimentelor istorice ale unui site și relativ ușor de recuperat, fișierele jurnal sunt o sursă excelentă de informații.

În ciuda faptului că fișierele jurnal oferă acces la o arhivă interesantă de informații de analizat, acestea nu ne permit să afișăm valorile afacerii sau comportamentul real al unui vizitator al site-ului, cum ar fi navigarea pe site de la început până în momentul în care validează un coș de cumpărături sau părăsește site-ul. site-ul. Aspectul comportamental rămâne însă specific instrumentelor menționate mai sus; analiza jurnalului ne poate ajuta să ajungem destul de departe.

Înțelegerea fișierelor jurnal

Ce sunt fișierele jurnal? Jurnalele sunt un tip de fișier a cărui misiune principală este de a stoca un istoric al evenimentelor.

Despre ce fel de evenimente vorbim? În esență, „evenimentele” sunt vizitatorii și roboții care vă accesează site-ul în fiecare zi.

Google Search Console poate colecta și aceste informații, dar din mai multe motive – în special motive de confidențialitate – aplică un filtru foarte specific.

(Sursa: https://support.google.com/webmasters/answer/7576553. „Diferențe între Search Console și alte instrumente”.)

În consecință, veți avea doar o mostră din ceea ce poate oferi o analiză de jurnal. Cu fișierele jurnal, aveți acces la 100% din date!

Analizarea liniilor fișierelor jurnal vă poate ajuta să prioritizați acțiunile viitoare.

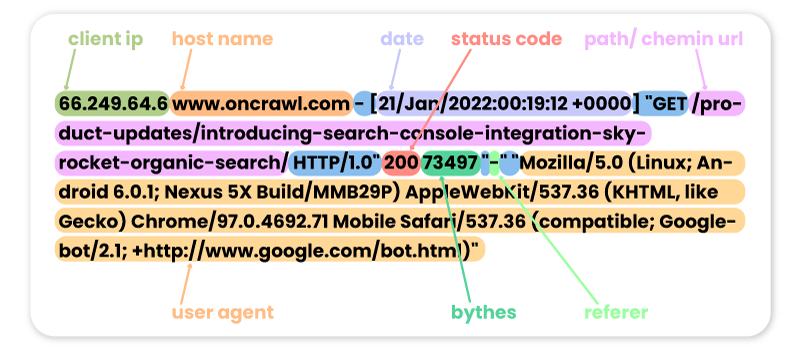

Iată câteva exemple de vizite anterioare pe site-ul Oncrawl de la diferiți roboți:

FACEBOOK:

66.220.149.10 www.oncrawl.com - [07/Feb/2022:00:18:35 +0000] "GET /feed/ HTTP/1.0" 200 298008 "-" "facebookexternalhit/1.1 (+http://www.facebook.com/externalhit_uatext.php)"

SEMRUSH:

185.191.171.20 fr.oncrawl.com - [13/Feb/2022:00:18:27 +0000] "GET /infographie/mises-jour-2017-algorithme-google/ HTTP/1.0" 200 50441 "-" "Mozilla/5.0 (compatible; SemrushBot/7~bl; +http://www.semrush.com/bot.html)"

BING:

207.46.13.188 www.oncrawl.com - [22/Jan/2022:00:18:40 +0000] "GET /wp-content/uploads/2018/04/url-detail-word-count.png HTTP/1.0" 200 156829 "-" "Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm)"

GOOGLE BOT:

66.249.64.6 www.oncrawl.com - [21/Jan/2022:00:19:12 +0000] "GET /product-updates/introducing-search-console-integration-skyrocket-organic-search/ HTTP/1.0" 200 73497 "-" "Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.71 Mobile Safari/537.36 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)"

Vă rugăm să rețineți că unele vizite bot pot fi false. Este important să vă amintiți să verificați adresele IP pentru a ști dacă acestea sunt vizite reale de la Googlebot, Bingbot etc. În spatele acestor agenți utilizatori falși, pot exista profesioniști care uneori lansează roboți pentru a vă accesa site-ul și a verifica prețurile, conținutul sau alte informațiile pe care le consideră utile. Pentru a le recunoaște, doar IP-ul va fi de ajutor!

Iată câteva exemple de vizite pe site-ul Oncrawl de către utilizatorii de internet:

De la Google.com:

41.73.11x.xxx fr.oncrawl.com - [13/Feb/2022:00:25:29 +0000] "GET /seo-technique/predire-trafic-seo-prophet-python/ HTTP/1.0" 200 57768 "https://www.google.com/" "Mozilla/5.0 (Linux; Android 10; Orange Sanza touch) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.98 Mobile Safari/537.36"

Din UTM-urile Google Ads:

199.223.xxx.x www.oncrawl.com - [11/Feb/2022:15:18:30 +0000] "GET /?utm_source=sea&utm_medium=google-ads&utm_campaign=brand&gclid=EAIaIQobChMIhJ3Aofn39QIVgoyGCh332QYYEAAYASAAEgLrCvD_BwE HTTP/1.0" 200 50423 "https://www.google.com/" "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/96.0.4664.110 Safari/537.36"

Din LinkedIn, mulțumim referrerului:

181.23.1xx.xxx www.oncrawl.com - [14/Feb/2022:03:54:14 +0000] "GET /wp-content/uploads/2021/07/The-SUPER-SEO-Game-Building-an-NLP-pipeline-with-BigQuery-and-Data-Studio.pdf HTTP/1.0" 200 3319668 "https://www.linkedin.com/"

[Ebook] Patru cazuri de utilizare pentru a utiliza analiza jurnalelor SEO

De ce să analizăm conținutul jurnalului?

Acum că știm ce conțin de fapt jurnalele, ce putem face cu el? Răspunsul: analizează-le, ca orice alt instrument de analiză.

Boți sau roboți

Aici, ne putem pune următoarea întrebare:

Care roboți petrec cel mai mult timp pe site-ul meu?

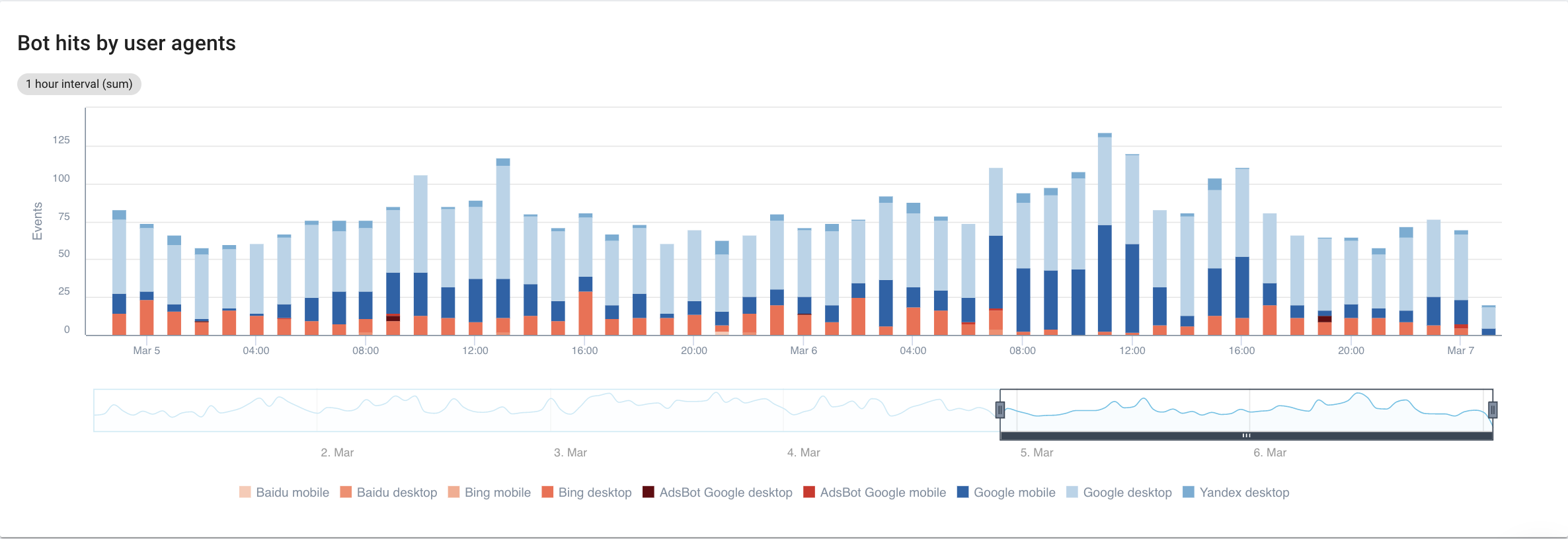

Dacă ne concentrăm pe motoarele de căutare, cu o vedere detaliată a fiecărui bot, iată ce putem vedea:

Sursa: aplicație Oncrawl

În mod clar, Google Mobile și Desktop petrec mult mai mult timp cu crawlere decât roboții Bing sau Yandex. Googlebot are o cotă de piață globală de peste 90%.

Dacă Google accesează cu crawlere paginile mele, acestea sunt indexate automat? Nu, nu neapărat.

Dacă ne întoarcem cu câțiva ani în urmă, Google a folosit un reflex automat pentru a indexa paginile imediat după ce le-a vizitat. Astăzi, acesta nu mai este cazul dat fiind volumul de pagini pe care trebuie să le proceseze. Ca rezultat, apare o luptă SEO în ceea ce privește bugetul de accesare cu crawlere.

Acestea fiind spuse, s-ar putea să vă întrebați: ce rost are să știm care bot petrece mai mult timp decât altul pe site-ul meu?

Răspunsul la această întrebare depinde de fiecare algoritm al roboților. Fiecare este puțin diferit și nu se întorc neapărat din aceleași motive.

Fiecare motor de căutare are propriul buget de accesare cu crawlere pe care îl împarte între acești roboți . Cu alte cuvinte, asta înseamnă că Google își împarte bugetul de accesare cu crawlere între toți acești roboți. Prin urmare, devine destul de interesant să privim puțin mai îndeaproape ce face GooglebotAds, mai ales dacă avem 404-uri în jur. Curățarea acestora este o modalitate de a optimiza bugetul de accesare cu crawlere și, în cele din urmă, SEO.

Analizor de jurnal oncrawl

Încrucișarea datelor Googlebot cu datele Oncrawl Crawler

Pentru a aprofunda analiza comportamentului Googlebot, Oncrawl încrucișează datele din jurnal cu datele de accesare cu crawlere pentru a obține cele mai detaliate și mai precise informații.

Scopul este, de asemenea, de a afirma sau infirma ipotezele legate de mai mulți KPI-uri precum profunzimea, conținutul, performanța etc.

În consecință, trebuie să vă puneți întrebările potrivite:

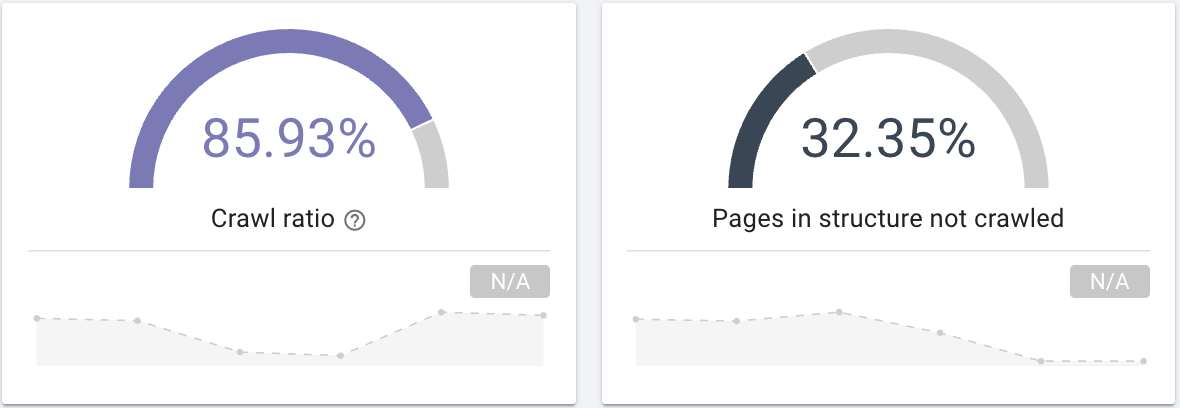

- Googlebot accesează cu crawlere toate paginile de pe site-ul dvs.? Interesați-vă de raportul de accesare cu crawlere, care oferă în mod clar aceste informații pe care le puteți filtra și cu o segmentare a paginilor dvs.

Sursa: aplicație Oncrawl

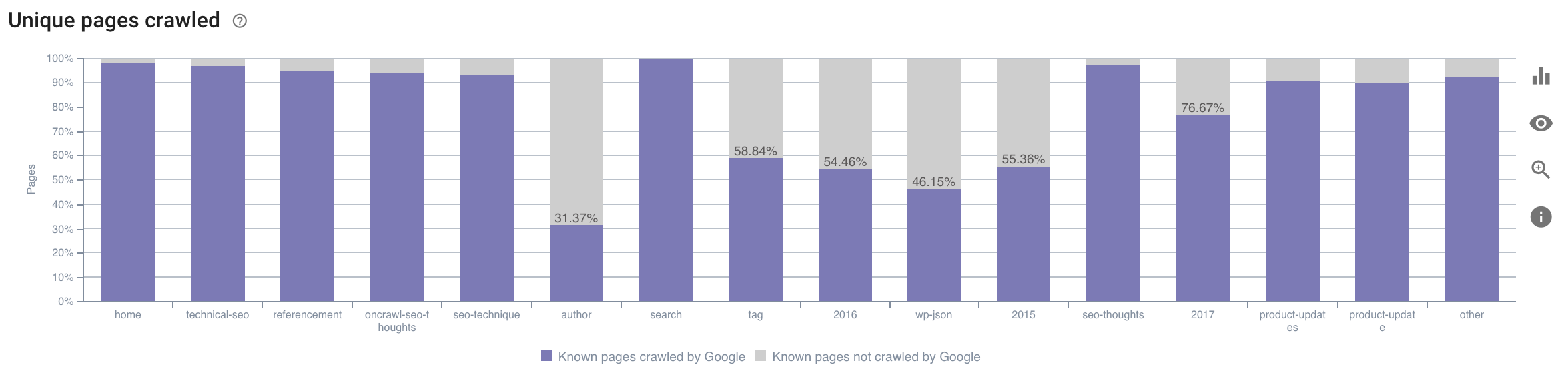

- Pe ce categorie își petrece timpul Googlebot? Este aceasta o utilizare optimă a bugetului de accesare cu crawlere? Acest grafic din Raportul de impact SEO al Oncrawl face referințe încrucișate la date și vă oferă aceste informații.

Sursa: aplicație Oncrawl

Sursa: aplicație Oncrawl

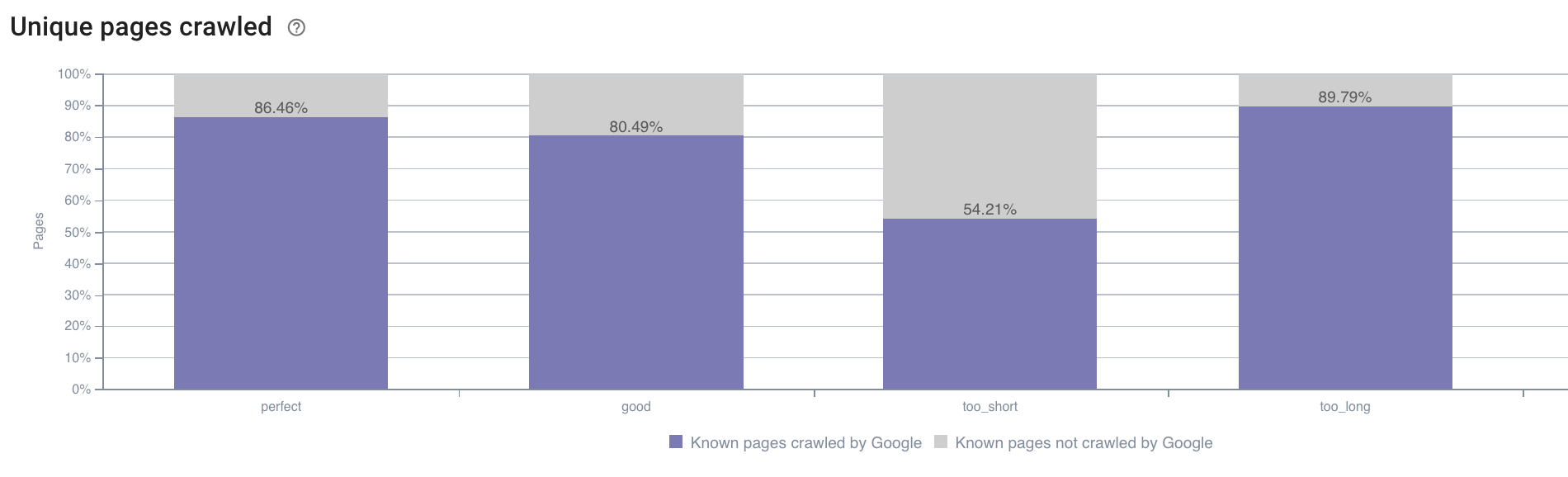

- Este posibil să avem întrebări și în afara domeniului a ceea ce oferă în mod implicit raportul de accesare cu crawlere Oncrawl. De exemplu, lungimea descrierii are un impact asupra comportamentului Googlebot? Avem datele despre aceasta datorită accesării cu crawlere, așa că le putem folosi pentru a crea o segmentare la fel ca mai jos:

Sursa: aplicație Oncrawl

Descrierile prea scurte sunt accesate cu crawlere mult mai puțin decât cele care au dimensiunea ideală desemnată aici ca „perfectă” sau „bună” de aplicația Oncrawl (între 110 și 169 de caractere).

Dacă descrierea îndeplinește, printre altele, criteriile de relevanță și dimensiune, Googlebot își va crește bucuros bugetul de accesare cu crawlere pe paginile relevante.

Notă: paginile care sunt considerate prea lungi sunt uneori rescrise de Google.

Analizați vizitele pe site folosind jurnalele

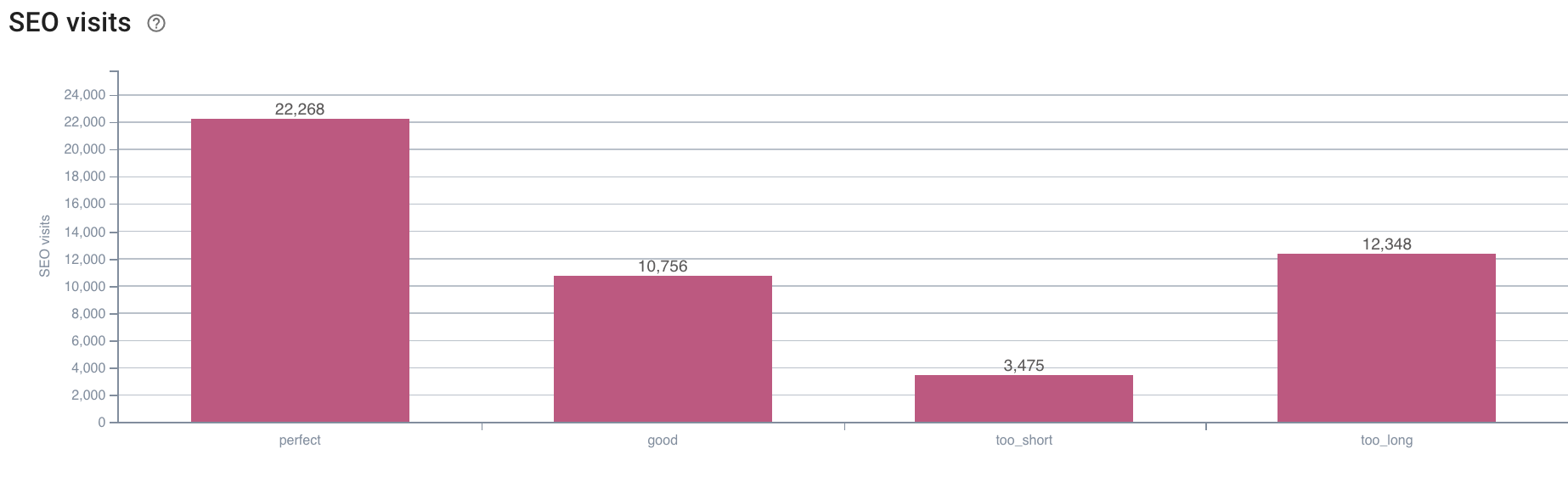

În continuare, dacă ne uităm la exemplul de SEO, deoarece acesta este ceea ce încercăm să analizăm cu Oncrawl, vă sugerez să vă puneți o altă întrebare:

- Care este corelația dintre comportamentul Googlebot și vizitele SEO?

Oncrawl are aceleași grafice pentru a încrucișa datele dintre cele ale accesării cu crawlere și vizitele SEO preluate în jurnale.

Sursa: aplicație Oncrawl

Sursa: aplicație Oncrawl

Răspunsul este foarte clar: paginile care au o lungime de descriere „perfectă” sunt cele care par să genereze cele mai multe vizite SEO. Prin urmare, trebuie să ne concentrăm eforturile pe această axă. Pe lângă „hrănirea” Googlebot, utilizatorii par să aprecieze relevanța descrierii.

Aplicația Oncrawl oferă date similare pentru mulți alți KPI. Simțiți-vă liber să vă verificați ipotezele!

In concluzie

Acum că știți și înțelegeți posibilitatea de a explora ceea ce se întâmplă pe site-ul dvs. în fiecare zi datorită jurnalelor, vă încurajez să analizați utilizatorii de internet și vizitele roboților pentru a găsi diverse modalități de optimizare a site-ului dumneavoastră. Răspunsurile pot fi tehnice sau legate de conținut, dar rețineți că o bună segmentare este cheia unei bune analize.

Cu toate acestea, acest tip de analiză nu este posibil cu instrumentele Google Analytics; datele lor pot fi uneori confundate cu cele ale crawler-ului nostru. A avea la dispoziție cât mai multe date este, de asemenea, o soluție bună.

Pentru a profita și mai mult de datele de jurnal și de analizele de accesare cu crawlere, nu ezitați să aruncați o privire asupra unui studiu realizat de echipa Oncrawl care compilează 5 KPI-uri SEO legate de jurnalele de pe site-urile de comerț electronic.