7 pași cheie pentru a învăța și a îmbunătăți din rezultatele testelor dvs. A/B

Publicat: 2021-04-13

Testul dvs. A/B tocmai s-a terminat, dar nu vedeți rezultatele așteptate.

Toți ceilalți împărtășesc studii de caz în care au văzut o creștere uriașă cu doar o schimbare a culorii butonului sau o mică modificare, dar testul dvs. nu a obținut nicio îmbunătățire în conversie sau, mai rău, pare să fi pierdut bani, iar acum trebuie să prezinta asta sefului tau.

Ei bine, ce se întâmplă dacă testul tău nu este de fapt un învins?

Dacă este un câștigător deghizat?

Și dacă este un învins, ce se întâmplă dacă un test care pierde este de fapt un lucru bun?

În acest ghid, vă vom ajuta să obțineți o perspectivă mai profundă asupra rezultatelor testului A/B, astfel încât să le puteți analiza și defalca pentru a găsi aurul.

Vom discuta de ce este atât de important să înveți din testele tale A/B și de ce perdanții vă pot aduce vânzări. Vă împărtășim un proces pe care îl puteți urma, astfel încât să vă puteți analiza pe deplin testele pas cu pas și să vă simțiți încrezători în ceea ce vedeți, câștigați sau eșuați.

Mai bine, te vom ajuta să treci de la anxietatea datelor și să nu dorești să-ți verifici analizele, la a fi încrezător în a-ți împărtăși rezultatele cu colegii tăi.

Deci haideți să ne scufundăm...

De ce trebuie să înveți din testele A/B?

Pentru început, există costul evident implicat. Fiecare test costă bani pentru a fi configurat. Dacă aveți variante pierdute, atunci veți observa și o scădere a vânzărilor pentru varianta respectivă.

Iată însă chestia:

Testarea A/B (și CRO în general) nu se referă doar la a câștiga mai mulți bani. Este vorba despre cumpararea datelor . Datele despre publicul dvs. vă pot ajuta să le înțelegeți mai bine și să oferiți un produs și un serviciu mai bun. Acest lucru duce apoi la mai multe vânzări și la o experiență îmbunătățită a clienților și chiar la informații despre noi oferte de produse.

Cu cât înveți mai multe despre oamenii pe care îi slujești, cu atât te descurci mai bine. De aceea este atât de important să testați și să testați des, chiar și atunci când majoritatea testelor eșuează.

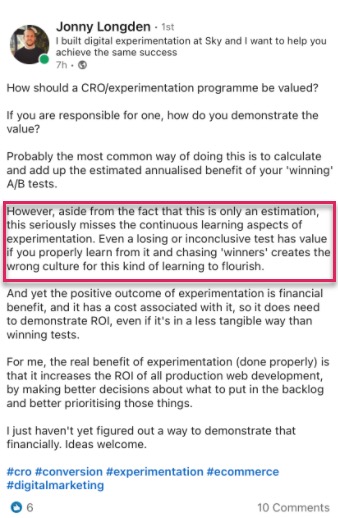

Nici noi nu suntem singuri în această gândire.

De fapt, când am analizat datele noastre interne de 28.304 de teste cu instrumentul nostru, împreună cu conversațiile cu agențiile de testare experți, am constatat că majoritatea companiilor găsesc doar 1 câștigător din 10 teste, în timp ce agențiile vor vedea de obicei 1 câștigător din fiecare. 4.

Și știu la ce te gândești,

Cu siguranță asta înseamnă că pierd bani 90% din timp cu fiecare test?

Da, dar numai pentru jumătate din audiența dvs. de testare. Cealaltă jumătate vă vede în continuare site-ul dvs. și face conversii ca de obicei.

De asemenea, datele pe care le obțineți vă ajută să aflați ce nu funcționează, astfel încât să puteți afla ce funcționează. Testați, învățați, testați din nou și continuați până când găsiți ceea ce funcționează.

Și acele teste de 10% care câștigă?

Acestea pot oferi o creștere continuă care poate fi îmbunătățită din nou și din nou, înainte de a fi extinse pe site-ul dvs. pe fiecare pagină similară pentru un impact mai mare.

Aceasta este frumusețea de a vedea o creștere a conversiilor pe o platformă digitală. Amploarea totală a unei creșteri de doar 1% poate avea un impact uriaș asupra afacerii dvs., atât acum, cât și cu tot traficul viitor. De fapt, Jeff Bezos gândește în aceleași direcții, denumind Amazon și obiectivul lor de testare și îmbunătățire „cel mai bun loc din lume în care să eșueze” în timpul raportului lor anual pentru acționari:

Având în vedere o șansă de 10 la sută de a câștiga de 100 de ori, ar trebui să luați acel pariu de fiecare dată. Dar tot vei greși de nouă ori din zece .

Jeff Bezos, Amazon

Totuși, mai multe vânzări și informații mai bune nu sunt singurele beneficii ale testării A/B.

Executarea testelor vă permite să vă îndepărtați de subiectele blocate și teoria de grup. În loc să petreceți luni de zile discutând despre posibilele modificări ale designului web și să nu faceți nimic, luați măsuri și testați-l, eliberându-vă echipa să se concentreze asupra altor lucruri. (Ai grijă să-i testezi efectul înainte de a-l împinge live!)

Nu numai asta, dar poți învăța ceva nou despre publicul tău pe care DOAR testele A/B îți pot spune.

Elaborarea teoriei și sondajele clienților sunt grozave, dar ceea ce publicul tău face de fapt pe site-ul tău contează cel mai mult, nu doar ceea ce spun ei. Înțelegerea testelor vă ajută să demonstrați sau să infirmați acele idei și feedback.

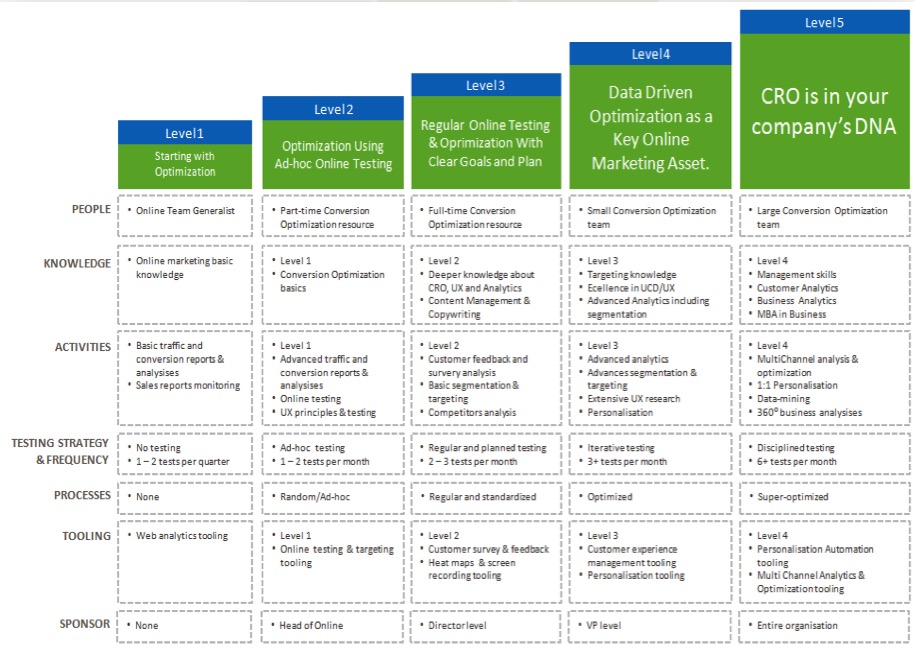

Cu cât înțelegi mai mult rezultatele, cu atât devii mai încrezător în testare, permițându-ți să-ți „maturi” eforturile CRO și să rulezi teste mai des și poate chiar să începi să construiești o echipă de testare în interior.

Acum că vedeți beneficiul învățării din fiecare test A/B, să vă ghidăm printr-un proces simplu de a analiza fiecare test nou pe care îl rulați...

Procesul în 7 pași pentru a învăța din testele dvs. A/B (împreună cu sistemele pe care le puteți utiliza pentru a îmbunătăți testele viitoare)

Am împărțit acest lucru în 7 pași cheie de urmat.

Este posibil să nu aveți toate metodele sau instrumentele pe care le recomandăm aici, dar, văzând cum se potrivesc, le puteți evalua valoarea și puteți decide dacă doriți să le integrați în testele viitoare.

Pasul #1: Verificați dacă datele dvs. sunt corecte, valide și semnificative

Aceasta este cea mai importantă parte a întregului proces. Asigurați-vă că informațiile pe care le aveți la test sunt corecte și valide, astfel încât să aveți încredere în rezultate.

Deci, cum vă asigurați că rezultatele testelor vă oferă date în care puteți avea încredere?

Ei bine, sunt câteva lucruri pe care le poți face...

Verificați acuratețea instrumentului dvs

Acum, majoritatea oamenilor le este dor de asta. Simțiți-vă liber să omiteți dacă site-ul dvs. nu primește mai mult de 10.000 de vizitatori pe lună. Din punct de vedere tehnic, nu este necesar să începeți cu CRO și funcționează cel mai bine cu site-uri cu un volum mare de trafic, dar aș fi neglijent să nu îl includ aici, deoarece site-urile mari pot vedea cu adevărat diferența.

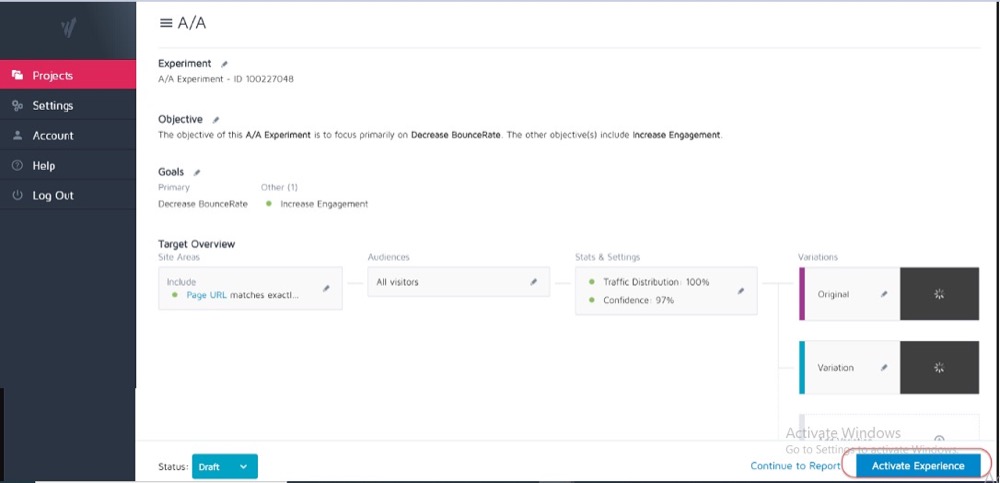

În mod ideal, ați efectuat deja un test A/A pe instrumentul dvs. actual de testare pentru a vedea cât de precis este și dacă are probleme.

Cum?

Efectuați un simplu test de împărțire cu 2 copii identice ale unei pagini web și apoi urmăriți rezultatele pe acele 2 pagini identice.

Deoarece nu există diferențe între ele, rezultatele ar trebui să fie aceleași pentru fiecare pagină. Cu toate acestea, pot exista unele discrepanțe cauzate de instrument și de modul în care acesta măsoară sau urmărește datele dvs.

Cunoașterea acestui lucru în avans vă poate ajuta să obțineți o toleranță pentru acuratețea rezultatelor testării și să o utilizați ca ghid pentru toate testele viitoare.

Exemplu

Dacă ați observat că testul dvs. A/A a arătat o diferență de 0,5% în rata de conversie între două pagini identice, atunci s-ar putea să fiți atenți la orice rezultate ale testului care arată un câștigător atunci când este doar o diferență de 0,5% între control și variantă.

Ați putea stabili reguli interne care spun că un test trebuie să arate o creștere de 1% sau mai mare înainte de a crede rezultatul. Din nou, trebuie să rulați o singură dată un test A/A atunci când încercați un nou instrument sau dacă credeți că instrumentul dvs. actual poate avea probleme cu raportarea sau este configurat incorect.

Testele A/A funcționează cel mai bine cu site-uri cu trafic mare, deoarece eșantionul de date necesare pentru a verifica cu precizie poate fi destul de mare, dar diferența de eroare de 1% poate fi uriașă.

Executați testul suficient de lung pentru a obține o imagine validă a modului în care clienții dvs. interacționează cu site-ul dvs

Așa că acum că aveți încredere în instrumentul dvs., doriți să rulați testul timp de 2-4 săptămâni, chiar dacă obțineți suficiente conversii pentru a-l putea opri din punct de vedere statistic înainte.

De ce?

Pentru că publicul tău va interacționa adesea cu site-ul tău diferit, în funcție de ziua săptămânii sau de anumite etape ale lunii.

Exemplu

Dacă oamenii din audiența dvs. ar fi plătiți joia, ați observa o creștere pe care ați putea să o ratați dacă testul ar fi derulat doar de luni până miercuri, nu?

De asemenea, alți utilizatori ar putea fi plătiți o dată pe două săptămâni sau lunar, modificând din nou rezultatele dvs. dacă testele dvs. nu au rulat suficient de mult pentru a le include în ele. Pur și simplu ați presupune vânzări sau trafic mai scăzute pentru orele pe care le-ați ratat.

De unde știi când să închei un test? Citiți mai multe despre semnificația statistică a testării A/B: cum și când să încheiați un test

Fiți conștienți de orice factori interni sau externi care vă pot afecta rezultatele

Acestea sunt evenimente unice sau programate care v-ar putea modifica datele.

De exemplu, dacă CEO-ul sau compania dvs. a fost la știri sau dacă desfășurați campanii de marketing sau promoții curente, precum și orice factori externi, cum ar fi sărbătorile naționale sau chiar creșteri aleatorii ale traficului.

Toate acestea pot afecta traficul site-ului dvs. și apoi pot modifica cât de precise sunt rezultatele dvs. în acea perioadă.

Poveste adevărată:

În urmă cu aproximativ 6 ani, obișnuiam să dețin o companie de îmbrăcăminte pentru surf.

Într-o zi, traficul nostru a crescut cu aproximativ 800% de nicăieri și rata de respingere a crescut. Nu derulăm campanii noi de marketing și așa că am făcut o mică investigație pentru a afla de unde a venit traficul.

Se pare că unul dintre tricourile noastre avea un nume de produs care era același cu noua melodie a unei trupe pop coreene și timp de 2 zile ne-am clasat și am primit vizitatori.

Desigur, acest nou public nu a fost deloc interesat de produsul nostru și au plecat curând.

Nebun, nu?

Altă dată, blogul meu de marketing a început să se claseze pentru marca unei companii de televiziune și s-a întâmplat același lucru. Am avut vârfuri de trafic de la publicul greșit.

Oricât de aleatoriu este, acest tip de lucruri se pot întâmpla, așa că fiți conștienți de evenimente externe sau interne ca acesta. Puteți oricând să vă verificați analizele pentru a vedea de unde a venit traficul și apoi să reporniți testul când totul revine la normal.

Asigurați-vă că obțineți suficiente date

Doriți să vă asigurați că testul dvs. are suficiente conversii pentru a vă face o idee validă despre performanța acestuia.

A avea un control și o variantă cu doar 50 de conversii totale și doar o mică diferență între ele nu este suficient pentru a obține o perspectivă asupra audienței dvs. – chiar dacă rezultatele testelor au fost oarecum semnificative statistic. Majoritatea experților sunt de acord că aproximativ 300 de conversii per variantă este de obicei o regulă generală bună (cu chiar mai multe dacă doriți să segmentați mai târziu).

Cu cât setul de date este mai mare, cu atât este mai ușor să găsiți informații în analiza dvs. post-test.

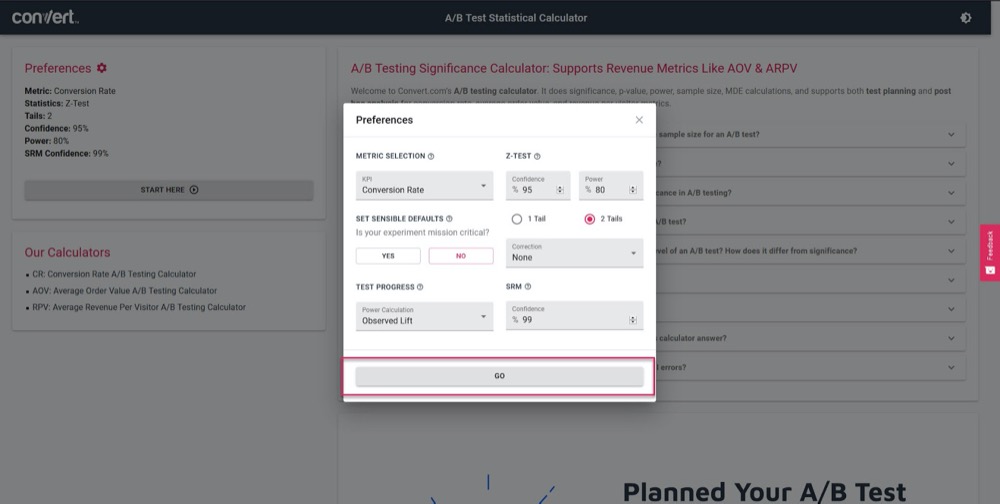

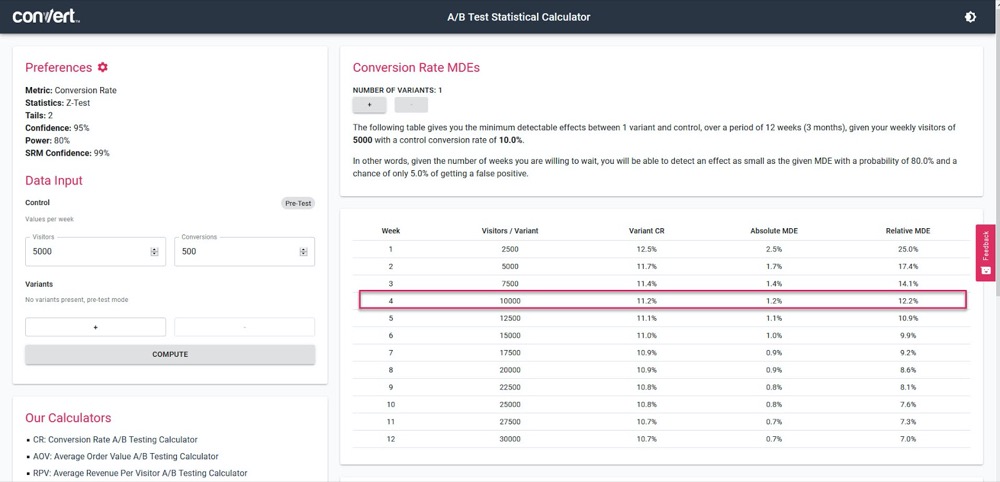

Utilizați calculatorul nostru de semnificație a testării A/B pentru a vă face o idee despre cât de precis va fi testul dvs., pe baza unui ciclu de vânzări de 4 săptămâni și a informațiilor actuale ale paginii de „control”.

Pur și simplu setați parametrii de testare:

Apoi, introduceți cât trafic ar trebui să obțină testul dvs. pe săptămână, împreună cu numărul de conversii al paginii dvs. curente, apoi aflați exactitatea și procentul de creștere pe care testul dvs. le va putea calcula.

În exemplul de mai sus, putem măsura o creștere de 1,2% după 4 săptămâni. (Dacă dorim să obținem o precizie mai mare, pur și simplu rulați testul mai mult timp sau creșteți volumul de trafic în test.)

Obțineți rezultate semnificative statistic

Iată de ce semnificația statistică este importantă, dar nu cel mai important factor în timpul testării.

Da, doriți să vă asigurați că testul durează suficient de mult pentru a vedea un rating de încredere de 95-99% în rezultate, dar doriți, de asemenea, să vă asigurați că fiecare alt factor pe care l-am acoperit mai sus este afectat.

De ce?

Chiar și un test A/A poate arăta o încredere de 95% că o versiune este mai bună decât copia sa identică dacă nu este rulată suficient de mult.

(Ar putea vedea aleatoriu toate conversiile dintr-o versiune într-o zi și niciuna în cealaltă.)

Prea mulți testeri noi vor opri o campanie odată ce atinge „stat sig”, determinându-le să obțină date false. De aceea, vă recomandăm să obțineți o semnificație statistică de 95% sau mai mare, dar ȘI să rulați testul pe 2-4 cicluri de vânzări, cu peste 300 de conversii și cu o dimensiune a eșantionului suficient de mare.

Dacă faceți toate acestea, atunci puteți fi destul de sigur că puteți avea încredere că testul vă va oferi rezultate valide și precise.

Nu pot sublinia suficient cât de important este să lași testul să ruleze astfel încât să îndeplinești aceste criterii.

Apelarea unui test prea devreme vă poate oferi informații false care pot duce la:

- Nu găsiți un potențial câștigător deoarece nu aveți suficiente informații,

- Desfășurați campanii cu performanțe mai scăzute, deoarece credeți că acestea sunt câștigătoare, dar sunt de fapt o rată de conversie mai mică,

- Sau, mai rău, puteți obține o încredere falsă în acele rezultate și apoi să utilizați ceea ce ați învățat pentru a o extinde în alte părți ale site-ului dvs., crescând astfel acele efecte negative.

Știți cum instrumentul dvs. de testare A/B ajunge la concluzii despre variantele câștigătoare? Faceți clic aici pentru a utiliza Calculatorul nostru de semnificație a testării A/B.

Notă marginală:

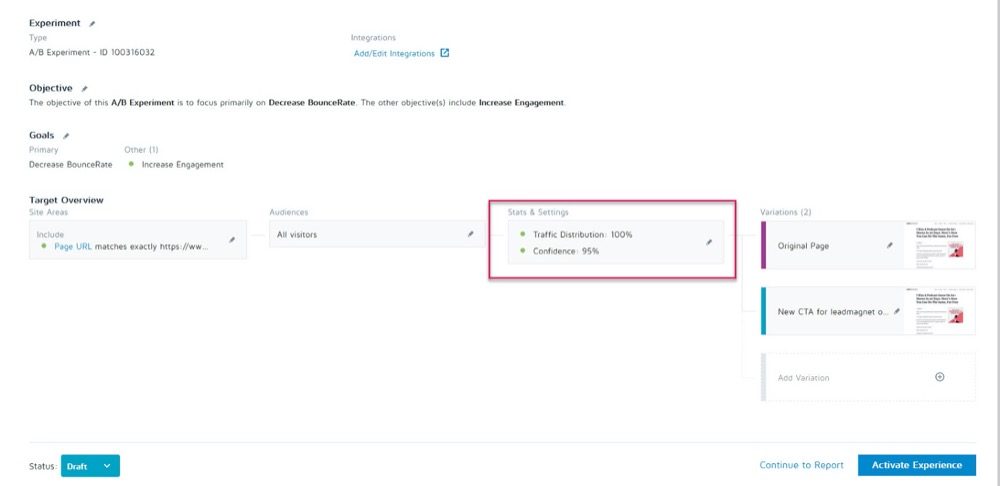

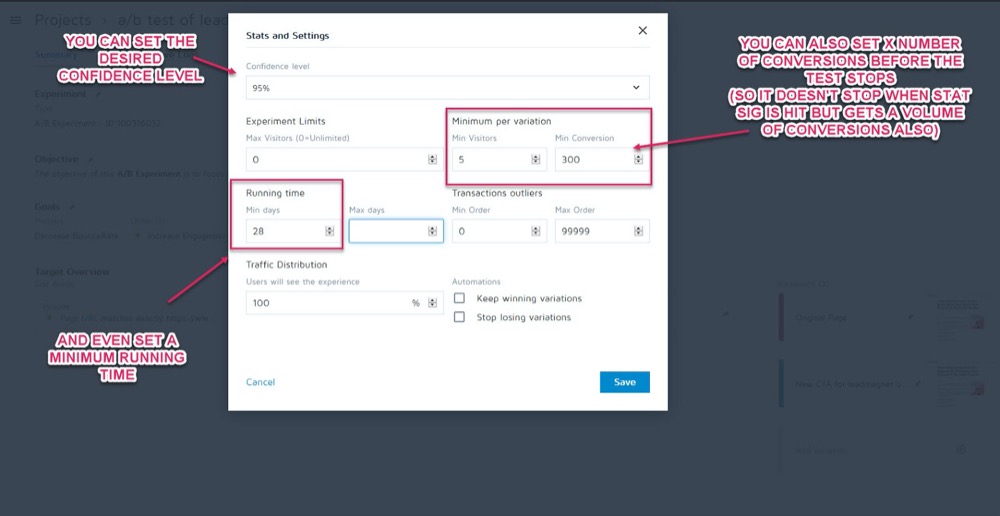

Îi puteți configura ca parametri înainte de rularea testului în secțiunea Statistici și setări a experimentului din aplicația Conversie experiențe.

Puteți seta apoi nivelul de încredere dorit, timpul minim de rulare și numărul de conversii de realizat înainte ca testul să poată fi apelat.

Odată ce ești sigur că datele tale sunt exacte, este timpul să le analizezi...

Pasul #2: Verificați valorile Micro, Macro și Guardrail

Majoritatea oamenilor se vor uita la un test și vor considera câștigătorul sau învinsul la valoarea nominală din orice le spune instrumentul.

Problema este, desigur, că instrumentul vă poate spune doar cum funcționează testul pe baza criteriilor pe care le-ați stabilit pentru el. În calitate de testeri CRO, vrem întotdeauna să înțelegem „cum” și „de ce” care au determinat aceste rezultate, astfel încât să putem învăța de la ele.

Acum sunt câteva verificări pe care le vom face, dar, mai întâi, voi acoperi trei dintre cele mai importante. Aici intervine urmărirea rezultatelor micro și macro.

Lasă-mă să explic:

- Urmărirea micro se referă la urmărirea obiectivului pentru care ați optimizat testul, care ar putea fi mai multe clicuri, înscrieri etc.

- Urmărirea macro se analizează efectul asupra valorii Northstar pentru afacerea dvs., care este de obicei vânzări.

De ce contează asta?

Uneori, o creștere a micro-evenimentului de pe pagina ta de testare nu afectează macrocomandă așa cum ai putea crede.

Exemplu

Să presupunem că testezi CTA pe o pagină de captare a clienților potențiali, iar învinsul primește mai puține clienți potențiali decât controlul.

Pare evident care test a câștigat, nu?

Dar la o inspecție ulterioară în analizele dvs., observați că clienții potențiali care au ajuns la acel test de „pierdere”, de fapt s-au convertit mult mai sus pe backend și au creat un ROI mult mai mare.

De ce s-ar întâmpla asta?

Este posibil ca pagina dvs. actuală să atragă un public mai larg și să convertească mai mulți clienți potențiali, dar noua variantă „pierdetoare” este de fapt atrăgătoare pentru persoanele care sunt gata să cumpere chiar acum.

În exemplu, campania care pierde ar fi de fapt pagina pe care ați dori să rulați, deoarece conversia este mult mai bună cu valoarea dvs. Northstar.

Amintiți-vă de obiectivul final și concentrați-vă eforturile asupra a ceea ce vă afectează cel mai mult.

Rezultatele micro și macro nu sunt tot ce trebuie să căutați.

Dacă nu ați făcut-o deja, vă recomandăm să adăugați „Valori de protecție” la campaniile dvs.

Acestea sunt valori de bază pe care doriți să le urmăriți atunci când faceți orice alte modificări, astfel încât, dacă acestea încep să scadă, puteți să anulați sau să opriți anumite metode de testare, deoarece performanța lor este prea importantă.

La Uber, derulăm 100 de experimente în orice moment. Scopul acestor experimente este de a îmbunătăți continuu produsele noastre și experiența utilizatorului. Cu toate acestea, uneori, un experimentator poate avea în minte anumite valori cheie și poate să nu fie conștient de impactul asupra altor câteva valori importante pentru echipă și companie în general, iar pe măsură ce experimentul este derulat, aceste valori nemonitorizate pot regresa.

Pentru a detecta și a atenua astfel de scenarii, ne-am construit platforma noastră de monitorizare a experimentelor. Scopul este să identificăm și să monitorizăm câteva valori de protecție pe care nu dorim să le degradăm în timpul experimentului. Aplicăm o variație a metodologiei secvențiale A/B pentru a monitoriza în mod continuu aceste valori de protecție și pentru a detecta orice regresie între tratament și grupul de control al unui experiment. Dacă este detectată regresia, trimitem alerte proprietarului experimentului .

Suman Bhattacharya, cercetător principal de date, Uber

Exemplu

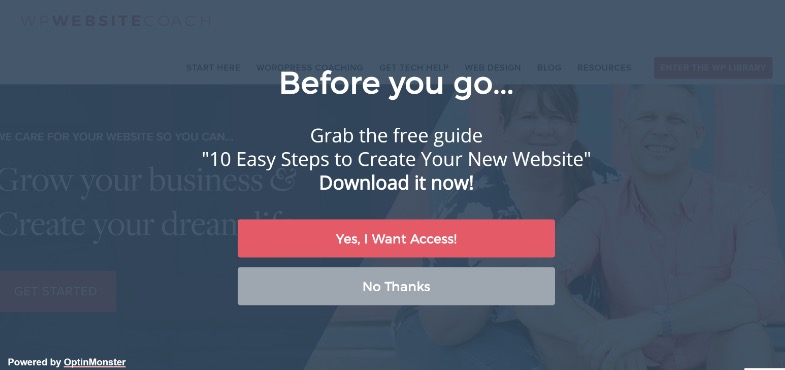

Să presupunem că doriți să colectați mai multe clienți potențiali folosind ferestre pop-up pe tot ecranul.

Pentru unele site-uri, acestea funcționează excelent, dar nu întotdeauna. (De aceea testăm!)

Poate că ați instalat o fereastră pop-up pe ecran complet și ați început să obțineți mai multe clienți potențiali pe pagina respectivă, dar e-mailurile de bun venit către acești noi abonați revin și nu se livrează.

Se pare că oamenii s-au înscris cu e-mailuri false doar pentru ca ferestrele pop-up să nu se mai afișeze.

Nu doriți clienți potențiali falși pe lista dvs. de e-mail, deoarece acestea vă pot reduce rezultatele livrării de e-mail către abonații efectivi. Nici nu ar trebui să dorești să scazi atât de mult experiența utilizatorului, încât publicul tău să simtă că trebuie să-și falsifice e-mailul.

Deoarece marketingul prin e-mail este o parte esențială a procesului dvs. de vânzări, decideți să configurați o alertă pentru a vă anunța dacă rata de respingere a e-mailurilor depășește un punct stabilit în timp ce rulați teste A/B pe pagina dvs. de captare a clienților potențiali.

Aceasta ar fi valorile pentru balustradă. În acest exemplu, puteți vedea că este stricat și vă decideți să utilizați metode de captare a clienților potențiali mai puțin intruzive.

Are sens?

Totuși, valorile de gardă nu sunt doar capturarea potențialului și rata de respingere. Sunt valori cheie în care nu doriți să vedeți o scădere care afectează experiența utilizatorului.

Pentru a preveni o degradare a experienței utilizatorului, asigurându-vă în același timp că îmbunătățiți și valorile care contează, definiți câteva valori pentru balustradă care, dacă ar scădea cu un anumit prag, v-ar împiedica să mergeți mai departe cu lansarea presupusului „ varianta câștigătoare”. Acest lucru ajută, de asemenea, la încheierea dezbaterii dintre optimizarea conversiilor și UX sau liniile directoare ale mărcii .

Alex Birkett, Omniscient Digital

Depinde de tine să decizi care sunt acele valori pentru afacerea ta. Folosiți-le pentru a vedea dacă aveți un câștigător real sau dacă pur și simplu tranzacționați creșterea unui rezultat pentru o pierdere într-un domeniu mai important.

Dacă aveți nevoie de inspirație, consultați lista lui Ben Labay cu valorile comune ale balustradei în experimentare și testare:

Apoi, faceți acele modificări în consecință.

Atâta timp cât aveți aplicația Conversie experiențe configurată cu statisticile și segmentele avansate, ar trebui să puteți găsi aceste informații cu o privire rapidă în jur. Verificați efectul fiecărei variații asupra valorii dvs. Northstar, precum și „parapele de protecție”, astfel încât să nu alegeți doar câștigătorul instrumentului de testare.

Acum că ați acoperit valorile de bază, să ne uităm puțin mai în profunzime la rezultatele dvs....

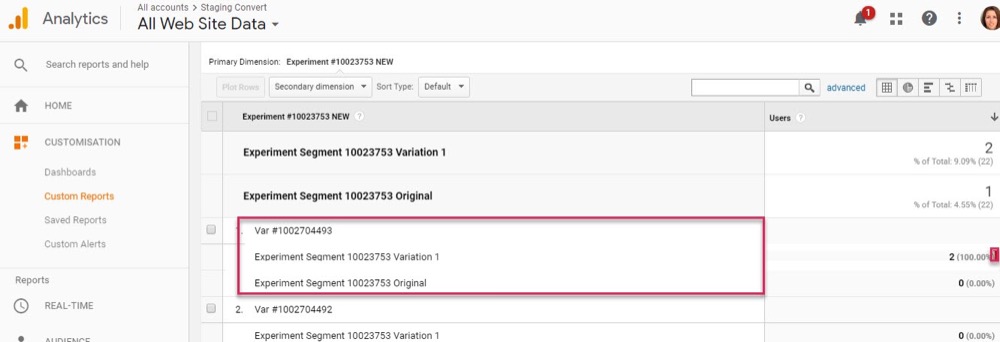

Pasul 3: Mergeți mai adânc și segmentați rezultatele

Amintiți-vă că atunci când vine vorba de testare, media este o minciună .

Rezultatul mediu vă poate oferi întotdeauna informații ample bazate pe o combinație de mai multe puncte de date. Depinde de tine să înțelegi de ce a apărut acel rezultat și apoi să te uiți mai profund pentru că nu este întotdeauna ceea ce pare.

Am văzut deja acest lucru, rezultatele macro fiind afectate de modificările microtestelor, dar segmentele dvs. de analiză pot oferi informații și mai profunde.

Exemplu

Să presupunem că efectuați un test pentru mai multe clienți potențiali. La prima vedere, controlul și varianta au aceeași rată de conversie a vizitatorilor către abonați.

Cu toate acestea, la o inspecție mai profundă, observați că pe desktop, noua variație este aproape dublă față de rata de conversie a controlului, dar pe mobil este zero, ceea ce face ca media paginii să pară identică cu controlul.

În mod clar, ceva nu este în regulă, dar de ce s-ar întâmpla asta?

S-ar putea ca noua variantă pur și simplu să nu se încarce corect pe mobil sau poate că formularul nu funcționează pe anumite dispozitive, așa că niciun utilizator de telefonie mobilă care dorea să se aboneze nu ar putea. Și dacă ați remediat această problemă, s-ar putea ca varianta dvs. de „rezultat egal” să fie de fapt capabilă să depășească cu mult controlul.

Puteți găsi aceste lucruri doar atunci când lucrați pentru a obține mai multe informații în spatele rezultatelor dvs.

Cu fiecare test, vă veți experimenta statistici, ceea ce va informa o segmentare mai inteligentă, ceea ce va duce la noi perspective, care vă vor conduce în cele din urmă către o strategie mai semnificativă .

Shanelle Mullins, Shopify

Segmentarea nu se referă doar la găsirea erorilor, ci și la găsirea altor informații despre utilizatori.

Poate că pagina și controlul funcționează în regulă, dar când te uiți mai profund, observi că anumite canale de trafic fac conversie mult mai mare la acest nou test decât altele?

Adesea, veți avea unele segmente cu performanțe slabe, iar altele supraperformante. Acest lucru poate informa apoi noi campanii de personalizare sau strategii de trafic plătit sau organic.

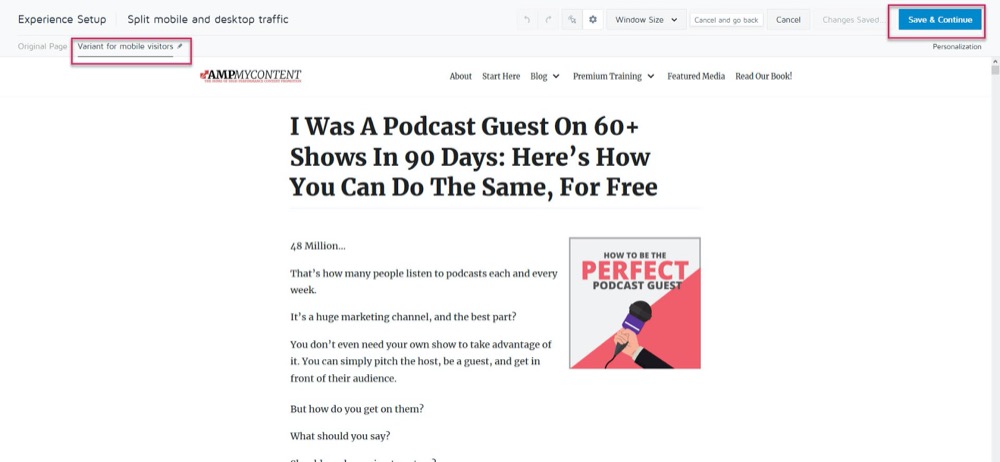

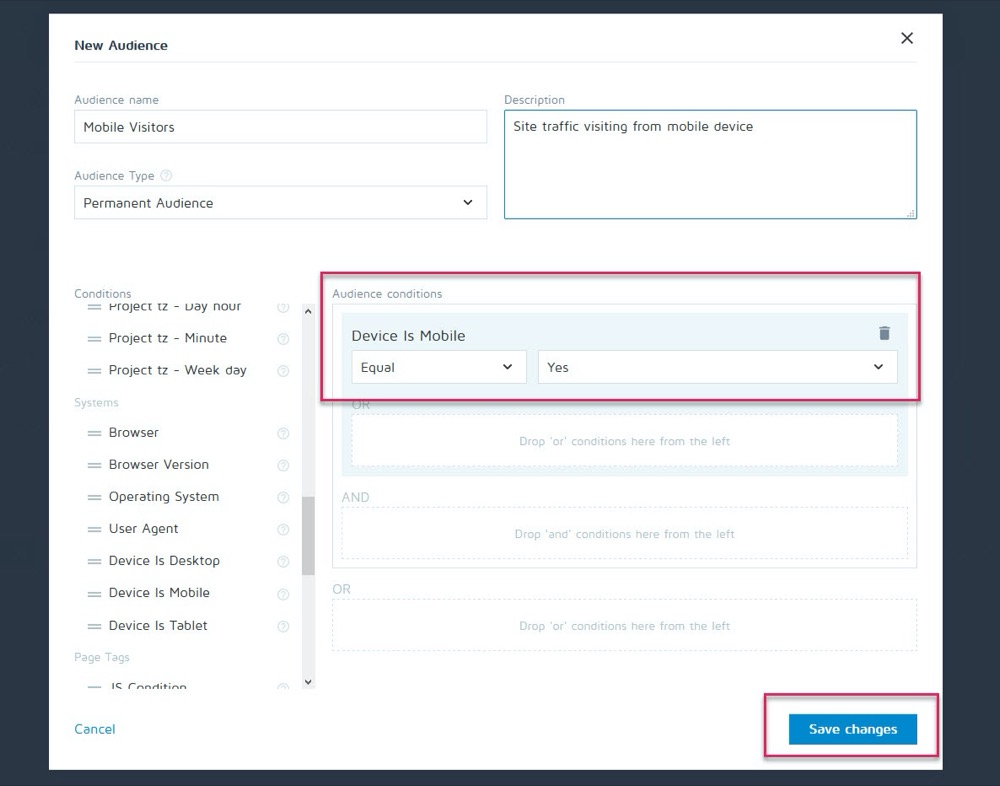

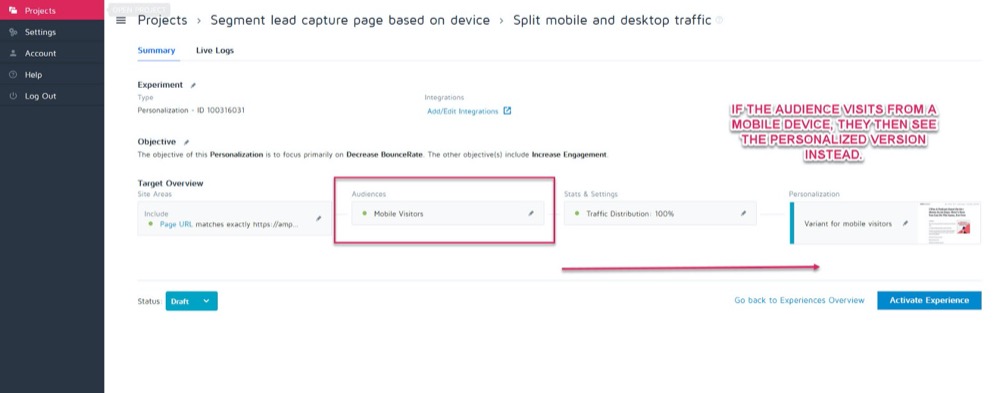

Poate că controlul se convertește cel mai bine pe desktop, dar noua variantă face o conversie mai mare pe mobil. Să presupunem, de exemplu, că doriți să alegeți ce versiune se afișează în funcție de modul în care spectatorul vă vede site-ul.

Folosind caracteristica de personalizare a lui Convert, puteți configura varianta câștigătoare pentru dispozitive mobile ca personalizare doar pentru acel public.

Apoi, puteți afișa noua versiune atunci când vizitatorul vine de pe orice dispozitiv mobil.

Dar dacă se întâlnesc cu un desktop, ar vedea în schimb versiunea desktop.

Există o mulțime de metode de personalizare diferite pe care le puteți folosi, dar numai odată ce obțineți câteva informații din campaniile dvs.

Cheia analizei segmentelor este să vă uitați întotdeauna la rezultate pentru a afla DE CE s-a întâmplat ceva.

Uita-te la:

- Publicul nou vs. revenit . O variantă aduce oamenii înapoi mai des? Se convertește unul mai mulți membri ai publicului rece/nou?

- Sursa de trafic. Un canal merge mai bine decât alții? Te-ai putea concentra mai mult aici?

- Vizualizări de pagină. Mai ales dacă pagina de test încearcă să atragă trafic către pagina de vânzări. Lipsa de clicuri pe o versiune ar putea însemna că aveți un buton rupt sau o problemă cu CTA.

- Rata de respingere. Acest lucru poate indica o legătură întreruptă/încărcare lentă/experiență UX proastă sau chiar vizarea unui public greșit.

- Sistem de operare,

- Mobile Vs Desktop.

- Dispozitiv folosit.

O mică declinare a răspunderii:

Pentru a obține o reflectare exactă a fiecărui canal atunci când segmentați astfel, aveți nevoie de MULTE date. O regulă generală bună este să aveți un test cu aproximativ 10 ori mai mare decât volumul de conversii pe care îl puteți rula în mod normal (sau 300 de conversii pe canal, nu doar pe pagina variantă).

S-ar putea să vă gândiți: „Nu avem cum să obținem suficient trafic pentru a rula un astfel de test ”. Sau dacă o faci, ar putea dura luni până să se întâmple.

Chiar dacă acesta este cazul, nu sări peste analiza dvs. de segment.

De ce?

Chiar dacă s-ar putea să nu aveți suficiente conversii în fiecare segment pentru a trage concluzii bazate pe date, vă poate oferi niște informații clare dacă începeți să vedeți probleme precum afișări de pagină cu zero clicuri sau o rată de respingere imediată .

Toate acestea sunt lucruri care ar putea indica un test întrerupt și vă pot ajuta să găsiți un câștigător potențial ratat. Continuați și căutați orice scăderi și probleme majore. Funcționa totul pe fiecare platformă și dispozitiv?

În mod ideal, le-ați verificat pe toate înainte de test, dar lucrurile se pot rupe la mijlocul testului, așa că verificați din nou.

Personal, mi-am cerut WordPress să se actualizeze automat la jumătatea campaniei, ceea ce a făcut ca formularele de captare a clienților potențiali să nu mai funcționeze brusc la mijlocul unui test. Înregistrați-vă întotdeauna și, dacă vedeți ceva care distruge acuratețea rezultatelor, opriți testul, reparați problema și apoi rulați din nou.

Si daca totul mergea ok?

Să aruncăm o privire și să aflăm DE CE oamenii nu ți-au luat măsuri...

Pasul #4: Verificați comportamentul utilizatorului pentru informații suplimentare

În mod ideal, ar trebui să aveți urmărire calitativă pe lângă instrumentul dvs. de testare.

De ce?

Deoarece acest lucru vă poate oferi adesea informații despre varianta dvs., pe care le-ați rata doar cu teste regulate.

Tine minte:

Instrumentele de testare cantitativă , cum ar fi Convert, vă spun ce s-a întâmplat. Vă putem oferi datele numerice brute între câte persoane au făcut clic sau nu au făcut clic și vă putem ajuta să configurați fiecare test A/B.

Dar adăugarea de instrumente calitative vă ajută să înțelegeți DE CE s-a întâmplat o acțiune. Vă permit să vedeți ce făcea utilizatorul și să obțineți mai multe informații despre acțiunile sale.

(De obicei, testele vor eșua din cauza execuției proaste sau a înțelegerii publicului și doar vedem ce a mers prost putem rezolva problema.)

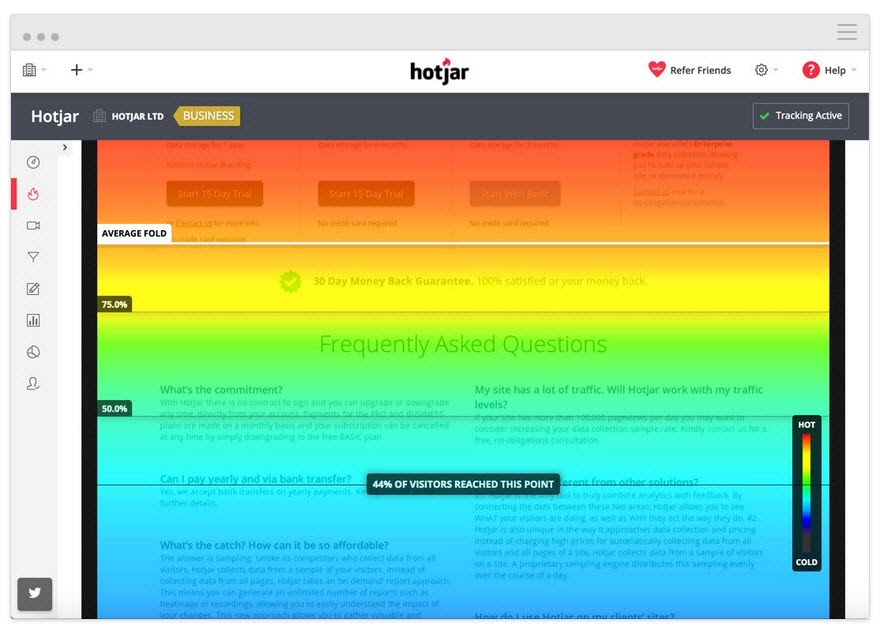

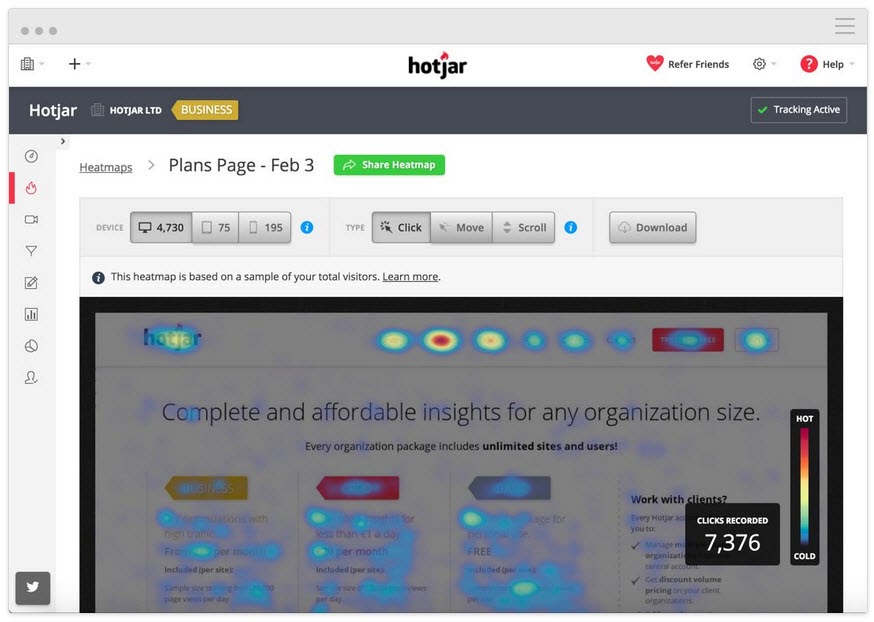

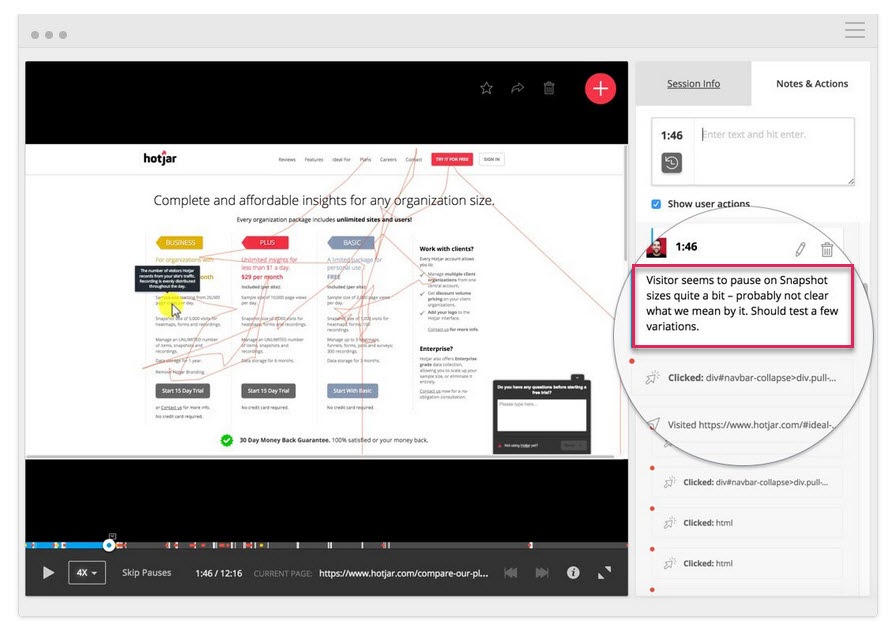

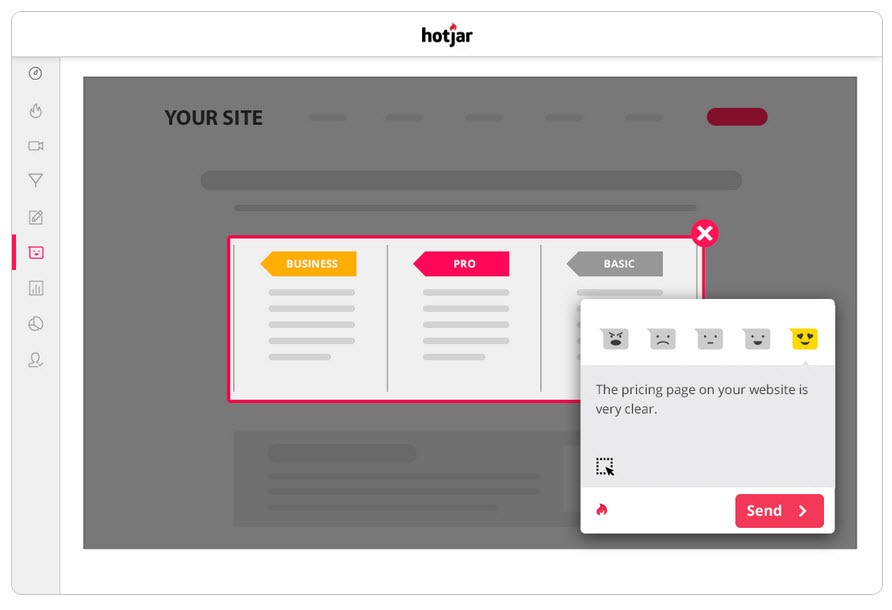

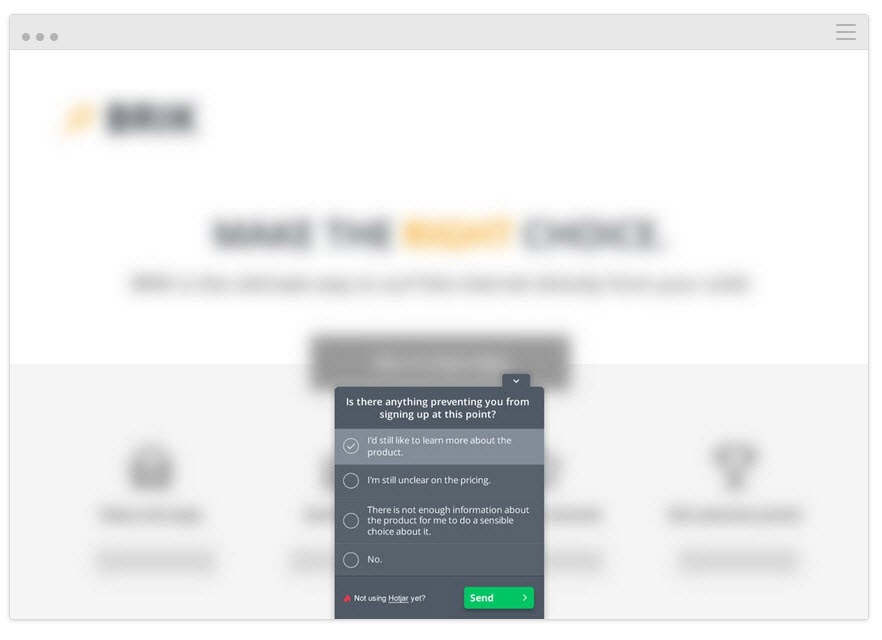

Folosind un instrument precum Hotjar, puteți rula o serie de teste calitative și chiar puteți introduce datele direct în tabloul de bord Convert cu integrarea noastră încorporată.

Pentru a obține informații mai profunde, configurați integrarea Hotjar – Convert și încercați tactica de mai jos.

Urmăriți cât de departe citește utilizatorul

Adăugați un instrument de hărți termice pe pagina dvs. pentru a vedea dacă publicul ajunge atât de departe decât CTA. Dacă nu, puteți rula din nou testul și puteți muta CTA mai sus în pagină.

Urmăriți pe ce da clic utilizatorii, dar nu ar trebui

Faceți clic pe CTA strategice sau este text aleatoriu despre care cred că ar putea fi un link?

Urmărește înregistrările de pe ecran pentru a vedea pe ce nu fac clic, dar ar trebui

Nu fac clic pe butonul CTA, chiar dacă derulează suficient pentru a-l vedea? Fac clic, dar nu se deschide? Îl văd, dar nu realizează că este un buton pe care trebuie să dai clic?

Puteți urmări toate acestea și chiar adăuga note atunci când aceste lucruri apar.

Nu doar instrumentele de cartografiere termică și de urmărire a clicurilor pot ajuta.

Rulați sondaje pentru publicul dvs

Sondajele vă ajută nu numai să obțineți feedback cu privire la ceea ce a determinat publicul să ia măsuri (sau la oprit), dar vă oferă și limbajul pe care îl folosește pentru a descrie acest lucru.

În copywriting, numim această „limbă oglindă” și este incredibil de eficientă în legătură cu utilizatorul. Simți că nu numai că le recunoști problema, dar o înțelegi mai bine decât oricine altcineva, așa cum o descrii în aceleași cuvinte pe care le folosesc ei.

Două modalități excelente de a folosi sondajele împreună cu instrumentul de testare A/B sunt:

- Sondajele de intenție de ieșire . Identificați-i pe cei care nu iau noua versiune, pentru a afla ce i-a oprit.

Există vreun motiv pentru care nu ați optat/cumpărat astăzi?

- Sondajele post-cumpărare/conversie. Găsiți-i pe cei care acceptă varianta și vedeți dacă au existat puncte de blocare și factori de motivare.

Ce te-a determinat să iei măsuri astăzi?” A fost ceva care aproape te-a împiedicat să te decizi?

Puteți chiar să rulați sondaje similare pe control dacă doriți mai multe informații. Toate acestea vă vor ajuta să înțelegeți cum a funcționat testul, astfel încât să puteți repeta și să vă îmbunătățiți.

Apropo de care…

Pasul 5: Învață din testele pierdute

Cel mai important lucru când vine vorba de obținerea unui test de pierdere este să înveți ceva din rezultat. Nu există un test prost, atâta timp cât puteți obține informații din acesta pentru a vă îmbunătăți sau a înțelege mai bine publicul.

Testarea A/B este un proces interactiv. Eșuăm înainte în timp ce dobândim înțelegere. Adesea, puteți învăța mult mai multe din a susține un test învins pentru un câștigător decât doar obținerea unui câștigător.

Până acum am făcut 3 lucruri:

- Asigurați-vă că datele de testare sunt exacte,

- Privind rezultatele brute pentru orice probleme și

- Încercarea de a înțelege utilizatorii noștri și acțiunile lor.

Acest pas este mai degrabă o abordare euristică pentru a vă ajuta să înțelegeți problemele comune care pot cauza un eșec (presupunând că datele de testare sunt corecte și că toate butoanele CTA funcționează) și să vă analizați abordarea și ipoteza.

Ipoteza ta a fost greșită sau testul tău a fost greșit?

Aceasta este o problemă comună, în special în rândul testatorilor noi.

V-ați efectuat testul pe baza unor valori sau idei „woo woo” care nu erau aliniate cu un KPI real?

Exemplu

Să presupunem că doriți mai multe vânzări de pe o pagină, dar din anumite motive, ați decis să testați ajustări ale butoanelor de distribuire socială. (Chiar dacă nu aveți date care să arate că mai multe acțiuni sociale vă afectează vânzările.)

Sună nebunesc, dar vei fi surprins cât de des se întâmplă așa ceva.

Intreaba-te pe tine insuti:

Obiectivul meu de testare s-a aliniat cu un KPI de bază și într-un mod care îl poate afecta?

Dacă nu a fost, atunci este în regulă, dar asigură-te că următorul test se aliniază mai bine.

Eșuăm, învățăm, încercăm din nou.

La următorul test, asigurați-vă că vă concentrați pe valorile KPI de bază și asupra modului în care le puteți afecta și, de asemenea, oferiți testului un scenariu clar de câștig/eșec.

Dorim ca această pagină să obțină mai mulți clienți potențiali, așa că testăm ceea ce îi face să se înscrie, ceea ce înseamnă că vrem să creăm un CTA mai bun.

sau

Dorim ca această pagină să obțină mai multe clienți potențiali și am constatat că utilizatorii nu derulează până la CTA, așa că încercăm să o ridicăm în pagină.

Alinierea testului cu obiectivul tău te va duce pe calea cea bună, dar chiar și atunci, s-ar putea să nu înregistreze mai multe conversii...

Ipoteza a fost corectă și testul a fost aliniat, dar nu a existat încă nicio modificare a rezultatelor

Acest lucru se poate întâmpla în 90% din timp și de aceea majoritatea testelor eșuează.

Exemplul #1

Datele dvs. de utilizator arată că utilizatorii nu au suficientă încredere în site-ul dvs. Ați adăugat factori de încredere precum dovada socială, mărturiile utilizatorilor, certificatele SSL, dar conversiile încă nu au crescut.

Asta înseamnă că ar trebui să te oprești și să încerci un nou test sau unghi?

Deloc…

Ipoteza dvs. inițială poate să fi fost corectă, dar testul trebuie doar îmbunătățit sau executat mai bine înainte de a putea vedea vreun efect.

Ați putea încerca să adăugați mai mulți factori de încredere sau chiar să vă mutați pe cei pe care îi aveți, astfel încât să iasă mai mult în evidență. Poate reformula limba folosită în ele pentru a-i ajuta să se conecteze mai bine cu publicul tău.

Toate aceste lucruri încă se aliniază cu ipoteza inițială, trebuie doar să testați mai multe versiuni pentru a găsi câștigătorul.

Exemplul #2

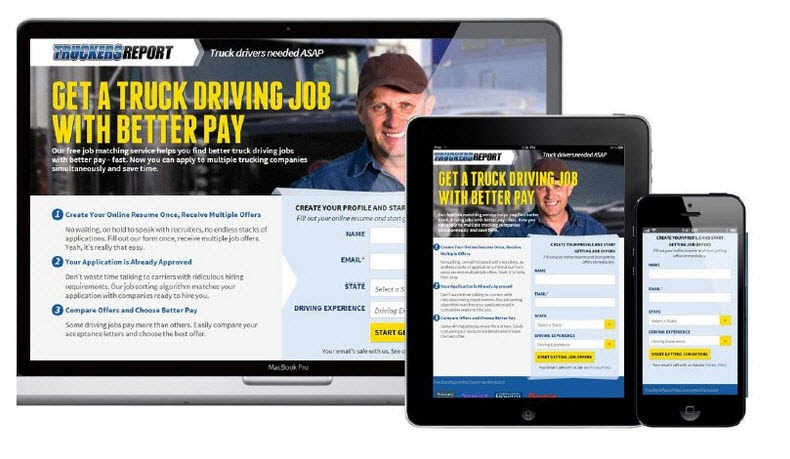

CXL a desfășurat 6 campanii de testare diferite pe această pagină de destinație pentru a obține mai multe clienți potențiali pentru certificările de șofer de camion.

Au crescut rata de înscriere de la 12,1% la 79,3%, toate din continuarea îmbunătățirii paginii.

(Aproape toate aceste campanii de testare au făcut mai multe încercări folosind aceeași ipoteză înainte de a vedea o creștere. Abia apoi, au trecut mai departe și au testat pentru a îmbunătăți celelalte elemente de pe pagină.)

Testarea A/B este un proces iterativ. Trebuie să continuați să testați și să ajustați pentru a găsi îmbunătățiri, și chiar și cei mai buni din domeniu ar putea găsi un câștigător doar în 10% din timp.

Dacă ipotetic ai fi o organizație și fiecare test pe care l-ai rulat a fost un succes, atunci acesta ar fi de fapt un steag roșu în opinia mea.

Sună contraintuitiv, dar îmi arată că testezi doar lucruri evidente și că nu se asumă suficient risc pentru a muta cu adevărat acul .

Deborah O'Malley, Ghici testul

Este întotdeauna grozav să înveți de la cei mai buni și suntem încântați să împărtășim interviul pe care l-am făcut cu Deborah. Am vorbit despre motivul pentru care testele nu sunt niciodată un eșec și despre importanța de a avea mentalitatea potrivită în testare. Pentru a vă ajuta să începeți cu piciorul bun, ascultați interviul nostru aici.

Asta înseamnă că s-ar putea să aveți nevoie de 9 teste înainte de a vedea un lift pozitiv, așa că rămâneți la el.

Testele dvs. ar trebui să urmeze un sistem de prioritate de la cel mai mare impact la cel mai mic. Efectuând mai multe teste și modificări pentru a vă îmbunătăți campania actuală, veți observa mult mai mult impact decât trecerea la un test de importanță mai mică, deoarece nu vedeți rezultate imediate cu cel actual.

Și dacă tot nu vede o creștere cu modificări mai mici, luați în considerare rularea unui test inovator în care executați un design diferit.

Poate fi un leagăn pentru gard, dar uneori poate fi schimbarea pe care trebuie să o faci.

Ce se întâmplă dacă după toate aceste teste și ajustări, varianta este încă un învins?

Deci datele sunt corecte și ați încercat fiecare modificare și chiar ați făcut modificări inovatoare mari la întreaga pagină și tot nu va funcționa mai bine decât controlul.

Poate că nu pare, dar acesta este de fapt un LUCRU BUN.

De ce?

Pentru că ai aflat ce nu funcționează cu publicul tău!

Atât de multe site-uri web fac schimbări majore fără a testa nimic și doar le lansează indiferent.

Întreabă-te asta:

Dacă acea variantă de pagină face o conversie cu doar 1% mai slabă decât controlul dvs. actual, câți bani ați economisit testând aceasta mai întâi și nu lansând-o?

Back in 2014, Marks and Spencer decided to update their entire website without testing it with a sample audience first.

Rezultatul?

Their online sales dropped by 8.1% in 3 months, causing a loss of $55 million.

This is why testing and finding losers is a really good thing because even losing tests can save you money.

What if the Test and the Variant Have Identical Results?

You checked everything, it all works, you've segmented down and gone into the nitty-gritty, but there's just no discernible difference between your current page and your new variant.

You've even tried complete page overhauls but through some fluke of math, your new page still converts at the same rate as the old one.

In this case, it's simply the dealer's choice.

Does the new variation more actively represent your brand and style?

If so, choose whichever you wish to use. The results are still the same but you are happier with the design.

Note: This should be the only time that you do this. Branding should not sacrifice results; it should aid them, as seen in the previous example.

Step #6: Double Down on Winners and Continue to Improve Them

So far we've been covering losing campaigns, but what if you got a winner right out of the gate?

First off, congratulations!

Second, let's make sure you actually have a winner. Oftentimes, things can happen to affect your results and give you a false positive (ie we think it's a winner but we implement it and nothing happens.)

Go ahead and run the test again with just your control and the winning variant and prove the lift in results first before you make any changes to your site.

Then if it really is a winner? Don't stop there, continue to improve it!

Iterative improvements of a new winning campaign are the easiest new test to run. With each new improvement, you'll see more ongoing ROI. You can even take what you learned with your winning test and then roll it out across similar pages on your site for further tests and see if it also adds lift there too.

Step #7: Create a Learning Repository for Future Tests

This step is relevant to both winning and losing tests.

Not only will it help you with future tests, but it will also help your QA team diagnose any broken campaigns faster, as they can see where issues have appeared in the past.

Better still?

It will help you document your results for clients or your boss, while also standardizing your reporting processes and ramping up your test velocity.

Iată cum funcționează:

You're going to create a master archive or learning repository of all past tests. A place to document your previous wins and losses that you can use to both reference for new campaigns and share with stakeholders or customers.

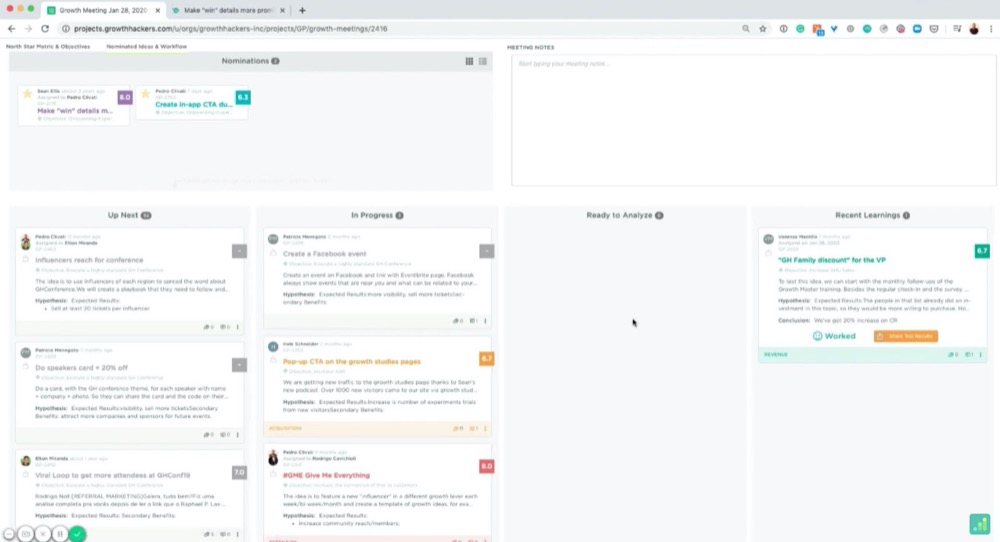

You can use a folder on your computer for this, but, if you really want to get organized, there's a great tool called GrowthHackers experiments.

Its main goal is to help marketing growth teams communicate and organize campaigns, but you can easily use it to manage your CRO testing and learnings. It will even pull in results from your test tool and allows you to archive each test. (You can simply tag and then add them to the repository.)

Whatever you decide to use, here are some best practices:

Organizing Your Tests

You probably have your own naming conventions but if you're just starting, I recommend naming each test like so:

“Goal – Campaign – Test Date”

De exemplu:

“CTR lift test – XYZ client – March 1st-14th 2021”

This way, you can organize tests by goals to get inspiration for future tests, search through and find them for client campaigns, or look back on your experiments month by month.

Then, if you wanted to run a CTR test later on, you can swipe through them and see what ideas worked or failed in the past.

How Do We Create Documents for the Learning Repository?

Feel free to add screenshots of your testing tools graphs, confidence, and power level or any data that you think is relevant.

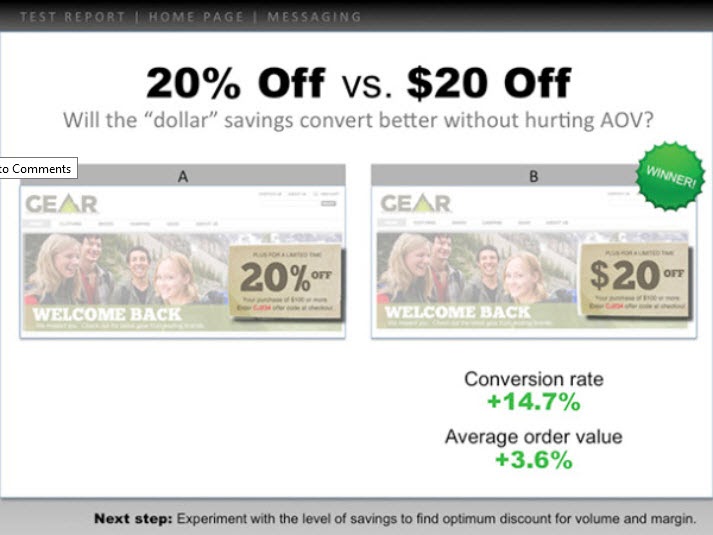

However, I highly recommend creating a slide with the following information:

- The hypothesis and how you came up with the idea (any survey data or information).

- A headline with the test goal.

- A screenshot of the control, the winning variant, and any other failed versions/tests that got some lift but not as much. (Highlight the key elements so you can spot what changed without having to look too hard.)

- Add the micro goal and its percentage lift. (Perhaps 3.2% CTR)

- Then add the macro goal and its percentage lift. (AVG order value up 2.2%, etc.)

Iată un exemplu:

You can use these slides to present the test information to anyone else who needs them, while also having a simple file to understand the test at a moment's notice.

Pretty handy, right?

Now that you've analyzed your test and recorded the results, let's walk you through how to present this to your boss in a way that even if the test failed, they're still happy to see your findings…

How To Present This Information To Your Boss (Even When Your Campaigns Failed)

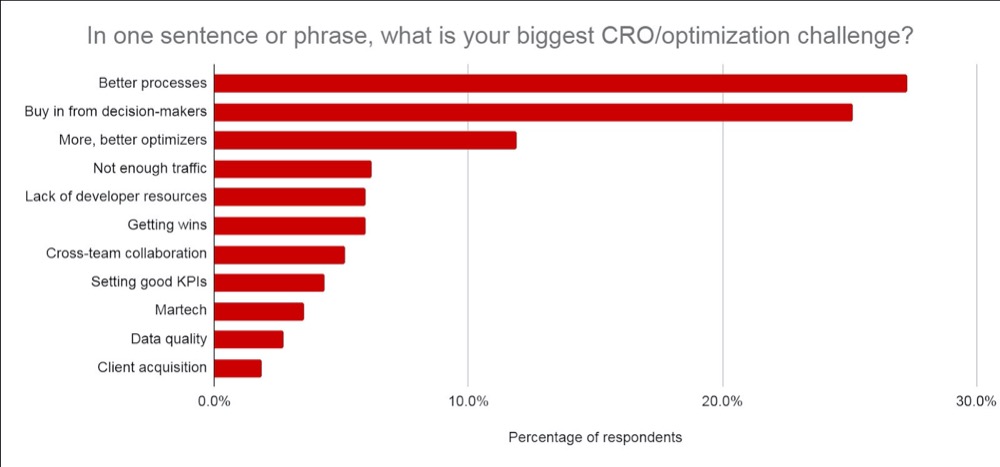

Don't worry if you feel anxious about this, you're not alone. In fact, according to CXL's state of the industry report, presenting test information or getting buy-in from your stakeholders is consistently one of the biggest struggles CROs face.

We've covered the best ways to communicate this information before, but I want to give you a few extra tips on how to get your test results across (even if your test failed).

Tip #1: Get Everyone On Board With CRO and Its Realities as Soon as Possible

Ideally, you covered this when you first broached the topic of running A/B tests but it never hurts to recap.

Make sure they understand that A/B testing is a continual learning process that's more about understanding your audience and improving their experience. The lift in ROI is simply a byproduct of taking action on each test and implementing what you learn, regardless of if it wins or fails.

Winners give lift and losers give insight into where to improve.

No test is ever wasted but the majority of them do fail. You're looking at roughly 1/10 winners for most people's tests and agencies are around 1/4.

Be clear on how many tests fail and the need to run more tests to find winners.

Tip #2: Present the Information as Simply as You Can

Not everyone can read graphs easily. Even if they can, it still means that it takes effort to understand the context of what they are seeing.

The more effort it takes to understand something, the more frustrating it can be and can cause you to lose the other person's attention.

(Top tip for landing pages btw ^^)

Break it down nice and simple by using the slides from your learning repository.

It should already include:

- Ce ai învățat înainte și cum ai ajuns la ideea de testare.

- Ce ai testat. Arată controlul, variațiile și câștigătorul.

- Cum a funcționat la nivel micro și macro. Includeți rezultatele.

Finally, add any insights you drew from tests to decide on your next important action to take. (Improve execution, test new variations, new hypothesis, etc.)

Providing insight into what happened is HUGE.

Șeful tău îi pasă mai mult de ceea ce ai învățat decât de rezultate, deoarece se poate acționa asupra lor. Împărtășirea acestui lucru și oferirea de idei despre ce să facă în continuare îi va ajuta să vadă că dețineți controlul asupra situației și îi va ajuta să se simtă încrezători în testele ulterioare.

Sfatul #3: Fă-le să arate bine

Fă un pas mai departe și adaugă date la care le pasă:

- Dacă testul a eșuat, atunci oferiți informații despre motivul pentru care credeți că a eșuat . Adăugați rentabilitatea investiției salvată prin nerularea testului eșuat și modul în care ar afecta MRR și ARR.

- Dacă a câștigat, atunci oferiți informații despre rentabilitatea investiției realizată și modul în care aceasta afectează veniturile/MRR și ARR de la an la an , împreună cu orice oportunitate de a-l extinde și de a obține o creștere mai mare a rentabilității investiției. (de exemplu, este posibil să fi testat o pagină de captare a clienților potențiali și să fi observat o creștere la modificarea aspectului. Este posibil să aveți alte 30 de pagini similare cărora le-ați putea aplica acest test, care ar putea vedea o creștere potențială.)

- Dacă testul a fost plat, atunci împărtășiți informații despre ceea ce credeți că s-a întâmplat și ce trebuie să faceți în continuare. (Execuție mai bună, o nouă variantă, o schimbare totală sau un test mai bine aliniat etc.)

Sigur, impactul ARR + MRR sau YOY este o estimare aproximativă, dar arată impactul potențial și valoarea testării dvs. La asta îi pasă șefului tău și la ce se gândește atunci când văd rezultatele tale.

Credeți-mă, când vă prezentați informațiile astfel, veți observa că sunt mult mai ușor. Treceți de la încadrarea testului ca „bani pierduți” sau o pierdere de timp la concentrarea pe potențialele economii, pe câștigurile reale și pe potențiala creștere ulterioară.

Nu numai asta, dar veți putea, de asemenea, să demonstrați valoarea efectuării și mai multor teste, maturizării eforturilor dvs. CRO și creșterii vitezei de testare.

Concluzie

Iată-l.

Până acum, ar trebui să vă simțiți mult mai încrezători în modul în care să analizați și să învățați din rezultatele testelor dvs. A/B și să puteți prezenta aceste informații șefului dvs. sau oricui altcuiva, indiferent de modul în care au fost efectuate testele dvs.

Pur și simplu urmați acest ghid pentru a eficientiza analiza post-test a fiecărui nou test A/B pe care îl rulați!