Cum să vă optimizați bugetul de accesare cu crawlere

Publicat: 2017-07-05În mai, am organizat un webinar în limba franceză despre bugetul de accesare cu crawlere Google. Pentru cel de-al doilea webinar cu OnCrawl, Erle Alberton, fost șef de SEO pentru Orange & Sosh (un furnizor de internet francez) și acum Customer Success Manager pentru OnCrawl, prezintă conceptul de buget cu crawl, cele mai bune practici pentru optimizarea acestuia, ce trebuie evitat etc. Practic. exemplele vor ilustra acest concept care a fost confirmat recent de echipa Google.

Ce spune Google despre bugetul de accesare cu crawlere

La mijlocul lunii ianuarie, Google a postat un articol pe blogul lor în care afirma: „nu avem un singur termen care să descrie tot ceea ce înseamnă „buget cu crawl” extern. ” Cu alte cuvinte, ceea ce noi, SEO, considerăm bugetul de crawl.

Gigantul web indică, de asemenea, că, dacă noile pagini sunt de obicei accesate cu crawlere în aceeași zi a publicării lor, atunci nu trebuie să vă faceți griji cu privire la bugetul de accesare cu crawlere. De asemenea, se precizează că, dacă un site are mai puțin de câteva mii de adrese URL, acesta va fi accesat corect, deoarece bugetul de accesare cu crawlere este de obicei rezervat site-urilor cu volum mare... Acest lucru este atât corect, cât și greșit, deoarece toate site-urile din Google Search Console au un buget de accesare cu crawlere. Putem vedea cu ușurință acest lucru în valorile Google.

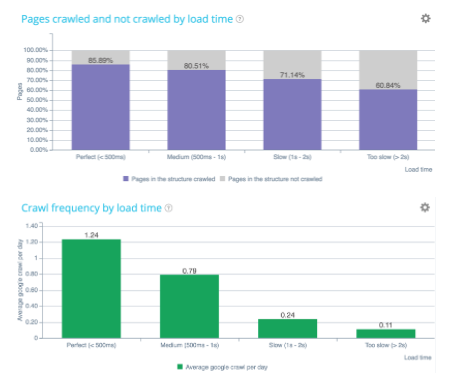

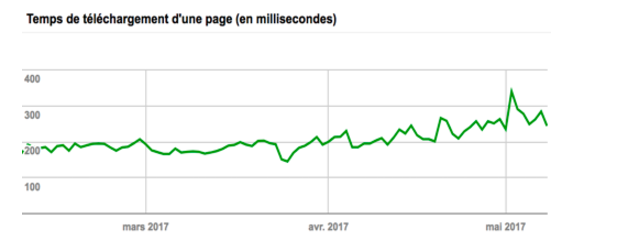

De asemenea, aflăm în acest articol că Google încearcă să atingă o „limită a ratei de accesare cu crawlere” care limitează rata maximă de preluare pentru un anumit site. Putem observa că, de exemplu, atunci când un timp de încărcare este prea lung, Google își reduce bugetul aproape în 2. Acestea fiind spuse, există factori care pot afecta bugetul de accesare cu crawlere, cum ar fi arhitectura proastă (sistem, coduri de stare, structură internă). ), conținut slab și/sau duplicat, capcane de păianjen etc.

Cum funcționează bugetul de accesare cu crawlere Google?

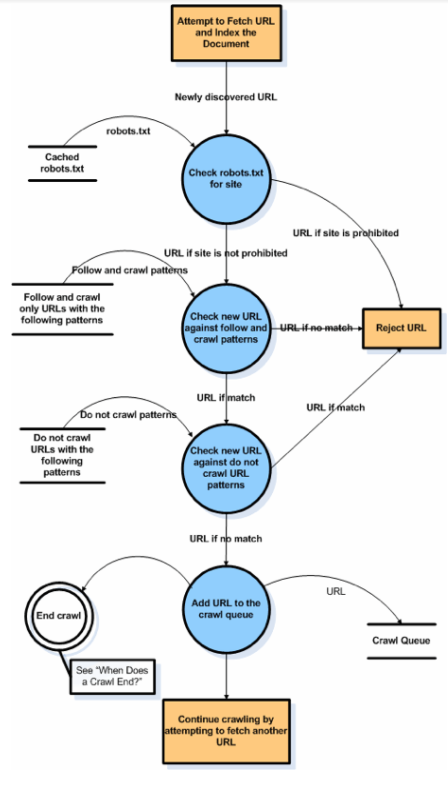

Crawl-ul Google este un set de pași simpli care funcționează recursiv pentru fiecare site. Iată un grafic de la Google în care vedem că accesarea cu crawlere începe cu o lovitură pe un robot txt și apoi se separă într-un set de adrese URL care sunt compilate într-o listă. În continuare, Google încearcă să le preia în timp ce compară cu adresele URL pe care le cunoaște deja, în plus față de cele pe care le are deja în backup.

Scopul său este să-și completeze indexul în mod exhaustiv și precis. Vedem că, chiar dacă site-ul este în JavaScript, Google va trimite crawlere de nivel al treilea. Ar trebui să fiți totuși atenți la site-urile JavaScript, deoarece acestea consumă o mulțime de resurse bot și sunt trimise în medie doar o dată pe trimestru. Trebuie să ne regândim metoda, astfel încât Google să aibă acces la pagini din afara navigației JavaScript.

Google va verifica apoi starea actualizării paginii (comparație cu conținutul indexat anterior) pentru a evalua dacă pagina este importantă sau mai puțin importantă. Într-adevăr, Google trebuie să își optimizeze resursele de accesare cu crawlere, deoarece nu poate accesa cu crawlere fiecare pagină a tuturor site-urilor web. Se numește importanța paginii… este un scor foarte important de urmărit și pe care îl vom vedea în detalii mai jos!

Fapt: dacă Google optimizează, este pentru că există un motiv

Bugetul de accesare cu crawlere depinde de:

- Capacitatea site-ului de a răspunde rapid;

- Sanitatea site-ului – 4xx, 5xx, 3xx (când un site începe să aibă 404s sau 500s, bugetul de accesare cu crawlere va fi afectat, deoarece va verifica întotdeauna dacă s-au făcut remedieri);

- Calitatea conținutului – semantică și exhaustivitate;

- Diversitatea Anchor (o pagină este considerată importantă atunci când primește o mulțime de link-uri. Cu InRank-ul OnCrawl poți analiza totul);

- Popularitatea paginii – externă și internă;

- Factori optimizabili – simplificați accesarea cu crawlere (reduceți dimensiunea imaginii, capacitatea de a avea css, js, gif, fonturi etc.)

[Studiu de caz] Măriți bugetul de accesare cu crawlere pe paginile strategice

Componentele cheie ale Google Page Importance

Definiția importanței paginii nu este aceeași cu Page Rank:

- Locația paginii pe site – adâncimea ratei de accesare cu crawlere;

- Page Rank: TF/CF al paginii – Majestic;

- Internal Page Rank – InRank al lui OnCrawl;

- Tip de document: PDF, HTML, TXT (PDF este de obicei un document calitativ final, așa că este accesat cu crawlere);

- Includerea în sitemap.xml;

- Număr de link-uri interne:

- Calitatea/importanța ancorei;

- Conținut calitativ: număr de cuvinte, puține aproape duplicate (Google va penaliza conținut similar dacă paginile sunt prea apropiate în conținut);

- Importanța paginii de „acasă”.

Cum să planificați adrese URL importante de accesat cu crawlere

Programarea adreselor URL: ce pagini dorește să viziteze Google și cât de des?

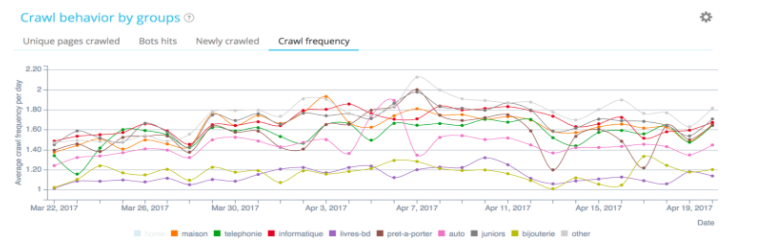

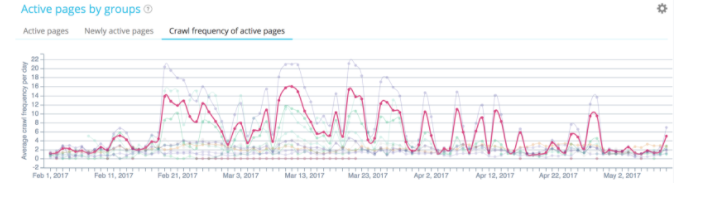

În exemplul de mai sus, (observarea unei frecvențe de accesare cu crawlere a aceluiași site) Google nu accesează cu crawlere la aceeași frecvență pe diferitele grupuri. Vedem că atunci când Google accesează cu crawlere o parte a site-ului, impactul clasamentului se vede rapid.

Mai multe informații despre bugetul de accesare cu crawlere Google

- 100% dintre site-urile Google Search Console au date de accesare cu crawlere;

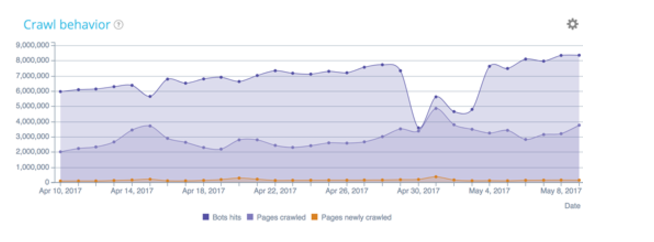

- Îi putem urmări comportamentul de crawler datorită unei analize de jurnal care vă ajută să detectați rapid o anomalie în comportamentul botului;

- O structură internă proastă (paginare, pagini orfane, capcane spider) poate împiedica Google să acceseze cu crawlere paginile potrivite;

- Bugetul de accesare cu crawlere este direct legat de clasare.

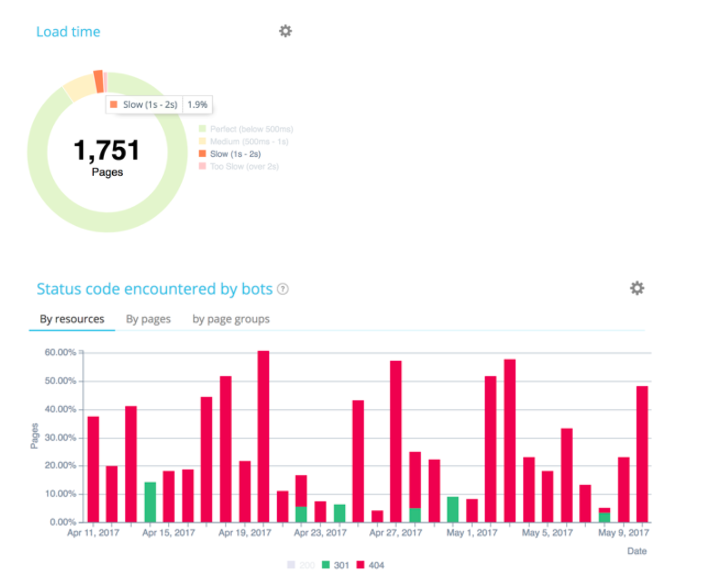

Viteza paginii mai întâi

Cel mai important factor este timpul de încărcare a paginii, deoarece joacă un rol decisiv asupra bugetului de accesare cu crawlere. Într-adevăr, astăzi ne aflăm într-o lume mobilă. Cel mai bun activ al dvs. este, prin urmare, timpul de încărcare a paginii pentru a vă optimiza bugetul de accesare cu crawlere și SEO. Odată cu revoluția mobilă, timpul de încărcare este un factor esențial în evaluarea calității unui site. Capacitatea sa de a răspunde rapid – în special pentru mobil și mobil indexat mai întâi.

Pentru a-l optimiza, putem folosi soluții CDN (Content Delivery Network) precum Cloudflare. Aceste soluții permit roboților Google să fie cât mai aproape de resurse și să încarce paginile cât mai repede posibil.

Google testează în mod constant capacitatea unui site de a răspunde rapid. Arhitectura și calitatea codificării au un impact puternic asupra notației Google.

Timp de încărcare

Este primul factor de alocare al bugetului de accesare cu crawlere!

În ceea ce privește serverul , trebuie să:

- Evitați redirecționările;

- Autorizați compresia;

- Îmbunătățiți timpul de răspuns.

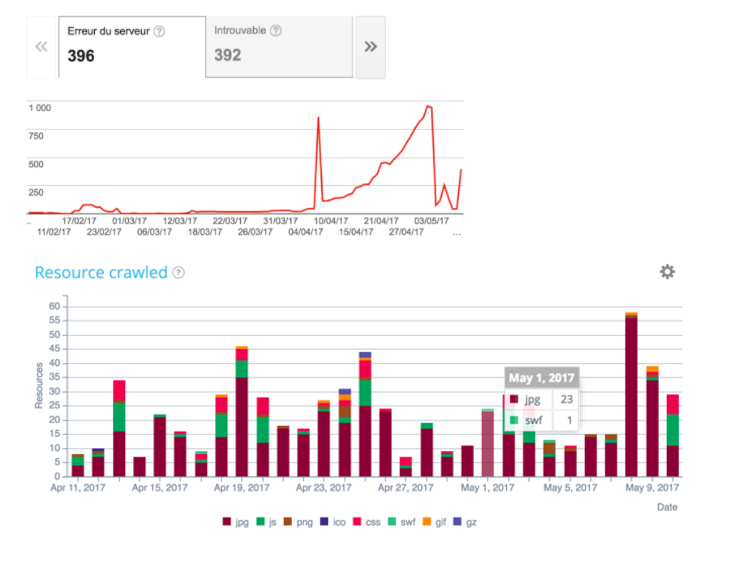

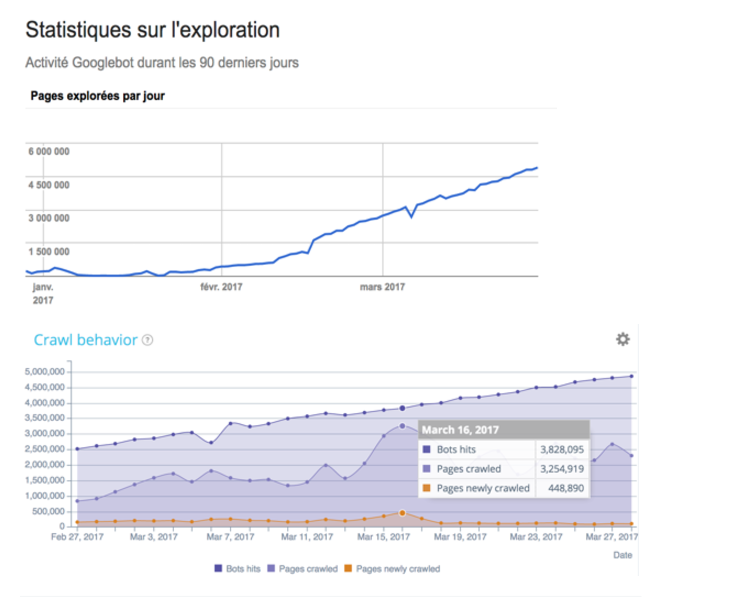

Mai sus, un exemplu cu site-ul lui Manageo care avea un buget de crawlere liniar și unde putem observa o creștere liniară. În luna mai, există o scădere a numărului de pagini accesate cu crawlere pe zi și, în consecință, o schimbare a vitezei site-ului. Google vede că site-ul răspunde mai puțin rapid, așa că își reduce la jumătate bugetul de accesare cu crawlere. Pentru a corecta toate acestea, trebuie să vă optimizați codurile pe partea de server, să reduceți redirecționările, să utilizați compresia și așa mai departe.

În ceea ce privește fața , trebuie să:

- Operați memorarea în cache a browserului

- Reduceți dimensiunea resurselor (optimizarea imaginii, folosiți CDN/încărcare leneră/ștergeți JS care blochează afișarea);

- Utilizați scripturi asincrone.

Scăderea calității = gata de dragoste = gata de buget

Este necesar să verificați codurile de stare trimise înapoi roboților Google pentru a vă asigura că IS-ul este curat. Acesta este singurul mod prin care Google poate valida că calitatea codului și arhitectura dvs. sunt curate.

Urmărirea evoluției lor în timp asigură că actualizările de cod sunt prietenoase cu SEO. Google cheltuiește mult pe resurse (css, img, js), așa că asigurați-vă că acestea sunt impecabile.

Conținut unic și bogat

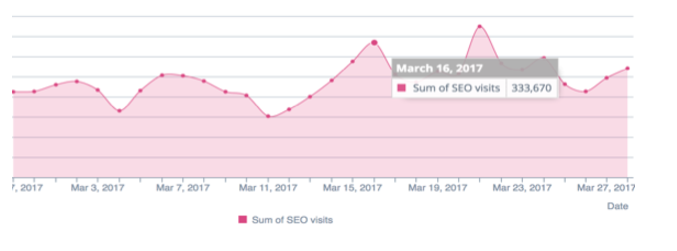

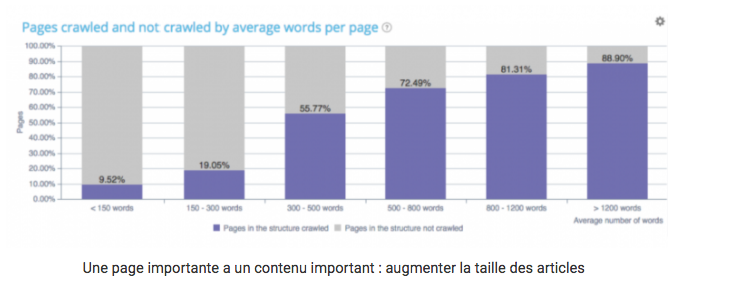

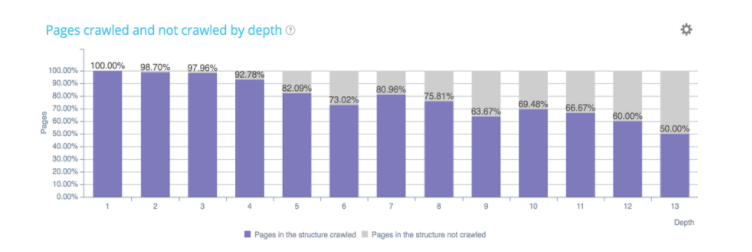

Mai importantă este o pagină, cu atât textul acesteia este mai bogat. După cum se arată mai sus, numărul de pagini accesate cu crawlere și nu de Google este legat de numărul de cuvinte care se află pe pagină. Prin urmare, paginile dvs. ar trebui să fie îmbunătățite și actualizate cât mai regulat posibil.

Feriți-vă de canonice și de conținut duplicat

Google va cheltui de două ori mai mult buget atunci când două pagini similare nu indică aceeași adresă URL canonică. Astfel, managementul canonic poate deveni critic pentru site-urile cu fațete sau link-uri externe cu queryString.

Gestionarea conținutului aproape duplicat și canonicalele devin aspecte importante ale optimizării bugetului de accesare cu crawlere.

Structura internă și distribuția InRank

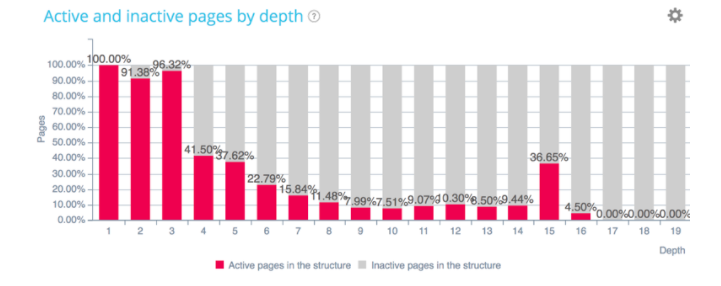

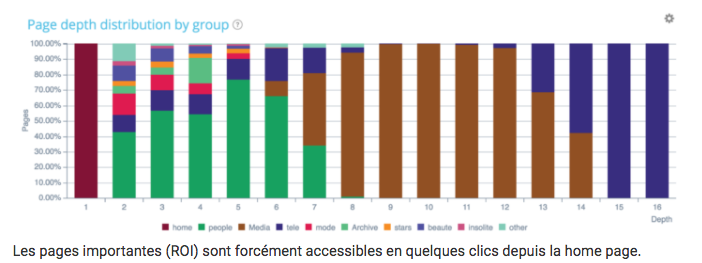

Paginile care generează vizite SEO sunt considerate active. Acestea sunt cele care se află în vârful arhitecturii site-ului. Pe de altă parte, vedem aici că la pagina 15 apare un grup de pagini. Poate că aceste pagini sunt mult mai căutate de utilizatorii dvs. decât credeați și ar trebui să fie actualizate în arhitectură pentru a le îmbunătăți clasarea.

După cum știm, cu cât paginile sunt mai adânci, cu atât Google le va vizita mai puțin!

Sunt paginile mele de bani bine localizate?

Sfat: Dacă doriți să optimizați adâncimea anumitor grupuri de pagini, nu ezitați să creați planuri de site html, adică pagini care sunt cruciale pentru gestionarea profunzimii dvs.

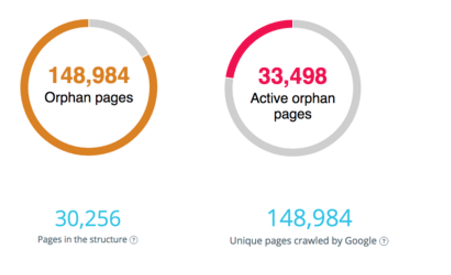

Google va compara paginile structurii dvs. vs accesate cu crawlere vs active. Acestea fiind spuse, ar fi în avantajul tău să rezolvi problema paginilor orfane pentru care Google cheltuiește inutil buget și să repari arhitectura site-ului pentru a returna link-uri către pagini active, dar în afara structurii.

Uneori paginile nu mai primesc link-uri, ele se numesc pagini orfane. Pe de altă parte, Google nu a uitat de ele. Va continua să-i viziteze. Nu mai primesc link-uri așa că își pierd din importanță, dar în graficul din dreapta, unele pagini orfane continuă să primească vizite SEO. Ceea ce trebuie să știți este cum să le identificați rapid și să remediați problemele de legătură care sunt în arhitectură. Aceasta este o modalitate excelentă de a vă optimiza bugetul de accesare cu crawlere.

Greșeli de care să stai departe

- Robots.txt în 404;

- Sitemap.xml & sitemap.html învechit;

- Erori 50x / 40x / soft 404;

- Având redirecționări în lanț;

- Erori canonice;

- Conținut duplicat (subsol) / aproape duplicat / HTTP vs HTTPS;

- Timp de răspuns prea lung;

- Greutatea paginii prea importantă;

- AMP/ erori. Acest protocol este utilizat pe scară largă de Google în special pentru site-urile de comerț electronic (nu doar site-uri media);

- Legătură internă greșită + Rel=nofollow;

- Folosind JS fără altă alternativă.

Concluzii

Pentru a optimiza bugetul de accesare cu crawlere, trebuie să:

- Cunoaște-ți paginile de bani și cunoașteți reacțiile Google;

- Îmbunătățiți timpul de încărcare;

- Optimizați-vă linkurile interne: puneți toate paginile de bani în partea de sus a structurii;

- Remediați paginile orfane;

- Adăugați text în paginile dvs. de bani;

- Actualizați la maximum paginile dvs. de bani – prospețime;

- Reduceți conținutul slab și duplicatele;

- Optimizați-vă canonicalele, imaginile, greutatea resurselor;

- Evitați redirecționările în lanț;

- Monitorizați-vă jurnalele și reacționați atunci când există anomalii (consultați acest caz de utilizare de la Manageo în timpul SEOcamp Lyon despre acest subiect).

Pentru a optimiza bugetul de accesare cu crawlere, trebuie să monitorizați cu exactitate crawler-ul Google

Unele momente ale drumului Google pe site-ul tău sunt mai importante decât altele, așa că trebuie să știi cum să le optimizezi.

Pentru a optimiza bugetul de accesare cu crawlere, este necesar să gestionați corect migrarea HTTPS (HTTP2).

Trebuie să-l poți urmări și monitoriza. Provocați-vă echipele IT să migreze la HTTP2 cu HTTPS.

OnCrawl vă ajută să urmăriți zilnic bugetul de accesare cu crawlere Google și țintește rapid remedieri și modificări structurale pentru a vă îmbunătăți performanța SEO.