Nicăieri de ascuns: blocarea conținutului din motoarele de căutare

Publicat: 2022-06-12TL;DR

- Dacă vă gândiți să excludeți conținut din motoarele de căutare, asigurați-vă mai întâi că o faceți din motivele corecte.

- Nu faceți greșeala de a presupune că puteți ascunde conținutul într-o limbă sau într-un format pe care roboții nu îl vor înțelege; asta e o strategie miop. Fiți în fața lor folosind fișierul robots.txt sau eticheta Meta Robots.

- Nu uita că, doar pentru că folosești metodele recomandate pentru a bloca conținut, ești în siguranță. Înțelegeți cum blocarea conținutului va face site-ul dvs. să apară pentru roboți.

Când și cum să excludeți conținut dintr-un index al motorului de căutare

O fațetă majoră a SEO este a convinge motoarele de căutare că site-ul dvs. este reputat și oferă o valoare reală pentru cei care caută. Iar pentru ca motoarele de căutare să determine valoarea și relevanța conținutului tău, trebuie să se pună în pielea unui utilizator.

Acum, software-ul care se uită la site-ul dvs. are anumite limitări pe care SEO-urile le-au exploatat în mod tradițional pentru a păstra anumite resurse ascunse de motoarele de căutare. Totuși, boții continuă să se dezvolte și devin din ce în ce mai sofisticați în eforturile lor de a vă vedea pagina web așa cum ar face-o un utilizator uman într-un browser. Este timpul să reexaminați conținutul de pe site-ul dvs. care nu este disponibil pentru roboții motoarelor de căutare, precum și motivele pentru care nu este disponibil. Există încă limitări în roboți, iar webmasterii au motive legitime pentru blocarea sau externalizarea anumitor părți de conținut. Deoarece motoarele de căutare caută site-uri care să ofere conținut de calitate utilizatorilor, lăsați experiența utilizatorului să vă ghideze proiectele, iar restul se va pune în aplicare.

De ce blocați conținutul?

- Conținut privat. Obținerea paginilor indexate înseamnă că acestea sunt disponibile pentru a fi afișate în rezultatele căutării și, prin urmare, sunt vizibile pentru public. Dacă aveți pagini private (informații despre contul clienților, informații de contact pentru persoane fizice etc.) doriți să le păstrați în afara indexului. (Unele site-uri de tip whois afișează informații despre înregistrare în JavaScript pentru a împiedica roboții scraper să fure informații personale.)

- Conținut duplicat. Fie că sunt fragmente de text (informații despre mărci comerciale, sloganuri sau descrieri) sau pagini întregi (de exemplu, rezultate personalizate de căutare pe site-ul dvs.), dacă aveți conținut care apare pe mai multe adrese URL de pe site-ul dvs., păianjenii motoarelor de căutare ar putea vedea acest lucru ca fiind de calitate scăzută. . Puteți utiliza una dintre opțiunile disponibile pentru a bloca paginile respective (sau resursele individuale dintr-o pagină) să nu fie indexate. Le puteți păstra vizibile pentru utilizatori, dar blocate din rezultatele căutării, ceea ce nu vă va afecta clasamentul pentru conținutul pe care doriți să îl afișați în căutare.

- Conținut din alte surse. Conținutul, cum ar fi reclamele, care sunt generate de surse terțe și sunt duplicate în mai multe locuri de pe web, nu fac parte din conținutul principal al unei pagini. Dacă acel conținut publicitar este duplicat de mai multe ori pe web, un webmaster poate dori să împiedice afișarea anunțurilor ca parte a paginii.

Asta are grijă de ce, ce zici de cum?

Mă bucur că ai întrebat. O metodă care a fost folosită pentru a menține conținutul în afara indexului este să încărcați conținutul dintr-o sursă externă blocată folosind un limbaj pe care roboții nu o pot analiza sau executa; este ca atunci când îi spui cuvintele unui alt adult pentru că nu vrei ca copilul mic din cameră să știe despre ce vorbești. Problema este că copilul în această situație devine mai inteligent. Pentru o lungă perioadă de timp, dacă ai vrut să ascunzi ceva de motoarele de căutare, ai putea folosi JavaScript pentru a încărca acel conținut, ceea ce înseamnă că utilizatorii îl primesc, roboții nu.

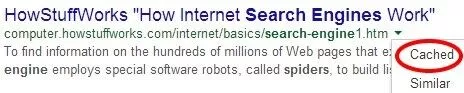

Dar Google nu este deloc timidă cu privire la dorința lor de a analiza JavaScript cu roboții lor. Și încep să o facă; instrumentul Preluare ca Google din Instrumentele pentru webmasteri vă permite să vedeți pagini individuale așa cum le văd roboții Google.

Dacă utilizați JavaScript pentru a bloca conținutul site-ului dvs., ar trebui să verificați unele pagini din acest instrument; șansele sunt, Google îl vede.

Rețineți, totuși, că doar pentru că Google poate reda conținut în JavaScript nu înseamnă că conținutul este stocat în cache. Instrumentul „Preluare și randare” vă arată ce poate vedea botul; pentru a afla ce este indexat, ar trebui să verificați în continuare versiunea stocată în cache a paginii.

Există o mulțime de alte metode de externalizare a conținutului pe care oamenii le discută: iframes, AJAX, jQuery. Dar încă din 2012, experimentele arătau că Google putea accesa cu crawlere linkurile plasate în cadre iframe; deci acolo merge acea tehnică. De fapt, zilele vorbirii unei limbi pe care roboții nu o puteau înțelege se apropie de sfârșit.

Dar dacă le ceri politicos roboților să evite să se uite la anumite lucruri? Blocarea sau interzicerea elementelor din robots.txt sau din eticheta Meta Robots este singura modalitate sigură (în scurt timp de directoarele de server care protejează cu parolă) de a împiedica indexarea elementelor sau a paginilor.

John Mueller a comentat recent că conținutul generat cu fluxuri AJAX/JSON ar fi „invizibil pentru [Google] dacă ați interzis accesarea cu crawlere a JavaScript-ului”. El continuă să clarifice că simpla blocare a CSS sau JavaScript nu vă va afecta neapărat clasamentul: „Cu siguranță nu există o relație simplă „CSS sau JavaScript nu este permis accesul cu crawlere, prin urmare algoritmii de calitate văd site-ul în mod negativ”. Deci, cea mai bună modalitate de a păstra conținutul în afara indexului este pur și simplu să ceri motoarele de căutare să nu indexeze conținutul. Acestea pot fi adrese URL individuale, directoare sau fișiere externe.

Aceasta, deci, ne readuce la început: de ce. Înainte de a decide să blocați orice conținut, asigurați-vă că știți de ce o faceți, precum și riscurile. În primul rând, blocarea fișierelor dvs. CSS sau JavaScript (în special a celor care contribuie substanțial la aspectul site-ului dvs.) este riscantă; poate, printre altele, să împiedice motoarele de căutare să vadă dacă paginile dvs. sunt optimizate pentru mobil. Nu numai că, dar după lansarea Panda 4.0, unele site-uri care au fost lovite puternic au reușit să revină prin deblocarea CSS și JavaScript, ceea ce ar indica că au fost vizate în mod special de algoritmul Google pentru blocarea acestor elemente de la roboți.

Încă un risc pe care îl asumați când blocați conținut: este posibil ca paianjenii motoarelor de căutare să nu poată vedea ce este blocat, dar știu că ceva este blocat, așa că ar putea fi forțați să facă presupuneri cu privire la ceea ce este acel conținut. Ei știu că reclamele, de exemplu, sunt adesea ascunse în cadre iframe sau chiar în CSS; deci, dacă aveți prea mult conținut blocat în partea de sus a unei pagini, riscați să fiți lovit de algoritmul de aspect al paginii „Top Heavy”. Orice webmasteri care citesc acest lucru și care se gândesc să folosească iframe ar trebui să ia în considerare cu fermitate consultarea cu un SEO de renume. (Inserați aici promoția BCI nerușinată.)