Cum să gestionați turbarea de roboți și lupta cu păianjeni pentru clasamente?

Publicat: 2020-01-23

Crawlerele Google indexează fiecare conținut pe care îl publicați pe site-ul dvs. web. Aceste crawler-uri sunt programe software programate care urmăresc link-uri și coduri și le livrează unui algoritm. Apoi, algoritmul îl indexează și vă adaugă conținutul la o bază de date vastă. În acest fel, ori de câte ori un utilizator caută un cuvânt cheie, motorul de căutare extrage și clasifică rezultatele aferente din baza de date a paginilor deja indexate.

Google alocă un buget de accesare cu crawlere fiecărui site web, iar crawlerele execută accesarea cu crawlere a site-ului dvs. în consecință. Trebuie să gestionați și să utilizați bugetul de accesare cu crawlere pentru a asigura accesarea și indexarea inteligentă a întregului site web.

În această postare, puteți afla despre trucurile și instrumentele pentru a gestiona modul în care motoarele de căutare roboții/păianjenii sau crawlerele accesează cu crawlere și indexează site-ul dvs.

1. Optimizarea Directivei Disallow pentru Robot.txt:

Robots.txt este un fișier text cu o sintaxă strictă care funcționează ca un ghid pentru păianjeni pentru a determina cum să acceseze cu crawlere site-ul dvs. Un fișier robots.txt este salvat în arhivele gazdă ale site-ului dvs. web, de unde crawlerele caută adresele URL. Pentru a optimiza aceste Robots.txt sau „Protocol de excludere a robotilor”, puteți folosi câteva trucuri care pot ajuta adresele URL ale site-ului dvs. să fie accesate cu crawlere de către crawlerele Google pentru poziții mai înalte.

Unul dintre aceste trucuri este folosirea unei „Directive de respingere” , aceasta este ca și cum ați pune un panou cu „Zona restricționată” pe anumite secțiuni ale site-ului dvs. Pentru a optimiza Directiva Disallow, trebuie să înțelegeți prima linie de apărare: „User-agents”.

Ce este o directivă User-agent?

Fiecare fișier Robots.txt constă dintr-una sau mai multe reguli și dintre acestea, regula user-agent este cea mai importantă. Această regulă oferă crawler-urilor acces și non-acces la o anumită listă de pe site.

Deci, directiva user-agent este folosită pentru a se adresa unui anumit crawler și pentru a-i oferi instrucțiuni despre cum să execute crawlerul.

Tipuri de crawlere Google utilizate în mod popular:

Directiva de respingere:

Acum, după ce ați aflat despre botul care este desemnat să acceseze cu crawlere site-ul dvs., puteți optimiza diferite secțiuni ale acestuia în funcție de tipul de user-agent. Câteva trucuri și exemple esențiale pe care le puteți urma pentru a optimiza directiva de interdicție a site-ului dvs. sunt:

- Folosiți un nume complet de pagină care poate fi afișat în browser pentru a fi folosit pentru directiva disallow.

- Dacă doriți să redirecționați crawler-ul dintr-o cale de director, utilizați marcajul „/”.

- Utilizați * pentru prefixul de cale, sufixul sau un șir întreg.

Exemple de utilizare a directivelor disallow sunt:

# Exemplul 1: blocați numai Googlebot

Agent utilizator: Googlebot

Nu permite: /

# Exemplul 2: blocați Googlebot și Adsbot

Agent utilizator: Googlebot

Agent utilizator: AdsBot-Google

Nu permite: /

# Exemplul 3: blocați toate crawlerele cu excepția AdsBot

Agent utilizator: *

Nu permite: /

2. O directivă non-index pentru Robots.txt:

Când alte site-uri web trimit la site-ul dvs., atunci există șanse ca adresa URL, pe care nu doriți să o indexeze crawler-ul, să poată fi expusă. Pentru a depăși această problemă, puteți utiliza o directivă non-index. Să vedem cum putem aplica directiva non-index la Robots.txt:

Există două metode de a aplica o directivă non-index pentru site-ul dvs. web:

Etichete <Meta>:

Metaetichetele sunt fragmente de text care descriu conținutul paginii dvs. într-un mod scurt și transparent, care permite vizitatorilor să știe ce urmează? Putem folosi același lucru pentru a evita ca crawlerele să indexeze pagina.

Mai întâi, plasați o etichetă meta „<meta name= „robots” content=" noindex”>” în secțiunea „<head>” a paginii pe care nu doriți să o indexeze crawlerele.

Pentru crawlerele Google, puteți folosi „<meta name="googlebot” content="noindex”/>” în secțiunea „<head>”.

Deoarece diferiți crawler-uri ale motoarelor de căutare caută paginile dvs., aceștia pot interpreta în mod diferit directiva dvs. non-index. Din acest motiv, paginile dvs. pot apărea în rezultatele căutării.

Deci, ar fi de ajutor dacă ați defini directive pentru pagini în funcție de crawler-uri sau user-agents.

Puteți utiliza următoarele metaetichete pentru a aplica directiva pentru diferite crawler-uri:

<meta name="googlebot” content="noindex”>

<meta name="googlebot-news” content="nosnippet”>

Eticheta X-Robots:

Știm cu toții despre anteturile HTTP care sunt folosite ca răspunsuri la solicitarea clientului sau a motorului de căutare pentru informații suplimentare legate de paginile dvs. web, cum ar fi locația sau serverul care le furnizează. Acum, pentru a optimiza aceste răspunsuri de antet HTTP pentru directiva non-index, puteți adăuga etichete X-Robots ca element al răspunsului antet HTTP pentru orice adresă URL dată a site-ului dvs.

Puteți combina diferite etichete X-Robots cu răspunsurile de antet HTTP. Puteți specifica diverse directive într-o listă separată prin virgulă. Mai jos este un exemplu de răspuns de antet HTTP cu diferite directive combinate cu etichete X-Robots.

HTTP/1.1 200 OK

Data: marți, 25 ianuarie 2020 21:42:43 GMT

(...)

X-Robots-Tag: noarchive

X-Robots-Tag: unavailable_after: 25 iulie 2020 15:00:00 PST

(...)

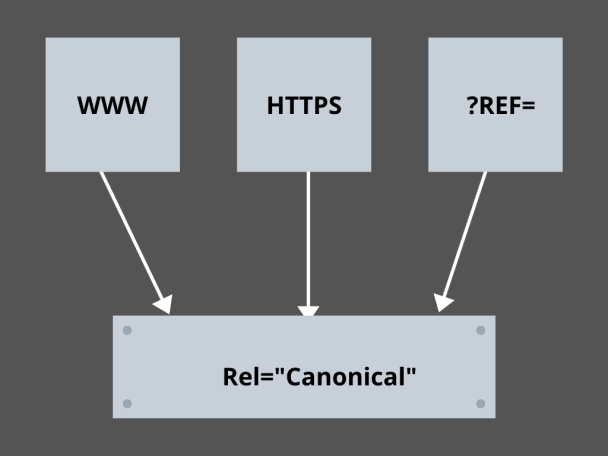

3. Stăpânirea legăturilor canonice:

Care este cel mai de temut factor în SEO astăzi? Clasamente? Trafic? Nu! Este teama ca motoarele de căutare să vă penalizeze site-ul pentru conținut duplicat. Așadar, în timp ce vă stabiliți o strategie pentru bugetul de accesare cu crawlere, trebuie să aveți grijă să nu vă expuneți conținutul duplicat.

Aici, stăpânirea linkurilor dvs. canonice vă va ajuta să vă gestionați problemele de conținut duplicat. Cuvântul conținut duplicat nu este ceea ce înseamnă. Să luăm un exemplu de două pagini ale unui site de comerț electronic:

De exemplu, aveți un site de comerț electronic cu o pereche de pagini identice pentru un ceas inteligent și ambele au conținut similar. Când roboții motoarelor de căutare vă accesează cu crawlere adresa URL, ei vor verifica dacă există conținut duplicat și pot alege oricare dintre adresele URL. Pentru a le redirecționa către adresa URL care este esențială pentru dvs., se poate seta un link canonic pentru pagini. Hai să vedem cum poți să o faci:

- Alegeți oricare dintre cele două pagini pentru versiunea canonică.

- Alegeți-l pe cel care primește mai mulți vizitatori.

- Acum adăugați rel="canonical" la pagina dvs. non-canonică.

- Redirecționează linkul paginii non-canonice către pagina canonică.

- Acesta va îmbina ambele link-uri de pagină ca un singur link canonic.

4. Structurarea site-ului web:

Crawlerele au nevoie de marcatoare și panouri care să îi ajute să descopere adresele URL importante ale site-ului dvs. și, dacă nu vă structurați site-ul, crawlerelor le este dificil să execute accesarea cu crawlere a adreselor dvs. URL. Pentru aceasta, folosim hărți de site deoarece oferă crawler-urilor link-uri către toate paginile importante ale site-ului dvs.

Formatele standard de hărți de site pentru site-uri web sau chiar aplicații dezvoltate prin procesele de dezvoltare a aplicațiilor mobile sunt hărțile de site XML, Atom și RSS. Pentru a optimiza accesarea cu crawlere, trebuie să combinați hărțile de site XML și fluxurile RSS/Atom.

- Deoarece, hărțile de site XML oferă crawlerelor indicații către toate paginile de pe site-ul sau aplicația dvs.

- Și RSS/Atom feed oferă actualizări în paginile dvs. ale site-ului web pentru crawlere.

- Deoarece, hărțile de site XML oferă crawlerelor indicații către toate paginile de pe site-ul sau aplicația dvs.

5. Navigarea paginilor:

Navigarea în pagină este esențială pentru păianjeni și chiar pentru vizitatorii site-ului dvs. Aceste cizme caută pagini de pe site-ul dvs., iar o structură ierarhică predefinită poate ajuta crawlerii să găsească pagini care contează pentru site-ul dvs. Alți pași de urmat pentru o navigare mai bună în pagină sunt:

- Păstrați codarea în HTML sau CSS.

- Aranjați-vă paginile ierarhic.

- Utilizați o structură superficială a site-ului web pentru o navigare mai bună în pagină.

- Păstrați meniul și filele din antet pentru a fi minime și specifice.

- Va ajuta navigarea pe pagină să fie mai ușoară.

6. Evitarea capcanelor de păianjen:

Capcanele de păianjen sunt adrese URL infinite care indică același conținut pe aceleași pagini atunci când crawlerele accesează cu crawlere site-ul dvs. Acest lucru este mai degrabă ca să împușcăm blancuri. În cele din urmă, îți va consuma bugetul de accesare cu crawlere. Această problemă se intensifică cu fiecare accesare cu crawlere, iar site-ul dvs. web este considerat a avea conținut duplicat, deoarece fiecare adresă URL pe care este accesată cu crawlere în capcană nu va fi unică.

Puteți sparge capcana blocând secțiunea prin Robots.txt sau folosiți una dintre directivele follow sau no follow pentru a bloca anumite pagini. În cele din urmă, puteți căuta să remediați problema din punct de vedere tehnic, oprind apariția URL-urilor infinite.

7. Structura de legătură:

Interconectarea este una dintre părțile esențiale ale optimizării accesului cu crawlere. Crawlerii vă pot găsi mai bine paginile cu link-uri bine structurate pe site-ul dvs. Unele dintre trucurile cheie pentru o structură excelentă de legătură sunt:

- Utilizarea linkurilor text, deoarece motoarele de căutare le accesează cu crawlere cu ușurință: <a href="new-page.html”>link text</a>

- Utilizarea textului ancoră descriptiv în linkurile dvs

- Să presupunem că gestionați un site web de sală și doriți să conectați toate videoclipurile dvs. de la sală, puteți utiliza un link ca acesta - Simțiți-vă liber să răsfoiți toate <a href="videos.html">videoclipurile noastre de la sală</a>.

8. Execuție HTML:

Curățarea documentelor HTML și menținerea minimă a dimensiunii încărcăturii utile a documentelor HTML este importantă, deoarece le permite crawler-urilor să acceseze cu crawlere URL-urile rapid. Un alt avantaj al optimizării HTML este că serverul dvs. se încarcă puternic din cauza mai multor accesări cu crawlere de către motoarele de căutare, iar acest lucru vă poate încetini încărcarea paginii, ceea ce nu este un semn grozav pentru SEO sau crawlingul motorului de căutare. Optimizarea HTML poate reduce sarcina de accesare cu crawlere pe server, menținând încărcarea paginii să fie rapidă. De asemenea, ajută la rezolvarea erorilor de accesare cu crawlere din cauza expirării timpului de server sau a altor probleme vitale.

9. Încorporați simplu:

Niciun site web de astăzi nu va oferi conținut fără imagini și videoclipuri grozave care să le susțină conținut, deoarece acesta este ceea ce face conținutul lor mai atractiv din punct de vedere vizual și mai ușor de obținut pentru crawlerele motoarelor de căutare. Dar, dacă acest conținut încorporat nu este optimizat, poate reduce viteza de încărcare, alungând crawlerele de conținutul tău care se poate clasa.

Aici, respectarea codului HTML pentru conținutul încorporat poate ajuta la o mai bună accesare cu crawlere din motoarele de căutare. Tehnologii precum AJAX, Javascript etc. sunt destul de bune în furnizarea de noi funcții, dar fac și ca motoarele de căutare să fie destul de complicată.

Concluzie:

Având un accent mai mare pe SEO și un trafic mai mare, fiecare proprietar de site-uri web caută modalități mai bune de a gestiona turbarea botilor și conflictul de păianjeni. Însă, soluțiile constă în optimizările granulare pe care trebuie să le faci pe site-ul tău web și în URL-urile de crawling care pot face ca crawlingul motorului de căutare să fie mai specific și optimizat pentru a reprezenta tot ce este mai bun din site-ul tău, care se poate clasa mai sus în paginile cu rezultate ale motorului de căutare.