Bugetul de accesare cu crawlere Google: cum funcționează și cum să-l maximizați

Publicat: 2021-03-02Pentru fiecare site de pe internet, Google are un buget fix pentru câte pagini pot și sunt dispuși să acceseze roboții lor. Internetul este un loc mare, așa că Googlebot poate petrece atât de mult timp accesând cu crawlere și indexând site-urile noastre web. Optimizarea bugetului de accesare cu crawlere este procesul prin care se asigură că paginile corecte ale site-urilor noastre web ajung în indexul Google și sunt afișate în cele din urmă celor care caută.

Recomandările Google pentru optimizarea bugetului de accesare cu crawlere sunt destul de limitate, deoarece Googlebot accesează cu crawlere majoritatea site-urilor web fără a-și atinge limita. Dar site-urile de la nivel de întreprindere și de comerț electronic cu mii de pagini de destinație riscă să își maximizeze bugetul. Un studiu din 2018 a constatat chiar că crawlerele Google nu au reușit să acceseze cu crawlere peste jumătate din paginile web ale site-urilor mai mari din experiment.

Influențarea modului în care este cheltuit bugetul de accesare cu crawlere poate fi o optimizare tehnică mai dificilă de implementat pentru strategi. Dar pentru site-urile de comerț electronic și la nivel de întreprindere, merită efortul de a maximiza bugetul de accesare cu crawlere acolo unde puteți. Cu câteva ajustări, proprietarii de site-uri și strategii SEO pot îndruma Googlebot să acceseze cu crawlere și să indexeze în mod regulat paginile cu cele mai bune performanțe.

Cum stabilește Google bugetul de accesare cu crawlere?

Bugetul de accesare cu crawlere reprezintă, în esență, timpul și resursele pe care Google este dispus să le cheltuiască pentru a vă accesa site-ul web. Ecuația este următoarea:

Bugetul de accesare cu crawlere = Rata de accesare cu crawlere + Cererea de accesare cu crawlere

Autoritatea domeniului, backlink-urile, viteza site-ului, erorile de accesare cu crawlere și numărul de pagini de destinație toate influențează rata de accesare cu crawlere a unui site web. Site-urile mai mari au de obicei o rată de accesare cu crawlere mai mare, în timp ce site-urile mai mici, site-urile mai lente sau cele cu redirecționări excesive și erori de server sunt de obicei accesate cu crawlere mai rar.

Google determină, de asemenea, bugetul de accesare cu crawlere în funcție de „cererea de accesare cu crawlere”. Adresele URL populare au o cerere mai mare de accesare cu crawlere, deoarece Google dorește să ofere utilizatorilor cel mai recent conținut. Google nu-i place conținutul învechit din indexul său, așa că paginile care nu au fost accesate cu crawlere de ceva timp vor avea și o cerere mai mare. Dacă site-ul dvs. trece printr-o migrare a site-ului, Google va crește cererea de accesare cu crawlere pentru a-și actualiza mai rapid indexul cu noile dvs. adrese URL.

Bugetul de accesare cu crawlere al site-ului dvs. poate fluctua și cu siguranță nu este fix. Dacă vă îmbunătățiți găzduirea serverului sau viteza site-ului, Googlebot poate începe să vă acceseze cu crawlere site-ul mai des, știind că nu încetinește experiența web pentru utilizatori. Pentru a vă face o idee mai bună despre rata medie de accesare cu crawlere a site-ului dvs., consultați Raportul de accesare cu crawlere din consola dvs. de căutare Google.

Fiecare site trebuie să-și facă griji cu privire la bugetul de accesare cu crawlere?

Site-urile web mai mici care se concentrează doar pe obținerea unui clasament pentru câteva pagini de destinație nu trebuie să-și facă griji cu privire la bugetul de accesare cu crawlere. Dar site-urile web mai mari – în special site-urile nesănătoase cu pagini sparte și redirecționări excesive – își pot atinge cu ușurință limita de accesare cu crawlere.

Tipurile de site-uri web mari care riscă cel mai mult să-și maximizeze bugetul de accesare cu crawlere au de obicei zeci de mii de pagini de destinație. Principalele site-uri de comerț electronic, în special, sunt adesea afectate negativ de bugetele de accesare cu crawlere. Am întâlnit mai multe site-uri web de întreprindere cu un număr semnificativ de pagini de destinație neindexate, ceea ce înseamnă zero șanse de a fi clasat în Google.

Există câteva motive pentru care site-urile de comerț electronic, în special, trebuie să acorde mai multă atenție unde se duce bugetul lor de accesare cu crawlere.

- Multe site-uri de comerț electronic construiesc în mod programatic mii de pagini de destinație pentru SKU-urile lor sau pentru fiecare oraș sau stat în care își vând produsele.

- Aceste tipuri de site-uri își actualizează în mod regulat paginile de destinație atunci când articolele se epuizează, sunt adăugate produse noi sau au loc alte modificări ale inventarului.

- Site-urile de comerț electronic tind spre pagini duplicate (de exemplu, pagini de produse) și identificatori de sesiune (de exemplu, cookie-uri). Ambele sunt percepute ca adrese URL „cu valoare adăugată scăzută” de către Googlebot, care influențează negativ rata de accesare cu crawlere

O altă provocare în influențarea bugetului de accesare cu crawlere este aceea că Google îl poate crește sau reduce oricând. Deși o hartă a site-ului este un pas important pentru site-urile mari pentru a îmbunătăți accesul cu crawlere și indexarea celor mai importante pagini ale acestora, nu este suficient pentru a se asigura că Google nu vă maximizează bugetul de accesare cu crawlere pe pagini cu valoare mai mică sau cu performanțe slabe.

Deci, cum pot webmasterii să optimizeze bugetul de accesare cu crawlere?

Deși proprietarii de site-uri pot seta limite mai mari de accesare cu crawlere în conturile lor Google Search Console, setarea nu garantează o creștere a solicitărilor de accesare cu crawlere și nici nu influențează paginile pe care Google ajunge să le acceseze cu crawlere. S-ar putea să se simtă că cea mai naturală soluție este de a determina Google să acceseze cu crawlere site-ul dvs. mai des, dar există optimizări foarte limitate care au o corelație directă cu o rată crescută de accesare cu crawlere.

Știm cu toții că o bună bugetare nu înseamnă creșterea limitelor de cheltuieli; este să fii mai selectiv cu ceea ce cheltuiești banii. Când aplicați același concept la bugetul de accesare cu crawlere, acesta poate produce rezultate uriașe. Iată câțiva pași strategici pentru a ajuta Google să-ți cheltuiască bugetul în avantajul tău.

Pasul 1: identificați ce pagini accesează cu crawlere Google pe site-ul dvs

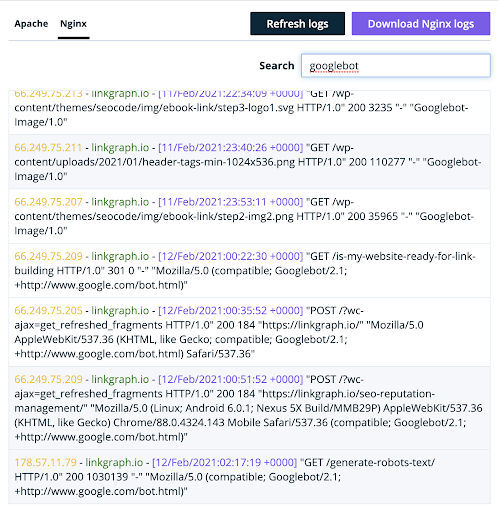

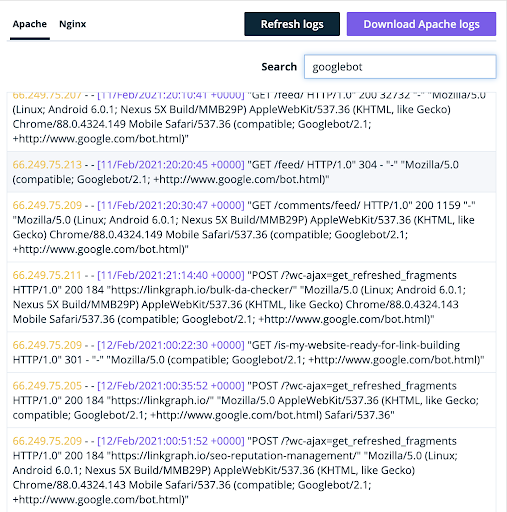

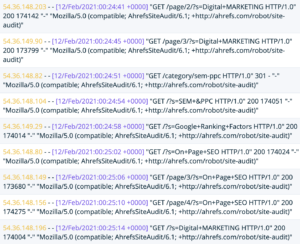

Până de curând, raportul de accesare cu crawlere al Google Search Console le spunea numai proprietarilor de site-uri câte solicitări de accesare cu crawlere au primit site-ul lor în anumite zile. Deși noul Raport privind statisticile cu crawlere de la Google oferă informații mult mai detaliate despre accesarea cu crawlere, cel mai bun loc pentru a înțelege cum accesează Google cu crawlere site-ul dvs. este încă în fișierele jurnal de server.

Când Google vă vizitează site-ul web, acesta utilizează un anumit user agent. Acest lucru permite serverului dvs. să știe că traficul este de fapt Googlebot și nu o persoană reală.

(Veți găsi acolo și botul lui Bingbot și Ahrefs).

Analizor de jurnal oncrawl

Proprietarii de site-uri care analizează conținutul acestui fișier jurnal vor primi o mulțime de informații despre bugetul de accesare cu crawlere Google pentru site-ul lor. Fișierul va dezvălui câteva lucruri:

- Ce pagini vizitează agentul utilizator

- Câte pagini accesează cu crawlere agentul pe zi

- Indiferent dacă oricare dintre paginile accesate cu crawlere este 404 sau ruptă

În mod ideal, doriți ca Google să acceseze cu crawlere paginile de destinație de pe site-ul dvs. care sunt optimizate pentru cuvintele cheie de cea mai mare valoare. De asemenea, proprietarii de site-uri nu ar trebui să irosească niciodată bugetul de accesare cu crawlere pe 404. Google Search Console vă va arăta doar câteva dintre erorile dvs. soft 404, dar le puteți identifica pe toate în jurnalele de server.

După ce aveți informații mai detaliate despre paginile site-ului dvs. care sunt accesate cu crawlere, finalizați următoarele acțiuni:

- Adăugați etichete roboți: dacă Googlebot accesează cu crawlere acele pagini 404 sau rupte, prioritatea numărul unu ar trebui să fie adăugarea etichetelor roboți [noindex, nofollow] pentru a împiedica Googlebot să acceseze cu crawlere și să indexeze acele pagini.

- Ajustați harta site-ului: dacă jurnalele serverului dvs. dezvăluie că Google nu accesează cu crawlere paginile dvs. potențial de înaltă performanță, plasați-le mai sus în harta dvs. de site pentru a vă asigura că sunt accesate cu crawlere.

Pasul 2: Acceptați că nu toate paginile dvs. de destinație trebuie să fie clasate pe Google

Motivul principal pentru care atât de multe site-uri web la nivel de întreprindere își irosesc bugetul de accesare cu crawlere este că permit Google să acceseze cu crawlere fiecare pagină de destinație de pe site-ul lor. Multe site-uri chiar le place să-și pună toate paginile în aplicația mobilă, astfel încât Google să le poată găsi și accesa cu crawlere pe toate. Aceasta este o greșeală, deoarece, în realitate, nu toate paginile noastre de destinație se vor clasa.

Care este valoarea de a avea o pagină de destinație în indexul Google? Clasare și conversie. Dacă site-ul dvs. are pagini de destinație care nu își strâng greutatea prin clasarea pentru mai multe cuvinte cheie sau prin conversia vizitatorilor site-ului în clienți potențiali și în venituri, de ce să vă asumați chiar riscul de a lăsa Google să le acceseze cu crawlere?

Proprietarii de site-uri la nivel de întreprindere și de comerț electronic ar trebui să știe care pagini ale site-urilor lor sunt optimizate pentru conversie și au cele mai mari șanse de a se clasa și de a face conversie. Apoi, ar trebui să profite de toate avantajele pe care le pot pentru a se asigura că Google cheltuiește bugetul de accesare cu crawlere pe acele pagini cu performanțe ridicate.

Paginile de destinație ale site-ului dvs. care au un potențial ridicat de conversie și de clasare merită să cheltuiți bugetul de accesare cu crawlere. Iată câteva sfaturi pentru a vă asigura că Googlebot include acele pagini în bugetul dvs.

- Reduceți numărul de pagini din harta site-ului dvs. Concentrați-vă doar pe paginile care au de fapt șanse mari de a se clasa și de a obține trafic organic.

- Ștergeți paginile neperformante sau inutile . Eliminați acele pagini care nu aduc nicio valoare, deoarece nu au nici un scop de clasificare, conversie sau funcțional.

- Conținut tăiat . Tăiați paginile care de fapt nu primesc trafic organic și redirecționați-le către alte pagini de destinație de pe site-ul dvs. care sunt relevante și care primesc trafic. Rețineți că redirecționările consumă puțin din bugetul de accesare cu crawlere, așa că încercați să le folosiți cu moderație și să nu le folosiți niciodată de două ori la rând.

Este dificil pentru orice proprietar de site să renunțe la conținut, dar este mult mai ușor să împiedici Google să acceseze cu crawlere anumite pagini decât să-l determine să crească bugetul general de accesare cu crawlere. Curățarea site-ului dvs., astfel încât crawlerele Google să aibă mai multe șanse să găsească și să indexeze cele mai bune lucruri este o prioritate majoră dacă doriți să vă cheltuiți cu înțelepciune bugetul de crawlere.

Pasul 3: utilizați linkuri interne pentru a crește paginile cu performanțe ridicate pentru crawlerele Google

După ce ați identificat ce pagini accesează cu crawlere Google, ați adăugat etichetele roboților necesare, ați șters sau tăiat paginile cu performanțe slabe și ați făcut ajustări la harta site-ului dvs., crawlerele Google vor fi mai predispuse să-și cheltuiască bugetul pe paginile potrivite de pe site-ul dvs.

Dar pentru a maximiza cu adevărat acest buget, paginile dvs. trebuie să aibă ceea ce este necesar pentru a se clasa. Cele mai bune practici SEO pe pagină sunt esențiale, dar o strategie tehnică mai avansată este să utilizați structura internă de legături pentru a ridica acele pagini potențial de înaltă performanță.

La fel cum Googlebot are doar un buget limitat de accesare cu crawlere, site-ul dvs. are doar o anumită valoare a site-ului pe baza amprentei sale pe internet. Este responsabilitatea ta să-ți concentrezi capitalul într-un mod inteligent. Aceasta înseamnă că direcționați echitatea site-ului către acele pagini care vizează cuvintele cheie pentru care aveți șanse mari să vă clasați și pe cele care vă aduc trafic cu tipurile potrivite de clienți, cei care sunt susceptibili să facă conversii și care au efectiv valoare economică.

Această strategie SEO este cunoscută ca sculptare PageRank. Dacă aveți un site web mare, cu mii de pagini de destinație, un strateg avansat poate rula experimente SEO pentru a optimiza profilul de link intern al site-ului dvs. pentru o distribuție mai bună a PageRank. Dacă sunteți un site web nou, puteți trece înaintea curbei încorporând sculptarea PageRank în arhitectura site-ului dvs. și gândindu-vă la echitatea site-ului cu fiecare pagină de destinație nouă pe care o creați.

Iată două dintre strategiile mele preferate pentru a-mi analiza paginile pentru a determina care ar beneficia cel mai mult de sculptarea PageRank.

- Găsiți paginile site-ului dvs. care au trafic bun, dar nu au suficient PageRank . Găsiți modalități de a obține paginile respective mai multe link-uri interne și de a trimite mai mult PageRank acolo. Adăugarea acestora la antetul sau subsolul site-ului dvs. este o modalitate excelentă de a face acest lucru rapid, dar nu exagerați cu linkurile din meniul de navigare.

- Concentrați-vă pe paginile care au multe link-uri interne, dar care nu obțin mult trafic, afișări de căutare și clasare pentru foarte puține cuvinte cheie . Paginile care primesc multe link-uri interne conțin de obicei mult PageRank. Dacă nu folosesc acel PageRank pentru a aduce trafic organic pe site-ul dvs., îl irosesc. Este mai bine să mutați acel PageRank în pagini care pot muta efectiv acul.

Înțelegerea rolului pe care îl joacă fiecare link de pe site-ul dvs. în nu numai trimiterea Googlebot în jurul site-ului dvs., ci și în distribuirea capitalului dvs. de link, este pasul final în optimizarea bugetului de accesare cu crawlere. Obținerea corectă a structurii de legături interne poate duce la îmbunătățiri dramatice ale clasamentului paginilor dvs. de bani. În cele din urmă, cel mai bun mod de a-ți cheltui bugetul de accesare cu crawlere este pe paginile de destinație care sunt cel mai probabil să-ți pună venituri în buzunar.

După ce implementați modificările, urmăriți clasarea cuvintelor cheie pentru acele pagini îmbunătățite într-un instrument Google Search Console. Dacă clasamentele se îmbunătățesc pentru acele pagini, arată că optimizarea bugetului de accesare cu crawlere funcționează. Apoi, pe măsură ce adăugați pagini noi pe site-ul dvs., fiți mai selectiv dacă merită sau nu să vă consume bugetul de accesare cu crawlere. Dacă nu, continuați să direcționați crawlerele numai către paginile care lucrează cel mai mult pentru marca dvs.