Urmărirea bugetului cu crawlere înainte și după o actualizare

Publicat: 2019-12-10Psst... Există un secret pe care vreau să-ți spun.

Site-ul dvs. are un „buget de accesare cu crawlere” stabilit de Google.

Aceasta este valoarea secretă folosită de Google pentru a măsura două lucruri:

- Cât de bine este construit site-ul dvs

- Cât de popular este site-ul dvs

Acest articol se va concentra pe primul punct.

Îmbunătățirea calității de construcție a site-ului dvs. va crește bugetul de accesare cu crawlere.

Cu cât bugetul de accesare cu crawlere este mai mare, cu atât Google va trece mai des și va citi paginile.

Să începem prin a împărtăși o înțelegere a ce este un buget de accesare cu crawlere.

Ce este Bugetul Crawl

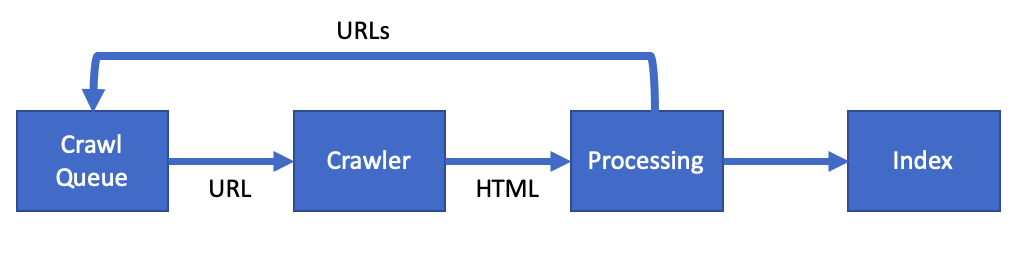

Google folosește un program software special numit web crawler (sau spider) pentru a citi paginile de pe site-ul dvs.

Ei numesc acest crawler web, Googlebot.

Bugetul de accesare cu crawlere este termenul care descrie cât de des va accesa cu crawlere paginile dvs. Googlebot.

Prin optimizarea site-ului, vă puteți crește bugetul de accesare cu crawlere.

Google a spus că bugetul dvs. de accesare cu crawlere este o combinație de:

- Rata de accesare cu crawlere – Viteza cu care Googlebot vă poate accesa cu crawlere site-ul fără a vă distruge serverele

- Cererea de accesare cu crawlere – Cât de importantă este pagina dvs. web pentru utilizatorii Google

Pe măsură ce aceste valori se îmbunătățesc, veți vedea că Googlebot vizitează mai des. Citind mai multe pagini la fiecare vizită.

Odată ce Google accesează cu crawlere o pagină, acesta va adăuga conținutul la Indexul Google. Care apoi actualizează informațiile afișate în rezultatele Căutării Google.

Prin optimizarea bugetului de accesare cu crawlere, puteți îmbunătăți viteza actualizărilor de pe site-ul dvs. la Căutarea Google.

De ce ar trebui să vă îmbunătățiți bugetul de accesare cu crawlere

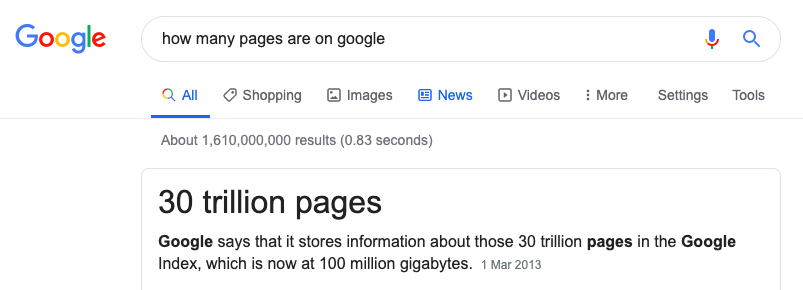

Google are o sarcină grea. Trebuie să acceseze cu crawlere și să indexeze fiecare pagină de pe internet.

Puterea de care au nevoie pentru a face acest lucru este imensă și nu pot indexa fiecare pagină.

Optimizarea bugetului de accesare cu crawlere va oferi site-ului dvs. cele mai bune șanse de a apărea în căutare.

[Studiu de caz] Gestionarea accesării cu crawlere a botului Google

Cum să vă îmbunătățiți bugetul de accesare cu crawlere

Îmbunătățirea unui site înseamnă a face timpul petrecut de Googlebot pe un site cât mai eficient posibil.

Nu vrem:

- Googlebot citește pagini pe care nu le dorim în Căutarea Google.

- Googlebot vede erori de server

- Googlebot urmărește link-uri întrerupte/moarte

- Googlebot așteaptă încărcarea paginii

- Googlebot citește conținut duplicat

Toate cele de mai sus irosesc resursele prețioase ale Google și ar putea vedea ca rata de accesare cu crawlere să scadă.

Bugetul de accesare cu crawlere și SEO tehnic

Multe din ceea ce trebuie să faceți ca parte a SEO tehnic este la fel cu optimizarea bugetului de accesare cu crawlere.

Avem nevoie:

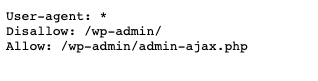

- Optimizați robots.txt și verificați dacă există erori

- Remediați orice hreflang și etichetele de link canonice

- Rezolvați non-200 de pagini

- Remediați redirecționările și orice bucle de redirecționare

- Asigurați-vă că orice sitemap nu conține erori

Să aruncăm o privire în continuare la crearea paginii perfecte pentru Googlebot.

Cum se creează pagina perfectă

OK, deci poate nu este pagina perfectă, dar ar trebui să încercăm să îmbunătățim pagina cât de mult putem.

Să ne uităm la câteva probleme comune de pe pagină pe care le puteți îmbunătăți.

Probleme de pagină

- Conținut duplicat – Marcați orice conținut duplicat de pe site-ul dvs. cu o etichetă de link canonică.

- Pagini non-SSL – Găsiți orice linkuri HTTP și convertiți-le în HTTPS. Dacă nu aveți un certificat SSL, obțineți unul gratuit de la Let's Encrypt.

- Accesați cu crawlere numai paginile utile – Folosiți fișierul robots.txt pentru a reduce locurile unde poate merge Googlebot. De exemplu, dacă aveți pagini folosite pentru un administrator, atunci nu permiteți acest lucru în fișierul robots.txt.

- Conținut subțire – Luați în considerare blocarea răzuirii paginilor cu conținut subțire sau foarte scăzut. Dacă aveți pagini care au puțină valoare pentru un utilizator, atunci nu pierdeți timpul lui Googlebot cu aceste pagini.

- Erori de server – Erorile de server sunt un semn al unui server web nesănătos. Dacă site-ul dvs. returnează erori 5xx, atunci remediarea acestora poate crește rata de accesare cu crawlere.

Pagini cu încărcare lentă

O modalitate de a îmbunătăți bugetul de accesare cu crawlere este să faci pagina rapidă.

Paginile rapide fac Googlebot mai rapid și acesta este un semn pentru Google că serverul web este „sănătos”.

Google a spus deja că viteza paginii crește rata de accesare cu crawlere:

Efectuarea unui site mai rapid îmbunătățește experiența utilizatorilor, în același timp crește rata de accesare cu crawlere.

- Greutatea paginii – Această valoare este dimensiunea totală a paginii dvs. Aceasta include toate CSS Javascript și imaginile de pe pagină. Acesta ar trebui să fie sub 1 MB în total.

- Imagini optimizate – Imaginile ar trebui să fie cât mai mici posibil în KB fără a pierde calitatea. Utilizarea unui instrument precum Squoosh poate ajuta în acest sens.

- CSS și JS minimizate – Minimizați fișierele JS și CSS. Acesta este procesul de eliminare a tuturor caracterelor inutile din fișier. Utilizați CSSNano și UglifyJS pentru a minimiza fișierele.

- Comprimare și stocare în cache – Asigurați-vă că este compresia GZip sau BR pe server. Acest lucru va accelera timpul necesar pentru a obține un fișier. Adăugați cache pentru ca fișierul să fie descărcat o singură dată.

Pentru o listă de îmbunătățiri ale vitezei paginii, aruncați o privire la această analiză aprofundată a performanței site-ului. Are 30 de pași pentru a îmbunătăți performanța site-ului.

Metode de măsurare a modificărilor dvs

În calitate de SEO inteligent, știți că înainte de a începe orice optimizare trebuie să urmăriți modificările.

Trebuie să alegeți un punct de date cu două proprietăți:

- Trebuie să puteți urmări punctul de date în timp.

- Trebuie să poți influența acele date prin acțiunile tale.

Deci, care este punctul de date pe care ar trebui să îl urmărim pentru bugetul de accesare cu crawlere?

Am spus mai devreme că Google utilizează doi factori atunci când decide asupra unui buget de accesare cu crawlere:

- Rata de accesare cu crawlere – Viteza cu care Googlebot vă poate accesa cu crawlere site-ul fără a vă distruge serverele

- Cererea de accesare cu crawlere – Cât de importantă este pagina dvs. web pentru utilizatorii Google

Deoarece suntem tehnicieni SEO, sarcina noastră este să îmbunătățim rata de accesare cu crawlere.

Deci acesta este punctul de date pe care ar trebui să-l urmărim.

Urmărirea ratei de accesare cu crawlere

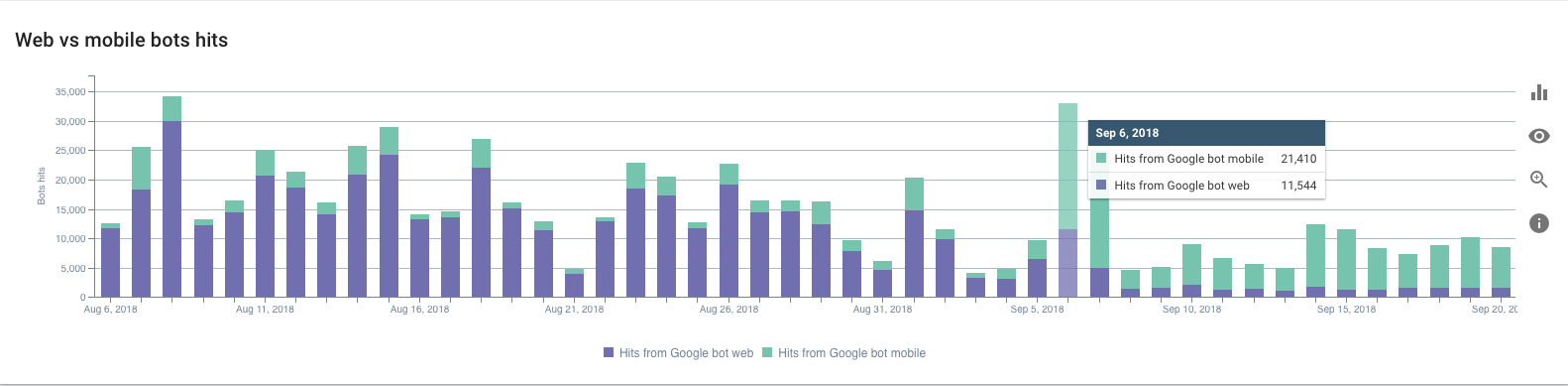

Deci, cum urmărim rata de accesare cu crawlere Googlebot?

Trebuie să folosim jurnalele dvs. de acces la serverul web.

Jurnalele stochează fiecare solicitare făcută către serverul dvs. web. De fiecare dată când un utilizator sau Googlebot vizitează site-ul dvs., o intrare de jurnal este adăugată la fișierul jurnal de acces.

Iată cum ar arăta o intrare pentru Googlebot:

127.0.0.1 - - [11/Nov/2019:08:29:01 +0100] „GET /example HTTP/1.1” 200 2326 „-” „Mozilla/5.0 (compatibil; Googlebot/2.1; +http://www. .google.com/bot.html)"

Există trei puncte de date importante în fiecare jurnal. Data:

[11/Nov/2019:08:29:01 +0100]

Adresa URL:

„GET /example HTTP/1.1”

Și user-agent care ne spune că Googlebot face cererea:

„Mozilla/5.0 (compatibil; Googlebot/2.1; +http://www.google.com/bot.html)”

Jurnalul de mai sus este de la un server web Nginx. Dar, toate serverele web, cum ar fi Apache sau IIS, vor avea o intrare similară în jurnalul de acces.

În funcție de configurația dvs., este posibil să aveți o rețea de livrare de conținut (CDN). Un CDN precum Cloudflare sau Fastly va crea, de asemenea, jurnalele de acces.

Analizarea manuală a unui jurnal de acces nu este cea mai distractivă, deși este posibilă.

Puteți descărca access.log și puteți analiza acest lucru folosind Excel. Cu toate acestea, aș recomanda să utilizați un analizor de jurnal, cum ar fi cel de la OnCrawl.

Acest lucru vă va permite să vedeți rata de accesare cu crawlere Googlebot pe un grafic și în timp real. Odată ce aveți această configurație de monitorizare pentru a urmări rata de accesare cu crawlere, puteți începe să o îmbunătățiți.

Efectuarea Schimbărilor

Acum știm ce urmărim, ne putem uita la realizarea unor îmbunătățiri. Dar, nu face multe schimbări în același timp. Fii metodic și fă schimbări una câte una.

Construiește, Măsoară, Învață.

Folosind această tehnică, puteți adapta schimbările pe care le faceți pe măsură ce învățați. Concentrarea asupra sarcinilor care îmbunătățesc rata de accesare cu crawlere.

Dacă vă grăbiți și schimbați prea mult deodată, poate fi dificil să înțelegeți rezultatele.

Făcând greu de spus ce a funcționat și ce nu a funcționat.

În timp, pe măsură ce pagina se îmbunătățește, veți observa o creștere a bugetului de accesare cu crawlere, pe măsură ce rata de accesare cu crawlere crește.

Încheiere, urmărire cu crawlere a bugetului înainte și după o actualizare

Am acoperit exact ce este un buget de accesare cu crawlere.

În calitate de SEO tehnic, aveți puterea de a crește rata de accesare cu crawlere a site-ului.

Îmbunătățind starea tehnică, puteți eficientiza timpul petrecut pe site-ul Googlebot.

Urmăriți rata de accesare cu crawlere folosind jurnalele dvs. pentru rezultate precise.

Utilizați Construiți, Măsurați, Învățați ca tehnică pentru a face o schimbare pe rând și pentru a îmbunătăți pe măsură ce mergeți.

În timp, rata de accesare cu crawlere va crește. Paginile dvs. vor apărea mai rapid în rezultatele căutării Google. Și utilizatorii vor avea o experiență grozavă pe site-ul dvs.