25 de cele mai bune instrumente de crawling web pentru extragerea eficientă a datelor de pe site-uri web

Publicat: 2023-06-15O introducere în instrumentele de crawling pe web

Instrumentele de crawling pe web, cunoscute și sub numele de păianjeni sau răzuitoare de web, sunt esențiale pentru companiile care doresc să extragă date valoroase de pe site-uri web în scopuri de analiză și extragere de date. Aceste instrumente au o gamă largă de aplicații, de la cercetare de piață până la optimizare pentru motoarele de căutare (SEO). Ei colectează date din diverse surse publice și le prezintă într-un format structurat și utilizabil. Folosind instrumente de crawling, companiile pot urmări știrile, rețelele sociale, imaginile, articolele, concurenții și multe altele.

25 Cele mai bune instrumente de accesare cu crawlere pe web pentru a extrage rapid date de pe site-uri web

Scrapy

Scrapy este un cadru de crawling web popular, bazat pe Python, cu sursă deschisă, care permite dezvoltatorilor să creeze crawlere web scalabile. Oferă un set cuprinzător de caracteristici care facilitează implementarea crawlerelor web și extragerea datelor de pe site-uri web. Scrapy este asincron, ceea ce înseamnă că nu face cereri pe rând, ci în paralel, rezultând o crawling eficientă. Fiind un instrument de crawling web bine stabilit, Scrapy este potrivit pentru proiecte de scraping web la scară largă.

Caracteristici cheie

- Acesta generează exporturi de feed în formate precum JSON, CSV și XML.

- Are suport încorporat pentru selectarea și extragerea datelor din surse, fie prin expresii XPath, fie CSS.

- Permite extragerea automată a datelor din paginile web folosind spider.

- Este rapid și puternic , cu o arhitectură scalabilă și tolerantă la erori.

- Este ușor de extensibil , cu un sistem de plug-in și un API bogat.

- Este portabil , rulează pe Linux, Windows, Mac și BSD.

Prețuri

- Este un instrument gratuit.

ParseHub

ParseHub este un instrument de crawler web care poate colecta date de pe site-uri web care utilizează tehnologia AJAX, JavaScript, cookie-uri și multe altele. Tehnologia sa de învățare automată poate citi, analiza și apoi transforma documentele web în date relevante. Aplicația desktop ParseHub acceptă sistemele de operare Windows, Mac OS X și Linux. Oferind o interfață ușor de utilizat, ParseHub este conceput pentru non-programatori care doresc să extragă date de pe site-uri web.

Caracteristici cheie

- Poate răzui site-uri web dinamice care utilizează AJAX, JavaScript, derulare infinită, paginare, meniuri derulante, conectări și alte elemente.

- Este ușor de utilizat și nu necesită abilități de codare.

- Este bazat pe cloud și poate stoca date pe serverele sale.

- Acceptă rotația IP , colectarea programată , expresii regulate , API și web-hooks.

- Poate exporta date în formatele JSON și Excel .

Prețuri

- ParseHub are atât planuri gratuite, cât și planuri plătite. Prețurile pentru planurile plătite încep de la 149 USD pe lună și oferă viteze de proiect îmbunătățite, o limită mai mare a numărului de pagini răzuite pe rulare și posibilitatea de a crea mai multe proiecte.

Octoparse

Octoparse este un instrument de crawling web bazat pe client, care permite utilizatorilor să extragă date web în foi de calcul fără a fi nevoie de codare. Cu o interfață punct-and-click, Octoparse este creat special pentru non-codatori. Utilizatorii își pot crea propriile crawler-uri web pentru a aduna date de pe orice site web, iar Octoparse oferă scraper-uri pre-construite pentru site-uri web populare precum Amazon, eBay și Twitter. Instrumentul oferă, de asemenea, funcții avansate, cum ar fi extracția programată în cloud, curățarea datelor și ocolirea blocării cu serverele proxy IP.

Caracteristici cheie

- Interfață Point-and-click : Puteți selecta cu ușurință elementele web pe care doriți să le răzuiți făcând clic pe ele, iar Octoparse va identifica automat modelele de date și va extrage datele pentru dvs.

- Modul avansat : vă puteți personaliza sarcinile de scraping cu diverse acțiuni, cum ar fi introducerea de text, clic pe butoane, derularea paginilor, trecerea în buclă a listelor etc. De asemenea, puteți utiliza XPath sau RegEx pentru a localiza datele cu precizie.

- Serviciu cloud : Puteți rula sarcinile de scraping pe serverele cloud ale Octoparse 24/7 și puteți stoca datele în platforma cloud. De asemenea, puteți să vă programați sarcinile și să utilizați rotația IP automată pentru a evita blocarea site-urilor web.

- API : Vă puteți accesa datele prin API și le puteți integra cu alte aplicații sau platforme. De asemenea, puteți transforma orice date în API-uri personalizate cu Octoparse.

Prețuri

- Are atât planuri gratuite, cât și plătite. Planurile plătite încep de la 89 USD/lună.

WebHarvy

WebHarvy este un software de scraping web point-and-click conceput pentru non-programatori. Poate răzui automat text, imagini, adrese URL și e-mailuri de pe site-uri web și le poate salva în diferite formate, cum ar fi XML, CSV, JSON sau TSV. WebHarvy acceptă, de asemenea, accesarea cu crawlere anonimă și gestionarea site-urilor web dinamice prin utilizarea serverelor proxy sau a serviciilor VPN pentru a accesa site-urile web țintă.

Caracteristici cheie

- Interfață Point-and-click pentru selectarea datelor fără codare sau scripting

- Exploatare pe mai multe pagini cu crawling și scraping automat

- Category scraping pentru scraping date din pagini sau listări similare

- Descărcarea imaginilor din paginile cu detalii despre produse ale site-urilor web de comerț electronic

- Detectarea automată a modelelor pentru liste sau tabele de răzuire fără configurație suplimentară

- Extragerea bazată pe cuvinte cheie prin trimiterea cuvintelor cheie introduse în formularele de căutare

- Expresii regulate pentru mai multă flexibilitate și control asupra răzuirii

- Interacțiune automată cu browserul pentru a efectua sarcini precum clic pe linkuri, selectarea opțiunilor, derulare și multe altele

Prețuri

- WebHarvy este un software de scraping web care are o taxă de licență unică.

- Prețul licenței lor începe de la 139 USD pentru un an.

Frumoasa Supa

Beautiful Soup este o bibliotecă Python open-source folosită pentru analizarea documentelor HTML și XML. Acesta creează un arbore de analiză care facilitează extragerea datelor de pe web. Deși nu este la fel de rapid ca Scrapy, Beautiful Soup este lăudat în principal pentru ușurința sa de utilizare și pentru sprijinul comunității atunci când apar probleme.

Caracteristici cheie

- Analizare : Puteți utiliza Beautiful Soup cu diverse analizoare, cum ar fi html.parser, lxml, html5lib, etc. pentru a analiza diferite tipuri de documente web.

- Navigare : Puteți naviga în arborele de analiză folosind metode și atribute Pythonic, cum ar fi find(), find_all(), select(), .children, .parent, .next_sibling etc.

- Căutare : Puteți căuta în arborele de analiză folosind filtre, cum ar fi numele de etichete, atribute, text, selectoare CSS, expresii regulate etc. pentru a găsi elementele dorite.

- Modificare : Puteți modifica arborele de analiză adăugând, ștergând, înlocuind sau editând elementele și atributele acestora.

Prețuri

Beautiful Soup este o bibliotecă gratuită și open-source pe care o puteți instala folosind pip.

Nokogiri

Nokogiri este un instrument de crawler web care face ușoară analizarea documentelor HTML și XML folosind Ruby, un limbaj de programare care este prietenos pentru începători în dezvoltarea web. Nokogiri se bazează pe parsere native, cum ar fi libxml2 C și xerces Java, făcându-l un instrument puternic pentru extragerea datelor de pe site-uri web. Este potrivit pentru dezvoltatorii web care doresc să lucreze cu o bibliotecă de crawling web bazată pe Ruby.

Caracteristici cheie

- DOM Parser pentru XML, HTML4 și HTML5

- SAX Parser pentru XML și HTML4

- Push Parser pentru XML și HTML4

- Căutarea documentelor prin XPath 1.0

- Căutarea documentelor prin selectoare CSS3, cu unele extensii asemănătoare jquery

- Validarea schemei XSD

- Transformarea XSLT

- DSL „Builder” pentru documente XML și HTML

Prețuri

- Nokogiri este un proiect open source care poate fi folosit gratuit.

Zyte (fost Scrapinghub)

Zyte (fost Scrapinghub) este un instrument de extragere a datelor bazat pe cloud, care ajută mii de dezvoltatori să preia date valoroase de pe site-uri web. Instrumentul său de scraping vizual open-source permite utilizatorilor să răzuiască site-uri web fără cunoștințe de programare. Zyte folosește Crawlera, un rotator de proxy inteligent care acceptă ocolirea contra-măsurilor de bot pentru a accesa cu crawlere site-uri mari sau protejate de bot și le permite utilizatorilor să acceseze cu crawlere din mai multe adrese IP și locații fără durerea de gestionare a proxy printr-un simplu API HTTP.

Caracteristici cheie

- Date la cerere: Furnizați site-uri web și cerințe de date către Zyte, iar acestea furnizează datele solicitate în programul dvs.

- Zyte AP I: preia automat HTML de pe site-uri web folosind cea mai eficientă configurație de proxy și extracție, permițându-vă să vă concentrați asupra datelor fără probleme tehnice.

- Scrapy Cloud : găzduire scalabilă pentru păianjenii dvs. Scrapy, oferind o interfață web ușor de utilizat pentru gestionarea, monitorizarea și controlul crawlerelor dvs., complet cu instrumente de monitorizare, înregistrare și control al datelor.

- API-ul de extracție automată a datelor : accesați datele web instantaneu prin API-ul de extracție bazat pe inteligență artificială de la Zyte, oferind rapid date structurate de calitate. Integrarea surselor noi devine mai simplă cu această tehnologie brevetată.

Prețuri

Zyte are un model de preț flexibil care depinde de complexitatea și volumul datelor de care aveți nevoie. Puteți alege dintre trei planuri:

- Dezvoltator: 49 USD/lună pentru 250.000 de solicitări

- Afaceri: 299 USD/lună pentru 2 milioane de solicitări

- Enterprise: prețuri personalizate pentru peste 10 milioane de solicitări

- De asemenea, puteți încerca Zyte gratuit cu 10.000 de solicitări pe lună.

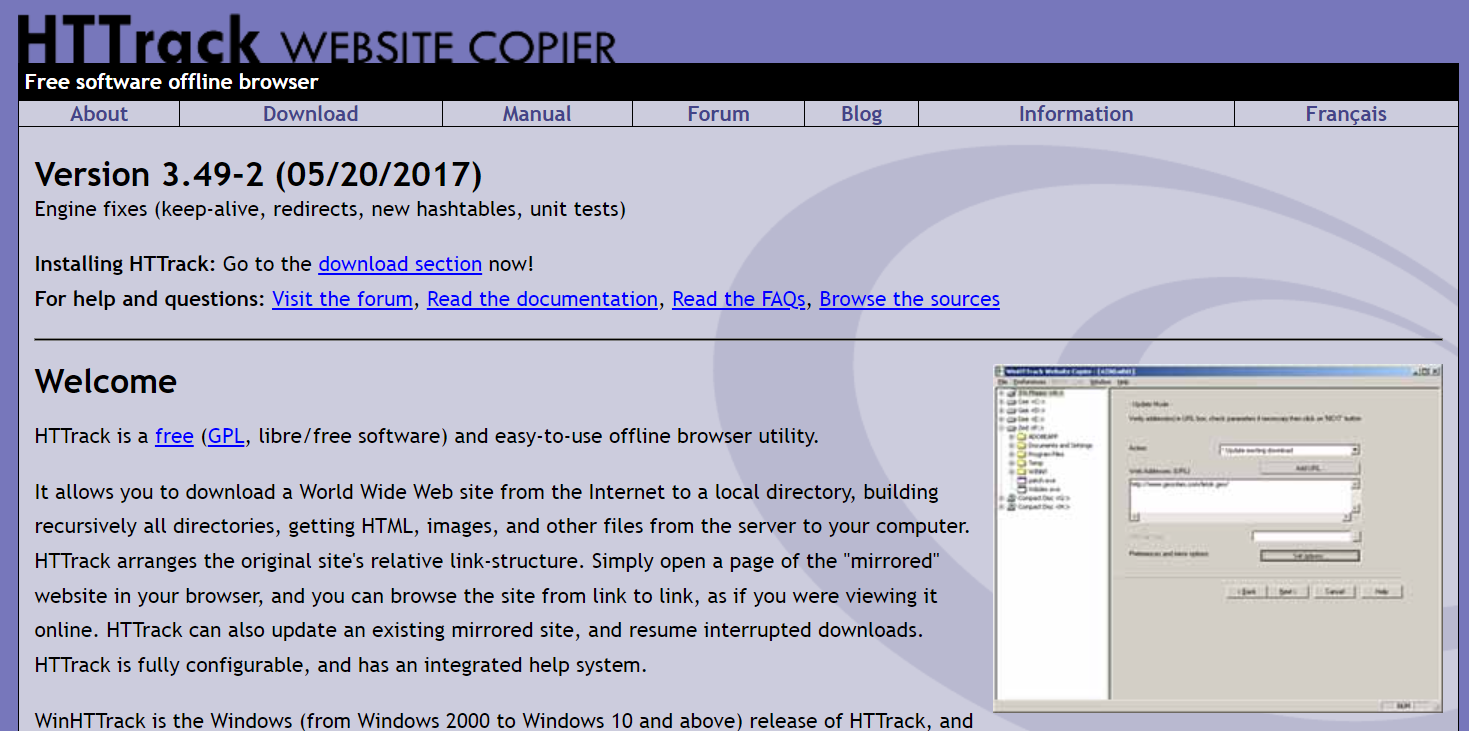

HTTrack

HTTrack este un instrument de crawling gratuit și open-source care permite utilizatorilor să descarce site-uri web întregi sau anumite pagini web pe dispozitivul lor local pentru navigare offline. Oferă o interfață de linie de comandă și poate fi utilizat pe sistemele Windows, Linux și Unix.

Caracteristici cheie

- Păstrează structura de legături relativă a site-ului original.

- Poate actualiza un site oglindit existent și poate relua descărcările întrerupte.

- Este complet configurabil și are un sistem de ajutor integrat.

- Suportă diverse platforme precum Windows, Linux, OSX, Android etc.

- Are o versiune de linie de comandă și o versiune de interfață grafică cu utilizatorul.

Prețuri

- HTTrack este un software gratuit licențiat sub GNU GPL.

Apache Nutch

Apache Nutch este un crawler web extensibil cu sursă deschisă folosit adesea în domenii precum analiza datelor. Poate prelua conținut prin protocoale precum HTTPS, HTTP sau FTP și poate extrage informații textuale din formate de document precum HTML, PDF, RSS și ATOM.

Caracteristici cheie

- Se bazează pe structurile de date Apache Hadoop, care sunt excelente pentru procesarea în lot a unor volume mari de date.

- Are o arhitectură foarte modulară, permițând dezvoltatorilor să creeze plug-in-uri pentru analiza de tip media, regăsirea datelor, interogare și grupare.

- Suportă diverse platforme precum Windows, Linux, OSX, Android etc.

- Are o versiune de linie de comandă și o versiune de interfață grafică cu utilizatorul.

- Se integrează cu Apache Tika pentru parsare, Apache Solr și Elasticsearch pentru indexare și Apache HBase pentru stocare.

Prețuri

- Apache Nutch este un software gratuit licențiat sub licența Apache 2.0.

Razuitoare cu heliu

Helium Scraper este un instrument vizual de accesare cu crawlere a datelor web care poate fi personalizat și controlat de utilizatori fără a fi nevoie de codare. Oferă funcții avansate precum rotația proxy, extragerea rapidă și suport pentru mai multe formate de date, cum ar fi Excel, CSV, MS Access, MySQL, MSSQL, XML sau JSON.

Caracteristici cheie

- Extragere rapidă : delegați automat sarcinile de extragere către browsere separate

- Big Data : baza de date SQLite poate stoca până la 140 terabytes

- Generarea bazei de date : Relațiile tabelelor sunt generate pe baza datelor extrase

- Generare SQL : alăturați și filtrați rapid tabele pentru export sau pentru date de intrare

- Apelare API : Integrați web scraping și apelarea API într-un singur proiect

- Manipulare text : generați funcții pentru a potrivi, împărți sau înlocui textul extras

- Suport JavaScript: injectați și rulați cod JavaScript personalizat pe orice site web

- Rotație proxy : introduceți o listă de proxy și rotiți-le la orice interval dat

- Detectare elemente similare : detectează elemente similare din una sau două mostre

- Detectare liste : detectează automat listele și rândurile de tabel de pe site-uri web

- Export de date : exportați date în CSV, Excel, XML, JSON sau SQLite

- Programare : Lansabil din linia de comandă sau din Programatorul de activități Windows

Prețuri

- Licența de bază costă 99 USD per utilizator.

Captură de conținut (Sequentum)

Content Grabber este un software de crawling web destinat întreprinderilor, care permite utilizatorilor să creeze agenți de crawling web autonomi. Oferă funcții avansate, cum ar fi integrarea cu aplicații terțe de analiză a datelor sau de raportare, editare de scripturi puternice și interfețe de depanare și suport pentru exportarea datelor în rapoarte Excel, XML, CSV și majoritatea bazelor de date.

Caracteristici cheie

- Interfață ușor de utilizat punct și clic : Detectează automat acțiunile bazate pe elemente HTML

- API robustă : acceptă integrarea simplă prin drag-and-drop cu conductele de date existente

- Personalizare : personalizați-vă agenții de scraping cu limbaje de codare comune precum Python, C#, JavaScript, expresii regulate

- Integrare : integrați biblioteci terțe AI, ML, NLP sau API-uri pentru îmbogățirea datelor

- Fiabilitate și amploare : Mențineți costurile de infrastructură la un nivel scăzut, în timp ce vă bucurați de monitorizarea în timp real a operațiunilor end-to-end

- Conformitate legală : reduceți răspunderea și reduceți riscul asociat proceselor costisitoare și amenzilor de reglementare

- Exportarea datelor : Exportați datele în orice format și livrați-le la orice punct final

- Programare : Lansați agenții de scraping din linia de comandă sau din Windows Task Scheduler

Prețuri

- Licența de bază costă 27.500 USD pe an și vă permite să utilizați software-ul pe un singur computer.

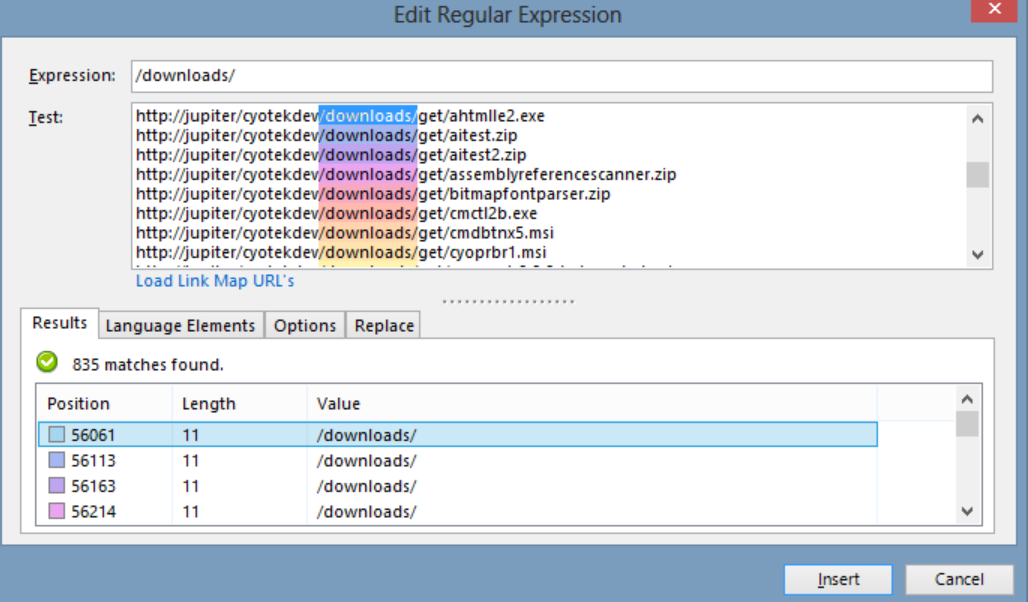

Cyotek WebCopy

Cyotek WebCopy este un crawler gratuit pentru site-uri web care permite utilizatorilor să copieze site-uri web parțiale sau complete la nivel local pe hard disk pentru referință offline. Poate detecta și urmări link-uri dintr-un site web și remapa automat link-urile pentru a se potrivi cu calea locală. Cu toate acestea, WebCopy nu include un DOM virtual sau orice formă de analiză JavaScript, așa că este posibil să nu gestioneze corect aspectele dinamice ale site-urilor din cauza utilizării intense a JavaScript.

Caracteristici cheie

- Interfață ușor de utilizat punct-and-click cu detectarea automată a acțiunii bazată pe elemente HTML

- API robust pentru integrare perfectă cu conductele de date existente prin funcționalitate simplă de glisare și plasare

- Opțiuni de personalizare folosind limbaje de codare populare, cum ar fi Python, C#, JavaScript și expresii regulate, pentru a adapta agenții de scraping la nevoi specifice

- Capabilități de integrare cu biblioteci AI, ML, NLP sau API-uri terțe pentru a îmbogăți datele scraped

- Infrastructură fiabilă și scalabilă cu monitorizare în timp real pentru operațiuni rentabile

- Caracteristici de conformitate cu legislația pentru a reduce răspunderea și a atenua riscul proceselor și amenzilor de reglementare

- Exportarea datelor în orice format dorit și livrarea la diferite puncte finale

- Opțiunile de programare permit lansarea agenților de scraping din linia de comandă sau din Windows Task Scheduler

Prețuri

- Licența de bază costă 27.500 USD pe an și vă permite să utilizați software-ul pe un singur computer.

80 picioare

80legs este un instrument puternic de crawling web care poate fi configurat pe baza cerințelor personalizate. Acceptă preluarea unor cantități mari de date împreună cu opțiunea de a descărca instantaneu datele extrase. Instrumentul oferă utilizatorilor un API pentru a crea crawlere, a gestiona date și multe altele. Unele dintre caracteristicile sale principale includ personalizarea scraper, servere IP pentru solicitări de web scraping și un cadru de aplicație bazat pe JS pentru configurarea crawlerilor web cu comportamente personalizate.

Caracteristici cheie

- Scalabil și rapid : puteți accesa cu crawlere până la 2 miliarde de pagini pe zi cu peste 50.000 de solicitări simultane.

- Flexibil și personalizabil: puteți folosi propriul cod pentru a controla logica de crawling și extragerea datelor sau puteți utiliza instrumentele și șabloanele încorporate.

Prețuri

- Puteți alege dintre diferite planuri de prețuri în funcție de nevoile dvs., începând de la 29 USD/lună pentru 100.000 de adrese URL/crawler până la 299 USD/lună pentru 10 milioane de adrese URL/crawler.

Webhose.io

Webhose.io le permite utilizatorilor să obțină date în timp real prin accesarea cu crawlere a surselor online din toată lumea și prezentându-le în diferite formate curate. Acest instrument de crawler web poate accesa cu crawlere date și poate extrage în continuare cuvinte cheie în diferite limbi folosind mai multe filtre care acoperă o gamă largă de surse. Utilizatorii pot salva datele răzuite în formate XML, JSON și RSS și pot accesa datele istorice din Arhiva sa. Webhose.io acceptă până la 80 de limbi cu rezultatele sale de accesare cu crawlere, permițând utilizatorilor să indexeze și să caute cu ușurință datele structurate accesate cu crawlere de instrument.

Caracteristici cheie

- Formate multiple : puteți obține date în formate XML, JSON, RSS sau Excel.

- Rezultate structurate : puteți obține date care sunt normalizate, îmbogățite și clasificate în funcție de nevoile dvs.

- Date istorice : puteți accesa datele arhivate din ultimele 12 luni sau mai mult.

- Acoperire largă : puteți obține date din peste un milion de surse în 80 de limbi și 240 de țări.

- Varietate de surse : puteți obține date de pe site-uri de știri, bloguri, forumuri, forumuri, comentarii, recenzii și multe altele.

- Integrare rapidă : puteți integra Webhose.io cu sistemele dvs. în câteva minute cu un simplu API REST.

Prețuri

- Are un plan gratuit care vă permite să faceți 1000 de solicitări pe lună fără costuri. De asemenea, are planuri personalizate pe care le puteți contacta pentru o ofertă.

Mozenda

Mozenda este un software de scraping web bazat pe cloud, care permite utilizatorilor să extragă date web fără a scrie o singură linie de cod. Automatizează procesul de extragere a datelor și oferă funcții precum extracția programată a datelor, curățarea datelor și ocolirea blocării cu serverele proxy IP. Mozenda este conceput pentru companii, cu o interfață ușor de utilizat și capabilități puternice de scraping.

Caracteristici cheie

- Analiza textului: puteți extrage și analiza date text de pe orice site web folosind tehnici de procesare a limbajului natural.

- Extragerea imaginilor: puteți descărca și salva imagini din pagini web sau puteți extrage metadate ale imaginii, cum ar fi dimensiunea, formatul, rezoluția etc.

- Colectare diferită de date: puteți colecta date din mai multe surse și formate, cum ar fi HTML, XML, JSON, RSS etc.

- Extragerea documentelor: puteți extrage date din PDF, Word, Excel și alte tipuri de documente utilizând metode de recunoaștere optică a caracterelor (OCR) sau de extragere a textului.

- Extragerea adreselor de e-mail : puteți găsi și extrage adrese de e-mail din pagini web sau documente folosind expresii regulate sau potrivirea modelelor.

Prețuri

- Planul plătit începe de la 99 USD pe lună.

UiPath

UiPath este un software de automatizare a proceselor robotizate (RPA) pentru web scraping gratuit. Automatizează accesarea cu crawlere a datelor de pe web și desktop din majoritatea aplicațiilor terță parte. Compatibil cu Windows, UiPath poate extrage date tabulare și bazate pe modele pe mai multe pagini web. Software-ul oferă, de asemenea, instrumente încorporate pentru accesarea cu crawlere și gestionarea interfețelor complexe cu utilizatorul.

Caracteristici cheie

- Analiza textului : extrageți și analizați datele textului utilizând procesarea limbajului natural, expresii regulate și potrivirea modelelor pentru activități precum extragerea adreselor de e-mail.

- Extragerea imaginilor : descărcați și salvați imaginile de pe paginile web, extrageți metadatele imaginii, inclusiv dimensiunea, formatul și rezoluția.

- Colectare diferită de date : Adunați date din diverse surse și formate precum HTML, XML, JSON, RSS, cu capabilități de integrare pentru conectarea la alte servicii online și API-uri.

- Extragerea documentelor : extrageți date din PDF, Word, Excel și alte tipuri de documente folosind metode de extracție OCR sau text. Procesați și extrageți informații din diferite tipuri și structuri de documente cu funcții de înțelegere a documentelor.

- Automatizare web : Automatizați activitățile bazate pe web, cum ar fi autentificarea, navigarea prin pagini, completarea formularelor, clicurile pe butoane. Utilizați funcția de înregistrare pentru a captura acțiuni și pentru a genera scripturi de automatizare.

Prețuri

- Cei plătiți planul începe de la 420 USD pe lună.

OutWit Hub

OutWit Hub este un add-on pentru Firefox cu zeci de funcții de extragere a datelor pentru a simplifica căutările pe web ale utilizatorilor. Acest instrument de crawler web poate naviga prin pagini și poate stoca informațiile extrase într-un format adecvat. OutWit Hub oferă o interfață unică pentru extragerea unor cantități mici sau uriașe de date la nevoie și poate crea agenți automati pentru a extrage date de pe diverse site-uri web în câteva minute.

Caracteristici cheie

- Vizualizați și exportați conținut web: puteți vizualiza legăturile, documentele, imaginile, contactele, tabelele de date, fluxurile RSS, adresele de e-mail și alte elemente conținute într-o pagină web. De asemenea, le puteți exporta în HTML, SQL, CSV, XML, JSON sau în alte formate.

- Organizați datele în tabele și liste: puteți sorta, filtra, grupa și edita datele pe care le colectați în tabele și liste. De asemenea, puteți utiliza mai multe criterii pentru a selecta datele pe care doriți să le extrageți.

- Configurați funcții automate : puteți utiliza caracteristica scraper pentru a crea scraper-uri personalizate care pot extrage date de pe orice site web folosind comenzi simple sau avansate. De asemenea, puteți utiliza caracteristica macro pentru a automatiza navigarea pe web și sarcinile de scraping.

- Generați interogări și adrese URL: puteți utiliza funcția de interogare pentru a genera interogări bazate pe cuvinte cheie sau modele. De asemenea, puteți utiliza funcția URL pentru a genera adrese URL pe baza modelelor sau parametrilor.

Prețuri

- Licența Light este gratuită și complet operațională, dar nu include caracteristicile de automatizare și limitează extragerea la una sau câteva sute de rânduri, în funcție de extractor.

- Licența Pro costă 110 USD pe an și include toate caracteristicile licenței Light plus funcțiile de automatizare și extracție nelimitată.

Scraper vizual

Visual Scraper, pe lângă faptul că este o platformă SaaS, oferă și servicii de web scraping, cum ar fi servicii de livrare a datelor și crearea de extractoare de software pentru clienți. Acest instrument de accesare cu crawlere acoperă întregul ciclu de viață al unui crawler, de la descărcare, gestionarea adreselor URL până la extragerea conținutului. Permite utilizatorilor să programeze proiecte pentru a rula la anumite ore sau să repete secvențe în fiecare minut, zi, săptămână, lună sau an. Visual Scraper este ideal pentru utilizatorii care doresc să extragă știri, actualizări și forumuri frecvent. Cu toate acestea, site-ul oficial pare să nu fie actualizat acum și este posibil ca aceste informații să nu fie actualizate.

Caracteristici cheie

- Interfață ușor de utilizat

- Suporta mai multe formate de date (CSV, JSON, XML etc.)

- Acceptă paginarea, AJAX și site-uri web dinamice

- Suportă servere proxy și rotație IP

- Suportă programare și automatizare

Prețuri

- Are un plan gratuit și planuri plătite, începând de la 39,99 USD pe lună.

Import.io

Import.io este un instrument de scraping web care permite utilizatorilor să importe date dintr-o anumită pagină web și să le exporte în CSV fără a scrie niciun cod. Poate răzui cu ușurință mii de pagini web în câteva minute și poate construi peste 1000 de API-uri bazate pe cerințele utilizatorilor. Import.io integrează datele web în aplicația sau site-ul web al unui utilizator cu doar câteva clicuri, facilitând scrapingul web.

Caracteristici cheie

- Selectați și faceți clic pe selecție și antrenament

- Extragere autentificată și interactivă

- Descărcări de imagini și capturi de ecran

- Proxy premium și extractoare specifice țării

- Ieșire CSV, Excel, JSON și acces API

- SLA și raportare privind calitatea datelor

- Asistență prin e-mail, bilet, chat și telefon

Prețuri

- Începător: 199 USD pe lună pentru 5.000 de interogări

Dexi.io

Dexi.io este un crawler web bazat pe browser, care permite utilizatorilor să răzuie date pe baza browserului lor de pe orice site web și oferă trei tipuri de roboți pentru a crea o sarcină de scraping - Extractor, Crawler și Pipes. Programul gratuit oferă servere proxy web anonime, iar datele extrase vor fi găzduite pe serverele Dexi.io timp de două săptămâni înainte ca datele să fie arhivate sau utilizatorii pot exporta direct datele extrase în fișiere JSON sau CSV. Oferă servicii plătite pentru utilizatorii care necesită extragerea datelor în timp real.

Caracteristici cheie

- Selectați și faceți clic pe selecție și antrenament

- Extracție autentificată și interactivă

- Descărcări de imagini și capturi de ecran

- Proxy premium și extractoare specifice țării

- Ieșire CSV, Excel, JSON și acces API

- SLA și raportare privind calitatea datelor

- Asistență prin e-mail, bilet, chat și telefon

Prețuri

- Standard: 119 USD pe lună sau 1.950 USD pe an pentru 1 lucrător

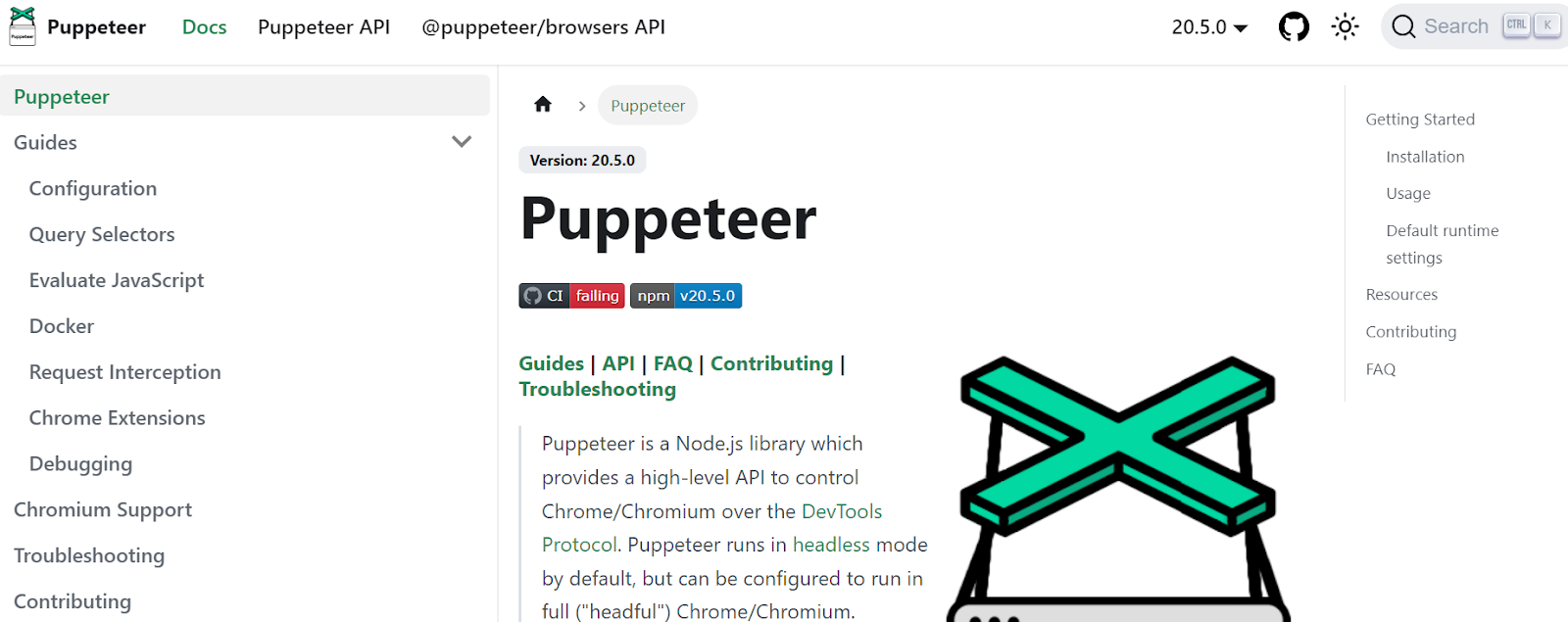

Păpușar

Puppeteer este o bibliotecă Node dezvoltată de Google, care oferă un API pentru programatori pentru a controla Chrome sau Chromium prin protocolul DevTools. Le permite utilizatorilor să creeze un instrument de scraping web cu Puppeteer și Node.js. Puppeteer poate fi utilizat în diverse scopuri, cum ar fi realizarea de capturi de ecran sau generarea de PDF-uri ale paginilor web, automatizarea trimiterilor de formulare/introducerea datelor și crearea de instrumente pentru testarea automată.

Caracteristici cheie

- Generați capturi de ecran și PDF-uri ale paginilor web

- Accesați cu crawlere și răzuiți datele de pe site-uri web

- Automatizați trimiterea formularelor, testarea UI, introducerea de la tastatură etc.

- Capturați valori și urme de performanță

- Testați extensiile Chrome

- Rulați în modul fără cap sau fără cap

Prețuri

- Puppeteer este gratuit și open-source.

Crawler4j

Crawler4j este un crawler web Java cu sursă deschisă, cu o interfață simplă pentru a accesa cu crawlere web. Permite utilizatorilor să construiască crawler-uri multi-threaded, fiind în același timp eficient în utilizarea memoriei. Crawler4j este potrivit pentru dezvoltatorii care doresc o soluție de crawling web simplă și personalizabilă, bazată pe Java.

Caracteristici cheie

- Vă permite să specificați ce adrese URL trebuie accesate cu crawlere și care ar trebui ignorate folosind expresii regulate.

- Vă permite să gestionați paginile descărcate și să extrageți date din ele.

- Respectă protocolul robots.txt și evită accesarea cu crawlere a paginilor care sunt interzise.

- Poate accesa cu crawlere HTML, imagini și alte tipuri de fișiere.

- Poate aduna statistici și poate rula mai multe crawler-uri simultan.

Prețuri

- Crawler4j este un proiect Java open source care vă permite să configurați și să rulați cu ușurință propriile dvs. crawler-uri web.

Common Crawl

Common Crawl este un instrument de crawler web care oferă un corp deschis de date web în scopuri de cercetare, analiză și educație.

Caracteristici cheie

- Oferă utilizatorilor acces la date de accesare cu crawlere web, cum ar fi datele brute ale paginilor web, metadate extrase și text, precum și indexul comun de accesare cu crawlere.

Prețuri

- Aceste date de accesare cu crawlere web gratuite și accesibile public pot fi folosite de dezvoltatori, cercetători și companii pentru diverse sarcini de analiză a datelor.

Supa mecanică

MechanicalSoup este o bibliotecă Python folosită pentru analizarea site-urilor web, bazată pe biblioteca Beautiful Soup, inspirată din biblioteca Mechanize. Este excelent pentru stocarea cookie-urilor, urmărirea redirecționărilor, hyperlink-urile și gestionarea formularelor pe un site web.

Caracteristici cheie

- MechanicalSoup oferă o modalitate simplă de a răsfoi și de a extrage date de pe site-uri web fără a fi nevoie să se ocupe de sarcini complexe de programare.

Prețuri

- Este un instrument gratuit.

Node Crawler

Node Crawler este un pachet popular și puternic pentru accesarea cu crawlere a site-urilor web cu platforma Node.js. Funcționează pe baza Cheerio și vine cu multe opțiuni pentru a personaliza modul în care utilizatorii accesează cu crawlere sau războară web, inclusiv limitarea numărului de solicitări și a timpului necesar între ele. Node Crawler este ideal pentru dezvoltatorii care preferă să lucreze cu Node.js pentru proiectele lor de crawling pe web.

Caracteristici cheie

- Ușor de folosit

- API bazat pe evenimente

- Reîncercări și timeout configurabile

- Detectarea automată a codificării

- Gestionarea automată a cookie-urilor

- Gestionarea automată a redirecționării

- Manevrare automată gzip/deflate

Prețuri

- Este un instrument gratuit.

Factori de luat în considerare atunci când alegeți un instrument de crawling pe web

Prețuri

Luați în considerare structura de preț a instrumentului ales și asigurați-vă că este transparent, fără costuri ascunse. Optează pentru o companie care oferă un model clar de preț și oferă informații detaliate despre caracteristicile disponibile.

Ușurință în utilizare

Alegeți un instrument de crawling web ușor de utilizat și care nu necesită cunoștințe tehnice extinse. Multe instrumente oferă interfețe punct-and-click, facilitând extragerea datelor de pe site-uri web pentru non-programatori.

Scalabilitate

Luați în considerare dacă instrumentul de accesare cu crawlere web poate gestiona volumul de date pe care trebuie să îl extrageți și dacă poate crește odată cu afacerea dvs. Unele instrumente sunt mai potrivite pentru proiecte la scară mică, în timp ce altele sunt concepute pentru extragerea datelor la scară largă.

Calitatea și acuratețea datelor

Asigurați-vă că instrumentul de crawling poate curăța și organiza datele extrase într-un format utilizabil. Calitatea datelor este crucială pentru o analiză precisă, așa că alegeți un instrument care oferă caracteristici eficiente de curățare și organizare a datelor.

Relații Clienți

Alegeți un instrument de accesare cu crawlere pe web cu asistență pentru clienți receptivă și utilă, care să vă asiste atunci când apar probleme. Testați serviciul de asistență pentru clienți, contactându-i și notând cât timp durează pentru a răspunde înainte de a lua o decizie în cunoștință de cauză.

Concluzie

Instrumentele de crawling pe web sunt esențiale pentru companiile care doresc să extragă date valoroase de pe site-uri web în diverse scopuri, cum ar fi cercetarea de piață, SEO și analiza competitivă. Luând în considerare factori precum prețul, ușurința de utilizare, scalabilitatea, calitatea și acuratețea datelor și asistența pentru clienți, puteți alege instrumentul de accesare cu crawlere potrivit nevoilor dvs. Cele mai bune 25 de instrumente de crawling web menționate mai sus se adresează unei game de utilizatori, de la non-programatori la dezvoltatori, asigurându-se că există un instrument potrivit pentru toată lumea. De asemenea, vă puteți înscrie pentru o perioadă de încercare gratuită de 7 zile cu Scalenut pentru a optimiza conținutul site-ului dvs. și pentru a vă îmbunătăți clasarea.