57 Greșeli frecvente de testare A/B și cum să le evitați

Publicat: 2021-06-15

Efectuați teste A/B, dar nu sunteți sigur dacă funcționează corect?

Vrei să înveți care sunt greșelile comune la testarea A/B, astfel încât să nu pierzi timp prețios într-o campanie întreruptă?

Ei bine, vești bune! În acest articol, vă vom prezenta 57 de greșeli comune (și uneori mai puțin frecvente) de testare A/B pe care le vedem, astfel încât să puteți fie să le ocoliți, fie să vă dați seama când se întâmplă și să le remediați rapid.

Le-am împărțit în 3 secțiuni cheie:

- Greșeli înainte de a începe testarea,

- Probleme care pot apărea în timpul testului,

- Și erori pe care le puteți face odată ce testul este terminat.

Puteți pur și simplu să citiți și să vedeți dacă faceți unul dintre acestea singur.

Si amintesteti:

Fiecare eșec este o lecție valoroasă, atât în ceea ce privește testarea, cât și greșelile de configurare. Cheia este să înveți de la ei!

Deci haideți să ne scufundăm...

- Greșeli obișnuite de testare A/B care pot fi făcute chiar înainte de a efectua testul

- #1. Împingeți ceva în direct înainte de testare!

- #2. Nu rulează un test A/B real

- #3. Nu se testează pentru a vedea dacă instrumentul funcționează

- #4. Folosind un instrument de calitate scăzută și intermitent conținut

- #5. Fără test QA

- #6. Funcționează noul tratament/variație?

- #7. Nu urmează o ipoteză și doar testează orice lucru vechi

- #8. Având o ipoteză netestabilă

- #9. Nu stabiliți un obiectiv clar pentru testul dvs. în avans

- #10. Concentrându-se pe metrici superficiale

- #11. Folosind doar date cantitative pentru a forma idei de testare

- #12. Copierea concurenților tăi

- #13. Testează doar „cele mai bune practici din industrie”

- #14. Concentrându-vă mai întâi asupra sarcinilor cu impact mic, atunci când sunt disponibile recompense mari/fructe cu impact scăzut

- #15. Testarea mai multor lucruri deodată și neștiind care schimbare a cauzat rezultatul

- #16. Nu se execută o analiză pre-test adecvată

- #17. Etichetarea greșită a testelor

- #18. Executare teste la adresa URL greșită

- #19. Adăugarea unor reguli de afișare arbitrare la testul dvs

- #20. Testarea traficului greșit pentru obiectivul dvs

- #21. Eșecul de a exclude vizitatorii care revin într-un test și denaturarea rezultatelor

- #22. Nu vă ștergeți IP-urile din test

- #23. Nesegmentarea variațiilor grupului de control (efect de rețea)

- #24. Desfășurarea de teste în timpul evenimentelor sezoniere sau evenimentelor majore pe site/platformă

- #25. Ignorarea diferențelor culturale

- #26. Rularea mai multor campanii conectate în același timp

- #27. Ponderarea inegală a traficului

- Greșeli frecvente de testare A/B pe care le puteți face în timpul testului

- #28. Nu rulați suficient de mult pentru a obține rezultate precise

- #29. Monitorizare/peeking cu elicopterul

- #30. Nu se urmărește feedbackul utilizatorilor (mai ales important dacă testul afectează o acțiune directă, imediată)

- #31. Efectuarea modificărilor la mijlocul testului

- #32. Modificarea procentului de alocare a traficului la mijlocul testului sau eliminarea persoanelor cu performanțe slabe

- #33. Nu opriți un test atunci când aveți rezultate precise

- #34. A fi investit emoțional în pierderea variațiilor

- #35. Executarea testelor pentru prea mult timp și urmărirea scade

- #36. Nu folosiți un instrument care vă permite să opriți/implementarea testului!

- Greșeli frecvente de testare A/B pe care le puteți face după ce testul este terminat

- #37. Renunț după un test!

- #38. Renunțând la o ipoteză bună înainte de a testa toate versiunile acesteia

- #39. Așteptând victorii uriașe tot timpul

- #40. Nu se verifică validitatea după test

- #41. Nu citesc corect rezultatele

- #42. Nu se uită la rezultatele pe segmente

- #43. Nu învăța din rezultate

- #44. Luând învinșii

- #45. Nu luați măsuri cu privire la rezultate

- #46. Nu repetarea și îmbunătățirea câștigurilor

- #47. Nu distribuie constatările câștigătoare în alte domenii sau departamente

- #48. Nu testează acele modificări în alte departamente

- #49. Prea multă iterație pe o singură pagină

- #50. Nu testează suficient!

- #51. Nu se documentează testele

- #52. Uitând de fals pozitive și nu verificați dublu campanii uriașe de creștere

- #53. Nu urmăresc rezultatele downline

- #54. Nu ține cont de efectele de primație și de noutate, care pot influența rezultatele tratamentului

- #55. Se modifică perioada de examinare

- #56. Nu se retestează după X timp

- #57. Testează doar calea și nu produsul

- Concluzie

Greșeli obișnuite de testare A/B care pot fi făcute chiar înainte de a efectua testul

#1. Împingeți ceva în direct înainte de testare!

S-ar putea să aveți o pagină nouă fantastică sau un design de site web și sunteți foarte dornic să-l puneți în direct fără a-l testa.

Așteaptă!

Rulați mai întâi un test rapid pentru a vedea cum funcționează. Nu doriți să faceți o schimbare radicală în direct fără a obține niște date sau ați putea pierde vânzări și conversii.

Uneori, această nouă schimbare poate fi o scădere substanțială a performanței. Așa că faceți-i mai întâi un test rapid.

#2. Nu rulează un test A/B real

Un test A/B funcționează prin rularea unei singure surse de trafic către o pagină de control și o variație a acelei pagini. Scopul este de a afla dacă schimbarea pe care ați implementat-o face ca publicul să se convertească mai bine și să ia măsuri.

Chestia este că pentru a ne asigura că acest test este controlat și corect, trebuie să rulăm acel test cu parametri specifici. Avem nevoie de aceleași surse de trafic care vizionează campania în aceeași perioadă de timp, astfel încât să nu avem niciun factor extern care să afecteze un test și nu celălalt.

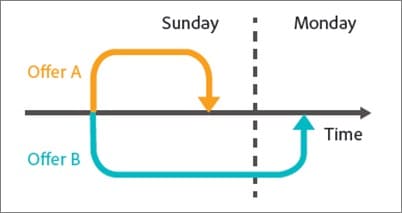

Unii oameni fac greșeala de a rula un test în secvență. Își rulează pagina actuală timp de X timp, apoi versiunea nouă pentru X timp după aceea și apoi măsoară diferența.

Aceste rezultate nu sunt în întregime precise, deoarece multe lucruri s-ar fi putut întâmpla în timpul acelor ferestre de testare. Puteți obține o explozie de trafic nou, puteți organiza un eveniment, ceea ce face ca cele 2 pagini să aibă audiențe și rezultate extrem de diferite.

Așa că asigurați-vă că executați un test A/B real în care împărțiți traficul între cele 2 versiuni și le testați exact în același timp.

#3. Nu se testează pentru a vedea dacă instrumentul funcționează

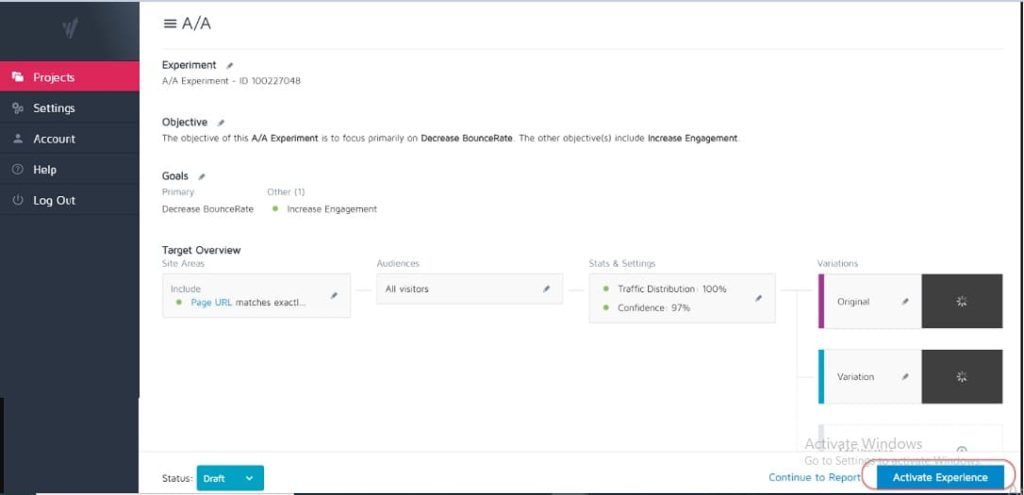

Niciun instrument de testare nu este 100% precis. Cel mai bun lucru pe care îl puteți face atunci când începeți este să efectuați un test A/A pentru a vedea cât de precis este instrumentul dvs.

Cum? Pur și simplu rulați un test în care împărțiți traficul 50:50 între o singură pagină. (Asigurați-vă că este o pagină pe care publicul dvs. poate face conversie, astfel încât să puteți măsura un anumit rezultat.)

De ce?

Deoarece ambele seturi ale publicului dvs. văd exact aceeași pagină, rezultatele conversiei ar trebui să fie identice pe ambele părți ale testului, nu?

Ei bine, uneori nu sunt, ceea ce înseamnă că instrumentul dvs. poate fi configurat incorect. Așa că mergeți mai departe și verificați instrumentul de testare înainte de a rula orice campanie.

#4. Folosind un instrument de calitate scăzută și intermitent conținut

Unele instrumente nu sunt la fel de bune ca altele. Ei fac treaba, dar se luptă sub încărcarea traficului sau „clipiește” și pâlpâie.

Acest lucru poate face ca testul dvs. să eșueze, chiar dacă aveți o variantă potențială câștigătoare.

Să presupunem că sunteți divizat pentru a testa o imagine de pe pagina dvs. Pagina de control se încarcă bine, dar variația pâlpâie între noua imagine de test și cea originală doar pentru o fracțiune de secundă. (Sau poate de fiecare dată când utilizatorul defilează în sus și în jos pe pagină.)

Acest lucru poate distrage atenția și poate cauza probleme de încredere, scăzând rata de conversie.

De fapt, noua ta imagine s-ar putea chiar converti mai bine în teorie, dar pâlpâirea instrumentului scade rezultatele, oferindu-ți un test inexact al acelei imagini.

Asigurați-vă că aveți un instrument suficient de bun pentru a testa.

(Acesta este un factor atât de important pentru experiența utilizatorului, încât Google își ajustează în prezent clasamentele pentru site-uri care nu au elemente de pâlpâire sau de mișcare).

#5. Fără test QA

O greșeală super simplă, dar ai verificat dacă totul funcționează?

- Ai trecut prin procesul de vânzare?

- Mai au altele? (Și pe dispozitivele necachete, deoarece uneori ceea ce este salvat în browser nu este așa cum arată pagina.)

- Se încarcă paginile ok? Sunt lente? Sunt modelele încurcate?

- Functioneaza toate butoanele?

- Funcționează urmărirea veniturilor?

- Ați verificat dacă pagina funcționează pe mai multe dispozitive?

- Aveți raportarea erorilor în cazul în care ceva se defectează?

Toate acestea merită verificate ÎNAINTE de a începe să difuzați trafic către orice campanie.

Obțineți lista noastră de verificare pentru asigurarea calității pentru testele A/B. Este un PDF care poate fi completat la care veți dori să vă întoarceți de fiecare dată când verificați QA un test.

#6. Funcționează noul tratament/variație?

De asemenea, ați trecut prin și ați testat că noua dvs. variație funcționează înainte de a rula un test?

Poate fi o parte trecută cu vederea a testării QA, dar campaniile pot rula adesea cu butoane întrerupte, linkuri vechi și multe altele. Verificați mai întâi, apoi testați.

#7. Nu urmează o ipoteză și doar testează orice lucru vechi

Unii oameni testează ceva fără să se gândească cu adevărat la asta.

Ei își fac o idee pentru o schimbare și doresc să o testeze, dar fără o analiză reală a modului în care pagina se convertește în prezent sau chiar de ce schimbarea pe care o testează ar putea face diferența. (S-ar putea ca ei să reducă conversia, dar nici măcar nu știu asta, deoarece nu au un rezultat de bază urmărit încă).

Formarea unei ipoteze despre unde se află o problemă, cauza acesteia și cum o puteți rezolva va face o diferență enormă pentru programul dvs. de testare.

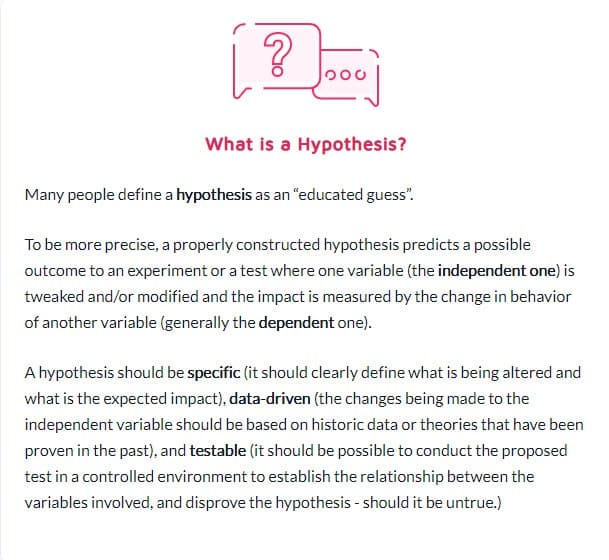

#8. Având o ipoteză netestabilă

Nu orice ipoteză este corectă. Este în regulă. De fapt, cuvântul înseamnă literal „Am o idee bazată pe informații X și cred că Y s-ar putea întâmpla în circumstanța Z”.

Dar veți avea nevoie de o ipoteză care poate fi testată, ceea ce înseamnă că poate fi dovedită sau infirmată prin testare. Ipotezele testabile pun inovația în mișcare și promovează experimentarea activă. Acestea ar putea avea ca rezultat succes (caz în care bănuiala ta a fost corectă) sau eșec – arătând că ai greșit tot timpul. Dar ei vă vor oferi perspective. Poate însemna că testul dvs. trebuie executat mai bine, datele dvs. au fost incorecte/citite greșit sau ați găsit ceva care nu a funcționat, ceea ce oferă adesea o perspectivă asupra unui nou test care ar putea funcționa mult mai bine.

#9. Nu stabiliți un obiectiv clar pentru testul dvs. în avans

Odată ce aveți o ipoteză, o puteți folosi pentru a vă alinia cu un anumit rezultat pe care doriți să-l obțineți.

Uneori, oamenii pur și simplu rulează o campanie și văd ce se schimbă, dar cu siguranță veți obține mai multe clienți potențiali/conversii sau vânzări dacă aveți claritate asupra elementului specific pe care doriți să vedeți o creștere.

(De asemenea, acest lucru vă împiedică să vedeți o scădere a unui element important, dar considerând testul un câștig, deoarece „a primit mai multe acțiuni”.)

Apropo de care…

#10. Concentrându-se pe metrici superficiale

Testul dvs. ar trebui să fie întotdeauna legat de valorile Guardrail sau de un element care vă afectează direct vânzările. Dacă este vorba de mai multe clienți potențiali, atunci ar trebui să știți până la un dolar cât valorează un client potențial și valoarea creșterii ratei de conversie.

În același timp, valorile care nu se conectează la sau nu conduc la un rezultat măsurabil ar trebui de obicei evitate. Mai multe aprecieri pe Facebook nu înseamnă neapărat mai multe vânzări. Eliminați acele butoane de distribuire socială și urmăriți doar câte clienți potențiali mai primiți. Fiți atenți la valorile de vanitate și amintiți-vă că doar pentru că o scurgere este remediată, nu înseamnă că nu mai există și alta în altă parte de rezolvat!

Iată lista lui Ben Labay de valori comune pentru balustrade pentru programele de experimentare:

#11. Folosind doar date cantitative pentru a forma idei de testare

Utilizarea datelor cantitative pentru a obține idei este grozavă, dar este și ușor defectuoasă. Mai ales dacă singurele date pe care le folosim sunt din analizele noastre.

De ce?

Din datele noastre putem ști că X numărul de persoane nu au făcut clic, dar s-ar putea să nu știm de ce.

- Este butonul prea jos pe pagină?

- Este neclar?

- Se aliniază cu ceea ce își dorește privitorul?

- Măcar funcționează?

Cei mai buni testeri își ascultă și publicul. Ei află de ce au nevoie, ce îi mută înainte, ce îi reține și apoi îl folosesc pentru a formula idei noi, teste și copii scrise.

Uneori, utilizatorii tăi sunt reținuți de problemele de încredere și de îndoieli de sine. Alteori, este claritate și forme rupte sau design proaste. Cheia este că acestea sunt lucruri pe care datele cantitative nu vi le pot spune întotdeauna, așa că întrebați întotdeauna publicul și folosiți-l pentru a vă ajuta să planificați.

#12. Copierea concurenților tăi

Ești gata pentru un secret?

De cele mai multe ori concurenții tăi doar o fac. Cu excepția cazului în care au pe cineva care a derulat campanii de creștere pe termen lung, s-ar putea să încerce doar lucruri pentru a vedea ce funcționează, uneori fără să folosească date pentru ideile lor.

Și chiar și atunci, ceea ce funcționează pentru ei, s-ar putea să nu funcționeze pentru tine. Așa că da, folosiți-le pentru inspirație, dar nu vă limitați ideile de testare doar la ceea ce îi vedeți făcând. Puteți chiar să mergeți în afara industriei dvs. pentru inspirație și să vedeți dacă declanșează unele ipoteze.

#13. Testează doar „cele mai bune practici din industrie”

Din nou, ceea ce funcționează pentru unul nu este ceea ce funcționează întotdeauna pentru altul.

De exemplu, imaginile cu glisare au de obicei performanțe groaznice, dar, pe unele site-uri, pot genera mai multe conversii. Testează totul. Nu ai nimic de pierdut și totul de câștigat.

#14. Concentrându-vă mai întâi pe sarcinile cu impact mic, atunci când sunt disponibile recompense mari/fructe cu impact scăzut

Cu toții putem fi vinovați că ne concentrăm asupra detaliilor. S-ar putea să avem o pagină pe care dorim să o facem mai bine și să testăm modele de aspect și imagini și chiar culorile butoanelor. (Am personal o pagină de vânzări care se află la a 5-a iterație.)

Chestia este că probabil că există pagini mult mai importante pe care să le testați chiar acum.

Prioritizează impactul cel mai mult:

- Va afecta această pagină direct vânzările?

- Există alte pagini din procesul de vânzări care au performanțe masive?

Dacă da, concentrează-te mai întâi pe acestea.

O creștere de 1% pe o pagină de vânzări este grozavă, dar o creștere de 20% pe pagina care îi aduce acolo ar putea fi mult mai importantă. (Mai ales dacă pagina respectivă este locul în care îți pierzi cea mai mare parte a audienței.)

Uneori, nu doar căutăm mai multă putere, ci și să remediam ceva care este un blocaj.

Testează și îmbunătățește cel mai mare impact, mai întâi fructele cu cel mai mic agățat. Asta fac agențiile și de aceea efectuează același număr de teste ca echipele interne, dar cu un ROI mai mare. Agențiile obțin cu 21% mai multe câștiguri pentru același volum de teste!

#15. Testarea mai multor lucruri deodată și neștiind care schimbare a cauzat rezultatul

Nu este nimic în neregulă să faci teste radicale în care schimbi mai multe lucruri simultan și faci o reproiectare a întregii pagini.

De fapt, aceste reproiectări radicale pot avea uneori cel mai mare impact asupra rentabilității investiției dvs., chiar dacă sunteți un site cu trafic redus și, mai ales, dacă sunteți în platou și nu mai puteți obține un plus.

Dar rețineți că nu orice test A/B ar trebui să fie pentru o schimbare radicală ca aceasta. 99% din timp doar testăm o schimbare a unui singur lucru, de exemplu

- Titluri noi

- Imagini noi

- Aspect nou al aceluiași conținut

- Prețuri noi etc.

Cheia atunci când faceți un test cu un singur element este totuși asta. Păstrați-vă testul doar la o modificare a unui element, astfel încât să puteți vedea ce face diferența și să învățați din el. Prea multe schimbări și nu știi ce a funcționat.

#16. Nu se execută o analiză pre-test adecvată

Aveți destui vizitatori în grupul dvs. de testare? Merită testul?

Fă calculul! Asigurați-vă că aveți suficient trafic înainte de a rula un test - altfel este doar timp și bani pierduti. Multe teste eșuează din cauza traficului insuficient sau a sensibilității slabe (sau ambelor).

Efectuați o analiză pre-test pentru a determina dimensiunea eșantionului și efectul minim detectabil pentru experimentul dvs. Un Calculator de semnificație a testării A/B, precum Convert, vă va spune dimensiunea eșantionului și MDE pentru testul dvs., ceea ce vă va ajuta să decideți dacă merită rulat. De asemenea, puteți folosi aceste informații pentru a determina cât de mult ar trebui să dureze testul și cât de mic nu ați dori să pierdeți înainte de a concluziona că un test a avut succes sau nu.

#17. Etichetarea greșită a testelor

O greșeală super simplă, dar se întâmplă. Etichetați greșit testele și apoi obțineți rezultate greșite. Variația câștigă, dar se numește control, iar apoi nu implementați niciodată câștigul și rămâneți cu cel învins!

Verificați întotdeauna!

#18. Executare teste la adresa URL greșită

O altă greșeală simplă. Fie adresa URL a paginii a fost introdusă incorect, fie testul rulează pe un „site de testare” unde ați făcut modificările și nu la versiunea live.

S-ar putea să arate ok pentru tine, dar de fapt nu se va încărca pentru publicul tău.

#19. Adăugarea unor reguli de afișare arbitrare la testul dvs

Din nou, trebuie să testați un lucru cu tratamentul dumneavoastră și nimic altceva.

Dacă este o imagine, atunci testați imaginea. Toate celelalte ar trebui să fie la fel, inclusiv ora din zi în care oamenii pot vedea ambele pagini!

Unele instrumente vă permit să testați diferite ore ale zilei pentru a vedea cum se comportă traficul în diferite intervale de timp. Acest lucru este util dacă doriți să vedeți când este cel mai bun trafic pe site-ul dvs., dar nu este util dacă paginile sunt împărțite de cine le vede ȘI au diferite variante.

De exemplu, traficul propriului nostru blog scade în weekend (ca majoritatea blogurilor de afaceri).

Imaginați-vă dacă am rula un test de luni-miercuri pe pagina de control și apoi am afișat traficul de vineri-duminică pe tratament? Ar avea un trafic mult mai mic de testat și probabil rezultate mult diferite.

#20. Testarea traficului greșit pentru obiectivul dvs

În mod ideal, atunci când rulați un test, doriți să vă asigurați că testați doar un singur segment al publicului dvs. De obicei, sunt vizitatori organici noi, pentru a vedea cum răspund pentru prima dată pe site-ul tău.

Uneori s-ar putea să doriți să testați vizitatorii repeți, abonații de e-mail sau chiar traficul plătit. Trucul este să testați doar unul dintre ele odată, astfel încât să puteți obține o reprezentare exactă a modului în care grupul respectiv funcționează cu pagina respectivă.

Când vă configurați testul, selectați publicul cu care doriți să lucrați și eliminați orice alții care ar putea polua rezultatul, cum ar fi vizitatorii care revin.

#21. Eșecul de a exclude vizitatorii care revin într-un test și denaturarea rezultatelor

Numim această probă poluare.

Practic, dacă un vizitator vede pagina site-ului dvs., revine și vede variația dvs., atunci va răspunde foarte diferit decât dacă ar vedea doar una dintre ele.

Ele pot fi confuze, pot sări sau chiar pot converti mai sus, pur și simplu din cauza acelor interacțiuni suplimentare.

Ideea este că datele dvs. devin poluate și mai puțin precise. În mod ideal, doriți să utilizați un instrument care randomizează pagina pe care o văd, dar apoi le arată întotdeauna aceeași versiune până când testul se termină.

#22. Nu vă ștergeți IP-urile din test

Vorbind despre poluarea mostrelor, iată o altă modalitate de a vă polua datele (și oricum este o practică bună pentru analiză).

Asigurați-vă că vă blocați adresele IP dvs. și ale personalului dvs. din instrumentul dvs. de analiză și testare. Ultimul lucru pe care îl doriți este ca dvs. sau un membru al echipei să vă „înregistrați” pe o pagină și să fiți etichetat în test.

#23. Nesegmentarea variațiilor grupului de control (efect de rețea)

O altă opțiune de poluare care este rară, dar se poate întâmpla, mai ales dacă aveți o rețea pentru publicul dvs.

Iată un exemplu.

Să presupunem că ai o platformă în care publicul tău poate comunica. Poate o pagină de Facebook sau o secțiune de comentarii, dar toți o pot accesa.

În această situație, este posibil să aveți oameni care văd o pagină și alții care văd o variație, dar toți sunt pe aceeași rețea socială. Acest lucru vă poate modifica datele, deoarece acestea pot afecta reciproc alegerile și interacțiunile cu pagina. Linkedin și-a segmentat publicul atunci când a testat noi funcții pentru a preveni problemele legate de efectul de rețea.

În mod ideal, doriți să separați comunicarea dintre cele 2 grupuri de testare până la finalizarea testului.

#24. Desfășurarea de teste în timpul evenimentelor sezoniere sau evenimentelor majore pe site/platformă

Cu excepția cazului în care testați pentru un eveniment sezonier, nu doriți niciodată să rulați o campanie de testare în timpul sărbătorilor sau în orice alt eveniment major, cum ar fi o vânzare specială sau un eveniment mondial.

Uneori nu te poți abține. Veți avea un test de rulare, iar Google doar implementează o nouă actualizare de bază și va încurca cu sursele dvs. de trafic la mijlocul campaniei *tuși*.

Cel mai bun lucru de făcut este pur și simplu reluare după ce totul se stinge.

#25. Ignorarea diferențelor culturale

Este posibil să aveți un obiectiv pentru o pagină, dar desfășurați și o campanie globală cu mai multe variante care apar în diferite limbi și țări diferite.

Trebuie să țineți cont de acest lucru atunci când rulați testul. Unele modificări pot fi făcute la nivel global, cum ar fi o simplă schimbare a aspectului sau adăugarea de semnale de încredere etc.

Alteori, trebuie să țineți cont de punctele culturale de diferență. Cum văd oamenii aspectul, cum văd imaginile și avatarurile de pe pagina ta.

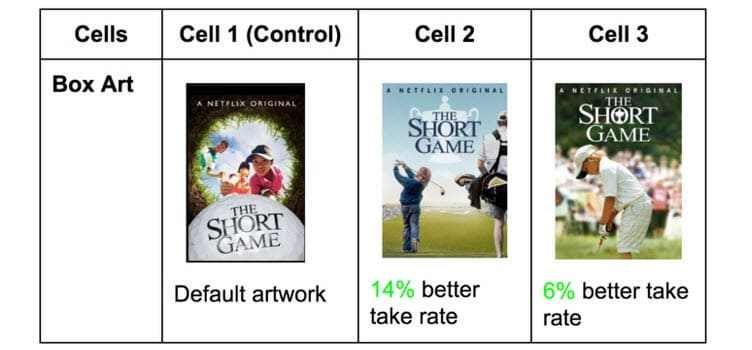

Netflix face acest lucru cu miniaturile tuturor emisiunilor lor, testând diferite elemente care pot atrage audiențe diferite (prezentând, în schimb, anumiți actori faimoși în acea țară).

Ceea ce primește clicuri într-o țară poate fi incredibil de diferit în altele. Totuși, nu știi până nu testezi!

#26. Rularea mai multor campanii conectate în același timp

Este ușor să fii entuziasmat și să vrei să rulezi mai multe teste simultan.

Nu uitați: puteți rula mai multe teste pentru puncte similare din procesul de vânzare în același timp, dar nu rulați mai multe teste pentru mai multe puncte conectate în canal.

Iată ce vreau să spun.

Puteți rula destul de ușor teste pe fiecare pagină de generare de clienți potențiali pe care o aveți, toate în același timp.

Cu toate acestea, nu ați dori să testați simultan paginile de clienți potențiali, paginile de vânzări și paginile de finalizare a achiziției, deoarece acest lucru poate introduce atât de multe elemente diferite în procesul dvs. de testare, necesitând volume masive de trafic și conversii pentru a obține informații utile.

Nu numai atât, dar fiecare element poate provoca efecte diferite pe pagina următoare, atât bune, cât și rele. Dacă nu aveți sute de mii de vizitatori pe săptămână, probabil că veți avea dificultăți să obțineți rezultate precise.

Așa că aveți răbdare și testați doar o etapă la un moment dat sau pagini care nu sunt conectate în proces.

Notă marginală:

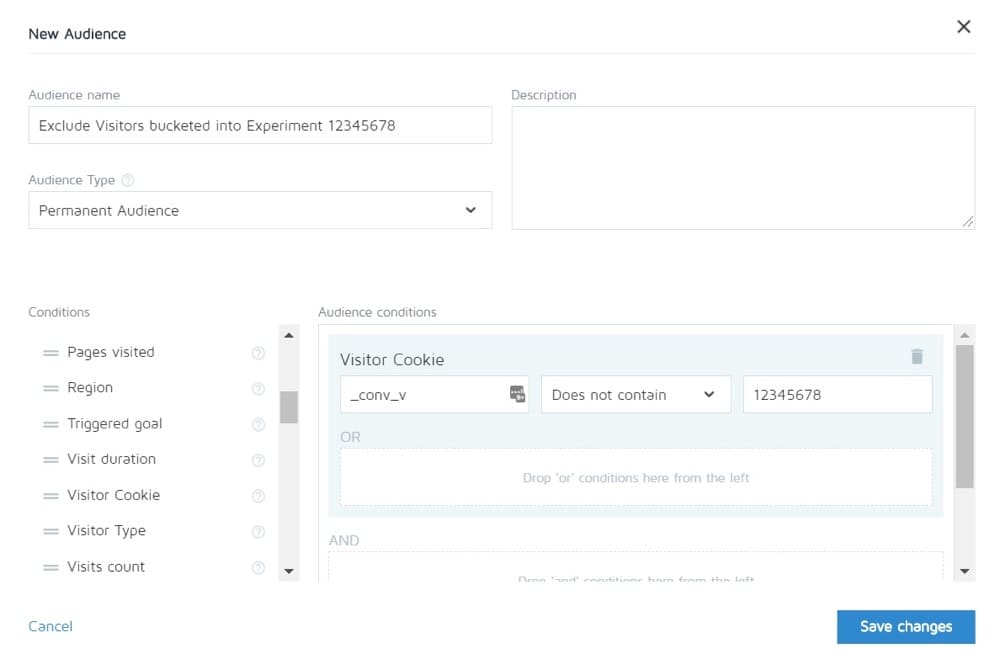

Convertiți vă permite să excludeți persoanele dintr-un experiment de la a vedea altele. Deci, teoretic, puteți testa întregul ciclu de vânzări și apoi puteți vedea doar controlul celorlalte pagini.

#27. Ponderarea inegală a traficului

Nu contează dacă executați un test A/B, un A/B/n sau un test multivariat. Trebuie să alocați un volum de trafic egal fiecărei versiuni, astfel încât să puteți obține o măsurare precisă.

Setați-le să fie egale de la început. Majoritatea instrumentelor vă vor permite să faceți acest lucru.

Greșeli frecvente de testare A/B pe care le puteți face în timpul testului

#28. Nu rulați suficient de mult pentru a obține rezultate precise

Există 3 factori importanți de care trebuie să luați în considerare atunci când doriți să testați și să obțineți rezultate precise:

- Semnificație statistică,

- Ciclul de vânzări și

- Marime de mostra.

Așa că haideți să o descompunem.

Majoritatea oamenilor încheie testele odată ce instrumentul lor de testare le spune că un rezultat este mai bun decât celălalt ȘI rezultatul este semnificativ statistic, adică dacă testul continuă să funcționeze astfel, atunci acesta este un câștigător definitiv.

Chestia este că poți apăsa „stat sig” destul de repede uneori cu doar o cantitate mică de trafic. În mod aleatoriu, toate conversiile au loc pe o pagină și niciuna pe cealaltă.

Totuși, nu va rămâne întotdeauna așa. S-ar putea ca testul să fi lansat, e ziua de plată și ai avut o grămadă de vânzări în acea zi.

Acesta este motivul pentru care trebuie să luăm în considerare ciclul vânzărilor. Vânzările și traficul pot fluctua în funcție de ziua săptămânii sau de lună. Pentru a obține o reprezentare mai exactă a modului în care se desfășoară testul, în mod ideal trebuie să rulați între 2 și 4 săptămâni.

În sfârșit, aveți dimensiunea eșantionului.

Dacă rulați testul timp de o lună, probabil că veți obține suficient trafic pentru a obține rezultate precise. Prea puțin și testul pur și simplu nu vă va putea oferi un nivel de încredere că va funcționa așa cum ar trebui.

Deci, ca regulă de bază,

- Alegeți un rating de încredere de 95%.

- Alergați o lună.

- Aflați în avans ce dimensiune a eșantionului aveți nevoie și nu opriți testul până când nu ajungeți SAU obțineți un rezultat uimitor care demonstrează fără nicio umbră de îndoială că aveți un câștigător.

#29. Monitorizare/peeking cu elicopterul

Peeking este un termen folosit pentru a descrie momentul în care un tester se uită la testul său pentru a vedea cum funcționează acesta.

În mod ideal, nu vrem să ne uităm niciodată la testul nostru odată ce a fost executat și nu luăm niciodată o decizie cu privire la el până când nu termină un ciclu complet, cu dimensiunea eșantionului potrivită și semnificația statistică a acestuia.

Totuși... Ce se întâmplă dacă testul nu rulează?

Ce se întâmplă dacă ceva este spart?

Ei bine, în cazul ăsta, chiar nu vrei să aștepți o lună să vezi că s-a stricat, nu? Acesta este motivul pentru care verific întotdeauna pentru a vedea dacă un test are rezultate în control și variație, la 24 de ore după ce l-am setat să ruleze.

Dacă văd că amândoi primesc trafic și obțin clicuri/conversii, atunci plec și îl las să-și facă treaba. Nu iau nicio decizie până când testul și-a terminat cursul.

#30. Nu se urmărește feedbackul utilizatorilor (mai ales important dacă testul afectează o acțiune directă, imediată)

Să presupunem că testul primește clicuri și traficul este distribuit, așa că *pare* că funcționează, dar dintr-o dată începi să primești rapoarte că oamenii nu pot completa formularul de vânzări. (Sau și mai bine, ați primit o alertă automată că o măsurătoare pentru balustradă a scăzut mult sub nivelurile acceptabile.)

Ei bine, atunci primul tău gând ar trebui să fie că ceva este stricat.

Nu este întotdeauna. Este posibil să primiți clicuri de la un public care nu rezonează cu oferta dvs., dar pentru orice eventualitate, merită să verificați formularul respectiv.

Dacă este stricat, reparați-l și reporniți.

#31. Efectuarea modificărilor la mijlocul testului

S-ar putea să fi fost clar din ultimele câteva puncte, dar nu vrem să facem niciodată modificări unui test odată ce acesta a fost lansat.

Sigur, ceva s-ar putea rupe, dar asta este singura schimbare pe care ar trebui să o facem vreodată. Nu schimbăm designul, copierea sau nimic.

Dacă testul funcționează, lăsați-l să ruleze și lăsați datele să decidă ce funcționează.

#32. Modificarea procentului de alocare a traficului la mijlocul testului sau eliminarea persoanelor cu performanțe slabe

Așa cum nu modificăm paginile testate, nu eliminăm nicio variație și nici nu modificăm distribuția traficului la mijlocul testului.

De ce?

Să presupunem că executați un test A/B/n cu un control și 3 variante. Începi testul și după o săptămână arunci cu obraznic o privire și observi că 2 versiuni merg grozav și una prost.

Acum ar fi tentant să dezactivezi varianta „pierdetoare” și să redistribuim traficul între celelalte variante, nu? La naiba... s-ar putea să doriți chiar să luați acel 25% în plus din trafic și să-l trimiteți pur și simplu celor mai performanti, dar nu o faceți.

De ce?

Nu numai că această redistribuire va afecta performanța testului, dar poate afecta direct rezultatele și modul în care acestea apar pe instrumentul de raportare.

Toți utilizatorii care au fost grupați anterior la varianta eliminată vor trebui realocați unei variante și vor vedea o pagină web modificată într-un interval scurt de timp, ceea ce le-ar putea afecta comportamentul și alegerile ulterioare.

De aceea, nu modificați niciodată traficul și nici nu opriți variațiile la jumătatea drumului. (Și, de asemenea, de ce nu ar trebui să te uiți cu ochiul!)

#33. Nu opriți un test atunci când aveți rezultate precise

Uneori ai uitat să oprești un test!

Continuă să ruleze și să alimenteze 50% din publicul tău către o pagină mai slabă și 50% către câștigător. Hopa!

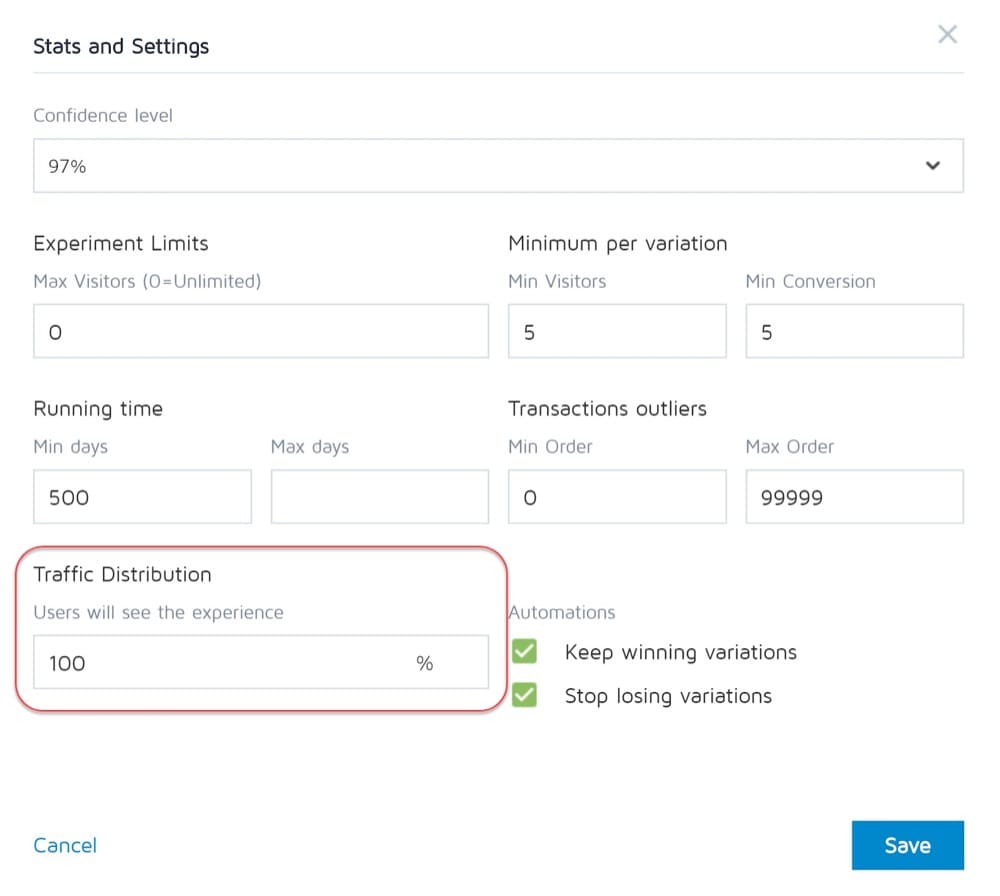

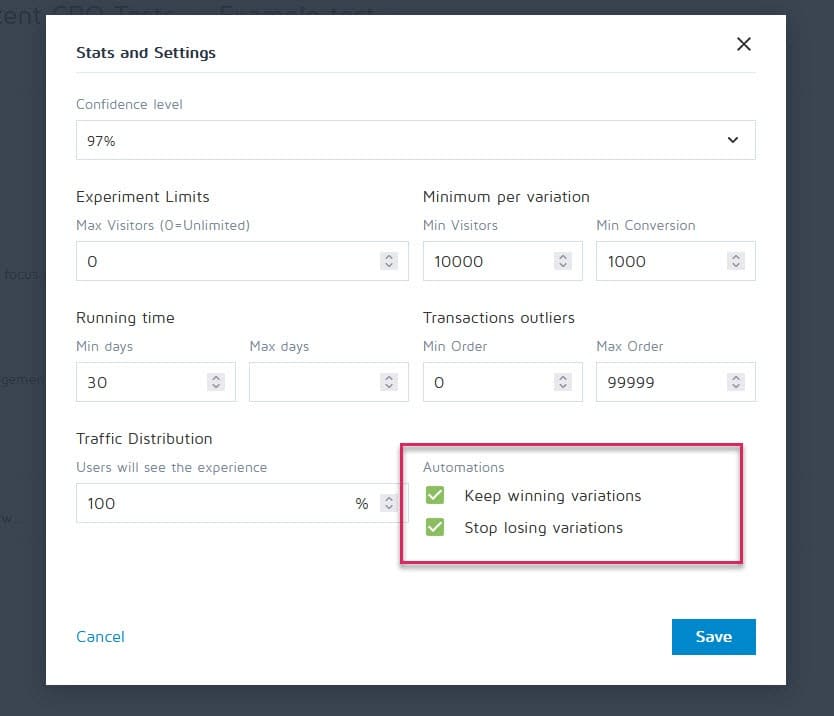

Din fericire, instrumente precum Convertiți experiențe pot fi configurate pentru a opri o campanie și pentru a afișa automat câștigătorul odată ce acesta atinge anumite criterii (cum ar fi dimensiunea eșantionului, semnul statistic, conversiile și intervalul de timp).

#34. A fi investit emoțional în pierderea variațiilor

Ca testeri, trebuie să fim imparțiali. Uneori, totuși, s-ar putea să ai un anumit design sau o idee pe care pur și simplu o iubești și că ești convins că ar fi trebuit să câștige, așa că continui să extinzi testul din ce în ce mai mult pentru a vedea dacă merge înainte.

Scoate bandajul.

S-ar putea să aveți o idee bună care trebuie doar îmbunătățită, dar nu puteți face asta până când nu încheiați testul curent.

#35. Executarea testelor pentru prea mult timp și urmărirea scade

Iată o altă problemă potențială de poluare a probei.

Dacă executați un test mai mult de 4 săptămâni, există șansa să vedeți că cookie-urile utilizatorilor se dezactivează. Acest lucru poate cauza o lipsă de urmărire a evenimentelor, dar acestea pot chiar să revină și să polueze din nou datele eșantionului.

#36. Nu folosiți un instrument care vă permite să opriți/implementarea testului!

O altă problemă rară.

Unele programe de testare insistă să creeze teste hard-coded. adică un dezvoltator și un inginer construiesc campania de la zero.

Nu este grozav, totuși, când testul se termină și trebuie să așteptați ca același dezvoltator să îl dezactiveze și să instaleze varianta câștigătoare. Nu numai că este frustrant, dar poate încetini serios numărul de teste pe care le puteți rula și chiar rentabilitatea investiției paginii în timp ce așteptați ca aceasta să fie disponibilă.

Greșeli frecvente de testare A/B pe care le puteți face după ce testul este terminat

#37. Renunț după un test!

9 din 10 teste sunt de obicei un eșec.

Asta înseamnă că trebuie să rulezi 10 teste pentru a obține acel câștigător. Este nevoie de efort, dar întotdeauna merită, așa că nu te opri după o campanie!

#38. Renunțând la o ipoteză bună înainte de a testa toate versiunile acesteia

Un eșec poate însemna pur și simplu ipoteza ta este corectă, dar trebuie executată mai bine.

Încercați moduri noi, designuri noi, aspect nou, imagini noi, avatare noi, limbă nouă. Ai ideea și vezi dacă o poți executa mai bine.

A fost nevoie de 21 de iterații CXL pentru a îmbunătăți pagina clientului lor, dar le-a luat de la o rată de conversie de 12,1% la 79,3%.

#39. Așteptând victorii uriașe tot timpul

Adevărul este că s-ar putea să obțineți un câștig uriaș doar 1 din fiecare 10 sau mai multe campanii câștigătoare.

Asta e ok. Continuăm să testăm și ne continuăm să ne îmbunătățim, pentru că chiar și o creștere cu 1% a compușilor în timp. Îmbunătățiți-l și aduceți-l la 2% și acum ați dublat eficacitatea.

Ce tipuri de teste dau cele mai bune rezultate?

Adevărul este că diferite experimente au efecte diferite. Conform cercetărilor lui Jakub Linowski din peste 300 de teste, experimentele de aspect tind să conducă la rezultate mai bune.

Care este cel mai dificil tip de ecran de optimizat? Aceeași cercetare dezvăluie ecranele de checkout (cu un efect median de +0,4% din 25 de teste).

#40. Nu se verifică validitatea după test

Deci testul s-a terminat. Ai alergat suficient de mult, ai văzut rezultate și ai obținut semnul statistic, dar poți avea încredere în acuratețea datelor?

S-ar putea ca ceva să fi fost rupt la jumătatea testării. Nu strică niciodată să verifici.

#41. Nu citesc corect rezultatele

Ce îți spun cu adevărat rezultatele tale? Eșecul de a le citi corect poate lua cu ușurință un potențial câștigător și poate părea un eșec total.

- Pătrundeți-vă adânc în analizele dvs.

- Uitați-vă la orice date calitative pe care le aveți.

Ce a funcționat și ce nu? De ce s-a întâmplat?

Cu cât înțelegi mai mult rezultatele, cu atât mai bine.

#42. Nu se uită la rezultatele pe segmente

Merită întotdeauna să te scufunzi puțin mai adânc.

De exemplu, o variantă nouă ar putea părea că face conversii slabe, dar pe mobil are o creștere de 40% a conversiilor!

Puteți afla asta doar segmentându-l în rezultatele dvs. Uită-te la dispozitivele folosite și la rezultatele de acolo. S-ar putea să găsiți câteva informații valoroase!

Doar fiți conștienți de semnificația dimensiunii segmentului dvs. Este posibil să nu fi avut suficient trafic către fiecare segment pentru a avea încredere în el, dar puteți oricând să efectuați un test numai pentru dispozitive mobile (sau indiferent de canalul acesta) și să vedeți cum funcționează.

#43. Nu învăța din rezultate

Pierderea testelor vă poate oferi o perspectivă asupra locurilor în care trebuie să vă îmbunătățiți în continuare sau să faceți mai multe cercetări. Cel mai enervant lucru ca CRO este să vezi clienți care refuză să învețe din ceea ce tocmai au văzut. Au datele, dar nu le folosesc...

#44. Luând învinșii

Sau mai rău, ei iau varianta pierzătoare.

Poate că ei preferă designul, iar rata de conversie este diferită de doar 1%, dar în timp acele efecte se compun. Luați acele mici câștiguri!

#45. Nu luați măsuri cu privire la rezultate

Și mai rău din nou?

Obține un câștig, dar nu îl implementezi! Ei au datele și pur și simplu nu fac nimic cu ele. Nicio schimbare, nicio perspectivă și nicio teste noi.

#46. Nu repetarea și îmbunătățirea câștigurilor

Uneori poți lua un lift, dar mai sunt multe de avut. După cum am spus mai devreme, este foarte rar ca fiecare câștig să îți ofere o creștere de două cifre.

Dar asta nu înseamnă că nu poți ajunge acolo rulând noi iterații și îmbunătățiri și găzduindu-ți drumul cu 1% la un moment dat.

Totul se adaugă, așa că continuați să vă îmbunătățiți!

#47. Nu distribuie constatările câștigătoare în alte domenii sau departamente

Unul dintre cele mai mari lucruri pe care le vedem cu echipele CRO super-succesoase/mature este că își împărtășesc câștigurile și constatările cu alte departamente din companie.

Acest lucru oferă altor departamente perspective asupra modului în care se pot îmbunătăți.

- Găsiți o copie câștigătoare a paginii de vânzări? Precadrați-l în reclamele dvs. pentru a le duce la pagină!

- Găsiți un stil de magnet cu plumb care funcționează grozav? Testați-l pe întregul site.

#48. Nu testează acele modificări în alte departamente

Și aici este cheia. Chiar dacă împărtășiți informații cu alte departamente, ar trebui să testați pentru a vedea cum funcționează.

Un design de stil care dă lifting într-o zonă ar putea da o scădere în altele, așa că testați întotdeauna!

#49. Prea multă iterație pe o singură pagină

Numim asta atingerea „maximului local”.

Pagina pe care desfășurați testele s-a liniștit și pur și simplu nu mai puteți beneficia de ea.

Puteți încerca reproiectări radicale, dar ce urmează?

Pur și simplu treceți pe o altă pagină din procesul de vânzare și îmbunătățiți-o. (În mod ironic, acest lucru se poate dovedi că oferă un ROI mai mare oricum.)

Preluarea unei pagini de vânzări de la o conversie de 10% la 11% poate fi mai puțin importantă decât trecerea paginii care generează trafic către ea de la 2% la 5%, deoarece în esență vei dubla traficul de pe pagina anterioară.

Dacă aveți îndoieli, găsiți următorul test cel mai important din lista dvs. și începeți să vă îmbunătățiți. S-ar putea chiar să găsiți că oricum ajută la conversie pe pagina respectivă blocată, pur și simplu prin hrănirea ei cu potențiali mai buni.

#50. Nu testează suficient!

Testele necesită timp și sunt doar atâtea pe care le putem rula simultan.

Deci ce putem face?

Pur și simplu reduceți timpul de nefuncționare dintre teste!

Finalizați un test, analizați rezultatul și fie repetați, fie executați un alt test. (În mod ideal, aveți-i la coadă și gata de plecare).

În acest fel, veți vedea o rentabilitate mult mai mare pentru investiția dvs. de timp.

#51. Nu se documentează testele

Un alt obicei pe care echipele CRO mature îl au este crearea unei baze de date interne de teste, care să includă date despre pagină, ipoteză, ce a funcționat, ce nu, liftul etc.

Nu numai că puteți învăța din teste mai vechi, dar vă poate împiedica să reluați un test din întâmplare.

#52. Uitând de fals pozitive și nu verificați dublu campanii uriașe de creștere

Uneori un rezultat este prea bun pentru a fi adevărat. Fie ceva a fost configurat sau s-a înregistrat greșit, fie acesta se întâmplă să fie acel 1 din 20 de teste care dă un fals pozitiv.

Deci ce poți face?

Pur și simplu reluați testul, setați un nivel ridicat de încredere și asigurați-vă că le rulați suficient de mult.

#53. Nu urmăresc rezultatele downline

Atunci când urmăriți rezultatele testelor, este, de asemenea, important să vă amintiți obiectivul final și să urmăriți valorile din downline înainte de a decide un câștigător.

O nouă variantă poate obține, din punct de vedere tehnic, mai puține clicuri, dar generează mai multe vânzări de la persoanele care fac clic.

În acest caz, această pagină ar fi de fapt mai profitabilă de rulat, presupunând că traficul pe care clicurile continuă să facă conversie...

#54. Nu ține cont de efectele de primație și de noutate, care pot influența rezultatele tratamentului

Să presupunem că nu vizați doar noi vizitatori cu o schimbare, ci tot traficul.

Încă le segmentăm, astfel încât 50% să vadă versiunea originală și 50% să vadă noua versiune, dar le permitem vizitatorilor din trecut să intre în campanie. Aceasta înseamnă că oamenii care v-au văzut site-ul înainte, v-au citit conținutul, v-au văzut îndemnurile etc.

De asemenea, pe durata campaniei, ei văd doar versiunea lor specifică de testare.

Când faci o nouă schimbare, aceasta poate avea de fapt un efect de noutate asupra audienței tale trecute.

Poate că văd același CTA tot timpul și acum pur și simplu îl ignoră, nu? În acest caz, un nou buton sau design CTA poate vedea de fapt o creștere a vizitatorilor din trecut, nu pentru că își doresc mai mult acum, ci pentru că este nou și interesant.

Uneori, este posibil să obțineți chiar mai multe clicuri, deoarece aspectul s-a schimbat și ei explorează designul.

Din această cauză, veți primi de obicei o creștere inițială ca răspuns, dar care se stinge în timp.

Cheia atunci când rulați testul este să segmentați publicul și să vedeți dacă noii vizitatori răspund la fel de bine ca și cei vechi.

Dacă este mult mai mică, atunci ar putea fi un efect de noutate cu vechii utilizatori făcând clic în jur. Dacă este la un nivel similar, s-ar putea să ai un nou câștigător pe mâini.

Oricum, lăsați-l să funcționeze pentru întregul ciclu și echilibrați-vă.

#55. Se modifică perioada de examinare

Un alt lucru de luat în considerare la testare este orice variantă care ar putea schimba perioada de considerație a publicului.

Ce vreau să spun?

Să presupunem că în mod normal nu obțineți vânzări imediate. Clientii potențiali pot fi pe un ciclu de vânzări de 30 de zile sau chiar mai lung.

Dacă testați un îndemn la acțiune care le afectează în mod direct timpul de a lua în considerare și de a cumpăra, aceasta vă va denatura rezultatele. În primul rând, controlul dvs. ar putea obține vânzări, dar să fie în afara perioadei de testare, așa că le pierdeți.

Un alt scenariu este dacă aveți un CTA care oferă o ofertă, un preț pentru orice altceva care îi face să dorească să ia măsuri acum, atunci acest lucru vă va denatura rezultatele aproape întotdeauna pentru a face ca această versiune să pară că se convertește mult mai bine.

Ține cont de acest lucru și analizează-ți analizele în timpul și după test pentru a fi sigur.

#56. Nu se retestează după X timp

Este mai puțin despre o anumită pagină sau o greșeală de testare, ci mai mult despre filozofia de testare.

Da, s-ar putea să aveți o pagină minunată și, da, s-ar putea să fi făcut 20 de iterații pentru a ajunge acolo unde este astăzi.

Chestia este că în câțiva ani s-ar putea să fie nevoie să revizuiți din nou întreaga pagină. Mediile se schimbă, limba și termenii folosiți, produsul poate fi modificat.

Fiți întotdeauna gata să reveniți la o campanie veche și să retestați. (Un alt motiv pentru care a avea un depozit de testare funcționează grozav.)

#57. Testează doar calea și nu produsul

Aproape toți ne concentrăm pe calea spre vânzare și testăm pentru asta. Dar realitatea este că produsul poate fi, de asemenea, testat și îmbunătățit A/B și poate oferi chiar o putere mai mare.

Gândiți-vă la iPhone.

Apple și-a testat site-ul web și l-a îmbunătățit, dar iterațiile și îmbunătățirile produsului continuă să creeze și mai mult.

Acum, este posibil să nu aveți un produs fizic. S-ar putea să aveți un program sau o ofertă digitală, dar a afla mai multe despre nevoile publicului dvs. și a testa acest lucru, apoi revenirea pe pagina dvs. de vânzări poate fi URIAȘĂ în ceea ce privește creșterea.

Concluzie

Deci iată-l. Cele 57 de greșeli comune și neobișnuite de testare A/B pe care le vedem și cum le puteți evita.

Puteți folosi acest ghid pentru a vă ajuta să evitați aceste probleme pentru toate campaniile viitoare.