5 sfaturi pentru economisirea timpului folosind OnCrawl

Publicat: 2017-06-21Cum să profitați de funcțiile avansate OnCrawl pentru a vă îmbunătăți eficiența în timpul monitorizării zilnice SEO.

OnCrawl este un instrument SEO puternic care vă ajută să monitorizați și să optimizați vizibilitatea motorului de căutare a site-urilor web de comerț electronic, a editorilor online sau a aplicațiilor. Instrumentul a fost construit în jurul unui principiu simplu: ajutați managerii de trafic să economisească timp în procesul lor de analiză și în gestionarea zilnică a proiectelor SEO.

Pe lângă faptul că este un instrument de audit la fața locului, bazat pe o platformă SaaS susținută de un API care combină toate datele site-urilor web, este și un analizor de jurnal care simplifică extragerea și analiza datelor din fișierele serverului de jurnal.

Posibilitățile OnCrawl sunt destul de largi, dar trebuie stăpânite. În acest articol, vom împărtăși 5 sfaturi care economisesc timp pentru utilizarea zilnică a crawler-ului nostru SEO și a analizorului de jurnal.

1# Cum să clasificați URL-urile HTTP și HTTPS

Migrarea HTTPS este un subiect fierbinte în sfera SEO. Pentru a gestiona perfect acest pas cheie, este important să urmăriți cu exactitate comportamentul roboților pe ambele protocoale.

Experiența a arătat că roboții au nevoie de mai mult sau mai puțin timp pentru a trece complet de la HTTP la HTTPS. În medie, această tranziție durează câteva săptămâni sau luni, în funcție de factori externi și interni legați de calitatea și migrarea site-ului.

Pentru a înțelege cu precizie acea fază de tranziție, în care bugetul dvs. de accesare cu crawlere este puternic afectat, este inteligent să monitorizați accesările roboților. Prin urmare, este necesar să se analizeze jurnalele serverului. Botul, ca utilizator obișnuit, lasă urme pe fiecare pagină, resursă și cerere pe care o face. Jurnalele dvs. dețin porturile care au livrat aceste apeluri. Astfel, puteți valida calitatea migrării site-ului dvs. HTTPS.

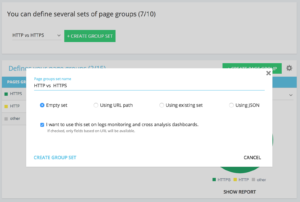

Metode pentru a configura un set dedicat http vs https de grup de pagini

Pe pagina de pornire a proiectului Avansat, puteți găsi în colțul din dreapta sus un buton „Setări”. Apoi, selectați meniul „Configurare grup de pagini”. Odată ajuns aici, creați un nou „Creare Group Set” și numiți-l „HTTP vs HTTPS”.

Pentru a vă accesa jurnalele, este important să selectați opțiunea „Vreau să folosesc acest set pentru monitorizarea jurnalelor și tablourile de bord de analiză încrucișată” .

- HTTPS: „URL complet” / „începe cu” / https

- HTTP: „URL complet” / „nu începe cu” / https

Odată salvat, veți accesa o vizualizare a migrației dvs. HTTPS (dacă ați adăugat portul de solicitare în liniile dvs. de jurnal. Puteți arunca o privire la ghidul nostru.)

Filtrele noastre rapide pot fi găsite în Data Explorer. Au fost construite pentru a facilita accesul la unele valori SEO importante, cum ar fi link-uri care indică către 404, 500 sau 301/302, pagini prea lente sau prea slabe etc.

Iată lista completă:

- 404 erori

- erori 5xx

- Pagini active

- Pagini active care nu au fost accesate cu crawlere de Google

- Pagini active cu un cod de stare întâlnit de Google diferit de 200

- Canonic nu se potrivește

- Canonic nu este setat

- Pagini indexabile

- Fără pagini indexabile

- Pagini active orfane

- Pagini orfane

- Pagini accesate cu crawlere de Google

- Pagini accesate cu crawlere de Google și OnCrawl

- Paginile din structura nu au fost accesate cu crawlere de Google

- Pagini care indică erori 3xx

- Pagini care indică erori 4xx

- Pagini care indică erori 5xx

- Pagini cu h1 prost

- Pagini cu h2 prost

- Pagini cu meta descriere proastă

- Pagini cu titlu prost

- Pagini cu probleme de duplicare HTML

- Pagini cu mai puțin de 10 link-uri

- Redirecționează 3xx

- Pagini prea grele

- Pagini prea lente

Dar, uneori, aceste filtre rapide nu răspund tuturor preocupărilor dvs. de afaceri. În acest caz, puteți începe de la unul dintre ele și puteți crea „Propriul filtru” adăugând bucăți în filtru și salvându-le pentru a găsi rapid filtrele de fiecare dată când vă conectați la instrument.

De exemplu, de la linkurile care indică spre 4xx, puteți alege să filtrați linkurile care au o ancoră goală: „Ancora“ / „este” / „” și să salvați acel filtru. Odată salvat, poate fi modificat de câte ori este nevoie.

Acum aveți acces direct la acel „Filtru rapid” în lista „Selectați un filtru rapid” din partea de jos a părții „Proprie”, așa cum se vede în captura de ecran de mai jos.

3# Cum să configurați câmpurile personalizate legate de DataLayer?

Puteți utiliza o segmentare a tipurilor de pagini asociate, de exemplu, atunci când definiți etichetele instrumentelor de analiză. Acest cod special este foarte interesant pentru a segmenta sau încrucișa datele din OnCrawl cu datele externe.

Pentru a vă permite să creați o „coloană pivot” pentru analiza dvs., putem extrage aceste bucăți de coduri în timpul accesării cu crawlere și să le aducem înapoi ca tip de date ale proiectului dumneavoastră.

Opțiunea „Câmpuri personalizate” permite răzuirea oricărui element din paginile de cod sursă datorită unei expresii regex sau unui XPath. Aceste limbi au propriile lor definiții și reguli. Puteți găsi informații despre XPath aici și despre regex aici.

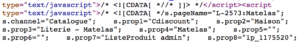

Cazul de utilizare 1: extragerea datelor stratului de date din codul sursă al paginilor

Cod de analizat:

Soluție: Folosiți un „regex”: s.prop2=”([^”]+)” / Extras: Mono-valoare / Format câmp: Valoare

- Găsiți șirul de caractere s.prop2="

- Răzuiți toate caracterele care nu sunt „ (primul caracter după datele de extras)

- Șirul de extras poate fi găsit înainte de închidere „

În urma crawl-ului, în exploratorul de date, veți găsi în coloana sProp2, sProp3 sau în câmpul dvs. Nume, datele extrase:

Utilizați un XPATH

Cod de analizat:

Trebuie doar să copiați/lipiți elementul Xpath pe care doriți să îl răzuiți direct din analizatorul de cod Chrome. Fiți atenți, dacă codul este redat în JavaScript, va trebui să configurați un proiect de scrape personalizat. Limbajul Xpath este foarte puternic și poate fi greu de manipulat, așa că dacă aveți nevoie de ajutor, vă rugăm să sunați experții noștri.

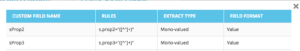

Cazul de utilizare 3: testarea prezenței unei etichete de analiză în timpul unei faze de recepție

Folosiți un regex

Cod de analizat:

Soluție: Folosiți un „regex”: „_setAccount”, „UA-364863-11” / Extras: Verificați dacă există

Veți obține în Data Explorer un „adevărat” dacă se găsește șirul, „fals” dimpotrivă.

4# Cum să vizualizați frecvența de accesare cu crawlere Google în fiecare parte a site-ului dvs

Bugetul de accesare cu crawlere este în centrul oricărei preocupări SEO. Este strâns legat de conceptul „Importanța paginii” și de programarea accesului cu crawlere de la Google. Știm că aceste principii, introduse în brevetul Google încă din 2012, permit societății Mountain View să optimizeze resursele dedicate crawl-ului web.

Google nu cheltuiește aceeași energie în fiecare parte a site-ului dvs. Frecvența sa de accesare cu crawlere în fiecare parte a site-ului dvs. vă oferă informații precise despre importanța paginilor dvs. pentru ochii Google.

Paginile importante sunt accesate cu crawlere mai mult de roboții Google, deoarece bugetul de accesare cu crawlere este strâns legat de abilitățile de clasificare a paginii.

Proiectele OnCrawl Advanced vă permit să vedeți în mod nativ bugetul de accesare cu crawlere în secțiunea „Monitorizare jurnal” / „Comportament cu crawlere” / „Comportament cu crawlere în funcție de grup”.

Puteți vedea că grupul „Pagină de pornire” are cea mai mare frecvență de accesare cu crawlere. Este normal pentru că Google caută în permanență articole noi și acestea sunt în general listate pe pagina de start. Ideea Page Importance este profund legată de conceptul Google Freshness. Pagina dvs. de pornire este cea mai importantă pagină pentru a prioritiza bugetul de accesare cu crawlere Google. Apoi, optimizarea este răspândită în alte pagini în ceea ce privește profunzimea și popularitatea.

Cu toate acestea, este greu să vezi diferențele de frecvență. Astfel, trebuie să faceți clic pe grupurile pe care doriți să le eliminați (făcând clic pe legendă) și să vedeți afișarea datelor.

5# Cum să testați codurile de stare dintr-o listă de adrese URL după o migrare

Când doriți să testați rapid codurile de stare dintr-un set de adrese URL, este posibil să modificați setările unui nou acces cu crawlere:

- Adăugați toate adresele URL de pornire (butonul „adăugați adresa URL de pornire”)

- Definiți adâncimea maximă la 1

Această accesare cu crawlere personalizată va returna date calitative referitoare la acest set de adrese URL.

Veți putea verifica dacă redirecționările sunt bine configurate sau veți putea urmări evoluția codurilor de stare în timp. Gândiți-vă la avantajul accesării cu crawlere în mod regulat, veți putea urmări automat adresele URL vechi.

De ce nu creați un tablou de bord automatizat prin intermediul API-ului nostru și să creați monitorizare automată a testelor pe aceste aspecte.

Sperăm că aceste hack-uri vă vor ajuta să vă îmbunătățiți eficiența utilizând OnCrawl. Încă mai avem multe trucuri avansate de arătat. Vă rugăm să împărtășiți cu noi pe Twitter, de exemplu, #oncrawlhacks, ne bucurăm că utilizatorii noștri se pot distra la fel de mult ca și noi cu instrumentul nostru.