Cele 5 chei ale analizei fișierelor jurnal de care are nevoie orice SEO

Publicat: 2018-12-13Fișierele jurnal sunt o reflectare precisă a vieții site-ului dvs. Fie de către utilizatori sau de către roboți, pe pagini sau pe resurse, toată activitatea de pe site-ul dvs. este stocată în jurnalele dvs.

Conținând informații precum adrese IP, coduri de stare, agenți de utilizator, referenți și alte date tehnice, fiecare linie din jurnale (date bazate pe server) vă poate ajuta să completați analiza site-ului dvs., care se bazează de obicei pe date de analiză (utilizator- date orientate).

Datele pe care le veți găsi în jurnalele dvs. vă pot ajuta, singure, să vă concentrați strategia SEO.

1. Starea de sănătate a site-ului dvs. web

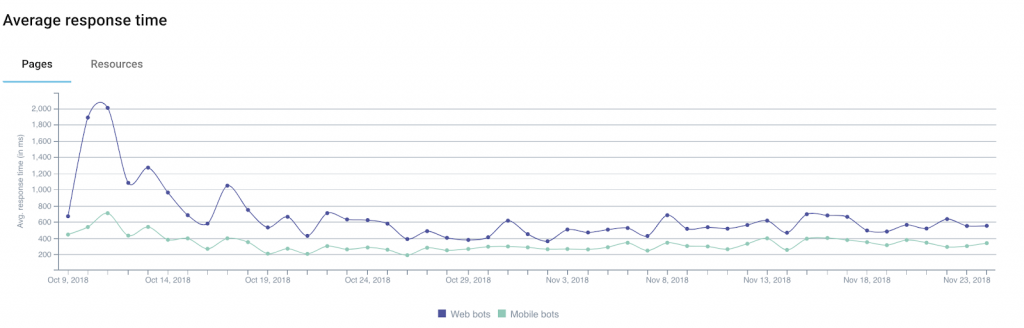

Printre informațiile pe care le puteți obține prin jurnalele dvs., codul de stare , dimensiunea răspunsului și timpul de răspuns sunt indicatori excelenți ai stării site-ului dvs.

De fapt, este obișnuit să pierzi trafic sau conversii fără a înțelege cu adevărat de ce. Asta pentru că explicația poate fi uneori tehnică.

Printre pistele de luat în considerare sunt câteva care au legătură directă cu cele 3 domenii pe care tocmai le-am menționat.

Exemplul 1: o creștere a numărului de erori de server („5xx”) ar putea indica probleme tehnice care pot rămâne nedetectate dacă pur și simplu navigați de la o pagină la alta.

Exemplul 2: mai multe studii au arătat impactul timpului de încărcare asupra ratei de conversie pentru site-urile de comerț electronic. O scădere a veniturilor din vânzări s-ar putea corela cu o creștere a timpului de încărcare a paginilor dvs.

În plus, Google oferă un calculator care vă permite să simulați relația dintre timpul de încărcare și venituri (de luat cu un grăunte de sare).

Exemplul 3: se poate întâmpla uneori ca serverul tău, în urma diverselor probleme tehnice, să returneze pagini goale. În acest caz, simpla monitorizare a codurilor dvs. de stare nu va fi suficientă pentru a vă alerta. De aceea, poate fi util să adăugați dimensiunea răspunsului la datele pe care le monitorizați: aceste pagini goale (sau goale) sunt de obicei mai ușoare decât de obicei.

Prin segmentarea site-ului dvs. pe baza diferitelor tipuri de URL-uri/pagini, veți putea izola mai ușor sursele problemelor tehnice, ceea ce va simplifica rezolvarea problemei.

2. Frecvența loviturilor botului

Pentru membrii comunității SEO, jurnalele reprezintă o mulțime de informații utile despre modul în care roboții din motoarele de căutare își „consumă” site-urile web.

De exemplu, ei ne anunță când roboții au vizitat o pagină pentru prima sau ultima dată.

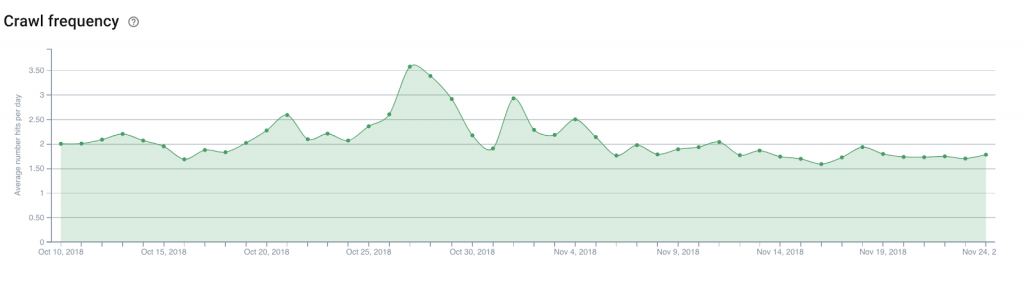

Să luăm exemplul unui site de știri care are nevoie în mod logic de motoare de căutare pentru a găsi și indexa rapid conținutul proaspăt. Analiza câmpurilor de jurnal care indică data și ora face posibilă definirea timpului mediu dintre publicarea unui articol și descoperirea lui de către motoarele de căutare.

De acolo, ar fi interesant de analizat numărul de accesări zilnice a botului (sau frecvența de accesare cu crawlere ) pe pagina principală a site-ului web, paginile de categorii... Acest lucru va face ușor să determinați unde să plasați link-uri către articole noi care trebuie descoperite.

Aceeași teorie se poate aplica și unui site de comerț electronic pentru a obține produse noi în catalog descoperite, cum ar fi cele pe care doriți să le evidențiați pentru a fi la curent cu tendințele emergente.

3. Buget de accesare cu crawlere

Bugetul de crawl (un fel de credit al lățimii de bandă de crawl pe care Google și colegii săi îl dedică unui site) este un subiect preferat al experților SEO, iar optimizarea acestuia a devenit o sarcină obligatorie.

În afara jurnalelor, doar Google Search Console (versiunea veche pentru moment) vă va oferi o idee de bază despre bugetul pe care motoarele de căutare îl acordă site-ului dumneavoastră. Dar nivelul de acuratețe din Search Console nu vă va ajuta cu adevărat să știți unde să vă concentrați eforturile. Mai ales că datele raportate sunt de fapt date agregate acumulate de la toți Googlebots.

Jurnalele, totuși, datorită unei analize a câmpurilor user-agent și URL , pot identifica ce pagini (sau resurse) roboții vizitează și cu ce rată.

Aceste informații vă vor informa dacă Googlebots navighează în mod excesiv în părți ale site-ului dvs. care nu sunt importante pentru SEO, irosind buget care ar putea fi util pentru alte pagini.

Acest tip de analiză poate fi folosit pentru a structura strategia de conectare internă, gestionarea fișierelor robots.txt, utilizarea de către dvs. a meta-etichetelor care vizează roboții...

4. Mobile-First și migrare

Unii abia așteaptă, alții sunt îngroziți de asta, dar cu siguranță va veni ziua în care veți primi un e-mail de la Google care vă indică faptul că site-ul dvs. a fost trecut la celebrul index mobil-first.

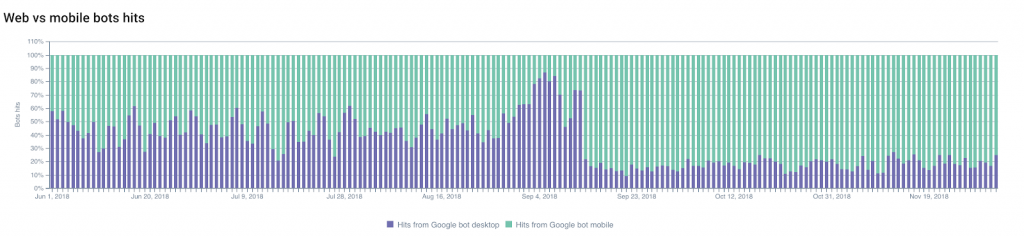

Puteți prezice când va avea loc schimbarea urmând modificări ale raportului dintre accesările Googlebot-desktop și accesările Googlebot-mobile .

Porțiunea de accesare cu crawlere de către Googlebots mobili va crește în general, permițându-vă să preziceți și să planificați schimbarea.

Pe de altă parte, faptul că nu vedeți modificări în acest raport poate fi, de asemenea, un indiciu semnificativ al conformității site-ului dvs. cu criteriile Google pentru schimbarea indexurilor.

De asemenea, puteți monitoriza și alte modificări: migrări (de la HTTP la HTTPS , de exemplu) sau modificări ale structurii site-ului dvs. web .

Dacă ne concentrăm pe primul exemplu — pe o modificare a protocolului utilizat — indexarea URL-urilor și redirecționările securizate, precum și „declinul” progresiv al vechilor URL-uri pot fi monitorizate cu ușurință datorită jurnalelor.

Monitorizarea modificărilor codurilor de stare va fi cel mai bun aliat al tău!

5. Vecini năzuiți

Ești un excelent SEO și eforturile tale au dat roade!

Acest lucru a stârnit curiozitatea concurenților dvs. (și a altor oameni năzuitori) care doresc să înțeleagă cum ați scos-o și care au decis să vă acceseze cu crawlere întregul site.

Asta e rău. Dar nu neobișnuit (dimpotrivă).

Treaba ta acum este să-i vezi pe snoopers..

Cei mai subtili dintre ei vor încerca să-și dea boții drept Googlebots folosind agenții de utilizare Google. Și aici adresa IP stocată în jurnale poate fi foarte utilă.

Dar, de fapt, Googlebots oficiali folosesc numai intervale bine documentate de adrese IP. Google îi sfătuiește pe webmasteri să efectueze o căutare inversă DNS pentru a verifica originile roboților.

Dacă acest test eșuează, rezultatele (sau rezultatele urmăririi geografice IP) vă pot ajuta să decideți ce să faceți.

Doar pentru record, expertul în securitate digitală de la Imperva Incapsula a condus un studiu publicat în 2016 care arată că 28,9% din lățimea de bandă analizată a fost consumată de „boții răi” (comparativ cu 22,9% de „boții buni” și 48,2% de către utilizatori). ). Aruncați o privire asupra jurnalelor dvs. vă poate ajuta să evitați consumarea excesivă a resurselor dvs. prin detectarea roboților nedoriți.