Meta-análise em experimentos controlados online: um olhar imparcial sobre o poder e as limitações deste método científico

Publicados: 2022-09-28

Quão útil é a meta-análise em testes A/B e outros experimentos online?

É útil aproveitar o aprendizado passado para melhorar sua geração de hipóteses? Ou a meta-análise é apenas uma desculpa preguiçosa para simplesmente confiar em “padrões comprovados” em vez de se basear em dados específicos da situação para inovar em seus negócios por meio da experiência?

Este é um tema de debate quente. Alguns são a favor, e alguns são fortemente contra. Mas como você pode se beneficiar de ambos os pontos de vista e agregar valor tangível ao seu programa de experimentação?

É disso que trata este post. Nele, você vai

- Entenda o que realmente é meta-análise

- Veja exemplos de meta-análise em ação

- Descubra por que a meta-análise como conceito deve ser tratada com cautela (e respeito) e

- Saiba como as equipes de experimentação podem fazer a meta-análise da maneira certa

E com um bônus: você também verá dois conhecidos especialistas em otimização de taxa de conversão discutindo isso de lados opostos.

Vamos entrar nisso.

- O que é Metanálise?

- Exemplos de meta-análise em experimentos controlados on-line

- Interessado em conduzir sua própria meta-análise de teste A/B?

- Meta-análise – Sim ou Não

- Meta-análise - Pise com cautela?

- Não comprometa o rigor do teste e a busca pela inovação

- Meta-análise — lubrificando o volante da experimentação?

- Meta-análise - Pise com cautela?

- Se você optar por conduzir (e usar) a meta-análise – lembre-se do seguinte

- Baixa qualidade dos experimentos incluídos na análise

- Heterogeneidade

- Viés de publicação

O que é Metanálise?

A meta-análise usa estatísticas para tomar uma decisão a partir da análise de vários resultados de experimentos. Ele vem do mundo científico, onde os pesquisadores reúnem resultados de estudos médicos que abordam o mesmo problema e usam análises estatísticas para julgar se um efeito está realmente presente e quão significativo ele é.

Em experimentos controlados on-line, nos quais temos testes A/B, testes multivariados e testes divididos para tomada de decisões e para encontrar maneiras de alto desempenho para direcionar metas de negócios, tomamos emprestada a meta-análise para aproveitar o que já aprendemos em experiências anteriores. testes para informar testes futuros.

Vamos ver diferentes exemplos na natureza.

Exemplos de meta-análise em experimentos controlados on-line

Aqui estão 3 exemplos de meta-análise em teste A/B, como foi usado e o que foi encontrado em cada esforço:

- Uma meta-análise empírica de estratégias de teste A/B de comércio eletrônico por Alex P. Miller e Kartik Hosanagar

Esta meta-análise de testes A/B foi publicada em março de 2020. Os analistas estudaram testes especificamente do setor de comércio eletrônico, com dados coletados de uma plataforma de testes SaaS A/B. Ele consistiu em 2.732 testes A/B conduzidos por 252 empresas de comércio eletrônico sediadas nos EUA em 7 setores em um período de 3 anos.

Eles analisaram esses testes para fornecer uma análise robusta de como os testes são posicionados em vários estágios do funil de conversão de e-commerce.

O que encontraram foi:

- Quando comparados a outros tipos de experimentos, os testes em promoções de preços e aqueles posicionados em páginas de categorias estão associados aos maiores tamanhos de efeito.

- Evidência de que a resposta dos consumidores a diferentes promoções depende de onde essas promoções estão posicionadas no site de comércio eletrônico.

- Embora as promoções relacionadas aos preços dos produtos sejam mais eficazes no início do funil de conversão, as promoções relacionadas ao envio são mais eficazes no final do funil de conversão (nas páginas de produtos e checkouts).

Vejamos outro exemplo e o que os pesquisadores descobriram…

- O que funciona no comércio eletrônico — Uma meta-análise de 6.700 experimentos de Will Browne e Mike Swarbrick Jones

Com dados de 6.700 grandes experimentos de comércio eletrônico principalmente nos setores de varejo e viagens, Browne e Jones pesquisaram o efeito de 29 tipos diferentes de mudanças e estimaram seu impacto cumulativo na receita. Foi publicado em junho de 2017.

Como o título do artigo sugere, o objetivo era explorar o que funciona no comércio eletrônico executando uma grande meta-análise. Foi assim que eles chegaram a esse poderoso resumo: que as mudanças na aparência do site tiveram um impacto muito mais insignificante na receita do que as mudanças baseadas na psicologia comportamental.

A métrica de receita por visitante (RPV) é usada para medir esse impacto. Portanto, em seus resultados, um aumento de +10% em um experimento significa que o RPV aumentou 10% nesse experimento.

Aqui estão alguns outros resultados da análise:

- Os melhores desempenhos (por categoria) foram:

- Escassez (indicadores de ações, por exemplo, “Apenas 3 restantes”): +2,9%

- Prova social (informando os usuários sobre o comportamento dos outros): +2,3%

- Urgência (temporizadores de contagem regressiva): +1,5%

- Recuperação de abandono (enviando mensagens aos usuários para mantê-los no site): +1,1%

- Recomendações de produtos (upsells, cross-sells, etc): +0,4%

- Mas as alterações cosméticas na interface do usuário, como as abaixo, não foram eficazes:

- Cor (alterando a cor dos elementos da página da web): +0,0%

- Botões (modificando botões do site): -0,2%

- Calls to action (alterando o texto): -0,3%

- 90% dos experimentos tiveram menos de 1,2% de efeito na receita, positivo ou negativo

- Poucas evidências de que os testes A/B levam a aumentos de dois dígitos na receita comumente apresentados em estudos de caso.

Agora espere. Antes de considerar esses resultados de meta-análise como um evangelho, você precisa saber que a meta-análise de experimentos online tem limitações. Nós vamos entrar nisso mais tarde.

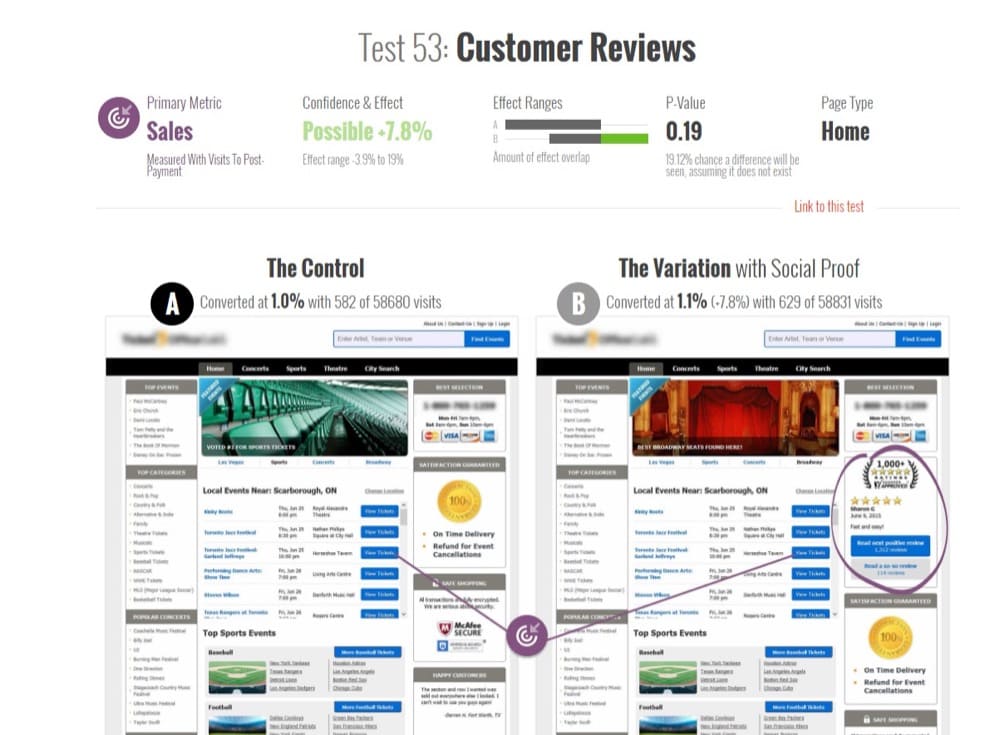

- Meta-análise de 115 testes A/B no GoodUI.org por Georgi Georgiev

Em junho de 2018, o especialista em experimentação online e autor de “Statistical Methods in Online A/B Testing”, Georgi Georgiev, analisou 115 testes A/B disponíveis publicamente no GoodUI.org.

GoodUI.org publica uma coleção de resultados de experimentação, incluindo padrões de interface do usuário recém-descobertos e o que empresas orientadas a experimentação como Amazon, Netflix e Google estão aprendendo com seus testes.

O objetivo de Georgi era reunir e analisar esses dados para revelar os resultados médios dos testes e contribuir com ideias sobre melhores práticas estatísticas ao projetar e conduzir uma meta-análise de testes A/B.

Ele começou podando o conjunto de dados inicial e fazendo alguns ajustes estatísticos. Estes incluíram a remoção:

- Testes com desequilíbrios entre o número de usuários enviados para experimentar o controle versus aqueles enviados para experimentar o desafiante, e

- Testes comprometidos (identificados por seu poder estatístico irrealisticamente baixo).

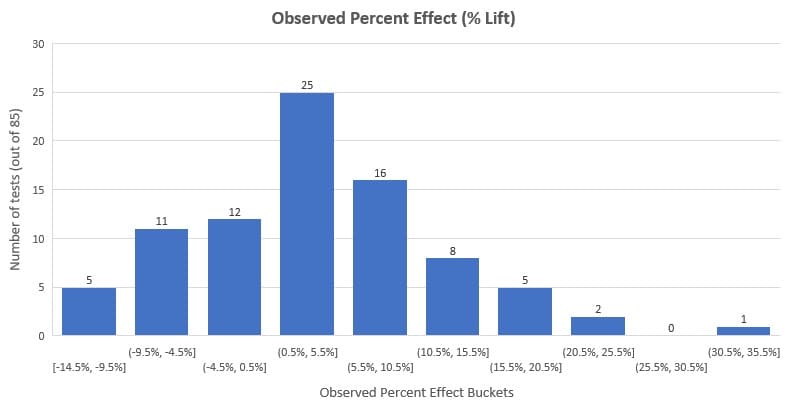

Ele analisou os 85 testes restantes e descobriu que o aumento percentual médio foi de 3,77% e o aumento médio foi de 3,92%. Observando a distribuição abaixo, você verá que 58% dos testes (que é a maioria) tiveram um efeito observado (% de aumento) entre -3% e +10%.

É importante observar que isso representa esse conjunto de dados e nem todos os testes A/B que já foram feitos. Além disso, temos que levar em conta o viés de publicação (uma das desvantagens da meta-análise que discutiremos mais adiante).

No entanto, essa meta-análise é útil para otimizadores de taxa de conversão e outras partes interessadas em otimização para ter uma noção de quais são os benchmarks externos nos testes A/B.

Interessado em conduzir sua própria meta-análise de teste A/B?

Você obtém acesso ao mesmo conjunto de dados que Georgi usou. Está disponível publicamente no GoodUI.org — um repositório de resultados destilados de testes A/B realizados em plataformas, indústrias e para diferentes problemas principais.

Existem outras coleções de resultados de testes A/B como esta (você pode até criar o seu extraindo dados de vários exemplos de testes A/B e estudos de caso), mas o GoodUI é único. Você obtém informações estatísticas adicionais sobre o teste que, de outra forma, são impossíveis ou difíceis de obter se você estiver navegando e coletando estudos de caso.

Mais algumas coisas tornam o GoodUI único:

- Ele não discrimina com base nos resultados dos experimentos. Inclui testes vencedores, inconclusivos, planos e negativos para combater o viés de publicação na meta-análise, que é um problema real, conforme declarado em “Meta-análise, gráficos de funil e análise de sensibilidade” de John Copas e Jian Qing Shi.

O viés de publicação é uma preferência por publicar pequenos estudos se seus resultados forem 'significativos' em relação a estudos com resultados negativos ou inconclusivos. Você não pode corrigir isso sem fazer suposições não testáveis.

- GoodUI vai um passo além. Muitas vezes, os resultados da meta-análise estão enterrados em trabalhos de pesquisa. Eles quase nunca chegam à aplicação prática, especialmente para equipes de experimentação que não são extremamente maduras.

Com os padrões GoodUI, é possível que otimizadores curiosos analisem a alteração percentual observada, cálculos de significância estatística e intervalos de confiança. Eles também podem usar a avaliação do GoodUI de quão forte é o resultado, com valores possíveis de “Insignificante”, “Possível”, “Significante” e “Forte”, indo em ambas as direções para cada padrão de conversão. Você poderia dizer que “democratiza” insights de meta-análises de testes A/B.

- No entanto, há um problema aqui. Experimentadores que podem não estar cientes dos problemas que assolam a meta-análise - heterogeneidade e viés de publicação - mais o fato de que os resultados da meta-análise dependem da qualidade da própria meta-análise, podem se desviar para o território de copiar cegamente os padrões.

Em vez disso, eles devem conduzir sua própria pesquisa e executar seus testes A/B. A falha em fazê-lo ultimamente (com razão) tem sido motivo de preocupação no espaço CRO.

Outro recurso de estudo de caso de teste A/B no qual você pode se aprofundar para obter detalhes semelhantes em alguns testes como o GoodUI é o GuessTheTest.

AVISO LEGAL : Não estamos escrevendo este blog com a intenção de garimpar ou elogiar meta-análise e padrões de conversão. Vamos apenas apresentar os prós e os contras, conforme discutido por especialistas na área de CRO. A ideia é apresentar a meta-análise como ferramenta para que você possa utilizá-la a seu critério.

Meta-análise – Sim ou Não

Uma mente inteligente procura padrões. É assim que você encurta o caminho do problema para a solução na próxima vez que se deparar com um problema semelhante.

Esses padrões levam você a uma resposta em tempo recorde. É por isso que estamos inclinados a acreditar que podemos pegar o que aprendemos com os experimentos, agregá-los e deduzir um padrão.

Mas isso é aconselhável para as equipes de experimentação fazerem?

Quais são os argumentos a favor e contra a meta-análise em experimentos controlados online? Você pode encontrar um meio-termo que obtenha o melhor dos dois mundos?

Perguntamos a duas das vozes mais vocais no campo da experimentação com (respeitosamente) diversos pontos de vista sobre sua opinião sobre a meta-análise.

Jonny Longden e Jakub Linowski são vozes em que você pode confiar.

Meta-análise - Pise com cautela?

Na discussão acima, Jonny apontou dois problemas potenciais com o uso de dados de meta-análise em testes online que exigem que os profissionais de CRO ajam com cautela.

- Problema nº 1: usando um resultado sem testá-lo

“Se funcionou para aquela empresa, deve funcionar para nós também”. Isso pode se tornar um pensamento errôneo porque há nuances em torno dos testes que não chegam ao snippet dos resultados que você está analisando.

Vários testes podem demonstrar uma solução óbvia, mas isso é apenas uma probabilidade de que funcione um pouco melhor do que outras soluções e não uma resposta definitiva de que funcionará em seu site.

- Problema nº 2: você não pode classificar testes tão facilmente

Conforme mencionado no item 1, esses resultados não mostram a história completa e diferenciada por trás dos testes. Você não vê por que os testes foram executados, de onde vieram, quais problemas anteriores existiam no site etc.

Você só vê que foi um teste no call to action na página do produto, por exemplo. Mas os bancos de dados de meta-análise irão classificá-los em padrões específicos, mesmo que eles não se encaixem perfeitamente nesses padrões.

O que isso significa para você, um usuário de banco de dados de meta-análise de teste A/B ou um pesquisador de CRO montando seu próprio banco de dados de meta-análise para extrair aprendizados?

Isso não significa que a meta-análise esteja fora dos limites, mas você deve ter cuidado ao usá-la. Que tipo de cautela você deve ter?

Não comprometa o rigor do teste e a busca pela inovação

Lembre-se de que a meta-análise é uma ideia estatística da comunidade médica, onde os experimentos são fortemente controlados para garantir a repetibilidade da descoberta.

O ambiente e outros fatores que cercam a observação são repetidos em vários experimentos, mas isso não é o mesmo com experimentos online. A meta-análise de experimentos online reúne seus dados independentemente dessas diferenças.

Um site é radical e totalmente diferente de outro site porque tem um público muito diferente e coisas muito diferentes acontecendo. Mesmo que pareça relativamente semelhante, mesmo que seja o mesmo produto, ainda é completamente e totalmente diferente em milhões e milhões de maneiras, então você simplesmente não pode controlar isso.

Jonny Longden

Entre outras limitações, isso afeta a qualidade do que podemos chamar de verdadeira meta-análise.

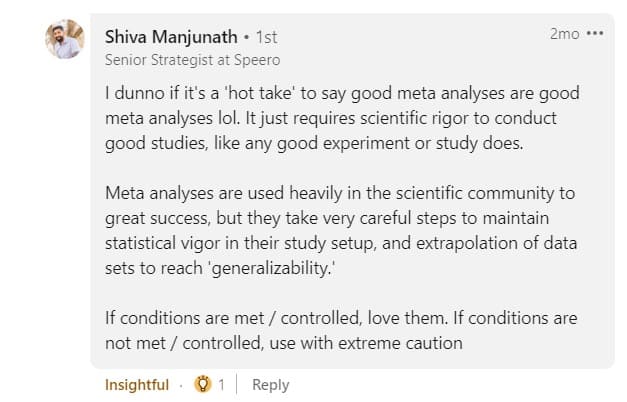

Então, onde você não tem certeza do nível de vigor estatístico que entrou nos testes e meta-análise dos testes, você só pode usar com extrema cautela, como aconselha Shiva Manjunath.

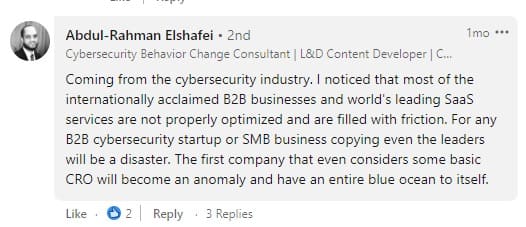

O objetivo da meta-análise não deve ser copiar os concorrentes. O salto da alavancagem da meta-análise para a cópia direta ultrapassa os limites da credibilidade. Existem nuances na intenção por trás de “copiar”, então dificilmente é uma situação em preto e branco.

Os comentários no post de Deborah acima foram variados. Não há problema em copiar até certo ponto, mas exagerar é perigoso:

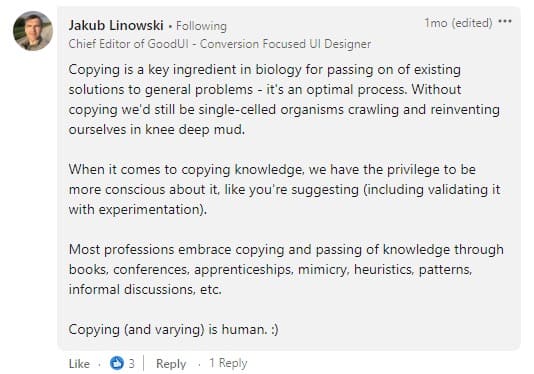

Como Jakub concorda, temos que ser cautelosos ao copiar, especialmente quando se trata de validar os padrões que observamos com os experimentos.

No entanto, o que devemos nos proteger é a experimentação comoditizadora . Ou seja, usar os padrões e insights da meta-análise como melhores práticas para substituir a pesquisa na experimentação, em vez de elogiar o que os dados específicos da situação têm a dizer.

Portanto, comece entendendo o problema que deseja resolver e identifique o tipo de intervenção com maior probabilidade de sucesso. É aí que a meta-análise de dados de experimentação legados oferece melhor suporte a uma estratégia de otimização exclusiva.

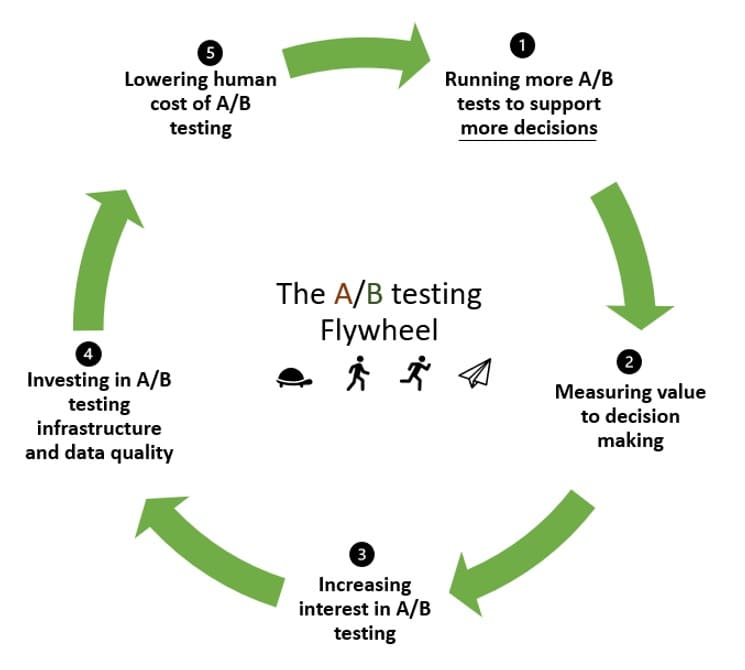

Meta-análise — lubrificando o volante da experimentação?

O volante de experimentação tem uma maneira de reciclar o impulso. Quando você está experimentando pela primeira vez, você precisa de muita inércia para colocar as coisas em movimento.

A ideia com o volante de experimentação é aproveitar esse impulso para fazer mais testes e dar a volta por cima, ficando cada vez melhor, executando mais e mais testes.

E é aí que a meta-análise pode ajudar. No volante:

- Você executa testes para validar suas hipóteses (e talvez rejeitar algumas no processo).

- Meça o valor que eles agregaram à tomada de decisão.

- Incentive mais interesse e adesão para testes A/B.

- Invista em infraestrutura de teste A/B e na melhoria da qualidade de seus dados.

- Reduza o custo humano dos testes A/B para que a próxima etapa comece com menos esforço do que a rodada anterior.

Mas, como uma organização orientada a dados, você não para por aí ao reconhecer o poder dos testes A/B. Em vez disso, você deseja aproveitar seu investimento inicial de experimentação para validar ou rejeitar mais hipóteses.

Se essa percepção ou conhecimento inicial não estiver lá para começar, a inércia para colocar seu volante em movimento será muito grande. Compartilhar esse conhecimento (democratizando os dados de teste A/B) inspira e permite que outros adotem uma abordagem de experimentação, diminuindo a barreira do conhecimento.

Isso nos leva ao ponto 1 de como a meta-análise lubrifica o volante da experimentação:

- A meta-análise pode reduzir o tempo para hipotetizar ideias.

Você pode pegar o que aprendeu, insights e tudo, de testes anteriores para gerar novas hipóteses facilmente. Isso aumenta o número de testes executados e é uma excelente maneira de acelerar o volante de testes A/B.

Gastamos menos tempo refazendo o que já estabeleceu padrões e mais tempo criando novos caminhos com base no que aprendemos em experimentos anteriores.

- A meta-análise pode levar a melhores taxas de previsão com dados anteriores.

Outra maneira pela qual o aprendizado orientado à experimentação pode fazer com que o volante da experimentação gire mais rápido é quando ele é combinado com dados atuais para informar novas hipóteses.

Isso melhora potencialmente como o impacto observado em um teste A/B se espalha para o futuro.

A implantação de um teste A/B não é garantia de ver o resultado desejado, pois a taxa de falsa descoberta (FDR) para testes com 95% de significância está entre 18% e 25%. E apenas 70% dos testes examinados que levaram a essa conclusão tiveram poder adequado.

A taxa de descoberta falsa é a fração de resultados de testes A/B significativos que são, na verdade, efeitos nulos. Não deve ser confundido com falso positivo ou erro tipo I.

- Finalmente, a meta-análise pode ser uma maneira de construir confiança nos resultados dos testes que são essencialmente inconclusivos.

Os níveis de confiança ajudam você a confiar que os resultados dos seus testes não se devem ao mero acaso. Se você não tiver o suficiente, pode estar inclinado a rotular esse teste como “inconclusivo”, mas não tenha tanta pressa.

Por quê? Estatisticamente, você pode acumular valores p insignificantes para obter um resultado significativo. Veja a postagem abaixo:

A meta-análise tem dois benefícios principais: 1) melhora a precisão das estimativas de efeito e 2) aumenta a generalização dos achados.

Fonte: O bom, o mau e o feio: meta-análises de Madelon van Wely

Dado que uma meta-análise ajusta e corrige o tamanho do efeito e os níveis de significância, pode-se usar esses resultados padrão mais altos da mesma forma que usa qualquer outro experimento, incluindo:

1) fazer cálculos de potência/estimativas de tamanho de amostra para seus próprios experimentos (usando dados reais em vez de suposições subjetivas)

2) para tomar a decisão do experimento de exploração. Nos casos em que alguém sente que é necessária confiança adicional, eles podem decidir realizar seus próprios experimentos adicionais. Nos casos em que alguém acha a evidência da meta-análise forte o suficiente, eles podem simplesmente agir mais cedo, sem realizar experimentos adicionais.

Jakub Linowski

Com todas as maneiras pelas quais a meta-análise pode ajudar seu programa de experimentação a ganhar mais impulso, é importante ter em mente que ele sofre de algumas limitações bem conhecidas.

Se você optar por conduzir (e usar) a meta-análise – lembre-se do seguinte

Sim, combinar os resultados de experimentos por meio de métodos meta-analíticos pode melhorar a precisão estatística, mas isso não remove problemas fundamentais com o conjunto de dados inicial, como…

Baixa qualidade dos experimentos incluídos na análise

Se os experimentos incluídos na meta-análise forem mal configurados e contiverem erros estatísticos, não importa quão preciso seja o meta-analista, eles obterão resultados inválidos.

Talvez tenha havido uma alocação desigual do tamanho da amostra nos testes A/B, o poder ou o tamanho da amostra foram insuficientes, ou houve evidência de espiar – seja qual for o caso, esses resultados são falhos.

O que você pode fazer para contornar essa limitação é escolher cuidadosamente os resultados do teste. Elimine resultados questionáveis do seu conjunto de dados. Você também pode recalcular a significância estatística e os intervalos de confiança para os testes que escolheu incluir e usar os novos valores em sua meta-análise.

Heterogeneidade

Isso está combinando resultados de teste que não devem ser colocados no mesmo bucket em primeiro lugar. Por exemplo, quando a metodologia usada para realizar os testes é diferente (análise estatística Bayesiana vs Frequentista, diferenças específicas da plataforma de teste A/B, etc.).

Esta é uma limitação comum da meta-análise onde o analista, conscientemente ou não, ignora as principais diferenças entre os estudos.

Você pode olhar para os dados quantitativos brutos para combater a heterogeneidade. É melhor do que combinar apenas o resumo dos resultados do teste. Isso significa recalcular os resultados de cada teste A/B, supondo que você tenha acesso aos dados.

Viés de publicação

Também conhecido como o 'problema da gaveta de arquivos', este é o problema mais infame da meta-análise. Ao realizar uma meta-análise em dados disponíveis publicamente, você está limitado a agrupar os resultados que chegaram à publicação.

E os que não conseguiram? As publicações geralmente favorecem resultados que são estatisticamente significativos e onde há um efeito de tratamento significativo. Quando esses dados não estão representados na meta-análise, os resultados apenas retratam o que foi publicado.

Você pode identificar o viés de publicação com gráficos de funil e estatísticas correspondentes.

Então, onde você encontra testes A/B que não chegaram aos estudos de caso ou bancos de dados de meta-análise de testes A/B? As plataformas de teste A/B estão na melhor posição para fornecer dados sobre os testes, independentemente dos resultados. É aí que os exemplos 1 e 2 neste artigo são afortunados.