SEO em um mundo de dois algoritmos: Pubcon Keynote por Rand Fishkin

Publicados: 2022-06-12 Rand dedica esta apresentação a Dana Lookadoo, que sempre estará conosco.

Rand dedica esta apresentação a Dana Lookadoo, que sempre estará conosco.

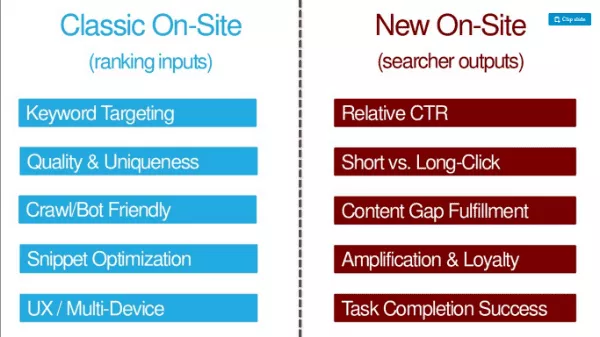

A opinião TL:DR deste autor: Além dos fatores tradicionais de otimização de SEO (entradas de classificação, como segmentação por palavras-chave, qualidade e exclusividade, facilidade de rastreamento/bot, otimização de snippets, otimização de UX/multi-dispositivo), os SEOs precisam otimizar as saídas do pesquisador ( como CTR, cliques longos, preenchimento de lacunas de conteúdo, amplificação e fidelidade, sucesso na conclusão de tarefas).

Aqui você encontra a apresentação: http://bit.ly/twoalgo

Lembra quando tínhamos apenas um emprego? Tivemos que fazer páginas perfeitamente otimizadas. A equipe de qualidade de pesquisa classificaria e usaria os links como um sinal importante. Em 2007, o spam de links era onipresente. Todo SEO é obcecado por jogos de defesa porque adoramos otimizar. Mesmo em 2012, parecia que o Google estava transformando o mundo do SEO de chapéu branco em mentirosos (-Wil Reynolds).

Rand diz hoje que essa afirmação não é mais verdadeira. Conteúdo autêntico e excelente é recompensado pelo Google melhor do que nunca. O Google apagou as práticas da velha escola, combatendo coisas como spam de links. E eles aproveitaram o medo e a incerteza da penalização para manter os sites na linha. Muitas vezes é tão perigoso usar rejeições que muitos de nós estão matando links que agregam valor aos nossos sites porque temos muito medo de penalidades.

O Google se tornou mais inteligente

O Google também se tornou bom em descobrir a intenção. Eles analisam a linguagem e não apenas as palavras-chave.

Eles preveem resultados diversos.

Eles descobriram quando queremos frescura.

Eles podem separar as consultas de navegação das informativas. Eles conectam entidades a tópicos e palavras-chave. Até as marcas se tornaram uma forma de entidades. Bill Slawski observou que o Google menciona marcas em várias de suas patentes registradas.

O Google está muito mais alinhado com suas declarações públicas. Eles geralmente têm uma política que corresponde à melhor maneira de fazer marketing de pesquisa hoje.

A postura do Google em relação ao aprendizado de máquina mudou

Durante esses avanços, a equipe de qualidade de pesquisa do Google passou por uma revolução. No início, o Google rejeitou o aprendizado de máquina em seu algoritmo de classificação orgânica. O Google disse que o aprendizado de máquina não permitiu que eles possuíssem, controlassem e entendessem os fatores do algoritmo. Mas, mais recentemente, os comentários de Amit Singhal sugerem que parte disso mudou.

Em 2012, o Google publicou um artigo sobre como eles usam o aprendizado de máquina para prever a taxa de cliques em anúncios. Os engenheiros do Google chamaram seu sistema SmartASS (aparentemente esse é REALMENTE o nome do sistema!). Em 2013, Matt Cutts falou no Pubcon sobre como o Google poderia usar o aprendizado de máquina (ML) publicamente na pesquisa orgânica.

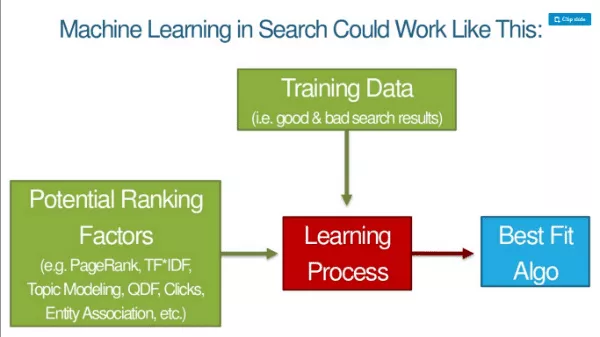

À medida que o ML assume mais o algoritmo do Google, os fundamentos dos rankings mudam. O Google é público sobre como eles usam ML no reconhecimento e classificação de imagens. Eles pegam fatores que poderiam usar para classificar imagens e, em seguida, adicionam dados de treinamento (coisas que dizem à máquina que algo é um gato, cachorro, macaco etc.), e há um processo de aprendizado que os leva a um algoritmo de melhor correspondência. Em seguida, eles podem aplicar esse padrão a todos os dados ao vivo.

A apresentação de slides do representante do Google, Jeff Dean, sobre Deep Learning é uma leitura obrigatória para SEOs. Rand diz que esta é uma leitura essencial e não muito difícil de consumir. Jeff Dean é um membro do Google e alguém de quem eles gostam muito de tirar sarro no Google: “A velocidade da luz no vácuo costumava ser de cerca de 35 milhas por hora. Até que Jeff Dean passou um fim de semana otimizando a física.”

Bounce, cliques, tempo de permanência – todas essas coisas são qualidades no processo de aprendizado de máquina, e o algoritmo tenta emular as boas experiências de SERP. Estamos falando de um algoritmo para construir algoritmos. Os Googlers não se alimentam de fatores de classificação. A própria máquina os determina. Os dados de treinamento são bons resultados de pesquisa.

O que significa Deep Learning para SEO?

Os Googlers não saberão por que algo é classificado ou se uma variável está no algoritmo. Entre o leitor e Rand, isso não se parece muito com as coisas que os Googlers dizem agora? ;)

As métricas de sucesso da consulta serão tudo o que importa para as máquinas:

- Proporção de cliques longos para curtos

- CTR relativa vs. outros resultados

- Taxa de pesquisadores que realizam pesquisas relacionadas adicionais

- Taxa de compartilhamento/amplificação versus outros resultados

- Métricas de engajamento do usuário em todo o domínio

- Métricas de engajamento do usuário na página (Como? Usando Chrome e Android)

Se muitos resultados em um SERP fizerem todos os itens acima, eles continuarão incluindo isso. Estaremos otimizando mais as saídas do pesquisador. Esses provavelmente serão os critérios de SEOs no site no futuro.

OK - mas essas métricas estão nos afetando hoje? Em 2014, a Moz fez um teste de consultas e cliques. Desde então, tem sido muito mais difícil mover a agulha com consultas e cliques brutos. O Google está pegando cliques brutos e manipulações de consultas.

No SMX Advanced, Gary Illyes disse que usar cliques diretamente nos rankings não faria muito sentido com esse barulho. Ele disse que havia pessoas produzindo barulho em cliques, chamando Rand Fishkin. - Caso encerrado! Ou é … ?

Mas e se tentássemos cliques longos versus cliques curtos? Às 11h39 do dia 21 de junho, Rand pediu às pessoas que fizessem um teste em que rapidamente clicavam no resultado nº 1 e depois clicavam e se demoravam no resultado nº 4. O resultado nº 4 permaneceu na posição nº 1 da SERP por cerca de 12 horas. Isso nos diz que os resultados do pesquisador afetam os rankings. (PS Isso é difícil de replicar. Não faça isso, porque é magia negra.)

O que você deve fazer são coisas que naturalmente farão com que as pessoas queiram clicar no seu resultado na SERP.

Uma escolha de dois algoritmos

É por isso que Rand diz que estamos otimizando para dois algoritmos. Temos que escolher como estamos equilibrando nosso trabalho. Martelo em sinais de idade? Eles ainda funcionam. Os links ainda funcionam. O texto âncora ainda move a agulha. Mas podemos ver no horizonte com mais clareza do que nunca para onde o Google está indo.

SEO On-Site Clássico (entradas de classificação) vs. SEO On-Site Novo (resultados do pesquisador):

Usar as duas coisas porque existem dois algoritmos.

Novos elementos de SEO

Vamos falar sobre os cinco novos elementos do SEO moderno.

1. Perfuração acima da sua CTR média

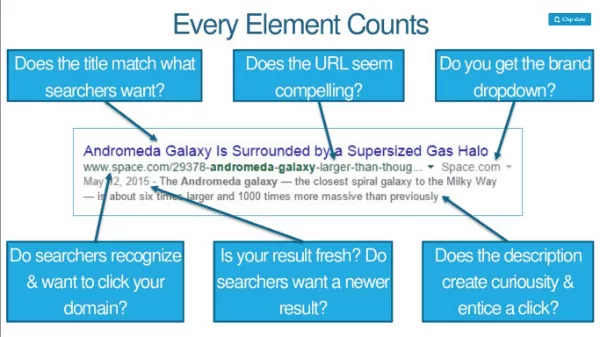

Otimizando o título, meta descrição e URL um pouco para palavras-chave, mas muito para cliques. Se você estiver em 3º lugar, mas puder aumentar seu CTR, poderá ganhar um aumento no ranking. Cada elemento conta. Os pesquisadores reconhecem e querem clicar no seu domínio? A URL parece atraente? Você recebe um drop-down de marca?

Aumente a CTR por meio de pesquisas de marca ou marca e isso pode lhe dar um impulso extra. Esforços de branding (como publicidade na TV, rádio, PPC) têm impacto na CTR. O orçamento da marca ajuda a taxa de cliques relativa e todos os tipos de outros sinais de classificação, e esse aumento está causando parte disso.

Com os intervalos mais precisos e personalizáveis do Google Trends, você pode realmente observar os efeitos de eventos e anúncios no volume de consultas de pesquisa. Por exemplo, há um aumento nas consultas “fitbit” depois que o Fitbit está veiculando anúncios no domingo da NFL.

2. Superando as listagens de outros SERPs no engajamento

Juntos, pula-pula e cliques longos podem determinar em grande parte onde você classifica (e por quanto tempo). O que os influencia? Aqui está uma lista de verificação de SEO para um melhor engajamento:

- Conteúdo que atende às necessidades conscientes e inconscientes do pesquisador

- Velocidade, velocidade e mais velocidade

- Oferecendo o melhor UX em todos os navegadores

- Obrigar os visitantes a ir mais fundo em seu site

- Evitar recursos que incomodam ou dissuadem os visitantes

Exemplo: o New York Times tem gráficos de alto engajamento que pedem aos visitantes que desenhem o melhor final de um gráfico.

3. Preenchendo lacunas no conhecimento dos visitantes

A busca do Google por sinais que mostram uma página atende a todas as necessidades de um pesquisador. Os modelos de ML podem notar que a presença de certas palavras, frases e tópicos prevê pesquisas mais bem-sucedidas. Os rankings vão para páginas/sites que preenchem as lacunas no conhecimento dos pesquisadores. DICA: Confira Alchemy API ou MonkeyLearn. Execute seu conteúdo por meio deles para ver como ele funciona de uma perspectiva de ML.

4. Ganhando mais compartilhamentos, links e fidelidade por visita

Dados do Buzzsumo e Moz mostram que pouquíssimos artigos ganham compartilhamentos/links e que esses dois não têm correlação. As pessoas compartilham um monte de coisas que nunca leram. O Google quase definitivamente classifica diferentes tipos de SERPs de maneira diferente. Muitos compartilhamentos de informações médicas, por exemplo, não farão o resultado subir no ranking; precisão será mais importante.

Um novo KPI: compartilhamentos e links por 1.000 visitas. Visitas únicas em compartilhamentos + links.

Saber o que faz as pessoas retornarem ou as impede de fazê-lo também é fundamental.

Não precisamos de conteúdo melhor, precisamos de conteúdo 10X (ou seja, conteúdo 10 vezes melhor do que o melhor atualmente disponível).

5. Cumprindo a tarefa do pesquisador (não apenas sua consulta)

Tarefa = o que eles querem realizar quando fazem essa consulta. O Google não quer um caminho de múltiplas buscas de consultas continuamente focadas. Eles querem uma pesquisa ampla para a qual preencham todas as etapas e você conclua sua tarefa.

O mecanismo de pesquisa pode usar os dados do fluxo de cliques para ajudar a classificar um site mais alto, mesmo que ele não tenha os sinais de classificação tradicionais. Uma página que responde à consulta inicial pode não ser suficiente, especialmente se os concorrentes permitirem a conclusão da tarefa.

Algo 1: Google

Algo 2: Subconjunto da humanidade que interage com seu conteúdo (dentro e fora dos resultados de pesquisa)

“Faça páginas para pessoas, não para motores” é um conselho terrível.

Os motores precisam de muitas coisas que sempre fizemos e é melhor continuarmos fazendo isso. As pessoas precisam de coisas adicionais e é melhor fazermos isso também.

Links de bônus:

- http://bit.ly/10Xcontent

- http://bit.ly/sharesvslinks